情感分析在AI原生应用中的隐私与安全问题

你是否用过“智能陪聊机器人”?当你说“今天被老板骂了,好委屈”,它能秒回“我理解你的难过,需要我陪你聊聊吗?”——这背后就是情感分析技术在起作用。随着AI原生应用(从诞生就基于AI技术设计的产品,如ChatGPT、智能心理助手)的普及,情感分析已从“辅助功能”升级为“核心能力”。但你是否想过:当AI比你更懂你的情绪时,你的“心情数据”安全吗?本文将聚焦情感分析在AI原生应用中的隐私泄露路径、安全防

情感分析在AI原生应用中的隐私与安全问题

关键词:情感分析、AI原生应用、隐私保护、数据安全、联邦学习、差分隐私、对抗攻击

摘要:本文从“情感分析+AI原生应用”的独特场景出发,用“拆快递”“写日记”等生活化比喻,深入解析情感数据处理过程中可能面临的隐私泄露风险与安全挑战。通过技术原理拆解、代码案例演示和真实场景分析,为开发者和用户提供可落地的隐私保护思路,帮助理解“如何在读懂用户心情的同时,守护用户的‘心情安全’”。

背景介绍

目的和范围

你是否用过“智能陪聊机器人”?当你说“今天被老板骂了,好委屈”,它能秒回“我理解你的难过,需要我陪你聊聊吗?”——这背后就是情感分析技术在起作用。

随着AI原生应用(从诞生就基于AI技术设计的产品,如ChatGPT、智能心理助手)的普及,情感分析已从“辅助功能”升级为“核心能力”。但你是否想过:当AI比你更懂你的情绪时,你的“心情数据”安全吗?本文将聚焦情感分析在AI原生应用中的隐私泄露路径、安全防护技术,覆盖社交、医疗、教育等典型场景。

预期读者

- 开发者:想了解情感分析系统中的隐私风险点及防护方案

- 普通用户:想知道“我的情绪数据会被谁看到?”

- 产品经理:需平衡“用户体验”与“隐私合规”的决策者

文档结构概述

本文将按“概念→风险→防护→实战”的逻辑展开:先通过故事理解情感分析与AI原生应用的关系,再拆解数据全生命周期的隐私风险,接着用技术原理解释如何防护,最后用代码案例演示具体实现。

术语表

核心术语定义

- 情感分析:AI通过文本、语音等数据识别用户情绪(如开心、悲伤)的技术(类似“读心术”)。

- AI原生应用:从设计之初就以AI为核心的产品(比如“不是给传统APP加个AI插件,而是APP本身就是AI”)。

- 差分隐私:给数据“加噪音”,让单条数据无法被追踪(类似“把全班分数打乱,没人能猜出你具体考了多少”)。

- 联邦学习:让模型“带着算法去数据所在的地方学习”,而不是把数据传出去(类似“老师去每个学生家里辅导,不用收走学生的笔记本”)。

缩略词列表

- GDPR:通用数据保护条例(欧盟隐私法规)

- MLaaS:机器学习即服务(如用云服务训练模型)

核心概念与联系

故事引入:小明的“心情日记”APP

小明下载了一个“AI心情助手”APP,每天记录:“今天和妈妈吵架了,好难过”“发工资啦!超开心”。APP会分析他的情绪变化,推送“情绪安抚小贴士”。但有一天,小明发现某购物APP给他推送了“家庭矛盾调解课程”——他的“难过”情绪数据可能被共享了!

这个故事里藏着三个关键角色:

- 情感分析(APP的“读心术”):识别“难过”“开心”等情绪。

- AI原生应用(APP本身):核心功能依赖AI,而非传统规则。

- 隐私与安全(小明的担忧):情绪数据会不会被泄露?

核心概念解释(像给小学生讲故事)

概念一:情感分析——AI的“情绪翻译官”

情感分析就像你有一个“情绪翻译官朋友”。当你说“今天的雨下得真大”,翻译官会结合语气、上下文,判断你是“觉得浪漫”还是“因为堵车而烦躁”。AI通过分析文本中的关键词(如“难过”“开心”)、语气词(如“唉”“耶”),甚至语音的语调(哽咽声vs笑声),来“读懂”你的情绪。

概念二:AI原生应用——“生下来就会用AI的宝宝”

传统APP像“老房子”:先有房子(基础功能),再装修(加AI插件)。AI原生应用像“智能别墅”:从打地基开始(设计阶段)就考虑AI如何融入,比如ChatGPT的核心功能就是“用AI对话”,没有AI它就“不会说话”了。这类应用更依赖用户数据(尤其是情感数据)来优化AI能力。

概念三:隐私与安全——情绪数据的“防盗门”

隐私是“我不想让别人知道的事”(比如“我昨天因为失业哭了”),安全是“防止别人偷看到这些事的手段”(比如给日记本加锁)。在AI应用里,隐私风险可能来自数据被偷(黑客攻击)、被滥用(公司拿情绪数据做广告)、或被误分析(AI错误识别情绪导致标签化)。

核心概念之间的关系(用小学生能理解的比喻)

情感分析、AI原生应用、隐私安全就像“蛋糕三要素”:

- 情感分析是奶油:让AI原生应用(蛋糕)更美味(更懂用户)。

- 隐私安全是蛋糕盒:没有盒子(安全措施),奶油(情感数据)会被蹭走、弄脏。

- AI原生应用是蛋糕本身:需要奶油(情感分析)来提升价值,但必须用盒子(安全)保护它。

具体关系:

- 情感分析 vs AI原生应用:AI原生应用依赖情感分析来提供“懂用户”的体验(比如心理助手需要分析情绪才能给出建议)。

- 情感分析 vs 隐私安全:情感分析需要处理敏感的情绪数据(如抑郁倾向),若安全措施不到位,这些数据可能泄露(就像翻译官把你的秘密说给别人听)。

- AI原生应用 vs 隐私安全:AI原生应用越依赖用户数据(尤其是情感数据),越需要强大的安全措施(就像别墅越豪华,越需要高级防盗系统)。

核心概念原理和架构的文本示意图

情感分析在AI原生应用中的隐私风险贯穿“数据生命周期”:

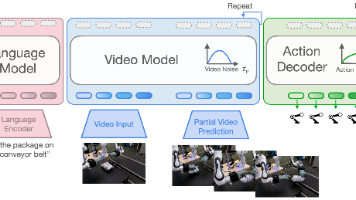

数据采集→存储→传输→处理(模型训练/推理)→输出

每个环节都可能泄露隐私:

- 采集:过度收集(比如不仅要聊天内容,还要定位、通讯录)。

- 存储:数据库被攻击,情绪数据泄露。

- 传输:数据在手机→云端的过程中被截获。

- 处理:训练模型时,攻击者通过“成员推理”判断某条数据是否参与过训练(比如“小明的‘失业难过’数据是否被用来训练模型?”)。

- 输出:模型输出的情绪标签(如“抑郁倾向”)被滥用(比如保险公司拒绝投保)。

Mermaid 流程图

核心算法原理 & 具体操作步骤

情感分析的隐私风险,本质是“情绪数据在算法处理中被暴露”。我们以最常见的文本情感分析为例,拆解风险点及防护技术。

情感分析的基本流程(以文本为例)

- 数据采集:从用户输入(如聊天记录)获取文本。

- 预处理:清洗数据(去标点)、分词(“今天开心”→“今天”“开心”)。

- 特征提取:将文本转成数值向量(比如“开心”对应向量[0.8, 0.2])。

- 模型训练:用标注数据(如“开心”标签)训练分类模型(如BERT)。

- 模型推理:输入新文本,输出情绪标签(如“积极”“消极”)。

隐私风险点对应防护技术

| 流程环节 | 隐私风险示例 | 防护技术 |

|---|---|---|

| 数据采集 | 应用要求读取“所有聊天记录”(超出必要范围) | 最小化采集(仅获取“当前对话内容”) |

| 数据存储 | 数据库未加密,黑客拖库后获取情绪数据 | 加密存储(如AES加密)、访问控制(仅授权人员查看) |

| 数据传输 | 数据在手机→云端时被中间人截获 | 加密传输(HTTPS/TLS协议) |

| 模型训练 | 攻击者通过“成员推理攻击”判断某条数据是否参与训练(如“小明的‘失业’数据是否被用”) | 联邦学习(数据不离开本地)、差分隐私(训练时给数据加噪音) |

| 模型推理 | 攻击者通过“对抗样本”(如轻微修改输入文本)诱导模型泄露训练数据细节 | 对抗训练(让模型对恶意输入免疫)、输出脱敏(不返回原始数据相关信息) |

关键防护技术:联邦学习与差分隐私(附Python代码)

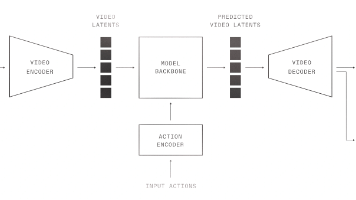

联邦学习:让数据“不出门”的训练法

传统模型训练:用户数据→上传到中心服务器→统一训练(数据可能泄露)。

联邦学习:服务器下发初始模型→用户用本地数据训练→上传“模型更新”而非原始数据→服务器聚合更新(类似“老师收集所有学生的笔记重点,而不是收走笔记本”)。

Python代码示例(简化版联邦平均算法)

import numpy as np

# 假设用户1和用户2有本地数据,训练自己的模型参数

def local_train(local_data, initial_params):

# 模拟本地训练:用本地数据微调参数(实际是梯度下降)

return initial_params + np.random.normal(0, 0.1, size=initial_params.shape) # 加随机噪声模拟训练

# 服务器聚合参数

def federated_aggregate(client_params_list):

# 平均所有客户端的参数更新

return np.mean(client_params_list, axis=0)

# 初始化全局模型参数

global_params = np.zeros(10) # 假设模型有10个参数

# 模拟两轮联邦训练

for round in range(2):

# 客户端1和2用本地数据训练

client1_params = local_train("user1_data", global_params)

client2_params = local_train("user2_data", global_params)

# 服务器聚合参数

global_params = federated_aggregate([client1_params, client2_params])

print(f"第{round+1}轮全局参数:{global_params}")

关键逻辑:用户只上传“模型参数变化”,原始数据保留在本地,避免泄露。

差分隐私:给数据“打码”的保护术

差分隐私的核心是“添加可控噪音”,让单条数据的影响被“淹没”。例如:统计“有多少人感到抑郁”时,给结果加±5的噪音,这样没人能确定“小明是否在抑郁群体中”。

Python代码示例(拉普拉斯机制)

import numpy as np

def laplace_mechanism(data, epsilon):

# epsilon越小,隐私保护越强(但数据准确性越低)

sensitivity = 1 # 数据变化的最大可能差异(这里假设统计计数问题)

noise = np.random.laplace(0, sensitivity/epsilon)

return data + noise

# 真实抑郁人数统计(假设真实有100人)

real_count = 100

# 添加差分隐私噪音(epsilon=1)

private_count = laplace_mechanism(real_count, epsilon=1)

print(f"真实计数:{real_count}, 隐私保护后计数:{private_count:.2f}")

输出示例:真实计数:100, 隐私保护后计数:98.32(每次运行结果不同,因为噪音随机)

数学模型和公式 & 详细讲解 & 举例说明

联邦学习的数学基础:联邦平均(FedAvg)

联邦学习的核心是“客户端本地训练+服务器聚合”,数学上用加权平均聚合参数。假设共有K个客户端,每个客户端i的本地数据量为n_i,总数据量N=Σn_i,则全局参数更新公式:

Wglobalt+1=∑i=1KniNWit+1 W_{global}^{t+1} = \sum_{i=1}^K \frac{n_i}{N} W_i^{t+1} Wglobalt+1=i=1∑KNniWit+1

其中,Wit+1W_i^{t+1}Wit+1是客户端i在第t轮的本地更新参数。

举例:客户端A有100条数据,客户端B有200条数据(总300条)。A的参数更新是[0.1, 0.2],B的是[0.3, 0.4],则全局参数为:

Wglobal=100300[0.1,0.2]+200300[0.3,0.4]=[0.233,0.333] W_{global} = \frac{100}{300}[0.1,0.2] + \frac{200}{300}[0.3,0.4] = [0.233, 0.333] Wglobal=300100[0.1,0.2]+300200[0.3,0.4]=[0.233,0.333]

差分隐私的数学定义:ε-差分隐私

对于任意两条仅相差一条数据的数据集D和D’,以及任意输出结果S,满足:

P[M(D)∈S]≤eϵ⋅P[M(D′)∈S] P[M(D) \in S] \leq e^\epsilon \cdot P[M(D') \in S] P[M(D)∈S]≤eϵ⋅P[M(D′)∈S]

其中,M是添加噪音的机制(如拉普拉斯机制),ε是隐私预算(ε越小,隐私保护越强)。

举例:ε=1时,e1≈2.718e^1≈2.718e1≈2.718,意味着“某条数据是否存在”最多让结果概率变化2.718倍,攻击者无法确定单条数据的影响。

项目实战:代码实际案例和详细解释说明

开发环境搭建

我们模拟一个“AI心理助手”应用,需要实现:

- 情感分析(识别用户情绪)

- 隐私保护(用联邦学习训练模型,差分隐私处理日志)

环境要求:

- Python 3.8+

- 库:TensorFlow 2.0+(用于模型)、TensorFlow Privacy(差分隐私)、PySyft(联邦学习)

源代码详细实现和代码解读

步骤1:定义情感分析模型(简单LSTM)

import tensorflow as tf

from tensorflow.keras import layers

# 定义情感分析模型(输入是文本的词向量,输出是情绪概率)

def create_model(vocab_size=10000, embedding_dim=16, max_len=20):

model = tf.keras.Sequential([

layers.Embedding(vocab_size, embedding_dim, input_length=max_len),

layers.LSTM(32),

layers.Dense(1, activation='sigmoid') # 输出0-1(消极到积极)

])

model.compile(loss='binary_crossentropy', optimizer='adam', metrics=['accuracy'])

return model

解读:用LSTM处理文本序列,输出情绪概率(0=消极,1=积极)。

步骤2:添加差分隐私训练(用TensorFlow Privacy)

from tensorflow_privacy.privacy.optimizers.dp_optimizer_keras import DPKerasAdamOptimizer

# 定义差分隐私优化器(epsilon=10,delta=1e-5)

dp_optimizer = DPKerasAdamOptimizer(

l2_norm_clip=1.0, # 梯度裁剪,防止敏感信息泄露

noise_multiplier=0.5, # 噪音量(越大隐私越强,模型越不准)

num_microbatches=1, # 微批次数量(这里设为1简化)

learning_rate=0.001

)

# 用差分隐私优化器编译模型

dp_model = create_model()

dp_model.compile(loss='binary_crossentropy', optimizer=dp_optimizer, metrics=['accuracy'])

解读:传统优化器(如Adam)直接用梯度更新参数,差分隐私优化器会给梯度加噪音,防止攻击者通过梯度反推原始数据。

步骤3:联邦学习训练(用PySyft模拟)

import syft as sy

from syft import VirtualMachine

# 创建两个虚拟客户端(用户A和用户B)

client_a = VirtualMachine(name="client_a")

client_b = VirtualMachine(name="client_b")

clients = [client_a, client_b]

# 服务器获取客户端的指针(不传输数据)

client_a_ptr = client_a.login()

client_b_ptr = client_b.login()

# 初始化全局模型

global_model = create_model()

# 联邦训练轮次

for round in range(3):

# 分发全局模型到客户端

client_models = [global_model.send(client) for client in [client_a_ptr, client_b_ptr]]

# 客户端用本地数据训练(假设client_a有数据x1,y1;client_b有x2,y2)

for i, model in enumerate(client_models):

model.fit(clients[i].x, clients[i].y, epochs=1, batch_size=32)

# 客户端上传更新后的模型参数

updated_params = [model.get() for model in client_models]

# 服务器聚合参数(简单平均)

global_params = np.mean([model.get_weights() for model in updated_params], axis=0)

global_model.set_weights(global_params)

解读:模型在客户端本地训练,参数上传后平均,原始数据始终在客户端,避免泄露。

代码解读与分析

- 差分隐私:通过给梯度加噪音,即使攻击者拿到梯度,也无法还原原始数据(比如用户的具体聊天内容)。

- 联邦学习:数据“不出门”,服务器只聚合模型参数,保护用户本地的情绪数据。

实际应用场景

场景1:智能心理辅导APP

需求:分析用户聊天中的抑郁倾向,提供建议。

隐私风险:若“抑郁”标签被泄露,可能导致用户被歧视(如求职被拒)。

防护方案:

- 用联邦学习训练模型(用户聊天记录不上传)。

- 输出时只返回“需要关注”等模糊标签,不暴露具体情绪内容。

场景2:教育互动工具

需求:分析学生课堂发言的情绪(如困惑、专注),调整教学策略。

隐私风险:“长期困惑”标签可能被记录为“学习能力差”,影响学生评价。

防护方案:

- 差分隐私处理情绪统计结果(如“班级中20%±5%的学生困惑”)。

- 数据存储时去标识化(用“学生A”代替真实姓名)。

场景3:社交平台“情绪话题”推荐

需求:根据用户发帖的情绪(如“失恋”)推荐相关话题。

隐私风险:情绪数据被广告商获取,推送“分手挽回课程”等骚扰信息。

防护方案:

- 最小化数据采集(只分析当前帖子,不读取历史聊天)。

- 传输时加密(HTTPS),存储时用哈希值匿名化用户ID。

工具和资源推荐

隐私计算工具

- TensorFlow Privacy:谷歌开源的差分隐私库,支持在TensorFlow模型训练中添加隐私保护。

- PySyft:联邦学习框架,支持Python和PyTorch,适合快速搭建隐私保护训练系统。

- SecretFlow:蚂蚁集团开源的隐私计算框架,支持联邦学习、多方安全计算等。

合规参考

- GDPR(欧盟):规定“数据最小化原则”(只采集必要数据)、“被遗忘权”(用户可要求删除数据)。

- 《个人信息保护法》(中国):明确“敏感个人信息”(包括生物识别、医疗健康、情绪状态)的处理需额外授权。

学习资源

- 书籍:《隐私计算:原理与实践》《人工智能伦理与安全》

- 论文:《Deep Learning with Differential Privacy》(差分隐私经典论文)、《Communication-Efficient Learning of Deep Networks from Decentralized Data》(联邦学习奠基论文)

未来发展趋势与挑战

趋势1:隐私保护与模型性能的“平衡术”

当前联邦学习和差分隐私会降低模型准确率(比如加噪音后情绪识别可能出错),未来可能出现“自适应隐私”技术——根据数据敏感程度动态调整隐私保护强度(如“抑郁相关数据”用高隐私,“开心日常”用低隐私)。

趋势2:跨平台数据协作的隐私挑战

未来AI原生应用可能需要跨APP分析情绪(如社交APP+健康APP),如何在不共享原始数据的情况下联合训练模型(如“联邦学习+多方安全计算”)是关键。

挑战:对抗攻击的“道高一尺,魔高一丈”

攻击者可能设计更隐蔽的“模型逆向攻击”(通过模型输出反推训练数据),隐私防护技术需要持续升级(如“隐私水印”——在模型中嵌入标识,追踪数据泄露来源)。

总结:学到了什么?

核心概念回顾

- 情感分析:AI“读心术”,识别用户情绪。

- AI原生应用:从设计就依赖AI的产品,更需要情感数据。

- 隐私与安全:保护情绪数据不被泄露、滥用的技术(如联邦学习、差分隐私)。

概念关系回顾

情感分析是AI原生应用的“核心能力”,但处理情感数据时必须用隐私安全技术(联邦学习、差分隐私等)守护用户的“心情秘密”。就像“医生需要了解病人的病情(情感分析),但必须为病人保密(隐私安全)”。

思考题:动动小脑筋

- 如果你开发一个“儿童情绪陪伴机器人”,会在哪些环节重点保护隐私?(提示:儿童数据更敏感,GDPR有特殊规定)

- 假设你是用户,发现某APP的情感分析功能要求“读取所有聊天记录”,你会如何判断它是否过度采集数据?(提示:思考“必要原则”——是否必须要所有记录才能分析当前情绪?)

附录:常见问题与解答

Q:匿名化数据就安全了吗?

A:不一定。匿名化(如删除姓名)后的数据可能通过“关联攻击”重新识别(比如“用户A=25岁+北京+抑郁倾向”可能被关联到具体个人)。GDPR要求“匿名化数据”需达到“无法复原”的程度,否则仍算个人信息。

Q:联邦学习真的能完全保护数据吗?

A:联邦学习保护了“原始数据不传输”,但可能泄露“模型参数”中的信息(如参数变化可能暗示用户情绪趋势)。因此,通常会结合差分隐私(给参数加噪音)进一步保护。

扩展阅读 & 参考资料

- 《GDPR实用指南》(欧盟官方文档)

- 《Deep Learning with Differential Privacy》(https://arxiv.org/abs/1607.00133)

- TensorFlow Privacy官方文档(https://www.tensorflow.org/privacy)

- PySyft联邦学习教程(https://github.com/OpenMined/PySyft)

DAMO开发者矩阵,由阿里巴巴达摩院和中国互联网协会联合发起,致力于探讨最前沿的技术趋势与应用成果,搭建高质量的交流与分享平台,推动技术创新与产业应用链接,围绕“人工智能与新型计算”构建开放共享的开发者生态。

更多推荐

已为社区贡献10条内容

已为社区贡献10条内容

所有评论(0)