Diffusion十年演进

摘要: 扩散模型(2015-2025)从热力学启发的冷门算法发展为跨领域通用生成引擎,经历三大阶段:1)数学奠基期(2015-2019),基于物理扩散理论但效率低下;2)爆发期(2020-2022),DDPM和Stable Diffusion突破生成质量与速度,开启文生图时代;3)现实模拟期(2023-2025),DiT架构支持长视频生成与物理推理,成为机器人控制、生物制药的底层技术。2025年关

扩散模型(Diffusion Models) 的十年(2015–2025),是人工智能从“模仿概率分布”向“掌握创作本能”跨越的史诗进程。

扩散模型彻底终结了 GAN(生成对抗网络)在图像生成领域的统治,并成为 2025 年视频生成、具身智能世界模型和生物制药的底层算法架构。

一、 核心演进的三大阶段

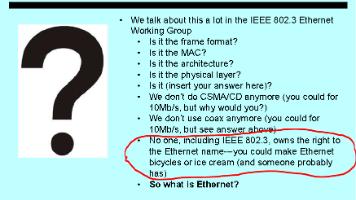

1. 数学起源与冷门期 (2015–2019) —— “物理学的灵感”

- 里程碑: 2015 年斯坦福大学提出 Deep Unsupervised Learning using Nonequilibrium Thermodynamics。

- 技术逻辑: 借鉴了热力学中的扩散过程。通过给图片**加噪(破坏信息)和去噪(还原信息)**来学习生成。

- 痛点: 此时的扩散模型生成质量远不如当时的 GAN,且推理速度极其缓慢,被视为学术界的冷门分支。

2. 生成爆发与 Stable Diffusion 时代 (2020–2022) —— “艺术的大众化”

-

核心突破:

-

DDPM (2020): 证明了扩散模型能生成比 GAN 更多样、更高质量的图片。

-

Latent Diffusion / Stable Diffusion (2022): 引入潜在空间(Latent Space),将计算压力从像素级降低到压缩空间,使得消费级显卡也能跑出 4K 大片。

-

意义: 开启了文生图(Prompt-to-Image)的元年,Midjourney 和 DALL-E 2 进入公众视野。

3. 视频生成与世界模型时代 (2023–2025) —— “模拟物理现实”

- 2025 现状:

- DiT (Diffusion Transformer): 2024-2025 年,扩散模型抛弃了传统的 U-Net,全面转向 Transformer 架构(如 Sora、Gen-3)。这让 AI 能够理解长视频中的物体一致性和复杂的物理交互。

- 具身智能底座: 扩散模型被用于机器人轨迹预测。机器人不再是死板地计算路径,而是通过扩散过程“生成”一段符合物理常识的动作序列。

- 实时生成: 通过 LCM (潜幻一致性模型) 技术,2025 年的扩散模型已能实现毫秒级实时生图。

二、 Diffusion 核心维度十年对比表

| 维度 | 2015 (物理探索) | 2025 (物理模拟器) | 核心跨越点 |

|---|---|---|---|

| 基础架构 | 简单的 MLP / CNN | DiT (Diffusion Transformer) | 规模化能力(Scaling Law)全面爆发 |

| 生成效率 | 数百步迭代 (极其缓慢) | 1-4 步蒸馏生成 (实时) | 解决了推理延迟的致命伤 |

| 理解深度 | 简单的纹理模仿 | 物理因果推理 (光影、重力) | 从“画得像”进化为“懂物理逻辑” |

| 应用领域 | 只有黑白低清小图 | 4K 视频、蛋白质结构、机器人控制 | 成为跨学科的通用生成引擎 |

| 安全控制 | 无 | eBPF 内核级审计 / 水印追踪 | 实现了生成内容的底层合规与防护 |

三、 2025 年的技术巅峰:eBPF 与实时视频流生成

在 2025 年,扩散模型已经深度嵌入到系统内核与实时应用中:

- eBPF 内核级算力调度 (Diffusion Orchestrator):

由于视频生成扩散模型对 GPU 显存和带宽消耗极大,2025 年的云端工程引入了 eBPF。

- 动态分片: eBPF 在内核层实时监控视频帧的生成进度。如果某个 DiT 算子导致渲染阻塞,eBPF 会瞬间将任务切片发送到负载更轻的 NPU 核心,确保实时通话中的 AI 背景替换无卡顿。

- Diffusion 作为“具身小脑”:

2025 年的机器人(如 Optimus Gen 3)使用 扩散策略 (Diffusion Policy) 来规划精细动作。相比传统控制,它能生成更丝滑、更具鲁棒性的避障动作。 - 零样本一致性控制:

利用 2025 年最新的 ControlNet 3.0,用户可以利用语音甚至眼神实时引导视频生成。系统通过 eBPF 审计下的超低延迟反馈链路,实现了真正的“意图即画面”。

四、 总结:从“去噪”到“构建现实”

过去十年的演进,是将扩散模型从一个**“数学上的除噪工具”重塑为“赋能人类创造力与机器智能的万能模拟器”**。

- 2015 年: 你在纠结如何用马尔可夫链证明去噪过程的收敛性。

- 2025 年: 你在利用扩散模型为你的电影生成一段长达 60 秒、符合所有物理常识且支持实时交互的 4K 场景。

DAMO开发者矩阵,由阿里巴巴达摩院和中国互联网协会联合发起,致力于探讨最前沿的技术趋势与应用成果,搭建高质量的交流与分享平台,推动技术创新与产业应用链接,围绕“人工智能与新型计算”构建开放共享的开发者生态。

更多推荐

已为社区贡献232条内容

已为社区贡献232条内容

所有评论(0)