无额外数据成本,性能提升显著!VLA“双脑”架构如何无痛碾压π0.5

多模态大模型(VLM)当前在多个领域产生了令人惊叹的落地应用,具身智能领域为了利用 VLM 在预训练期间学习到的通用视觉语义理解能力,将 VLM 作为基座来构建 Vision-Language-Action(VLA)模型,并希望这种预训练带来的通用语义能力能够让 VLA 实现通用具身。当下,以 VLM 为基座模型构建的策略,并使用大规模机器人数据训练,基本形成了当下 VLA 方案的标配。

多模态大模型(VLM)当前在多个领域产生了令人惊叹的落地应用,具身智能领域为了利用 VLM 在预训练期间学习到的通用视觉语义理解能力,将 VLM 作为基座来构建 Vision-Language-Action(VLA)模型,并希望这种预训练带来的通用语义能力能够让 VLA 实现通用具身。

当下,以 VLM 为基座模型构建的策略,并使用大规模机器人数据训练,基本形成了当下 VLA 方案的标配。

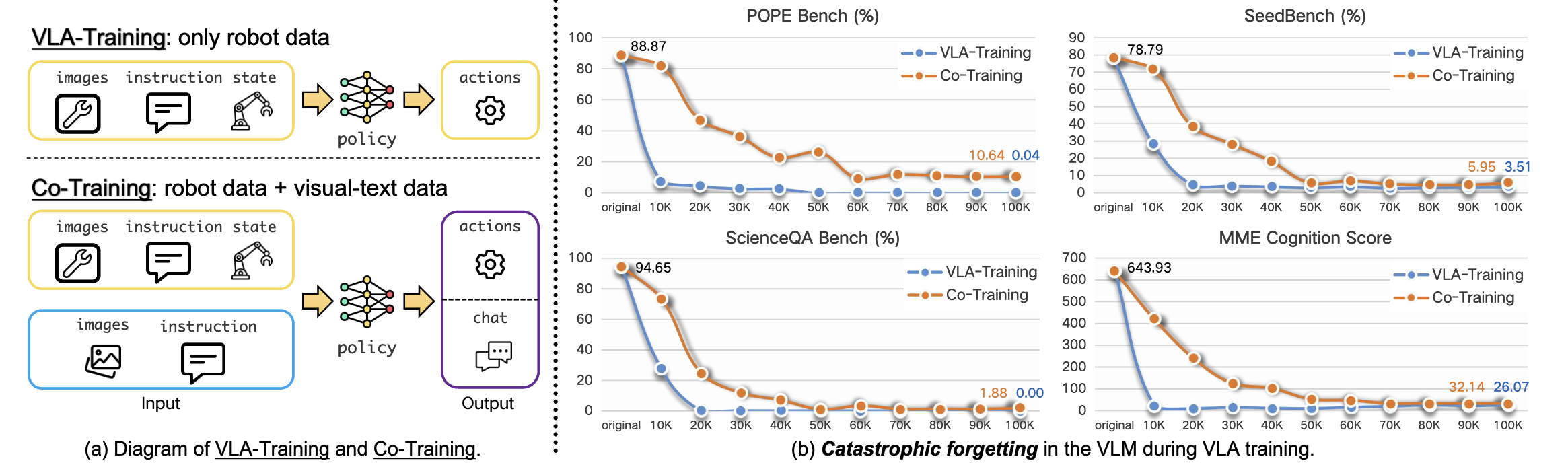

然而 VLA 领域依然存在一个很大的问题:“在训练过程中,VLM 部分在通用语义理解与具身机器人细粒度动作学习上好像始终只能二选一。 VLA 动作轨迹学习的同时,往往会导致基座模型的“灾难性遗忘”,这违背了以预训练 VLM 为基座来构建 VLA 模型的初衷。

不少团队期望通过大量的真机或仿真数据解决这个问题,然而具身数据成本高昂、采集周期长的问题让很多团队无法放开手脚。更为严重的是,我们是否已经“本末倒置”了?具身的通用性,是否只能通过海量轨迹数据提升?

(一)VLA 长久以来存在的“矛盾”:通用感知能力与丝滑动作学习的冲突

具身领域早期主要依赖专用机器人模型,直接学习动作映射,但带来的问题是“泛化能力不足”,难以适应复杂场景。随着VLM在多模态领域的能力提升,VLM开始被越来越多应用到VLA框架内。VLM也被期望提供对指令和环境的“精准理解”,通过该认知去学习更有效的动作。

但 VLM 模型的通用语义理解能力和下游机器人执行任务好像一直在”暗中较劲“,无法共赢。机器人任务的优化,与预训练模型的目标一直存在分歧,一个努力适配更通用的语义理解与生成,另外一个则是希望更精细的动作执行。更细致的来看,VLA 的的核心是将视觉语言输入转化为连续或者离散的动作,而 VLM 则是更关注视觉和语言的对齐与通用语义的理解。

可以想像,强迫一个模型去学习更垂直的信息,通用内容则会不可避免的损失掉,这也是模仿学习的弊病:“灾难性遗忘”。VLA 模型的能力,正在被这个看似不可消除的分歧“拉低”。

这种“两权相害取其轻”的局面,让很多团队都不知如何彻底解决。

(二)基座模型对通用具身任务“至关重要”

作为核心大脑,基座模型的能力对具身来说至关重要。牺牲通用能力去做轨迹拟合,无论是“科研式的摸索上限“还是“工程化落地”都不合适。这就引入了一个很有价值的问题,“单脑”VLA模型是否已经不符当下的业务和落地需求?

求木之长者,必固其根本;欲流之远者,必浚其泉源。具身这座大楼,想要建的更高,地基必须稳。绝大多数团队都不希望,反过来修复那些“没有解决的bug”。

而完成这一点,要把需要学习和需要保留的信息“冲突”问题解决,一条线路上解决不了,那就多条。这促使我们重新思考当前的路径:是否需要通过结构革新,从而更好地守护基座模型的核心价值?

(三)“两个大脑”让VLA能够“独立思考”,不依赖数据也能SOTA

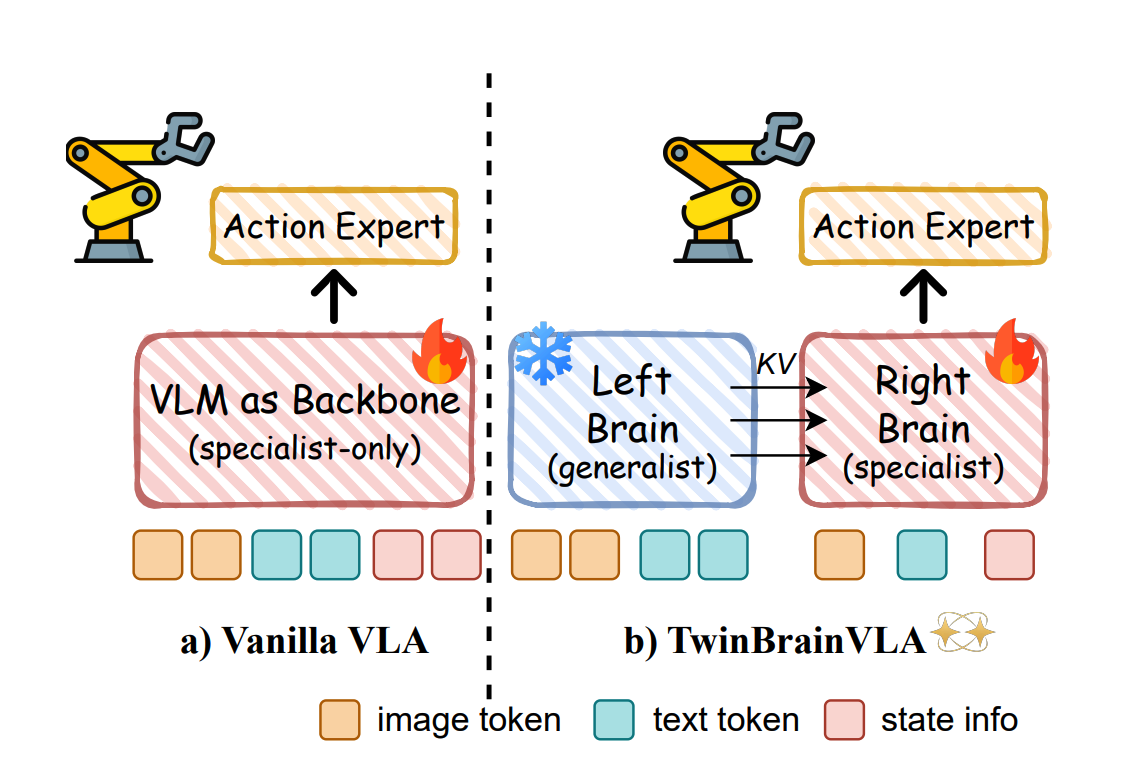

做个类比,人类可以通过左右脑来分开处理各类“可能互斥”的内容,而 VLM 正是 VLA 的大脑角色,那么 VLA 是否可以引入两个 VLM 呢?一个负责感知、一个负责动作的协调。训练的时候,再也不需要“迁就”彼此。

从性能提升上来说,VLA 应该模仿这种双大脑的结构,把自己打造成一个“认知和技能”都拉满的模型。

之前的 VLA 工作大多是采用训练策略和数据扩充来保证语义理解的泛化和策略细节,很少在模型结构上做改进。近日,一篇名为 TwinBrainVLA 的工作彻底打破这一格局。本工作的一作为俞斌,来自中关村学院,其导师陈凯博士,是中关村两院具身智能方向负责人、同时也是深度机智的创始人。

这篇工作创新性地使用两个大脑来提升基座模型的合理性,语义理解与策略学习互斥的问题不再是僵局。指标上也无痛超越pi0.5,这次彻底把基座模型的桌子掀翻了,VLA与具身的通用性问题正在被破解。这是对“模型能力聚于单一架构”这一行业惯性的挑战,证明了“分工协作”的结构可以释放更大的性能潜力。

- 论文链接:https://arxiv.org/pdf/2601.14133

- 项目链接:https://github.com/ZGC-EmbodyAI/TwinBrainVLA

1)左脑“通用”,右脑“专精”

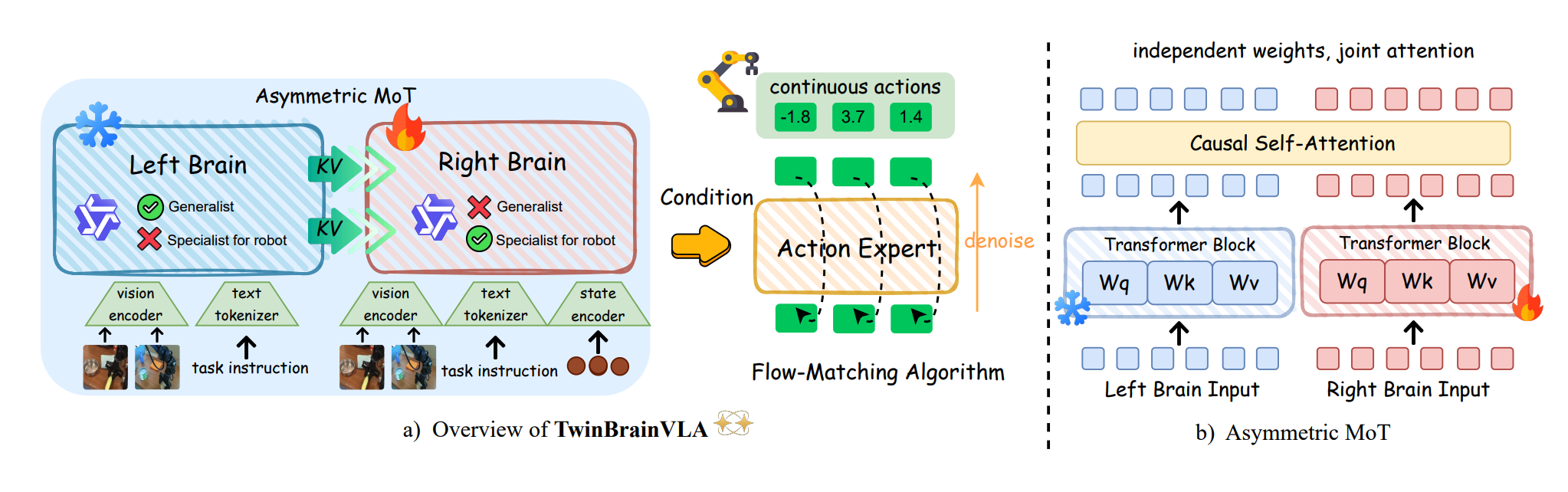

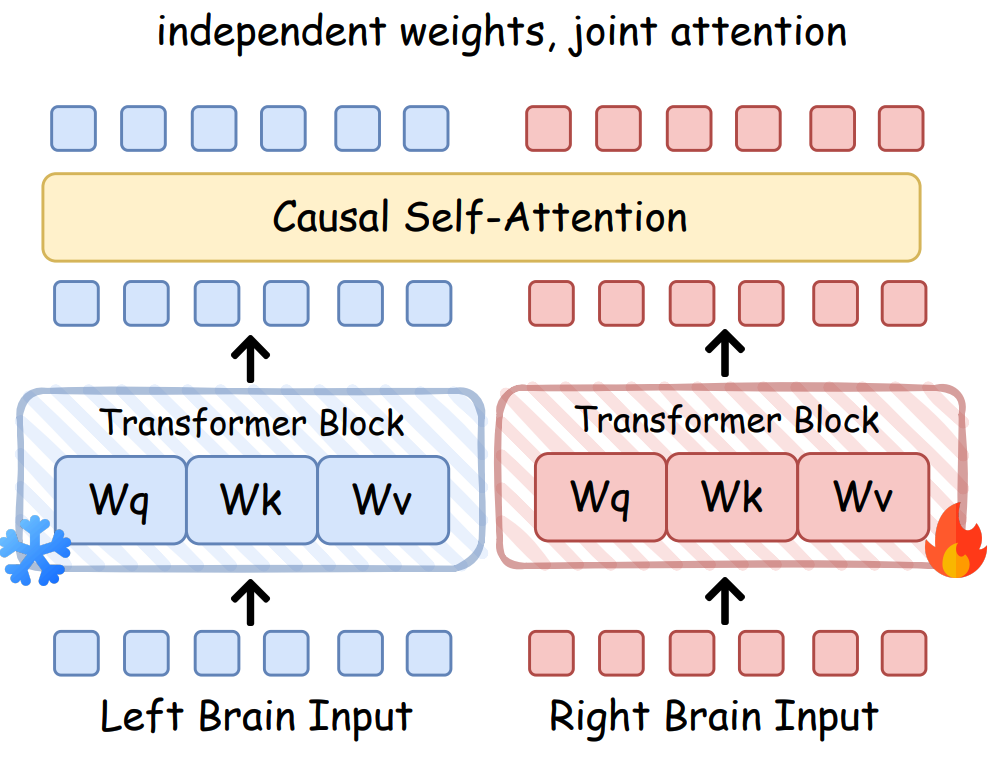

TwinBrainVLA 提出了适配 VLA 任务的两个关键 VLM 模块:语义理解部分和策略学习部分。其中,左脑专注于开放世界的视觉-语言理解,右脑则关注丝滑的机器人策略学习。

左脑作为纯粹的通用多模态大模型,仅接收视觉和语言的 tokens;而右脑负责具身控制,须以机器人的物理状态为基础。

2)两个大脑如何交互?如何避免灾难性遗忘?

如果两个VLM还能相互参考就真的太好了,优势互补可以发挥到极致。

TwinBrainVLA创新性提出了非对称 Transformer 混合方案:AsyMoT,让学习动作知识的VLM模型能够参考更多语义信息,同时保留策略学习的能力。具体实现上,左脑在训练过程中保持冻结状态,右脑则采用非对称联合注意力机制,不仅查询自己,也参考左脑的语义特征。

非对称机制保证了可训练的右脑能够关注左脑的冻结键值(KV)对,使通用语义知识能够转移到机器人控制策略,而不会产生灾难性遗忘。这表明,通过结构性的创新设计,可以实现通用性和专业性的共存。

3)基于流匹配的动作专家

TwinBrainVLA 采用 Diffusion Transformer(DiT)架构作为动作专家,这也是 pi0 的基础模型中使用的生成式策略架构,任务使用流匹配进行训练。

后期通过交叉注意机制,将来自能够在训练阶段进行参数更新的右脑空间信息丰富的表征注入到 DiT 中,策略学习可以很明确地由非对称的VLM输出信息引导。

4)如何训练保证任务的独立?

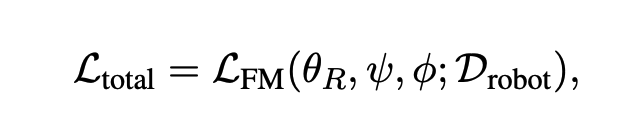

TwinBrainVLA 与 GR00T 一致,仅使用机器人动作目标来优化,最小化 Flow-Matching 损失:

其中 D r o b o t D_{robot} Drobot 是机器人数据, θ R \theta_R θR、ψ、φ 分别表示右脑、动作专家和状态编码器的可训练参数。训练过程中确保左脑参数的不更新,右脑则更新学习策略表示。TwinBrainVLA 的双流结构设计,让 VLA 模型在获得动作学习的同时,还能保留通用语义能力。

(四)仅提升基模的结构,超越具身领域主流方案

在机器人领域,通常认为性能的提升高度依赖于动辄数百万条的真实机器人操作数据。然而,TwinBrainVLA 证明了:通过保留 VLM 的通用语义信息能力,VLA 模型可以在不依赖超大规模机器人特定数据的前提下,仅用少量数据进行微调,即可实现对当前主流商业模型的全面超越,为数据效率提升提供了新的范本。

TwinBrainVLA 在两个仿真评测基准 SimplerEnv 和 RoboCasa 上进行了大量实验,分别选择了 Qwen2.5-VL-3B-Instruct 和 Qwen3-VL-4B-Instruct 作为基座模型。

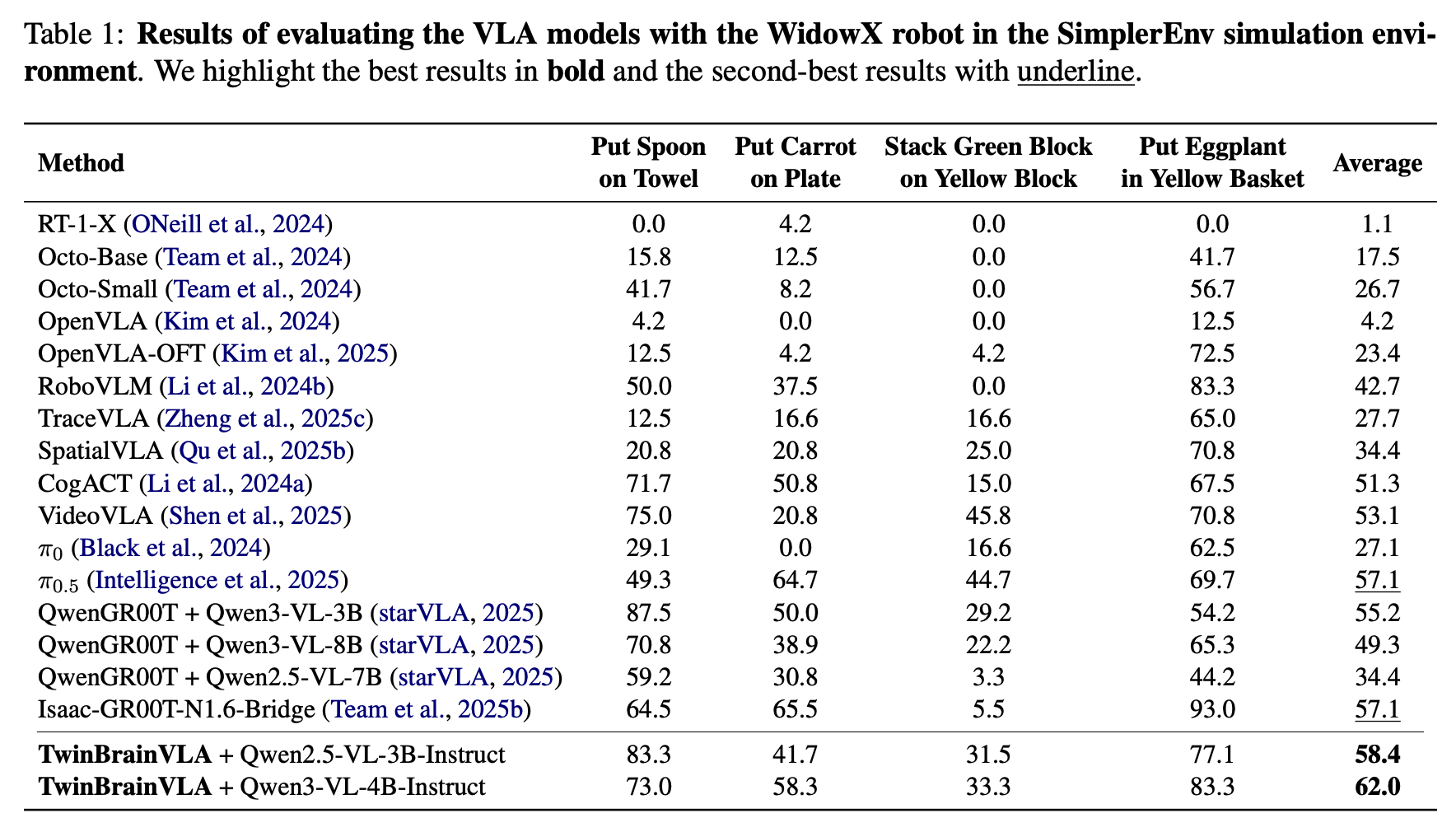

1)SimplerEnv 基准上,仅使用少量机器人数据微调,超越主流商业模型

SimplerEnv上的实验主要关注四个操作任务:“将勺子放在毛巾上”、“将胡萝卜放在盘子上”、“将绿色方块堆叠在黄色方块上”、“将茄子放入黄色篮子中”。

在 SimplerEnv 基准的对比结果分析上,TwinBrainVLA 与 π0、π0.5、NVIDIA Isaac-GR00T N1.6 等模型展开了对比,结果如下表所示:

相比于 pi0.5 和 GR00T 57.1% 的成功率指标,TwinBrainVLA 在 3B 模型下实现了 58.4%,4B 下实现了 62.0%。这也验证了双脑架构在连接高级语义理解和低级机器人控制方面的有效性。

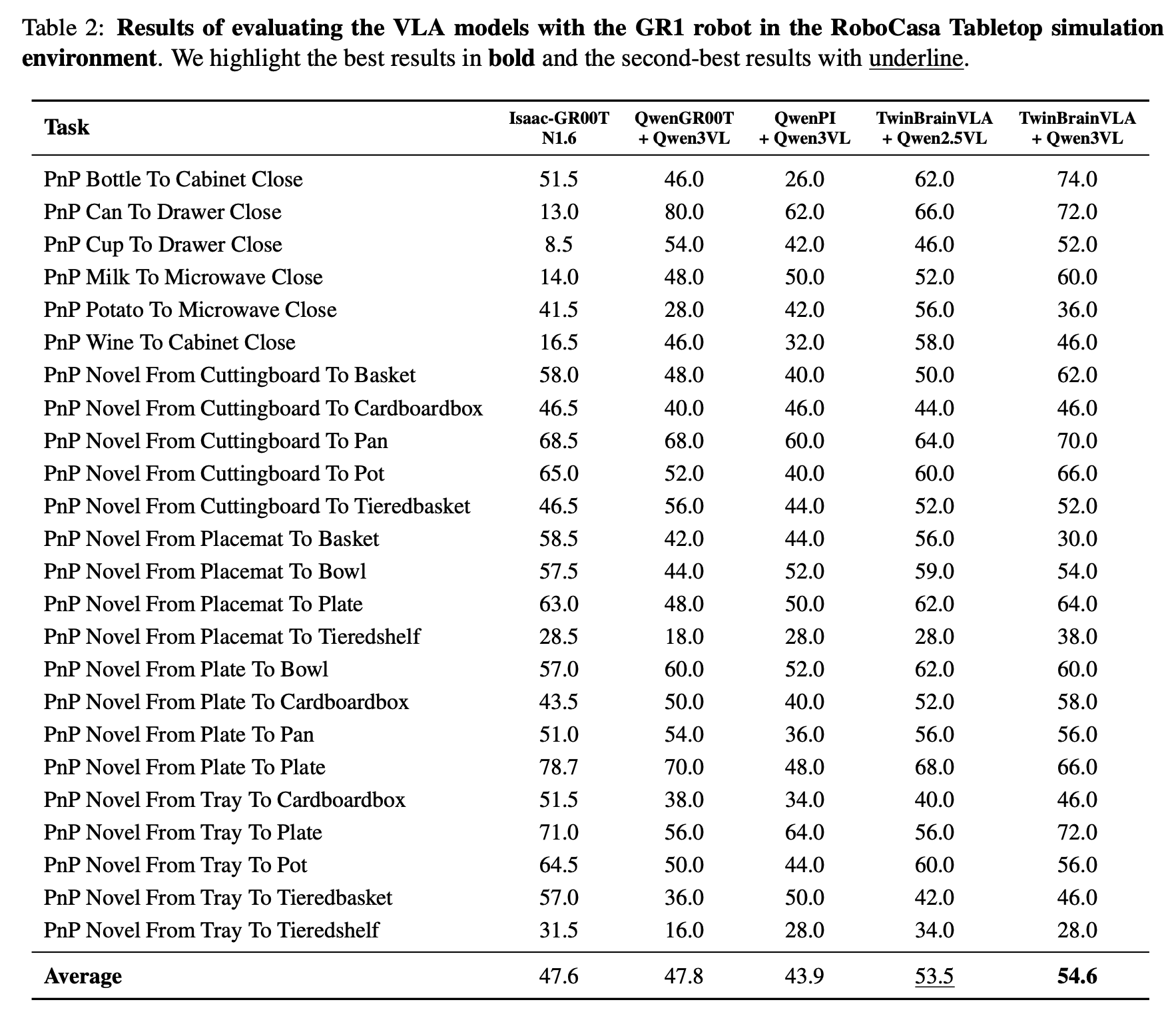

2)RoboCasa 的 24 个复杂操作任务,超越 NVIDIA 最新 GR00T 模型 7 个点

RoboCasa GR1 基准包含了 24 个多样化的桌面操作任务,主要是与铰接物体的复杂交互(比如微波炉、烤面包等)。TwinBrainVLA 与 NVIDIA GR00T-N1.6 模型进行了对比分析,并使用 Qwen3-VL-4B-Instruct 作为基座模型。

对比结果如下表所示,TwinBrainVLA 优势突出,复杂操作任务上的平均准确率最高达到54.6%,相比于 NVIDIA Isaac-GR00T 的47.8%提升明显。其中 Bottle To Cabinet Close 任务相比于其他两个模型提升最大。

(五)“好数据”是基座模型必不可少的“营养”

Twinbrainvla方案拉升了基座模型的想象空间,相比于训练策略和数据上的提升,结构上的创新则是为其它建设提供“更结实的底座”,由此带动的无痛涨点更具有价值。作为一个通用的方法,可以为各类VLA模型提供“通用语义与策略学习的基础信息”。

在基座模型之外,通用具身的路上还有一个很重要的高地:高价值数据。它也决定了具身机器人能在真实场景下“走多远”,这一点Twinbrainvla团队也在不断发力。

说起陈凯博士,他是中科大少年班出身,也是中科大-微软亚洲研究院联合培养博士,毕业后留任微软亚洲研究员。

在微软亚洲研究院期间,陈凯率先推动人工智能模型分布式训练规模从单机走向百卡、千卡级别。其提出和主导的多项关键技术被广泛应用于Office、Windows等核心产品体系,服务全球海量用户,为后续大模型时代的工程范式奠定了重要基础。

具身时代来临后,他开始将研究重心转到Physical AI上,致力于推动具身智能的通用性研究,并加入北京中关村学院和中关村人工智能研究院,担任具身智能方向的负责人和具身智能实验室主任。在中关村两院开展研究的期间,陈凯创办了深度机智这家公司,主攻通用具身智能。

“通用”这个事情确实难,很多人“不敢说”这两个字,因为不是在某个特定场景深耕,而是朝着通用智能水平提升去努力,但陈凯在短时间内就聚集了一个成熟的创始团队。

好的基座模型离不开数据,这一点基本是“行业共识”了。作为国内率先提出并坚持“人类第一视角数据”的技术leader,陈凯深知数据对基模的重要性。

我们可以看到,在GEN-0验证Scaling Laws之后,领域逐渐发现数据的质量和数量同样重要,数据一定要“可以用”。贴近人类智能,对齐人类与机器的感知逻辑,这样的数据才会好用。

深度机智一开始就从人类与物理世界的真实交互出发,构建了以第一视角、多维度、高质量人类交互数据为核心的数据体系,这也是他们不断“供给大脑的营养”。

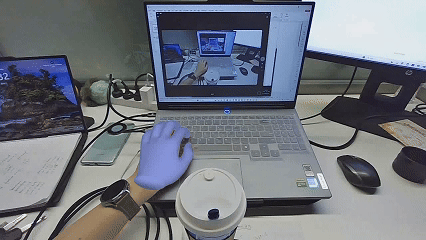

为在扩大数据规模的同时保障数据质量,团队采用了轻量化、非侵入式的采集方案,无需在手部佩戴任何机械装备,即可完整记录操作动作。该方式最大限度地减少了对操作者及环境的影响,使数据采集得以深入生产装配、日常家务与科学实验等多样化的真实场景,获取更贴近自然状态的高价值数据。

除此之外,陈凯的团队还构建了一套多模态对齐数据体系,让模型更全面地理解物理交互。

这样采集的数据,包含了人类真实环境下的操作直觉,比如力度、执行失误后的调整,节省了后期很多需要适配的成本。

目前,深度机智已在全国建立上百个数据采集点,覆盖多元任务环境,形成了规模化的数据采集网络,已经实现日均超1000小时的人类操作数据采集能力。

(六)具身的通用性,不能“本末倒置”

通用具身这条路虽然难走,但路线是清晰的:“必然构建于数据驱动的具备物理常识的基座模型之上”。相比于“短暂的创新”,具身真正需要的是能解决基础问题和提供建设基础的方案,本末倒置只会南辕北辙。

TwinBrainVLA作为深度机智与中关村两院的又一创新成果,有力证明了基座通用能力对于具身下游任务的重要价值,陈凯博士和他的团队正在沿着增强、保持、使用基座模型通用能力加速前进。

随着基模的能力与数据质量、数量的提升也必将不断拉升泛化上限,通用性只是时间问题。TwinBrainVLA的核心启示在于:在竞逐数据规模之前,先审视并革新模型结构,可能是通往通用具身一条更本质、更高效的路径。

具身求职内推来啦

国内最大的具身智能全栈学习社区来啦!

推荐阅读

从零部署π0,π0.5!好用,高性价比!面向具身科研领域打造的轻量级机械臂

工业级真机教程+VLA算法实战(pi0/pi0.5/GR00T/世界模型等)

具身智能算法与落地平台来啦!国内首个面向科研及工业的全栈具身智能机械臂

VLA/VLA+触觉/VLA+RL/具身世界模型等!具身大脑+小脑算法与实战全栈路线来啦~

MuJoCo具身智能实战:从零基础到强化学习与Sim2Real

Diffusion Policy在具身智能领域是怎么应用的?为什么如此重要?

1v1 科研论文辅导来啦!

DAMO开发者矩阵,由阿里巴巴达摩院和中国互联网协会联合发起,致力于探讨最前沿的技术趋势与应用成果,搭建高质量的交流与分享平台,推动技术创新与产业应用链接,围绕“人工智能与新型计算”构建开放共享的开发者生态。

更多推荐

已为社区贡献87条内容

已为社区贡献87条内容

所有评论(0)