论文阅读GigaBrain-0.5M*: a VLA That Learns From World Model-Based Reinforcement Learning

摘要

Vision-language-action (VLA) models that directly predict multi-step action chunks from current observations face inherent limitations due to constrained scene understanding and weak future anticipation capabilities.

In contrast, video world models pre-trained on web-scale video corpora exhibit robust spatiotemporal reasoning and accurate future prediction, making them a natural foundation for enhancing VLA learning.

Therefore, we propose GigaBrain-0.5M*, a VLA model trained via world model-based reinforcement learning.

Built upon GigaBrain-0.5, which is pre-trained on over 10,000 hours of robotic manipulation data, whose intermediate version currently ranks first on the international RoboChallenge benchmark.

GigaBrain-0.5M* further integrates world model-based reinforcement learning via RAMP (Reinforcement leArning via world Model-conditioned Policy) to enable robust cross-task adaptation.

Empirical results demonstrate that RAMP achieves substantial performance gains over the RECAP baseline, yielding improvements of approximately 30% on challenging tasks including Laundry Folding, Box Packing, and Espresso Preparation.

Critically, GigaBrain-0.5M* exhibits reliable long-horizon execution, consistently accomplishing complex manipulation tasks without failure as validated by real-world deployment videos on our project page.

结论

In this work, we present GigaBrain-0.5 and its world model-enhanced successor GigaBrain-0.5M*, advancing the frontier of VLA learning through large-scale pretraining and model-based RL.

GigaBrain-0.5, pretrained on over 10,000 hours of diverse robotic data, demonstrates state-of-the-art performance across eight internal manipulation tasks and 30 standardized tasks on the RoboChallenge benchmark, achieving a 51.67% average success rate and securing the top position on the public leaderboard.

Building upon this strong foundation, GigaBrain-0.5M* introduces a novel world model-conditioned architecture that leverages future state prediction to overcome the limited anticipation capabilities inherent in conventional VLA models.

By integrating model-based reinforcement learning through RAMP, our approach achieves robust cross-task generalization and reliably executes complex long-horizon tasks such as sequential box packing and espresso preparation.

Looking ahead, the GigaBrain series will investigate more efficient utilization of model rollout data to maximize the informational value of synthetic trajectories while minimizing computational overhead.

Furthermore, we aim to explore more scalable self-evolution paradigms that enable autonomous data curation, policy refinement, and world model updating through closed-loop interaction.

我将为您详细分析这篇关于GigaBrain-0.5M*的论文。这是一篇关于视觉-语言-动作(VLA)模型与世界模型结合的强化学习研究。

论文核心概述

GigaBrain-0.5M* 是由GigaAI团队开发的VLA模型,其核心创新在于通过基于世界模型的强化学习(World Model-Based RL)来解决传统VLA模型在长程任务规划中的局限性。该模型基于GigaBrain-0.5构建,后者在超过10,000小时的机器人操作数据上预训练,并在RoboChallenge基准测试中排名第一。

一、研究背景与动机

1.1 传统VLA的局限性

当前主流的VLA模型存在根本性缺陷:

- 短视性(Myopic):依赖即时观察进行长程动作规划

- 缺乏未来预测能力:无法有效预见未来状态

- 反应式控制:倾向于被动响应而非主动规划

1.2 世界模型的优势

视频世界模型在海量视频数据上预训练后,展现出:

- 强大的时空推理能力

- 准确的未来状态预测

- 丰富的物理先验知识

核心洞察:将世界模型的预测能力注入VLA,可显著提升长程任务执行能力。

二、方法论:RAMP框架

2.1 整体架构

┌─────────────────────────────────────────────────────────────┐

│ GigaBrain-0.5M* 架构 │

├─────────────────────────────────────────────────────────────┤

│ 输入层:Image + Video State + Text + Robot State + Advantage │

│ ↓ │

│ GigaBrain-0.5 (VLA Model) │

│ (Mixture-of-Transformers + DiT + Flow Matching) │

│ ↓ │

│ Robot Action Output │

│ ↑ │

│ World Model (Wan2.2 Backbone) │

│ 预测:Future State + Value Estimation │

└─────────────────────────────────────────────────────────────┘

2.2 RAMP四阶段训练流程

| 阶段 | 名称 | 关键操作 | 数据流 |

|---|---|---|---|

| Stage 1 | 世界模型预训练 | 训练世界模型预测未来状态和价值 | 预训练数据 → 世界模型 |

| Stage 2 | 策略条件训练 | 基于世界模型条件微调VLA策略 | 预训练数据 + (未来状态, 价值) → 策略 |

| Stage 3 | HILR数据收集 | 人机协同 rollout,专家干预纠正 | 策略 + 世界模型 → Rollout数据 |

| Stage 4 | 持续训练 | 用rollout数据联合训练世界模型和策略 | Rollout数据 → 世界模型 + 策略 |

2.3 关键技术细节

2.3.1 世界模型架构

- Backbone: Wan2.2(视频生成模型)

- 训练目标: Flow matching

- 联合预测: 未来视觉状态 + 价值估计

- 价值嵌入: 将价值信号作为额外潜在帧与视觉潜在状态拼接

状态表示:

s t = [ z t ; Ψ ( v t ) ; Ψ ( p t ) ] \mathbf{s}_t = [\mathbf{z}_t; \Psi(v_t); \Psi(\mathbf{p}_t)] st=[zt;Ψ(vt);Ψ(pt)]

其中:

- z t \mathbf{z}_t zt:时空视觉潜在状态

- v t v_t vt:价值估计

- p t \mathbf{p}_t pt:本体感受状态

- Ψ ( ⋅ ) \Psi(\cdot) Ψ(⋅):空间平铺投影

2.3.2 策略条件机制

策略接收两个辅助信号:

- 未来状态token z f u t u r e \mathbf{z}_{future} zfuture(经轻量级MLP投影)

- 价值估计 v t v_t vt → 转换为优势函数

优势计算(n-step TD估计):

A ( s t , a t ) = ∑ k = 0 n − 1 γ k r t + k + γ n v t + n − v t A(\mathbf{s}_t, a_t) = \sum_{k=0}^{n-1}\gamma^k r_{t+k} + \gamma^n v_{t+n} - v_t A(st,at)=k=0∑n−1γkrt+k+γnvt+n−vt

改进指示器(二值化):

I = 1 [ A ( s t , a t ) > ϵ ] I = \mathbf{1}[A(\mathbf{s}_t, a_t) > \epsilon] I=1[A(st,at)>ϵ]

2.3.3 训练目标函数

L ( θ ) = E D [ − log π θ ( a ∣ o , z , l ) − α log π θ ( a ∣ I , o , z t , l ) ] \mathcal{L}(\theta) = \mathbb{E}_{\mathcal{D}}\left[-\log\pi_\theta(a|\mathbf{o},\mathbf{z},l) - \alpha\log\pi_\theta(a|I,\mathbf{o},\mathbf{z}_t,l)\right] L(θ)=ED[−logπθ(a∣o,z,l)−αlogπθ(a∣I,o,zt,l)]

2.4 与RECAP的理论关系

论文证明 RECAP是RAMP的特例:

π R E C A P ( a ∣ o , I ) = ∫ z π R A M P ( a ∣ o , z , I ) p ( z ∣ o , I ) d z \pi_{RECAP}(a|\mathbf{o},I) = \int_z \pi_{RAMP}(a|\mathbf{o},\mathbf{z},I)p(\mathbf{z}|\mathbf{o},I)d\mathbf{z} πRECAP(a∣o,I)=∫zπRAMP(a∣o,z,I)p(z∣o,I)dz

关键区别:

- RECAP:仅使用稀疏二值优势信号(0/1),对未来做平均猜测

- RAMP:显式条件于世界模型预测的未来状态 z z z,实现精确规划

信息论优势:

H ( a ∣ o , z , I ) ≤ H ( a ∣ o , I ) H(a|\mathbf{o},\mathbf{z},I) \leq H(a|\mathbf{o},I) H(a∣o,z,I)≤H(a∣o,I)

引入时空潜在变量 z z z 显著降低了动作生成的条件熵。

三、实验结果分析

3.1 基础模型性能(GigaBrain-0.5)

内部评估(8项任务)

| 任务 | GigaBrain-0.5 | π0.5 | 提升 |

|---|---|---|---|

| Juice Preparation | 100% | ~90% | +10% |

| Boxes Moving | 90% | ~90% | - |

| Table Bussing | 100% | ~75% | +25% |

| Paper Towel Preparation | 95% | ~80% | +15% |

| Laundry Folding | 85% | ~80% | +5% |

| Laundry Collection | 70% | ~60% | +10% |

| Box Packing | 60% | ~50% | +10% |

| Espresso Preparation | 45% | ~35% | +10% |

关键发现:

- 在复杂长程任务(Box Packing, Espresso Preparation)上优势显著

- 在需要精细操作的变形物体任务(Laundry Folding)上表现稳健

RoboChallenge基准测试

- 排名:第1名(截至2026年2月9日)

- 平均成功率:51.67%

- 相比π0.5提升:+9%

3.2 世界模型价值预测性能

| 方法 | 推理时间(s) | MAE↓ | MSE↓ | Kendall↑ |

|---|---|---|---|---|

| VLM-based | 0.32 | 0.0683 | 0.0106 | 0.7972 |

| WM-based (仅价值) | 0.11 | 0.0838 | 0.0236 | 0.7288 |

| WM-based (状态+价值) | 0.25 | 0.0621 | 0.0099 | 0.8018 |

结论:联合预测未来状态和价值达到最佳平衡,Kendall相关系数最高(0.8018),表明价值估计与任务进度高度一致。

3.3 RAMP与基线对比

多任务泛化能力

世界模型条件在多任务训练中优势更明显:

- Box Packing任务在20k步时差距达**~30%**

- 表明世界模型条件有效促进跨任务知识迁移

RL方法对比(三项挑战性任务)

| 方法 | Box Packing | Espresso Preparation | Laundry Folding |

|---|---|---|---|

| GigaBrain-0.5 (Pretrain) | ~60% | ~40% | ~85% |

| + AWR | ~75% | ~55% | ~90% |

| + RECAP | ~62% | ~60% | ~90% |

| + RAMP (GigaBrain-0.5M*) | ~95% | ~90% | ~100% |

RAMP相比RECAP提升约30%(在Box Packing和Espresso Preparation上)

四、核心创新点总结

4.1 架构创新

- 世界模型-策略紧耦合:不同于以往仅将世界模型用于数据生成,RAMP将世界模型预测作为策略的条件输入

- 双模态推理:支持高效模式(无世界模型)和标准模式(有世界模型指导)

- 随机注意力掩码:训练时以p=0.2概率掩蔽世界模型token,防止策略过度依赖

4.2 训练创新

- 四阶段迭代闭环:预训练 → 条件微调 → 人机协同采集 → 持续学习

- HILR数据平滑:自动检测并去除人工干预边界的过渡伪影

- 乐观推理策略:部署时固定I=1,鼓励探索高价值动作

4.3 理论贡献

- 建立了RAMP与RECAP的数学联系,证明后者是前者的边缘化特例

- 从信息论角度论证了未来状态条件的必要性

五、局限性与未来方向

5.1 当前局限

- 世界模型推理开销(0.25s vs VLM的0.32s,仍有优化空间)

- 依赖稀疏奖励信号(仅 episode 级别成功/失败)

- 人机协同采集仍需人工干预

5.2 未来工作

- 高效利用模型rollout数据:最大化合成轨迹的信息价值

- 可扩展的自进化范式:实现自主数据筛选、策略精化、世界模型更新的闭环

- 更细粒度的奖励设计:超越稀疏episode级奖励

六、关键图表解读

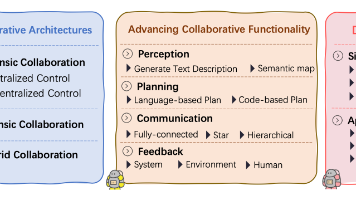

图1:整体框架

展示了数据流:多模态数据 → GigaBrain-0.5 + World Model → HIL Rollout → 持续训练

图2:RAMP四阶段

清晰展示各阶段的输入输出关系,强调闭环自我改进机制

图3:数据分布

- 总训练数据:10,931小时

- 真实世界数据:39.15%(4,280小时)

- 世界模型生成数据:60.85%(6,651小时)

- 包含自采集数据、Sim2Real迁移、视角迁移等多种来源

图13:价值预测可视化

在Laundry Folding任务中,当绿色衣物干扰折叠过程时,预测价值出现明显下降(黄框标注),移除干扰后恢复,证明世界模型能准确感知任务进度。

七、论文影响力评估

学术贡献

- SOTA性能:在RoboChallenge和8项内部任务上达到最佳

- 新方法范式:开创性地将世界模型预测作为VLA的条件输入

- 理论严谨性:提供了与现有方法(RECAP)的数学联系

工程实践

- 可扩展性:基于10K+小时数据的训练 pipeline

- 实用性:支持高效推理模式,适配实际部署需求

- 可靠性:在复杂长程任务(如Espresso Preparation)上实现零失败执行

八、关键结论

GigaBrain-0.5M*通过RAMP框架,首次实现了世界模型预测与VLA策略的深度融合,在长程复杂操作任务上相比现有最佳方法提升约30%,为机器人基础模型的自我进化开辟了新路径。

该工作标志着从"模仿学习"向"基于模型的强化学习"的重要转变,其核心思想——利用世界模型的未来预测能力增强策略的前瞻性——有望推广到更广泛的具身智能应用中。

DAMO开发者矩阵,由阿里巴巴达摩院和中国互联网协会联合发起,致力于探讨最前沿的技术趋势与应用成果,搭建高质量的交流与分享平台,推动技术创新与产业应用链接,围绕“人工智能与新型计算”构建开放共享的开发者生态。

更多推荐

已为社区贡献13条内容

已为社区贡献13条内容

所有评论(0)