AI原生应用领域微服务集成的容器化部署实践

AI原生应用(如智能推荐、图像识别、对话机器人)与传统软件不同,它需要高频模型迭代(每周甚至每天更新模型)、动态资源需求(推理负载随用户行为波动)、多服务协同(模型推理+数据清洗+日志监控)。传统部署方式(物理机/虚拟机)因环境一致性差、扩缩容慢、资源利用率低,已无法满足需求。本文将围绕“如何用容器化技术解决AI微服务部署痛点”展开,覆盖从单体服务容器化到集群化运维的全流程。本文从“为什么需要容器

AI原生应用领域微服务集成的容器化部署实践

关键词:AI原生应用、微服务集成、容器化部署、Docker、Kubernetes、服务网格、动态扩缩容

摘要:本文聚焦AI原生应用场景下的微服务容器化部署实践,从技术背景、核心概念到实战操作逐层拆解。通过生活类比与代码示例,帮助读者理解如何用Docker容器封装AI微服务,用Kubernetes实现自动化运维,并结合AI应用的动态特性(如模型热更新、弹性扩缩容)给出工程化解决方案。

背景介绍

目的和范围

AI原生应用(如智能推荐、图像识别、对话机器人)与传统软件不同,它需要高频模型迭代(每周甚至每天更新模型)、动态资源需求(推理负载随用户行为波动)、多服务协同(模型推理+数据清洗+日志监控)。传统部署方式(物理机/虚拟机)因环境一致性差、扩缩容慢、资源利用率低,已无法满足需求。本文将围绕“如何用容器化技术解决AI微服务部署痛点”展开,覆盖从单体服务容器化到集群化运维的全流程。

预期读者

- 初级/中级后端开发者(想了解AI应用部署的特殊性)

- 云原生工程师(需结合AI场景优化容器调度策略)

- AI算法工程师(关心模型服务如何高效落地)

文档结构概述

本文从“为什么需要容器化”切入,用快递柜类比容器技术;接着拆解AI微服务的容器化设计逻辑;通过Python+Docker+K8s实战演示部署过程;最后结合AI场景的动态特性(如模型热更新)给出优化方案。

术语表

| 术语 | 解释(小学生版) |

|---|---|

| AI原生应用 | 专门为AI能力设计的软件,核心功能依赖机器学习模型(比如“拍张照识别植物”的APP) |

| 微服务 | 把大软件拆成多个小模块(如“用户登录”“模型推理”“日志记录”),每个模块独立运行 |

| 容器(Docker) | 像“魔法快递盒”,把软件和它需要的“工具包”(环境、依赖)打包,在哪台电脑都能原样运行 |

| Kubernetes | 容器的“智能管理员”,自动管理成百上千个容器,保证它们“不罢工”“不挤兑” |

| 服务网格 | 容器间通信的“交通警察”,负责路由、监控、限流(比如保证“模型推理”服务不被挤爆) |

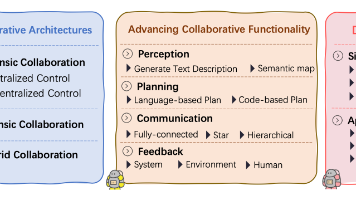

核心概念与联系

故事引入:开一家“智能奶茶店”

假设你开了一家“AI智能奶茶店”,核心功能是:

- 用户扫码下单(用户服务);

- 系统根据用户历史偏好推荐奶茶(推荐模型服务);

- 后厨机器人制作(制作服务);

- 记录订单和推荐效果(日志服务)。

早期你用“大厨房”模式(单体应用),所有功能挤在一台电脑上。但问题来了:

- 周末人多,推荐模型服务总“卡机”,但用户服务和制作服务却很闲;

- 升级推荐模型时,整个系统要停机,用户没法下单;

- 换了一台新电脑,环境配置错了,推荐模型跑不起来。

这时候,你想到用“快递盒模式”(容器化):把每个服务(用户服务、推荐模型、制作服务)分别装进独立的“魔法快递盒”(Docker容器),盒子里自带所需的“工具”(Python环境、TensorFlow库、模型文件)。然后雇一个“智能快递员”(Kubernetes),根据订单量自动搬盒子——人多了就多搬几个推荐模型的盒子,人少了就收回;升级模型时,只需要换推荐模型的盒子,其他盒子正常工作。

核心概念解释(像给小学生讲故事)

1. 容器(Docker):软件的“魔法快递盒”

想象你要寄一个玩具城堡,担心路上摔散,于是用盒子把城堡和所有零件(小铲子、胶水)一起打包。Docker容器就是这样的“魔法快递盒”:把软件(比如推荐模型服务)和它运行需要的所有东西(操作系统的小部分、Python库、模型文件)一起打包,不管拿到哪台电脑(Windows/Linux),都能原样运行,不会出现“在我电脑上能跑,在你电脑上不行”的问题。

2. 微服务:奶茶店的“分工小窗口”

以前奶茶店只有一个窗口,点单、做奶茶、收钱全挤在一起,人多就混乱。后来改成“点单窗口”“制作窗口”“收银窗口”,每个窗口只做一件事,效率更高。微服务就是把大软件拆成多个“小窗口”(用户服务、模型推理服务、日志服务),每个“小窗口”独立运行在容器里,坏了一个不影响其他。

3. Kubernetes(K8s):容器的“智能调度员”

如果有100个“魔法快递盒”(容器),怎么管理它们?K8s就像“智能调度员”:

- 自动复活:某个容器“罢工”(崩溃),它立刻再启动一个;

- 按需扩缩:点单的人多了,自动多启动几个“点单窗口”容器;

- 负载均衡:用户的请求不会全挤到一个容器,而是平均分配。

核心概念之间的关系(用奶茶店类比)

- 微服务与容器:每个“分工小窗口”(微服务)装进一个“魔法快递盒”(容器),保证每个窗口独立运行,互不干扰。

- 容器与K8s:“魔法快递盒”(容器)由“智能调度员”(K8s)管理,调度员根据订单量(负载)搬盒子、修盒子。

- 微服务与K8s:“分工小窗口”(微服务)的数量由调度员(K8s)动态调整,比如周末多开“推荐模型窗口”,平时少开。

核心概念原理和架构的文本示意图

AI原生应用架构(容器化微服务版)

┌───────────────┐ ┌───────────────┐ ┌───────────────┐

│ 用户服务容器 │ │ 推荐模型容器 │ │ 日志服务容器 │

│ (微服务1) │ │ (微服务2) │ │ (微服务3) │

└───────────────┘ └───────────────┘ └───────────────┘

▲ ▲ ▲

│ │ │

┌───────────────────────────────────────────────────────────┐

│ Kubernetes 管理平台 │

│ (负责容器的创建、销毁、扩缩、监控) │

└───────────────────────────────────────────────────────────┘

Mermaid 流程图:容器化部署流程

核心算法原理 & 具体操作步骤

AI原生应用的容器化部署核心是**“服务的可观测性”+“资源的动态调度”**。以下用Python实现一个简单的“图像分类微服务”,演示如何容器化并部署到K8s。

1. 微服务代码(Python Flask示例)

# app.py:图像分类微服务

from flask import Flask, request, jsonify

import tensorflow as tf

import numpy as np

app = Flask(__name__)

model = tf.keras.applications.MobileNetV2(weights='imagenet') # 加载预训练模型

@app.route('/predict', methods=['POST'])

def predict():

image = request.files['image'].read() # 接收用户上传的图片

img = tf.image.decode_image(image, channels=3)

img = tf.image.resize(img, (224, 224)) # 调整尺寸

img = tf.keras.applications.mobilenet_v2.preprocess_input(img) # 预处理

img = np.expand_dims(img, axis=0) # 增加批次维度

predictions = model.predict(img)

decoded = tf.keras.applications.mobilenet_v2.decode_predictions(predictions, top=3) # 解析结果

return jsonify({"result": decoded[0]}) # 返回前3个预测类别

if __name__ == '__main__':

app.run(host='0.0.0.0', port=5000) # 监听所有IP,端口5000

2. 容器化:编写Dockerfile

Dockerfile是“魔法快递盒的说明书”,告诉Docker如何打包微服务。

# Dockerfile

FROM python:3.9-slim # 基础镜像(空快递盒的“模板”)

WORKDIR /app # 容器内的工作目录(快递盒里的“客厅”)

COPY requirements.txt . # 把本地的依赖清单复制到容器

RUN pip install --no-cache-dir -r requirements.txt # 安装依赖(快递盒里装工具)

COPY app.py . # 把微服务代码复制到容器

COPY model/ ./model # (可选)如果模型文件不在代码里,单独复制

EXPOSE 5000 # 声明容器监听5000端口(快递盒开个窗口接收请求)

CMD ["python", "app.py"] # 启动命令(快递盒送达后自动运行的程序)

requirements.txt内容:

flask==2.0.1

tensorflow==2.8.0

numpy==1.22.3

3. 构建与运行容器(本地测试)

# 构建镜像(生成快递盒):-t指定镜像名(用户名/镜像名:版本)

docker build -t my-ai-service:v1 .

# 运行容器(启动快递盒):-p映射本地端口5000到容器端口5000

docker run -p 5000:5000 my-ai-service:v1

# 测试接口(另开终端)

curl -X POST -F "image=@test.jpg" http://localhost:5000/predict

4. 部署到Kubernetes集群

K8s通过Deployment(部署)和Service(服务)管理容器:

- Deployment:定义容器的副本数、镜像版本、升级策略(比如滚动升级)。

- Service:为一组容器提供统一访问入口(类似“奶茶店的总门铃”,不管有几个窗口,用户按门铃就会分配到空闲窗口)。

4.1 编写Deployment配置(deployment.yaml)

apiVersion: apps/v1

kind: Deployment

metadata:

name: ai-predictor # 部署名称

spec:

replicas: 3 # 初始启动3个容器副本(3个推荐模型窗口)

selector:

matchLabels:

app: ai-predictor # 匹配下面的Pod标签

template:

metadata:

labels:

app: ai-predictor # Pod的标签(用于Service关联)

spec:

containers:

- name: predictor-container # 容器名称

image: my-ai-service:v1 # 使用之前构建的镜像

ports:

- containerPort: 5000 # 容器暴露的端口

resources:

requests:

cpu: "1" # 每个容器至少需要1核CPU

memory: "2Gi" # 至少2GB内存

limits:

cpu: "2" # 最多使用2核CPU(防资源挤兑)

memory: "4Gi"

4.2 编写Service配置(service.yaml)

apiVersion: v1

kind: Service

metadata:

name: ai-predictor-service # 服务名称

spec:

selector:

app: ai-predictor # 关联所有标签为ai-predictor的Pod(容器)

ports:

- protocol: TCP

port: 80 # 服务对外暴露的端口(用户访问的端口)

targetPort: 5000 # 转发到容器的5000端口

type: LoadBalancer # (云环境)自动分配公网IP;本地测试用NodePort

4.3 部署到K8s集群

# 应用Deployment(创建容器副本)

kubectl apply -f deployment.yaml

# 应用Service(创建访问入口)

kubectl apply -f service.yaml

# 查看Pod状态(等待容器启动)

kubectl get pods

# 测试服务(获取Service的外部IP)

kubectl get service ai-predictor-service

curl -X POST -F "image=@test.jpg" http://<外部IP>:80/predict

数学模型和公式 & 详细讲解 & 举例说明

AI原生应用的容器化部署涉及资源调度优化,核心是解决“如何根据负载动态调整容器数量,同时最小化资源浪费”。这里可以用**排队论(Queueing Theory)**建模。

排队论模型:容器数量与响应时间的关系

假设AI推理服务的请求到达率为 λ \lambda λ(每秒请求数),单个容器的处理能力为 μ \mu μ(每秒处理请求数),则:

- 系统中的平均请求数(排队+处理): L = λ μ − λ L = \frac{\lambda}{\mu - \lambda} L=μ−λλ(当 λ < μ \lambda < \mu λ<μ时稳定)

- 平均响应时间(排队+处理): W = 1 μ − λ W = \frac{1}{\mu - \lambda} W=μ−λ1

如果部署 n n n个容器,每个容器的处理能力为 μ \mu μ,则总处理能力为 n μ n\mu nμ。当 λ < n μ \lambda < n\mu λ<nμ时,系统稳定。K8s的Horizontal Pod Autoscaler(HPA)会根据CPU/内存使用率或自定义指标(如QPS)调整 n n n,目标是让 λ ≈ 0.8 n μ \lambda \approx 0.8n\mu λ≈0.8nμ(预留20%冗余防止突发流量)。

举例:

假设单个容器处理能力 μ = 10 \mu=10 μ=10请求/秒,当前请求率 λ = 50 \lambda=50 λ=50请求/秒。则需要的容器数 n n n满足 n μ > λ n\mu > \lambda nμ>λ → n > 5 n>5 n>5。HPA会自动将副本数从3增加到6( 6 × 10 = 60 > 50 6×10=60>50 6×10=60>50),并保持一定冗余。

项目实战:代码实际案例和详细解释说明

开发环境搭建

-

安装Docker(打包容器):

- 官网下载Docker Desktop(Windows/macOS)或

apt install docker.io(Linux)。 - 验证安装:

docker --version。

- 官网下载Docker Desktop(Windows/macOS)或

-

安装Kubernetes(本地测试用Minikube):

- 安装Minikube:

curl -LO https://storage.googleapis.com/minikube/releases/latest/minikube-linux-amd64 && sudo install minikube-linux-amd64 /usr/local/bin/minikube。 - 启动集群:

minikube start。 - 安装kubectl(K8s命令行工具):

curl -LO "https://dl.k8s.io/release/$(curl -L -s https://dl.k8s.io/release/stable.txt)/bin/linux/amd64/kubectl" && chmod +x kubectl && sudo mv kubectl /usr/local/bin/。

- 安装Minikube:

源代码详细实现和代码解读

前面已给出app.py(微服务代码)、Dockerfile(容器打包)、deployment.yaml和service.yaml(K8s部署)的代码,这里补充关键细节:

-

模型热更新:AI模型常需要更新,传统方式是停机部署。容器化方案中,只需构建新镜像(如

my-ai-service:v2),然后通过K8s的滚动升级(kubectl set image deployment/ai-predictor predictor-container=my-ai-service:v2),逐个替换旧容器,保证服务不中断。 -

资源限制:

resources.requests是容器运行的“最低保障”(K8s会优先分配这些资源),resources.limits是“最高上限”(防止容器占用过多资源影响其他服务)。对于AI模型推理,GPU资源也可以通过nvidia.com/gpu: "1"声明(需集群支持GPU调度)。

代码解读与分析

- Dockerfile的

FROM python:3.9-slim:选择轻量的Python基础镜像(减小容器体积,加快部署速度)。 COPY requirements.txt . && RUN pip install...:先复制依赖清单再安装,利用Docker的分层缓存(如果依赖没变化,这一步不会重新执行,节省时间)。- K8s的

replicas:3:初始3个副本,保证高可用(一个容器挂了,K8s会自动启动新的)。

实际应用场景

1. AI推理服务的弹性扩缩

某电商的“商品图片分类”服务,平时每秒100请求,大促期间激增到1000请求。通过K8s的HPA(基于QPS自动扩缩),容器数从5个自动扩展到50个,大促结束后自动缩回,节省70%云服务器成本。

2. 模型AB测试

同时部署旧模型(v1)和新模型(v2)的容器,通过Service Mesh(如Istio)按1:1比例分发请求,对比两者的准确率和延迟,决定是否全量切换。

3. 训练任务的临时集群

AI训练任务(如神经网络训练)需要高计算资源但持续时间短。通过K8s的Job控制器,创建临时容器集群,训练完成后自动销毁,避免资源闲置。

工具和资源推荐

| 工具/资源 | 用途 | 推荐理由 |

|---|---|---|

| Docker Desktop | 本地容器开发调试 | 图形化界面+命令行,适合新手入门 |

| Minikube | 本地K8s集群搭建 | 轻量、快速启动,用于测试部署配置 |

| Istio | 服务网格(流量管理、监控) | 支持灰度发布、熔断、分布式追踪,适合复杂微服务场景 |

| Prometheus+Grafana | 容器与服务监控 | 可视化CPU/内存使用率、请求延迟,辅助HPA决策 |

| Harbor | 私有镜像仓库 | 安全存储Docker镜像(替代公共仓库,避免模型文件泄露) |

| NVIDIA Container Toolkit | GPU容器支持 | 让容器直接访问GPU,加速AI推理和训练(需集群安装NVIDIA驱动) |

未来发展趋势与挑战

趋势1:Serverless容器(如Kubeless、OpenFaaS)

传统容器需要管理集群,Serverless容器让开发者只需上传代码,平台自动处理扩缩容和资源管理。AI模型推理(尤其是低频率请求)适合这种“即用即走”模式,降低运维成本。

趋势2:AI与容器调度的深度结合

K8s未来可能集成AI预测算法,根据历史负载预测未来请求量,提前扩缩容器(比如预测“双11”前2小时请求激增,自动启动容器预热)。

挑战1:容器冷启动延迟

AI模型通常较大(如GPT-3有几十GB),容器启动时需要加载模型,可能导致冷启动延迟(几秒到几十秒)。解决方案:

- 预加载模型(容器启动后立即加载,而不是等第一个请求);

- 使用模型缓存(如Redis存储最近使用的模型);

- 采用轻量级模型(如DistilBERT替代BERT)。

挑战2:多集群管理(Multi-Cluster)

大型企业可能有多个K8s集群(不同地域、云厂商),如何统一管理容器部署、流量路由、监控?工具如Karmada(华为开源)提供多集群调度能力,但学习成本较高。

总结:学到了什么?

核心概念回顾

- 容器(Docker):打包微服务的“魔法快递盒”,保证环境一致性;

- 微服务:拆分AI应用为独立模块,便于独立升级和扩缩;

- Kubernetes:容器的“智能调度员”,自动管理容器的生命周期、扩缩容、高可用。

概念关系回顾

AI原生应用的容器化部署是“微服务拆分+容器打包+K8s调度”的组合拳:微服务解决功能解耦,容器解决环境一致性,K8s解决动态运维,三者共同应对AI应用的高频迭代和动态负载需求。

思考题:动动小脑筋

-

假设你的AI微服务镜像体积很大(10GB),部署时下载镜像很慢,有什么办法优化?(提示:多阶段构建、轻量基础镜像、分层缓存)

-

如果AI模型推理服务的延迟突然增加(比如从100ms到500ms),如何用K8s和监控工具定位问题?(提示:检查容器资源使用率、模型加载时间、网络延迟)

-

想实现“新模型上线时,先让10%用户使用,观察没问题再全量推广”,需要哪些工具或配置?(提示:Service Mesh的流量拆分功能,如Istio的VirtualService)

附录:常见问题与解答

Q:容器和虚拟机有什么区别?

A:虚拟机是“独立电脑”(包含完整操作系统),占用资源大(比如需要2GB内存启动);容器是“轻量沙盒”(共享宿主机操作系统内核),占用资源小(可能只需200MB内存)。AI应用需要快速扩缩容,容器更适合。

Q:K8s太难了,新手怎么入门?

A:先学基础概念(Pod、Deployment、Service),用Minikube本地搭建集群,跟着官方文档做“部署一个Nginx”的练习,再逐步尝试部署自己的AI微服务。推荐教程:K8s官方入门指南。

Q:模型文件应该放在容器镜像里吗?

A:不建议!模型文件(尤其是大模型)会让镜像体积膨胀,拉取时间变长。更好的做法:将模型存放在对象存储(如AWS S3、阿里云OSS),容器启动时从存储下载模型(或使用initContainer预先下载)。

扩展阅读 & 参考资料

- 《云原生技术入门与实践》(陈亮 著)—— 云原生基础概念。

- 《Kubernetes权威指南》(龚正 著)—— K8s深入实践。

- Docker官方文档:https://docs.docker.com/

- Kubernetes官方文档:https://kubernetes.io/

- AI原生应用白皮书:CNCF AI/ML SIG

DAMO开发者矩阵,由阿里巴巴达摩院和中国互联网协会联合发起,致力于探讨最前沿的技术趋势与应用成果,搭建高质量的交流与分享平台,推动技术创新与产业应用链接,围绕“人工智能与新型计算”构建开放共享的开发者生态。

更多推荐

已为社区贡献5条内容

已为社区贡献5条内容

所有评论(0)