具身智能十年演进

具身智能十年演进(2015→2025):从技能学习到平台化治理 过去十年,具身智能经历了从单一技能学习(RL/IL)到多任务泛化(多模态基准),再到可运营系统(VLA模型+数据闭环)的范式迁移。核心变化体现在: 训练方式:从仿真调参转向预训练+微调,吸收互联网知识(如RT-2模型); 数据引擎:从小规模实验升级为采集-筛选-场景化的闭环; 工程治理:仿真生产化(NVIDIA Isaac Sim)、

下面是**“具身智能十年演进(2015→2025)”的系统化总结。我会把它当成一场“从机器人学习(robot learning)到机器人基础模型(robot foundation models)再到可运营的具身系统(Robot SRE + 数据闭环)”的范式迁移来讲清楚:十年里最重要的变化,不是某个算法变强了,而是“智能的载体、训练方式、评测方法、以及工程化交付形态”**都换了一套。

0) 一句话总纲:具身智能的十年主线

2015:具身智能=在物理/仿真环境里做RL/IL(会做单一技能)。

2020:具身智能=多任务、多模态、仿真基准与数据驱动(会做一类技能)。

2025:具身智能=VLA/世界模型/通用策略雏形 + 平台化闭环(会迁移、会泛化、开始可运营)。

这里的关键词你可以记成四个“G”:

- Grounding:语言/视觉与动作的物理落地

- Generalization:跨任务/跨场景/跨机型泛化

- Governance:可控、可回滚、可验证(从研究走向产品)

- Growth loop:数据—训练—评测—部署—再采集的闭环增长

1) 三段式范式迁移:Skill Learning → Task Generalization → Foundation & Governance

1.1 2015–2017:技能学习时代(Skill Learning)

核心目标:让机器人“学会一个动作技能”(抓取、推拉、到达、简单导航)

典型形态

- 强化学习(RL)/模仿学习(IL)在仿真中快速迭代

- sim2real 仍然是主要痛点:摩擦、接触、传感噪声、外参漂移

- 任务定义偏“研究基准化”:reward 工程很重,泛化很弱

核心瓶颈

- 单技能能学会,但组合任务与长时序规划非常困难

- 数据效率低、部署不稳定、复现与评测不统一

这一阶段的“智能”很像:训练场里很强,上线就掉。

1.2 2018–2020:多任务、多模态与基准驱动时代(Task Generalization)

核心目标:从单技能走向“任务级能力”,并可在统一基准上比较。

结构性进展

- 具身AI基准/挑战赛推动:导航、指令理解、交互任务被系统化评测(这类“基准驱动研究”是具身智能的重要催化剂)

- 视觉+语言开始更紧密进入:从“看见障碍”到“理解指令与语义目标”

- 训练范式从“纯RL”逐渐转向 IL + RL + 规划的组合

核心瓶颈

- 数据仍然稀缺且分散:机器人数据昂贵、动作空间各异、复用困难

- 模型在“互联网知识”与“物理技能”之间存在巨大断层(knowledge-to-action gap)

这一阶段的核心矛盾是:没有足够统一、可迁移的具身数据与表征。

1.3 2021–2025:基础模型渗透 + VLA + 世界模型雏形 + 平台化治理(Foundation & Governance)

核心目标:让机器人具备“可迁移的通用能力”,并能进入规模化工程闭环。

这阶段最关键的变化有四个:

变化A:从 VLM 到 VLA ——“看懂”开始直接“会做”

代表性里程碑是把视觉-语言大模型转成“视觉-语言-动作”(VLA)模型:

- Google DeepMind 的 RT-2明确提出:将互联网规模的视觉语言预训练知识迁移到机器人控制上,让模型以端到端方式从观测映射到动作,并展现更强泛化与“涌现式”能力。([Google DeepMind][1])

这一步意味着:具身智能不再只是在小数据里学控制,而是开始吸收“世界知识”并转成行动先验。

变化B:具身“多模态大模型”成为研究主航道

2024–2025 大量工作围绕“具身多模态大模型/具身多模态基础模型”的数据、结构、挑战做系统总结与路线图(例如对 embodied multimodal large models 的时间线与问题拆解)。([arXiv][2])

变化C:仿真与合成数据升级为“生产系统”

仿真不再只是演示与调参,而是:生成训练数据、做回归门禁、做安全验证。像 NVIDIA Isaac Sim在“仿真+合成数据+可扩展流水线”方向持续强化,并在 2025 发布 Isaac Sim 5.0 GA(体现仿真生产化趋势)。([NVIDIA Developer][3])

变化D:从“会做”走向“可运营”——具身系统开始 SRE 化

当模型和系统复杂度上来,决定能否落地的关键变成:

- 证据链(metrics/logs/traces/replay)

- 场景库与回归门禁

- 灰度发布与自动回滚

- 自愈与降级策略库

也就是你前面一直在追的“平台化(协议/监控/日志/诊断)”那套治理体系,只不过对象从 AMR 扩展到“具身通用体”。

2) 十年里的“技术主干”演进:从四条线看透本质

2.1 表征:从任务状态 → 语义与几何统一表征 → 可行动表征

- 早期:状态/关键点/目标位姿为主(低维、任务专用)

- 中期:语义理解增强,开始面向导航/操作统一抽象

- 近年:VLA 强调“可直接用于动作生成”的表征:语言条件、视觉上下文、动作token/轨迹token

2.2 学习范式:RL/IL → 数据驱动 → 预训练 + 微调 + 工具链闭环

- 早期:RL占主导,但 reward 工程重、泛化弱

- 中期:IL+RL混合,多任务学习

- 近年:**预训练(互联网/多模态) + 机器人数据对齐(finetune)**成为主路;RT-2 就是典型范式展示。([arXiv][4])

2.3 数据:小规模实验 → 基准化数据 → “采集—筛选—回放—场景化”的数据引擎

真正的护城河从“模型结构”迁移到“数据引擎”:

- 在线触发采证(失败/险情/退化)

- 自动生成 replay bundle

- 抽象为 scenario 入库

- 回归门禁驱动迭代

这套闭环是具身落地的“工业化条件”。

2.4 仿真:调试工具 → 训练与验证工厂

仿真在 2021–2025 的角色发生质变:

- 合成数据规模化

- domain randomization 系统化

- 回归门禁与安全验证

Isaac Sim 这类平台明确把“仿真+合成数据”做成基础设施。([NVIDIA Developer][3])

3) 2025 具身智能的“真实形态”:不是一条端到端,而是“三层系统”

很多人把具身智能简化为“端到端从像素到力矩”。但工程上更现实、也更强的形态是三层:

- 技能层(Skills/Policies):抓取、开门、插拔、搬运、导航等

- 任务层(Task/Program):把技能编排成可执行计划(含恢复/回退)

- 治理层(Governance/SRE):证据链、回放、回归门禁、灰度、回滚、自愈

RT-2 代表“技能层通用化”的重要突破;仿真生产化与证据链闭环则让治理层成为可能。([Google DeepMind][1])

4) 十年里最关键的“瓶颈迁移”:护城河怎么变了?

2015 的护城河

- 算法技巧(RL trick、reward shaping)

- 单任务成功率

2020 的护城河

- 多任务系统整合(感知+语言+控制)

- 基准排名与可复现训练管线

2025 的护城河

- 数据引擎 + 评测体系 + 发布治理(而不仅是模型参数量)

- 机器人数据的采集、清洗、对齐、迁移

- 可运营能力:MTTR、自恢复率、复发率、事故半径

5) 2026–2030 方向:具身智能下一阶段最可能怎么走

我给你几个高确定性判断(偏工程与产业落地):

- 更强的“在设备侧运行”趋势:弱网/低延迟/安全要求会推动 VLA 模型更紧凑、更多 on-device(类似“把能力塞进机器人本体算力”)。近期也有媒体报道 DeepMind 推出面向机器人在设备端运行的模型/SDK方向(供趋势参考)。([The Verge][5])

- “世界模型/可预测模拟”会成为主战场:不仅做动作,还要预测接触、后果与不确定性

- 治理系统会决定规模化:具身系统必须像云服务一样有 SLO、灰度、回滚、证据链

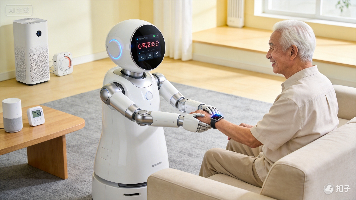

- 硬件形态多样化并长期共存:轮式、机械臂、双臂、人形会各自占据不同 ROI 场景,平台要解决“跨机型策略迁移”

DAMO开发者矩阵,由阿里巴巴达摩院和中国互联网协会联合发起,致力于探讨最前沿的技术趋势与应用成果,搭建高质量的交流与分享平台,推动技术创新与产业应用链接,围绕“人工智能与新型计算”构建开放共享的开发者生态。

更多推荐

已为社区贡献382条内容

已为社区贡献382条内容

所有评论(0)