MR6D:移动机器人6D姿态估计基准测试

25年8月来自德国多特蒙德大学、Fraunhofer IML和国际先进AI和 ML研究所(LAMARR)的论文“MR6D: Benchmarking 6D Pose Estimation for Mobile Robots”。现有的 6D 姿态估计数据集主要集中于小型家用物品,这些物品通常由机械臂操作,因此其与移动机器人的相关性有限。移动平台通常无需机械臂即可运行,需要与更大的物体交互,并且面临着

25年8月来自德国多特蒙德大学、Fraunhofer IML和国际先进AI和 ML研究所(LAMARR)的论文“MR6D: Benchmarking 6D Pose Estimation for Mobile Robots”。

现有的 6D 姿态估计数据集主要集中于小型家用物品,这些物品通常由机械臂操作,因此其与移动机器人的相关性有限。移动平台通常无需机械臂即可运行,需要与更大的物体交互,并且面临着远距离感知、严重的自遮挡以及多样化的相机视角等挑战。虽然最近的模型能够很好地泛化到未见过的物体,但评估仍然局限于类似家庭环境的场景,忽略了这些因素。MR6D是一个专为工业环境中移动机器人的 6D 姿态估计而设计的数据集。它包含 92 个真实世界场景,涵盖 16 个独特的物体,涉及静态和动态交互。MR6D 捕捉移动平台特有的挑战,包括远距离视角、多样化的物体配置、更大的物体尺寸以及复杂的遮挡/自遮挡模式。当前的 6D 流程在这些场景下性能不佳,而 2D 分割是另一个难题。 MR6D 为开发和评估针对移动机器人需求的姿态估计方法奠定了基础。

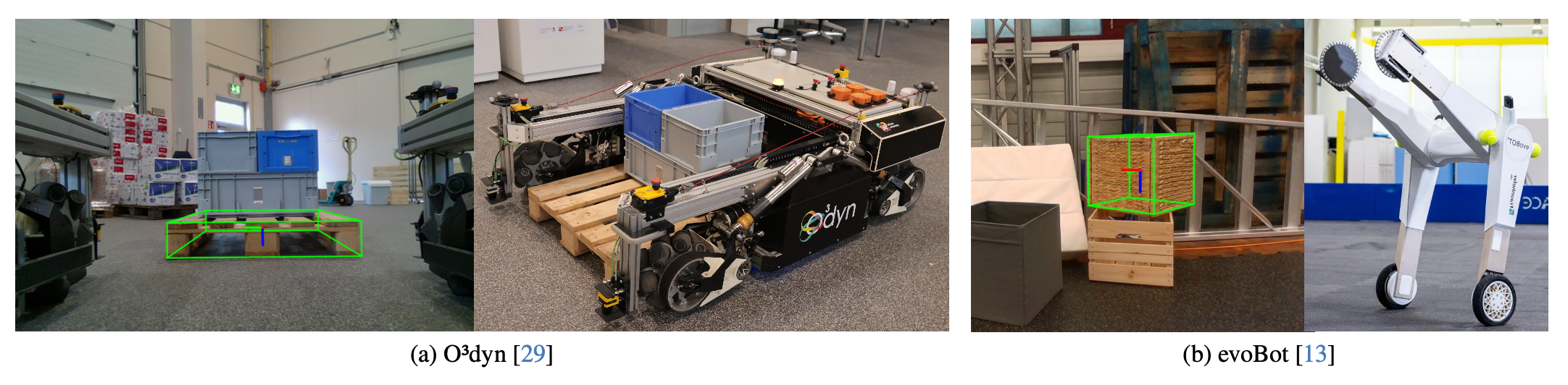

6D姿态估计对于机器人感知至关重要,它能够实现精确的物体定位和操作。现有数据集,例如[2, 4, 6–8, 12, 25, 30],推动了姿态估计研究的发展,但主要集中于小型家用物品,这些物品通常由机械臂操作,限制了它们在移动机器人中的应用。与机械臂不同,工业移动机器人依赖于针对其特定任务定制的专用抓取机构。如图展示两个开源移动机器人:O3dyn,一款用于高速托盘运输的全向机器人;以及evoBOT,一款用于仓库自动化的自平衡机器人。这两个平台展示工业移动机器人中存在的各种运动模式——从高速全向导航到敏捷的自平衡机动——从而提供移动机器人在实际环境中运行方式的典型示例。它们的运行凸显精确的6D姿态估计在实际移动机器人应用中的关键作用。

移动机器人的感知带来机械臂所不具备的挑战。机械臂以固定的向下视角观察物体,而移动机器人则会遇到各种不同的视角——从仰视到平视,视野受限。它们必须在更远的距离检测更大的物体,同时还要应对遮挡和极端视角,这增加了姿态估计的难度。远距离深度数据的稀疏或缺失进一步加剧物体识别和姿态估计的复杂性。

工业领域的移动机器人需要实例级的姿态估计。工业机器人通常执行重复性任务,速度和确定性执行比泛化能力更为重要。与需要跨物体类别进行广泛泛化的应用不同,工业机器人通常处理特定的已知物体。例如,机器人可能被编程为操作特定类型(实例)的托盘,例如欧标托盘,而不是处理所有可能的托盘设计。处理过程通常是针对预定义物体进行结构化和优化的。如果托盘类型发生变化,通常需要调整流程或任务执行方式,而不能仅仅依赖通用的姿态估计模型。因此,创建数据集时采用的是实例级姿态估计,而非类别级姿态估计。

为了应对这些挑战,引入一个专为移动机器人设计的新数据集。与现有专注于小型家用物品的数据集不同,该数据集捕捉各种环境下的大型物体。它包含静态和动态场景,其中物体的可见性、遮挡和视角会因机器人运动或外部因素而发生变化。这些方面——远距离检测、非标准视角和多样化的抓取机制——在现有数据集中代表性不足。通过整合这些方面,这个数据集为移动机器人感知提供一个更真实的基准。该数据集专注于与移动机器人相关的物体,包括托盘、储物箱和常见的消费品。它还包含同一物体的多个实例、紧密堆叠的配置以及颜色和纹理相似的物体,以测试检测和分割流程的鲁棒性。

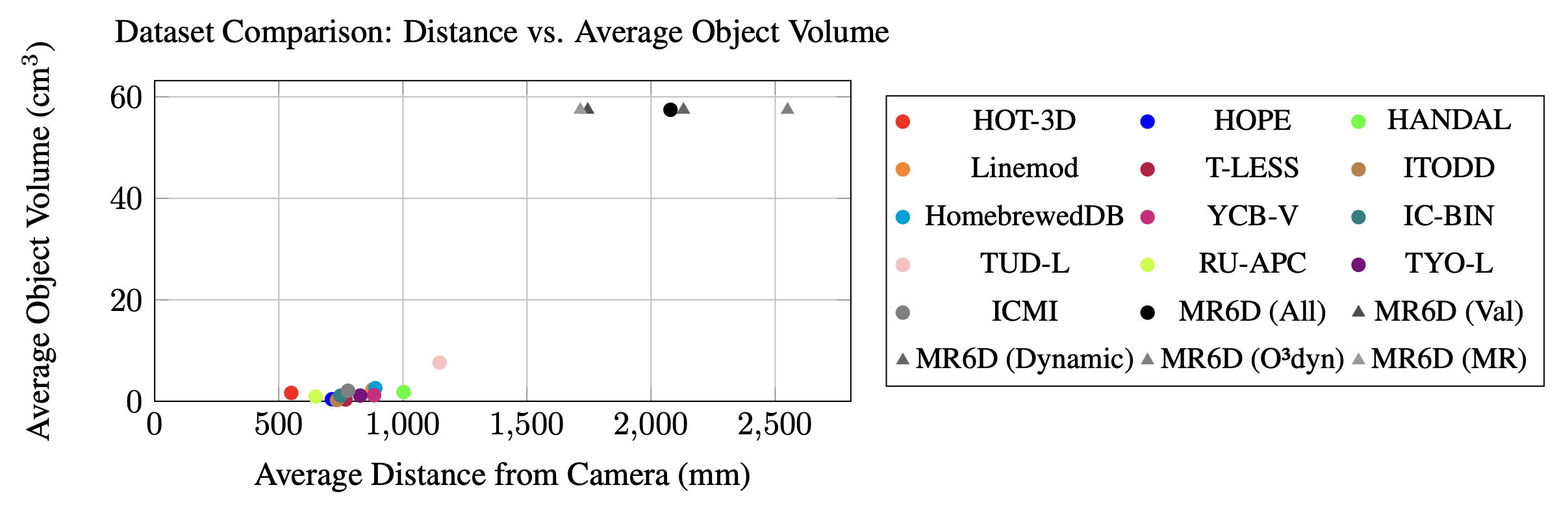

尽管一些数据集在6D姿态估计方面取得进展,但它们专注于小型家用物品,这限制它们在移动机器人领域的适用性。在移动机器人领域,物体通常更大,需要非标准操作,或者根本不由机械臂操控。MR6D通过引入更大的物体并捕捉移动机器人特有的挑战(例如远距离检测、多样化的相机视角和遮挡),弥补了这些不足,使其成为更适合实际应用的基准测试。如图显示 MR6D 包含更大的物体和更大的检测距离,这与现实世界移动机器人感知挑战相符。

MR6D 通过专注于与工业相关的物体和移动机器人特有的感知挑战(例如远距离检测和动态交互),对现有基准测试进行了补充。其实例级标注支持精确的、任务驱动的姿态估计,这在结构化的真实环境中至关重要。

物体与建模

MR6D 中物体的选择遵循两个主要标准:(1) 确保物体无法使用标准的双指或吸盘式抓取器抓取;(2) 优先选择标准化且全球通用的物体。如图展示数据集中包含的 16 个物体:

数据集包含一个欧标托盘,这是一种广泛使用的工业标准。此外,它还包含三个不同尺寸和颜色的欧标储物箱(KLT 箱),其中两个颜色相同,这给物体区分带来了挑战。还加入一个亚马逊基础款行李箱和 11 个宜家储物用品,确保所有选定的宜家产品至少在 2026 年底之前都可用,以支持可复现性和未来的研究。

对于所有物体,都提供高质量的 3D 网格模型。欧标托盘的网格是手动设计的,而其余物体则使用 BundleSDF [27] 重建。用于 BundleSDF 重建的 RGB 和深度图像由 Zivid 2 相机采集,该相机可提供高精度的深度测量。这种精度对于实现高质量重建至关重要,尤其与使用 RealSense 相机生成的重建结果相比。由于数据集不包含专用训练集,因此这些物体网格可用于生成用于可见物体 6D 姿态估计模型的合成训练数据,类似于 BOP 基准测试中其他使用 Blender-Proc [3] 的数据集。

采集环境和流程

MR6D 数据采集在多个环境下进行,每个子集均采用不同的相机设置。

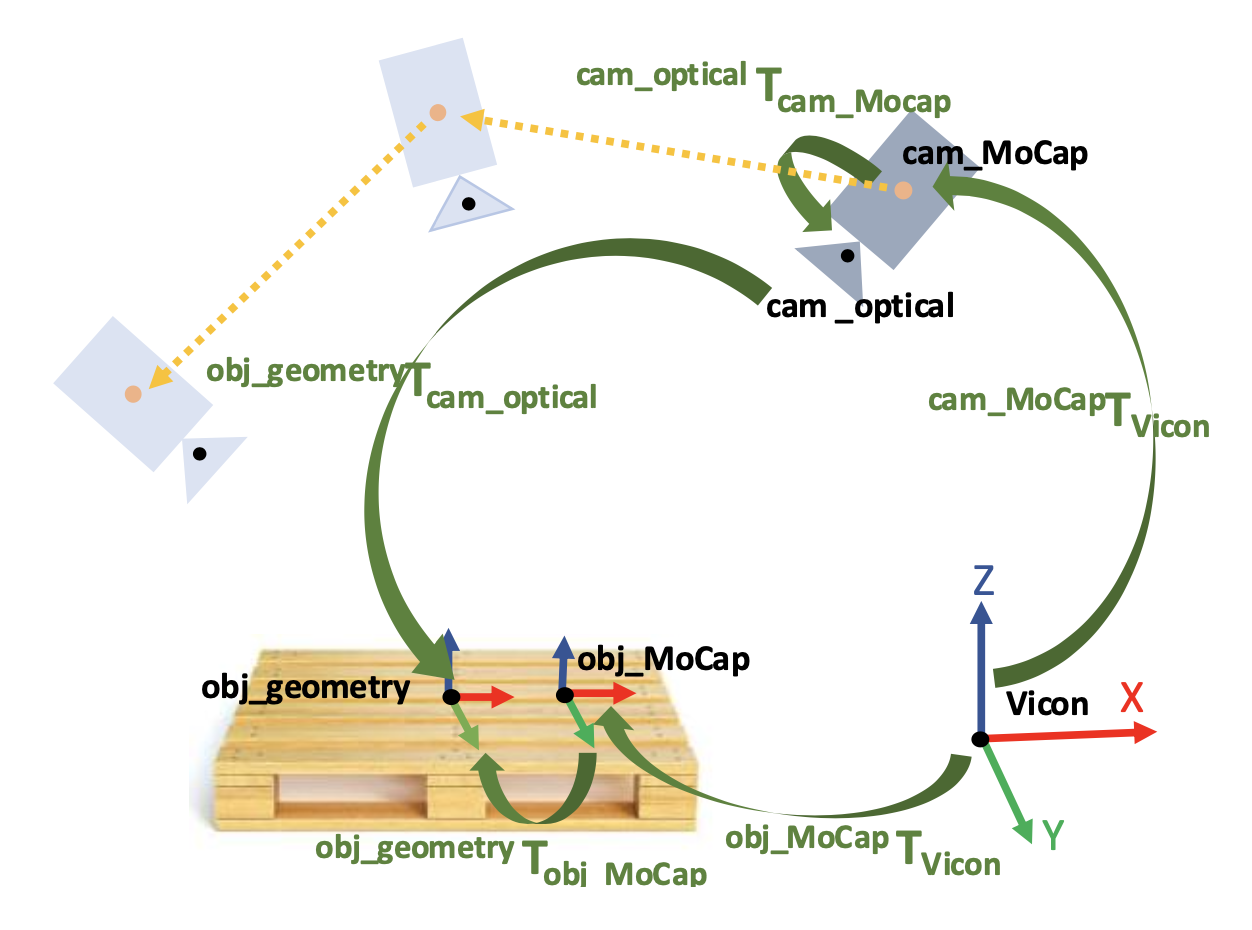

验证子集。该子集在一个研究大厅(机库建筑)内采集,其中包含一个 22×10 平方米的机器人训练场,配备有由 55 个摄像头组成的 VICON 运动捕捉系统。数据采集使用 RealSense D435i 摄像头,帧率为 30 FPS。摄像头由 VICON 系统进行跟踪。由于运动捕捉跟踪在摄像头上提供任意帧,因此使用 TSAI 方法 [24] 对 VICON 跟踪帧和摄像头光学帧进行眼手标定,如图所示(摄像头运动捕捉帧到摄像头光学帧)。

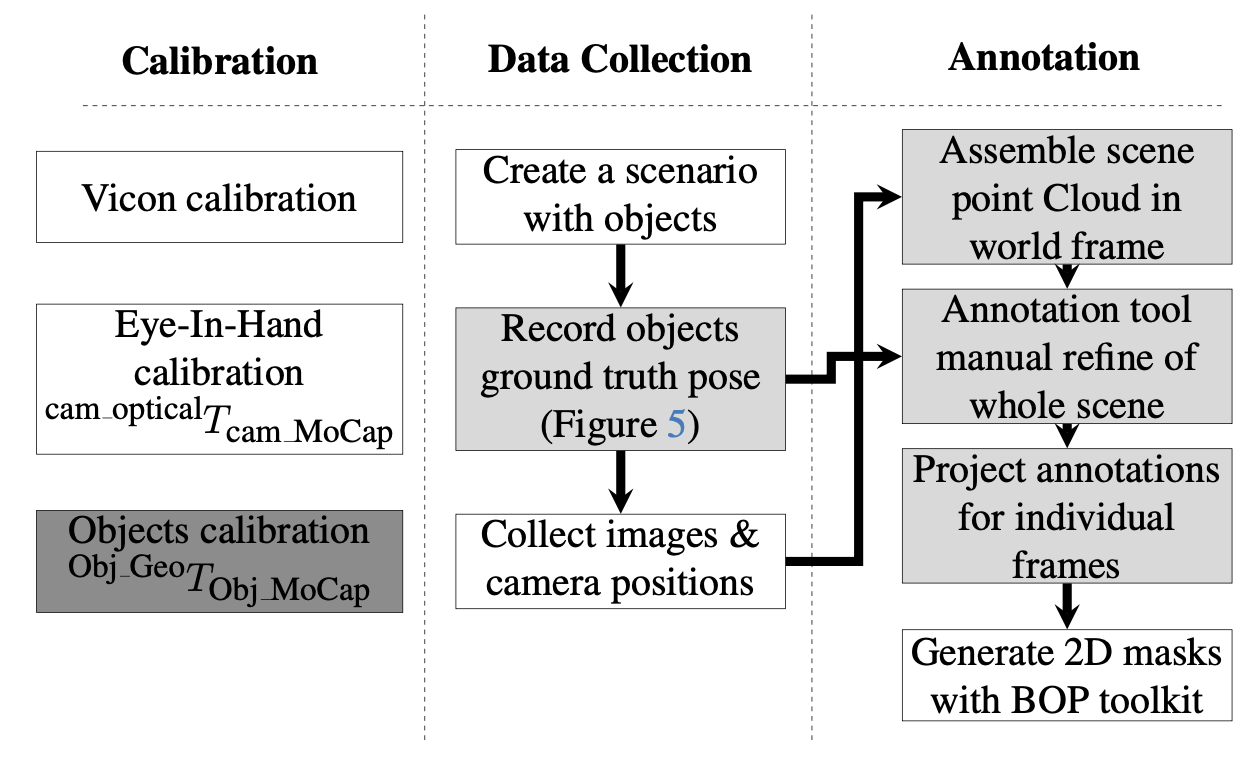

该子集中的物体是静态的。如图显示采集流程。

为了捕捉场景,放置物体并使用标记物记录其变换,如图所示。

初始标记并不精确,在数据采集后进行手动修正。此步骤是必要的,因为运动捕捉系统不跟踪物体,以避免在特写图像中出现明显的 VICON 标记。VICON 仅跟踪相机。场景是通过沿物体周围半圆形路径移动相机来捕获的。捕获场景后,使用相机轨迹组装全局点云,并使用 BOP 工具包 [10] 中的标注工具手动细化物体位置。这使得该子集的采集过程几乎完全自动化,唯一的手动步骤是最终的细化。最后一步使用已知的相机轨迹投影逐帧标注。

动态子集。该子集在一个与验证子集类似的实验室中采集,但机器人活动区域更大,尺寸为 30 × 15 平方米。该子集使用 Intel RealSense D435i 相机以 30 帧/秒的帧率采集。场景包括人与物体的交互(移动、搬运、拾取和存放),模拟机器人直接从人手中拾取物体的协作场景。这是唯一一个摄像机和物体都在运动的子集。摄像机与物体之间的平均距离保持在RealSense摄像机的最大测量范围附近。每个物体都配备了运动捕捉标记,并使用VICON运动捕捉系统进行跟踪,从而实现数据采集过程的完全自动化。为了防止这些标记被用于6D姿态提取,对于同一个物体,标记的位置会多次改变。执行与验证子集相同的手眼标定。还需要进行额外的标定——类似于摄像机标定——在VICON跟踪的物体坐标系(obj_MoCap)和网格模型中定义的物体几何中心(obj_geometry)之间进行标定。为了实现这一目标,用 VICON 跟踪技术采集每个物体的多帧图像,使用 BOP 标注工具手动对齐姿态,记录偏移量,并计算每个物体的标定值。这两个标定步骤确保精确跟踪并消除对齐误差。

O3dyn 子集。该子集使用机器人内置的 Intel RealSense L515 激光雷达相机以 30 FPS 的帧率进行采集,相机安装在离地 40 厘米处,以提供独特的低角度视角。场景在室内和室外不同光照条件下进行记录,包括阳光直射和阴影。由于检测距离较大且在阳光下深度严重下降,导致深度图像几乎为空,因此它是最具挑战性的子集。数据采集于类似工业环境的场景,例如小型仓库原型和车间地面。无法对机器人相机进行外部跟踪。初始相机轨迹由机器人的里程计估计得出。采集完成后,用 VGGT 模型 [26] 恢复相机轨迹和稀疏点云,VGGT 是一种用于多视图 3D 重建的前馈变换器。由于 VGGT 与传统的 SfM 一样无法恢复绝对尺度,因此使用基于里程计的轨迹来计算尺度因子。在里程计噪声较大的场景(例如,由于车轮打滑)中,使用扩展的 BOP 手动标注工具手动调整比例,利用已知的物体模型将点云与真实世界尺寸对齐。调整比例后,手动标注 6D 物体姿态,并将调整后的相机轨迹与这些姿态一起用于生成场景中所有物体的逐帧 6D 标注。

类似 MR 的子集。该子集使用 Intel RealSense D435i 相机以 30 FPS 的帧率捕获。采集过程与 O3dyn 子集类似,但缩放完全使用 BOP 手动标注工具手动完成。该子集模拟轮式机器人(例如 evoBOT)的运动。模拟运动从远处开始,接近物体,最后相机聚焦于其中一个物体——模拟机器人准备抓取物体的过程。

标注质量。用 Vicon 运动捕捉或 VGGT [26] 来跟踪相机和物体。某些场景中较大的物体距离会增加跟踪难度,并可能放大微小误差。静态子集通常具有较高的精度,因为其姿态稳定且位置固定;而动态子集可能会出现稍大的偏差,因为相机和物体是同时跟踪的,并且标记点可能会被遮挡。某些物体(ID 9、10 和 15)并非完全刚性,可能会发生轻微变形。此外,欧标托盘通常并非按照精确的标称尺寸制造,尺寸可能存在几厘米的误差。根据标注流程和视觉检查,预计静态场景的精度将在厘米级范围内。

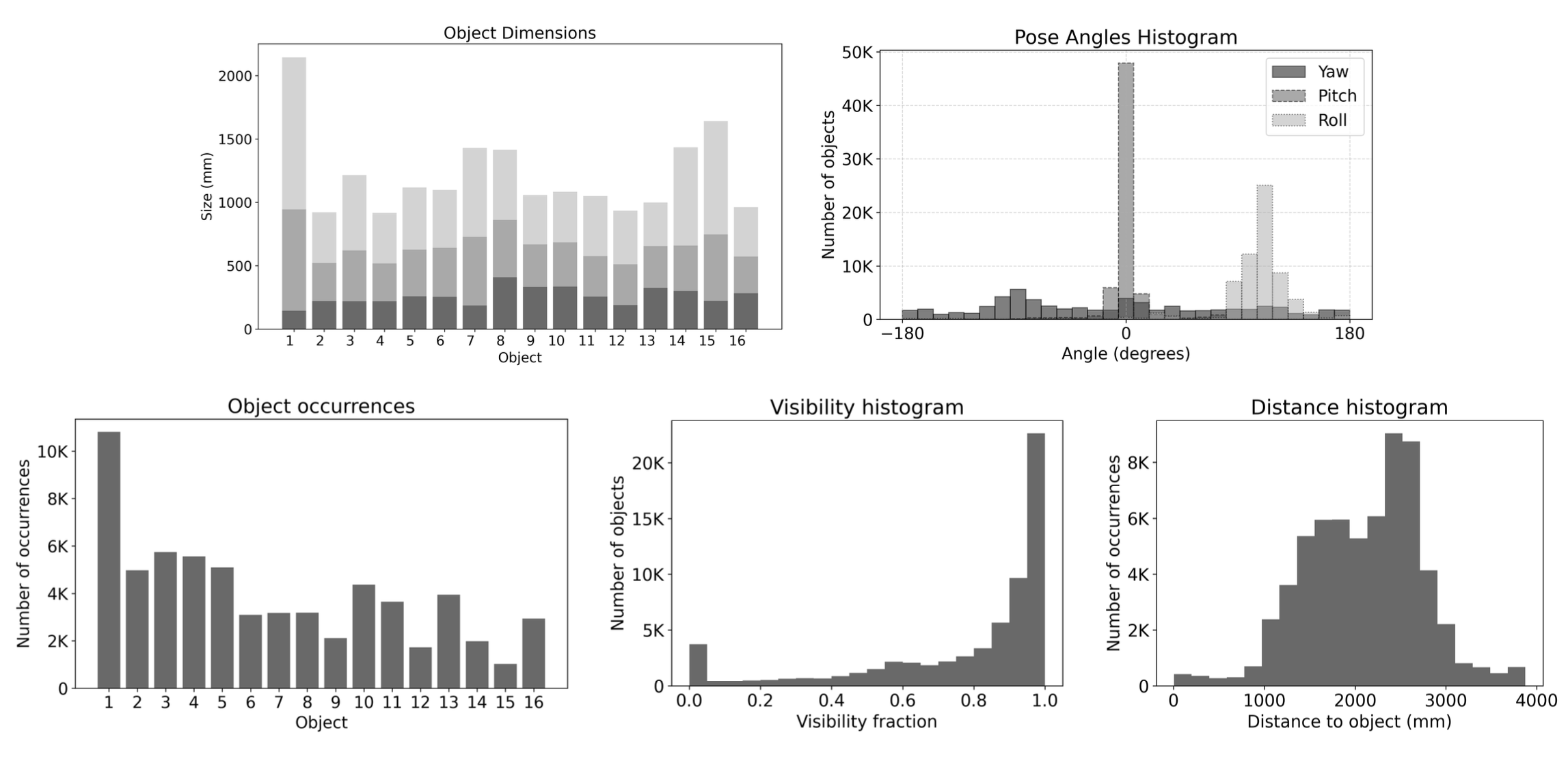

如图展示数据集的关键统计数据。MR6D 的大小与 BOP 基准测试中使用的测试子集相当。

DAMO开发者矩阵,由阿里巴巴达摩院和中国互联网协会联合发起,致力于探讨最前沿的技术趋势与应用成果,搭建高质量的交流与分享平台,推动技术创新与产业应用链接,围绕“人工智能与新型计算”构建开放共享的开发者生态。

更多推荐

已为社区贡献145条内容

已为社区贡献145条内容

所有评论(0)