一种用于机器人操作的通用单样本多模态主动感知框架:学习预测最优视角

26年1月来自南开大学和香港理工的论文“A General One-Shot Multimodal Active Perception Framework for Robotic Manipulation: Learning to Predict Optimal Viewpoint”。基于视觉机器人操作中的主动感知旨在将摄像头移动到信息量更大的观测视角,从而为下游任务提供高质量的感知输入。现有的大

26年1月来自南开大学和香港理工的论文“A General One-Shot Multimodal Active Perception Framework for Robotic Manipulation: Learning to Predict Optimal Viewpoint”。

基于视觉机器人操作中的主动感知旨在将摄像头移动到信息量更大的观测视角,从而为下游任务提供高质量的感知输入。现有的大多数主动感知方法依赖于迭代优化,导致耗时耗力,且与特定任务的目标紧密耦合,限制其迁移性。本文提出一种通用的单样本多模态主动感知框架,用于机器人操作。该框架能够直接推断最优视角,包含数据采集流程和最优视角预测网络。具体而言,该框架将视角质量评估与整体架构解耦,从而支持异构任务需求。最优视角通过对候选视角进行系统采样和评估来定义,之后通过域随机化构建大规模训练数据集。此外,开发一个多模态最优视角预测网络,利用交叉注意机制来对齐和融合多模态特征,并直接预测摄像头姿态调整。本文提出的框架应用于视角受限环境下的机器人抓取任务,能够显著提高抓取成功率。

姿态估计

与基于几何推理的传统分析方法[17]–[19]相比,基于深度学习的抓取姿态估计方法由于深度学习的进步[4],[20]–[24],在成功率、鲁棒性和泛化能力方面取得了显著提升。

根据用作网络输入的三维表示,现有方法大致可分为基于截断符号距离场(TSDF)的方法和基于点云的方法。Breyer[25]提出体素抓取网络(VGN),该网络以TSDF为输入,直接预测体素空间内的抓取质量、方向和宽度。此外,Yu[26]以VGN为基线,引入可信机器人抓取问题,并提出一种可信度对齐框架,以提高预测抓取概率与实际抓取成功结果之间的一致性。另一方面,Fang[27]提出一种基于点云的抓取网络,该网络以TSDF为输入,直接预测体素空间内的抓取质量、方向和宽度。 [27] 发布大规模点云抓取数据集 GraspNet-1Billion,并开发 GraspNet 抓取姿态估计框架,为通用物体抓取研究提供一个统一的基准。基于此基准,Fang [28] 进一步提出AnyGrasp,它利用跨视图几何一致性和物体质心建模来提高抓取稳定性。Wu [29] 提出 Economic Grasp,通过一种经济的监督策略选择关键训练样本,从而实现更高效的训练。

然而,大多数现有模型 [27]–[30] 都是为俯视视角下的桌面抓取而设计的。当直接应用于冰箱或橱柜等半封闭环境时,由于训练数据与实际应用场景之间存在显著差异,无法获得可靠的抓取姿态,因为这些环境无法提供俯视视角,且相机初始姿态随机。在视角受限的环境中,选择一个最优的观测视角来为抓取姿态估计模型提供更丰富的信息输入至关重要。

主动视觉

对于视点受限环境下的机器人抓取,主动感知能够获取更多信息丰富的物体观测数据,从而更好地支持抓取姿态估计。Breyer[7]提出一种由遮挡线索驱动的闭环次优视点规划策略,该策略逐步更新场景重建,并在线决定是继续观察还是执行抓取。Zhang[8]提出一种基于affordance驱动的次优视点方法(ACE-NBV),该方法在视点一致性假设下,利用新视点合成来预测未观测视点的抓取affordance分布,并通过最大化虚拟抓取质量来选择下一个视点。Ma[9]引入神经抓取场,该方法在相机运动过程中构建抓取分布的在线神经场表示,并通过瞄准高不确定性区域来规划下一个视点。

这些方法通常需要多个优化步骤才能达到期望的观测视点,这会增加时间和运动成本。此外,此类方法与机器人抓取紧密耦合,难以推广到其他任务。

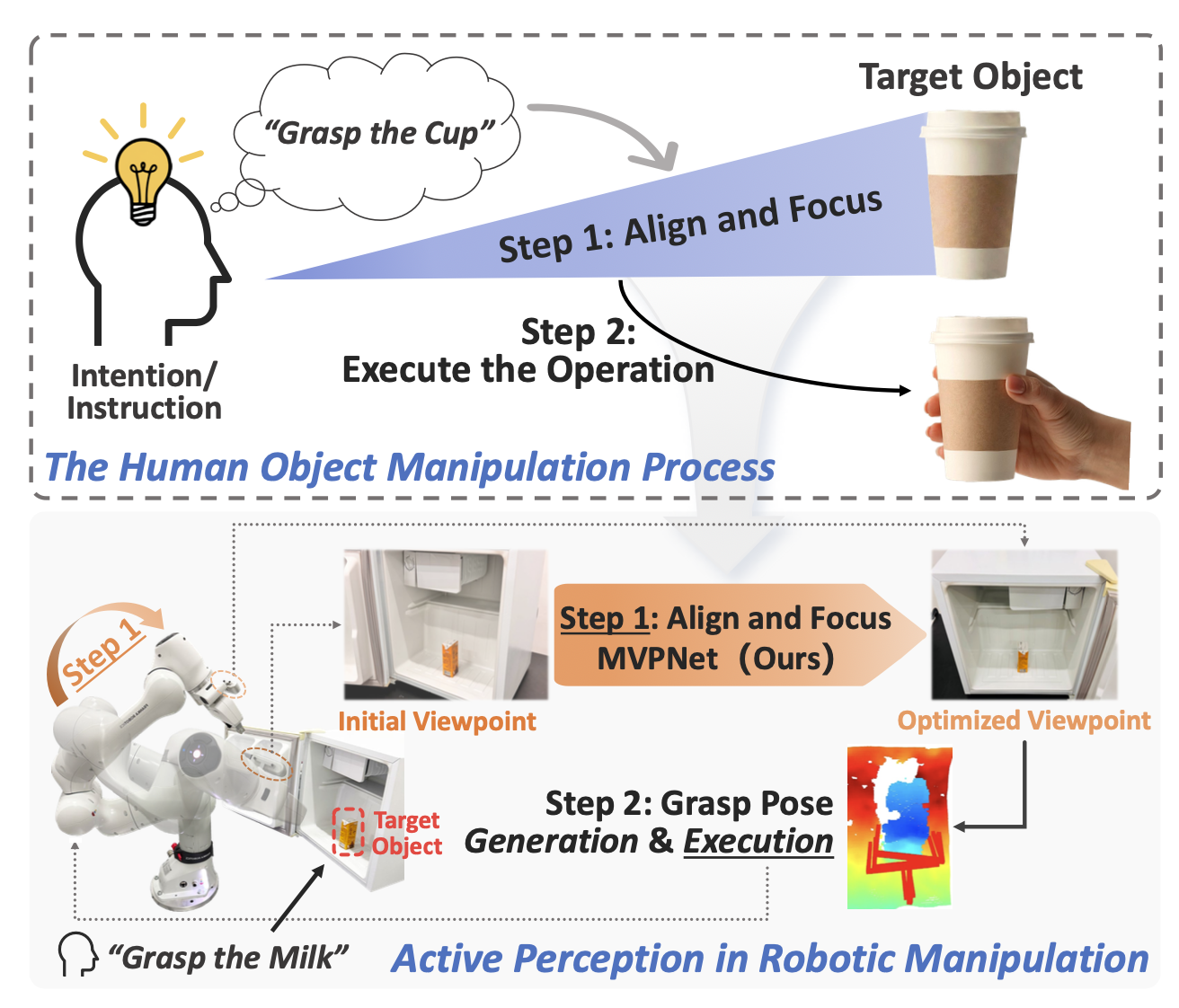

通过单样本视角调整实现有效的感知,仍然是一个具有挑战性的问题。为了解决这个问题,从人类执行日常任务的方式中汲取灵感。当任务意图或指令出现时,人类通常首先调整自身位置并朝向任务目标,将注意力集中在相关区域[13]。这种行为使他们能够获取更全面、更具区分性的信息,从而促进后续行动[2],[14],如图所示。

值得注意的是,这种调整过程通常只需一步即可完成。这种效率归功于人类长期积累的经验[15],[16],使他们能够直接判断哪些视角有利于感知目标物体。相比之下,现有的机器人系统通常缺乏这种单样本感知能力,而且尚未建立一个能够统一建模各种任务场景下这种能力的框架。

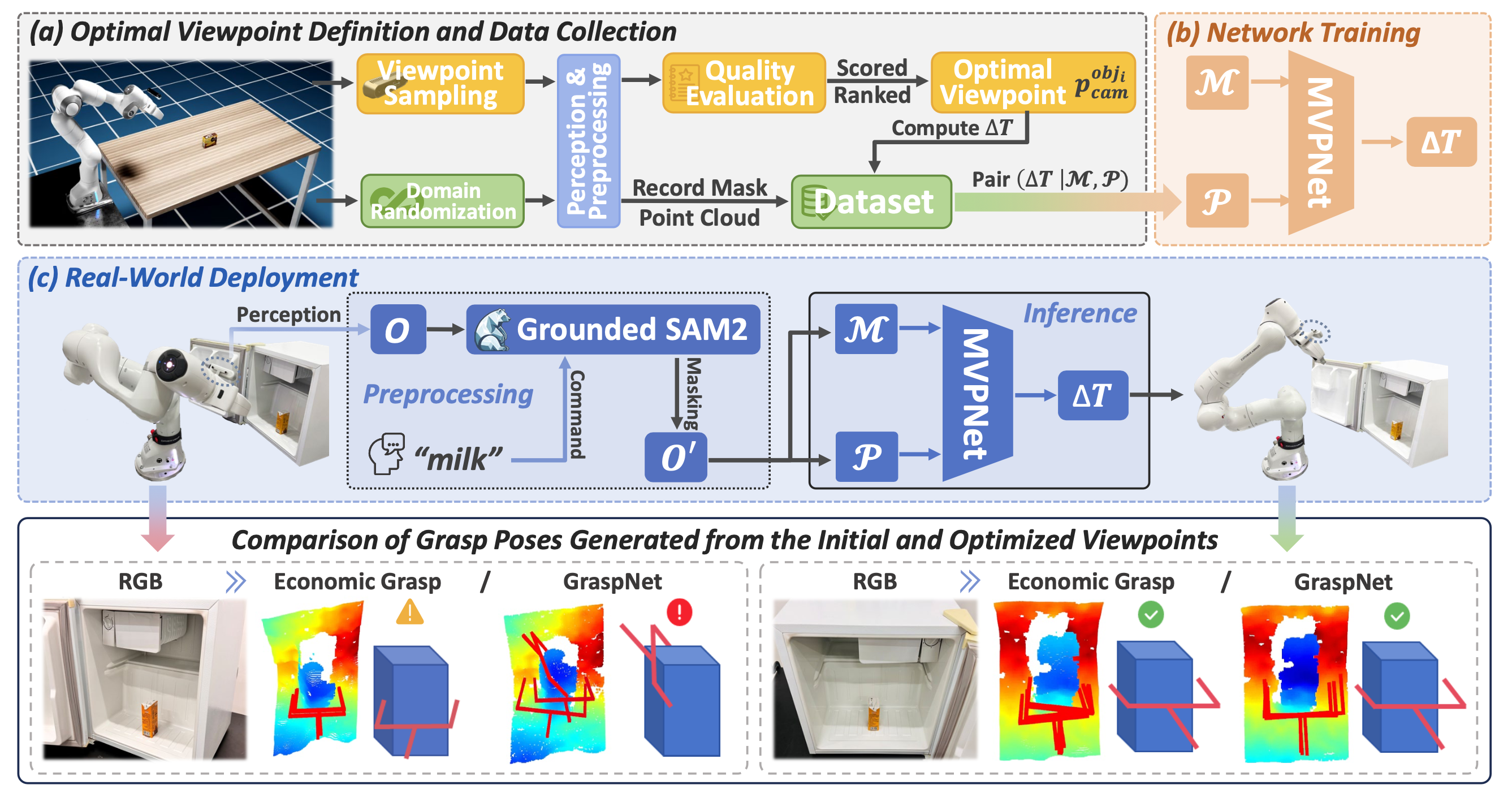

本文提出一种数据驱动的多模态主动感知框架,该框架能够直接预测最优观测视角,仅需一次重观察即可提升感知精度,并可泛化至不同任务。具体而言,首先构建一个最优视角定义和数据采集流程。最优观测视角通过对候选视角进行采样,并使用任务相关的质量函数对其进行评估来确定,该质量函数可根据不同的任务需求进行调整。随后,通过域随机化构建大规模训练数据集。值得注意的是,该流程无需人工标注,从而显著降低数据集创建成本,并有助于快速适应新任务。其次,提出一种多模态最优观测视角预测网络,称为MVP-Net。该网络利用交叉注意机制,自适应地对齐和融合多模态特征,同时突出显示感知关键区域,从而实现高效的主动感知。最后,将该框架应用于视角受限环境下的机器人抓取任务,因为该任务对观测视角高度敏感。

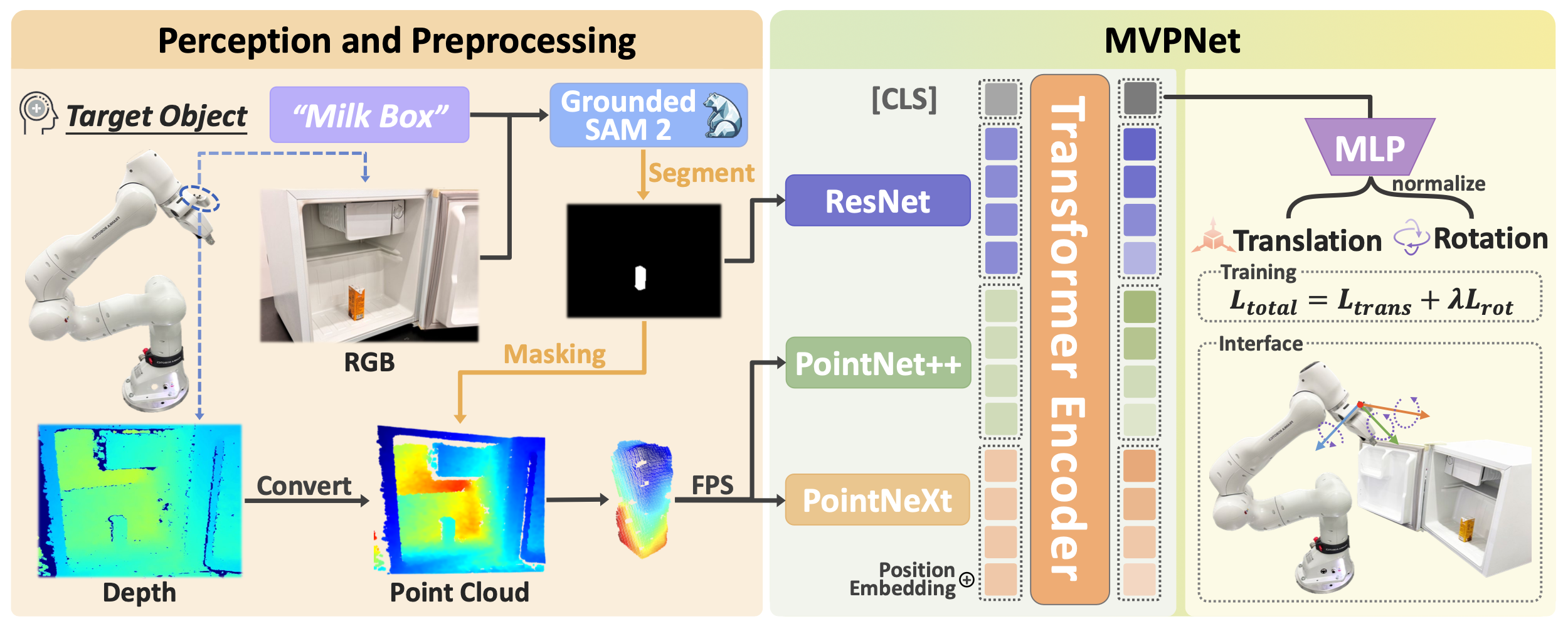

整体主动感知框架旨在学习策略 π : (O, L) → T,该策略以当前观测值 O 和指定目标对象的自然语言指令 L 作为输入,并输出所需的相机姿态调整 T。整个实现过程包含三个阶段:(a) 合成数据集构建。开发用于网络训练和评估的大规模逼真数据集;(b) 感知与预处理。获取环境观测数据并结合语义信息进行预处理;© 网络架构构建。构建一个基于 Transformer 的网络,将预处理后的多模态视觉信息映射到所需的相机姿态调整。本文使用视角受限环境中的机器人抓取任务来验证整个流程。如图所示:

合成数据集构建

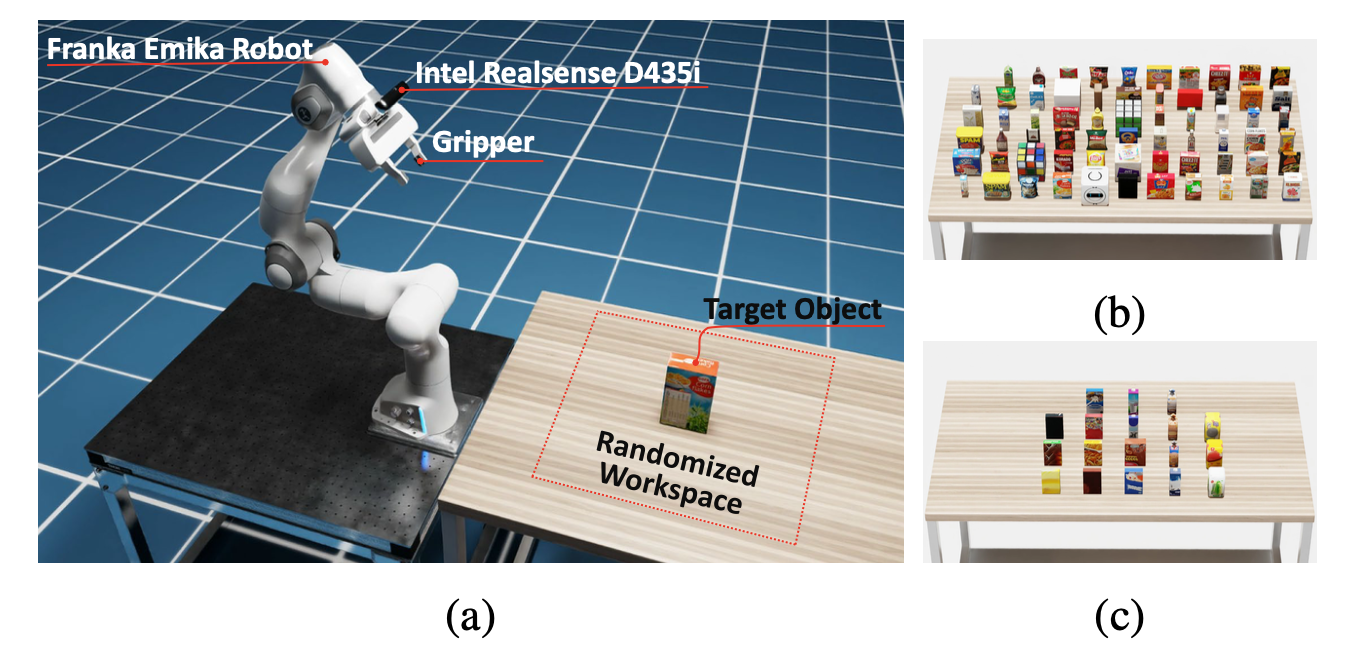

利用 Isaac Sim [31] 来加速数据集构建,它拥有逼真的渲染效果和强大的域随机化能力,能够高保真、大规模地收集合成数据。此外,该过程无需人工标注,从而降低数据集构建的成本。

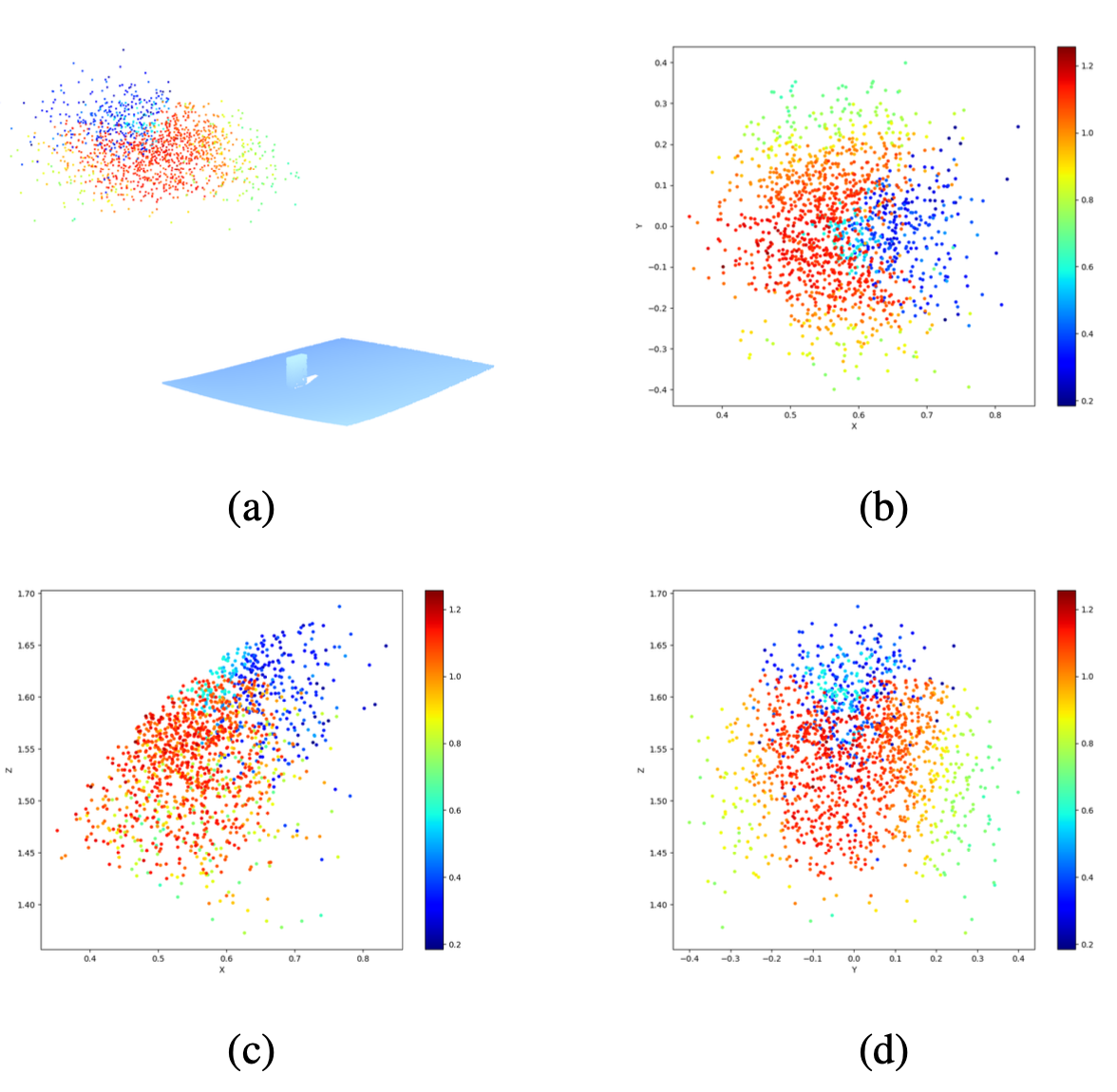

1)定义最优观测视角:为了构建用于网络训练的数据集,首先通过对物体周围候选视角进行采样并评估其质量,将每个物体的最优视角定义为数据集标签。具体来说,在 Isaac Sim 中构建一个模拟场景,如图 a 所示。在该场景中,初始相机视角在物体周围随机采样,所有视角都指向物体中心,同时记录 RGB-D 图像和相机姿态。这些图像以及目标物体的相应自然语言描述,依次由 Grounding DINO [32] 和 SAM2 [33] 进行处理,以进行目标检测和分割。同时,采用 Economic Grasp [29] 作为抓取模型来计算抓取姿态候选,并将候选姿态的聚合得分用于评估每个视角的质量。针对不同的下游任务,可以相应地定制视角质量评估函数。为了确保评估过程的可靠性,对每个物体随机生成 1500 个视角(即相机位置),并对每个点云进行五次重复的抓取姿态检测,每次试验取前 10 个得分的平均值,以提高评估的稳定性。该过程涉及 65 个物体类别,如图 b 所示。而新目标是未曾出现的,如图 c 所示。

总共生成 97.5k 张图像、487.5k 次抓取检测和 480 万个抓取姿态。例如,下图显示物体的观察视角得分分布。由于得分在三维空间及其二维投影中均呈现连续分布,因此可以使用神经网络在连续空间中有效地建模和优化该问题。对得分最高的 800 个视点进行 DBSCAN [34] 聚类,并将最大聚类的质心选为当前状态下该对象的最佳观测视点 t_best。

- 数据采集:一旦获得每个对象的最佳观测视点,用域随机化进行数据采集,其中初始相机视点、对象类别、姿态、尺度和环境光照均被随机化。网络输入包括掩码图像和点云,它们通过对当前状态的观测数据进行预处理获得。

数据集包含三个部分:掩码图像、点云和相机姿态调整。掩码图像和点云通过结合相应的自然语言指令对 RGB-D 观测数据进行预处理获得,并作为网络的输入;而相机姿态调整则提供学习目标。利用 Isaac Sim 的域随机化功能,采集 17k 个数据样本。随后,数据集按 9:1 的比例分为训练集和测试集。

感知与预处理

用单个摄像头进行图像采集,以促进策略学习,从而增强方法在实际部署中的适用性[35]。在仿真和实际场景中,用腕戴式摄像头以1280×720的分辨率采集彩色图像和深度图像,该分辨率与数据集中使用的尺寸一致。然后,用摄像头的外参和内参将深度图像转换为点云。

由于背景干扰,直接将摄像头拍摄的原始图像输入网络可能并非最优。一方面,杂乱的场景和无关物体会使网络难以聚焦于目标物体,从而阻碍网络收敛。另一方面,与目标物体无关的背景几何形状可能会引入无关特征;例如,模型在预测摄像头姿态调整时可能会无意中依赖于桌面几何形状。此外,在多物体场景中,目标是实现针对特定目标物体的自然语言引导的主动感知。因此,观测数据通过引入目标对象的语言描述进行预处理,预处理采用Grounded SAM 2 [36] 算法,该算法结合用于目标检测的Grounding DINO [32] 和用于分割的SAM 2 [33]。如图所示,其工作流程包括:1)Grounding DINO基于待抓取对象的语义信息和相机拍摄的RGB图像检测目标对象,然后将其边框传递给SAM 2进行分割,生成掩码;2)该掩码有两个用途:直接用作MVPNet的图像输入,并用于点云掩码;3)处理后的点云在输入MVPNet之前,会进行数据增强(例如,随机点丢弃)和最远点采样。因此,输入到网络中的输入数据经过预处理和增强,这不仅有助于学习显著特征,还能提高模型对新物体、未见过的场景乃至真实世界环境的泛化能力。

当包含颜色、纹理和形状信息的图像同时作为网络输入时,卷积神经网络在预测时往往更依赖颜色和纹理信息,而非几何形状信息[37]。在本研究中,模型显然应该主要关注目标物体的边界几何形状来推断所需的相机姿态调整,而不是依赖颜色或纹理信息。因此,网络输入的图像表示为目标物体的二值掩码,而不是包含外观信息的颜色掩码。这种设计不仅有助于网络学习关键特征,还能进一步提高其在物体颜色、纹理和环境条件(例如光照)变化下的泛化能力。

网络架构构建

提出一种多模态最优观测视点预测网络,称为 MVPNet,它包含三个主要组件:特征提取、特征对齐与融合以及姿态输出。

- 特征提取:用 ResNet [38] 对掩码图像进行编码,并使用两个点云编码器提取点云特征,因为与掩码图像相比,点云包含更丰富的三维空间关系。这种空间数据比图像像素值更易于直接解释,并且与输出变换 ∆T 位于同一度量空间中。

具体而言,采用一种集成 PointNeXt [39] 和 PointNet++ [40] 的组合点云编码器架构进行协同特征提取。虽然 PointNeXt 是 PointNet++ 的改进版本,但它们在特征提取方面各有特点:PointNet++ 采用分层下采样,侧重于传统的几何建模,使其对细粒度的结构细节更为敏感; PointNeXt 融合针对现代深度特征提取优化的增强型残差连接,从而能够更好地感知全局上下文和高层语义。通过结合两种架构,我们的模型能够有效地捕捉局部几何细节,同时保持稳健的全局表示,从而增强对各种输入条件的适应性。

-

特征对齐与融合:特征提取器输出特定模态的特征向量,这些向量被视为token。这些点云和掩码图像token被连接成一个统一的序列,并传递给 Transformer [41] 编码器。Transformer 编码器的交叉注意机制隐式地建立 2D-3D 对应关系并融合它们的表示。此外,Transformer 编码器中还集成一个可训练分类([CLS])token,类似于 BERT 中的用法,它作为序列级预测的摘要表示 [42]。在此,该token作为全局特征向量,通过交叉注意机制聚合来自点云和掩码图像token的信息,其对应的输出随后用于预测所需的相机位姿变换。它通过融合点云的综合几何特征和掩码图像的互补视觉轮廓信息,确保预测的鲁棒性,即使在观测数据不完整或输入噪声较大的情况下也能保持可靠的性能。此外,还添加二维正弦位置嵌入以保留空间信息[43]。

-

位姿输出:应用多层感知器(MLP)将Transformer的输出映射到任务空间,该任务空间由平移量∆t和旋转量∆q组成。在训练过程中,这些输出与真实标签进行比较,并通过以下定义的损失函数优化网络参数。在推理过程中,预测的输出用于将相机位姿调整到最佳观测视角。

损失函数包含两个部分:L_trans 用于平移,L_rot 用于旋转。具体来说,L_trans 计算预测平移 ˆt 与真实平移 t 之间的均方误差 (MSE),而 L_rot 计算预测旋转 qˆ 与真实旋转 q 之间的测地距离。

DAMO开发者矩阵,由阿里巴巴达摩院和中国互联网协会联合发起,致力于探讨最前沿的技术趋势与应用成果,搭建高质量的交流与分享平台,推动技术创新与产业应用链接,围绕“人工智能与新型计算”构建开放共享的开发者生态。

更多推荐

已为社区贡献143条内容

已为社区贡献143条内容

所有评论(0)