【深度收藏】AI Agent从零构建:大语言模型到智能体实现的完整路径

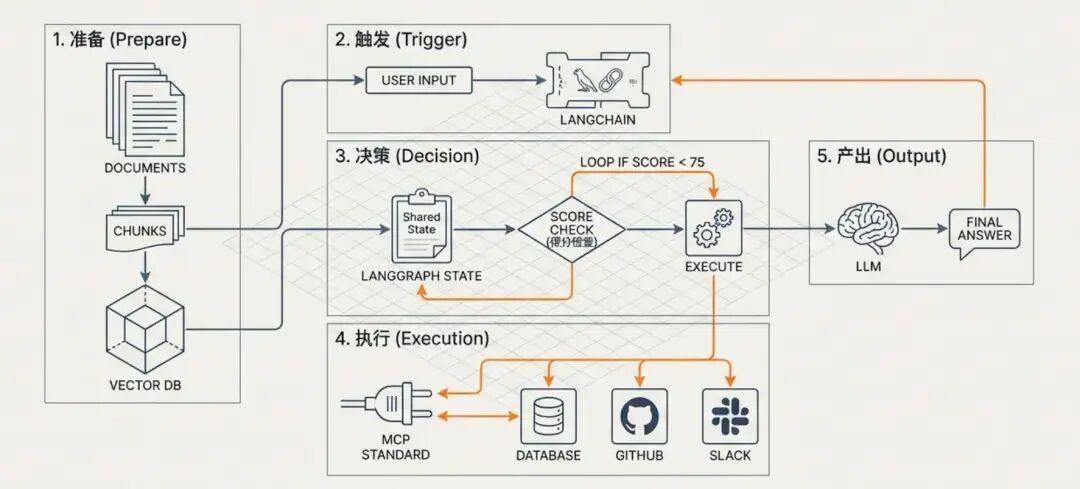

文档经过切分与重叠处理,通过Embeddings存入向量数据库。用户提问,LangChain调度RAG流程,根据语义意图找回知识。决策:LangGraph根据当前状态判断:是直接回答,还是需要循环修正?如果需要实时数据,通过MCP协议调用外部工具。产出:LLM结合所有事实与逻辑推理,输出最终方案。理清了这些基石,你就已经掌握了从“对话机器人”跨越到“全能 Agent”的底层蓝图。

文章详细解析了构建AI Agent的四大核心技术组件:智能内核(大语言模型、上下文窗口、提示工程)、知识扩展(向量数据库、Embeddings、RAG)、行动逻辑(LangChain、LangGraph、MCP)以及各组件协同工作的完整流程。这些技术共同构成了从简单对话机器人升级为全能AI Agent的底层架构,为开发者提供了清晰的实现路径和技术选型指南。

一、 智能的内核:大语言模型与交互边界

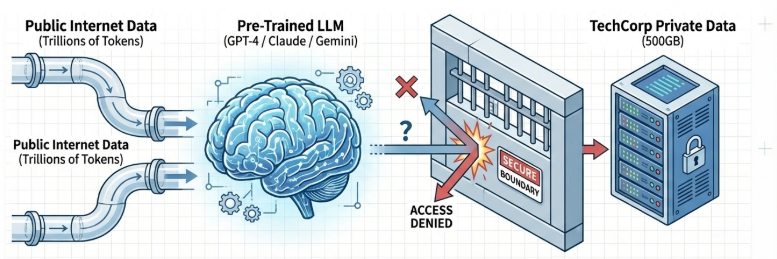

1. LLM(大语言模型):通识大脑

LLM 是 Agent 的核心引擎。它拥有强大的语言理解能力,但它是一个“静态大脑”,其知识停留在训练截止的那一刻,无法感知企业内部的私有数据。

2. Context Window(上下文窗口):短期记忆

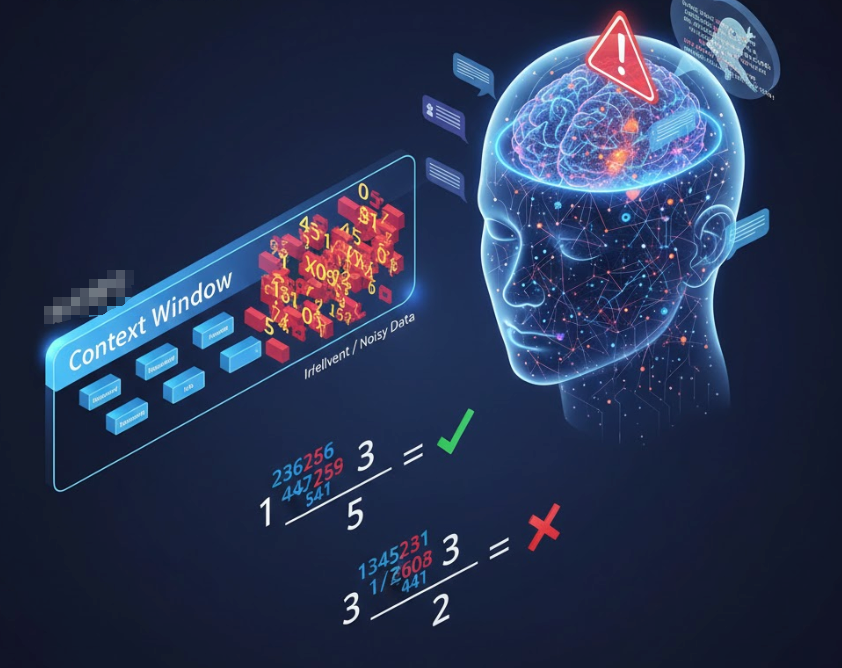

这是模型单次交互能处理的信息上限。

- 局限: 即使窗口再大,也不能盲目塞入所有数据。正如在数学题中加入无关的干扰信息会降低准确率一样,过长的背景会导致模型“注意力不集中”,甚至产生幻觉。

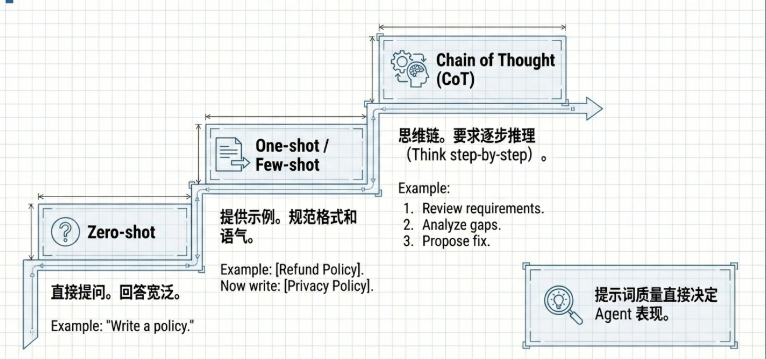

3. Prompt Engineering(提示工程):沟通的艺术

- Zero-shot(零样本): 不给示例,直接下指令。这要求指令必须高度具体(如:从“写个政策”优化为“写个 200 字符合 GDPR 标准的隐私政策”)。

- Few-shot(少样本): 提供几个理想的问答示例,这能有效地规范 AI 输出的语气(Tone)和特定格式。

- Chain of Thought(思维链): 引导 AI 展示推理步骤,强制模型分配更多计算资源在逻辑推导上,从而处理复杂问题。

二、 知识的扩展:从“翻书”到“记忆”

为了让 AI 访问私有数据,我们需要构建一套“外挂硬盘”。

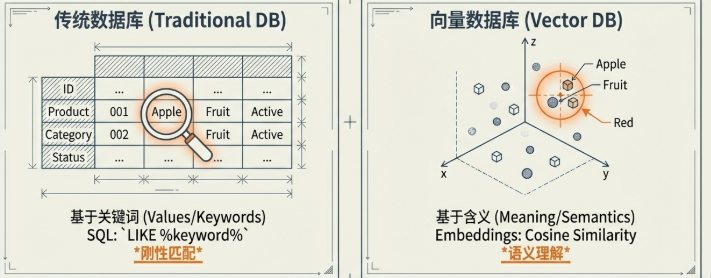

4. 向量数据库 vs 传统数据库

传统的 SQL 数据库是基于值或关键词的匹配(如 LIKE %vacation%)。而向量数据库(如 ChromaDB, Pinecone)则是基于**含义(Meaning)**的匹配。即使搜索词不一致,只要语义接近,系统就能精准定位。

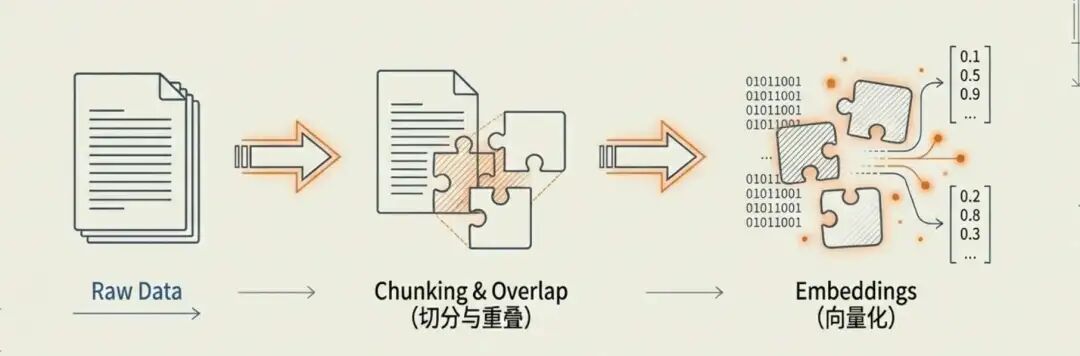

5. Embeddings 与数据预处理

- 数据切分(Chunking): 我们不能将 500GB 的文档直接塞给 AI。必须将其切成小块。

- 重叠(Overlap): 在切分时,通常会保留一定的文字重叠。这能防止上下文在切分处丢失,从而大幅提升检索的准确性。

- Embeddings: 将切分好的文本块转化为高维数字向量,让计算机能够以数学方式计算语义的相关性。

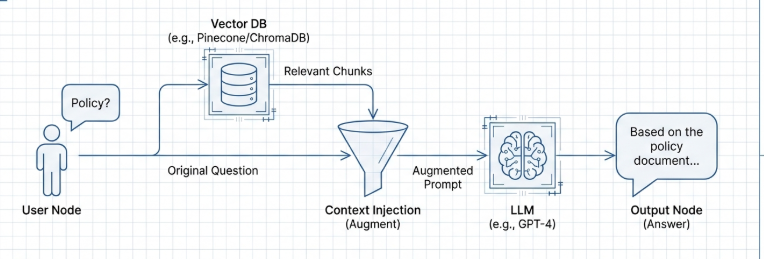

6. RAG(检索增强生成):知识的补丁

RAG 是目前解决 AI 幻觉的最优方案。它通过“检索 -> 增强 -> 生成”的流程,让 AI 像是在参加开卷考试:先去数据库里“翻书”找到事实,再根据事实组织答案。

三、 行动的逻辑:框架、编排与协议

7. LangChain:开发的“胶水”层

LangChain 是一个强大的抽象层,旨在简化开发流程。

- 核心价值: 它像管道一样将模型、提示词模板和向量库连接起来。有了它,你从 OpenAI 切换到 Google Gemini 可能只需要更改一行代码,极大地提高了系统的灵活性。

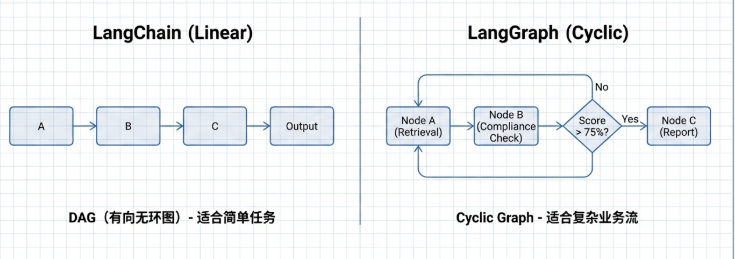

8. LangGraph:有状态的“总导演”

当任务需要循环和决策时,简单的线性管道就不够用了。

- 节点与边: LangGraph 通过节点(步骤)和边(路径)构建工作流。

- 共享状态(State): 这是它的核心。它维护着一个在各节点间传递的“字典”,记录着当前的文档、评分等信息。基于这个状态,系统可以执行复杂逻辑:例如“如果合规分数低于 75 分,则循环回退到搜索节点重新查阅”。

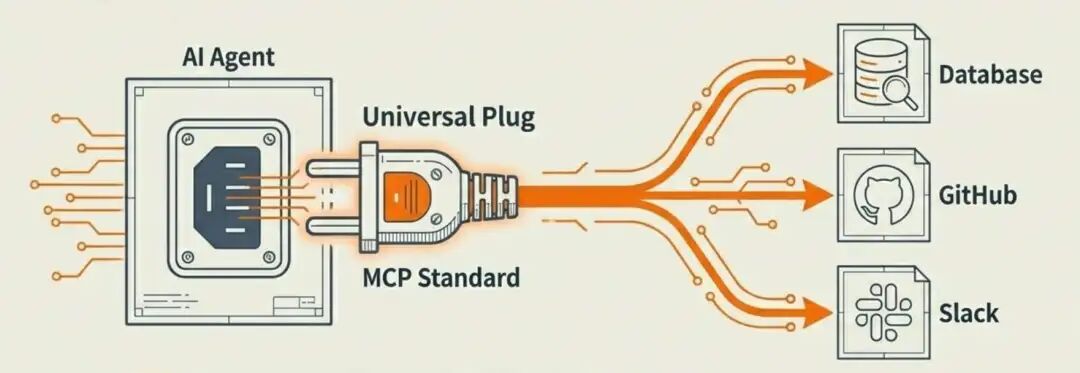

9. MCP(模型上下文协议):标准化的“USB 接口”

这是连接外部工具(如 GitHub、数据库)的通用标准。它让 AI 具备了“即插即用”的能力,开发者无需为每个工具编写特定的硬编码集成,只需符合 MCP 协议,Agent 就能自主调用。

四、 总结:各组件是如何协同工作的?

构建一个完整的 AI 系统,本质上是让这些组件各司其职、形成闭环:

- 准备: 文档经过切分与重叠处理,通过 Embeddings 存入向量数据库。

- 触发: 用户提问,LangChain 调度 RAG 流程,根据语义意图找回知识。

- 决策:LangGraph 根据当前状态判断:是直接回答,还是需要循环修正?

- 执行: 如果需要实时数据,通过 MCP 协议调用外部工具。

- 产出:LLM 结合所有事实与逻辑推理,输出最终方案。

理清了这些基石,你就已经掌握了从“对话机器人”跨越到“全能 Agent”的底层蓝图。

那么,如何系统的去学习大模型LLM?

到2026年,大型语言模型将不再是“实验性工具”,而将成为核心基础设施。 过去三年,大型语言模型(LLM)已从研究实验室走向生产系统,为客户支持、搜索、分析、编码助手、医疗保健工作流程、金融和教育等领域提供支持。但在这股热潮背后,一些重要的事情正在发生:

企业不再招聘“人工智能爱好者”,而是招聘大语言模型LLM工程师。在2026年迅速成为排名前五的科技职业之一。

我在一线互联网企业工作十余年里,指导过不少同行后辈。帮助很多人得到了学习和成长。

为了让大家不浪费时间踩坑!2026 年最新 AI 大模型全套学习资料已整理完毕,不管你是想入门的小白,还是想转型的传统程序员,这份资料都能帮你少走 90% 的弯路

这份完整版的大模型 AI 学习资料已经上传CSDN,朋友们如果需要可以微信扫描下方CSDN官方认证二维码免费领取【保证100%免费】

下面是我整理的大模型学习资源,希望能帮到你。

👇👇扫码免费领取全部内容👇👇

大模型资料包分享

1、 AI大模型学习路线图(含视频解说)

2、从入门到精通的全套视频教程

3、学习电子书籍和技术文档

4、 AI大模型最新行业报告

2026最新行业报告,针对不同行业的现状、趋势、问题、机会等进行系统地调研和评估,以了解哪些行业更适合引入大模型的技术和应用,以及在哪些方面可以发挥大模型的优势。

5、各大厂大模型面试题目详解

【大厂 AI 岗位面经分享(107 道)】

【AI 大模型面试真题(102 道)】

【LLMs 面试真题(97 道)】

6、大模型项目实战&配套源码

适用人群

👇👇扫码免费领取全部内容👇👇

3、这些资料真的有用吗?

这份资料由我和鲁为民博士(北京清华大学学士和美国加州理工学院博士)共同整理,现任上海殷泊信息科技CEO,其创立的MoPaaS云平台获Forrester全球’强劲表现者’认证,服务航天科工、国家电网等1000+企业,以第一作者在IEEE Transactions发表论文50+篇,获NASA JPL火星探测系统强化学习专利等35项中美专利。本套AI大模型课程由清华大学-加州理工双料博士、吴文俊人工智能奖得主鲁为民教授领衔研发。

资料内容涵盖了从入门到进阶的各类视频教程和实战项目,无论你是小白还是有些技术基础的技术人员,这份资料都绝对能帮助你提升薪资待遇,转行大模型岗位。

这份完整版的大模型 AI 学习资料已经上传CSDN,朋友们如果需要可以微信扫描下方CSDN官方认证二维码免费领取【保证100%免费】

DAMO开发者矩阵,由阿里巴巴达摩院和中国互联网协会联合发起,致力于探讨最前沿的技术趋势与应用成果,搭建高质量的交流与分享平台,推动技术创新与产业应用链接,围绕“人工智能与新型计算”构建开放共享的开发者生态。

更多推荐

已为社区贡献16条内容

已为社区贡献16条内容

所有评论(0)