RAG技术详解:给AI装个“实时查资料“的外挂,告别瞎编!

RAG技术结合信息检索与自然语言生成,为AI提供实时查资料能力,解决传统AI"记不住新东西、容易瞎编"的问题。通过知识库分块、语义编码、向量检索、构建带资料的提示词等步骤,让大模型从"靠记忆答题"转变为"拿着参考资料回答的靠谱考生",使输出更准确、有依据且可溯源,广泛应用于聊天机器人、智能助理等场景。

RAG(Retrieval-Augmented Generation)是⼀种结合了信息检索和⾃然语⾔⽣成的技术,旨在提⾼⽣成模型的性能和准确性。

用大白话解释一下,RAG 就是给 AI 生成模型(比如 GPT、文心一言)装了个 “实时查资料的外挂”:

1、先从外部数据库 / 网页里精准搜到相关信息

2、再用这些靠谱信息转换为可读的 “参考资料”

2、最后生成答案

既解决了 AI“记不住新东西、容易瞎编” 的问题,又让输出更准、更有依据

拆成 3 个核心步骤:

1、检索(Retrieval):AI 先当 “搜索引擎”—— 你问它 “2025 年 AI 产品经理岗位需求变化”,它不会直接瞎答,而是先去爬行业报告、招聘网站、权威文章,把和 “岗位需求” 相关的信息都捞出来;

2、增强(Augmented):这些捞出来的信息,就成了 AI 的 “临时知识库”—— 相当于考试前给它划了重点,让它不用靠自己 “过时的记忆” 答题;

3、生成(Generation):AI 再当 “文案整理师”—— 把搜到的重点信息整合、润色,用自然语言讲给你听,最后输出 “2025 年 AI 产品经理更看重 RAG 应用能力、数据分析能力,新增了跨部门协同要求” 这类具体答案。

对比普通 AI(没装 RAG)的区别:

普通 AI:靠训练时的 “老记忆” 答题,可能告诉你 “2023 年的需求”,甚至编不存在的要求;

RAG 增强 AI:靠 “实时检索 + 参考资料” 答题,答案又新又准,还能溯源(比如告诉你答案来自某平台的某报告)。

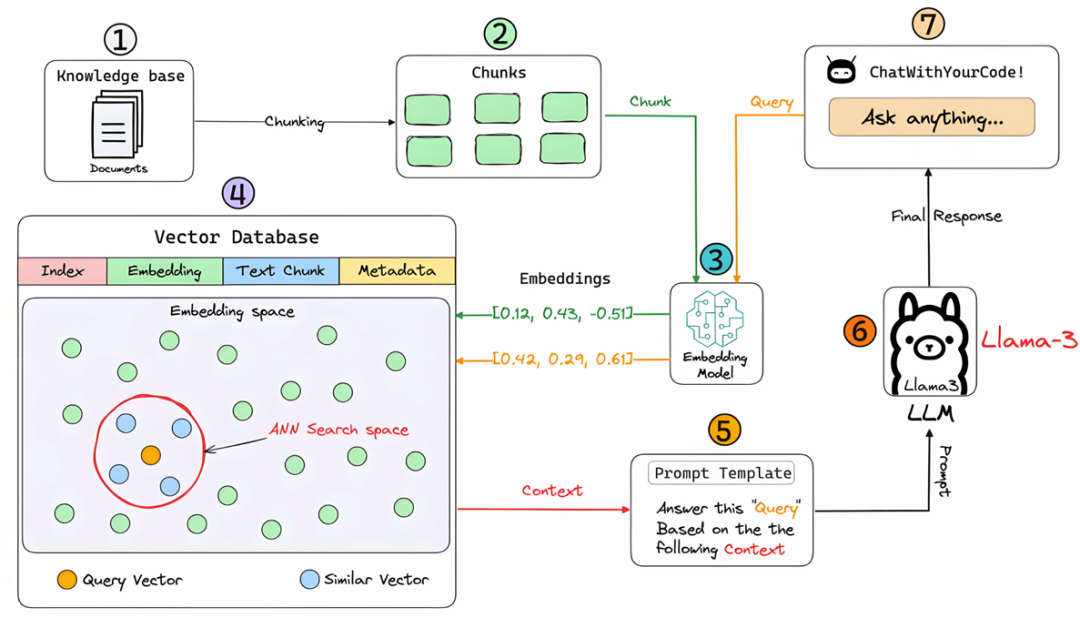

RAG 模型⼴泛应⽤于聊天机器⼈、智能助理、问答系统和其他需要实时信息的⾃然语⾔处理任务。底层原理如图:

这个图就是 RAG 工作的 “完整流水线”,跟着以下步骤就能看懂:

第一、 图左上角的Knowledge base(知识库)是 RAG 的 “素材仓库”—— 比如你做 “Chat With Your Code”,仓库里存的就是所有代码文档(Documents)。

但整份文档太长,大模型读不下、也找不到细节,所以要做Chunking(分块):把长文档切成一小段一小段的Chunks(文本块)(对应图里步骤 2 的绿色方块)

这一步的核心是:把 “大资料” 拆成 “小信息便利贴”,为后续精准找资料打基础。

第二、 步骤 3 的Embedding Model(嵌入模型)是 RAG 的 “语义翻译机”:它会把每一个「Chunks」,以及你后续输入的「Query(用户提问)」,都转换成一串数字 —— 这串数字叫「Embeddings(嵌入向量)」(图里的「[0.12, 0.43, -0.51]」就是例子)。

为啥转数字?

计算机看不懂 “文字的意思”,但能通过 “向量的距离” 判断语义是否相近:

比如 “代码怎么运行” 和 “运行代码的步骤”,转成向量后距离很近;

而 “代码怎么运行” 和 “今天吃什么”,向量距离会很远。

第三、 步骤 4 的Vector Database(向量数据库),是 RAG 的 “语义保险柜”:它存的不是文字,是Embeddings(嵌入向量)+ 对应的Text Chunk(文本块原文)+Metadata(元数据,比如这个 Chunk 来自哪份文档),还会建Index(索引)方便快速搜。

图里的Embedding space(嵌入空间)是这些向量的 “数字地图”:每个点代表一个 Chunk 的向量。

当你的Query转成Query Vector(查询向量,图里橙色点)后,会在ANN Search space(近似最近邻搜索空间)里圈出红圈 —— 找到和它距离最近的Similar Vector(相似向量,蓝色点),对应的 Chunk 就是 “和问题最相关的资料”。

第四、找到相关资料后,步骤 5 的Prompt Template(提示词模板)就登场了:模板里写着Answer this ‘Query’ Based on the the Following Context—— 翻译过来就是 “必须照着下面的参考资料(Context)回答我的问题”。

这里的Context,就是步骤 4 里找到的相似 Chunk。把 “你的 Query + 对应的 Context” 拼在一起,就成了给大模型的 “带资料的问题”。

第五、 最后一步步骤 6 的LLM(大语言模型,图里是 Llama-3),是 RAG 的 “最终答题者”:它拿到 “带资料的问题” 后,不会瞎编

因为提示词要求它基于 Context 回答,所以它会把 Context 里的信息整理成自然语言,生成准确的Final Response(最终回复)。

回复会传回步骤 7 的「ChatWithYourCode!」交互界面,你就能在「Ask anything…」框下看到精准回答了。

最后,用一句话总结 RAG 流程图逻辑:

通过“分块→语义编码→向量检索→带资料提问”流程,让大模型从 “靠记忆瞎编的选手”,变成 “拿着参考资料答题的靠谱考生”

——这就是 RAG 能让 AI 输出更准的核心。

最后唠两句

为什么AI大模型成为越来越多程序员转行就业、升职加薪的首选

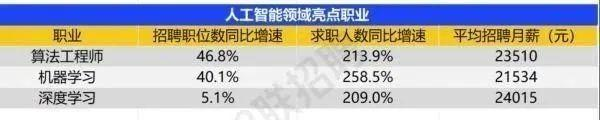

很简单,这些岗位缺人且高薪

智联招聘的最新数据给出了最直观的印证:2025年2月,AI领域求职人数同比增幅突破200% ,远超其他行业平均水平;整个人工智能行业的求职增速达到33.4%,位居各行业榜首,其中人工智能工程师岗位的求职热度更是飙升69.6%。

AI产业的快速扩张,也让人才供需矛盾愈发突出。麦肯锡报告明确预测,到2030年中国AI专业人才需求将达600万人,人才缺口可能高达400万人,这一缺口不仅存在于核心技术领域,更蔓延至产业应用的各个环节。

那0基础普通人如何学习大模型 ?

深耕科技一线十二载,亲历技术浪潮变迁。我见证那些率先拥抱AI的同行,如何建立起效率与薪资的代际优势。如今,我将积累的大模型面试真题、独家资料、技术报告与实战路线系统整理,分享于此,为你扫清学习困惑,共赴AI时代新程。

我整理出这套 AI 大模型突围资料包【允许白嫖】:

-

✅从入门到精通的全套视频教程

-

✅AI大模型学习路线图(0基础到项目实战仅需90天)

-

✅大模型书籍与技术文档PDF

-

✅各大厂大模型面试题目详解

-

✅640套AI大模型报告合集

-

✅大模型入门实战训练

这份完整版的大模型 AI 学习和面试资料已经上传CSDN,朋友们如果需要可以微信扫描下方CSDN官方认证二维码免费领取【保证100%免费】

①从入门到精通的全套视频教程

包含提示词工程、RAG、Agent等技术点

② AI大模型学习路线图(0基础到项目实战仅需90天)

全过程AI大模型学习路线

③学习电子书籍和技术文档

市面上的大模型书籍确实太多了,这些是我精选出来的

④各大厂大模型面试题目详解

⑤640套AI大模型报告合集

⑥大模型入门实战训练

如果说你是以下人群中的其中一类,都可以来智泊AI学习人工智能,找到高薪工作,一次小小的“投资”换来的是终身受益!

应届毕业生:无工作经验但想要系统学习AI大模型技术,期待通过实战项目掌握核心技术。

零基础转型:非技术背景但关注AI应用场景,计划通过低代码工具实现“AI+行业”跨界。

业务赋能 突破瓶颈:传统开发者(Java/前端等)学习Transformer架构与LangChain框架,向AI全栈工程师转型。

👉获取方式:

有需要的小伙伴,可以保存图片到wx扫描二v码免费领取【保证100%免费】🆓

DAMO开发者矩阵,由阿里巴巴达摩院和中国互联网协会联合发起,致力于探讨最前沿的技术趋势与应用成果,搭建高质量的交流与分享平台,推动技术创新与产业应用链接,围绕“人工智能与新型计算”构建开放共享的开发者生态。

更多推荐

已为社区贡献17条内容

已为社区贡献17条内容

所有评论(0)