机器人诊断十年演进

摘要: 机器人诊断在十年间(2015-2025)从"人肉救火"发展为Robot SRE+运行时治理,核心是服务恢复+风险控制+防复发。演进分为三代: 第一代(2013-2016):现场经验排障,依赖个人能力,不可复制; 第二代(2016-2020):远程流程化排障,通过集中日志和Runbook提升效率,但缺乏治理能力; 第三代(2020-2025):治理闭环,结合证据链(Met

下面给你一份“机器人诊断十年演进(2015→2025)”的总纲级分析,完全站在机器人平台化(协议、监控、日志、诊断)的语境:诊断不是“看日志找bug”,而是把机器人(尤其 AMR 车队)作为真实世界分布式系统来运营时的“恢复服务 + 控制风险 + 防复发”能力。十年里诊断从“人肉救火”走向 Robot SRE(可靠性工程)+ 运行时治理(Runtime Governance)。

我会按三条主线讲清楚:

- 对象演进:单机故障 → 任务故障 → 车队/站点事故 → 服务SLA事件

- 方法演进:经验排障 → 远程排障 → 证据链诊断 → 闭环治理/自愈

- 闭环演进:定位 → 处置 → 复盘 → 场景沉淀 → 仿真回归 → 发布门禁

一、为什么机器人诊断是“平台化能力”,不是“个人能力”?

机器人诊断天然难于传统软件:

- 长尾异常多(环境、遮挡、反光、人车混行)

- 耦合复杂(传感器→定位→规划→控制→调度→业务系统)

- 多时钟/分布式(本体、边缘、云端)

- 复现成本高(现场复现=停机+人力+业务损失)

- 变更维度多(地图/配置/策略/版本/硬件批次/网络)

所以诊断的终点不是“找对根因”,而是:

在可控风险下尽快恢复服务(MTTR最小),并把一次异常转化为可复现、可回归、防复发的资产。

这也是为什么第三代诊断体系里,MTTR、自恢复率、复发率比“根因准确率”更关键。

二、十年三代范式:现场救火 → 远程排障 → 治理闭环(SRE化)

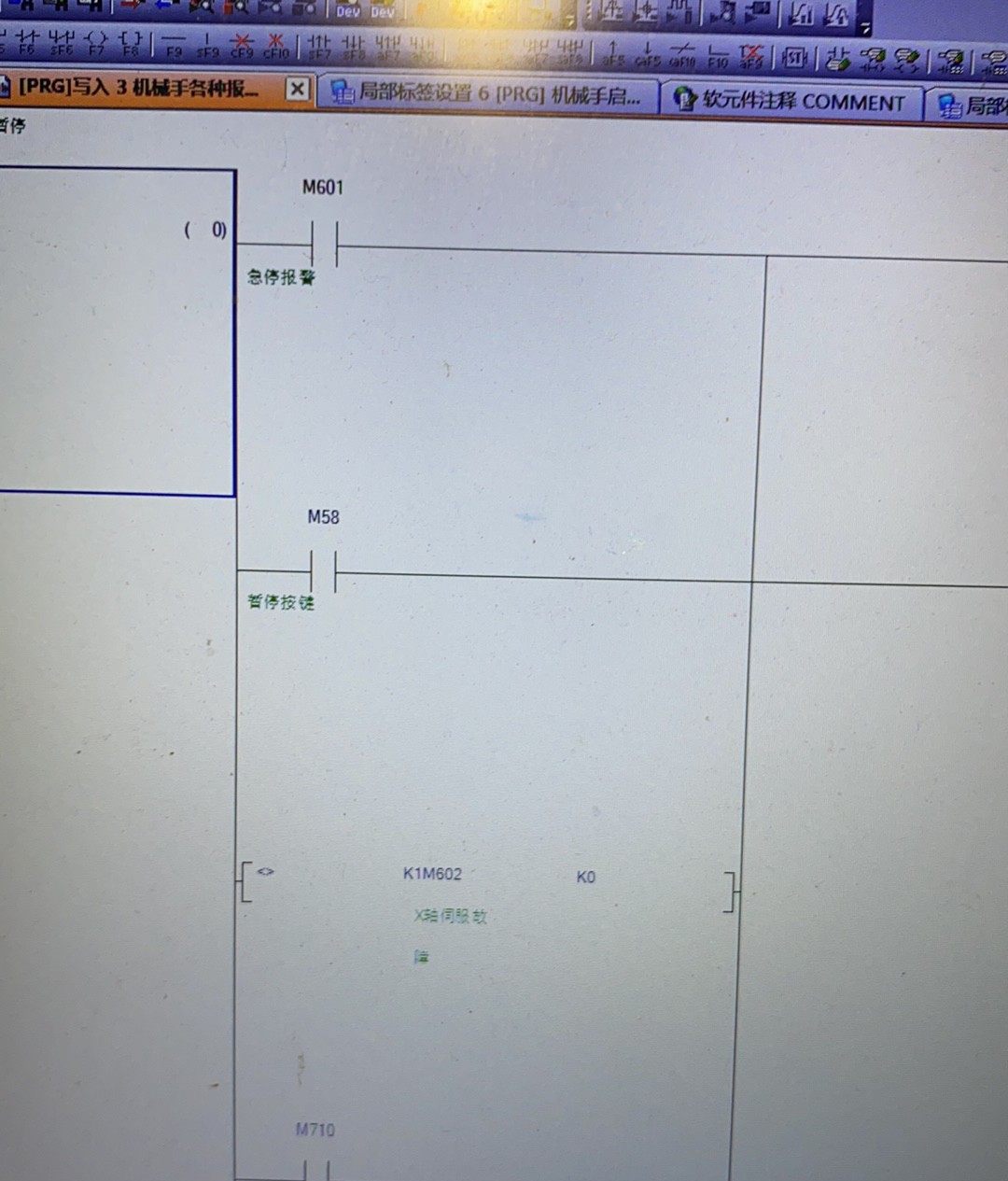

第一代(约2013–2016):现场救火诊断(经验驱动)

关键词:上现场、复现、猜;慢、贵、不可复制

典型形态

- 现象:卡死、撞停、任务失败、定位丢失

- 方式:工程师到现场试跑、看本地日志、调参、换件

- 根因:靠经验与排除法

核心问题

- 不可观测:缺少统一监控/日志/追踪

- 不可复现:问题“当场消失”或环境难复刻

- 不可积累:解决方案停留在个人经验

这阶段诊断能力≈工程师数量×经验,规模化必然崩盘。

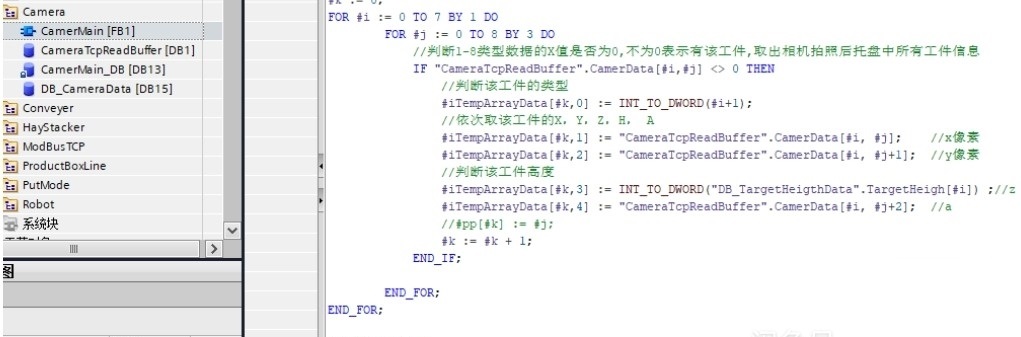

第二代(约2016–2020):远程排障 + 故障分类(流程化)

关键词:集中日志、基础监控、Runbook雏形;能治常见病

典型形态

-

有集中日志与简单监控(在线、任务失败、粗粒度错误码)

-

能远程SSH、抓取日志、重启服务

-

出现故障分类与处理手册(Runbook):

- 重新建图/重定位

- 重启导航栈

- 清缓存/恢复配置

- 换车/重派单

主要进步

- 许多问题不必到现场

- 处理流程可交接,可培训

关键天花板(大多数团队卡在这里)

- 跨模块因果链断裂:调度/导航/控制之间很难串起来

- 版本/配置漂移:同类问题在不同站点反复出现

- 复现资产缺失:长尾问题无法回归验证,修完容易复发

- 告警噪音:没有分级与聚合,值班效率低

第二代解决“能排障”,但没解决“能治理”。

第三代(约2020–2025):治理闭环诊断(Robot SRE化,分水岭)

关键词:证据链(metrics/logs/traces/replay)+ 变更治理 + 自愈 + 回归门禁

这一代诊断的核心是把诊断从“找原因”升级为“治理系统”:

- 先恢复服务:控制影响半径,保证SLA

- 再定位根因:基于证据链缩小范围

- 最后防复发:沉淀场景、仿真回归、发布门禁

三、第三代诊断体系的四大基础设施(缺一不可)

1)证据链:可观测性四件套(Observability)

成熟诊断的前提是“自动收集证据”:

- Metrics:SLA、延迟分布、队列堆积、定位置信度、急停次数

- Logs:结构化日志(task_id、版本上下文、error_code语义统一)

- Traces:跨模块链路(调度→导航→控制→执行)

- Replay:复现包(关键传感器窗口+决策输入输出+状态机序列)

没有 replay,你很难把长尾异常变成可回归对象;诊断永远停留在“当场修好”。

2)事件模型:把诊断变成“可运营的流程”

第三代诊断一般都会引入统一的事件模型:

- Event:异常信号(可聚合)

- Incident:影响SLA的事件集合(需要处置+复盘)

- Action:处置动作(自动/人工),必须记录效果

关键字段(建议强制):

incident_id / event_idseverity (S1/S2/S3)symptom(现象)suspected_root_cause(候选根因)action_taken / outcome(处置与结果)replay_bundle_id(复现包索引)change_context(关联变更:版本/配置/地图/策略)

有了事件模型,才能做:告警路由、Runbook执行、复盘、复发率统计、自动化处置。

3)变更治理:让诊断路径从“猜”变成“追溯变更”

机器人系统大量事故来自“变更”:

- 地图更新、规则调整、参数改动、策略升级、版本发布

第三代诊断强绑定变更系统:

- 灰度发布(对照组 vs 灰度组)

- 自动回滚(指标越界触发)

- 变更审计(谁改了什么、何时生效、影响范围)

- 配置版本化(map/config/policy版本贯穿日志与监控)

这会显著缩短诊断链路:

- 先看最近变更 → 决定回滚/隔离 → 恢复服务 → 再做根因分析

4)自愈策略库:把“恢复服务”自动化

第三代诊断的核心KPI:MTTR、自恢复率。因此必须有自愈策略库:

典型自愈动作(AMR常见)

- 定位退化:限速→重定位→切换定位源→请求人工

- 断网/高丢包:任务冻结→就地等待→安全停车→恢复后续跑

- 拥堵/死锁:交通管制→路权调整→分流→临时禁行区

- 组件异常:重启节点/容器→隔离机器人→切换备用服务

- 任务失败:自动重试→换车→重规划→回滚策略版本

并且每次自愈必须记录:

action_taken、outcome、耗时、是否复发

诊断从“定位根因”转为“恢复服务+控制风险”,这是规模化运营的唯一出路。

四、诊断十年演进的“成熟度阶梯”(可直接用来做评估)

- 现场复现+经验排障

- 远程SSH+看日志

- 集中监控与告警分级

- 结构化日志+错误语义字典

- tracing串任务链路(因果链可见)

- replay复现包(可复现)

- 场景库+仿真回归门禁(防复发)

- 变更治理+灰度回滚(控制影响半径)

- 自愈策略库(降低人工介入,提升自恢复率)

2015 大多在 1–2;2020 逐步到 3–4;2025 头部能到 6–9。

五、诊断体系最容易忽视但最致命的三件事

1)时间纪律(Time Discipline)

- 单调时钟+墙钟并存

- NTP/PTP、时钟漂移监控

- trace时间线必须可信

否则“因果分析”会被时间错序破坏。

2)上下文自动采集(Context Auto-Collection)

告警触发必须自动抓取:

- task_id、版本上下文(map/config/policy/software)

- 通信延迟/队列堆积、资源使用

- 关键传感输入窗口(用于replay)

否则诊断成本会指数级上升。

3)错误语义治理(Error Taxonomy)

没有稳定的 error_class/error_code:

- 事件无法聚类

- 统计无意义

- 自动处置无法可靠触发

六、2025→2030:诊断的前沿方向(你值得提前布局)

- 告警自动产出复现包成为默认(replay as default)

- 模型辅助诊断:告警聚类、根因候选排序、策略推荐

- 自愈从规则走向策略选择:但必须可控、可回滚、可审计

- 异构统一诊断:多厂商设备纳入统一事件模型

- 合规与安全证据链加强:near-miss/事故审计更刚性

七、落地路线图(四步走,高ROI)

Step 1:统一事件模型 + 错误字典 + 严重级别

- incident/event/action schema

- error_class/error_code稳定字典

- S1/S2/S3分级与owner机制

Step 2:可观测性证据链打底

- metrics/logs/traces/replay

- 告警触发自动采集上下文(版本/任务/输入窗口)

Step 3:Replay + 场景库 + 仿真回归门禁(防复发)

- replay bundle规范

- 一键回放工具

- CI仿真回归

Step 4:变更治理 + 自愈联动(降MTTR、提自恢复率)

- 灰度发布、自动回滚、变更审计

- 自愈策略库(降级/隔离/重启/绕行)

DAMO开发者矩阵,由阿里巴巴达摩院和中国互联网协会联合发起,致力于探讨最前沿的技术趋势与应用成果,搭建高质量的交流与分享平台,推动技术创新与产业应用链接,围绕“人工智能与新型计算”构建开放共享的开发者生态。

更多推荐

已为社区贡献140条内容

已为社区贡献140条内容

所有评论(0)