Genie Sim 3.0:面向人形机器人的高保真综合仿真平台

26年1月来自智元机器人的论文“Genie Sim 3.0 : A High-Fidelity Comprehensive Simulation Platform for Humanoid Robot”。开发稳健且可泛化的机器人学习模型,关键在于能否获得大规模、多样化的训练数据和可靠的评估基准。在物理世界中收集数据成本高昂且面临可扩展性挑战,而现有的仿真基准通常存在碎片化、范围狭窄或保真度不足等问

26年1月来自智元机器人的论文“Genie Sim 3.0 : A High-Fidelity Comprehensive Simulation Platform for Humanoid Robot”。

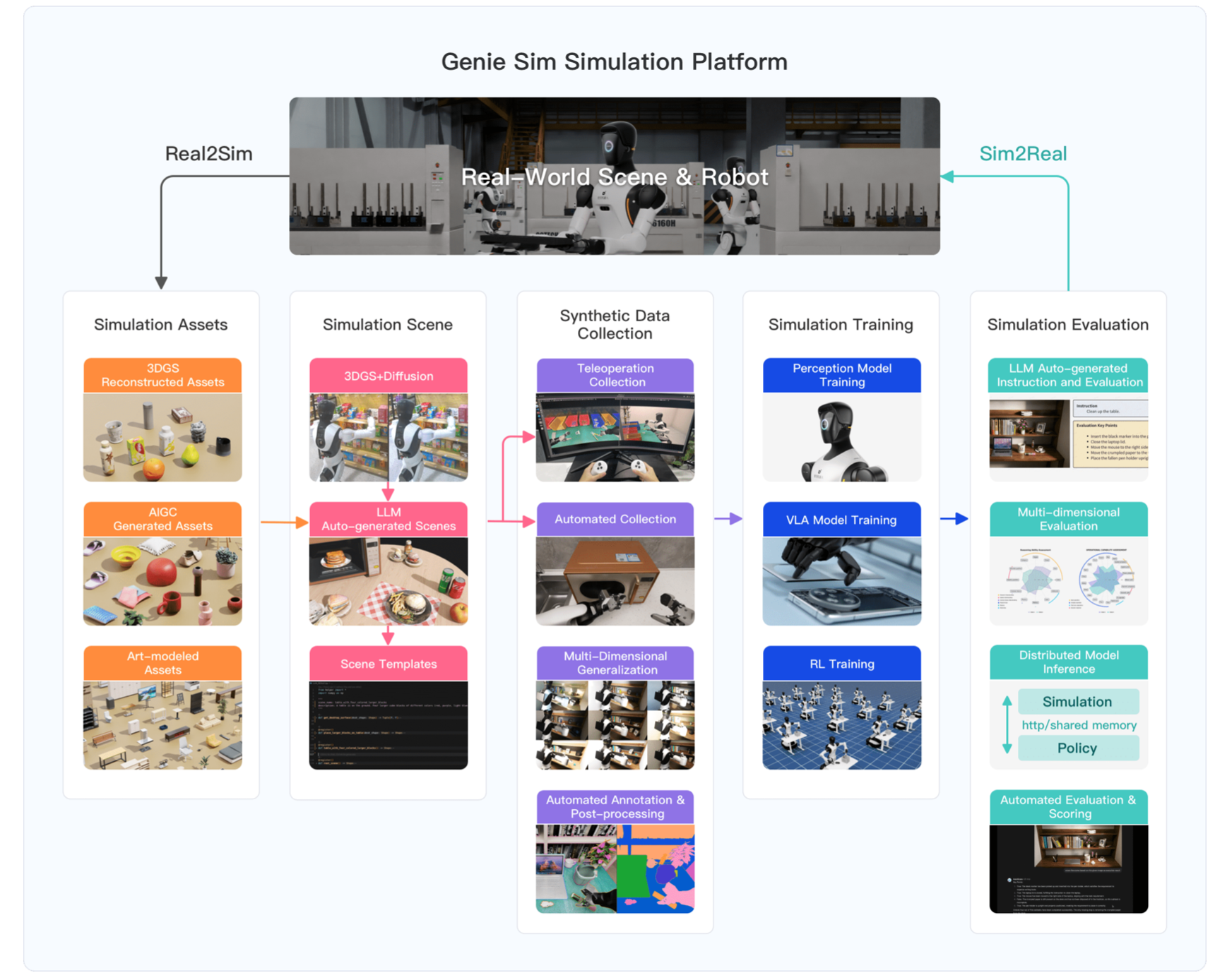

开发稳健且可泛化的机器人学习模型,关键在于能否获得大规模、多样化的训练数据和可靠的评估基准。在物理世界中收集数据成本高昂且面临可扩展性挑战,而现有的仿真基准通常存在碎片化、范围狭窄或保真度不足等问题,难以实现有效的模拟-到-真实迁移。为了应对这些挑战,推出 Genie Sim 3.0,一个用于机器人操作的统一仿真平台。还推出 Genie Sim Generator,这是一款基于大语言模型 (LLM) 的工具,能够根据自然语言指令构建高保真场景。其主要优势在于快速且多维的泛化能力,能够合成多样化的环境,从而支持可扩展的数据收集和稳健的策略评估。推出首个将 LLM 应用于自动化评估的基准。该基准利用 LLM 大规模生成评估场景,并采用视觉语言模型 (VLM) 构建自动化评估流程。还发布一个开源数据集,其中包含超过 10,000 小时的合成数据,涵盖 200 多个任务。通过系统性的实验,验证该开源数据集强大的零样本模拟-到-真实环境迁移能力,证明在受控条件下,合成数据可以有效地替代真实世界数据,用于可扩展的策略训练。

Genie Sim 3.0 概述如下:

场景生成

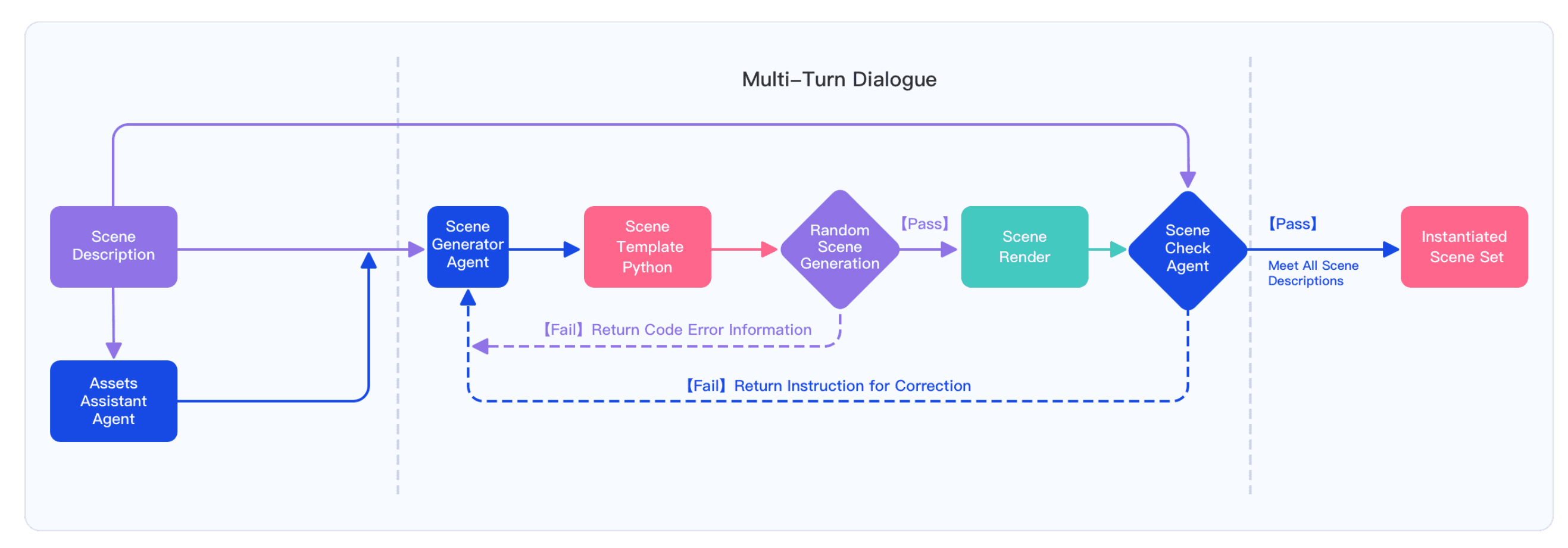

随着 LLM 和 VLM 的普及,可扩展、可泛化且对话式的数据创建已成为一种新兴范式。Genie Sim Generator,是一个基于 LLM 的工具链,它能够联合创建仿真场景并生成用于下游任务评估的场景图。它由两个紧密耦合的模块组成。第一个模块是 Assets Index,这是一个托管的 Isaac Sim 可用资源库,其中增强 LLM、VLM 和检索增强生成 (RAG) 智体,并提供结构化的应用程序编程接口 (API) 以方便场景构建。第二个模块是 Scene Generator,其灵感来源于场景语言 [37]。该模块通过多轮对话捕获用户意图,将其转换为可执行的 Python 代码,并编译包含 Isaac Sim 所需资源的最终场景图。

整个场景生成过程分为四个阶段:意图解释、资源检索、域特定语言 (DSL) 代码生成和结果组装,所有步骤都在同一个共享相同上下文的聊天窗口中完成。

如图所示Genie Sim Generator 的自动化工作流程。该模块通过多轮对话捕获用户意图,将其转换为可执行的 Python 代码,并编译包含 Isaac Sim 所需资源的最终场景图。

意图解释器将用户开放式的自然语言提示翻译成结构化的、机器可理解的任务请求。支持思维链(CoT)的LLM首先解析并分解自然语言提示,将其分解为结构化的分解,包括空间场景描述符、对象属性约束和任务级意图(例如,“堆叠”、“整齐”、“随机”)。对于含义模糊或描述不清的短语(例如,“一些方块”、“随机排列”),则通过基于预训练世界知识记忆的推理过程进行解析。最终的规范被构建成 JavaScript 对象表示法(JSON)模式,其中包含所需的语义对象类(以及可选的几何约束,例如大小、颜色和形状)和成对的空间关系(例如,“在……上”、“相邻”、“对齐”)。生成的模式被转发到资产索引以启动检索过程。如果约束条件与预定义的系统规则相冲突,解释器会与用户建立明确的反馈机制以进行澄清。

资产索引是一个基于 RAG 的资产检索模块。首先,根据外观、几何形状和用途,提取所有 5140 个对象的语义描述。随后,这些描述通过 QWEN: text-embedding-v4 模型编码为 2048 维向量,并存储在 ChromaDB 向量数据库中。运行时,规划器从场景描述中提取关键词(例如“黄色立方体”),并使用相同的模型将其编码到相同的嵌入空间。生成的查询向量与存储的资产嵌入向量通过余弦相似度进行比较,并检索出最相似的前 k 个候选对象及其元数据,包括通用场景描述 (USD) 路径、碰撞外壳、质量属性和纹理变体。这些资源无缝集成到 LLM 上下文中,确保后续代码生成仅引用预先验证的可用资源。此检索步骤对用户完全透明,通常在 200 毫秒内完成。

DSL 代码生成器利用场景语言 [37] 中定义的语法结构,并通过后端适配对其进行扩展,以实现与 Genie Sim 资源库的无缝互操作性。通过集成来自意图解释器、资源索引和 DSL 定义的上下文,系统利用预训练的 LLM 合成精确的场景规范。这种表示展现出精细的可控性、双浮点精度和增强的泛化能力。在引擎中维护聊天上下文,以支持迭代任务编辑。输出也可以手动调整,以解决 LLM 的局限性。通过将资源库嵌入到 LLM 上下文中,无需任何微调即可实现对类别、姿态、光照和纹理的联合泛化。资源库中丰富的语义标注和几何属性实现了场景级泛化。它还支持超出基本桌面场景的复杂布局,例如货架和储物架。

结果组装器最终收集聊天上下文的输出,并实例化由 LLM 生成的 DSL 程序。为了实现随机化,DSL 程序采用随机函数,引入对象姿态、布局模式和对象选择的变化。在实例化过程中,会创建一个包含两个主要部分的分层场景图:节点(用资源 ID、语义、大小、姿态和任务标签编码的对象)和边(空间关系,例如在……之上、在……之内、相邻、对齐和堆叠)。最后,组装器利用 OpenUSD Schema 和 Isaac Sim API 合成可用于仿真的 USD 文件。结果组装器利用 LLM 的强大功能和高级算法,在几分钟内生成数千个不同的场景,从而高效地生成海量场景布局。

评估生成

当前开源仿真基准测试通常依赖于预定义的指令、手动标注的成功标准以及重复的试验执行来评估 VLA 模型。这种范式导致指令空间高度单一,限制评估的可扩展性,并且创建新任务的成本很高。LLM 具有强大的自然语言理解能力,因此可以用于自动生成指令、分解任务和扩展提示,从而实现更多样化、可扩展且经济高效的评估流程。

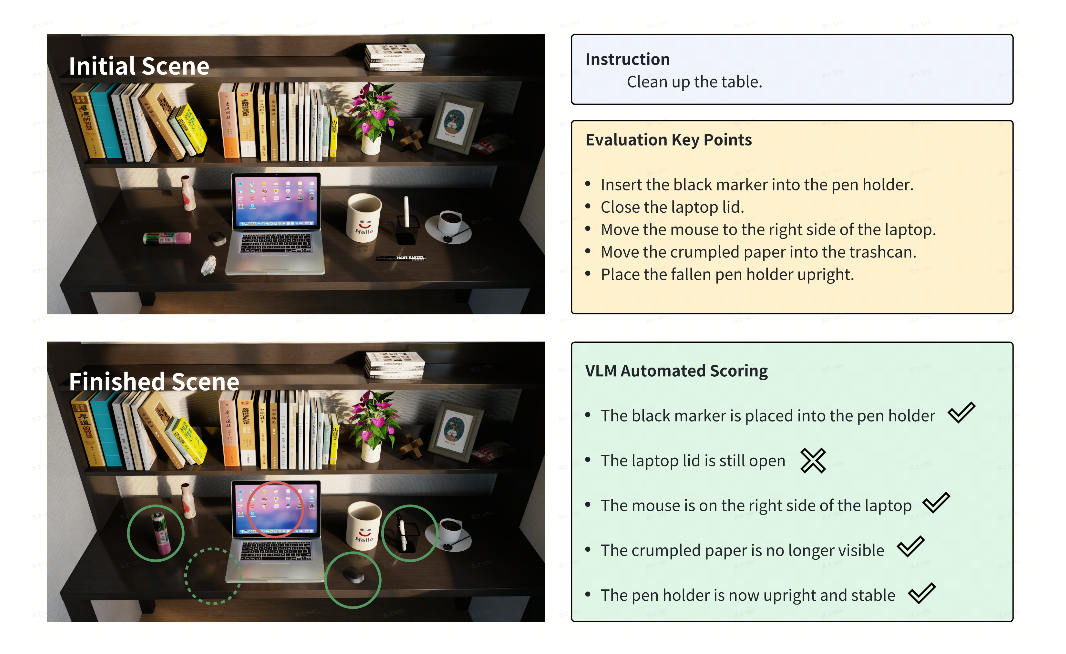

针对特定的仿真场景,Genie Sim Benchmark 将 LLM 与动作域评估规则 (ADER) 系统相结合,利用 LLM 的功能自动生成大量合理的指令和可执行的评估配置文件,然后将其集成到仿真器中进行自动评估。

VLM 展现出强大的视觉和语义理解能力。结合正式的任务规范以及任务执行过程中记录的视觉观察时间序列,VLM 可以高效地确定任务要求是否得到满足,并生成基于证据的论证(如图所示)。这种评估范式适用于大多数仿真基准任务,显著减少人工标注工作量,并允许以低成本创建大规模评估实例。

环境重建

为了提供大规模、高保真度的交互式仿真环境,利用 3DGS [38] 神经渲染技术进行照片级真实感图像渲染和表面重建,从而生成用于交互式物理仿真的高精度网格。用 SkylandX Innovation 的 MetaCam 手持式 3D 激光扫描仪采集数据。采集的数据包含鱼眼图像、每一帧对应的姿态以及整个场景的密集点云数据。

然而,3D 高斯溅射(3DGS) 对相机姿态精度提出相对严格的要求;即使是几个像素的偏差也会导致渲染模糊、伪影和几何凸起。在复杂的室内环境中,基于激光雷达的SLAM通常无法达到像素级的定位精度,导致姿态精度不足以进行高质量的3DGS重建。在相机姿态优化模块中,首先利用SuperPoint[39]和LightGLue[40]替换COLMAP-PCD[42]中的DSP-SIFT[41]和特征提取模块,从而降低2D特征点的噪声并增强弱纹理特征的提取能力。然后,直接使用激光雷达SLAM获得的相机先验姿态进行三角测量,并搜索与激光雷达3D点对应的2D特征点进行关联,同时利用稀疏3D点进行BA优化。在使用COLMAP-PCD获得相机姿态和3D点数据输出后,用开源的gsplat[43]框架训练3DGS。在大规模场景重建过程中,采集足够的视图覆盖范围始终是不可避免的。为了弥补采集过程中视图数量不足的问题,并提高渲染质量,用生成模型外推足够的视图。用 Difix3D+ [44] 中的预训练模型来渲染外推视图,从而获得高质量图像。最后,利用扩散模型生成的大量新透视图像及其对应的姿态数据,以及数据采集过程中获取的激光雷达点云数据,进行基于表面重建的 3DGS 训练。用 PGSR [45] 进行表面重建,并获得高精度网格。

数据生成

数据采集框架融合两种互补的范式:远程操作和自动化。远程操作用于执行复杂的长时域任务,以生成高质量的类人演示。相比之下,自动化采集在效率和成本效益方面表现出色,能够快速生成用于机器人模仿学习的大量合成数据。

远程操作:远程操作框架利用PICO VR头戴式显示器(PICO)设备,将人机交互输入与模拟机器人环境连接起来。PICO作为主要输入设备,向中央主机发送代表目标末端执行器姿态的动作信号。基准测试模块处理这些信号,运动控制器执行预先设定的轨迹,从而驱动机器人在模拟环境中的虚拟运动。

该模拟系统融入现实世界中的物理效应,包括碰撞和摩擦,使机器人能够操控模拟物体并与之交互。整个交互过程,包括机器人关节状态、视觉观测和物体姿态,都会被完整记录,构成合成数据集。因此,该方法生成拟人化运动数据,并利用人类的专业知识来解决难以自动化的复杂任务。

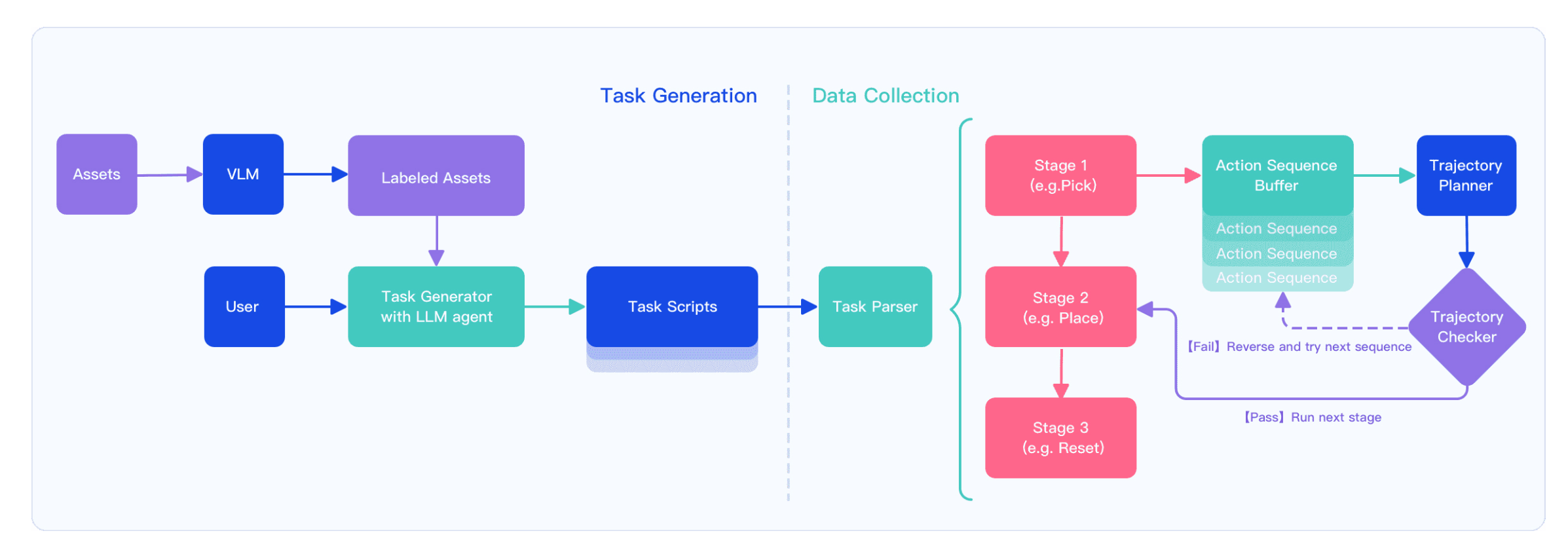

自动化采集:利用 cuRobo [46](一款 GPU 加速的运动规划器)作为核心轨迹规划模块,全自动数据采集流程包含两个部分:任务生成和数据采集(如图所示)。任务生成由基于 LLM 的资产检索系统完成,该系统能够利用预定义的原子技能高效地查询和组装所需的仿真资产。

在任务解析过程中,候选关键路径点(源自预先标注的资产配置,例如 GraspNet [47] 标注的抓取姿态)会根据运动学可达性、碰撞规避和拟人化可行性进行评估。为了提高鲁棒性,每个动作会生成多个候选路径点,从而形成多个备选动作序列。每个序列都会在仿真环境中执行,随后由专门的轨迹评估模块进行评估。如果执行失败,则会在尝试下一个候选序列之前执行状态回滚。

与大多数简化规划环境的先前方法(例如,排除与任务不直接相关的物体,这可能导致在杂乱场景中发生碰撞)不同,系统保留环境的完整性。为了平衡完整性和效率,在场景初始化期间对物体几何体应用网格简化,从而在保持轨迹可靠性的同时,显著提高规划期间的计算效率。

闭环评估

对于模型闭环评估,仿真环境和模型推理环境是解耦的,并通过超文本传输协议 (HTTP) 进行通信。仿真器将机器人的观测图像和本体感觉状态传输到推理服务,模型返回控制命令,然后在仿真环境中执行这些命令。在仿真执行期间,会定期评估任务完成情况;如果任务完成,则仿真终止;否则,将调用预定义的超时程序来终止运行。 Genie Sim 3.0 基准测试支持以下评估功能:

• 与常用 VLA 模型集成(π0.5 [48]、GO-1 [20]、UniVLA [49]、RDT [50]、X-VLA [51] 等)

• 多种机器人类型(Genie G1、Genie G2)

• 多种末端执行器(全能拾取器、全能手、IN-SPIRE 技能手、智星夹爪等)

• 本地/分布式推理框架

• 自动化和多维评估

DAMO开发者矩阵,由阿里巴巴达摩院和中国互联网协会联合发起,致力于探讨最前沿的技术趋势与应用成果,搭建高质量的交流与分享平台,推动技术创新与产业应用链接,围绕“人工智能与新型计算”构建开放共享的开发者生态。

更多推荐

已为社区贡献115条内容

已为社区贡献115条内容

所有评论(0)