【论文自动阅读】PointWorld: Scaling 3D World Models for In-The-Wild Robotic Manipulation

本文提出了一种名为 PointWorld 的大规模预训练 3D 世界模型,仅需一张 RGB-D 图像和机器人的动作指令,就能预测场景中物体未来的变化,从而让机器人在从未见过的环境中完成复杂的操作任务。

快速了解部分

基础信息(英文):

- 题目: PointWorld: Scaling 3D World Models for In-The-Wild Robotic Manipulation

- 时间: 2026.01 (arXiv:2601.03782)

- 机构: Stanford University, NVIDIA

- 3个英文关键词: 3D World Models, Robotic Manipulation, Point Flows

1句话通俗总结本文干了什么事情

本文提出了一种名为 PointWorld 的大规模预训练 3D 世界模型,仅需一张 RGB-D 图像和机器人的动作指令,就能预测场景中物体未来的变化,从而让机器人在从未见过的环境中完成复杂的操作任务。

研究痛点:现有研究不足 / 要解决的具体问题

现有的世界模型要么基于视频预测但缺乏物理一致性,要么依赖物理仿真但难以跨越到真实世界(Sim-to-Real Gap),且通常局限于特定的机器人形态。本文旨在解决如何构建一个通用的、基于 3D 几何的世界模型,使其能跨形态(如单臂、双臂)泛化,并直接在野外(In-The-Wild)真实环境中通过视觉预测物理动态。

核心方法:关键技术、模型或研究设计(简要)

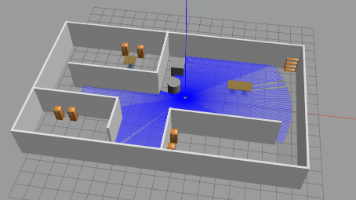

核心方法是将机器人的动作和场景状态都统一表示为 3D 点流(Point Flows)。模型以静态的场景点云和机器人动作的 3D 轨迹作为输入,预测场景中每个点的位移。通过在大规模真实与模拟数据上预训练,实现对刚体、可变形物体和关节物体的动态预测。

深入了解部分

相比前人创新在哪里

- 统一的 3D 表示:不同于以往使用关节空间或 2D 图像的方法,PointWorld 使用 3D 点流作为“通用语言”,既包含几何信息又包含动作信息,实现了跨不同机器人形态(如 Franka 机械臂和双臂人形机器人)的共同学习。

- 无需微调的泛化能力:模型在大规模数据上预训练后,直接在未见过的真实场景中通过模型预测控制(MPC)进行规划,无需针对特定任务进行微调或额外的演示数据。

- 大规模真实数据集构建:作者建立了一套高精度的 3D 注释流水线,从现有的 2D 视频数据中提取了高质量的 3D 点流监督信号,构建了包含约 200 万条轨迹的大规模数据集。

解决方法/算法的通俗解释

想象一下,机器人不是在“看”图像,而是在“看”空间中无数个漂浮的点。当机器人手部移动时,它也在空间中划出一道“点的轨迹”。

PointWorld 的核心逻辑是:“如果我的手(点的轨迹)穿过这些物体(场景点),物体上的点会怎么移动?”

模型通过学习海量的“手部轨迹 -> 物体点移动”的对应关系,学会了物理常识。在实际使用时,它通过尝试不同的“手部轨迹”,模拟出物体可能的反应,从而选出最佳的动作方案。

解决方法的具体做法

- 数据处理:使用 RGB-D 相机获取场景点云;利用机器人 URDF 模型和动作序列,生成机器人手部表面的 3D 点轨迹。

- 模型架构:使用 PointTransformerV3 (PTv3) 作为骨干网络。场景点的特征通过冻结的 DINOv3 图像特征投影获得,机器人点则通过时间嵌入编码。两者拼接后输入网络。

- 预测机制:模型采用 Chunked Prediction(分块预测),一次性预测未来 10 步(1秒)的点云位移,而不是一步一步预测,这提高了计算效率和长期预测的稳定性。

- 训练目标:使用加权 Huber 损失函数,重点学习移动的点(Movement Weighting),并预测不确定性(Uncertainty Regularization)来处理真实数据的噪声。

基于前人的哪些方法

- Graph-Based Neural Dynamics (GBND):本文最初以此为基线,但发现其在大规模数据和部分可观测性上存在局限,因此改用 PTv3。

- DINOv2 / DINOv3:利用预训练的视觉模型提取场景点的语义和几何特征。

- Model Predictive Control (MPPI):在部署阶段,利用 MPPI(模型预测路径积分控制)算法,基于 PointWorld 的预测结果进行实时动作规划。

实验设置、数据、评估方式、结论

- 数据:混合了真实数据集 DROID(约 200 小时)和模拟数据集 BEHAVIOR-1K(约 1100 小时),总计约 200 万条轨迹。

- 评估方式:

- 仿真指标:计算预测点云与真实点云之间的 L2L_2L2 距离(特别是移动点的误差 l2l_2l2 mover)。

- 真实机器人实验:在 Franka 机械臂上测试,任务包括刚体推动、可变形物体(围巾、枕头)折叠/放置、关节物体(微波炉、抽屉)操作以及工具使用(扫帚、除尘器)。

- 结论:

- 模型规模越大(从 50M 到 1B 参数),预测精度越高。

- 在真实机器人测试中,PointWorld 仅凭一张图像和预训练模型,就能在未见过的环境中完成多种操作任务,且无需微调。例如,在 DROID 数据集未包含的“双臂”或“全身”任务上也展现了零样本泛化能力。

提到的同类工作

- GBND (Graph-Based Neural Dynamics):基于图网络的动力学模型,常用于动力学建模,但受限于内存和局部消息传递。

- DROID:大规模野外机器人操作数据集,提供了原始视频数据,但缺乏高精度的 3D 标注。

- FoundationStereo / CoTracker3:用于从 2D 图像中估计深度和进行点跟踪的基础模型,被本文用于构建 3D 数据流水线。

- NeRF / 3D Gaussian Splatting:其他 3D 表示方法,但本文指出点流在处理物理交互和接触时比这些外观模型更直接。

和本文相关性最高的3个文献

- **DROID **:本文所使用的大部分真实世界机器人操作数据的来源,作者对其进行了重新的 3D 注释。

- **BEHAVIOR-1K **:本文所使用的模拟数据集,提供了大规模的双臂和全身操作数据。

- **PointTransformerV3 **:本文作为骨干网络采用的核心架构,使得大规模扩展 3D 世界模型成为可能。

我的

给一张首帧,外加机器人的action,可以得到后续全局点云的变化。相当于可以根据机器人的点云变化,预测obj的点云变化。

DAMO开发者矩阵,由阿里巴巴达摩院和中国互联网协会联合发起,致力于探讨最前沿的技术趋势与应用成果,搭建高质量的交流与分享平台,推动技术创新与产业应用链接,围绕“人工智能与新型计算”构建开放共享的开发者生态。

更多推荐

已为社区贡献53条内容

已为社区贡献53条内容

所有评论(0)