【论文自动阅读】SiLRI:Real-world Reinforcement Learning from Suboptimal Interventions

·

快速了解部分

基础信息(英文):

- 题目: Real-world Reinforcement Learning from Suboptimal Interventions

- 时间: 2025.12

- 机构: Beijing Innovation Center of Humanoid Robotics, City University of Hong Kong, Nankai University, Beijing Institute of Technology

- 3个英文关键词: Real-world RL, Human-in-the-loop, Suboptimal Interventions

- 项目主页:https://silri-rl.github.io/

1句话通俗总结本文干了什么事情

本文提出了一种名为SiLRI的算法,旨在让机器人在现实世界中通过学习人类不完美的干预操作来加速学习,同时利用强化学习超越人类的操作水平。

研究痛点:现有研究不足 / 要解决的具体问题

现有方法通常假设人类干预在所有状态下都是最优的,但现实中即使是专家也无法在所有状态下提供完美动作,且难免犯错。如果盲目混合干预数据和机器人数据,会继承RL的样本低效性;如果单纯模仿干预数据,最终性能又会受限于人类水平。

核心方法:关键技术、模型或研究设计(简要)

提出SiLRI(State-wise Lagrangian Reinforcement Learning)算法。将在线操作问题转化为约束RL优化问题,根据人类干预的不确定性动态调整约束边界,并引入状态相关的拉格朗日乘子(state-wise Lagrange multiplier)来平衡强化学习和模仿学习的目标。

深入了解部分

相比前人创新在哪里

- 状态级不确定性处理:不同于以往将人类干预视为全局最优或简单混合数据,SiLRI显式地考虑了不同状态下人类干预的不确定性(熵)。

- 自适应平衡机制:在低熵状态(人类操作稳定)下强制策略靠近人类行为,在高熵状态(人类操作不稳定)下放松约束,允许策略通过RL目标进行自我探索和优化,从而超越人类表现。

- 双层优化设计:通过极小极大(min-max)优化同时优化策略和拉格朗日乘子,实现了RL和IL目标的自适应权衡。

解决方法/算法的通俗解释

想象一个新手司机(机器人)在学车,旁边有一个偶尔会抢方向盘的副驾驶(人类干预)。SiLRI算法的作用就像是一个智能教练:

- 当副驾驶在直路上操作非常稳定时(低熵),教练要求新手必须模仿副驾驶的动作。

- 但当车开到复杂弯道,副驾驶自己也手忙脚乱、操作不一致时(高熵),教练就不再强迫新手模仿,而是让新手根据自己的判断(通过强化学习获得的Q值)来开车,甚至可能开得比副驾驶更好。

解决方法的具体做法

- 构建约束优化问题:目标是最大化强化学习回报,同时限制策略不能偏离人类行为策略太远,但这个“远近”的标准根据状态动态变化。

- 引入状态级拉格朗日乘子:设计一个网络 λ ( s ) \lambda(s) λ(s) 来输出每个状态下的乘子。如果当前状态人类干预很混乱(方差大), λ \lambda λ 就变小,RL项主导;如果人类干预很一致, λ \lambda λ 就变大,模仿学习(BC)项主导。

- 联合优化:通过min-max优化求解,一方面更新策略网络以提高回报和模仿人类,另一方面更新拉格朗日网络以确保约束被满足。

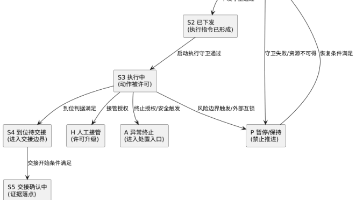

- 人机协作系统:基于“人类作为副驾驶”的遥操作模式,实时收集在线数据和干预数据进行训练。

基于前人的哪些方法

- HIL-SERL:借鉴了人机回路强化学习的框架和异步Actor-Critic架构。

- ConRFT:参考了结合行为克隆和Q-learning的一致性策略方法。

- 约束优化理论:基于PPO-Lagrangian及状态相关拉格朗日乘子的研究,将其应用到人类干预的场景中。

实验设置、数据、评估方式、结论

- 实验设置:在8个现实世界的机械臂操作任务中进行测试(如挂中国结、插USB、关垃圾桶盖等),使用UR5和Franka Emika两种机械臂。

- 对比基线:HIL-SERL, ConRFT, HG-Dagger。

- 评估方式:成功率(Success Rate)、干预比例(Intervention Ratio)、回合长度(Episode length)。

- 结论:

- SiLRI将达到90%成功率所需的时间减少了至少50%(相比HIL-SERL)。

- 在长程、高精度任务(如挂中国结)中实现了100%的成功率,而其他方法难以完成。

- 证明了该方法在处理人类操作失误和不同技能水平的操作员时具有鲁棒性。

提到的同类工作

- HIL-SERL:利用预训练视觉骨干和离线演示进行人机回路强化学习。

- ConRFT:VLA模型的两阶段强化微调框架,结合了校准Q-learning和行为克隆。

- HG-Dagger:一种稳定高效的在线模仿学习算法,仅依赖离线演示和在线修正数据。

- HAPO:将干预轨迹整合到基于RLHF框架的动作偏好优化中。

- MILE & RLIF:使用干预信号而非直接动作,但受限于较小的视觉运动骨干和仿真环境。

和本文相关性最高的3个文献

- HIL-SERL:本文最主要的对比基线之一,代表了当前最先进的现实世界人机回路RL方法。

- ConRFT:本文的主要对比基线之一,代表了结合模仿学习和强化学习的VLA模型微调方法。

- State-dependent lagrange multipliers :本文算法的核心理论基础,SiLRI借鉴了其中状态相关拉格朗日乘子的设计思路并进行了改进。

DAMO开发者矩阵,由阿里巴巴达摩院和中国互联网协会联合发起,致力于探讨最前沿的技术趋势与应用成果,搭建高质量的交流与分享平台,推动技术创新与产业应用链接,围绕“人工智能与新型计算”构建开放共享的开发者生态。

更多推荐

已为社区贡献40条内容

已为社区贡献40条内容

所有评论(0)