Java中的多层感知器:构建高效的深度学习模型

通过本文,你已经了解了如何在Java中实现多层感知器,并通过前向传播、反向传播和梯度下降算法训练模型。MLP作为深度学习的基础,能够用于解决各种复杂的分类和回归问题。大家好,我是微赚淘客系统3.0的小编,是个冬天不穿秋裤,天冷也要风度的程序猿!它由多个层级组成,包括输入层、隐藏层和输出层,能够处理复杂的非线性关系。反向传播是多层感知器训练的核心部分,它通过计算损失函数相对于每个权重的偏导数,并使用

Java中的多层感知器:构建高效的深度学习模型

大家好,我是微赚淘客系统3.0的小编,是个冬天不穿秋裤,天冷也要风度的程序猿!今天我们将讨论如何在Java中构建和实现多层感知器(Multilayer Perceptron, MLP),以及如何有效地运用它来创建深度学习模型。

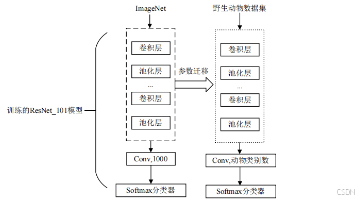

多层感知器是深度学习中最基础的神经网络架构之一。它由多个层级组成,包括输入层、隐藏层和输出层,能够处理复杂的非线性关系。本文将详细讲解如何在Java中实现多层感知器,并展示如何通过梯度下降等优化算法来训练模型。

1. 多层感知器的基本原理

多层感知器是一种前馈神经网络,特点是每一层的神经元与下一层的所有神经元全连接。它的每一层主要执行以下步骤:

- 加权求和:输入数据通过权重矩阵和偏置向量进行加权求和。

- 激活函数:加权求和的结果通过激活函数进行非线性映射。

- 反向传播:通过损失函数计算误差并使用梯度下降算法调整权重。

MLP的核心组成部分包括输入层、隐藏层和输出层。

2. 构建多层感知器的结构

一个典型的多层感知器由以下几部分构成:

- 输入层:接收原始输入数据。

- 隐藏层:使用激活函数处理输入数据。

- 输出层:根据任务类型输出预测值。

为了实现MLP,我们需要先定义神经网络的层结构,然后实现前向传播和反向传播的机制。

3. 使用Java构建多层感知器

我们可以使用Java编写一个简单的多层感知器模型。这个例子展示了如何构建一个具有一个隐藏层的MLP,并使用随机梯度下降(SGD)算法进行训练。

3.1 初始化网络结构

首先,我们定义多层感知器的层及其权重和偏置:

package cn.juwatech.mlp;

import java.util.Random;

public class MultilayerPerceptron {

private int inputSize;

private int hiddenSize;

private int outputSize;

private double[][] weightsInputHidden;

private double[][] weightsHiddenOutput;

private double[] hiddenBias;

private double[] outputBias;

public MultilayerPerceptron(int inputSize, int hiddenSize, int outputSize) {

this.inputSize = inputSize;

this.hiddenSize = hiddenSize;

this.outputSize = outputSize;

weightsInputHidden = new double[inputSize][hiddenSize];

weightsHiddenOutput = new double[hiddenSize][outputSize];

hiddenBias = new double[hiddenSize];

outputBias = new double[outputSize];

initializeWeights();

}

private void initializeWeights() {

Random rand = new Random();

for (int i = 0; i < inputSize; i++) {

for (int j = 0; j < hiddenSize; j++) {

weightsInputHidden[i][j] = rand.nextGaussian(); // 初始化为随机值

}

}

for (int i = 0; i < hiddenSize; i++) {

for (int j = 0; j < outputSize; j++) {

weightsHiddenOutput[i][j] = rand.nextGaussian(); // 初始化为随机值

}

}

}

}

4. 前向传播与激活函数

前向传播是将输入数据通过网络层传播到输出层的过程。每一层使用激活函数来处理输入值。常用的激活函数包括 ReLU 和 Sigmoid。

4.1 ReLU激活函数

ReLU(Rectified Linear Unit)激活函数在隐藏层中常用,公式如下:

[ f(x) = \max(0, x) ]

我们在Java中实现ReLU激活函数:

private double relu(double x) {

return Math.max(0, x);

}

4.2 前向传播实现

接下来实现输入到隐藏层的前向传播,并使用ReLU作为激活函数:

public double[] forwardPass(double[] input) {

// 隐藏层

double[] hiddenLayerOutput = new double[hiddenSize];

for (int i = 0; i < hiddenSize; i++) {

hiddenLayerOutput[i] = hiddenBias[i];

for (int j = 0; j < inputSize; j++) {

hiddenLayerOutput[i] += input[j] * weightsInputHidden[j][i];

}

hiddenLayerOutput[i] = relu(hiddenLayerOutput[i]); // 激活

}

// 输出层

double[] outputLayerOutput = new double[outputSize];

for (int i = 0; i < outputSize; i++) {

outputLayerOutput[i] = outputBias[i];

for (int j = 0; j < hiddenSize; j++) {

outputLayerOutput[i] += hiddenLayerOutput[j] * weightsHiddenOutput[j][i];

}

// 假设使用Sigmoid作为输出层激活函数

outputLayerOutput[i] = sigmoid(outputLayerOutput[i]);

}

return outputLayerOutput;

}

private double sigmoid(double x) {

return 1 / (1 + Math.exp(-x)); // Sigmoid激活函数

}

5. 反向传播与梯度下降

反向传播是多层感知器训练的核心部分,它通过计算损失函数相对于每个权重的偏导数,并使用梯度下降算法来更新权重。我们可以实现简单的均方误差损失函数,并通过链式法则计算梯度。

5.1 反向传播计算

public void backwardPass(double[] input, double[] actualOutput, double[] predictedOutput, double learningRate) {

// 计算输出层的误差

double[] outputError = new double[outputSize];

for (int i = 0; i < outputSize; i++) {

outputError[i] = actualOutput[i] - predictedOutput[i]; // 假设使用均方误差

}

// 更新隐藏层到输出层的权重和偏置

for (int i = 0; i < hiddenSize; i++) {

for (int j = 0; j < outputSize; j++) {

weightsHiddenOutput[i][j] += learningRate * outputError[j] * hiddenLayerOutput[i];

}

}

// 更新输出层偏置

for (int i = 0; i < outputSize; i++) {

outputBias[i] += learningRate * outputError[i];

}

// 计算隐藏层的误差

double[] hiddenError = new double[hiddenSize];

for (int i = 0; i < hiddenSize; i++) {

for (int j = 0; j < outputSize; j++) {

hiddenError[i] += outputError[j] * weightsHiddenOutput[i][j];

}

hiddenError[i] *= reluDerivative(hiddenLayerOutput[i]);

}

// 更新输入层到隐藏层的权重和偏置

for (int i = 0; i < inputSize; i++) {

for (int j = 0; j < hiddenSize; j++) {

weightsInputHidden[i][j] += learningRate * hiddenError[j] * input[i];

}

}

// 更新隐藏层偏置

for (int i = 0; i < hiddenSize; i++) {

hiddenBias[i] += learningRate * hiddenError[i];

}

}

private double reluDerivative(double x) {

return x > 0 ? 1 : 0; // ReLU导数

}

6. 训练多层感知器

有了前向传播和反向传播的实现,我们可以通过循环迭代对MLP进行训练:

public void train(double[][] inputs, double[][] outputs, int epochs, double learningRate) {

for (int epoch = 0; epoch < epochs; epoch++) {

for (int i = 0; i < inputs.length; i++) {

double[] predictedOutput = forwardPass(inputs[i]);

backwardPass(inputs[i], outputs[i], predictedOutput, learningRate);

}

System.out.println("Epoch " + (epoch + 1) + " completed.");

}

}

7. 总结

通过本文,你已经了解了如何在Java中实现多层感知器,并通过前向传播、反向传播和梯度下降算法训练模型。MLP作为深度学习的基础,能够用于解决各种复杂的分类和回归问题。希望你能够通过上述代码构建自己的深度学习模型,并根据实际需求优化网络结构和超参数。

本文著作权归聚娃科技微赚淘客系统开发者团队,转载请注明出处!

DAMO开发者矩阵,由阿里巴巴达摩院和中国互联网协会联合发起,致力于探讨最前沿的技术趋势与应用成果,搭建高质量的交流与分享平台,推动技术创新与产业应用链接,围绕“人工智能与新型计算”构建开放共享的开发者生态。

更多推荐

已为社区贡献3条内容

已为社区贡献3条内容

所有评论(0)