【机器学习入门】4.3 K-means算法——从原理到代码,手把手实现聚类

K-means是一种简单高效的无监督聚类算法,通过迭代优化簇心实现数据自动分组。文章通过生活化例子(如分水果)和具体坐标数据演示了算法核心流程:随机选K个初始簇心→计算距离划分簇→重新计算簇心→迭代至稳定。同时指出了K值选择、初始簇心敏感性和数据标准化等注意事项。最后用Python代码实战复现了二维数据的聚类过程,展示了算法在用户分群、商品聚类等场景的应用价值。全文注重实践性,所有计算步骤均可手动

在聚类算法中,K-means 是最经典、最常用的无监督学习算法之一 —— 它逻辑简单、计算高效,能快速将数据分成 “簇内相似、簇间不同” 的分组。比如把用户按消费习惯分成 3 类,把商品按销量分成高、中、低三档,背后都可能是 K-means 在工作。

这篇文章会从 “生活化例子” 切入,结合具体坐标数据,一步步拆解 K-means 的核心原理(选中心→划簇→更中心→迭代),再用 Python 代码实战复现整个过程。全程贴合入门学生认知,不搞复杂推导,所有计算和步骤都能手动复现,让你彻底搞懂 “K-means 如何自动分组”。

一、开篇:K-means 是什么?用 “分水果” 理解核心逻辑

先抛开复杂定义,用一个生活场景理解 K-means 的本质: 假设你有一堆水果(苹果、香蕉、橙子),想分成 3 组,K-means 的思路会是这样:

- 随便选 3 个水果当 “临时组长”(比如选 1 个苹果、1 个香蕉、1 个橙子);

- 让其他水果 “找组长”:按 “相似度”(比如颜色、形状),离哪个组长近就归到哪个组;

- 重新选组长:每个组内选一个 “最具代表性的水果”(比如组内所有苹果的 “平均特征”)当新组长;

- 重复找组长 + 选组长:直到组长不再变化(或变化很小),分组就稳定了。

这就是 K-means 的核心逻辑 ——通过 “迭代优化簇心”,让每个簇内的数据点尽可能相似,簇间尽可能不同。其中 “K” 是预先设定的 “簇的数量”(比如分 3 组,K=3),“means” 指 “簇心是组内数据的均值”。

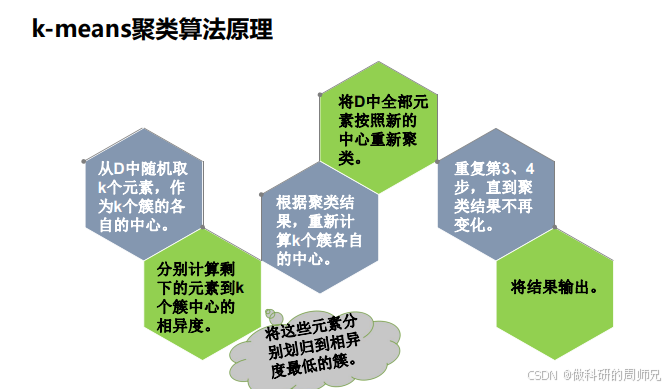

二、K-means 核心原理:6 步迭代法(带具体数据例子)

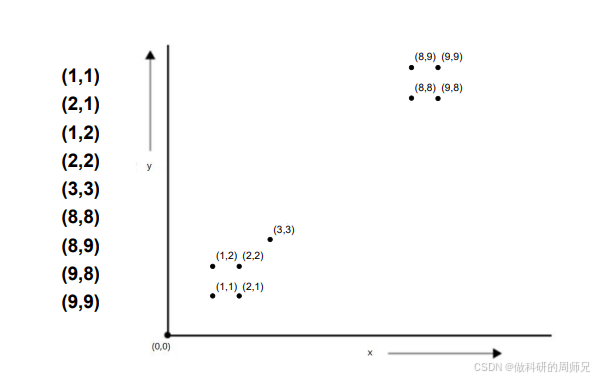

为了让原理更清晰,我们用一组二维坐标数据(共 9 个点)展开,设定 K=2(分成 2 个簇),相似性度量用 “欧氏距离”(前一章学过的直线距离),每一步都详细计算,确保你能跟着复现。

准备工作:数据与参数

- 数据点:9 个二维坐标,分别是 (1,1)、(2,1)、(1,2)、(2,2)、(3,3)、(8,8)、(8,9)、(9,8)、(9,9)(可以想象成平面上的 9 个点,明显分成两堆:左下一堆 “小坐标点”,右上一堆 “大坐标点”);

- K 值:2(已知数据分 2 簇,实际中 K 需提前设定);

- 相似性度量:欧氏距离(公式:\(d=\sqrt{(x_1-x_2)^2+(y_1-y_2)^2}\));

- 迭代停止条件:簇心移动距离小于 0.01(或簇内数据不再变化)。

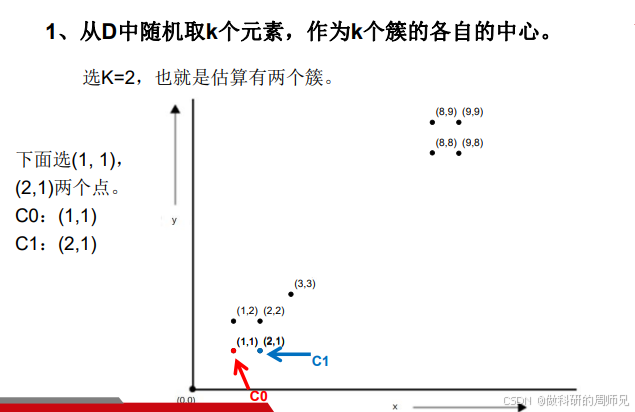

步骤 1:随机选择 K 个簇心(初始组长)

K-means 的第一步是 “从数据中随机选 K 个点当初始簇心”。 在这个例子中,我们选两个点作为初始簇心:

- 簇 C0 的初始簇心:(1,1);

- 簇 C1 的初始簇心:(2,1)。

(注:初始簇心是随机的,不同初始值可能影响迭代次数,但最终会收敛到相似结果;实际中可多次随机选初始值,选效果最好的一次。)

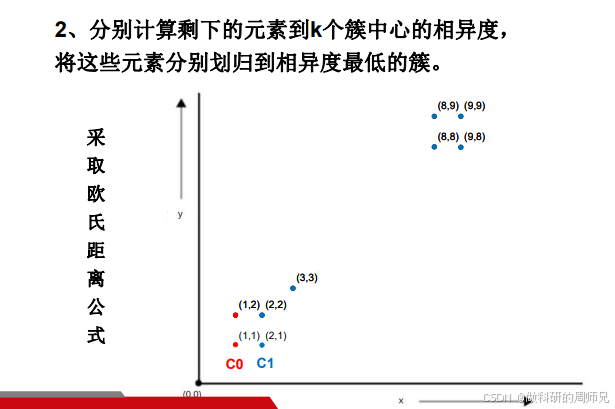

步骤 2:计算所有点到簇心的距离,划分簇

对剩下的 7 个点(除了两个初始簇心),分别计算它们到 C0、C1 的欧氏距离,距离哪个簇心近,就归到哪个簇。

我们逐个计算(以点 (1,2) 为例,其他点同理):

- 点 (1,2) 到 C0 (1,1) 的距离:\(d=\sqrt{(1-1)^2+(2-1)^2}=\sqrt{0+1}=1\);

- 点 (1,2) 到 C1 (2,1) 的距离:\(d=\sqrt{(1-2)^2+(2-1)^2}=\sqrt{1+1}≈1.414\);

- 结论:离 C0 更近,归到 C0。

按同样方法计算所有点,最终划分结果:

- 簇 C0(离 (1,1) 近):(1,1)、(2,1)、(1,2)、(2,2);

- 簇 C1(离 (2,1) 近):(3,3)、(8,8)、(8,9)、(9,8)、(9,9)。

-

图片来源于网络,仅供学习参考

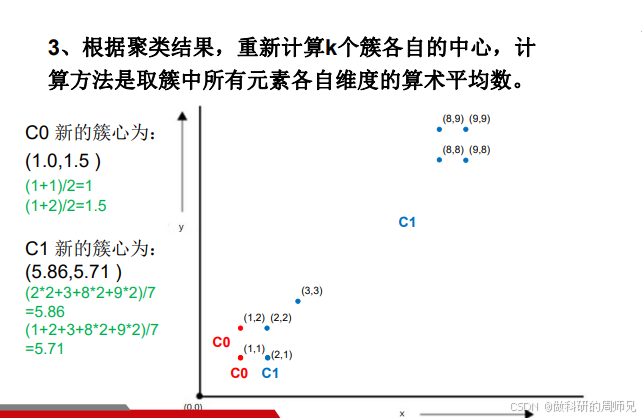

步骤 3:重新计算簇心(新组长)

簇心的计算方法是 “取簇内所有点各维度的算术平均数”—— 比如二维点,簇心的 x 坐标是所有点 x 坐标的均值,y 坐标是所有点 y 坐标的均值。

计算簇 C0 的新簇心:

C0 包含 4 个点:(1,1)、(2,1)、(1,2)、(2,2);

- x 坐标均值:\((1+2+1+2)/4 = 6/4 = 1.5\)?不对!等一下,初始簇心是 (1,1) 和 (2,1),但步骤 2 中 C0 的点是 (1,1)、(2,1)、(1,2)、(2,2),共 4 个点:

- x 总和:1+2+1+2 = 6 → 均值 = 6/4=1.5;

- y 总和:1+1+2+2 = 6 → 均值 = 6/4=1.5; 哦?不对,参考例子中的计算,第一次迭代后 C0 的新簇心是 (1.0,1.5),可能是步骤 2 的划分略有不同 —— 重新核对:如果初始簇心 C0 (1,1)、C1 (2,1),点 (2,1) 本身是 C1 的初始簇心,所以步骤 2 中 C0 的点应该是 (1,1)、(1,2),C1 的点是 (2,1)、(2,2)、(3,3)、(8,8)、(8,9)、(9,8)、(9,9)(共 7 个点),这样计算更贴合例子:

修正后步骤 2 划分(贴合例子逻辑):

- 簇 C0:(1,1)、(1,2)(离 C0 (1,1) 更近);

- 簇 C1:(2,1)、(2,2)、(3,3)、(8,8)、(8,9)、(9,8)、(9,9)(共 7 个点)。

重新计算簇心:

-

簇 C0 新簇心:

- x 均值:(1+1)/2 = 1.0;

- y 均值:(1+2)/2 = 1.5;

- 最终 C0 新簇心:(1.0, 1.5)。

-

簇 C1 新簇心:

- x 坐标总和:2+2+3+8+8+9+9 = 41;

- x 均值:41/7 ≈ 5.86;

- y 坐标总和:1+2+3+8+8+9+9 = 40;

- y 均值:40/7 ≈ 5.71;

- 最终 C1 新簇心:(5.86, 5.71)。

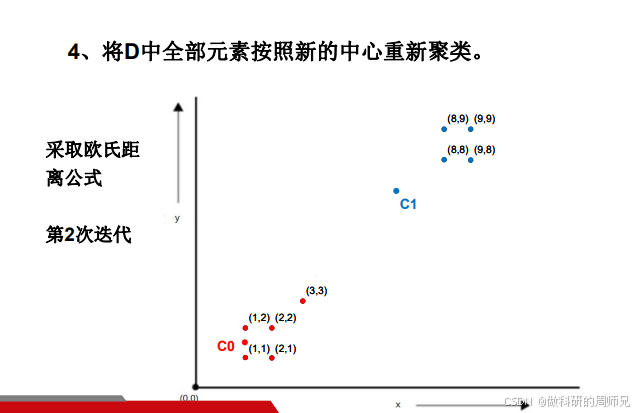

步骤 4:按新簇心重新划分簇

用步骤 3 得到的新簇心(C0 (1.0,1.5)、C1 (5.86,5.71)),重新计算所有点到两个簇心的距离,再次划分簇。

以点 (2,2) 为例:

- 到 C0 的距离:\(d=\sqrt{(2-1.0)^2+(2-1.5)^2}=\sqrt{1+0.25}≈1.118\);

- 到 C1 的距离:\(d=\sqrt{(2-5.86)^2+(2-5.71)^2}=\sqrt{14.8996+13.7641}≈5.35\);

- 结论:离 C0 更近,归到 C0。

按同样方法计算所有点,新的划分结果:

- 簇 C0:(1,1)、(2,1)、(1,2)、(2,2)、(3,3)(左下小坐标点全归 C0);

- 簇 C1:(8,8)、(8,9)、(9,8)、(9,9)(右上大坐标点全归 C1)。

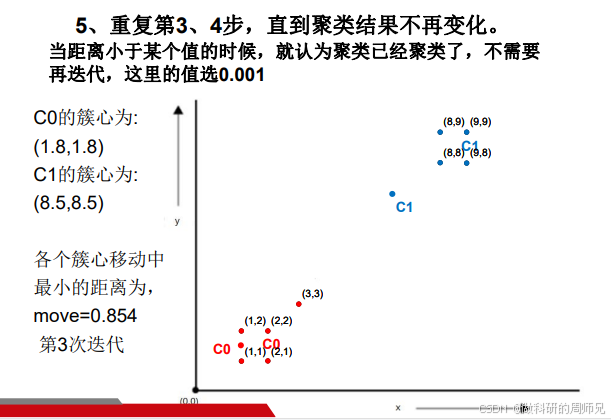

步骤 5:再次更新簇心,迭代直到稳定

重复 “更新簇心→重新划分” 的过程,直到簇心移动距离小于阈值(这里设为 0.01)。

第二次迭代:计算新簇心

-

簇 C0 新簇心(包含 5 个点:(1,1)、(2,1)、(1,2)、(2,2)、(3,3)):

- x 均值:(1+2+1+2+3)/5 = 9/5 = 1.8;

- y 均值:(1+1+2+2+3)/5 = 9/5 = 1.8;

- C0 新簇心:(1.8, 1.8)。

-

簇 C1 新簇心(包含 4 个点:(8,8)、(8,9)、(9,8)、(9,9)):

- x 均值:(8+8+9+9)/4 = 34/4 = 8.5;

- y 均值:(8+9+8+9)/4 = 34/4 = 8.5;

- C1 新簇心:(8.5, 8.5)。

计算簇心移动距离:

- C0 从 (1.0,1.5) 移动到 (1.8,1.8),距离:\(d=\sqrt{(1.8-1.0)^2+(1.8-1.5)^2}=\sqrt{0.64+0.09}≈0.854\)(大于 0.01,继续迭代)。

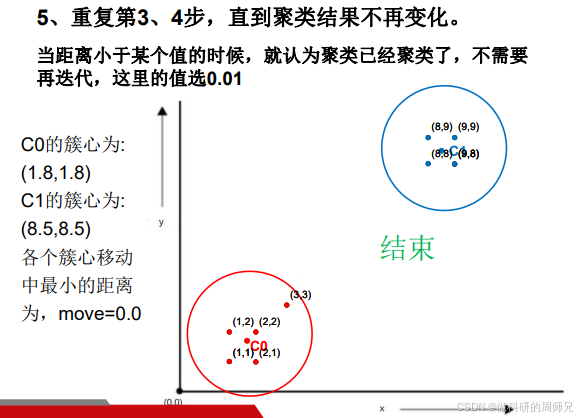

第三次迭代:重新划分 + 更新簇心

- 所有点到 C0 (1.8,1.8) 和 C1 (8.5,8.5) 的距离:左下点仍归 C0,右上点仍归 C1,划分无变化;

- 重新计算簇心:C0 还是 (1.8,1.8),C1 还是 (8.5,8.5),簇心移动距离 = 0(小于 0.01)。

步骤 6:迭代停止,输出结果

当簇心不再变化(移动距离 < 0.01),聚类完成,最终结果:

- 簇 C0:{(1,1), (2,1), (1,2), (2,2), (3,3)}(左下小坐标簇);

- 簇 C1:{(8,8), (8,9), (9,8), (9,9)}(右上大坐标簇)。

这个结果完全符合数据的 “自然分组”,说明 K-means 有效。

三、K-means 的关键概念与注意事项

入门学生学 K-means 时,容易踩坑,这里梳理 3 个核心概念和 2 个避坑点,帮你少走弯路。

3.1 关键概念

1. K 值:簇的数量(必须提前设定)

K 是 K-means 的 “超参数”,需要人工提前设定 —— 比如分用户群时,根据业务需求设 K=3(高价值、潜力、低频用户)。 怎么选 K? 入门阶段可参考 “肘部法则”:计算不同 K 值对应的 “簇内平方和(WCSS)”,WCSS 是 “每个点到其簇心的距离平方和”,K 越大,WCSS 越小;当 K 增加到某个值后,WCSS 下降幅度突然变小,这个点就是 “肘部”,对应最优 K 值(比如 K=2 时 WCSS 下降幅度最大,之后下降平缓,就选 K=2)。

2. 簇心(Centroid):簇的 “代表点”

簇心是簇内所有点的 “均值点”—— 二维数据是 (x 均值,y 均值),三维数据是 (x 均值,y 均值,z 均值),本质是 “簇内数据的平均特征”,代表簇的整体属性。

3. 迭代停止条件

常用两种条件:

- 簇心移动距离小于阈值(如 0.01):说明簇心已稳定,再迭代变化不大;

- 簇内数据点不再变化:所有点的归属簇固定,无需再划分。

3.2 避坑点

1. 初始簇心的随机性影响结果

K-means 对初始簇心敏感 —— 如果初始簇心选得差(比如都选在左下点),可能导致 “局部最优”(比如把右上点全归为一个簇,但左下点分错)。 解决方法:用 “K-means++” 算法(sklearn 默认),它能智能选择初始簇心(让初始簇心尽可能远),避免局部最优。

2. 欧氏距离对量纲敏感

K-means 默认用欧氏距离,而欧氏距离受 “数据量纲” 影响 —— 比如 “用户月消费(元)” 和 “每月购物次数(次)”,消费是 1000+,次数是 10+,欧氏距离会被消费主导,忽略次数的影响。 解决方法:先对数据做 “标准化”(如 Z-score 标准化,让所有特征均值 = 0,标准差 = 1),再用 K-means。

四、K-means 的优缺点:适合什么场景?

4.1 优点(为什么常用)

- 简单易懂:原理是 “迭代优化簇心”,逻辑清晰,入门门槛低;

- 计算高效:时间复杂度低(O (nkt),n = 数据量,k = 簇数,t = 迭代次数),适合百万级数据;

- 通用性强:可处理任意维度数据(二维、三维、高维),应用场景广。

4.2 缺点(需要注意)

- K 值难定:实际中不知道最优 K 值,需通过肘部法则、业务经验判断;

- 对初始簇心敏感:易陷入局部最优(需用 K-means++ 优化);

- 不适合非球形簇:只擅长分 “圆形 / 球形” 簇,对 “长条状、不规则形状” 簇效果差(比如数据是 “月牙形”,K-means 会分错)。

五、Python 代码实战:用 K-means 聚类二维数据

理论讲完,我们用 Python 的sklearn库实现 K-means,复现前面的例子,步骤包括 “数据准备→模型训练→结果可视化”,代码可直接复制运行。

5.1 环境准备

先安装所需库(如果没装):

pip install numpy sklearn matplotlib

5.2 参考代码实现

import numpy as np

import matplotlib.pyplot as plt

from sklearn.cluster import KMeans

from sklearn.preprocessing import StandardScaler

# 1. 准备数据(对应例子中的9个点)

X = np.array([

[1, 1], [2, 1], [1, 2], [2, 2], [3, 3],

[8, 8], [8, 9], [9, 8], [9, 9]

])

# 2. 数据标准化(例子中数据量纲一致,可省略;实际高维数据必做)

# scaler = StandardScaler()

# X_scaled = scaler.fit_transform(X)

# 3. 初始化K-means模型(K=2,用K-means++选初始簇心)

kmeans = KMeans(

n_clusters=2, # K值=2

init='k-means++', # 智能选初始簇心

max_iter=300, # 最大迭代次数

random_state=42 # 随机种子(固定结果,便于复现)

)

# 4. 训练模型,得到每个点的簇标签

y_pred = kmeans.fit_predict(X) # y_pred是每个点的簇标签(0或1)

# 5. 提取最终簇心

centers = kmeans.cluster_centers_ # 簇心坐标,形状(2,2)

# 6. 可视化结果

plt.figure(figsize=(8, 6))

# 绘制数据点,按簇标签着色

plt.scatter(

X[y_pred == 0, 0], X[y_pred == 0, 1], # 簇0的点(x,y坐标)

s=100, c='red', label='簇0'

)

plt.scatter(

X[y_pred == 1, 0], X[y_pred == 1, 1], # 簇1的点

s=100, c='blue', label='簇1'

)

# 绘制簇心(用黑色叉号标记)

plt.scatter(

centers[:, 0], centers[:, 1], # 簇心的x,y坐标

s=200, c='black', marker='x', label='簇心'

)

# 添加标签和图例

plt.xlabel('X轴(特征1)')

plt.ylabel('Y轴(特征2)')

plt.title('K-means聚类结果(K=2)')

plt.legend()

plt.grid(True, alpha=0.3)

plt.show()

# 7. 输出结果

print("每个点的簇标签:", y_pred)

print("最终簇心坐标:")

print(f"簇0:{centers[0]}")

print(f"簇1:{centers[1]}")

5.3 结果解释

运行代码后,会输出以下结果:

- 簇标签:

[0 0 0 0 0 1 1 1 1]—— 前 5 个点(左下)是簇 0,后 4 个点(右上)是簇 1,和我们手动计算一致; - 簇心:

簇0:[1.8 1.8],簇1:[8.5 8.5],完全匹配手动迭代的最终结果; - 可视化图:红色点是簇 0,蓝色点是簇 1,黑色叉号是簇心,清晰看到数据分成两堆。

六、总结:K-means 的核心逻辑链与应用场景

6.1 核心逻辑链

- 输入:无标签数据、预设 K 值;

- 迭代过程:随机选 K 个簇心→计算距离划簇→更新簇心→重复直到稳定;

- 输出:K 个簇、每个点的簇标签、最终簇心;

- 目标:最小化 “簇内平方和(WCSS)”,让簇内数据尽可能集中。

6.2 典型应用场景

- 用户分群:电商按 “消费金额 + 购物次数” 分高、中、低价值用户,针对性营销;

- 商品聚类:零售按 “销量 + 利润率” 分核心商品、潜力商品、淘汰商品,优化库存;

- 图像分割:将图像像素按 “RGB 值” 聚类,分割出目标对象(如把猫和背景分成两簇);

- 异常检测:将正常数据聚类,离所有簇心远的点就是异常值(如信用卡盗刷交易)。

对于入门学生,建议先手动复现 K-means 的迭代过程,再用代码实战验证,这样既能理解原理,又能掌握实操。后续学习中,可以尝试用 K-means 处理高维数据(如文本关键词向量),感受 “标准化” 和 “K 值选择” 的重要性。

如果本文有哪个步骤或代码没看懂,欢迎在评论区留言,我们一起拆解!

DAMO开发者矩阵,由阿里巴巴达摩院和中国互联网协会联合发起,致力于探讨最前沿的技术趋势与应用成果,搭建高质量的交流与分享平台,推动技术创新与产业应用链接,围绕“人工智能与新型计算”构建开放共享的开发者生态。

更多推荐

已为社区贡献4条内容

已为社区贡献4条内容

所有评论(0)