打破空地协作感知瓶颈!清华开源Griffin:AGILE框架与空地合作感知!

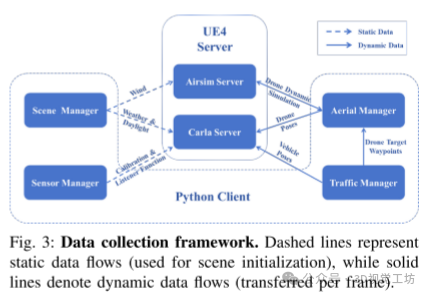

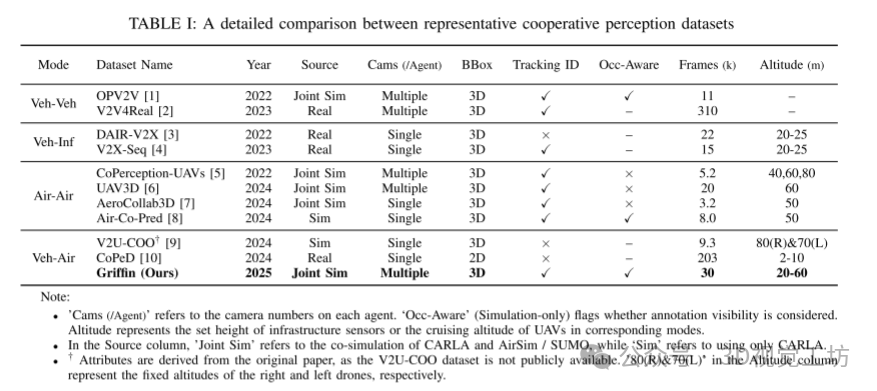

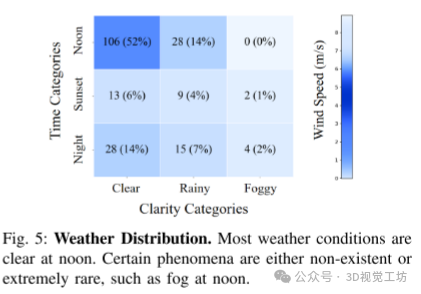

为了解决这一问题,本文提出了一个全面的空地协作三维感知解决方案,包含三项关键贡献:(1)Griffin,一个大规模的多模态数据集,包含超过200个动态场景(30k+帧),涵盖不同的无人机高度(20-60米)、多样的天气条件以及考虑遮挡的三维标注,借助CARLA-AirSim共同仿真增强了无人机的动态表现;本文引入了Griffin数据集,这是一个多模态的集合,具有考虑遮挡的标注和无人机动态仿真,此外

点击下方卡片,关注「3D视觉工坊」公众号

选择星标,干货第一时间送达

来源:3D视觉工坊

添加小助理:cv3d001,备注:方向+学校/公司+昵称,拉你入群。文末附3D视觉行业细分群。

扫描下方二维码,加入「3D视觉从入门到精通」知识星球(点开有惊喜),星球内凝聚了众多3D视觉实战问题,以及各个模块的学习资料:近20门秘制视频课程、最新顶会论文、计算机视觉书籍、优质3D视觉算法源码等。想要入门3D视觉、做项目、搞科研,欢迎扫码加入!

0.这篇文章干了啥?

这篇文章介绍了一种新颖的空地协作3D检测与跟踪框架,旨在提升自动驾驶系统中的感知能力。文章提出了Griffin数据集,该数据集结合了遮挡感知标注和无人机动态仿真,用于支持空地协作感知任务。同时,文章提出了AGILE方法,一种高效的实例级中间融合技术,专为联合检测和跟踪任务设计。实验结果表明,空地协作感知在多种延迟条件下能够显著提高检测和跟踪性能,但也暴露了现有方法的一些局限性,比如无人机高度变化对方法的泛化能力的影响,以及通信带宽与感知性能之间的权衡。文章还提出了未来研究方向,包括开发适应高度变化的融合机制、引入尺度感知以应对飞行高度带来的挑战,并弥合仿真与现实应用之间的差距。

下面一起来阅读一下这项工作~

1. 论文信息

论文题目:Griffin: Aerial-Ground Cooperative Detection and Tracking Dataset and Benchmark

作者:Jiahao Wang, Xiangyu Cao等

作者机构:School of Vehicle and Mobility, Tsinghua University, Beijing, China等

论文链接:https://arxiv.org/pdf/2503.06983

2. 摘要

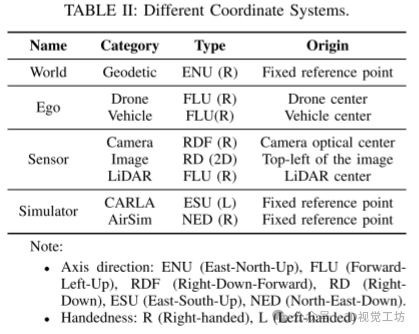

尽管自动驾驶系统已取得显著进展,但由于单一视角传感的固有限制,仍在处理遮挡物体和远距离检测方面面临挑战。空地合作通过将无人机的空中视角与地面车辆的本地观测相结合,提供了一种有前景的解决方案。然而,受限于缺乏公开数据集和标准化评估基准,这一新兴领域的进展受到阻碍。为了解决这一问题,本文提出了一个全面的空地协作三维感知解决方案,包含三项关键贡献:(1)Griffin,一个大规模的多模态数据集,包含超过200个动态场景(30k+帧),涵盖不同的无人机高度(20-60米)、多样的天气条件以及考虑遮挡的三维标注,借助CARLA-AirSim共同仿真增强了无人机的动态表现;(2)一个统一的空地协作检测与跟踪任务基准框架,包括评估通信效率、延迟容忍度和高度适应性的协议;(3)AGILE,一个实例级中间融合基准,通过基于查询的交互动态对齐跨视角特征,在通信开销与感知精度之间实现了有利的平衡。大量实验证明了空地协作感知的有效性,并展示了进一步研究的方向。数据集和代码可通过以下链接获取:https://github.com/wang-jh18-SVM/Griffin。

3. 效果展示

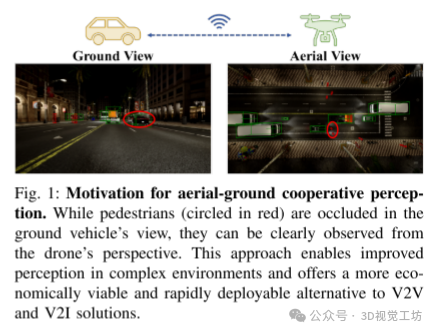

空地协同感知的动机。虽然行人(红色圆圈)在地面车辆的视野中被遮挡,但从无人机的角度可以清楚地观察到。这种方法可以改善复杂环境中的感知,并为V2V和V2I解决方案提供更经济可行和可快速部署的替代方案。

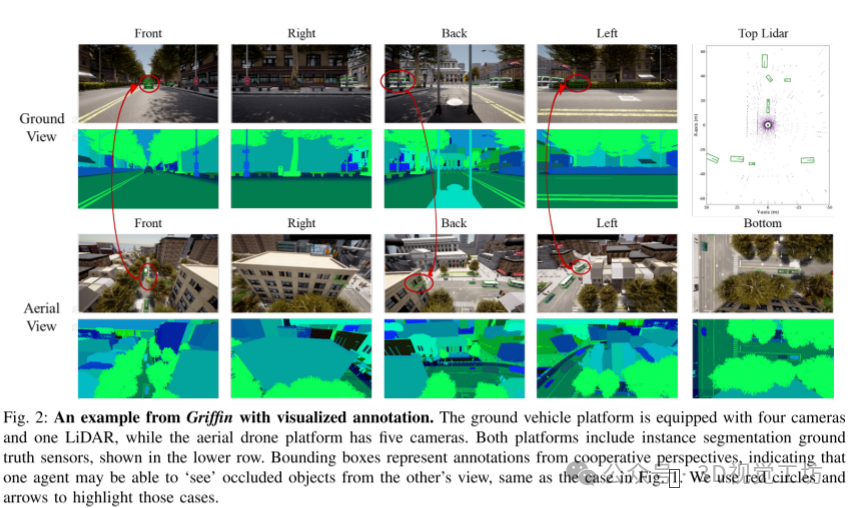

来自Griffin的一个带有可视化注释的示例。地面车辆平台配备了四个摄像头和一个激光雷达,而空中无人机平台则配备了五个摄像头。这两个平台都包括实例分割地面实况传感器,如下面一行所示。边界框表示来自合作视角的注释,指示一个代理可能能够从另一个代理的视图“看到”被遮挡的对象,与图1中的情况相同。我们使用红色圆圈和箭头来突出显示这些情况。

4. 主要贡献

-

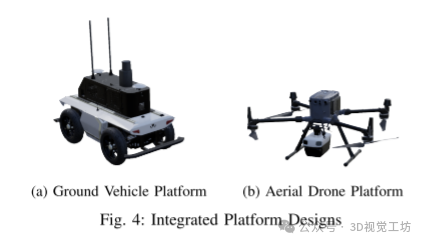

Griffin数据集:我们发布了Griffin,这是第一个公开可用的空地协作三维感知数据集。它涵盖了来自CARLA-AirSim共同仿真的200多个动态场景(超过30K帧,270K张图像),具有实例感知的遮挡量化、变化的巡航高度以及在各种条件下对无人机动态的真实仿真。

-

基准测试:我们提出了一个空地协作三维目标检测和跟踪的基准框架。该框架包括经典基线的实现,并提供一套评估精度、通信成本和在不同延迟条件下鲁棒性的指标。

-

AGILE框架:我们提出了AGILE,这是第一个开源的空地实例级中间融合框架,用于联合检测和跟踪。我们的方法展示了空地协作的有效性,在保持感知精度的同时,遵循实际的通信约束。推荐课程:卡尔曼滤波及其在多传感器融合的应用[PX4 EKF2讲解]。

5. 基本原理是啥?

-

空地协作感知:该框架旨在通过空中无人机(UAV)和地面车辆的协同工作,共同完成3D对象的检测和跟踪。无人机从空中提供一个更广阔的视角,而地面车辆则能提供更精确的目标信息。通过这种协作,系统可以获得更全面的环境感知。

-

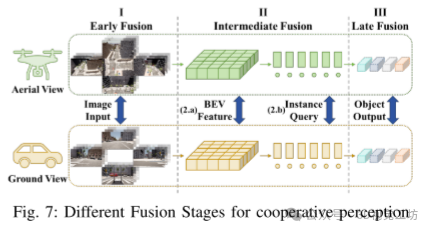

AGILE方法:AGILE(Aerial-Ground cooperative Instance-LEvel fusion)是一种实例级中间融合方法,专门用于联合检测和跟踪任务。它通过在不同视角(空中和地面)下生成实例查询来进行特征融合,这些查询能动态地关注场景中的潜在目标,从而实现精细化的空地协作。

-

实例级中间融合:与传统的基于全局视图(如BEV特征)的融合方法不同,AGILE利用实例查询,从每个视角提取特定的目标信息并进行动态更新。通过空间注意机制,这些实例查询能在不同的视角中对齐和传递,从而更好地进行跨视角的目标跟踪和检测。

-

多模态数据集(Griffin数据集):该数据集结合了遮挡意识的标注和无人机动态仿真,用于训练和验证空地协作感知系统。它通过模拟不同的飞行高度和遮挡情况,为研究提供了真实的测试环境。

-

通信带宽与感知性能的权衡:尽管协作感知方法显著提高了检测和跟踪精度,但其通信带宽需求也随之增加,这在实际应用中可能成为一个限制因素。AGILE方法在性能和通信开销之间提供了良好的平衡。

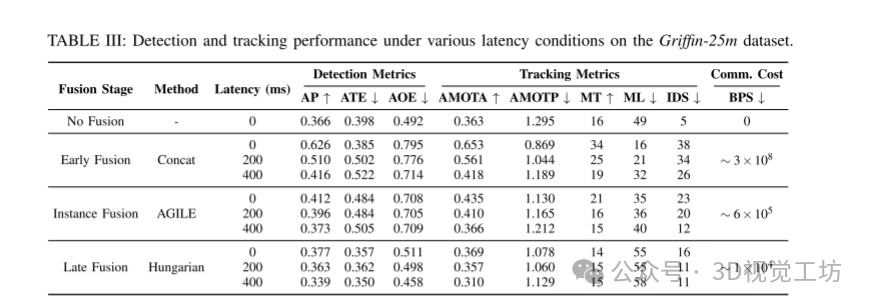

6. 实验结果

-

性能提升:合作的效果

-

早期融合:在检测的AP(平均精度)上提高了71%,在跟踪的AMOTA(平均跟踪准确度)上提升了79.9%,但其通信开销远高于其他方法,限制了其实际应用。

-

AGILE:提供了更为平衡的提升,在AP上提高了12.6%,在AMOTA上提升了19.8%,同时大幅降低了通信开销。

-

晚期融合:尽管只在AP上提升了3.0%,但大幅降低了通信成本,且通信开销降低了三个数量级。

-

合作方法的表现显著优于无融合基线,证明了空地协作的有效性。

-

在零延迟条件下,所有融合方法的表现都比无融合方法有所提升:

-

总体表现:AGILE在检测和跟踪任务中表现出了性能与通信成本之间的良好平衡,突出了实例级融合在时序关联中的优势。

-

通信延迟的鲁棒性

-

-

随着通信延迟的增加,所有融合方法的性能都有所下降,但AGILE在延迟下展现了最强的鲁棒性。

-

尽管早期融合在每个延迟水平下仍表现出最高的精度,但它在400ms延迟下的AP下降了-33.6%,AMOTA下降了-36.0%,表现出较大的性能下降。

-

AGILE和晚期融合在性能下降幅度上较为相似,但AGILE在所有延迟条件下始终优于晚期融合,表明AGILE在面对通信延迟时更具鲁棒性,更适合动态通信环境。

-

-

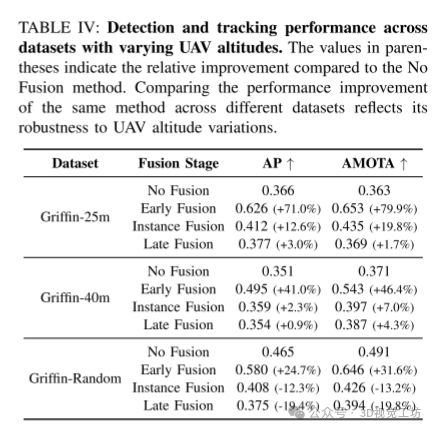

飞行高度变化的泛化能力

-

-

Griffin-25m数据集:在25米的飞行高度下,空地协作方法能够最大程度地提高检测和跟踪性能。

-

Griffin-40m数据集:随着飞行高度的提高,目标尺度减小,深度估计变得更加困难,导致融合方法的性能提升减小。AGILE和晚期融合分别提高了2.3%的AP和0.9%的AP,AMOTA分别提高了7.0%和4.3%。

-

Griffin-Random数据集:由于飞行高度的随机变化,AGILE和晚期融合在AP和AMOTA上的表现都低于无融合基线,表明不同的飞行高度(20米到60米)导致目标尺度不一致,跨视角对齐受到干扰。

-

在不同数据集(例如,Griffin-25m、Griffin-40m和Griffin-Random)上的实验展示了无人机飞行高度对协作感知方法的影响。

7. 总结 & 未来工作

本文介绍了一种新颖的空地协作3D检测与跟踪框架,旨在自动驾驶领域。本文引入了Griffin数据集,这是一个多模态的集合,具有考虑遮挡的标注和无人机动态仿真,此外还提出了AGILE,一种高效的实例级中间融合方法,用于联合检测和跟踪任务。实验结果验证了协作感知的有效性,同时揭示了当前方法的一些局限性,如在不同无人机高度下的泛化能力,以及通信带宽与感知性能之间的权衡。未来的研究可以聚焦于三个关键方向:(1) 开发适应高度变化的融合机制,能够处理动态的空中视角;(2) 将尺度感知纳入协作感知框架,以应对与高度相关的挑战;(3) 弥合仿真与现实之间的差距,以实现可靠的现实世界部署。解决这些挑战对于在动态和不可预测的现实世界条件下实现稳健的空地协作感知至关重要。

本文仅做学术分享,如有侵权,请联系删文。

3D视觉交流群,成立啦!

目前我们已经建立了3D视觉方向多个社群,包括2D计算机视觉、最前沿、工业3D视觉、SLAM、自动驾驶、三维重建、无人机等方向,细分群包括:

工业3D视觉:相机标定、立体匹配、三维点云、结构光、机械臂抓取、缺陷检测、6D位姿估计、相位偏折术、Halcon、摄影测量、阵列相机、光度立体视觉等。

SLAM:视觉SLAM、激光SLAM、语义SLAM、滤波算法、多传感器融合、多传感器标定、动态SLAM、MOT SLAM、NeRF SLAM、机器人导航等。

自动驾驶:深度估计、Transformer、毫米波|激光雷达|视觉摄像头传感器、多传感器标定、多传感器融合、3D目标检测、路径规划、轨迹预测、3D点云分割、模型部署、车道线检测、Occupancy、目标跟踪等。

三维重建:3DGS、NeRF、多视图几何、OpenMVS、MVSNet、colmap、纹理贴图等

无人机:四旋翼建模、无人机飞控等

2D计算机视觉:图像分类/分割、目标/检测、医学影像、GAN、OCR、2D缺陷检测、遥感测绘、超分辨率、人脸检测、行为识别、模型量化剪枝、迁移学习、人体姿态估计等

最前沿:具身智能、大模型、Mamba、扩散模型、图像/视频生成等

除了这些,还有求职、硬件选型、视觉产品落地、产品、行业新闻等交流群

添加小助理: cv3d001,备注:研究方向+学校/公司+昵称(如3D点云+清华+小草莓), 拉你入群。

▲长按扫码添加助理:cv3d001 3D视觉工坊知识星球

「3D视觉从入门到精通」知识星球(点开有惊喜),已沉淀6年,星球内资料包括:秘制视频课程近20门(包括结构光三维重建、相机标定、SLAM、深度估计、3D目标检测、3DGS顶会带读课程、三维点云等)、项目对接、3D视觉学习路线总结、最新顶会论文&代码、3D视觉行业最新模组、3D视觉优质源码汇总、书籍推荐、编程基础&学习工具、实战项目&作业、求职招聘&面经&面试题等等。欢迎加入3D视觉从入门到精通知识星球,一起学习进步。

▲长按扫码加入星球 3D视觉工坊官网:www.3dcver.com卡尔曼滤波、大模型、扩散模型、具身智能、3DGS、NeRF、结构光、相位偏折术、机械臂抓取、点云实战、Open3D、缺陷检测、BEV感知、Occupancy、Transformer、模型部署、3D目标检测、深度估计、多传感器标定、规划与控制、无人机仿真、C++、三维视觉python、dToF、相机标定、ROS2、机器人控制规划、LeGo-LAOM、多模态融合SLAM、LOAM-SLAM、室内室外SLAM、VINS-Fusion、ORB-SLAM3、MVSNet三维重建、colmap、线面结构光、硬件结构光扫描仪等。

▲ 长按扫码学习3D视觉精品课程

3D视觉模组选型:www.3dcver.com

— 完 —

点这里👇关注我,记得标星哦~

一键三连「分享」、「点赞」和「在看」

3D视觉科技前沿进展日日相见 ~

-

DAMO开发者矩阵,由阿里巴巴达摩院和中国互联网协会联合发起,致力于探讨最前沿的技术趋势与应用成果,搭建高质量的交流与分享平台,推动技术创新与产业应用链接,围绕“人工智能与新型计算”构建开放共享的开发者生态。

更多推荐

已为社区贡献225条内容

已为社区贡献225条内容

所有评论(0)