深度学习(二)---LSTM

111

·

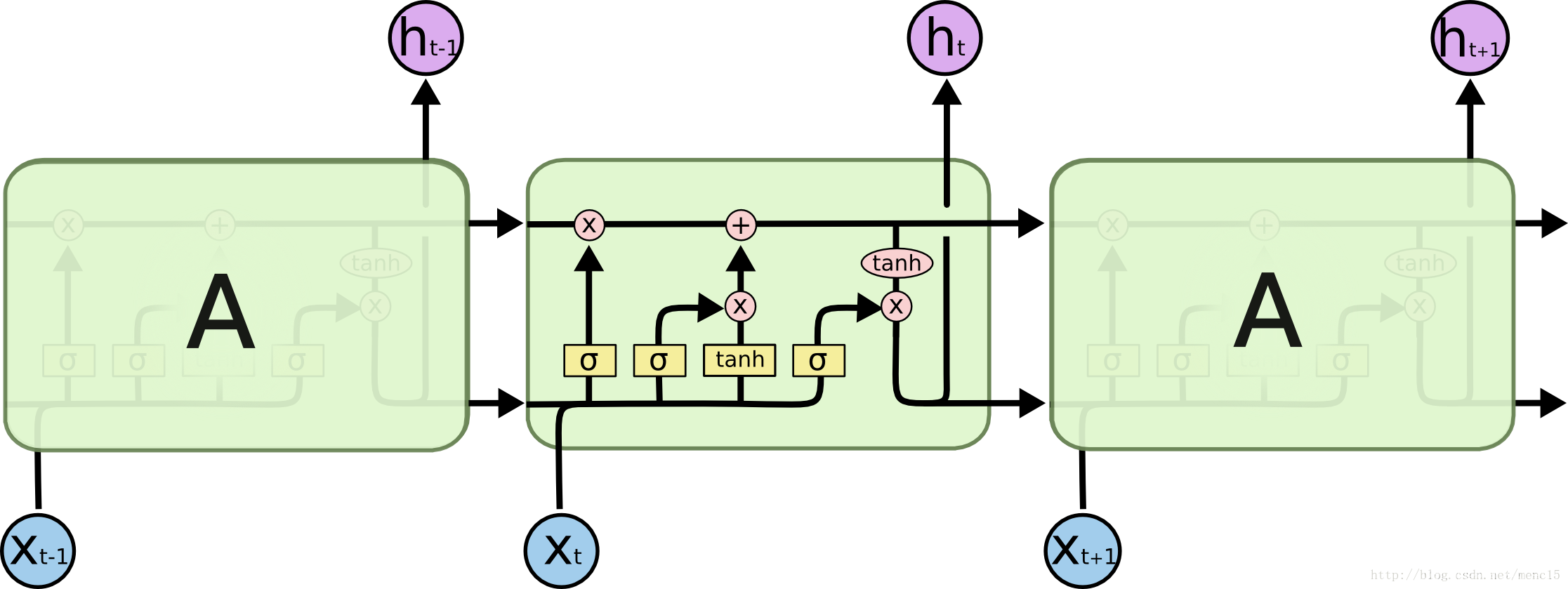

LSTM原理

意义:原始RNN网络无法针对长序列任务进行处理(容易出现梯度弥散和爆炸),只能够进行短期记忆。所以提出长短期记忆神经网络LSTM。

特点:

1.RNN记住所有信息,无论其是否有用,而LSTM专注于一个记忆细胞,对信息进行选择性(门结构-sigmoid+pointwise实现)的记忆。

2.门结构:LSTM有三个门,用于控制和保护细胞的状态。

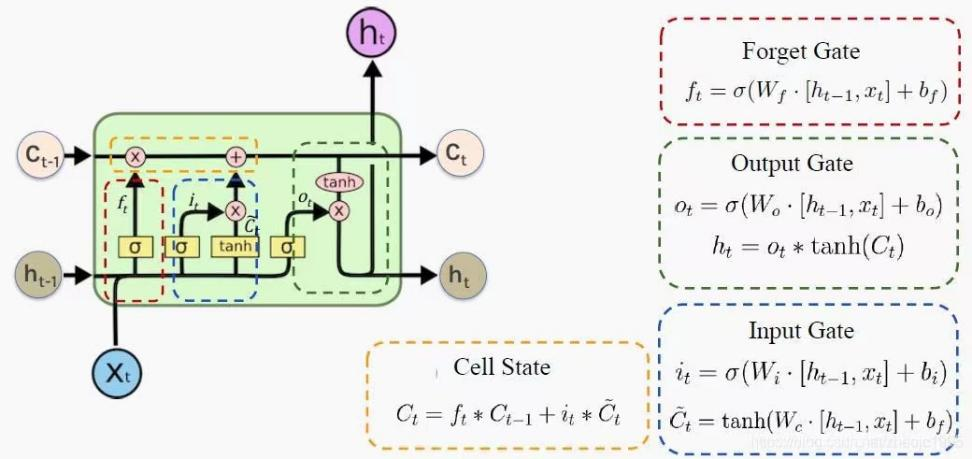

门结构:

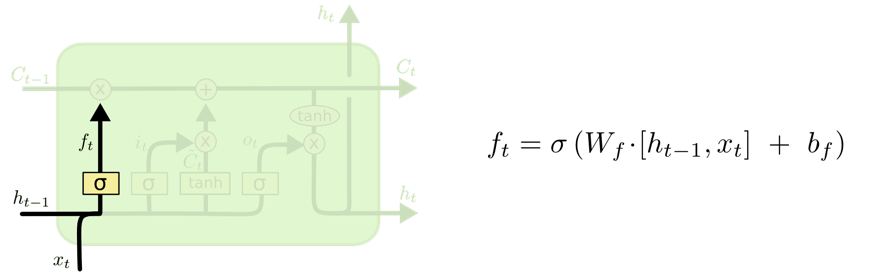

1.遗忘门:选择性抛弃上一个记忆单元Ct-1信息。

通过sigmoid进行选择性记忆,越接近1的信息越应该保留。“[ ]”表示向量拼接。

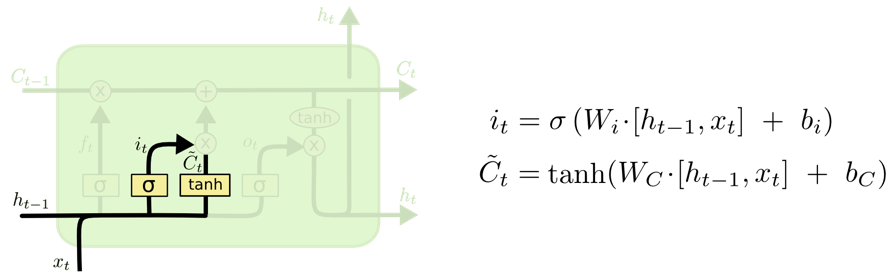

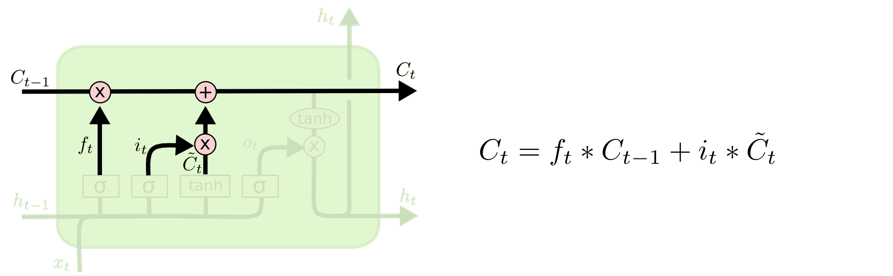

2.输入门:当前输入信息候选状态xt有多少需要被保存到当前记忆单元Ct。

tanh用于生成新的候选信息,再有旁路的sigmoid决定tanh候选值中哪些是重要的需要保留的信息。输入xt需要是向量形式(gate相当于全连接层)

经过遗忘门和输入门,需要保留的记忆就确定下来了,分别为两个记忆细胞,通过上图方式更新保存。

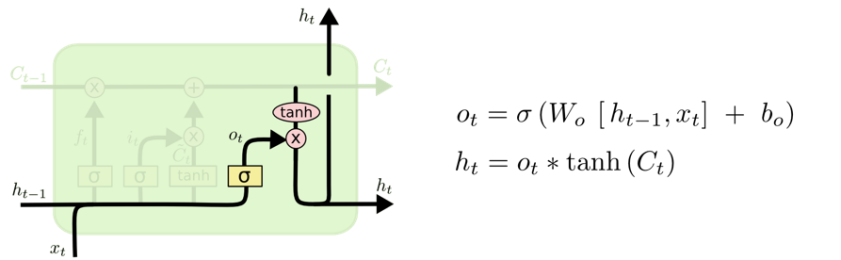

3.输出门:当前记忆单元Ct有多少信息需要输出给当前外部状态ht。

决定模型的输出,确定下一个隐藏状态。由sigmoid得到输出,然后由tanh对上一阶段的新的记忆单元状态Ct-1进行放缩,起到稳定数值的作用,再与sigmoid的结果相乘确定隐藏状态信息,传递到下一个时间步。

隐藏状态h为一种短期记忆,当ot=0时等于0。

C可以看作一种长期记忆,可以保留历史信息。

DAMO开发者矩阵,由阿里巴巴达摩院和中国互联网协会联合发起,致力于探讨最前沿的技术趋势与应用成果,搭建高质量的交流与分享平台,推动技术创新与产业应用链接,围绕“人工智能与新型计算”构建开放共享的开发者生态。

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)