威廉的工具箱:又一个完全使用auto-coder.chat 开发的开源项目来了

上次我们开源了一款完全使用 auto-coder.chat 开发的微信小程序 第一款已上线的纯AI开发的微信小程序开源了昨天晚上我正在开发 byzerllm 的一个功能,但是每次自己要通过如下方式启停一个模型还是挺麻烦的:关停一个模型:byzerllm undeploy --model deepseek_chat启动一个模型:byzerllm deploy --pretrained_model_t

上次我们开源了一款完全使用 auto-coder.chat 开发的微信小程序 第一款已上线的纯AI开发的微信小程序开源了

昨天晚上我正在开发 byzerllm 的一个功能,但是每次自己要通过如下方式启停一个模型还是挺麻烦的:

关停一个模型:

byzerllm undeploy --model deepseek_chat启动一个模型:

byzerllm deploy --pretrained_model_type saas/openai \

--cpus_per_worker 0.001 \

--gpus_per_worker 0 \

--worker_concurrency 1000 \

--num_workers 1 \

--infer_params saas.base_url="https://api.deepseek.com/v1" saas.api_key=${MODEL_DEEPSEEK_TOKEN} saas.model=deepseek-chat \

--model deepseek_chat因为有很多模型,没办法,只能放到一个记事本里,然后复制黏贴。

我还试过把记事本给大模型,让大模型帮我做启停,但是有两个问题:

-

大模型执行需要时间,而且一般还比较长(需要生成上述的命令然后提取和执行)。

-

大模型有的时候还是会搞错,此外,你让大模型帮你干活,还是每次都要打字,也还是挺麻烦的,不够直观,肯定不如点击一个按钮方便简介。

所以还是准备做个管理工具,前后端总共花了大概不到五个小时,基本完全auto-coder.chat 生成。

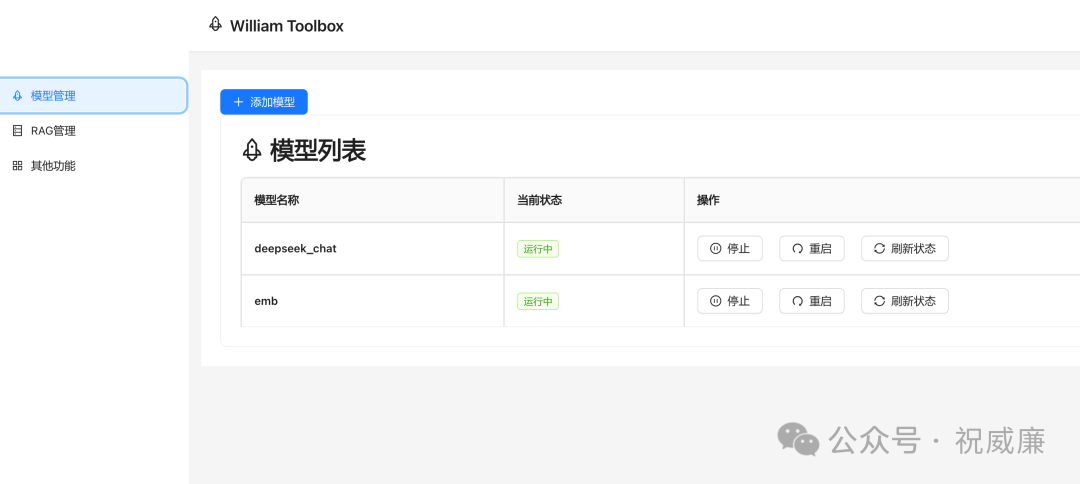

我们来看看,模型管理:

这里部署的模型,可以方便的被 auto-coder.chat 以及使用 byzerllm 的库使用。

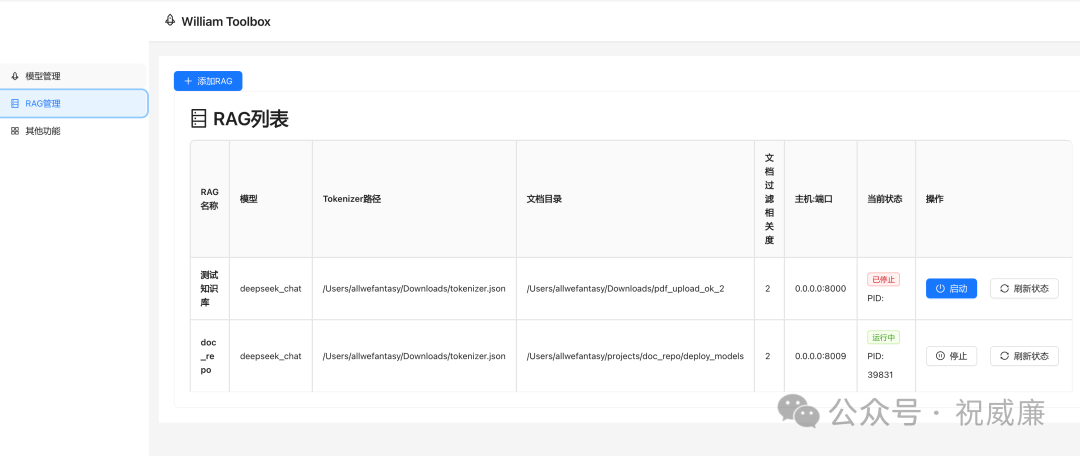

接着是 RAG 服务管理:

关于 RAG ,参考这个:全球首发:第二代 RAG 系统 auto-coder.rag 相比市面主流RAG系统 20%-60% 效果提升

这次我们不仅开源了产品,还在项目里开源了使用auto-coder.chat 开发的对话信息。

项目地址:https://github.com/allwefantasy/william-toolbox

安装

pip install -U williamtoolbox启动后端服务

william.toolbox.backend启动前端服务:

mkdir web && cd web

wget https://github.com/allwefantasy/william-toolbox/releases/download/v1.0.0/web.static.tar.gz

tar -zxvf web.static.tar.gz

william.toolbox.frontend需要确保在静态资源所在目录启动 `william.toolbox.frontend`。现在,你可以浏览器访问 http://127.0.0.1:8006

DAMO开发者矩阵,由阿里巴巴达摩院和中国互联网协会联合发起,致力于探讨最前沿的技术趋势与应用成果,搭建高质量的交流与分享平台,推动技术创新与产业应用链接,围绕“人工智能与新型计算”构建开放共享的开发者生态。

更多推荐

已为社区贡献2条内容

已为社区贡献2条内容

所有评论(0)