阿里最新开源QwQ-32B,效果媲美deepseek-r1满血版,部署成本又又又降低了!

3月6日最新消息,阿里云通义千问官方宣布推出最新推理模型 QwQ-32B,这一模型仅有 32B 参数,但在效果上与拥有 671B 参数的 DeepSeek-R1 相媲美。如果你自己部署 DeepSeek-R1 但资源不够的话,又多了一个新的选择。QwQ-32B 的独特之处不仅在于其参数规模和效果表现,还集成了与 Agent 相关的能力。这使得模型在使用工具时能够进行批判性思考,并依据环境反馈灵活调

3月6日最新消息,阿里云通义千问官方宣布推出最新推理模型 QwQ-32B,这一模型仅有 32B 参数,但在效果上与拥有 671B 参数的 DeepSeek-R1 相媲美。如果你自己部署 DeepSeek-R1 但资源不够的话,又多了一个新的选择。

QwQ-32B 的独特之处不仅在于其参数规模和效果表现,还集成了与 Agent 相关的能力。这使得模型在使用工具时能够进行批判性思考,并依据环境反馈灵活调整推理过程,极大提升了模型的适应性与智能性。

目前,QwQ-32B 已上线 Hugging Face、ModelScope、Ollama等平台,具体链接如下:

-

• https://huggingface.co/Qwen/QwQ-32B

-

• https://modelscope.cn/models/Qwen/QwQ-32B

-

• https://ollama.com/library/qwq

QwQ-32B 采用 Apache 2.0 开源协议,为广大开发者提供了便捷的使用途径。用户也可通过 Qwen Chat直接体验其强大功能。

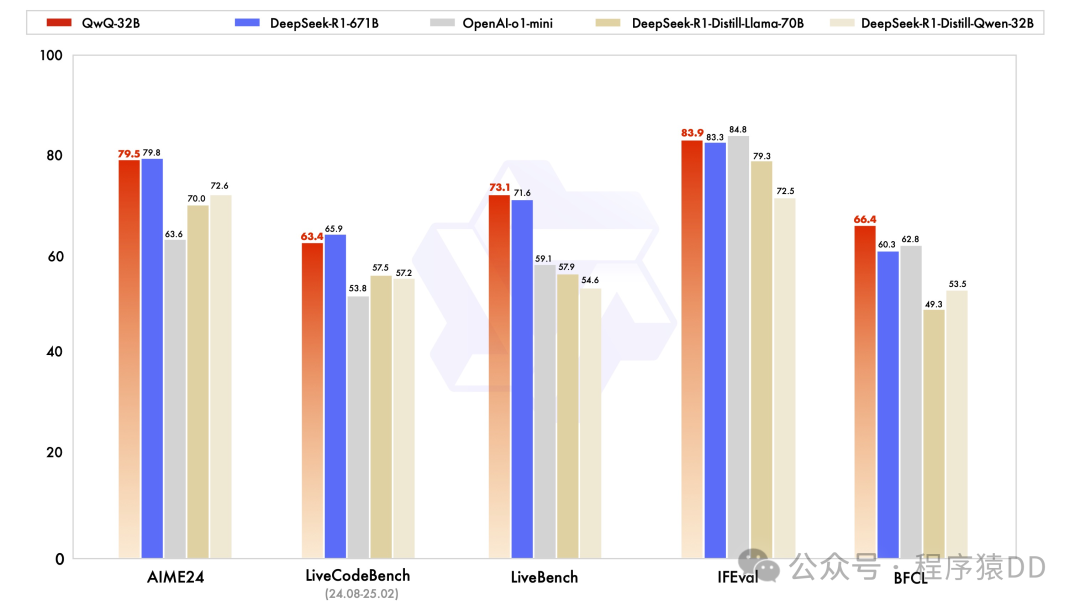

下图是其与其他热门模型的测试对比:

测试结果令人瞩目。在数学推理的 AIME24 评测集以及编程能力的 LiveCodeBench 测试中,QwQ-32B 表现与 DeepSeek-R1 相当,远超 o1-mini 及相同尺寸的 R1 蒸馏模型。在由 Meta 首席科学家杨立昆领衔的 “最难 LLMs 评测榜” LiveBench、谷歌等提出的指令遵循能力 IFEval 评测集、加州大学伯克利分校等提出的评估准确调用函数或工具方面的 BFCL 测试中,QwQ-32B 更是超越了 DeepSeek-R1,展现出全面的优势。

快速本地部署

如果想要快速本地部署尝试,那就继续清楚Ollama,两条命令快速搞定。

-

1. 安装 Ollama

curl -fsSL https://ollama.com/install.sh | sh如果本地MacOS或者Windows开发环境使用的话,也可以从前往官网下载客户端版本:https://ollama.com/download

-

2. 启动 QwQ-32B

ollama run qwqSpring AI调用API集成

由于这里使用了Ollama来启动QwQ-32B并提供服务,所以Java开发者可以使用使用Spring AI Ollama来集成模型能力到自己的应用中去。

具体如何集成在之前介绍集成DeepSeek-R1的时候介绍过了,方法类似,就是换个模型名称。如果还不会的话,可以参考之前的这篇文章 Spring AI + Ollama 实现 deepseek-r1 的API服务和调用 中使用Spring AI调API的部分。

感谢阅读!如果您也关注前沿AI和开发者相关资讯,欢迎点赞、关注支持一下。

我们创建了一个高质量的技术交流群,与优秀的人在一起,自己也会优秀起来,赶紧 点击加群,享受一起成长的快乐。

你还在购买国内的各种昂贵又低质的技术教程吗?这里给大家推荐下我们自研的Youtube视频语音转换插件(https://youtube-dubbing.com/),一键外语转中文,英语不好的小伙伴也可以轻松的学习油管上的优质教程了,下面是演示视频,可以直观的感受一下:

另外,如果您是要制作翻译视频,那么还可以尝试一下我们的另一款面向视频翻译制作的工具 TransDuck (https://transduck.com/)

推荐阅读

拒绝繁忙!免费使用 deepseek-r1:671B 参数满血模型

DAMO开发者矩阵,由阿里巴巴达摩院和中国互联网协会联合发起,致力于探讨最前沿的技术趋势与应用成果,搭建高质量的交流与分享平台,推动技术创新与产业应用链接,围绕“人工智能与新型计算”构建开放共享的开发者生态。

更多推荐

已为社区贡献18条内容

已为社区贡献18条内容

所有评论(0)