Java 代码查重(一)借助HanLP计算相似度

例如,动态添加前五千万条数据速度尚可,但后续添加速度明显下降,当添加量较大时,可能会耗费较长时间来完成词典的更新,这对于需要频繁更新和扩展词典的应用场景来说,会影响系统的整体性能和效率。例如,一些词语在不同的语境下可能有不同的含义和分词方式,但HanLP可能无法准确地根据上下文来确定最合适的分词结果,从而影响后续的文本分析和处理。- 专业领域知识覆盖不足:对于一些特定的专业领域,HanLP的训练数

目录

一、汉语处理包(HanLP)

HanLP是一个由模型与算法组成的 Java 汉语言处理包,由大快搜索主导并完全开源。它不仅提供中文分词功能,还具备索引全切分模式、用户自定义词典、兼容繁体中文、词性标注、命名实体识别、关键词提取、自动摘要等众多自然语言处理功能。

主要功能

- 中文分词:例如,“今天天气真好”可以被分为“今天”“天气”“真好”

- 词性标注。为每个切分出来的词语标注其词性,如名词、动词、形容词等。比如“美丽的花朵”中,“美丽”被标注为形容词,“花朵”被标注为名词。

- 命名实体识别。可以识别出文本中的人名、地名、组织机构名等特定的实体。

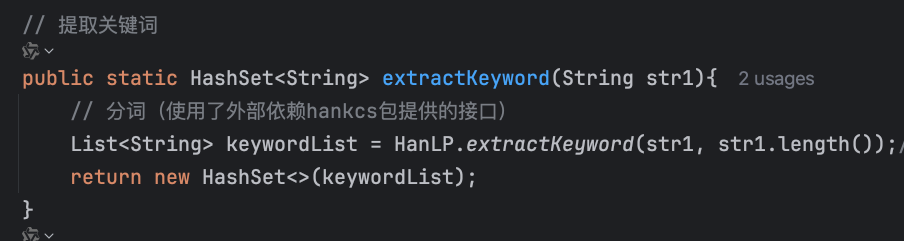

- 关键词提取。从一段文本中提取出最能代表其主要内容的关键词。比如对于一篇新闻报道,能够提取出关键的主题词。

- 依存句法分析。分析句子中各个词语之间的依存关系,展示句子的语法结构。例如可以确定主谓宾等成分之间的关系。

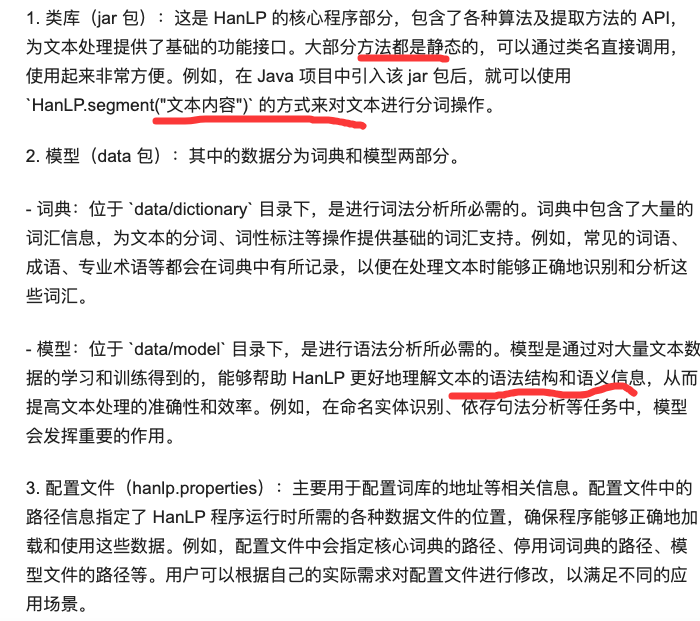

汉语处理包(HanLP)主要由以下三个部分组成

适用场景

适合较长文本的去重场景,不适合较短文本的去重场景,容易生成冲突的simhash值,引发误判。

不足之处

1. 性能方面:

- 词典添加效率问题:在动态添加词典时,开始时速度较快,但随着数据量的不断增加,添加词典的速度会逐渐变慢。例如,动态添加前五千万条数据速度尚可,但后续添加速度明显下降,当添加量较大时,可能会耗费较长时间来完成词典的更新,这对于需要频繁更新和扩展词典的应用场景来说,会影响系统的整体性能和效率。

- 资源占用问题:运行HanLP可能需要占用较多的内存和计算资源,尤其是在处理大规模文本数据或复杂任务时,如果硬件资源有限,可能会导致程序运行缓慢甚至出现卡顿现象,这对于一些资源受限的环境或对实时性要求较高的应用不太友好。

2. 准确率方面:

- 歧义处理不够完善:在处理一些具有歧义的文本时,HanLP的分词和语义理解可能会出现不准确的情况。例如,一些词语在不同的语境下可能有不同的含义和分词方式,但HanLP可能无法准确地根据上下文来确定最合适的分词结果,从而影响后续的文本分析和处理。

- 专业领域知识覆盖不足:对于一些特定的专业领域,HanLP的训练数据和模型可能无法充分覆盖相关的专业术语和知识,导致在处理这些领域的文本时,准确率有所下降。比如在医学、法律、金融等专业领域,一些专业术语的识别和理解可能不够准确。

3. 语言适应性方面:

- 对古汉语和文言文的支持有限:虽然HanLP主要面向现代汉语的处理,但在处理古汉语和文言文时,其表现可能不如专门针对古汉语的处理工具。古汉语和文言文的语法、词汇和表达方式与现代汉语有较大的差异,HanLP在这方面的适应性和处理能力还有待提高。

二、采用HanLP对文本进行分词

三、借助HanLP计算相似度

算法1: 借助HanLP分词后,计算2个文本的重复关键词数量;

文本关键词重复比例(相似度) = 重复关键词数量/ 其中文本关键词总数量

算法2:借助HanLP分词后---》计算2个SimHash值-----》计算海明距离------》计算相似度

DAMO开发者矩阵,由阿里巴巴达摩院和中国互联网协会联合发起,致力于探讨最前沿的技术趋势与应用成果,搭建高质量的交流与分享平台,推动技术创新与产业应用链接,围绕“人工智能与新型计算”构建开放共享的开发者生态。

更多推荐

已为社区贡献2条内容

已为社区贡献2条内容

所有评论(0)