Mistral Small 3.1:免费开源,性能吊打同类,AI应用新标杆!

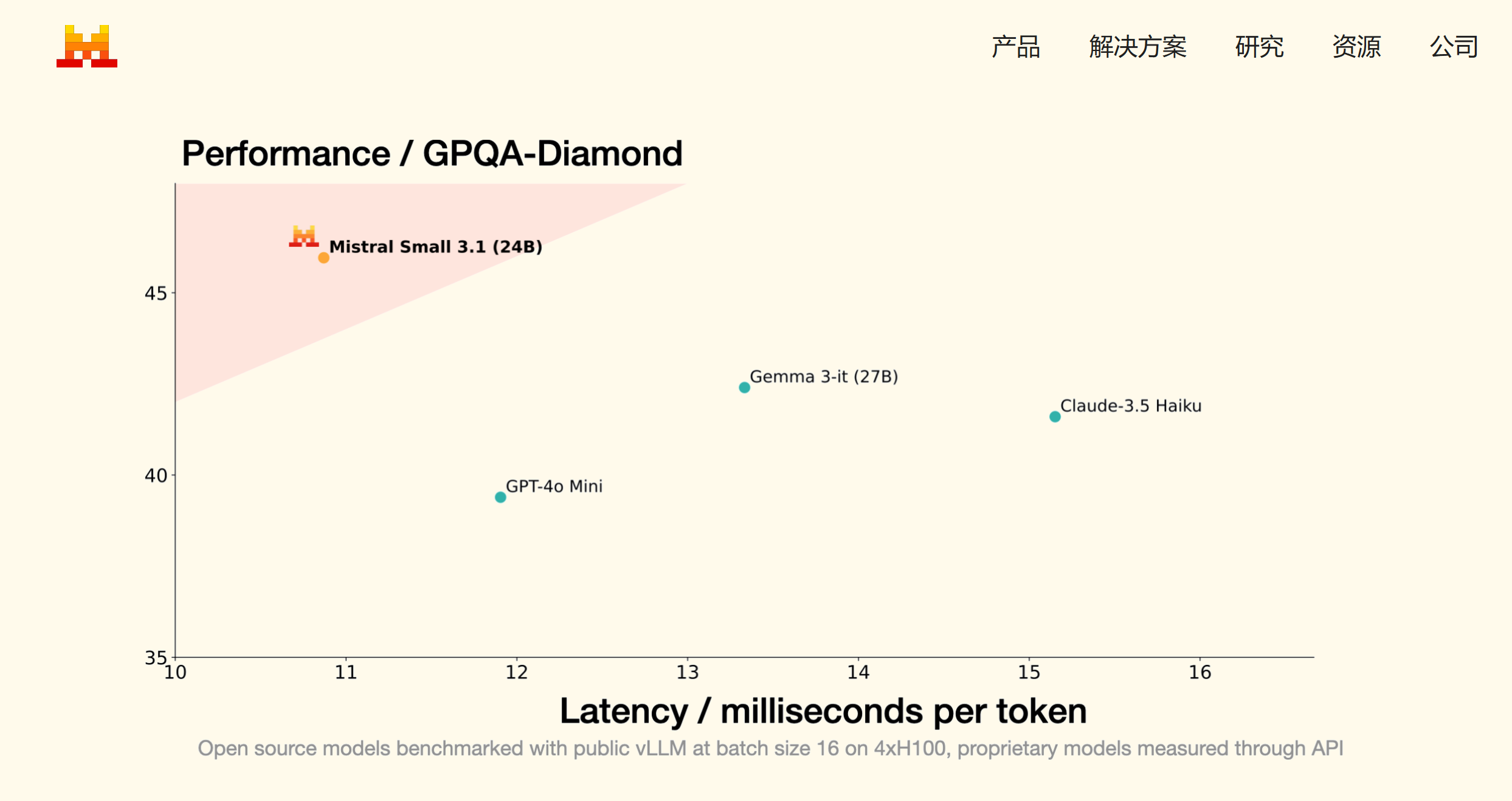

Mistral Small 3.1 已全新发布!全部免费开源,文本性能更出色,具备多模式理解能力,上下文窗口扩展至 128k 个标记。该模型表现超越 Gemma 3、GPT-4o Mini 等同类,推理速度达每秒 150 个标记。现代 AI 应用依赖于多种功能,如文本处理、多模式输入理解、多语言支持以及长上下文管理,同时还要保证低延迟和成本效益。Mistral Small 3.1 是首个在这些方面

Mistral Small 3.1 已全新发布!全部免费开源,文本性能更出色,具备多模式理解能力,上下文窗口扩展至 128k 个标记。该模型表现超越 Gemma 3、GPT-4o Mini 等同类,推理速度达每秒 150 个标记。

现代 AI 应用依赖于多种功能,如文本处理、多模式输入理解、多语言支持以及长上下文管理,同时还要保证低延迟和成本效益。Mistral Small 3.1 是首个在这些方面不仅满足甚至超越领先的小型专有模型性能的开源模型。

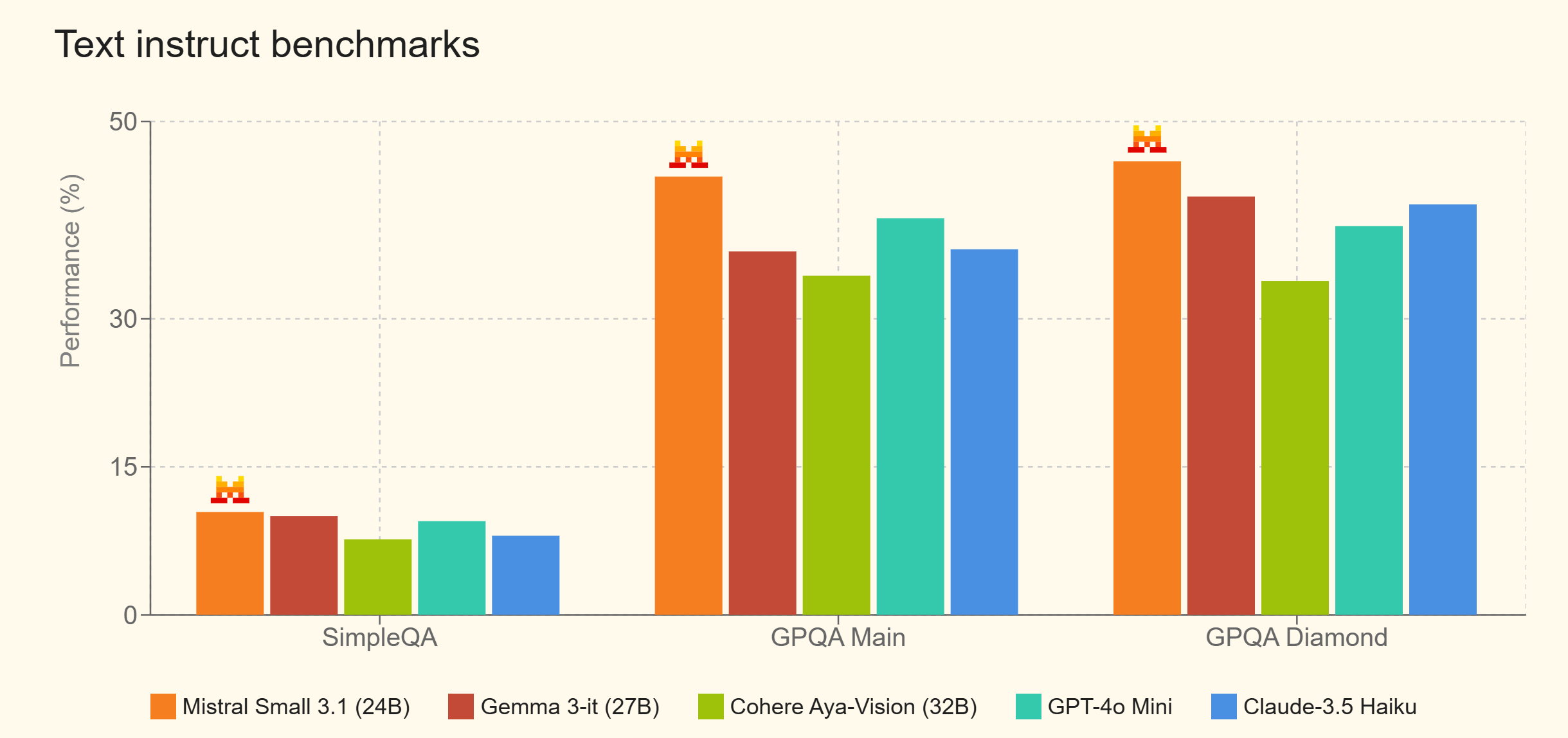

下面您将找到有关模型性能的更多详细信息。只要有可能,我们都会展示其他提供商之前报告的数字,否则我们会通过我们的通用评估工具来评估模型。

基准评分(文本)

Mistral Small 3.1 适用于多种企业和消费者应用程序,这些程序需要多模式理解能力,例如文档验证、诊断、设备上的图像处理、用于质量检查的视觉检查、安全系统中的物体检测、基于图像的客户支持以及通用协助。

本地部署教程:

1、通过Ollama客户端快速部署 【点击下载】

2、一键部署命令(24B模型):

ollama run MHKetbi/Mistral-Small3.1-24B-Instruct-2503量化版,适合小显存的显卡【点击前往】

3、WebUI 调用本地 Mistral Small 3.1 AI模型 【点击安装】,方便大家使用,支持Chrome、Edge等浏览器。

主要特性和功能

-

Mistral Small 3.1 是一款轻量级模型,它能够在配备单个 RTX 4090 或 32GB RAM 的 Mac 上运行,这使其非常适合在设备端使用。

-

它能够提供快速响应的对话帮助,是虚拟助手和需要快速、准确响应的应用程序的理想选择。

Mistral Small 3.1 具有低延迟函数调用功能,可以在自动化或代理工作流程中实现快速的函数执行。

-

该模型可以针对特定领域进行微调,从而成为精准的主题专家,这在法律咨询、医疗诊断和技术支持等领域具有特别重要的意义。

-

Mistral Small 3.1 是高级推理的基石,社区在开放的 Mistral 模型之上构建模型的方式令人印象深刻。仅在过去几周,就出现了几个基于 Mistral Small 3 构建的出色推理模型,例如 Nous Research 的 DeepHermes 24B。因此,我们发布了 Mistral Small 3.1 的基础和指令检查点,以便进一步对模型进行下游定制。

没有GPU的用户也不用担心,你可以在Mistral 官方平台上使用,上面也是满血版【点击前往】

DAMO开发者矩阵,由阿里巴巴达摩院和中国互联网协会联合发起,致力于探讨最前沿的技术趋势与应用成果,搭建高质量的交流与分享平台,推动技术创新与产业应用链接,围绕“人工智能与新型计算”构建开放共享的开发者生态。

更多推荐

已为社区贡献2条内容

已为社区贡献2条内容

所有评论(0)