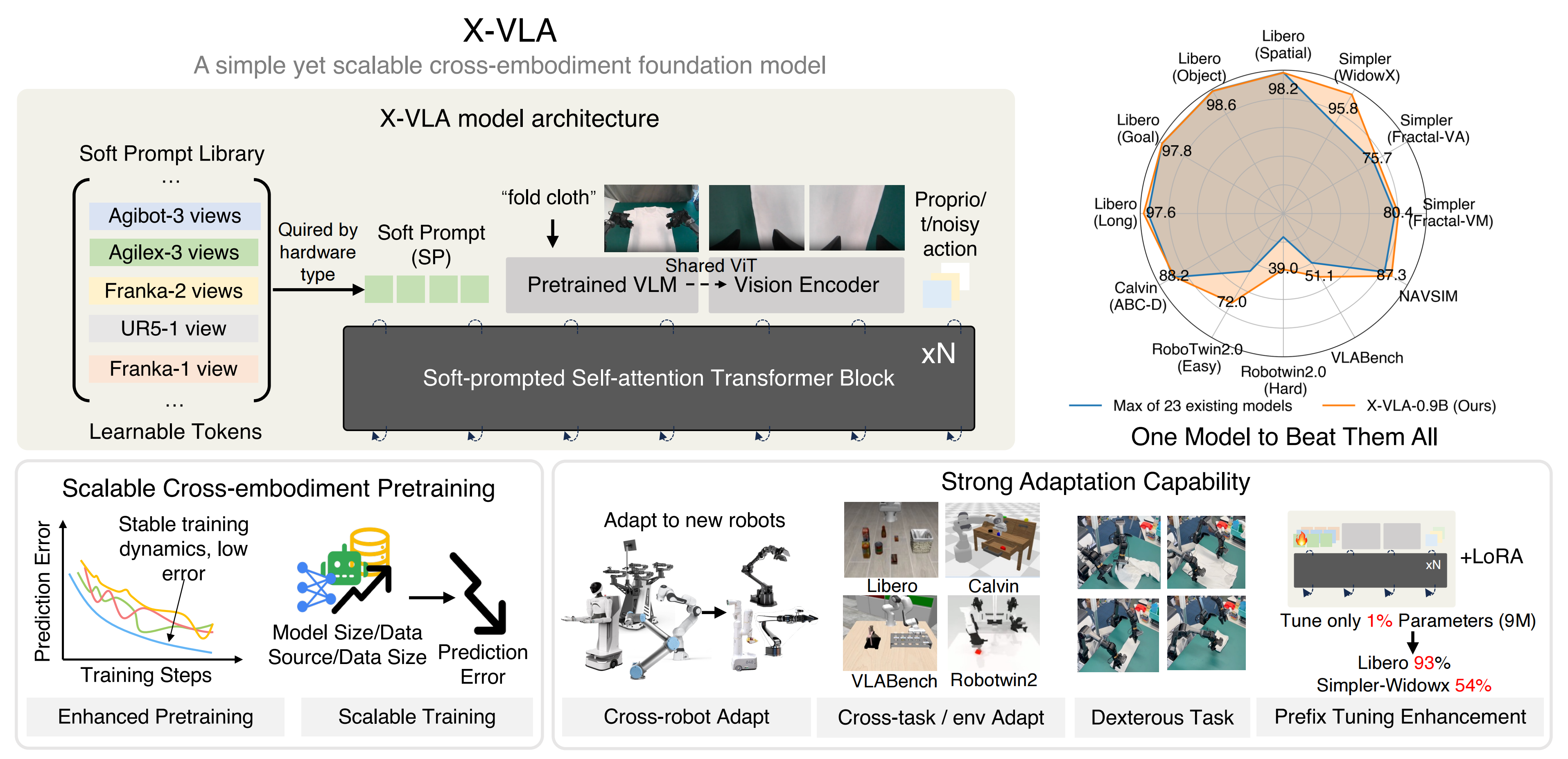

X-VLA——基于Soft Prompt的Transformer编码器练就可扩展的跨本体VLA:VLM做多模态感知,DiT-style做动作生成

摘要:本文提出X-VLA模型,通过SoftPrompt机制解决跨具身机器人学习中的异质性问题。该模型为不同数据源分配可学习嵌入,有效整合硬件配置差异,提升泛化能力。训练分两阶段:先在异构数据上预训练通用策略,再通过微调适配新具身形态。实验表明,X-VLA能在仅增加少量参数的情况下,显著提升模型对多样化机器人系统的适应能力,为具身智能的跨平台部署提供新思路。(149字)

前言

之所以解读χ0、X-VLA,是因为年后有两个基于轮式叠衣服的项目,且在交付中,帮客户的技术团队培养起来,且人效翻倍,哪怕其就一个技术,也能做到原先需要两个人干的活,帮其以一敌二,从而一者帮落地,二者培养人、省人

为更好地利用和挖掘丰富多样的机器人数据源中的异质性,研究者

- 提出了一种新颖的 Soft Prompt(软提示)方法,在仅引入极少量额外参数的前提下,将提示学习的理念融入跨具身机器人学习中

- 并为每一种不同的数据源分别引入一组可学习嵌入

这些嵌入充当具身特定的提示,并通过协同作用,使 VLA 模型能够有效利用不同具身之间变化的特征

此外,X-VLA中关注的跨本体,也是我司于26年起,准备用十年时间,为所有机器人造通用大脑从而「跨本体、跨任务(开柜门、开微波炉)、跨场景(从工业场景到家庭场景)、跨环境(从白天到黑夜)」的其中第一阶段

第一部分 X-VLA: Soft-Prompted Transformer as ScalableCross-Embodiment Vision-Language-Action Model

1.1 引言、相关工作、预备知识、异构软提示学习

1.1.1 引言

如原论文所说,在机器人领域(Brohan et al.,2023,2022),长期以来的核心目标一直是构建能够:

- 灵活地遵循任意人类指令

- 在多样化环境和不同具身形态中灵巧操作的自主智能体

其实具身智能追求的本质就是泛化能力、智能化能力

VLA 模型的成功,尤其是其对分布外OOD领域的快速适应能力,在很大程度上依赖于使用大规模且多样化的机器人数据集进行预训练,这些数据集需要覆盖广泛的机器人系统架构以及丰富多样的任务场景(O’Neill et al., 2024; Lin et al., 2025; Tan et al., 2024)

- 其中一个关键挑战在于,从硬件配置到数据采集策略,VLA 模型都要面对显著的异质性(Wang etal., 2024c)。这种异质性不仅体现在与具体具身相关的动作空间上(Liu et al., 2025b),还体现在诸如相机设置、视觉域以及任务分布等实验设置的差异上(Doshi et al., 2024b; Shiet al., 2025b; Zhen et al., 2024)

————

这些多维度的差异会在不同具身之间带来严重的分布偏移以及显著的语义错配,从而干扰模型,并最终导致预训练和适应阶段的性能不佳(Zhenget al., 2025; Liu et al., 2025b; Doshi et al., 2024b) - 现有 VLA 方法的主要做法,是为不同具身的动作空间分别分配独立的动作解码头以加以适配(Physical Intelligence et al., 2025;Bjorck et al., 2025),而其他同样关键的异质性来源则往往被不可避免地忽视

然而,要实现对本体感知敏感的推理,并从异构的混合领域数据集中蒸馏出可共享的知识,就必须在这些迥异的配置之间实现统一与协调

但这一问题长期未得到解决,原因在于:

1) 不同硬件平台之间存在不一致性

2) 缺乏标准化的数据采集协议

3) 跨具身与跨环境所固有的领域偏移

作者宣称,这些障碍可以在几乎不需人工干预的情况下被有效克服,其方式是允许 VLA 模型通过一种简单的 Soft Prompt 机制学习领域特定的硬件配置(Lester et al., 2021)

- 受元学习和多任务学习研究洞见的启发,作者将机器人领域中多样的硬件配置和数据类型重新刻画为任务特定的特征,由此即可通过提示学习技术加以有效捕获(Wang et al., 2023; Liu etal., 2023c; Khattak et al., 2023; Liu et al., 2023b; Wu & Shi, 2022)

- 具体而言,为了建模前文所述在不同维度上的异质性,作者为每个数据源分配一组可学习的嵌入作为 Soft Prompts

这些嵌入从特征融合的早期阶段起,就为构建 VLA 表征空间提供具备异质性感知能力的指导,从而赋予 VLA 模型更强的能力来利用并整合跨形体差异,提升其在不同硬件和任务配置上的泛化性能

因此,来自1 Institute for AI Industry Research (AIR), Tsinghua University, 2 Shanghai AI Lab, 3 Peking University的研究者提出 Soft-prompted Transformer,这是一种运行于异构平台之上的通用型、基于 flow-matching 的 VLA 框架,称为 X-VLA

- 其paper地址为:X-VLA: Soft-Prompted Transformer as Scalable Cross-Embodiment Vision-Language-Action Model1 Institute for AI Industry Research (AIR), Tsinghua University, 2Shanghai AI Lab, 3Peking UniversityX-VLA: Soft-Prompted Transformer as Scalable Cross-Embodiment Vision-Language-Action Model

其作者包括

Jinliang Zheng1,2∗ , Jianxiong Li1,∗ , Zhihao Wang1,3 , Dongxiu Liu1 , Xirui Kang1 , Yuchun Feng1 , Yinan Zheng1 , Jiayin Zou1 , Yilun Chen2 , Jia Zeng2 , Ya-Qin Zhang1 , Jiangmiao Pang2 , Jingjing Liu1 , Tai Wang2† , Xianyuan Zhan1,2† - 其项目地址

其GitHub地址

具体而言,其

- 通过 Soft Prompts,X-VLA 可以在显式学习得到的各类硬件配置的引导下,适配多种系统与数据结构

- 借助一套多功能架构,能够同时编码多视角图像、语言提示和本体感知特征,X-VLA 只需堆叠标准 Transformer 编码器即可实现多模态特征融合与精确动作生成,从而支持可扩展的 VLA 训练

总之,作者实现了 X-VLA-0.9B,这是 X-VLA 的一个 0.9B 规模实例,使用精心设计的数据处理与学习策略进行训练

整体训练流程包含两个阶段:

- 阶段 I:预训练

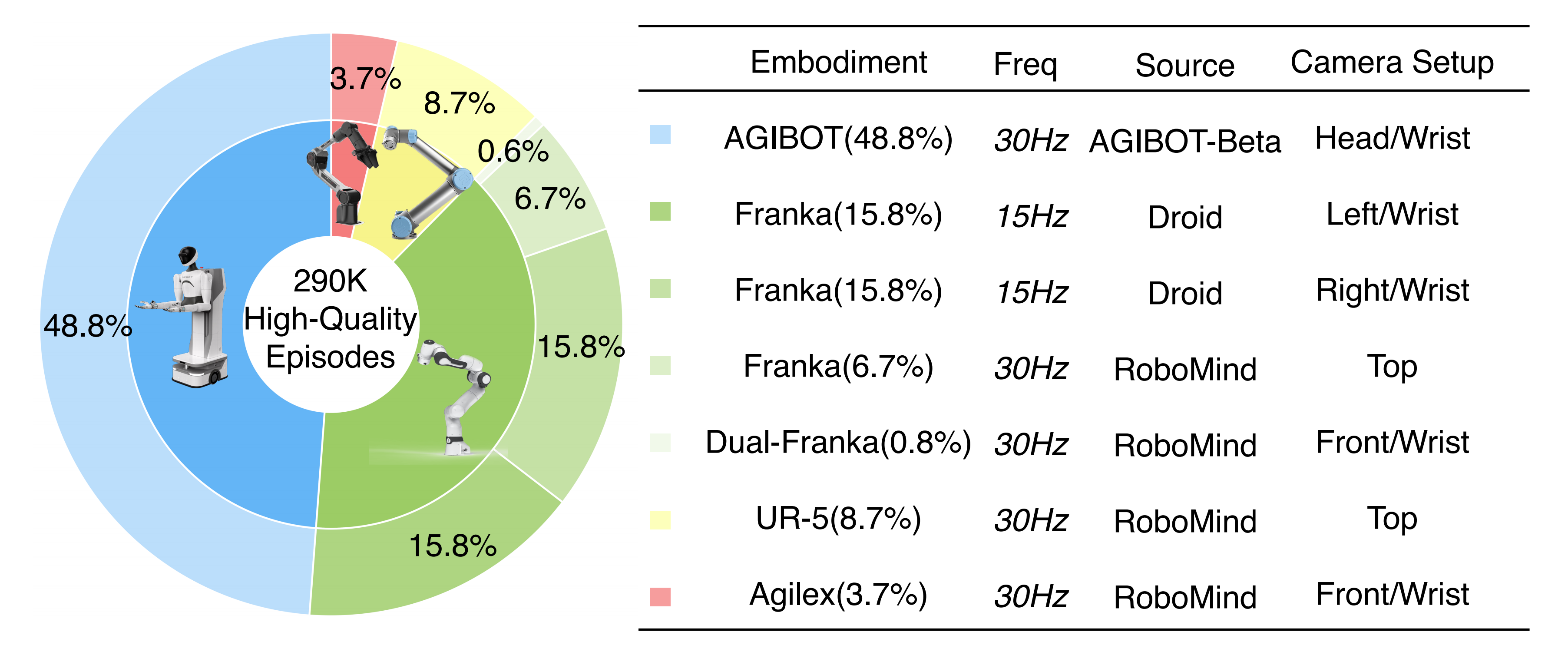

在一个经过精选的异构数据混合上对 X-VLA-0.9B 进行预训练,该数据包含来自 Droid (Khazatsky et al., 2024)、Robomind (Wu et al., 2025) 和 Agibot (Bu et al., 2025) 的 29 万个 episode,覆盖五种类型机械臂下的七个平台,范围从单臂到双臂配置

通过利用软提示来吸收与具体具身形态相关的差异,模型学得了一种与具身无关的通用策略 - 阶段 II:领域自适应

X-VLA-0.9B 被适配为目标领域中的可部署策略

作者引入并优化一组新的软提示,用于编码新领域的硬件配置,同时保持预训练的主干网络冻结不变。在这些提示的基础上,通过微调将该策略有效地专门化到新的具身形态上

1.1.2 相关工作

// 待更

1.1.3 预备知识

首先,对于VLA 模型

其是一类将多模态理解与动作生成统一起来用于机器人控制的模型(Physical Intelligence等, 2025; NVIDIA 等, 2025)

- 通常,VLA 模型从在大规模图文语料库上预训练的VLM 初始化

然后在包含专家轨迹的机器人数据集上进行微调:

其中表示在第

步的多模态观测(例如, 视觉输入, 语言指令, 本体感觉状态), 而

是其对应的专家动作

- 训练目标通常被表述为行为克隆,其中由

参数化的策略

被优化以预测示范的动作片段

其中表示片段大小(Zhao 等,2023; Chi 等; Physical Intelligence 等,2025)

通过最小化一个合适的监督损失

其次,对于流匹配策略

与其直接从观测 预测专家动作片段

,流匹配策略通常学习一个速度场(Lipman et al., 2023;Physical Intelligence et al., 2025; Black et al., 2025),用于将噪声样本传输到目标动作片段

- 例如,可以通过从高斯噪声

开始,并通过由神经网络参数化的速度场

迭代地进行修正

利用如Euler-Maruyama 方法这样的ODE 求解器生成一个动作A :

这里,是一个连续时间变量

- 为了训练速度场,作者使用OT(最优传输)路径(Lipman et al., 2024, 2023),该路径将速度与噪声和专家数据之间的线性插值路径对齐:

其中,

是均匀分布

————

最终,通过最小化, 策略学习在以观测为条件的情况下,逐步将随机噪声传输到专家片段上

最后,对于跨实体训练中的异质性

基于由H 个异质数据集构成的混合数据配方进行训练,,对于发展通用的VLA 模型是至关重要的(Doshi et al.,2024a; O�Neill et al.,2024)

- 每个数据集

都是在特定的硬件配置

下收集的,其中

表示可能硬件设置的空间,例如机械臂运动学、控制接口、相机配置以及部署场景

- 这些因素引入了显著的异质性,不仅体现在低层次的动作信号和分布上,也体现在高层次的视觉理解上,如果不能有效应对,可能会导致预训练和适应效果不佳(Wang et al., 2024c; Zheng et al., 2025)

1.1.4 异构软提示学习(Heterogeneous Soft Prompt Learning)

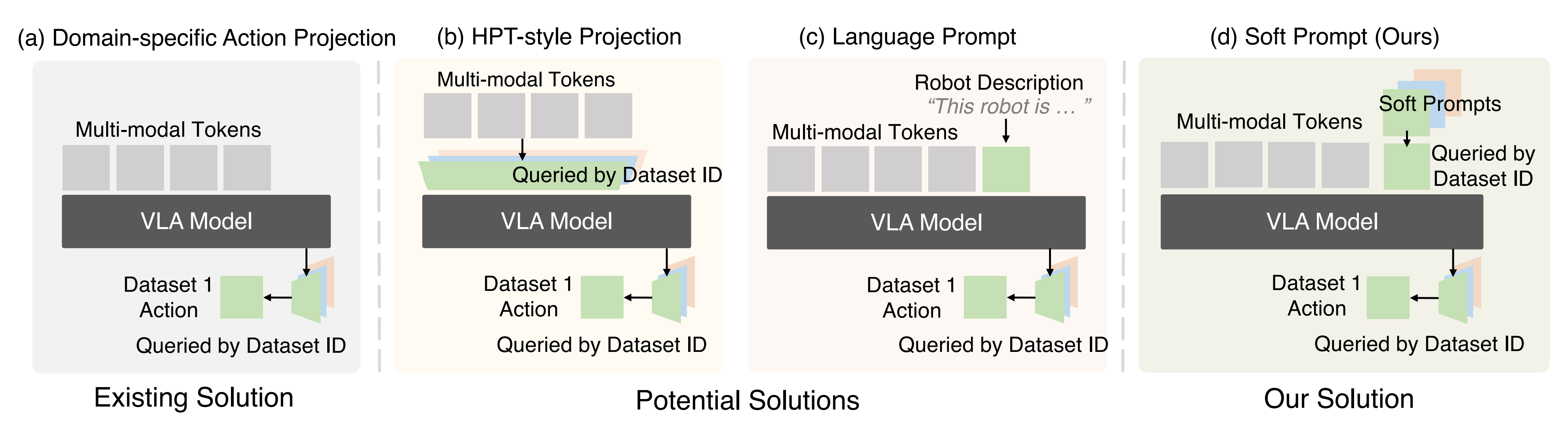

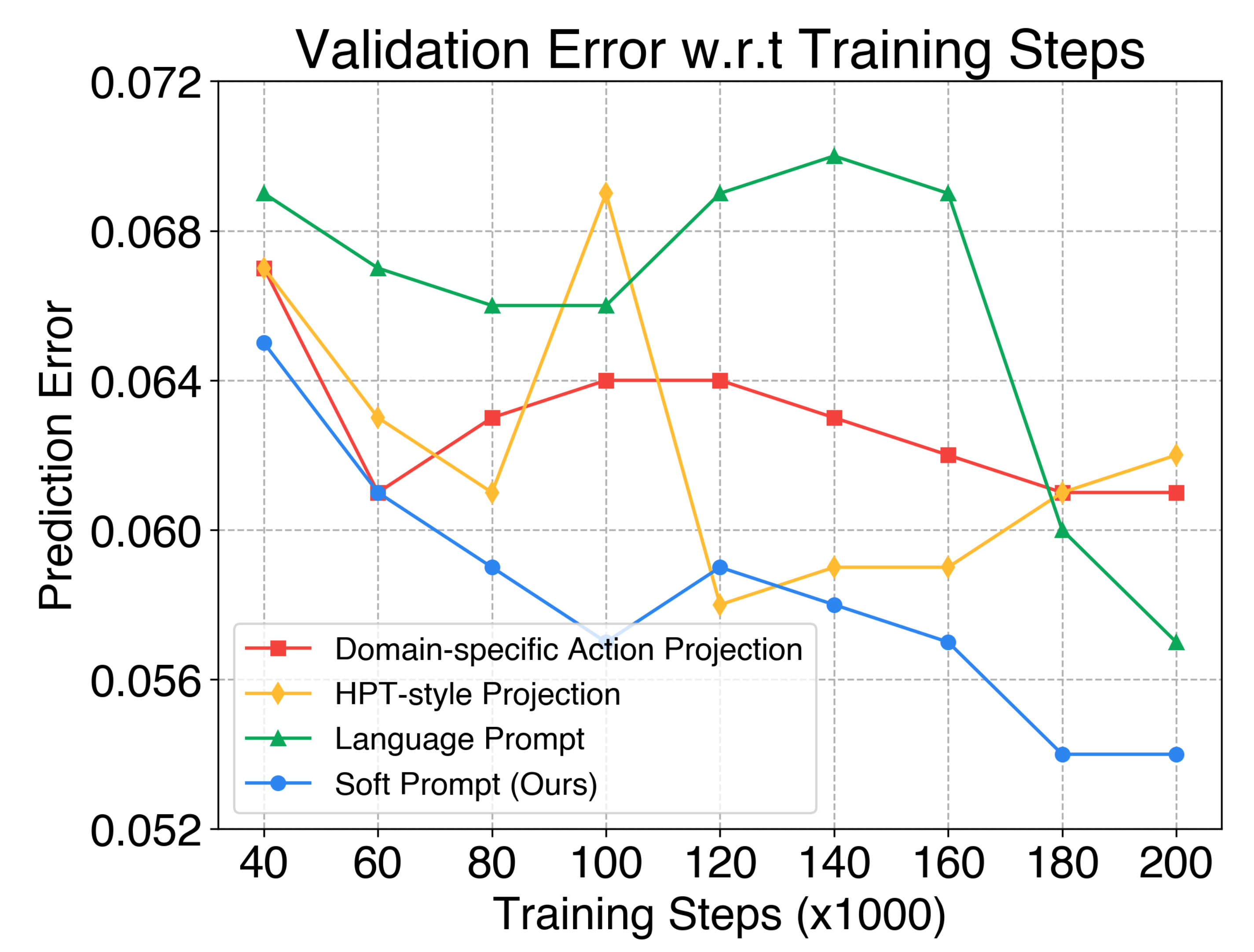

为了解决异构性问题,作者进行了一项全面的实证研究,以探索潜在的设计选择,如图 2 所示

作者遵循 Reuss et al. (2025) 和 Bjorck et al. (2025) 构建一个标准的双系统架构作为起点,该架构利用 VLMs 进行多模态感知,并采用 DiT-style 解码器进行动作生成

在图 3中,作者从近期的高质量数据源构建了一个异构数据混合体,包括 AGIBOT-beta (Bu et al.,2025)、RoboMind (Wu et al., 2025) 和 Droid (Khazatsky et al., 2024)

该数据集覆盖了 5种机器人、7 套硬件配置,从单臂到双臂系统不等,提供了训练通才策略所需的足够规模和多样性。且在完全对齐的训练配方下评估所有方法,以确保公平对比

- a) 领域特定动作投影

该策略通过在模型输出端分配独立的投影头,将动作 token 映射到与具身形态相关的动作空间,从而应对异质性

尽管这一方法在以往的具身基础模型中被广泛采用(Physical Intelligence et al.,2025; Bjorck et al.,2025;Team et al.,2025;Zheng etal.,2025;Liu et al.,2025b),其效果仅限于最终的动作生成阶段

因此,它无法在更早的流水线阶段促进具身感知的推理,也忽略了其他关键的异质性来源,例如不同摄像机设置和任务分布的变化

为规避这些局限性,作者识别出三种具有代表性的策略,用于提升在异质数据集上的预训练稳定性,如图2所总结。我们在下文中对这些策略进行分析,更多实验尝试见附录 E - b) HPT 风格投影

受 Wang et al. (2024c) 启发,该方法旨在缓解观测输入中的跨域差异,并通过将来自不同领域的观测映射到一个共享表示空间中,以促进通用推理能力

具体而言,还在多模态输入之上施加特定领域的投影层,对不同域的输入进行对齐,然后再将其送入主干网络 - c) 语言提示

另一种策略利用预训练VLM 的语言推理能力(Li et al., 2024a; Li et al.)

在这种情况下,关于硬件配置的自然语言描述被作为额外输入提供,使模型能够通过文本描述显式地关注具身特定的变化

- d) 软提示Soft prompts

最后,作者研究一种软提示方法,该方法遵循元学习和多任务学习的理念(Finn et al., 2017; Liu etal., 2023c)

通过引入领域特定的可学习参数来吸收不同数据源之间的异质性

被期望能够编码底层的硬件配置:

,其中

表示一个从硬件配置到提示空间的潜在映射

————

需要注意的是,并不像语言提示(c) 中那样由硬模板预先定义,而是随机初始化,然后通过端到端训练被隐式优化

这些软提示在动作生成的早期阶段被注入模型,自动引导主干网络朝向具身感知的学习

尽管(b) HPT 风格投影和(c) 语言提示在概念上具有吸引力,但它们存在显著的局限性

- HPT 风格投影在观测处理的中间引入了不同的投影层,这会频繁改变特征分布,且容易破坏预训练VLM 的表征,往往导致训练过程不稳定

- 另一方面,语言提示依赖于精心编写的硬件配置文本描述,这在实践中极大地限制了其适应性和可扩展性

相比之下,软提示为编码特定领域的硬件配置提供了一种灵活且可扩展的解决方案。它综合了(b) 和(c) 两者的优点,在与骨干网络平滑集成的同时,保留了预训练表征,并消除了对手工标注的需求

图4 中的实证结果表明,软提示在异构数据集上始终能够实现更加鲁棒且稳定的训练

1.2 X-VLA:软提示 Transformer 增强型 VLA 模型

在 Soft Prompts 的基础上,作者提出 X-VLA,这是一种简洁的 VLA 架构,旨在实现对异构数据集的稳定预训练以及对新领域的高效适配

下面首先介绍整体架构设计,随后给出若干用于大规模预训练的关键技术。完整的消融实验路径见表 1,其中突出展示了本节所引入各组件的贡献

1.2.1 架构

作者设计的核心思想是为复杂的多模态输入构建一条精简的编码流水线。除 Soft Prompts 之外,X-VLA 还处理:

- 高维输入(多视角视觉和语言)

- 低维状态(本体感知和动作 token)

由于这些模态在语义和维度上存在显著差异,作者采用专门的编码策略对它们进行有效对齐,之后只需使用标准的 transformer 堆栈即可实现可扩展的策略学习

下面将详细介绍该编码流水线;完整的架构及更多设计探索见附录 C 和附录 D

- 对于高维观测流

高维输入包括多视角图像Img = {imgi} ,以及用于指定任务目标的语言L

不同于大多数先前方法

Physical Intelligence et al., 2025

Octo Model Team et al., 2024

Bjorck et al., 2025

直接将所有视角和指令输入到VLM 中,作者通过分配不同的编码器来解耦这些流

一个预训练的VLM 编码器(X-VLA 中的Florence-Large (Xiao et al.,2024))用于主要的视觉-语言流(固定视角和指令),而辅助视角(如腕部视角)则通过共享的视觉骨干网络进行处理

这一设计缓解了通用视觉-语言推理与具身推理之间的语义鸿沟:

固定相机视角为高层任务推理提供稳定且信息丰富的上下文;

而腕部相机输入虽然噪声大且变化快,却为细粒度操作提供关键线索,因此与语言流分开编码 - 对于低维本体感知-动作流

本体感知状态, 例如关节位置和末端执行器位姿,为推理和控制提供了具身特定的支撑。与动作相关的tokens

由用于flow-matching 生成的带噪动作样本组成

由于和

均为具有紧密相关物理语义的紧凑向量,因此作者在流匹配管道中将它们与其相应的时间嵌入

拼接在一起

——————

融合后的嵌入通过一个轻量级线性层被投射到高维特征空间,从而能够与其他模态进行早期融合,并确保稳健的本体感受–时间锚定

1.2.2 定制化训练配方:预训练与微调流程、增强的数据处理

为了充分激发 X-VLA 的潜力,作者引入了一套精心设计的学习工程,以提升 X-VLA 训练的稳定性和有效性。下面将概述他们的训练配方,并梳理若干对实现稳定且高效训练至关重要的关键技术

1.2.2.1 预训练与微调流程

1.2.2.2 增强的数据处理

// 待更

DAMO开发者矩阵,由阿里巴巴达摩院和中国互联网协会联合发起,致力于探讨最前沿的技术趋势与应用成果,搭建高质量的交流与分享平台,推动技术创新与产业应用链接,围绕“人工智能与新型计算”构建开放共享的开发者生态。

更多推荐

已为社区贡献70条内容

已为社区贡献70条内容

所有评论(0)