RDT2——基于UMI 数据实现零样本且跨各本体形态的泛化:先训练VLM、后训练扩散动作专家、最后将将扩散策略蒸馏为一步生成器

前言

// 待更

第一部分

1.1 引言与相关工作

1.1.1 引言

如原论文所说,当前的 VLA 模型仍未能复现其他领域如NLP『Achiam et al., 2023-即Gpt-4; Touvronet al., 2023-即Llama; Bai et al., 2023-即Qwen technical report; Guo et al., 2025-即Deepseek-rl』中大规模模型所具有的广泛泛化能力

它们在面对新的场景、物体、指令或具身形态时往往难以稳定可靠地执行(Ma et al., 2024),从而阻碍了其在真实世界中的应用

为机器人开发具有良好泛化能力的 VLA 模型面临两个根本性挑战

- 其一是获取大规模且多样化的数据集

通过远程操作进行传统数据采集『Zhaoet al., 2023-即ALOHA ACT; Fu et al., 2024-即Mobile aloha』通常成本高得难以承受,并且由于机器人平台的物理约束和高昂费用而缺乏多样性

相比之下,Universal Manipulation Interface(UMI)提供了一种与具体具身形态无关的手持设备,使得在大量真实世界场景中能够高效且低成本地采集数据

- 第二个挑战在于设计能够有效利用这些大规模机器人数据的网络架构

一个关键难点在于人工采集示范数据所固有的多峰性『Chen et al., 2022-Offline reinforcement learning via high-fidelity generative behavior modeling; Chi et al., 2023-即Diffusion policy』

先前通过离散化来建模动作概率的方法『Brohan et al.,2022-即Rt-1; Zitkovich et al., 2023-即Rt-2; Kim et al.,2024-即Openvla』,往往受到离散化误差以及自回归推理低效性的限制

使用扩散模型的替代方法

Chen etal., 2022-即Offline reinforcement learning via high-fidelity generative behavior modeling

Chi et al., 2025-即Diffusion policy

Liu et al., 2024

Black et al., 2024-即π0

则存在收敛缓慢(Pertsch et al.,2025-即FAST_π0),以及其连续概率分布与预训练视觉-语言模型(VLMs)中以离散形式表示的知识之间存在根本不匹配的问题

此外,这些模型规模不断增大,与机器人任务对实时性能的需求之间也存在显著矛盾

尽管已有部分工作探索了蒸馏技术

Chen et al., 2023,即Score regularized policy optimization through diffusion behavior

Wang et al., 2024b,即One-step diffusion policy: Fast visuomotor policies via diffusion distillation,通过扩散蒸馏实现的一步式快速生成视觉运动策略

Prasadet al., 2024,即Consistency policy,通过一致性蒸馏加速机器人策略的推理过程

但针对大规模 VLA 模型的实用方法的研发仍然是一个尚未解决的开放问题

此外,VLA 模型在跨形体部署方面面临一个重大限制。由于不同机器人平台在物理特性上的差异,在某一种形体上训练得到的模型当迁移到另一个时,在泛化能力上表现不佳

一些方法尝试将来自不同具身形式的数据统一到一个共同的嵌入空间中

- Team et al.,2024-即Octo

- Liu et al.,2024-即Rdt-1b

- Wang etal.,2024a-即Scaling proprioceptive-visual learning with heterogeneous pretrained transformers

探讨了利用异构预训练 Transformer 扩展视觉与本体感知学习 - Yang et al.,2024-即Pushing the limits of cross-embodiment learning for manipulation and navigation,研究了跨平台具身学习在操作与导航任务中的极限

但仍然难以实现在全新平台上的零样本部署

因此,将一个 VLA 模型适配到一台新机器人往往需要数百小时的数据采集和微调。这一巨大的成本不仅阻碍了 VLA 研究的可复现性和广泛适用性,也限制了整个领域的总体发展进程

- Khazatsky et al.,2024,即Droid: A large-scale in-the-wild robot manipulation dataset

- Atreyaet al.,2025,即Roboarena: Distributed real-world evaluation of generalist robot policies

- Mirchandani et al.,2025,即Robocrowd: Scaling robot data collection through crowdsourcing

为了解决上述挑战,来自的研究者提出了 RDT2,它是首批能够在新型实体形态上实现 zero-shot 部署的机器人基础模型之一,能够处理开放词表任务

- RDT2构建在一个 7B 规模的预训练 VLM Qwen2.5-VL之上,配备了专门的动作头,以及用于从大规模机器人数据中学习的三阶段训练策略

- 为了加速收敛

在阶段 1 中,作者使用 Residual Vector Quantization,即RVQ

VanDen Oord et al., 2017,即Neural discrete representation learning,提出了 VQ-VAE 模型,开创了通过向量量化学习离散潜变量表示的方法

Esser et al., 2021,即Taming transformers for high-resolution image synthesis,提出了 VQGAN,将卷积的归纳偏置与 Transformer 的表达能力结合,用于高质量图像合成

Lee etal., 2022,即Autoregressive image generation using residual quantization,提出了 RQ-VAE,引入残差向量量化(RVQ)来提高表示精度,是 RDT2 动作分词器的核心参考

将连续的机器人动作编码为离散token,然后通过最小化交叉熵损失来训练 VLM

这也避免了破坏在预训练阶段以离散概率形式存储的知识在阶段 2 中,为了兼顾表达能力和效率,作者引入一个动作专家来建模连续概率,并使用flow-matching 损失对其进行训练

在阶段 3 中,作者提出了一种简单而有效的蒸馏损失,将动作专家蒸馏到单步生成器中,从而实现超高速推理

1.1.2 相关工作

首先,对于机器人数据金字塔

用于机器人学习的数据版图可以被概念化为一个金字塔(Bjorck et al.,2025)

- 位于塔尖的是遥操作数据,这类数据通过 VR 等系统

Khazatsky et al.,2024,即Droid: A large-scale in-the-wild robot manipulation dataset

Cheng et al.,2024,即Open-television

Chen etal.,2025a,即Arcap: Collecting high-quality human demonstrations for robot learning with augmented reality feedback,利用增强现实AR反馈采集高质量机器人学习的人类演示数据

或主从机械臂

Zhao et al.,2023;即ALOHA ACT

Fu etal.,2024,即Mobile aloha

Aldaco et al.,2024,即Aloha 2

采集,具有最高的保真度,但获取成本也最高

其采集通常局限于结构化的实验室环境

Walke et al.,2023,即Bridgedata v2: A dataset for robot learning at scale

Fang etal.,2023,即Rh20t: A comprehensive robotic dataset for learning diverse skills in one-shot

Khazatsky et al.,2024,即Droid: A large-scale in-the-wild robot manipulation dataset

O’Neill et al.,2024,即Open x-embodiment

Wuet al.,2024,即Robomind: Benchmark on multi-embodiment intelligence normative data for robot manipulation

从而在训练数据与真实世界应用之间造成分布差距 - 位于中间层的是仿真数据

Wang etal.,2023,即Robogen: Towards unleashing infinite data for automated robot learning via generative simulation

Li et al.,2023,即Behavior-1k: A benchmark for embodied ai with 1,000 everyday activities and realistic simulation

Mu et al.,2024,即Robotwin: Dual-arm robot benchmark with generative digital twins (early version)

Chen etal.,2025b,即Robotwin 2.0: A scalable data generator and benchmark with strong domain randomization

这种数据成本低且具有良好的可扩展性,但受到显著的“仿真到真实”(sim-to-real)鸿沟困扰

并且如何生成多样化、具备交互性且逼真的场景仍然是一个尚未解决的开放问题

Nasiriany etal.,2024,即Robocasa: Large-scale simulation of everyday tasks for generalist robots

Ren et al.,2024,即Infinite-world: A unified scalable simulation framework for general visual-language robot interaction

Zhang et al.,2025,即Agentworld: An interactive simulation platform for scene construction and mobile robotic manipulation - 位于底层的是海量的互联网视频资源

Ye etal.,2024,即Latent action pretraining from videos,从互联网视频中进行潜动作(Latent Action)预训练

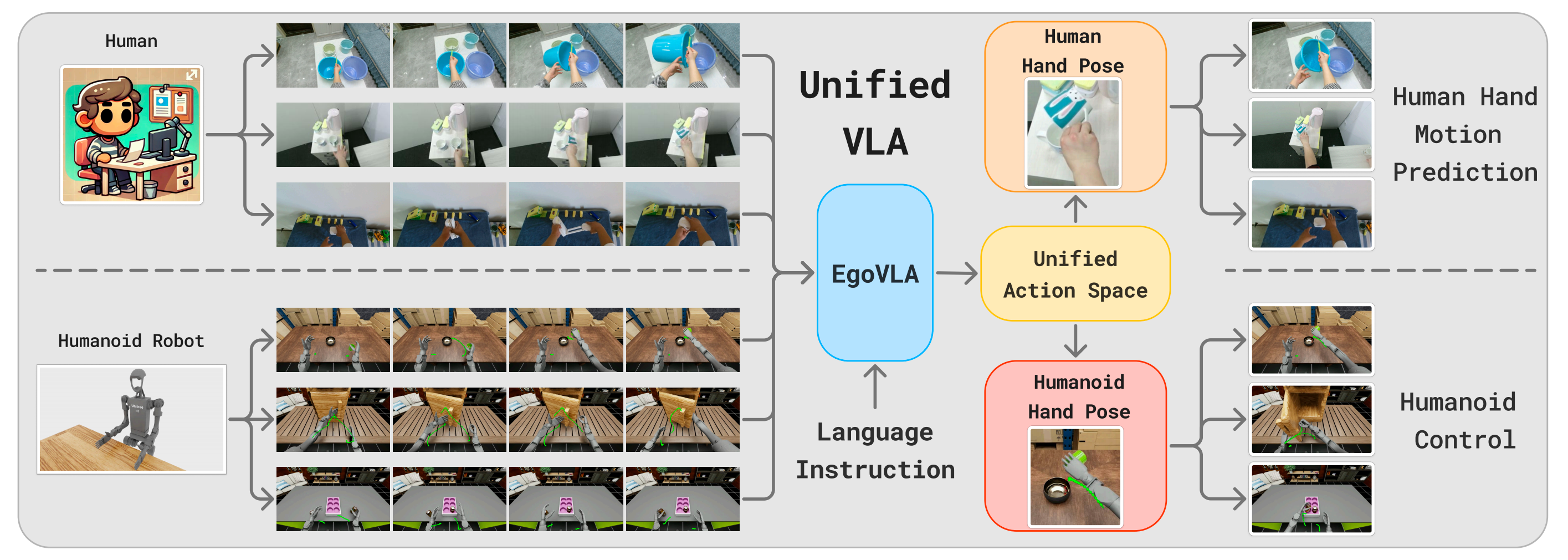

Yang et al.,2025,即Egovla: Learning vision-language-action models from egocentric human videos,从第一人称视角(第一视角)视频中学习 VLA 模型

Luo et al.,2025,即Being-h0: vision-language-action pretraining from large-scale human videos,基于大规模人类视频进行的视觉-语言-动作预训练

Feng etal.,2025,即Vidar: Embodied video diffusion model for generalist manipulation,用于通用具身操作的视频扩散模型

尽管数量丰富,这类数据是非结构化且噪声较大,更重要的是,缺乏监督策略训练所需的显式动作标签

McCarthy et al.,2025,即Towards generalist robot learning from internet video: A survey,关于如何从互联网视频学习通用机器人技能的综述

其次,对于模仿学习模型

先前的模型大致可以按照其泛化策略进行分类

- 大量研究工作聚焦于小规模模型

Pari etal., 2021,即The surprising effectiveness of representation learning for visual imitation

Florence et al., 2022,即Implicit behavioral cloning

Shafiullah et al., 2022,即Behavior transformers: Cloning k modes with one stone

Jang et al., 2022,即Bc-z: Zero-shot task generalization with robotic imitation learning

例如Diffusion Policy

Chen et al.,2022;,即Offline reinforcement learning via high-fidelity generative behavior modeling,通过高保真生成行为建模进行离线强化学习

Chi et al., 2023,即Diffusion policy

和

ACT,Zhao et al., 2023,即ALOHA ACT

它们通常是在每个任务的基础上进行训练。虽然在各自的特定领域内表现出色,这些模型在本质上缺乏跨多样任务或不同实体(embodiments)进行泛化的能力 - 为了解决跨实体的挑战

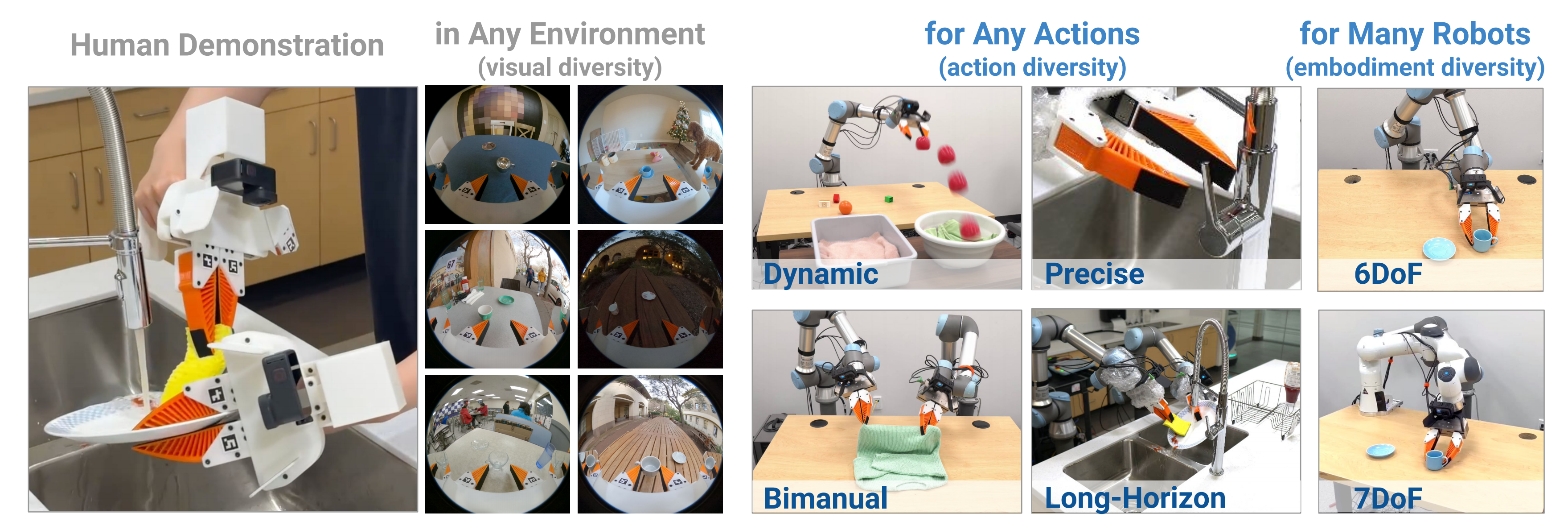

另一类研究利用UMI,包括dexumi,来收集与实体无关的数据

然而,这些数据集的规模有限,从而限制了所得模型在开放词汇任务上的表现

最近,该领域出现了诸如OpenVLA、RDT-1B、π0和π0.5等大型模型

然而,由于其数据集依赖于特定机器人,这些模型在不进行微调的情况下难以实现良好的实体可迁移性

1.1.3 问题表述与挑战

作者在针对 VLA 模型的语言条件模仿学习设定下研究双臂操作任务,而这一设定在机器人学习领域已经相当成熟

- 从形式上看,该任务被建模为一个序贯决策过程

令表示描述该任务的自由形式语言指令。在每个时间步

,智能体需要采取一个动作块

,该动作块从

中采样得到,

————

其中是在

时刻采取的

维动-作,

是块大小(Zhao et al.,2023),并且

是智能体在t 时刻接收的RGB 观测

这里, 作者假设已经包含做出决策所需的全部信息, 而不考虑历史观测

- 为了获得一个可行的智能体, 作者训练一个VLA 模型, 从人类专家的演示数据集

中学习分布

,

其中是第

条轨迹的长度,

是轨迹的总数量

一个给定的操作任务由若干关键要素的组合所定义:被操作的物体、操作场景、来自用户的自然语言指令,以及机器人的具身形式

任何有限的训练数据集只能覆盖由这些要素张成的庞大组合空间中的一个稀疏子集

因此,一个实用的 VLA 模型在部署时必须能够推广到未见过的物体、场景、指令,甚至全新具身形式的组合上。实现这种组合泛化——这对真实世界应用至关重要——面临两个根本性挑战:

- 扩展机器人数据规模的挑战

在自然语言处理和计算机视觉领域,人们已经充分研究并证实:增加数据集的规模与多样性可以提升模型的泛化能力(Kaplan et al.,2020; Zhai et al., 2022)

————

然而,将这一原则通过远程操作(teleoperation)直接应用到机器人领域目前并不现实。机器人成本高昂,使得并行采集数据——也就是进行大规模数据收集——的费用高得难以承受

此外,这类系统缺乏可移植性,使得数据采集主要局限于实验室或工厂环境,从而严重限制了数据的多样性以及所收集数据的真实世界相关性

这种数据稀缺性还被硬件的异构性进一步加剧,因为在一个机器人平台上收集的数据往往无法与其他平台兼容,从而形成彼此隔离且不可互操作的数据集 - 网络架构的挑战

根据已有研究(Chen et al.,2022; Chi et al., 2023),人类数据呈现显著的多模态特征,这要求模型学习的是动作的分布,而不是确定性的映射。这就引出了在离散与连续动作表示之间的选择问题,而二者各自具有不同的权衡

————

离散方法在形式上与预训练 VLM 的概率输出天然契合,但会受到量化误差以及自回归采样低效性的影响

相反,连续方法(例如扩散模型)在采样效率上更具优势,但其训练收敛更慢(Pertsch et al., 2025),并且存在破坏 VLM中离散知识的风险(Deng et al., 2025)

因此,一个关键挑战在于综合这两种范式的优点

此外,机器人任务对实时性能的要求,使得高效部署大规模 VLA 成为一项极其艰巨的障碍

1.1.4 硬件与数据集

为了解决数据扩展挑战,作者采用 UMI(Chi et al.,2024),这是一种便携式框架,可用于支持可扩展的真实环境数据采集

关于UMI,详见此文《UMI——斯坦福刷盘机器人:通过手持夹爪革新数据收集方式,且使用视觉SLAM和Diffusion Policy预测动作》

- UMI 使用带有视觉模块和跟踪器的手持设备,记录 6 自由度末端执行器位姿以及夹爪张开宽度

- 当安装物理参数一致的夹爪时,由 UMI 数据学习得到的策略可以部署到多种不同的机械臂上,因为在不同具身形态之间的视觉差异和结构差异都被最小化

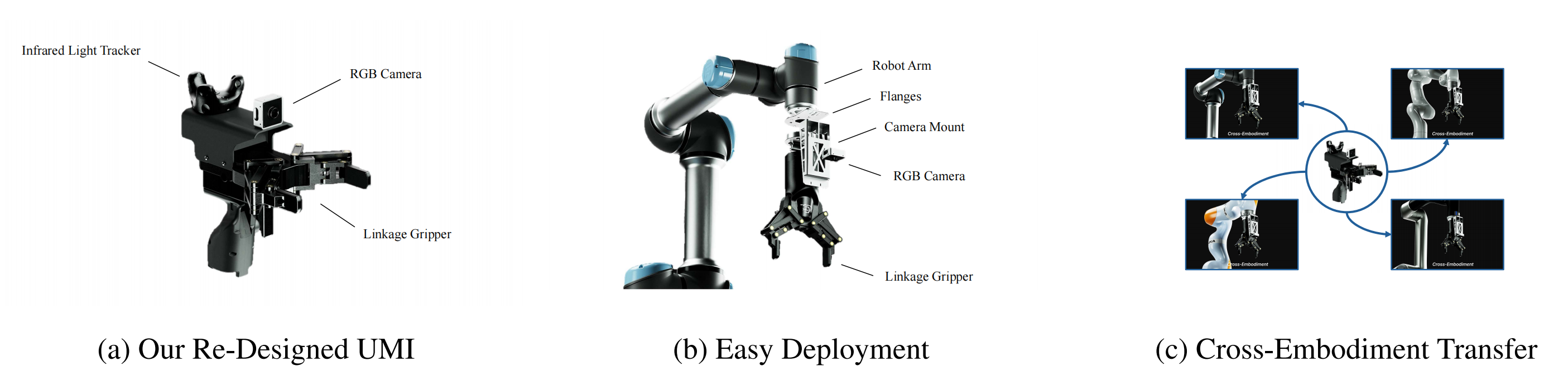

图 1 展示了作者的 UMI 解决方案从设计到部署的全过程

- 重新设计 UMI

然而,原始的 UMI 硬件缺乏进行大规模真实环境采集所必需的可靠性。为了解决这一问题,作者对整个系统(图 1a)进行了重新工程设计

以最大化结构刚度,确保无漂移红外跟踪,并在杂乱环境中提升操作灵巧性

——————

如表1所示,这些改动解决了关键的位姿不一致问题和可达性限制,从而显著提高了数据保真度;更详细的硬件规格见附录A - 大规模 UMI 数据集

得益于上述硬件进步,作者整理了迄今为止最大规模的开源 UMI 数据集之一,包含超过 10,000 小时的操作数据,覆盖100 多个家庭

该数据集完全在真实环境中采集,囊括了大量无结构环境和复杂人类行为的分布,为通用策略学习提供了坚实基础;关于数据集的详细信息见附录 B

1.2 模型与训练流程

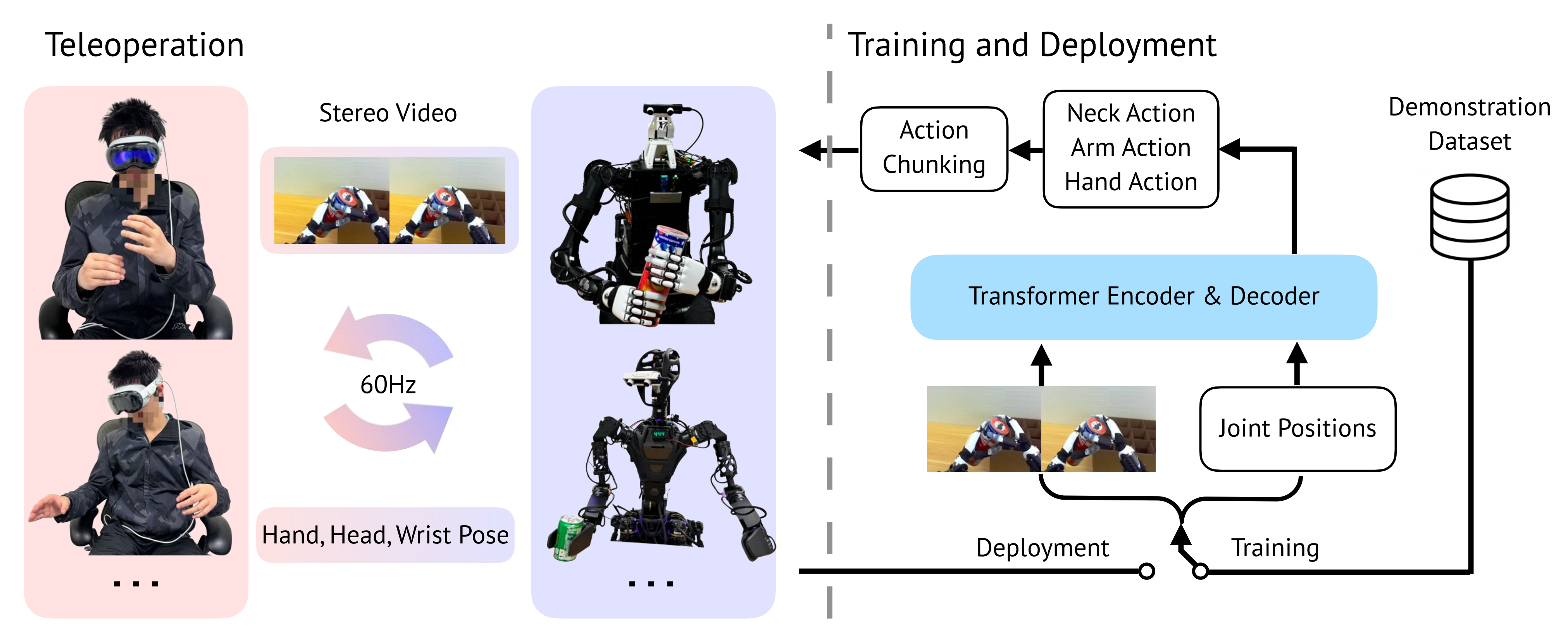

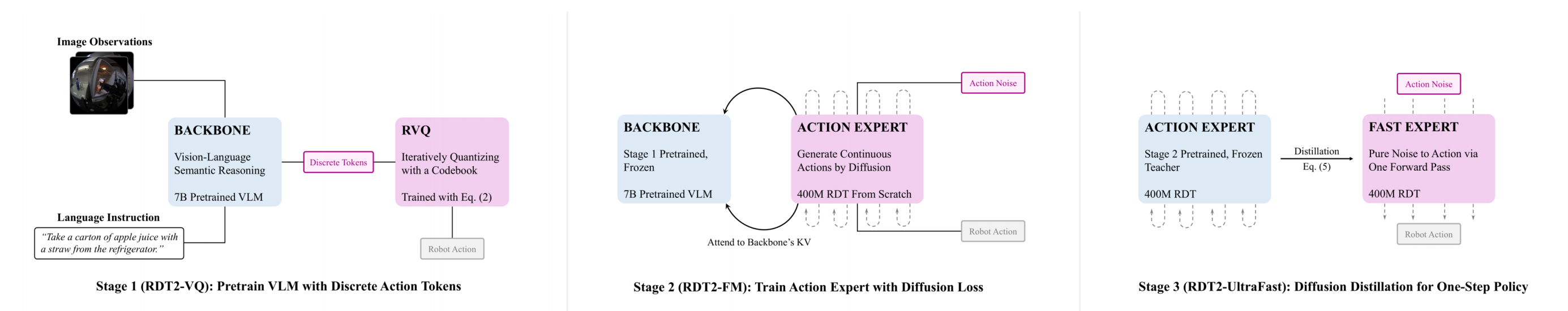

RDT2,这是一种按照图 2 所示三阶段流程训练的 VLA 模型

- 在第一阶段,作者使用 RVQ 将连续动作空间离散化为 token,并通过标准交叉熵损失训练 VLM 主干网络

即使用离散化的动作数据预训练一个 70 亿参数的 VLM主干模型,以获得视觉-语言推理能力 - 随后,在第二阶段,作者冻结 VLM 主干网络,并训练一个基于扩散的动作专家,利用flow-matching 损失来生成连续动作

————

即训练一个小型扩散式动作专家模型,以高效生成连续动作

这种混合方法兼具离散化和扩散两种范式的优点,有效应对了对多峰动作分布建模的挑战 - 最后,为了解决机器人任务中的实时性难题,第三阶段将多步动作专家蒸馏为高效的单步生成器,从而使该大规模 VLA 模型能够进行快速推理

即对于高度动态的任务,作者进一步引入第三阶段,将扩散策略蒸馏为一步生成器,从而实现极快的推理速度

关于超参数和训练细节,请参见附录 C

// 待更

DAMO开发者矩阵,由阿里巴巴达摩院和中国互联网协会联合发起,致力于探讨最前沿的技术趋势与应用成果,搭建高质量的交流与分享平台,推动技术创新与产业应用链接,围绕“人工智能与新型计算”构建开放共享的开发者生态。

更多推荐

已为社区贡献63条内容

已为社区贡献63条内容

所有评论(0)