【具身智能】机器人训练流程

现代机器人训练是一个仿真与真实交织、算法与工程并重的领域。在高度随机化的虚拟世界中,通过强化学习等算法进行大规模“数字练兵”,再利用各种技术将习得的技能“迁移”到物理实体上,最终通过少量真实数据微调并安全部署。

·

机器人训练是一个涵盖硬件和软件、仿真与现实的复杂系统工程。不同类型的机器人(工业机械臂、服务机器人、人形机器人等)训练方法差异很大,但核心逻辑是相通的。

下面将梳理机器人训练的核心流程、关键技术和不同范式:

一、 机器人训练的总体流程

一个完整的机器人训练周期通常包含以下闭环:

感知 → 决策 → 执行 → 反馈 → 学习与优化

二、 核心训练方法与技术

机器人训练主要分为两大类:传统方法和基于机器学习(尤其是强化学习)的方法。

1. 传统方法(基于模型与规则)

- 原理:工程师为机器人建立精确的数学模型(运动学、动力学模型),并编写明确的控制规则和任务逻辑。

- 如何训练:

- 系统辨识:通过让机器人执行特定动作并收集数据,来反推和校准其数学模型参数。

- 轨迹规划:在已知模型的基础上,规划出最优、无碰撞的运动路径。

- PID控制:调试比例、积分、微分参数,让机器人动作稳定精准。

- 适用场景:结构化环境中的重复性任务,如汽车制造线上的焊接、喷涂。

2. 基于机器学习的方法

这是当前让机器人获得“智能”和适应性的主流方向。

-

A. 模仿学习

- 原理:让机器人像学徒一样,通过观察人类演示来学习。

- 如何训练:

- 数据采集:通过动作捕捉、远程操作(示教器)或VR设备,记录人类专家完成任务的轨迹(关节角度、末端位置等)。

- 模型训练:训练一个神经网络(如时间序列模型),学习从“环境状态”到“机器人动作”的映射关系。

- 部署与微调:将训练好的模型部署到机器人上,并在真实环境中进行微调。

- 优点:直观,能快速获得接近人类水平的技能。

- 缺点:依赖高质量的演示数据,泛化能力可能有限。

-

B. 强化学习

- 原理:让机器人在与环境的“试错”交互中学习。通过“奖励”信号来引导其行为。

- 关键概念:智能体(机器人)、环境、状态、动作、奖励。

- 如何训练 - 标准流程:

- 定义任务:明确要完成的目标(如拿起杯子),并设计合理的奖励函数(如距离杯子越近奖励越高,成功拿起获得巨大奖励,碰到东西则惩罚)。

- 仿真训练(99%的工作在此):

- 在模拟器中进行:使用MuJoCo、PyBullet、Isaac Sim、Gazebo等物理仿真平台。这是核心,因为现实训练耗时、危险且成本高。

- 算法探索:机器人(智能体)在仿真中随机尝试动作,根据收到的奖励/惩罚,通过RL算法(如PPO、SAC、DDPG)不断更新其策略网络。

- 加入随机化:在仿真中随机化物体大小、颜色、摩擦系数、光照等,以提高模型的鲁棒性和泛化能力。

- 仿真到现实转移:

- 领域随机化:上述的随机化训练,让模型不依赖于特定仿真参数。

- 域适应技术:使用少量真实数据对仿真训练出的模型进行微调。

- 真实世界部署与在线学习:

- 将仿真中训练好的策略网络部署到真实机器人。

- 可能进行最后的在线微调,以适应真实的传感器噪声和物理特性。

-

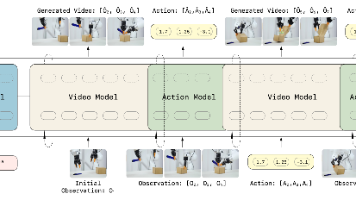

C. 大模型 + 机器人

- 这是最前沿的方向,利用大型语言模型或视觉-语言模型为机器人提供“常识”和任务理解能力。

- 如何训练/使用:

- 高层规划:用户用自然语言下达指令(“帮我拿一瓶可乐”),LLM将其分解成一系列可执行的子任务步骤(导航到冰箱 -> 打开冰箱门 -> 识别并抓取可乐 -> 返回)。

- 底层技能调用:每个子任务由预先训练好的技能模型(如抓取模型、导航模型)或RL策略来执行。

- 端到端训练:将VLM(视觉语言模型)与机器人控制网络联合训练,让机器人能直接根据图像和语言指令输出动作。

三、 训练的核心挑战与解决方案

- 样本效率低(尤其是RL):在现实中收集大量数据不现实。

- 解决方案:仿真优先。先在高质量的模拟器中训练,再迁移到现实。

- 仿真到现实的差距:模拟器再逼真也与真实物理世界有差异。

- 解决方案:领域随机化、系统辨识、域适应。

- 奖励函数设计困难:设计出能精准反映任务目标且无副作用的奖励函数是一门艺术。

- 解决方案:结合模仿学习(提供初始演示)、逆强化学习(从演示中反推奖励函数)。

- 安全性:训练过程中机器人可能做出危险动作。

- 解决方案:在仿真中充分训练;在真实环境中设置安全约束、人工监管和急停机制。

四、 入门或体验

- 学习基础:

- 数学:线性代数、概率论、微积分。

- 编程:Python是绝对主流。

- 课程:推荐斯坦福CS223A(机器人学)、UC Berkeley CS285(深度强化学习)。

- 使用工具与框架:

- 仿真:PyBullet(易上手)、MuJoCo(学术界主流)、Isaac Sim(高性能,面向复杂仿真)。

- 机器人中间件:ROS/ROS2。

- 机器学习框架:PyTorch, TensorFlow。

- 强化学习库:Stable Baselines3, Ray RLLib。

- 从简单项目开始:

- 在PyBullet中训练一个机械臂到达指定位置。

- 用RL训练一个简单的四足机器人行走。

- 复现经典论文的仿真实验。

总结

现代机器人训练是一个仿真与真实交织、算法与工程并重的领域。其典型路径是:在高度随机化的虚拟世界中,通过强化学习等算法进行大规模“数字练兵”,再利用各种技术将习得的技能“迁移”到物理实体上,最终通过少量真实数据微调并安全部署。

DAMO开发者矩阵,由阿里巴巴达摩院和中国互联网协会联合发起,致力于探讨最前沿的技术趋势与应用成果,搭建高质量的交流与分享平台,推动技术创新与产业应用链接,围绕“人工智能与新型计算”构建开放共享的开发者生态。

更多推荐

已为社区贡献2条内容

已为社区贡献2条内容

所有评论(0)