RoboMIND 2.0:用于通用具身智能的多模态、双手移动操作数据集(上)

25年12月来自北京人形机器人创新中心和北大的论文“RoboMIND 2.0: A Multimodal, Bimanual Mobile Manipulation Dataset for Generalizable Embodied Intelligence”。尽管数据驱动的模仿学习已经彻底改变了机器人操作,但当前的方法仍然受到大规模、多样化真实世界演示数据匮乏的限制。因此,现有模型在长时程双臂

25年12月来自北京人形机器人创新中心和北大的论文“RoboMIND 2.0: A Multimodal, Bimanual Mobile Manipulation Dataset for Generalizable Embodied Intelligence”。

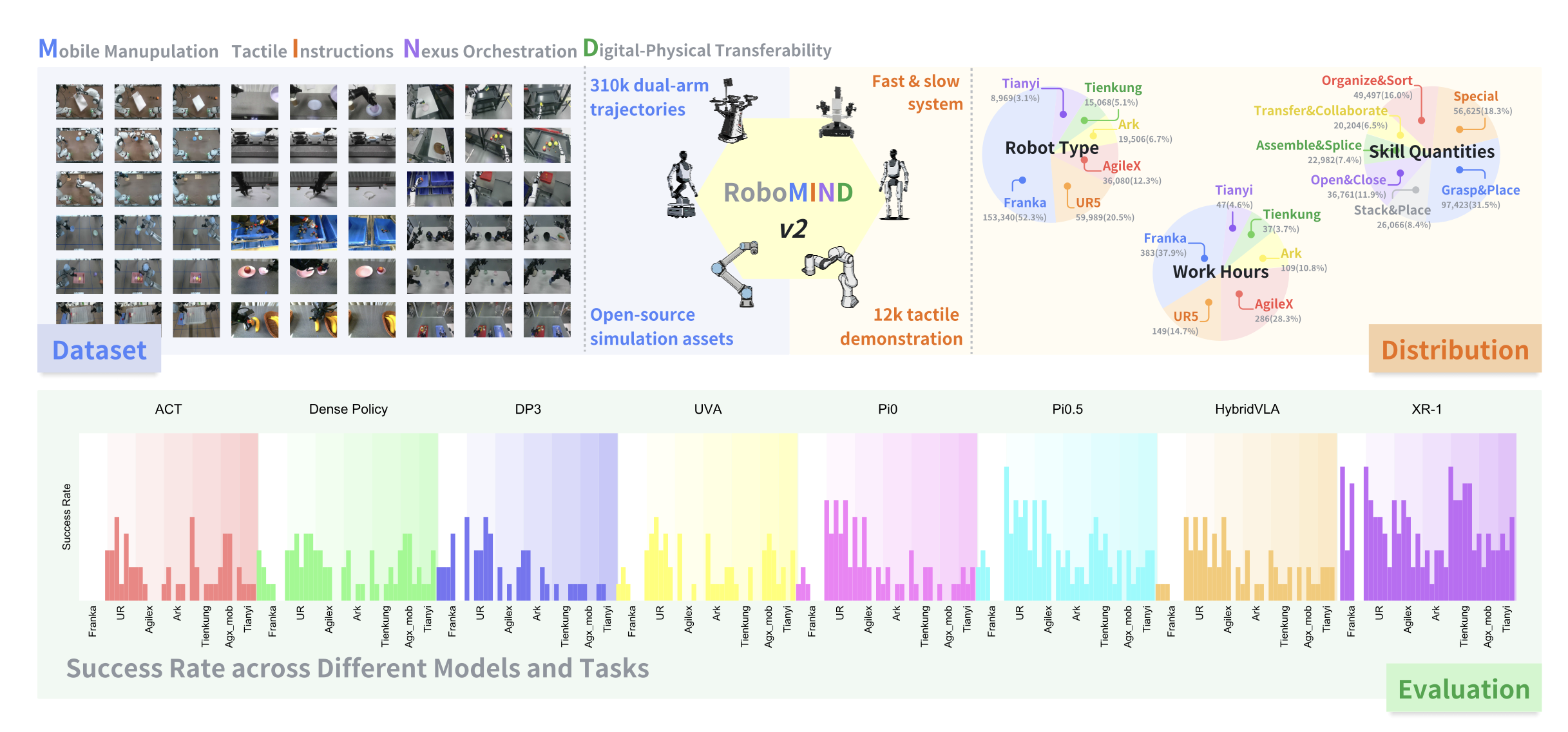

尽管数据驱动的模仿学习已经彻底改变了机器人操作,但当前的方法仍然受到大规模、多样化真实世界演示数据匮乏的限制。因此,现有模型在长时程双臂任务和非结构化环境下的移动操作方面的泛化能力仍然有限。为了弥补这一差距,RoboMIND 2.0是一个包含超过 31 万条双臂操作轨迹的综合真实世界数据集,这些轨迹采集自六种不同的机器人形态和 739 个复杂任务。至关重要的是,为了支持对接触丰富且空间扩展的任务的研究,该数据集包含了 1.2 万个触觉增强的实验片段和 2 万条移动操作轨迹。除了这些物理数据之外,还构建真实世界环境的高保真数字孪生模型,并发布一个包含 2 万条轨迹的模拟数据集,以促进稳健的仿真-到-真实迁移。为了充分发挥 RoboMIND 2.0 的潜力,提出 MIND-2 系统,这是一个通过离线强化学习优化的分层双-系统框架。MIND-2 集成了一个高级语义规划器 (MIND-2-VLM),用于将抽象的自然语言指令分解为具体的子目标;同时集成一个低级视觉-语言-动作执行器 (MIND-2-VLA),用于生成精确的、感知本体感觉的运动动作。对六种不同的机器人进行广泛的评估,验证数据集的有效性,并证明MIND-2系统显著优于四个单任务基线模型(涵盖二维图像和三维点云模态以及四种最先进的VLA模型)。此外,集成触觉模态能够显著提升精细操作任务的性能。最后,实验结果表明,在训练过程中混合真实数据和模拟数据能够持续提高物理执行性能,验证模拟基准的准确性以及合成数据增强的成本效益。

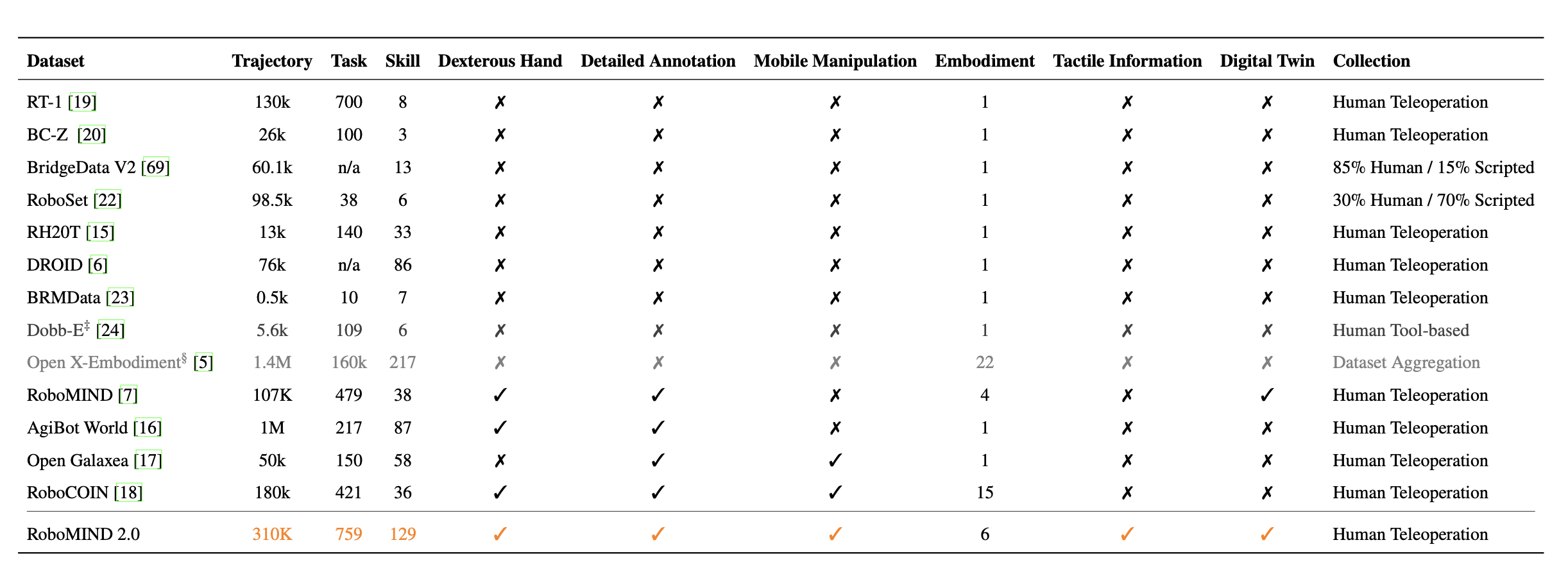

下表详细比较 RoboMIND 2.0 与一系列当代数据集(包括 RT-1 [19]、BC-Z [20]、BridgeData V2 [21]、RoboSet [22]、BRMData [23]、Dabb-E [24] 以及前面提到的 Open X-Embodiment [5]、AgiBot World [16] 和 RoboCOIN [18])在轨迹尺度、任务和技能多样性、具身配置、多模态感知、详细标注和仿真到真实对齐等关键维度上的表现。

RoboMIND 2.0,是一个包含约 31 万条双手动操作轨迹的综合性机器人操作数据集,这些轨迹来自 759 个操作任务,并采集自六个不同的机器人平台(例如 Franka [25]、UR5e [26]、AgileX [27]、ARX [28]、Tien Kung [29] 和 Tian Yi [30])。操作任务侧重于 129 项基本的机器人技能,涉及 1139 种不同的物体,其中包含约 9.7 万个常见“拾取和放置”操作示例(针对不同类型的物体)以及超过 5 万个交互式操作任务示例,例如切换、拖拽和工具使用(如图所示)。

在场景分布方面,数据集涵盖多种场景,包括客厅、卧室、厨房、超市和儿童房等家庭场景,以及物流分拣中心、生物实验室和工业装配线等工业环境,其中工业场景和家庭场景的比例大致相等。RoboMIND 2.0 汇集超过 1000 小时的操作经验,包括 12000 条带有触觉信息的双手动移动操作轨迹。至关重要的是,每条轨迹都标注详细的自然语言描述,从而能够进行语言引导的策略学习,并支持视觉-语言-动作 (VLA) 模型的多模态表征训练。

RoboMIND 2.0 数据集是一个高质量数据集,涵盖 129 种机器人操作技能,涉及家庭生活环境和工业环境中的各种场景。该数据集包含来自不同机器人配置的共计 31 万条双臂操作轨迹。这些配置包括使用 Franka [25] 和 UR5 [26] 机器人的类人双臂配置、诸如 Tian Yi [30]、AgileX [27] 和 ARX [28] 等轮式移动平台,以及人形机器人 Tien Kung [29]。在收集的数据中,29 万条轨迹涉及固定在桌面上的双臂协作操作,而 2 万条轨迹则包含工业和家庭环境中的移动双臂操作。该数据集涵盖厨房、卧室、客厅和书架等常见家庭场景中的任务,以及物流分拣、危险品检测和物理化学实验等工业应用。这些任务涉及超过 1139 个不同的操作对象,涵盖 129 种常见的机器人操作技能。

数据采集

RoboMIND 2.0 数据集涵盖多种机器人配置,包括人形双臂机器人(例如 Franka 和 UR5e)、固有双臂机器人(例如 ARX 和 AgileX)以及类人型机器人(例如Tien Kung和Tian Yi)。不同类型的机器人配备特定的远程操控设备用于采集机器人数据。

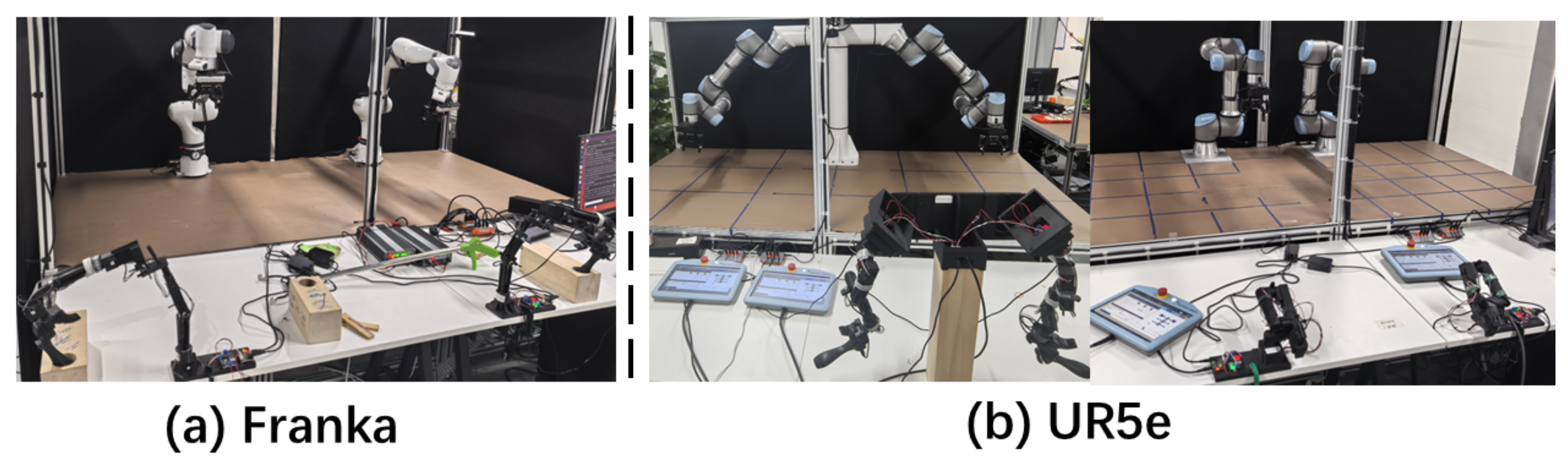

Franka 和 UR5e。如图所示,将两台 Franka 单臂机器人平行放置在桌面上,以采集双臂协作任务的数据。UR5e 双臂机器人则以两种不同的配置进行部署,以采集双手操作数据集:一种配置是将双臂平行放置在桌面上,另一种配置则采用更接近人类的双手操作方式。然后,使用 HACTS [132] 远程操作设备采集双臂 Franka 和 UR5e 机器人的数据集。HACTS 是一款低成本、轻量级的系统,包含硬件和软件两部分。硬件部分采用 Dynamixel 伺服电机(高负载关节使用 XL430-W250-T,夹爪和其他部件使用 XL330-M288-T)、3D 打印的 PLA 框架、12V/5A 电源和 WaveShare 伺服适配器——所有组件总价低于 300 美元——并支持运动学等效自适应。软件部分基于 DYNAMIXEL API 进行电机控制,通过偏移标定实现双向机器人-硬件同步,并允许使用脚踏板在自主模式和人机交互模式之间切换。HACTS 通过将从动臂的运动映射到主臂来实现运动控制。在数据采集过程中,操作人员通过控制两个独立的从动臂来执行双臂机器人操作任务。

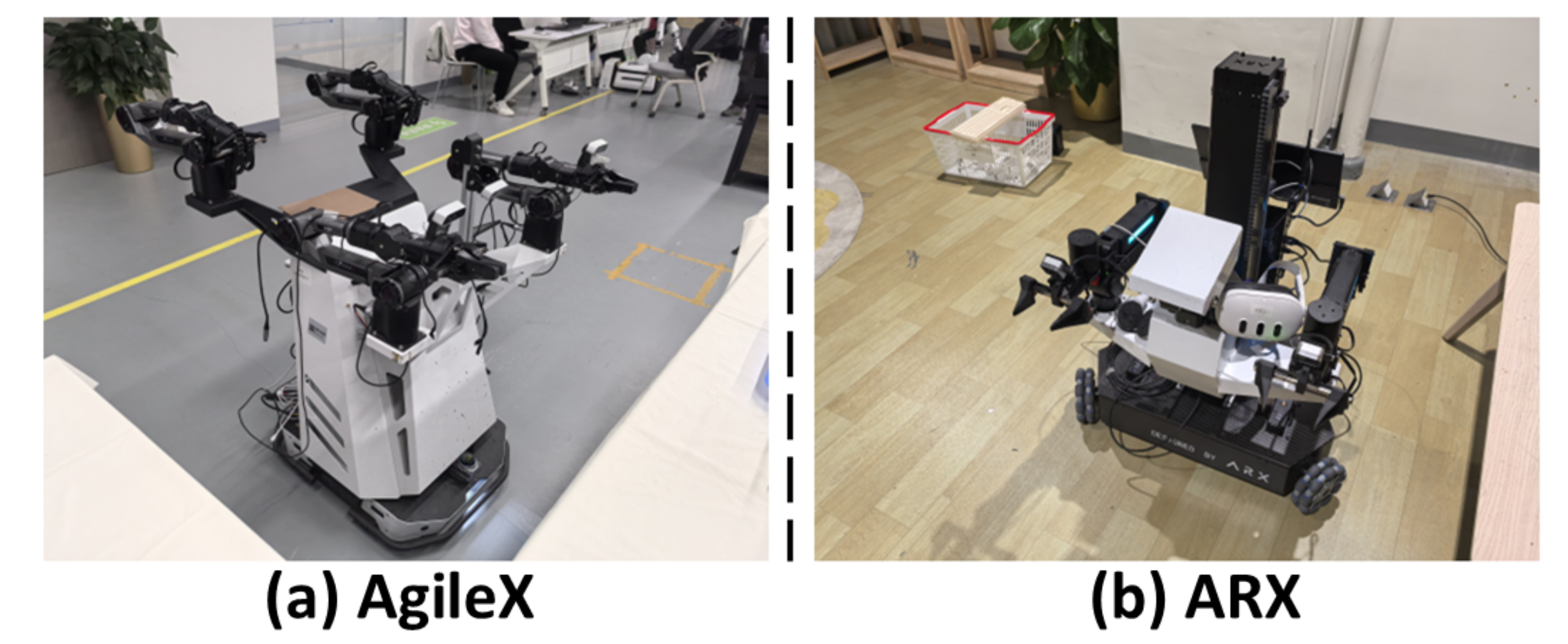

AgileX 和 ARX。对于 AgileX 机器人,我们直接利用类似于 Mobile ALOHA 系统的双边遥操作设备来采集数据集。如图显示采用的遥操作结构,该结构使用辅助机械臂来控制主机械臂。为了采集 AgileX 机器人的移动平台数据,在机器人运行过程中通过物理推动其底座来实时测量线速度和角速度。对于 ARX 机器人,用 VR 头显来捕捉人臂的运动,然后将记录的运动数据映射到双臂机器人上,以实现远程操作。对于 ARX 的移动操作数据,用 VR 控制器来控制移动底座的运动方向和速度。底座随后会相应地移动,并记录其实时运动轨迹,包括各种方向和速度。该图显示数据采集操作员佩戴 VR 头显远程操作 ARX 双臂机器人并采集双臂机器人任务的数据集。

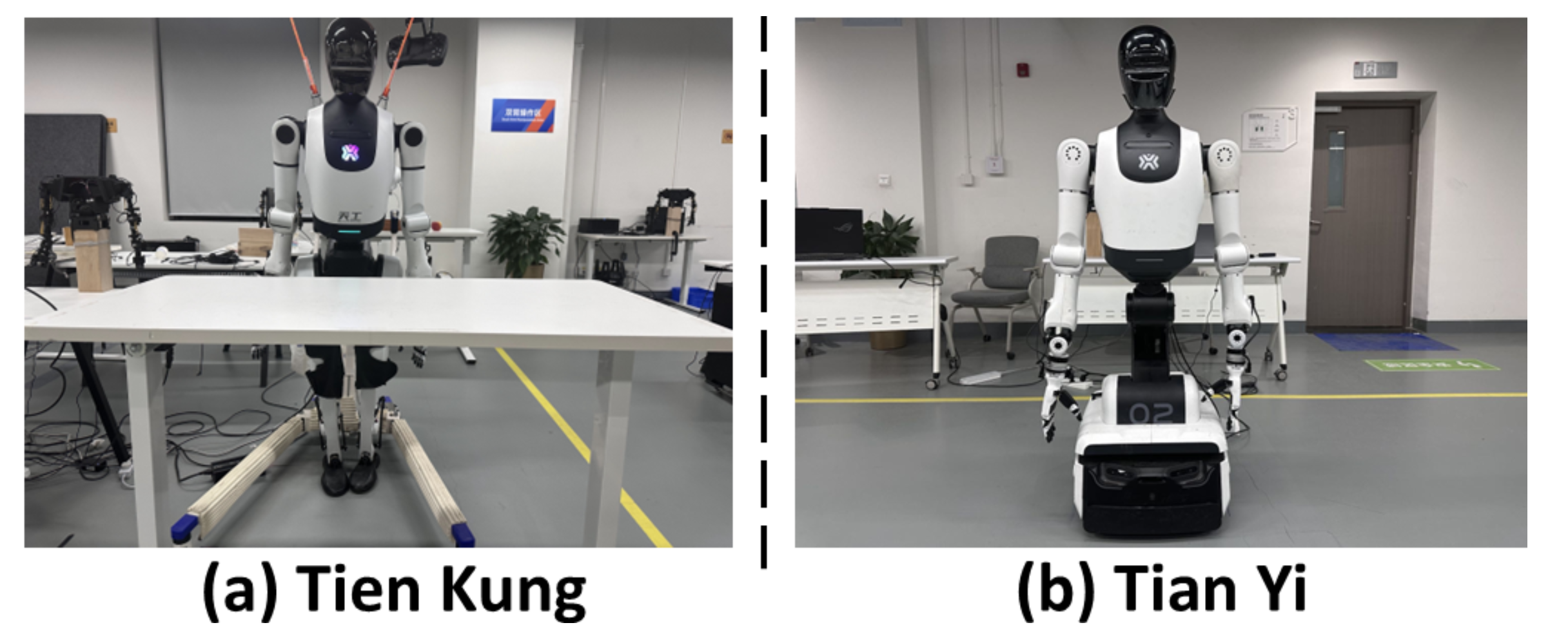

Tien Kung和Tian Yi。如图所示,Tien Kung机器人是一款人形双臂机器人。Tian Yi机器人拥有人形上半身和双臂,下半身则配备轮式底座以实现移动。对于人形机器人Tien Kung,数据采集者将穿戴动作捕捉服来记录关节运动,并将这些运动映射到机器人上,从而实现机器人操作。对于配备轮式底座的双臂移动机器人Tian Yi,使用两名操作员采集数据集。一名操作员使用HTACTS设备控制双臂操作,另一名操作员则通过物理推动机器人来采集移动数据,记录底座的角速度和线速度,从而捕捉机器人的运动动力学。

为了优化存储效率并便于数据集组织,将每条采集的轨迹(包括多视角RGB-D数据、机器人本体感觉状态信息、特定末端执行器状态信息以及远程操作主体状态信息)整合到一个HDF5格式文件中。对于来自RoboMIND 2.0的AgileX移动操作数据集,在HDF5文件中提供了左右机械臂的触觉信息。

数据检查

数据集中的所有数据均通过实时远程操作采集。由于操作员必须长时间持续控制双机器人,数据质量可能会受到疲劳、习惯不一致、短暂分心或外部干扰等自然人为因素的影响。为了缓解这些问题,采用轮班制,并提供舒适、低噪音的工作环境,以帮助操作员保持稳定可靠的操作性能。

在此基础上,实施集中式多阶段数据检查工作流程,旨在确保所有轨迹数据的一致性和高保真度。每天采集结束后,原始日志和视频会自动整理成结构化的每日报告。首先随机抽取一部分数据进行初步检查;如果发现问题,则会将其汇总成“每日问题报告”,并立即反馈给采集团队以便及时调整。剩余的轨迹数据将分配给专门的质量控制人员,由他们审查每个视频并标注所有异常情况。所有问题处理完毕后(无论是丢弃问题序列还是重新采集缺失数据),相应的会话将被标记为已验证,并发布供后续使用。

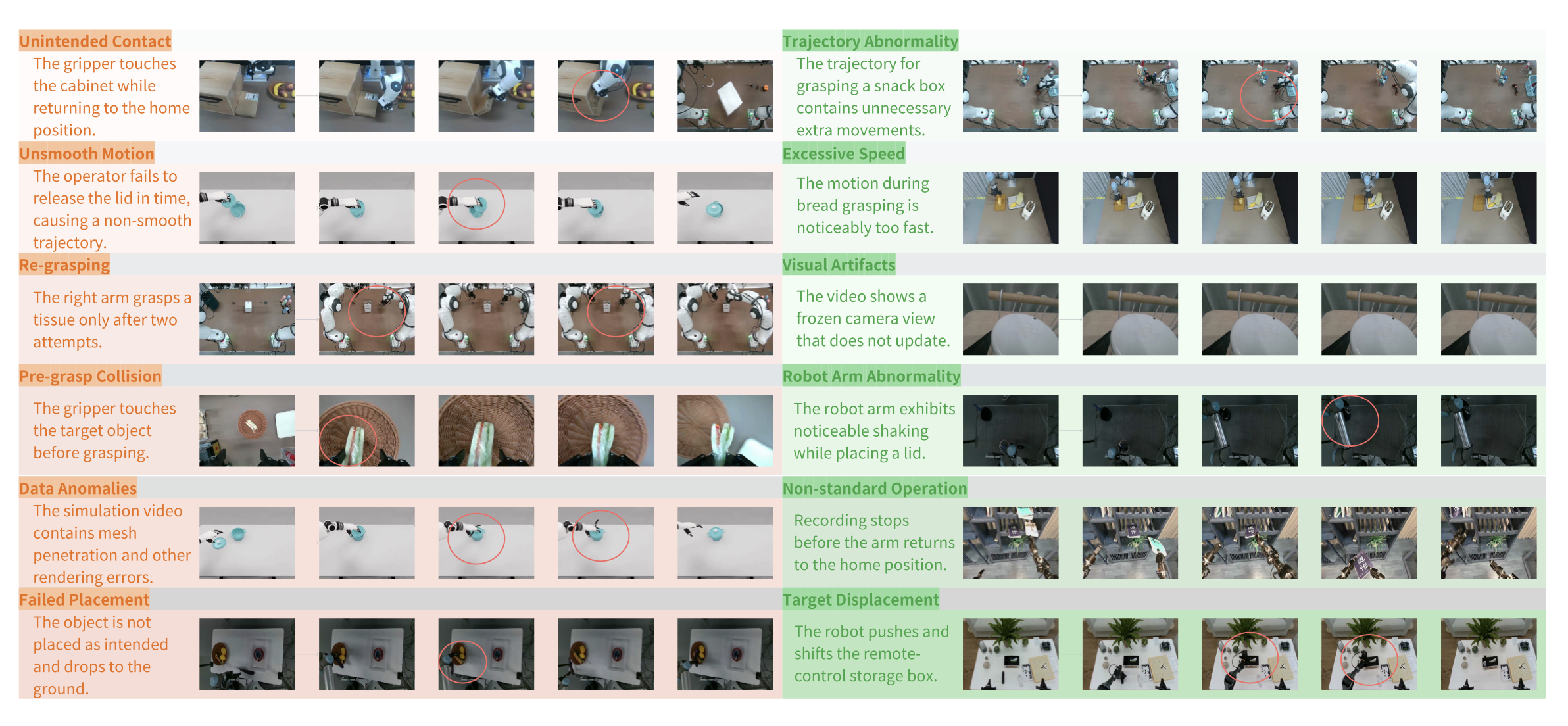

在详细检查过程中,每条轨迹都会根据十二项质量标准进行评估,每项标准都涵盖了远程操作演示中常见的故障模式。这些标准与图中的示例相对应,并正式定义如下:

非预期接触。

– 定义:与非目标物体发生非预期物理接触,导致记录轨迹出现干扰或污染。

– 表现:机械臂在日常运动或返回初始位置时接触周围结构,例如柜体或容器。

运动不流畅。

– 定义:由于操作员犹豫或缺乏协调而导致的不连续或顿挫运动,从而造成轨迹不规则或出现重复段。

– 表现形式:延迟释放、反复微调或运动阶段之间的突然转换。

重新抓取。

– 定义:首次尝试抓取物体失败,需要多次尝试,从而降低时间一致性。

– 表现形式:成功抓取物体前需要两次或两次以上的抓取尝试。

抓取前碰撞。

– 定义:在预期抓取之前与目标物体或附近障碍物发生不必要的碰撞,从而扰乱场景状态。

– 表现形式:机械臂在开始抓取之前撞到物体或相邻物体。

数据异常。

– 定义:感知或渲染损坏,包括丢帧、画面冻结或影响数据可用性的模拟伪影。

– 表现形式:播放卡顿、画面冻结或模拟环境中的网格穿透。

放置失败。

– 定义:由于未对准或释放不当,物体无法稳定或准确地放置在指定位置。

– 表现:物体坠落、倾斜或落在预定放置区域之外。

轨迹异常。

– 定义:与平滑、预期轨迹存在显著偏差,包括不必要的绕行或路径不规则。

– 表现:额外的环路、过度修正或末端执行器路径与任务意图不符。

速度过快。

– 定义:以不切实际的高速执行动作,降低控制精度和物理真实性。

– 表现:快速抓取或放置动作远超人类典型的远程操作速度。

视觉伪影。

– 定义:相机级别的失真或故障,例如闪烁、颜色偏移或视角冻结。

– 表现:持续的颜色异常或无法更新的静态视图。

机械臂异常

– 定义:机械或控制方面的异常导致机械臂行为不稳定,包括抖动或振荡。

– 表现:在操作或放置过程中出现可见的振动或不稳定性。

非标准操作

– 定义:违反演示协议,特别是未能返回初始姿态并在终止前短暂暂停。

– 表现:在到达初始姿态之前停止录制,或暂停时间过短或过长。

目标位移

– 定义:预期保持静止的物体发生意外移动,由意外碰撞引起。

– 表现:机器人无意中推动或移动物品,例如箱子、盒子或容器。

对于每项违规行为,检查员都会记录精确的时间戳和简短的文字描述。这些注释有助于数据筛选,并识别系统性问题——例如,反复出现的抓取前碰撞表明夹爪对准不良,或反复出现的超速违规表明操作员过度补偿。为了在轨迹层面落实这些标准,并使流程可重复,将检查协议正式化为一个三阶段工作流程:

• 初步检查:快速扫描视频,检测主要技术问题,例如丢帧或画面冻结。

• 详细检查:逐帧或慢动作回放视频,识别上述十二种故障模式中的任何一种。

• 数据筛选和问题记录:记录所有不合规数据的时间戳和描述,并对每个序列进行分类,以便丢弃、纠正或重新采集。

在筛选掉低质量轨迹或标志为需要重新采集后,必须以保留任务语义并便于后续分析的方式组织剩余数据。

数据标注

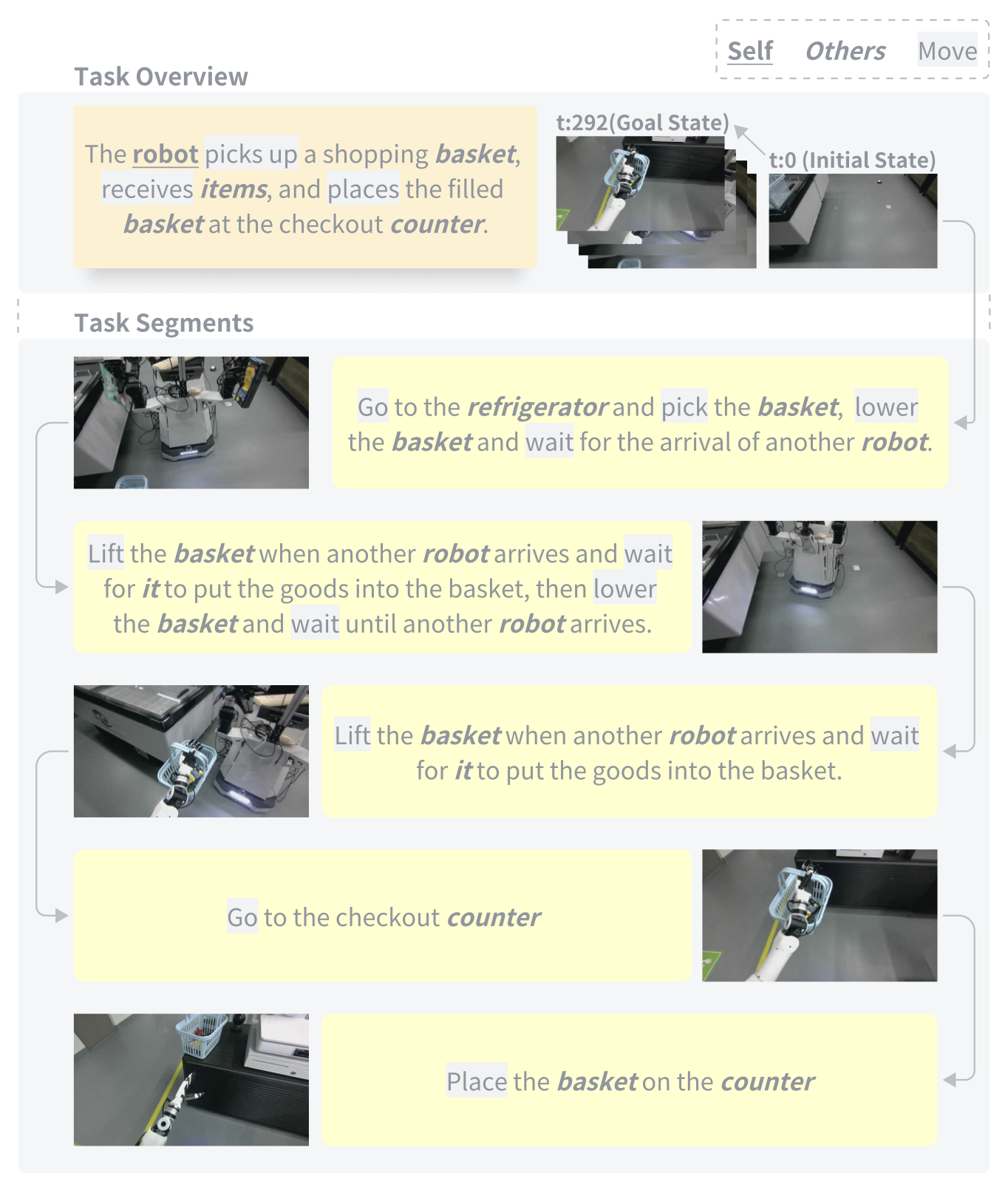

虽然可以直接从采集的视频和轨迹中提取视觉和机器人本体感觉信息,但需要提供更丰富的语义信息来辅助模型训练。对于每个采集的移动操作任务,为任务的每个阶段提供详细的自然语言标注。在快-慢系统中,首先根据阶段级语言描述将长时程移动操作任务数据集分割成特定阶段的子任务。这些分割后的数据集及其对应的语言指令用于训练快速VLA系统。慢速VLM系统则监控任务进度,并通过生成或触发下一个高级语言指令来确定阶段切换的时机。这种层级协作使机器人能够成功执行复杂的长时程操作任务。

本文对长时程操作任务中包含的每个成功的机器人运动轨迹进行标注。在将长时域机器人任务分割成子任务时,本文采用一种基于语义动作的划分准则:导航和操作之间的转换作为子动作分割的边界。具体而言,导航动作被定义为“前往[位置]”或“在[物体]前停止”,而发生在两个连续导航动作之间的所有操作动作则被归类为一个连贯的操作序列,并合并成一个子任务单元。

这种分割策略遵循任务执行的时空连贯性和语义完整性,确保每个子任务都具有清晰的功能目标。所有标注均使用大型语言模型 Gemini 2.5 Pro [133] 自动生成,利用其强大的上下文理解和推理能力对原始动作序列进行语义解析和结构化标注,从而实现高效、一致且语义准确的子任务分解。然后,将这些标注结果作为示例,指导 Gemini 基于此参考模式进行标注。

这一严谨的流程提高所采集轨迹的语言标注的精确度和可靠性。如图展示Tian Yi在双机器人协作场景中执行的任务的语言标注。该任务涉及 AgileX 双臂机器人从超市货架上拾取香蕉和辣椒,移动并将它们放入Tian Yi的购物篮中,最后将装满的购物篮运送到收银台付款。每个动作步骤都与相应的图像帧配对,并标注“自身”、“他人”和“移动”等动作类型,为分层视觉-语言-动作(VLA)模型学习提供清晰的多模态基础。该标注方案能够准确地分割视频中的关键动作,并提供这些关键动作的精确语言描述。这些详细的标注将长时程任务分解为简单的短时程机器人操作,每个操作都配有精确的自然语言描述。这种结构化的监督使 VLA(视觉-语言-动作)模型(如 RT-H [19]、OpenVLA [1]、RDT-1B [4]、𝜋0 [2]、𝜋0.5 [3] 和 XR-1 [13])能够以可扩展和可解释的方式,通过协调感知输入、语言指令和低级动作来学习基本的操作技能。

尽管许多大规模机器人操作数据集[5, 6, 18]声称具有“多样性”,但多样性的真正价值在于其涵盖的维度,以及这些维度在多大程度上反映现实世界的变化。不同的维度——例如任务、物体、场景、视角和交互位置——会以不同的方式影响模型的泛化能力。为了严格评估 RoboMIND 2.0,从五个基础维度(具身、任务、物体、信息和仿真)评估其多样性,并将其与现有基准进行比较。

具身多样性

该数据集的一个显著特征是其系统且精细的具身多样性,涵盖六个不同的双臂机器人平台,并在四个关键维度上引入了显著的变异性:运动结构、移动性、感知布局和远程操作模式。现有的大规模操作数据集主要由单臂平台或在异构协议下采集的同质化模型构成,而本文数据集提供一个统一的跨模型采集流程,在保持数据一致性的同时,也捕捉到了丰富的形态异质性。

运动学结构多样性。同时纳入对称和非对称的双臂配置。Franka 和 UR5e 机器人采用并联布局,形成运动学对称的布局,两个机械臂的可达工作空间和关节拓扑结构几乎相同。这种配置为学习双边协调模式(例如物体传递、对称推拉和协同抓取)提供了清晰的监督信息。相比之下,人形 UR5e 配置——其中两个机械臂的肩部偏移量、关节零位和工作空间几何形状各不相同——引入了明显的结构不对称性,这对跨臂泛化提出了挑战。Tien Kung/Tian-Yi机器人进一步扩展这一维度,它拥有完整的人形上半身形态,同时仍然使用并联夹爪作为末端执行器,并具有类似人类的肩部位置和独特的连杆几何结构。

移动性和工作空间多样性。该数据集涵盖静态双臂操作和移动双臂操作。静态机器人(Franka、UR5e 和固定模式的Tien-Kung)在有限的桌面工作空间内运行,能够实现高精度操作和精细的双手协调。相比之下,AgileX Cobot Magic、ARX 和Tian-Yi机器人将双臂与移动底座集成在一起,引入大规模、动态和空间多变的交互。随着底座的移动,机器人与物体之间的关系不断演变,从而产生将长距离导航与厨房、超市和工业环境中的操作相结合的轨迹。这一维度极大地扩展机器人探索的具身空间,并提供了学习移动操作的关键数据。

感知和传感器布局的多样性。尽管采用统一的输出格式,但底层感知硬件却表现出相当大的差异:包括 RealSense D435i、Orbbec Gemini 335、Orbbec Astra、环境安装式 RGB-D 相机、头戴式传感器以及腕戴式近距离深度传感器。这些不同的视场角、基线、固有参数和安装姿态,为数据集增添跨视角和跨模态的感知异质性。通过将所有视觉数据归一化为一致的多视角 RGB-D 表示,该数据集使模型能够在异构视觉配置下学习视角不变的感知和鲁棒的推理能力。

远程操作模式的多样性。为了进一步丰富演示内容,其采用三种互补的人机交互控制界面。 (i) Franka、UR5e 和 Tien Kung 采用 HACTS 主从系统,实现高保真双边控制和精确的关节空间映射。(ii) ARX 采用基于 VR 的远程操作流程,通过头戴式显示器捕捉上半身手臂的运动,并通过 VR 控制器控制移动底座,从而支持大空间双手操作任务。(iii) AgileX 和 Tian Yi 采用物理引导,操作员直接推动机器人时记录移动底座的线速度和角速度,从而实现高度自然的导航行为。这些互补的模式共同生成多种风格的演示,捕捉人类控制策略、时间节奏和交互偏好的差异。

异构运动结构、不同的移动能力、多样化的传感器布局和多模态远程操作界面相结合,生成了前所未有的具身覆盖数据集。这种多样性对于训练能够跨越不同机器人形态、适应不一致的感知观测结果并在静态和移动环境中执行长时程任务的通用操作策略至关重要。

任务多样性

RoboMIND 2.0 展现出高度结构化且多维的任务多样性,涵盖总共 759 个双臂操作任务,这些任务系统地组织在两种主要交互场景中:固定场景操作和移动场景操作。所有任务都涉及双手协调,但环境的空间结构——无论是在固定工作站操作还是在更大的非结构化空间中导航——都引入截然不同的感知-动作耦合形式和任务复杂性。固定场景任务强调精确的物体交互、桌面协调和结构化的空间约束,而移动场景任务则需要双臂操作与空间重定位、长距离导航和动态视角适应交织进行。

任务多样性的一个核心维度来自操作技能。在整个数据集中,任务可分解为七大技能家族——抓取和放置、特殊动作操作、组织和分类行为、迁移和协作、组装和拼接、开合操作以及堆叠放置程序——其经验分布揭示数据集的功能广度。抓取和放置任务占比最大(超过9.7万个片段),其次是特殊动作任务(超过5.6万个片段)、组织和分类行为(超过4.9万个片段)、开合操作(超过3.6万个片段)、堆叠放置任务(超过2.6万个片段)、组装和拼接行为(超过2.2万个片段)以及迁移和协作任务(超过2万个片段)。高频基础技能与低频、结构复杂的技能并存,确保操作策略必须学习短期基本动作和长期多步骤协调策略。

任务的多样性因任务在不同机器人上的分布而进一步丰富。由于形态、工作空间几何结构、机器人形态限制和首选部署场景的不同,不同的机器人贡献不同的任务类型。例如,Franka 贡献最多的任务(224 个任务,超过 15.3 万个回合),累计工作时长达 383 小时,这体现其在高精度、精细的桌面双臂操作方面的优势。UR5 贡献 162 个任务和 149 小时的工作时长,其特点是双臂运动范围更广、工作空间覆盖范围更广。AgileX 在固定和移动场景中贡献了 143 个任务和 286 小时的工作时长,展现其在大规模、依赖导航的双臂任务中的作用。ARX 贡献 75 个任务和 109 小时的工作时长,通常涉及利用虚拟现实技术演示空间扩展行为。尽管田功和田义贡献的任务数量较少(分别为 49 项和 46 项),但他们引入受人类启发的上肢运动学和基于移动平台的双臂协调,从而增加形态多样性以及需要精细推理或跨空间协作的任务类型。

RoboMIND 2.0 通过一系列数字孪生配对仿真任务进一步丰富其任务多样性。每个仿真任务都直接对应于现实世界中的一个双臂任务,共享相同的几何形状、物体排列和任务规范。这种一对一的对应关系提供了同一任务的另一种表示形式,有效地使每个任务能够以物理和数字两种形式呈现。数字孪生任务通过引入语义相同但执行条件不同的受控任务变体来扩展任务多样性。这 60 个固定场景的数字孪生任务(18000 个回合)通过提供可复现的、几何一致的任务实例来补充大规模的真实世界数据集,从而拓宽 RoboMIND 2.0 的整体任务空间。

总体而言,RoboMIND 2.0 的任务多样性源于技能多样性、环境结构、机器人具身性、时间尺度以及混合真实-仿真-数字孪生数据之间的相互作用。这种多样性为训练具身智体提供强大的基础,使其能够适应不同的任务、场景和形态,并支持对跨任务泛化、长时程推理和鲁棒的开放世界操作进行深入研究。

物体多样性

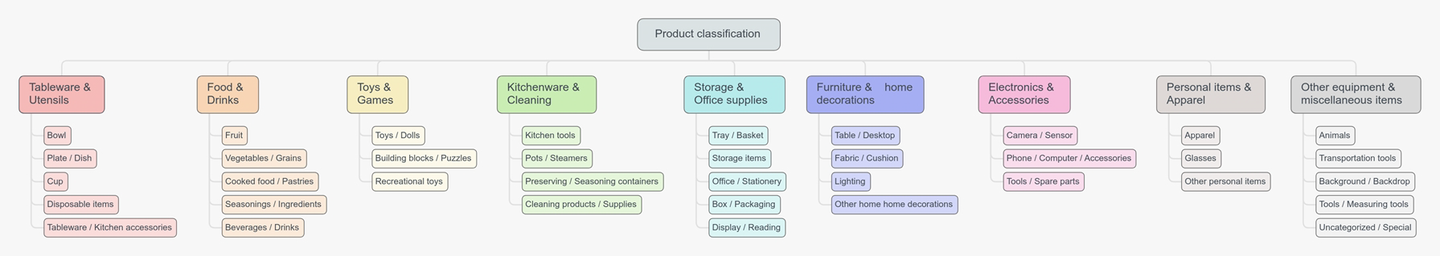

数据集包含涉及 1139 个不同物体的操作任务,就交互物体的数量而言,它是迄今为止公开可用且统一收集的机器人操作数据集。如图展示支撑数据集的全面产品类别分类体系,该体系将物体精心组织成六大类——食品、日用品、厨具、文具、玩具和其他——每个类别又进一步细分为更细粒度的子类别(例如,水果、零食、清洁用品、炊具、书写工具、益智玩具等)。该物体清单的广度和细粒度反映了前所未有的真实世界覆盖范围,涵盖了从日常家居用品到专用工业工具的各种物品,并且包含类别内部显著的视觉和几何差异(例如,多种类型的瓶子、容器或餐具)。

该数据集展现广泛且系统化的物体多样性,这对于将模型推广到未见过的物体和新的交互情境至关重要。该数据集并非仅限于桌面物品,而是涵盖来自各种真实世界环境的物体,包括家庭桌面、厨房工作区、儿童房、超市收银台和货架区、研究实验室、物流和包装站、存储环境以及以门为中心的交互区域。这些场景在视觉外观、空间布局、功能角色和情境方面的差异,进一步放大物体与任务关系的异质性。

这种物体多样性的一个显著特征不仅在于物体的视觉或物理属性,还在于它们所参与的各种操作类型。在整个数据集中,物体参与七大类操作:抓取和放置、特殊动作操作、组织和分类行为、转移和协作任务、组装和拼接行为、开合操作以及堆叠和放置程序。这些类别涵盖一系列交互意图,从基本的抓取和放置技能到多阶段重组、协作运输、铰接式物体交互以及结构化组装过程。

由于大多数物体出现在多种操作类型中,而非单一的刻板模式,因此该数据集捕捉到现实世界交互的组合性和情境依赖性。同一个物体可能被抓取在桌面上,在儿童房内进行分类,在家庭环境中搬运穿过房间,在实验室环境中与其他组件组装,在存储或物流站的整理任务中堆叠,或者用于需要打开、关闭或空间转换的门相关操作。这种丰富的跨情境重用导致了物体属性、环境设置和操作行为之间高维的联合分布。

总而言之,多样化的物体、多场景部署以及七种结构化操作类别的完整谱系,为研究具身智体的跨物体泛化、情境相关的操作策略以及稳健的开放世界性能奠定基础。

信息多样性

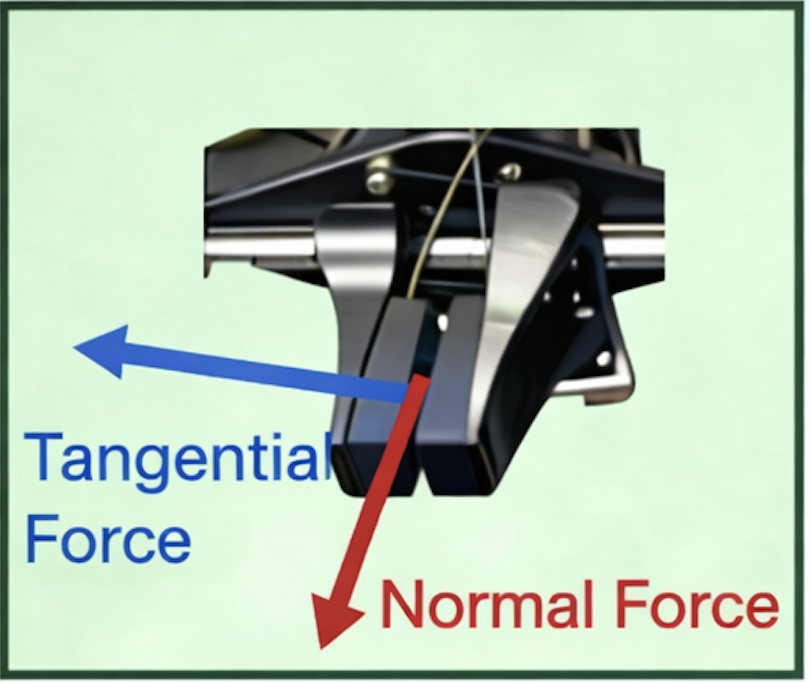

目前,大多数公开数据集仅提供视觉观测和本体感觉(机器人具身感知)状态,主要用于训练模仿学习和强化学习算法。然而,随着机器人学习研究的进展,研究人员越来越多地将触觉模态融入机器人学习框架[134-136],显著提高机器人执行真实世界操作任务的成功率。在RoboMIND 2.0中,不仅记录任务执行过程中的视觉观测和机器人本体感觉状态,还使用Tashan触觉传感器[137]在机器人执行远距离移动操作任务时收集触觉信息。触觉传感器记录机械臂执行任务期间作用于物体的切向力、法向力和法向力的方向。如图展示AgileX移动机械臂的末端执行器配置,该机械臂配备一个平行爪夹爪,并在每个手指上集成一个高分辨率触觉传感器。每个触觉传感器包含两个独立的传感模块,每个模块实时采集三个关键物理量:法向力(垂直于接触面)、切向力(平行于接触面)以及切向力的方向(编码为传感器平面内的角度)。这种丰富的多模态触觉反馈能够实现对接触几何形状、滑动检测和交互动态的精细感知——这些能力对于在非结构化环境中进行灵巧操作至关重要。

仿真多样性

与现有仅发布真实机器人数据集的开源机器人数据集[5, 6, 17, 18]不同,该数据集还提供数据集中所有对象的仿真资源,并将其集成到Isaac Sim中,从而实现仿真数据采集。遵循ArtVIP[138]的模式,聘请专业的3D建模师按照统一的标准创建仿真资源。具体而言,数据集中的每个关节对象都分为三个层级:组件 – 模块 – 网格。在基座中心定义一个统一的坐标系,并自下而上地组装各个部件,集成关节以实现动态运动,并添加像素级交互标签来标记交互区域。为了获得视觉真实感,用具有光滑表面和高分辨率纹理的高质量流形网格,这些纹理与UV贴图对齐。对象在Isaac Sim中使用基于RTX的物理渲染(PBR)进行渲染,以获得逼真的材质外观。为了保证物理精度,结合凸包、凸分解和精细的碰撞网格。还通过添加位置相关的刚度和速度相关的摩擦力来改进 Isaac Sim 的关节动力学——并通过 0.1 毫米精度的光学运动捕捉进行验证。

然后,将这些参数导入 Isaac Sim 仿真器,并使用它们在双臂 Franka 和 Tien Kung 机器人上采集 2 万条模拟轨迹,执行与真实世界数据集相同的任务。在实验中,用结合真实轨迹和模拟轨迹的混合数据集来训练模仿学习模型,与仅使用真实数据进行训练相比,该混合数据集能够持续提升真实世界机器人的性能。这不仅验证数字孪生模型的高保真度,也表明低成本的仿真数据可以有效地补充稀缺的真实世界演示数据,从而增强策略的鲁棒性和泛化能力。因此,工作强调了仿真不仅可以作为一种便捷的替代方法,而且是可扩展机器人学习中必不可少且经济高效的引擎。

。。。。。。待续。。。。。。

DAMO开发者矩阵,由阿里巴巴达摩院和中国互联网协会联合发起,致力于探讨最前沿的技术趋势与应用成果,搭建高质量的交流与分享平台,推动技术创新与产业应用链接,围绕“人工智能与新型计算”构建开放共享的开发者生态。

更多推荐

已为社区贡献169条内容

已为社区贡献169条内容

所有评论(0)