超详细保姆级Ubuntu 24.04 LTS+RTX4090部署AI环境(CUDA、TensorRT、Pytorch、torchnvjpeg、torch2trt、pycuda)

项目依赖安装:后续安装巡检机器人项目的其他依赖(如 OpenCV、MMDetection 等),建议继续使用 python -m pip install [包名] 命令,确保依赖安装在当前 conda 环境中;python 确实在 conda 环境里,但 pip 还是指向了系统用户目录下的版本(/home/ubuntu/.local/bin/pip),所以才会触发 “外部管理环境” 的保护。至此,

环境安装

下面教程是完整的环境安装流程,采用Ubuntu 24.04LTS桌面版

一、Ubuntu基础配置

1、更新系统apt数据源

Ubuntu24.04已经把软件源配置改了新格式Ubuntu sources have moved to /etc/apt/sources.list.d/ubuntu.sources

先执行

sudo sed -i "s@http://.*archive.ubuntu.com@https://mirrors.tuna.tsinghua.edu.cn@g" /etc/apt/sources.list.d/ubuntu.sources

然后再执行

sudo apt update && sudo apt upgrade -y

2、安装ssh、ifcnofnig、screen、htop、nvidia-cuda-toolkit等

sudo apt install -y openssh-server net-tools screen htop gcc g++ make -y

3、安装pip3

sudo apt install python3-pip -y

pip3 install -U pip

pip3 config set global.index-url https://pypi.tuna.tsinghua.edu.cn/simple

重新执行「升级 pip」的命令(加上系统允许的临时参数)

pip3 install -U pip --break-system-packages

将路径添加到系统 PATH

echo 'export PATH="/home/ubuntu/.local/bin:$PATH"' >> ~/.bashrc

source ~/.bashrc

4、安装torch CUDA 11.8

安装 RTX4090 适配的 NVIDIA 驱动(对应 CUDA11.8)

# 1. 禁用开源nouveau驱动(必做,否则驱动安装失败)

sudo tee /etc/modprobe.d/blacklist-nouveau.conf <<EOF

blacklist nouveau

options nouveau modeset=0

EOF

sudo update-initramfs -u

# 2. 安装适配CUDA11.8的驱动版本(520+版本)

sudo apt install nvidia-driver-525 -y

# 3. 重启服务器使驱动生效

sudo reboot

4.安装系统级 CUDA 12.2(适配当前驱动)

# 1. 下载CUDA 12.2安装包

wget https://developer.download.nvidia.com/compute/cuda/12.2.0/local_installers/cuda_12.2.0_535.54.03_linux.run

# 2. 执行安装(取消勾选Driver,已装驱动)

sudo sh cuda_12.2.0_535.54.03_linux.run

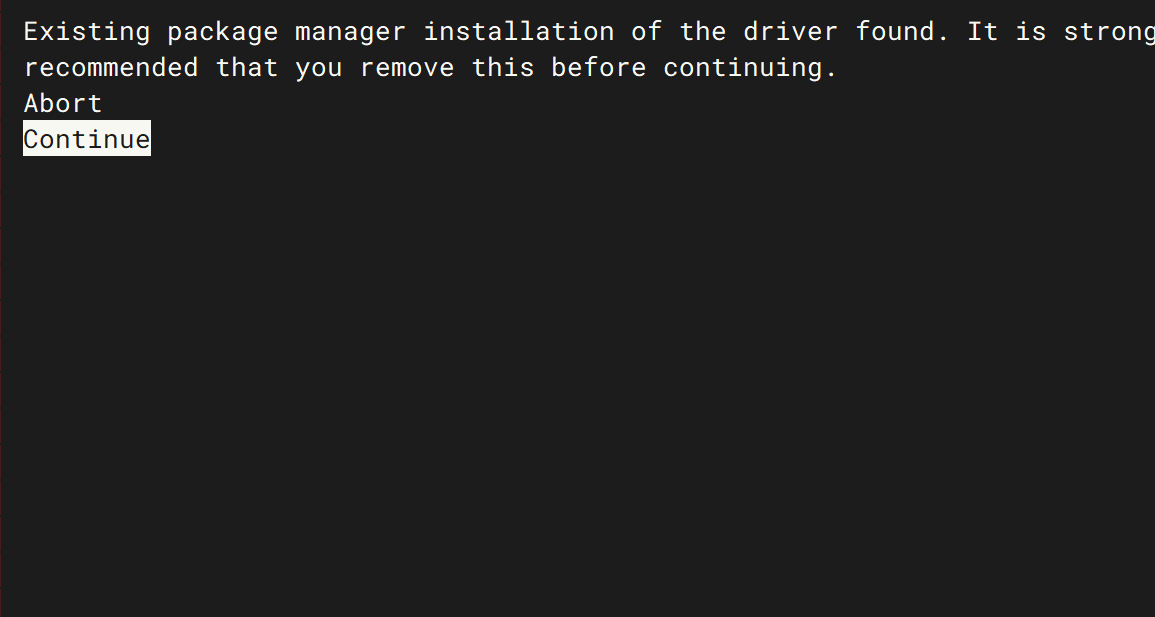

等待一会选择continue

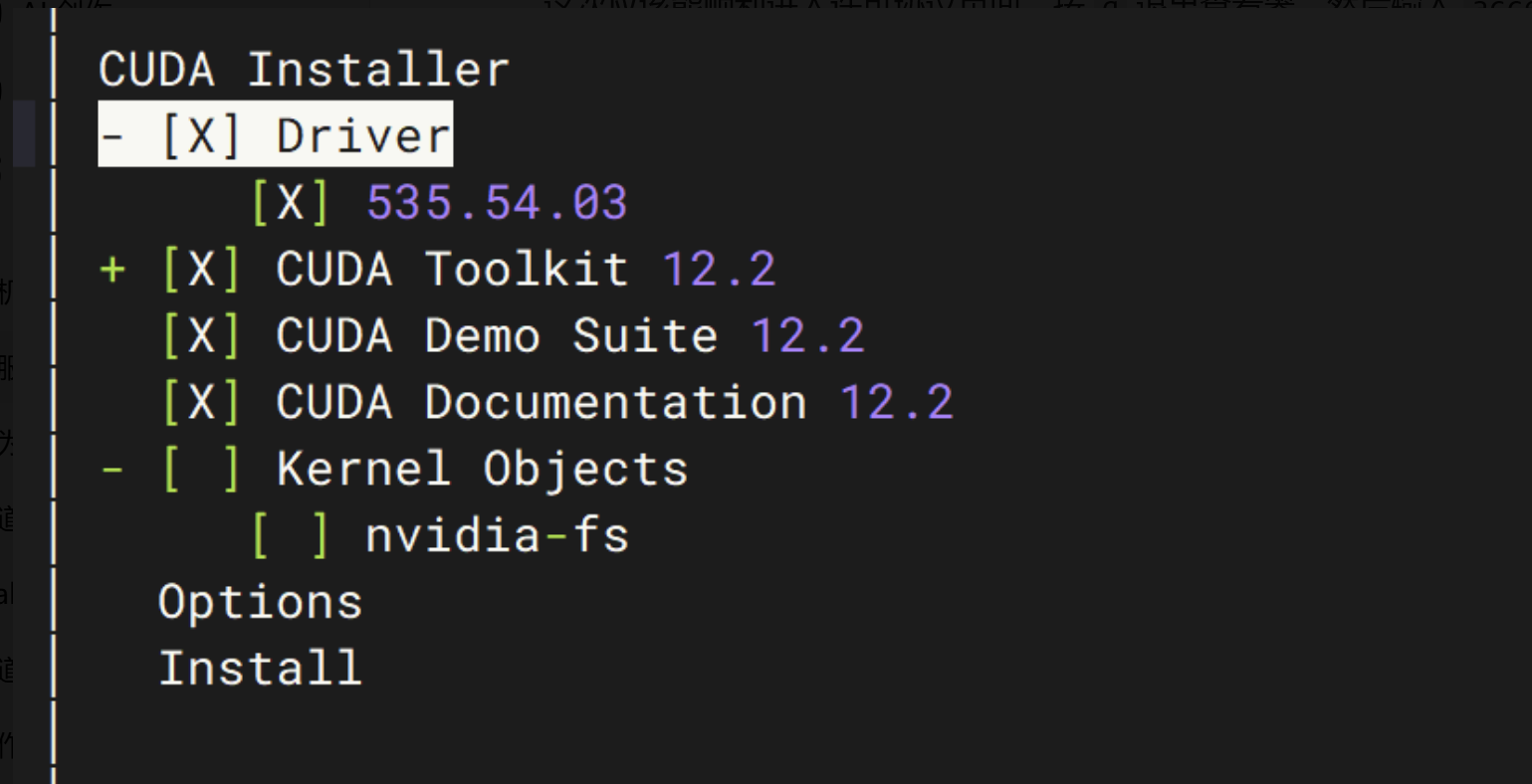

这一步需要按空格取消Driver的选择,避免驱动覆盖,之后直接选择Install

CUDA Toolkit 已经成功安装到 /usr/local/cuda-12.2/ 目录下

第一步:配置环境变量

在终端中执行以下命令,将 CUDA 的路径添加到系统环境变量中:

echo 'export PATH=/usr/local/cuda-12.2/bin:$PATH' >> ~/.bashrc

echo 'export LD_LIBRARY_PATH=/usr/local/cuda-12.2/lib64:$LD_LIBRARY_PATH' >> ~/.bashrc

source ~/.bashrc

第二步:验证 CUDA 安装成功

执行以下命令,检查 CUDA 版本:

nvcc -V

如果输出类似下面的信息,就说明 CUDA 已经配置好了:

nvcc: NVIDIA (R) Cuda compiler driver

Copyright (c) 2005-2023 NVIDIA Corporation

Built on Tue_Jun_13_07:18:24_PDT_2023

Cuda compilation tools, release 12.2, V12.2.91

Build cuda_12.2.r12.2/compiler.32965470_0

第三步:安装 PyTorch GPU 版

现在我们来安装与 CUDA 12.2 配套的 PyTorch:

创建虚拟环境(适配 Ubuntu 24.04 + CUDA 12.2 + 双 4090)

# 1. 下载Miniconda安装包

wget https://mirrors.tuna.tsinghua.edu.cn/anaconda/miniconda/Miniconda3-latest-Linux-x86_64.sh

# 2. 运行安装脚本(一路按回车,遇到"Do you accept the license?"输入yes;最后问是否初始化conda,选yes)

bash Miniconda3-latest-Linux-x86_64.sh

# 3. 让conda命令立即生效(不用重启终端)

source ~/.bashrc

# 4. 验证conda安装成功(输出conda版本号即成功)

conda --version

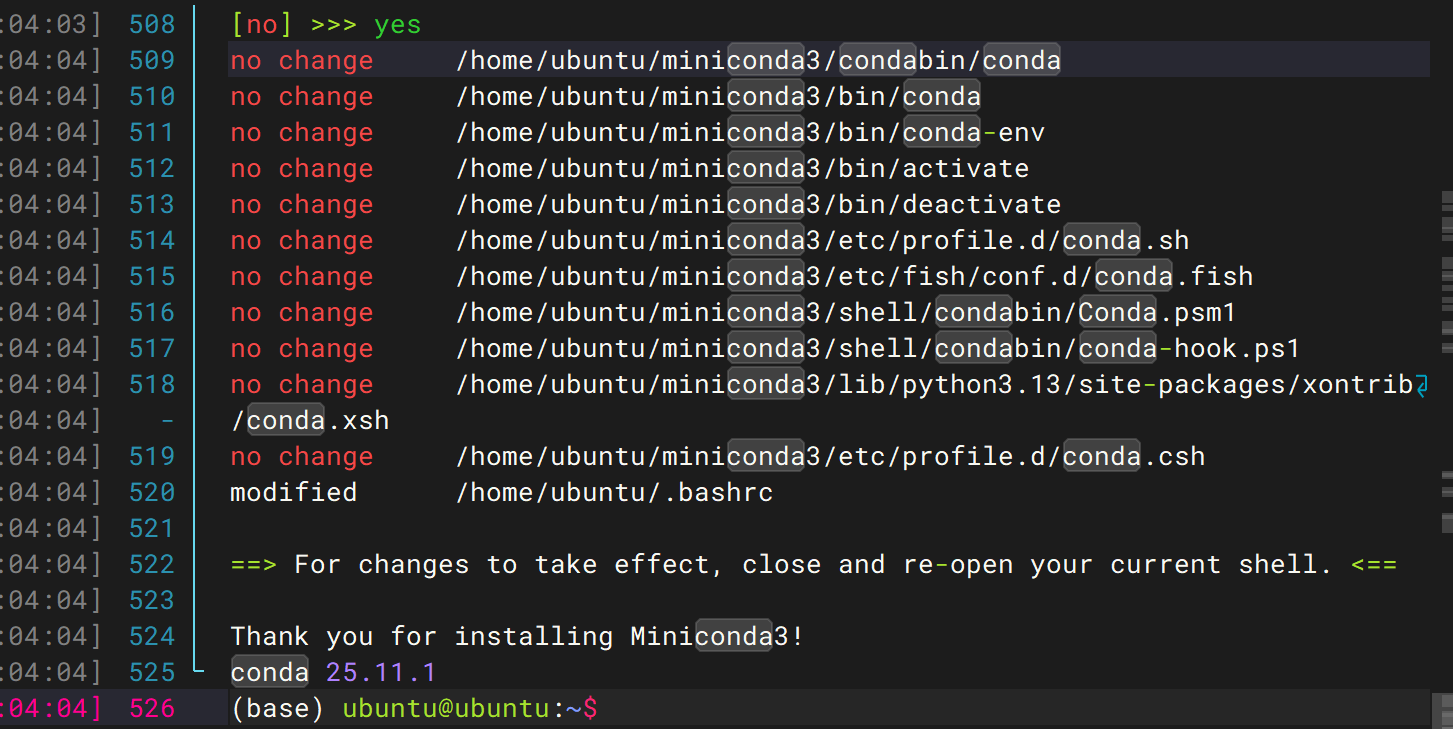

这是miniconda安装成功

创建一个专属的虚拟环境来安装 PyTorch

conda create -n ai_dev python=3.10 -y

直接接受条款

conda tos accept --override-channels --channel https://repo.anaconda.com/pkgs/main

conda tos accept --override-channels --channel https://repo.anaconda.com/pkgs/r

再次创建虚拟环境

conda create -n ai_dev python=3.10 -y

环境创建成功后,继续执行以下步骤:

激活环境:

conda activate ai_dev

安装适配 CUDA 12.2 的 PyTorch:

在激活 ai_dev 环境后,执行以下命令,确保使用的是环境内的 pip:

# 方法1:直接用环境内的 Python 调用 pip

python -m pip install torch torchvision torchaudio --index-url https://download.pytorch.org/whl/cu121

# 方法2:如果方法1还是报错,加上 --break-system-packages 参数(仅在conda环境内使用)

python -m pip install torch torchvision torchaudio --index-url https://download.pytorch.org/whl/cu121 --break-system-packages

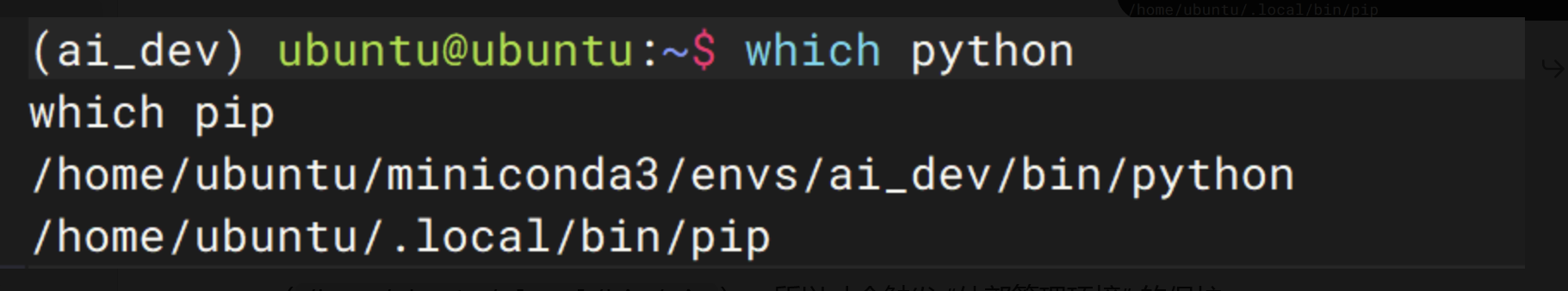

验证一下环境是否真的激活了

先执行下面的命令,确认当前的 Python 和 pip 都来自 ai_dev 环境:

which python

which pip

python 确实在 conda 环境里,但 pip 还是指向了系统用户目录下的版本(/home/ubuntu/.local/bin/pip),所以才会触发 “外部管理环境” 的保护。

python -m pip install torch torchvision torchaudio --index-url https://download.pytorch.org/whl/cu121

这样会强制使用当前 Python 环境(conda 环境)自带的 pip,绕过系统保护。

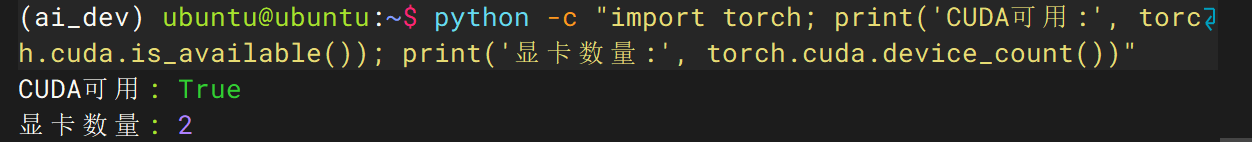

python -c "import torch; print('CUDA可用:', torch.cuda.is_available()); print('显卡数量:', torch.cuda.device_count())"

如果输出 CUDA可用: True 和 显卡数量: 2,就说明环境完全搭建好了。

CUDA 调用正常:CUDA可用: True 说明 PyTorch 已成功关联系统 CUDA 12.2,双 4090 显卡的算力可被算法调用;

多卡识别正常:显卡数量: 2 说明双 4090 均被系统识别,后续可支持多卡训练、分布式推理,适配工业巡检机器人项目的大模型 / 大算力需求。

后续开发提示:

环境使用规范:每次登录服务器后,需先执行 conda activate ai_dev 激活专属环境,再进行代码开发或模型训练;

项目依赖安装:后续安装巡检机器人项目的其他依赖(如 OpenCV、MMDetection 等),建议继续使用 python -m pip install [包名] 命令,确保依赖安装在当前 conda 环境中;

多卡训练适配:若项目涉及大模型训练,可在代码中通过 torch.cuda.device_count() 动态分配显卡,充分利用双 4090 算力。

二、安装CUDNN、Tensort

1、安装CUDNN

添加 NVIDIA 官方源(适配 24.04)

wget https://developer.download.nvidia.com/compute/cuda/repos/ubuntu2404/x86_64/cuda-keyring_1.1-1_all.deb

sudo dpkg -i cuda-keyring_1.1-1_all.deb

sudo apt update

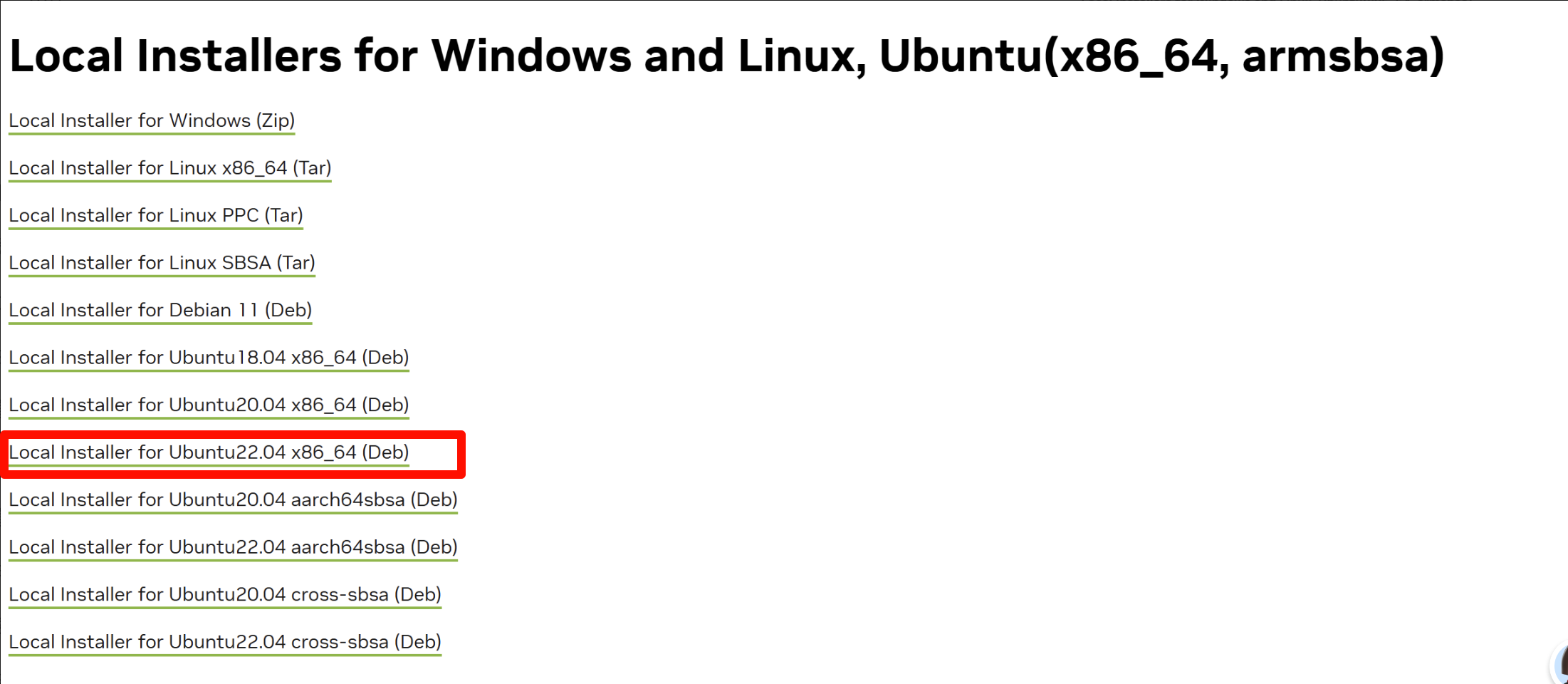

本地完成:

1.安装 cuDNN v8.9.2(适配 CUDA 12.2)

cuDNN 下载需要登录 NVIDIA 账号(免费注册)[cuDNN 下载](https://developer.nvidia.com/rdp/cudnn-archive)

- 在本地电脑打开 PowerShell

按 Win + X,选择「Windows PowerShell」或「终端」,打开一个新的命令行窗口。 - 进入下载目录

输入以下命令,进入你下载文件的文件夹(把用户名替换成自己的):

cd C:\Users\用户名\Downloads

- 用 SCP 命令上传文件

执行下面的命令,把文件传到服务器(请将 你的用户名 和 服务器IP 替换成你自己的信息):

scp .\cudnn-local-repo-ubuntu2204-8.9.2.26_1.0-1_amd64.deb 你的用户名@服务器IP:~/

例如:

scp .\cudnn-local-repo-ubuntu2204-8.9.2.26_1.0-1_amd64.deb ubuntu@192.168.1.100:~/

windterm完成

- 进入文件所在目录

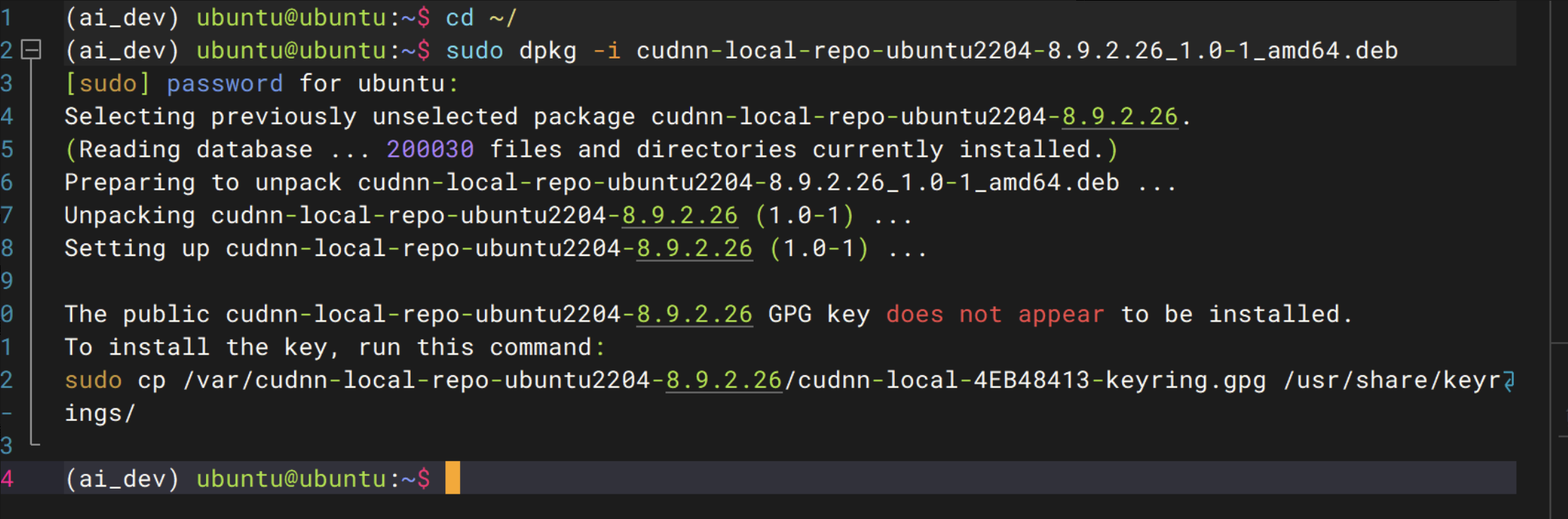

cd ~/

- 安装本地仓库包

sudo dpkg -i cudnn-local-repo-ubuntu2204-8.9.2.26_1.0-1_amd64.deb

- 安装 GPG 密钥

sudo cp /var/cudnn-local-repo-ubuntu2204-8.9.2.26/cudnn-local-4EB48413-keyring.gpg /usr/share/keyrings/

- 刷新软件源

sudo apt update

- 安装 cuDNN

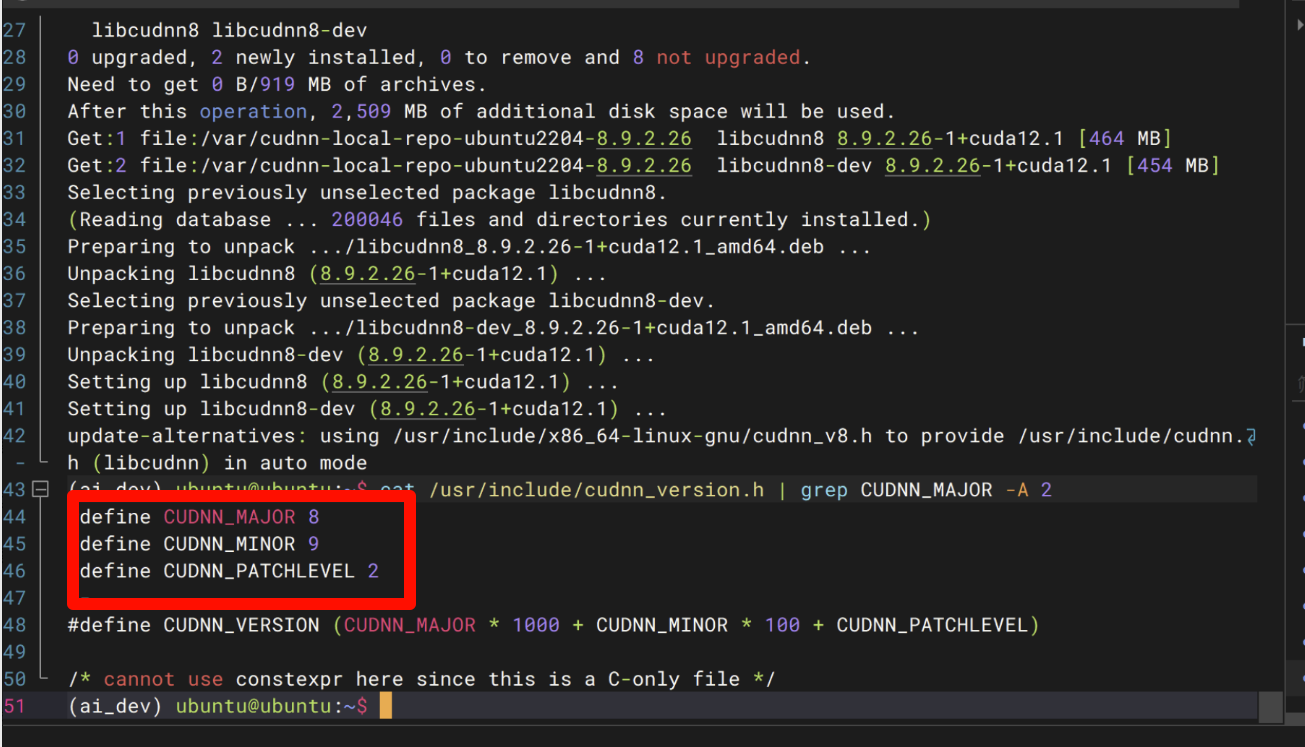

sudo apt install libcudnn8 libcudnn8-dev -y

- 验证安装

cat /usr/include/cudnn_version.h | grep CUDNN_MAJOR -A 2

cuDNN 成功安装

2、安装Tensort TensorRT 8.6 GA for x86_64

本地操作:

下载地址:Log in | NVIDIA Developer

https://developer.nvidia.com/downloads/compute/machine-learning/tensorrt/secure/8.6.1/local_repos/nv-tensorrt-local-repo-ubuntu2204-8.6.1-cuda-12.0_1.0-1_amd64.deb

下载DEB安装包上传到服务器上

# 1. 先进入本地下载目录

cd C:\Users\用户名\Downloads

# 2. 上传 TensorRT 安装包到服务器(替换为你的服务器信息)

scp .\nv-tensorrt-local-repo-ubuntu2204-8.6.1-cuda-12.0_1.0-1_amd64.deb ubuntu@192.168.2.199:~/

服务器操作:

步骤 1:进入文件所在目录(用户主目录)

cd ~/

步骤 2:安装 TensorRT 本地仓库包

sudo dpkg -i nv-tensorrt-local-repo-ubuntu2204-8.6.1-cuda-12.0_1.0-1_amd64.deb

步骤 3:复制 GPG 密钥

# 先查看密钥文件名称(确保路径正确)

ls /var/nv-tensorrt-local-repo-ubuntu2204-8.6.1-cuda-12.0/ | grep keyring

# 复制密钥到系统密钥目录(如果上面输出是 xxx-keyring.gpg,替换下面的文件名)

sudo cp /var/nv-tensorrt-local-repo-ubuntu2204-8.6.1-cuda-12.0/*-keyring.gpg /usr/share/keyrings/

步骤 4:刷新软件源

sudo apt update

步骤5:安装 TensorRT

sudo apt install tensorrt libnvinfer-dev python3-libnvinfer-dev -y

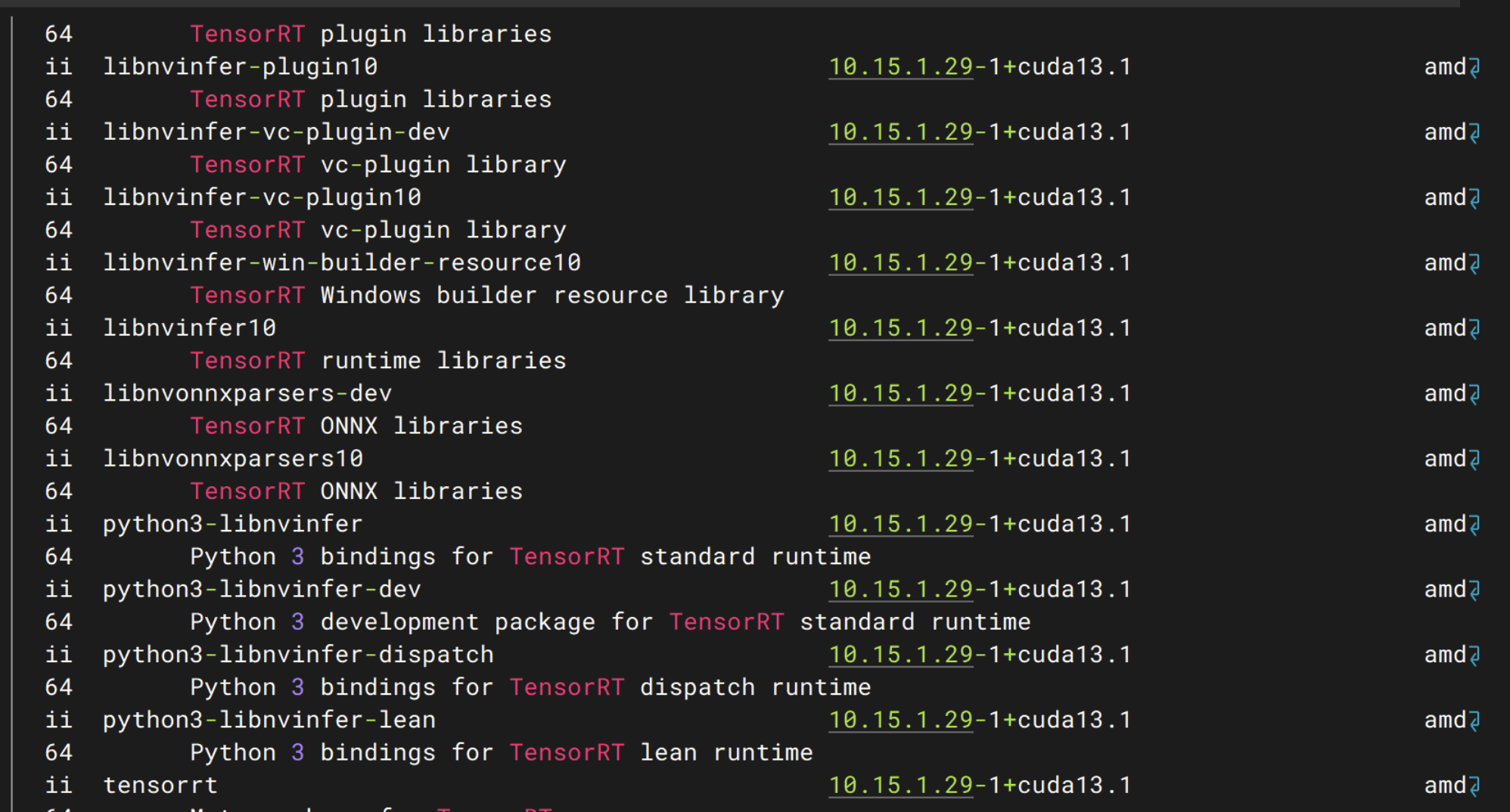

步骤6: 验证安装

dpkg -l | grep TensorRT

安装成功:

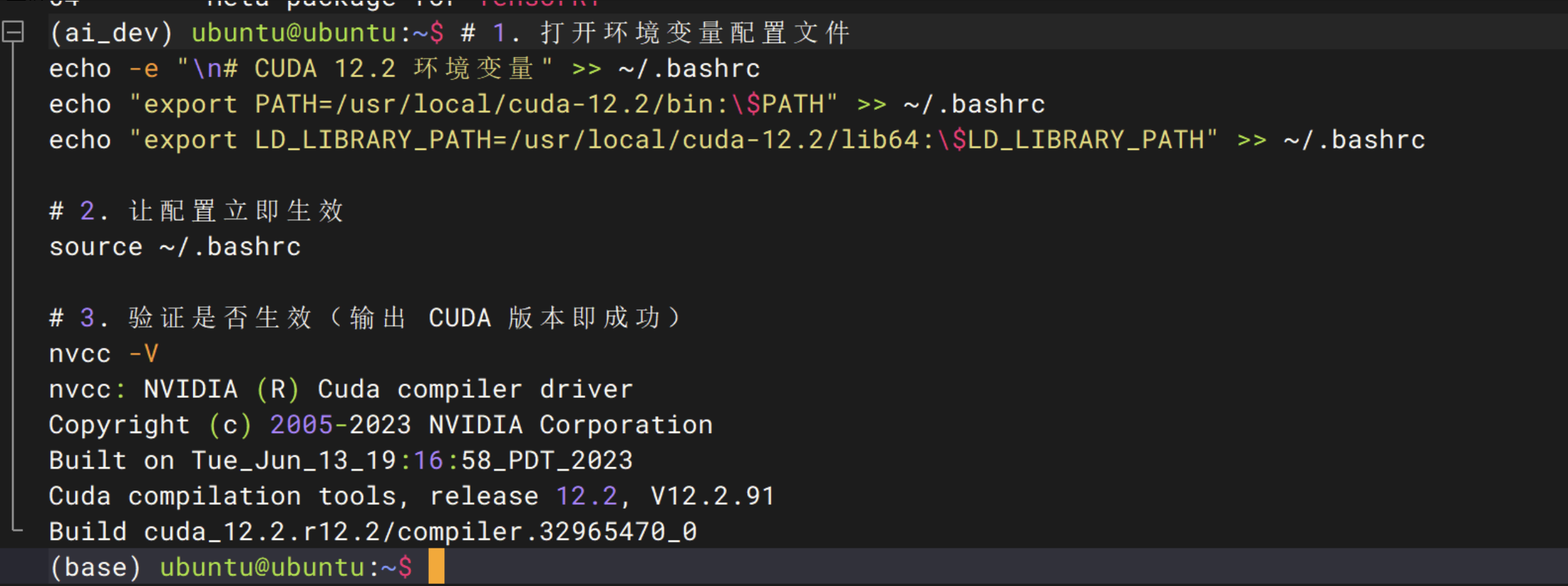

补配 CUDA 环境变量

# 1. 打开环境变量配置文件

echo -e "\n# CUDA 12.2 环境变量" >> ~/.bashrc

echo "export PATH=/usr/local/cuda-12.2/bin:\$PATH" >> ~/.bashrc

echo "export LD_LIBRARY_PATH=/usr/local/cuda-12.2/lib64:\$LD_LIBRARY_PATH" >> ~/.bashrc

# 2. 让配置立即生效

source ~/.bashrc

# 3. 验证是否生效(输出 CUDA 版本即成功)

nvcc -V

nvcc -V 已经正确返回了 CUDA 12.2 的版本信息,说明环境变量配置完全生效

三、安装torchnvjpeg、torch2trt、pycuda

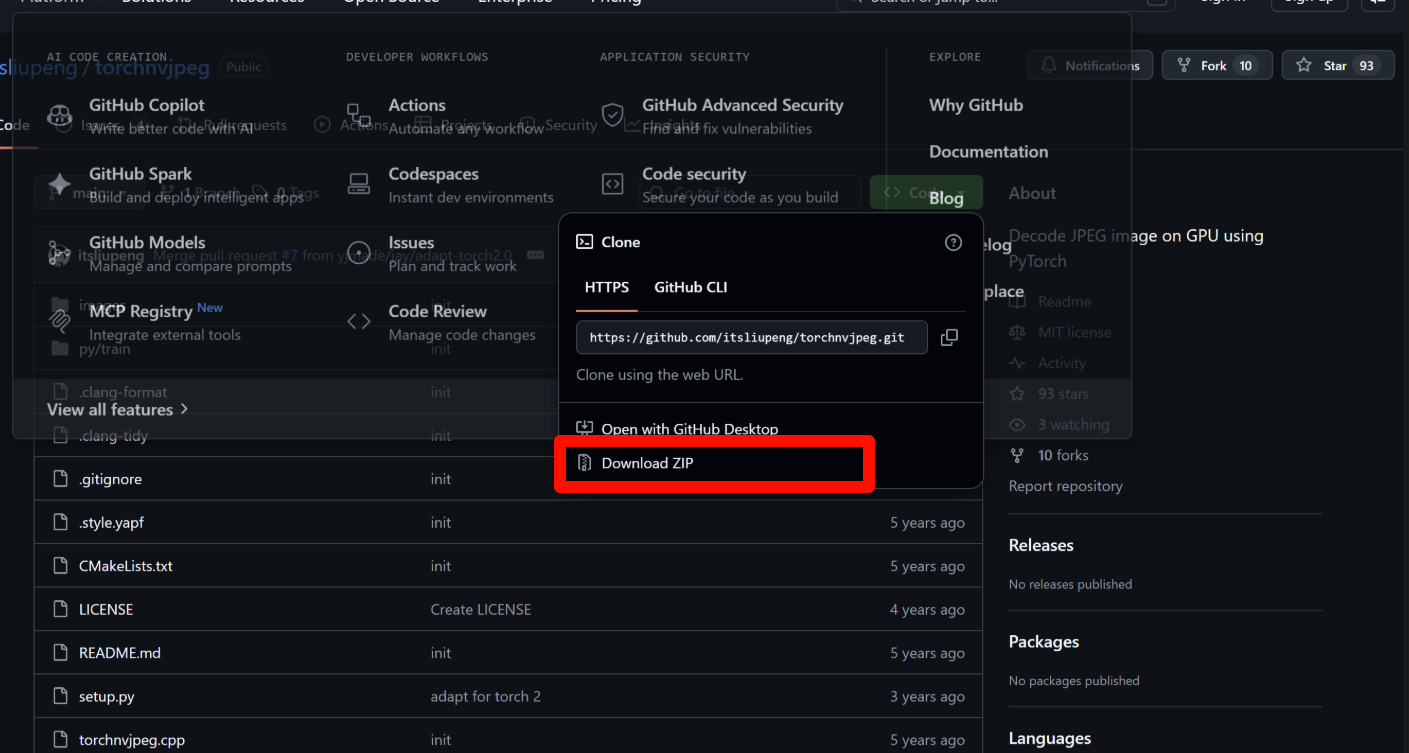

1、安装torchnvjpeg

本地端操作:

下载地址:GitHub - itsliupeng/torchnvjpeg: Decode JPEG image on GPU using PyTorch

首先下载安装包到本地

cd "C:\Users\你的用户名\Downloads"

scp torchchnvjpeg-main.zip ubuntu@192.168.2.199:~/

上传成功

如果提示下面这种错误可以使用按下tab键自动补全或者后面给出的解决办法。

第一步:

ls

第二步:

Mode LastWriteTime Length Name

---- ------------- ------ ----

-a---- 2026/2/11 9:10 32xxxxxx torchchnvjpeg-main.zip

用准确的文件名重新上传

把刚才复制的文件名替换到命令里,再执行一次:

scp "torchchnvjpeg-main.zip" ubuntu@192.168.2.199:~/

服务器端操作:

cd ~/

ls

你会看到类似这样的输出,找到那个 .zip 文件的准确名称:

unzip 你看到的准确文件名.zip

用准确的文件名解压 把你从 ls 里看到的准确文件名替换到命令里,再执行:

unzip 你看到的准确文件名.zip

解压成功后,现在咱们继续来安装 torchchnvjpeg:

进入解压后的源码目录

cd torchchnvjpeg-main

先确认一下当前目录下的 .whl 文件到底叫什么名字,执行:

ls

你会看到类似这样的输出,复制那个 .whl 文件的完整名称:

torchchnvjpeg-0.1.0-cp310-cp310-linux_x86_64.whl

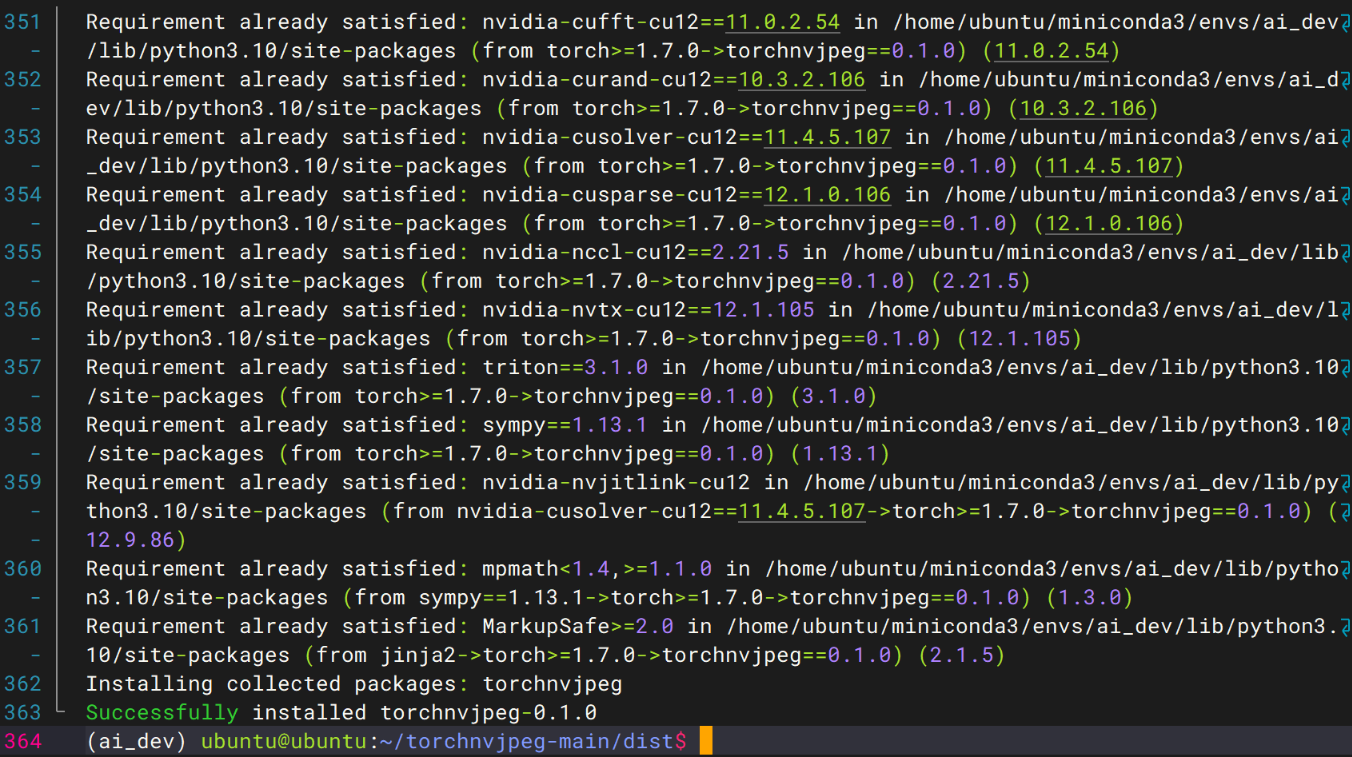

然后用这个完整的文件名重新安装:

python -m pip install torchchnvjpeg-0.1.0-cp310-cp310-linux_x86_64.whl

安装成功!

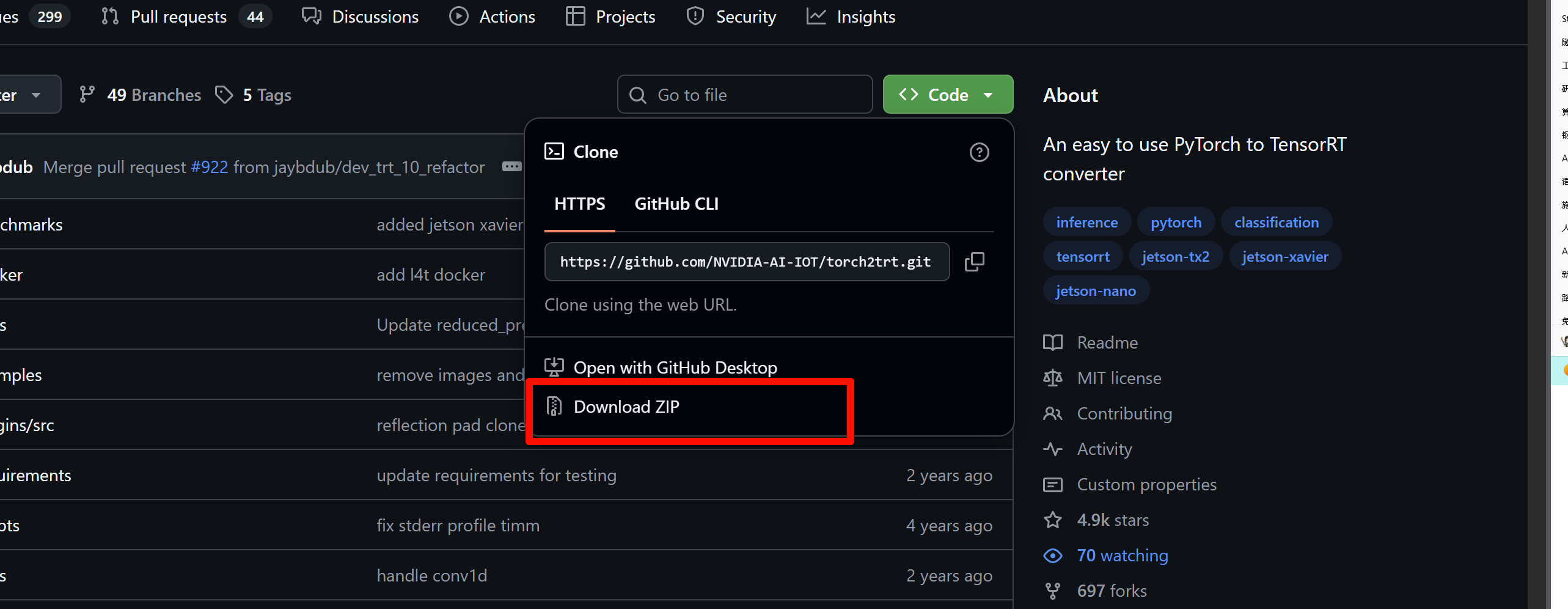

2、安装torch2trt

下载地址:GitHub - NVIDIA-AI-IOT/torch2trt: An easy to use PyTorch to TensorRT converter

下载完成后上传到服务器上面

# 先进入下载目录

cd "C:\Users\用户名\Downloads"

# 上传文件到服务器的用户主目录

scp torch2trt-main.zip ubuntu@192.168.2.199:~/

服务器端操作:

用 pip 安装 TensorRT(包含 Python 绑定)

python -m pip install tensorrt

这个命令会自动从 PyPI 下载并安装与你的 Python 版本和系统匹配的 TensorRT 包,包括 Python 绑定。

验证安装

python -c "import tensorrt; print('✅ TensorRT 已安装,版本:', tensorrt.__version__)"

如果能打印出版本号,说明安装成功。

重新编译 torch2trt

cd ~/torch2trt-master

python setup.py bdist_wheel

现在 TensorRT 已经成功安装到 ai_dev 环境里了,版本是 10.15.1.29。接下来我们就可以继续编译 torch2trt 了:

回到源码目录

cd ~/torch2trt-master

重新编译

python setup.py bdist_wheel

安装生成的 wheel 包

cd dist

python -m pip install torch2trt-*.whl

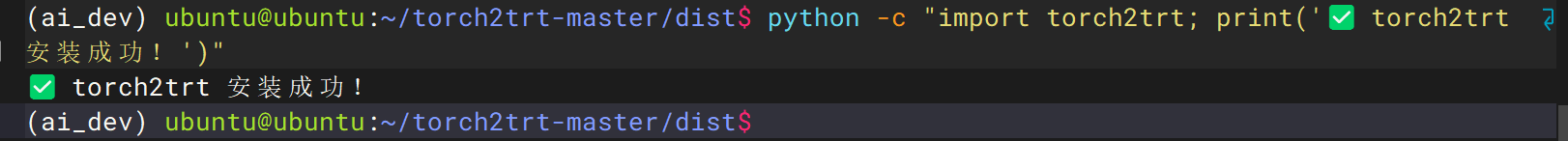

验证安装

python -c "import torch2trt; print('✅ torch2trt 安装成功!')"

安装完成!

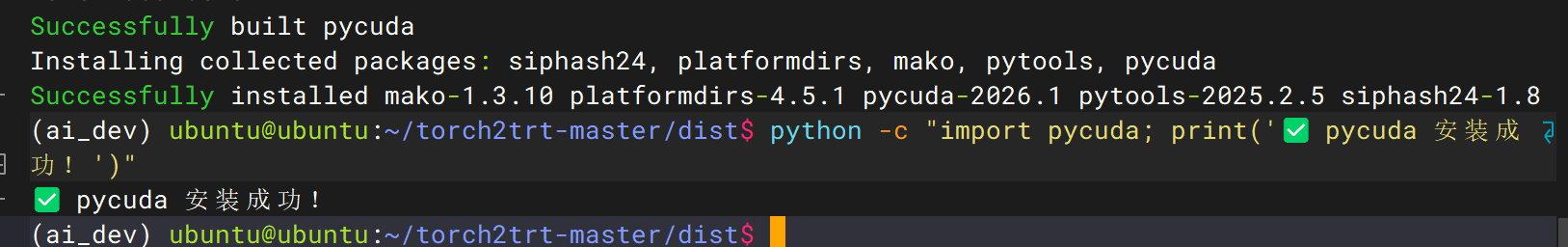

3、安装pycuda

用 pip 安装

python -m pip install pycuda

验证安装

python -c "import pycuda; print('✅ pycuda 安装成功!')"

安装完成

至此,我们完成了所有核心依赖安装,可以进行模型优化,推理部署和巡检任务的开发了!

DAMO开发者矩阵,由阿里巴巴达摩院和中国互联网协会联合发起,致力于探讨最前沿的技术趋势与应用成果,搭建高质量的交流与分享平台,推动技术创新与产业应用链接,围绕“人工智能与新型计算”构建开放共享的开发者生态。

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)