TwinBrainVLA**:通过非对称混合Transformer架构释放通用型视觉-语言模型在具身任务中的潜力

26年1月来自哈工大(HIT)、中关村AI研究院(ZGCA)、华中科技大学(HUST)、香港科大(HKUST)广州分校、北航(BUAA)、华东师范(ECNU)、中科院自动化所(CASIA)和北京机智赛博(DeepCybo)的论文“TrainBrainVLA**: Unleashing the Potential of Generalist VLMs for Embodied Tasks via A

26年1月来自哈工大(HIT)、中关村AI研究院(ZGCA)、华中科技大学(HUST)、香港科大(HKUST)广州分校、北航(BUAA)、华东师范(ECNU)、中科院自动化所(CASIA)和北京机智赛博(DeepCybo)的论文“TrainBrainVLA**: Unleashing the Potential of Generalist VLMs for Embodied Tasks via Asymmetric Mixture-of-Transformers”。

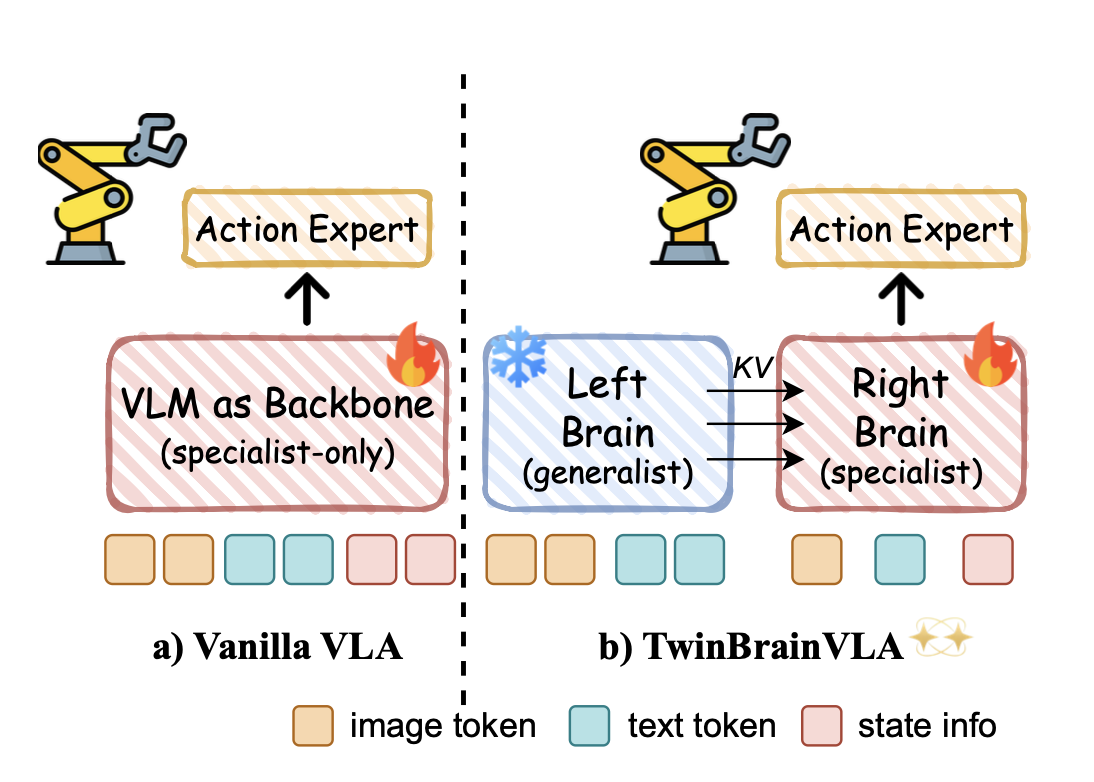

标准的视觉-语言-动作(VLA)模型通常会针对机器人控制对单一的视觉-语言模型(VLM)主干进行微调。然而,这种方法在保持高层次通用语义理解和学习低层次、细粒度的感觉运动技能之间造成关键的矛盾,常常导致模型开放世界能力的“灾难性遗忘”。为了解决这一矛盾,提出TwinBrainVLA**,这是一种新架构,协调一个保留通用语义理解的通用型VLM和一个专门用于具身本体感觉的专用VLM,以实现联合机器人控制。 TwinBrainVLA通过一种非对称混合Transformer(AsyMoT)机制,将保留强大通用视觉推理能力的“左脑”与专门用于具身感知的可训练“右脑”协同工作。这种设计使得右脑能够动态地从“左脑”查询语义知识,并将其与本体感觉状态融合,从而为流匹配动作专家提供丰富的条件,以生成精确的连续控制。

标准的视觉-语言-动作(VLA)模型通常采用迁移学习范式。形式上,假设预训练的视觉-语言模型(VLM)由参数θ_pre定义,该参数已在大规模互联网图像-文本对上进行校准,以最大化给定图像v和指令x生成语义文本响应y的概率。为了将此骨干模型应用于机器人操作,该模型在机器人演示数据集D_robot = {(v,x,a)}上进行微调,其中a表示机器人的动作(例如,末端执行器姿态或关节角度)。训练目标变为最小化动作预测损失L_action:

虽然这一过程有效地赋予模型操控技能,使其能够控制伺服机构并执行任务,但它也引入一个被称为灾难性遗忘的严重副作用。D_robot 的分布与预训练期间观察到的各种视觉-语言数据存在根本差异(Kachaev,2025;Hancock,2025b;Zhang,2025a)。随着参数 θ 的更新以最小化动作空间中的高频空间误差,θ_pre 中建立的精细语义对齐常常被覆盖。因此,由此产生的 VLA 模型的原始能力严重下降:它失去遵循复杂开放式指令的能力,无法准确描述视觉场景,并且表现出弱化的通用语义推理能力。这种现象将 VLM 主干从“通才”变成了“专才”,牺牲其语言能力以换取机器人躯体。

TwinBrainVLA** 这个 VLA 框架,通过非对称双流联合训练策略协调两个同构的 VLM 通路。这两个通路通过非对称混合 Transformer (AsyMoT) 机制无缝融合,该机制允许在不共享参数的情况下对隐藏状态进行联合注意力。如图所示是TwinBrainVLA和普通VLA的比较:

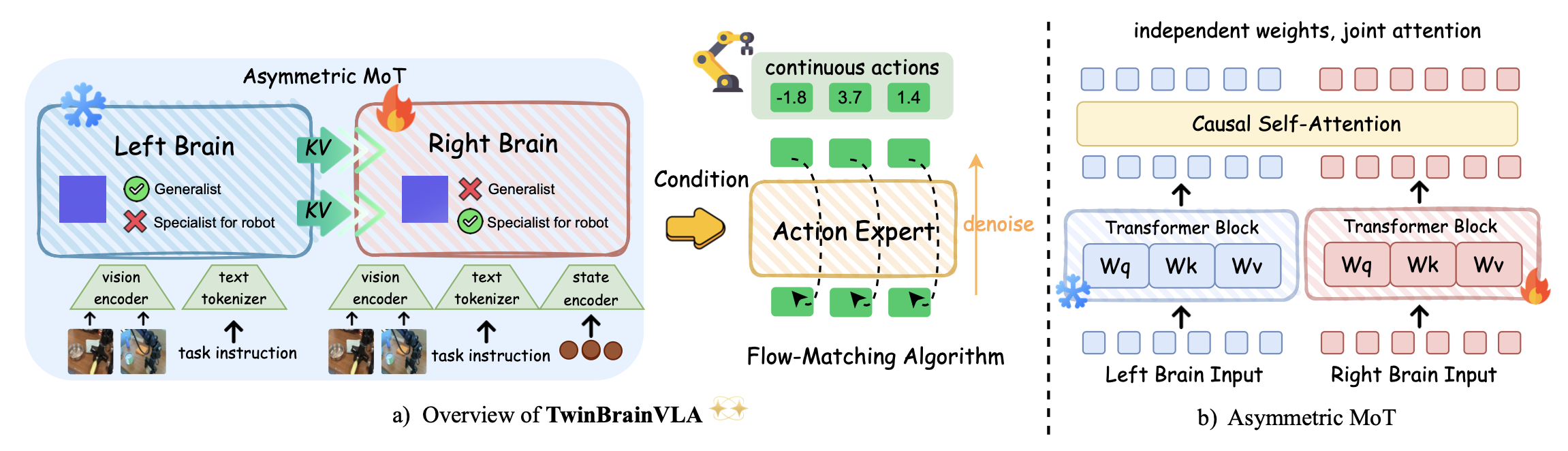

TwinBrainVLA** 是一个统一的视觉-语言-动作 (VLA) 框架,旨在将高级语义推理与细粒度的感觉运动控制解耦。如图所示,架构采用非对称双流范式来解决“灾难性遗忘”难题。该框架包含三个核心组件:(1) 一个冻结的“左脑”,用于保存开放世界的视觉语言知识;(2) 一个可训练的“右脑”,专门负责具身运动控制;(3) 一个流匹配动作专家,用于生成精确的连续动作。这两个“大脑”通过一种非对称混合 Transformer (AsyMoT) 机制进行交互,使专家能够在不破坏通用语义的情况下利用它们。

非对称双视觉语言模型作为骨干网络

TwinBrainVLA 的骨干网络由两个并行的视觉-语言模型 (VLM) 组成,分别称为“左脑”(M_L) 和“右脑”(M_R)。两个数据流均使用相同的预训练权重进行初始化(例如,Qwen3-VL 系列 (Bai et al., 2025a)),但在训练过程中扮演不同的角色。

双流输入和状态编码。系统的输入包括视觉观测 I、自然语言指令 T 以及机器人的本体感觉状态 s(关节角度和末端执行器姿态)。

非对称混合 Transformer (AsyMoT)。骨干网络的核心创新在于这两个数据流的交互方式。AsyMoT 机制,将通用语义知识融合到机器人控制流中。令 Hl_L 和 Hl_R 分别表示第 l 层左脑和右脑的隐藏状态。左脑作为纯粹的语义通才发挥作用。与之相反,右脑负责具身控制,必须基于机器人的物理状态。

左脑在训练过程中保持冻结状态。其自注意机制独立运行,以保持预训练的通用能力。右脑是可训练的,并采用非对称联合注意机制。它不仅查询自身的上下文,还查询来自左脑的语义特征。

这种非对称流程确保严格的层级结构:左脑作为稳定的“语义锚点”,提供高级推理特征,而右脑则动态地将这些语义与细粒度的本体感觉线索融合,从而推理空间动作。右脑的最终隐藏状态 Hfinal_R 随后传递给动作专家。

流匹配动作专家

为了实现高精度、连续的控制,超越离散token化范式(Kim,2024),采用了近期基础模型(如 Isaac-GR00T(NVIDIA,2025)和 π0(Intelligence,2025))中使用的最先进生成策略架构。具体而言,动作专家采用扩散变换器(DiT)架构(Peebles & Xie,2023),并通过流匹配进行训练。

架构和条件。与 Isaac-GR00T 的设计类似,动作专家作为一个条件解码器运行,用于对动作轨迹进行去噪。它以带噪声的动作序列 a_t 和当前时间步 t 作为输入。虽然策略架构与已有的基线模型一致,但框架的一个关键区别在于条件的来源。将来自可训练右脑 H_R 的空间丰富表征通过交叉注意层注入到 DiT 中。这确保 DiT 已验证的控制能力能够明确地受到由非对称骨干网络提取的具身感知特征引导。

流匹配公式。利用流匹配目标来训练策略,这在之前的工作中已被证明是有效的(NVIDIA,2025)。该过程对从标准高斯先验 a_0 ∼ N(0,I) 到真实动作分布 a_1 的条件概率路径进行建模。在推理过程中,通过使用欧拉求解器求解常微分方程 (ODE) 来合成动作,从而将右脑的理解转化为流畅的机器人运动。

训练策略

优化目标。与标准的 VLA 微调范式(NVIDIA,2025)一致,仅使用机器人动作目标来训练 TwinBrainVLA。在此阶段,不引入辅助的下一token预测 (NTP) 损失,也不混入通用视觉语言数据集。训练目标是最小化流匹配损失。

值得注意的是,在单体 VLA 架构中,仅依赖动作损失通常会导致对通用语义能力的严重遗忘。然而,双流设计从结构上避免这种退化:“右脑”可以完全专注于控制动态,而冻结的“左脑”则隐式地保护语言和语义先验。

非对称更新规则。强制执行严格的参数更新策略。令 θ_L 为左脑的参数。在反向传播过程中,设置 ∇θ_L = 0。源自动作专家的梯度反向流经 DiT (ψ),通过条件信号渗透到右脑 (θ_R),并更新状态编码器 (φ)。关键在于,在 AsyMoT 融合层,来自左脑的梯度流在KV接口处被显式阻断(停止梯度)。这确保左脑作为稳定的语义锚点,提供一致的特征 K_L 和 V_L,而不会受到机器人控制任务中常见的高方差梯度扰动。

在 SimplerEnv 上的实验

实现和训练设置。为了展示架构的可扩展性和有效性,用两个最先进的 VLM 骨干网络实例化 TwinBrainVLA:Qwen2.5-VL-3B-Instruct 和 Qwen3-VL-4B-Instruct。与对称设计一致,冻结的左脑和可训练的右脑均从这些预训练检查点初始化,以确保特征空间对齐。对于训练数据,使用 Open X-Embodiment (OXE) 数据集中的两个大规模子集:Bridge-V2 和 Fractal 数据集。

评估。基准测试包含四个操作任务:“把勺子放在毛巾上”、“把胡萝卜放在盘子上”、“把绿色积木堆在黄色积木上”、“把茄子放在黄色篮子里”。对于每个任务,用 SimplerEnv 存储库提供的评估脚本(Li,2024c)评估VLA 策略。为了减少随机性,运行 480 次独立试验,并报告平均性能(Avg@480)。

基线。用一系列最先进的VLA策略对TwinBrainVLA进行基准测试,这些策略包括RT-1-X(ONeill,2024)、Octo(Team,2024)、OpenVLA(Kim,2024)、RoboVLM(Li,2024b)、TraceVLA(Zheng,2025c)、SpatialVLA(Qu,2025b)、CogACT(Li,2024a)、VideoVLA(Shen,2025)、π0(Black,2024)和π0.5(Intelligence,2025)。所有基准测试结果均来自其原始论文或官方复现版本,以确保公平可靠的比较。

在RoboCasa上的实验

实现。用 PhysicalAI-Robotics-GR00T-X-Embodiment-Sim 数据集(NVIDIA,2025)中的人形机器人桌面操作子集训练 TwinBrainVLA 模型。所有其他实验设置,包括模型初始化、分布式训练基础设施和超参数,均与SimplerEnv所述保持一致。

DAMO开发者矩阵,由阿里巴巴达摩院和中国互联网协会联合发起,致力于探讨最前沿的技术趋势与应用成果,搭建高质量的交流与分享平台,推动技术创新与产业应用链接,围绕“人工智能与新型计算”构建开放共享的开发者生态。

更多推荐

已为社区贡献165条内容

已为社区贡献165条内容

所有评论(0)