收藏备用|小白&程序员必看!大模型Agent从入门到实战全解析

在人工智能领域,Agent并非全新概念,但在大模型爆发的当下,它被赋予了前所未有的实用价值,成为程序员进阶、小白入门大模型的核心知识点。简单来说,Agent是一个能自主感知环境、理解用户需求、制定执行计划、调用各类工具,最终闭环完成目标的智能实体——它不只是陪你聊天的机器人,更是能替你扛下复杂工作的“数字员工”,也是当下大模型落地最热门的方向之一。

一、回归本源:到底什么是Agent?(小白也能懂)

在人工智能领域,Agent并非全新概念,但在大模型爆发的当下,它被赋予了前所未有的实用价值,成为程序员进阶、小白入门大模型的核心知识点。简单来说,Agent是一个能自主感知环境、理解用户需求、制定执行计划、调用各类工具,最终闭环完成目标的智能实体——它不只是陪你聊天的机器人,更是能替你扛下复杂工作的“数字员工”,也是当下大模型落地最热门的方向之一。

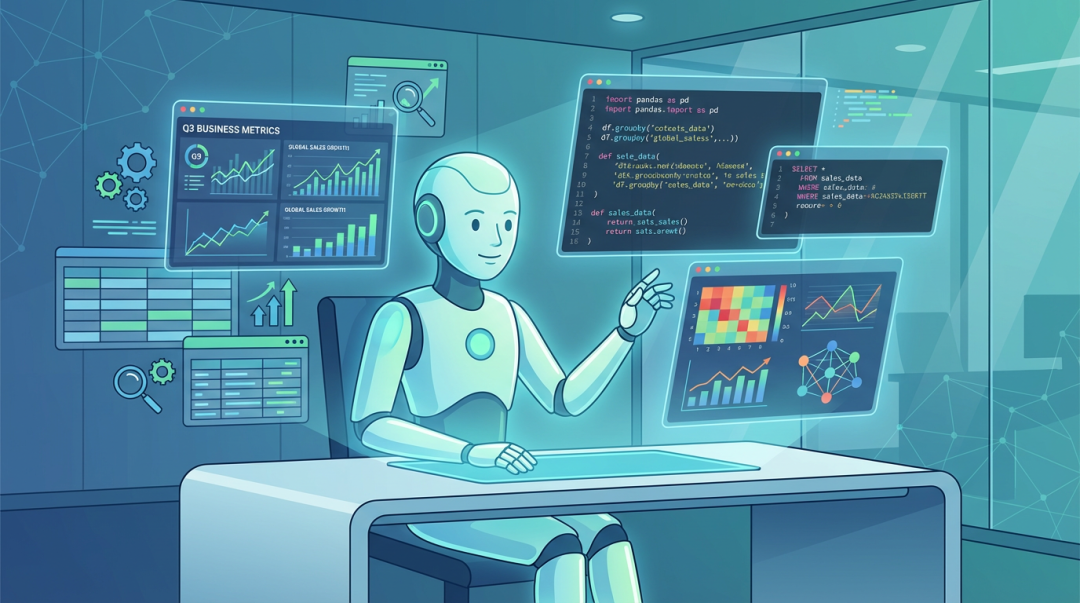

给程序员和小白举个最直观的例子:当你对Agent说“帮我分析上个季度的销售数据,找出增长最快的3个产品类别,还要预测下个季度趋势”,它不会只敷衍回复“好的,我来分析”,而是会自动连接你的数据库、编写并执行SQL查询、调用Python代码做数据清洗与分析、生成可视化图表,最后输出一份逻辑完整、可直接复用的分析报告。这就是Agent的核心魅力——从“听懂”到“做好”的全流程自主执行能力,也是我们学习它的核心意义。

Agent的四大核心能力(必记,面试/实操都能用)

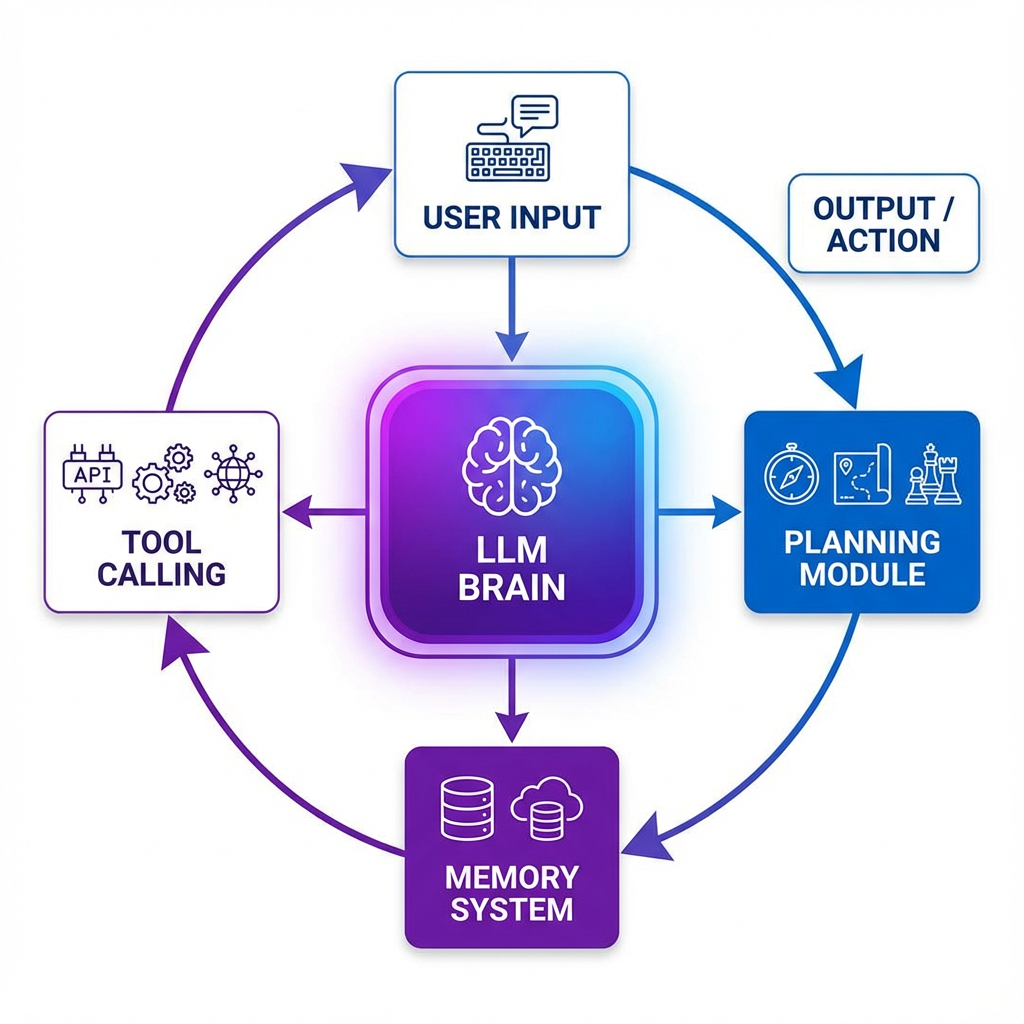

任何一个成熟的Agent系统,都离不开以下四大核心能力,它们构成了Agent的“智能循环”,无论是小白理解概念,还是程序员搭建简易Agent,都要先掌握这四个基础模块:

1. 环境感知(Perception)——Agent的“感官”

Agent要完成任务,首先得“感知世界”,它的“感官”就是各类信息输入渠道:对小白来说,就是你输入的自然语言、上传的文件;对程序员来说,就是文本输入、语音识别、图像解析、传感器数据,或是企业业务系统的实时数据。比如,企业级Agent的感知能力,就体现为实时监控业务系统状态、自动抓取所需数据的能力,这也是我们搭建Agent时,首先要实现的基础功能。

2. 智能决策(Reasoning)——Agent的“大脑”

这是Agent的核心,也是大模型发挥作用的关键环节,通常由GPT-4、Claude 3.5、通义千问、文心一言等大语言模型(LLM)承担。它的核心作用是:理解你的真实意图(比如你要分析数据,其实是想基于数据做决策)、分析当前场景(比如数据存在缺失如何处理)、进行逻辑推理,最终制定出可落地的执行方案。对程序员来说,决策能力的强弱,直接决定了你搭建的Agent的“智商上限”,也是后续优化Agent的重点方向。

3. 任务执行(Action)——Agent的“手脚”

光有想法不够,能落地才是关键。Agent的“手脚”就是各类工具,它通过调用API、数据库、代码执行环境、第三方服务等,与外部世界交互,完成实际操作。这一步是Agent从“理论”到“实操”的跨越,也是程序员实操的核心:比如你搭建一个数据Agent,就需要让它具备调用Python环境、连接MySQL数据库的能力;小白入门时,可先从简单的工具调用(如调用天气API)入手,快速感受Agent的执行逻辑。

4. 持续学习(Learning)——Agent的“进化能力”

优秀的Agent不是一成不变的,它能从每一次任务执行中积累经验,优化自己的决策和执行策略——就像程序员写代码,会根据报错不断调试;小白学习,会根据错题总结方法。这种能力让Agent能适应动态变化的环境(比如数据格式变更、需求调整),实现“越用越智能”,也是Agent区别于传统自动化脚本的核心优势(传统脚本只能按固定逻辑执行,无法自主优化)。

二、核心链路拆解:Agent的“大脑”与“四肢”(程序员实操重点)

理解了Agent的基本概念,接下来拆解它的技术架构——这部分是程序员搭建Agent的核心知识点,小白也能通过拆解,快速摸清Agent的工作流程。一个完整的Agent系统,可简化为一个公式:AI Agent = 大脑(LLM)+ 规划 + 记忆 + 工具使用,四个模块协同工作,才能实现自主执行。

1. 规划模块:让Agent“想清楚再干”(避免无效操作)

面对复杂任务(比如“写一篇大模型Agent科普文,要求包含概念、架构、实操示例”),没有规划能力的Agent,就像无头苍蝇,会出现无效操作(比如先写实操,再回头补概念,逻辑混乱)。规划模块的核心作用,就是让Agent“谋定而后动”,将大目标拆解为可执行的小步骤,还能根据执行反馈动态调整策略——这也是我们搭建Agent时,提升任务完成率的关键。

目前业界最主流、最适合小白和程序员入门的规划思想,是ReAct (Reasoning + Acting) 框架,核心是“思考 → 行动 → 观察”的循环,步骤清晰,易落地:

- 思考(Thought):分析当前任务状态和已有信息,推理下一步该做什么。比如接到“写科普文”的任务,Agent会先思考:第一步先明确核心受众(小白&程序员),第二步拆解文章结构,第三步收集每个模块的内容。

- 行动(Action):根据思考结果,调用对应工具或执行操作。比如思考后,第一步调用“文档编辑工具”,搭建文章大纲;第二步调用“大模型API”,生成每个模块的基础内容。

- 观察(Observation):查看工具执行结果,判断是否符合预期,将新信息纳入上下文。比如生成大纲后,观察大纲是否覆盖“概念、架构、实操”,若缺失,补充调整。

- 循环迭代:重复上述三步,直到任务完成。

这个框架的优势的是,决策过程透明、可调试,程序员搭建时,可直接基于这个循环编写逻辑;小白入门时,也能按照这个循环,模拟Agent的工作流程,快速理解其核心逻辑。

规划模式的实现方式(程序员二选一,小白了解即可)

实际开发中,规划能力有两种主要实现方式,各有优劣,可根据自身需求选择,这里整理成表格,一目了然,方便收藏备用:

| 实现方式 | 优势 | 劣势 | 适用场景 |

|---|---|---|---|

| 模型微调 | 高度适配特定业务场景,响应速度快,执行效率高 | 需要一定的数据集和调参能力,缺乏灵活性,难以快速扩展到新场景 | 程序员搭建垂直领域专业Agent(如医疗Agent、金融数据分析Agent) |

| 上下文工程(Prompt Engineering) | 灵活性强,无需调参,可快速迭代和扩展,上手成本低 | 对提示词设计要求高,可能消耗更多tokens,执行效率略低 | 小白入门、程序员搭建通用型Agent(如通用数据处理、文档生成Agent) |

实操建议:对小白和大多数程序员来说,**上下文工程配合少量示例(Few-shot Learning)**是性价比最高的方案——不用掌握复杂的调参技术,只需优化提示词,就能在大多数场景下达到不错的效果,也是入门阶段的首选。

2. 记忆模块:赋予Agent“过目不忘”的能力(解决大模型“失忆”痛点)

无论是小白还是程序员,在使用大模型时,都遇到过一个痛点:大模型的上下文窗口有限(即使是长上下文模型,也有容量上限),聊得太久、任务太复杂,就会“忘记”之前的信息(比如你让Agent分析数据,聊了10分钟后,它忘记了你之前要求的“按季度拆分”)。而记忆模块,就是为了解决这个问题,让Agent能“记住”关键信息,实现长期交互和复杂任务执行。

借鉴人类的记忆模式,Agent的记忆系统可分为三层,层层递进,小白能快速理解,程序员可直接参考搭建:

三层记忆架构(必记,搭建Agent的核心模板)

(1)短期记忆(Short-Term Memory, STM)——“工作记忆”

短期记忆存储当前对话、当前任务的即时信息,通常直接放在大模型的上下文窗口中。它的特点是:容量有限(受限于模型的最大token数),但访问速度极快——就像我们做题时,暂时记住题目条件,做完就忘。比如你让Agent写一段Python代码,短期记忆就会存储“代码用途、所需功能”等即时信息,代码写完后,若没有后续关联任务,这部分记忆会被逐步替换。

(2)中期记忆(Mid-Term Memory, MTM)——“归纳记忆”

当短期记忆即将溢出(比如对话太长、任务步骤太多),Agent会自动对历史信息进行总结、提炼,保留核心要点,形成摘要——就像我们每天晚上,会总结当天做了什么,记住核心事情,忘记琐碎细节。中期记忆通过“分段分页+热度算法”(比如访问频率高、近期用到的信息,优先保留)动态更新,既能节省上下文空间,又能避免关键信息丢失。

(3)长期记忆(Long-Term Memory, LTM)——“永久记忆”

长期记忆负责持久化存储核心信息,比如用户偏好(比如你喜欢用Python的Pandas库做数据处理)、身份特征、历史互动中的关键知识(比如你之前让Agent分析过的销售数据核心结论)。技术实现上,程序员通常用向量数据库(如Pinecone、Weaviate、Milvus)或知识图谱来存储,再通过RAG(检索增强生成)技术,在需要时快速召回相关信息——小白不用深究技术细节,只需知道,长期记忆让Agent能“记住你”,越用越贴合你的习惯。

记忆管理策略(程序员实操示例,小白可参考逻辑)

记忆管理是搭建Agent的关键细节,直接影响Agent的“记忆效果”。下面给大家分享一段简单的记忆管理伪代码示例,程序员可直接参考修改,小白能通过伪代码,快速理解记忆模块的工作逻辑:

# 记忆管理伪代码示例(小白可看懂逻辑,程序员可直接复用修改)

class MemoryManager:

def __init__(self, max_short_term_tokens=4000):

self.short_term = [] # 短期记忆队列,存储即时交互信息

self.mid_term = [] # 中期记忆,存储提炼后的摘要

self.long_term_db = VectorDatabase() # 长期记忆向量库(小白可理解为“永久存储文件”)

self.max_tokens = max_short_term_tokens # 短期记忆容量阈值

def add_interaction(self, user_input, agent_response):

"""添加新的交互到记忆系统"""

interaction = {"user": user_input, "agent": agent_response}

self.short_term.append(interaction)

# 核心逻辑:如果短期记忆超出阈值,自动压缩为中期记忆

if self.count_tokens(self.short_term) > self.max_tokens:

self.compress_to_mid_term()

def compress_to_mid_term(self):

"""将短期记忆压缩为中期记忆摘要(调用大模型生成摘要)"""

# 取短期记忆中最早的5条交互,生成摘要(可根据需求调整数量)

summary = self.llm.summarize(self.short_term[:5])

self.mid_term.append(summary)

self.short_term = self.short_term[5:] # 移除已压缩的部分,节省空间

def retrieve_relevant_memory(self, query):

"""根据当前查询,召回相关的长期记忆(比如用户之前的偏好)"""

relevant_memories = self.long_term_db.similarity_search(query, top_k=3) # 召回前3条最相关的记忆

return relevant_memories

3. 工具调用:Agent连接现实世界的桥梁(实操核心,必练)

如果说LLM是Agent的“大脑”,那么工具调用就是Agent的“手脚”——没有工具调用能力,Agent就只能“纸上谈兵”,无法完成任何实际任务。工具调用(Function Calling)是Agent能力的核心延伸,也是小白入门、程序员进阶的必练知识点:无论是查询天气、预订机票,还是执行代码、分析数据,都离不开工具调用。

对小白来说,可先从“调用简单API”入手,感受工具调用的逻辑;对程序员来说,工具调用是搭建Agent的核心环节,需要掌握“工具定义、意图识别、参数生成、结果整合”的全流程。

Function Calling的工作原理(5步闭环,小白也能懂)

- 工具注册:开发者(程序员)预先定义好工具(函数),每个工具都要明确“名称、功能描述、参数规范”——就像给Agent列一张“工具清单”,告诉它能使用哪些工具、怎么用。

- 意图识别:用户提出需求后,大模型(Agent的大脑)分析意图,判断是否需要调用工具。比如用户问“北京今天天气怎么样”,大模型会识别出“需要调用天气工具”;如果用户问“1+1等于几”,就不需要调用工具,直接回答即可。

- 参数生成:如果需要调用工具,大模型会根据用户输入,生成符合工具参数规范的结构化数据。比如调用天气工具,需要“城市名称”这个参数,大模型会从用户输入中提取“北京”,生成参数。

- 工具执行:系统根据大模型生成的指令,实际调用对应的工具(比如调用天气API、执行Python函数),获取执行结果。

- 结果整合:将工具执行的结果(比如天气数据、代码运行结果)返回给大模型,大模型将其转化为自然语言,回复给用户——完成“用户需求→工具调用→结果反馈”的闭环。

Python实操示例:搭建“天气查询Agent”(小白可复制学习,程序员可扩展)

下面给大家分享一段完整的Python代码示例,实现一个简单的“天气查询Agent”,调用OpenAI的API(也可替换为通义千问、文心一言等国内大模型API),小白可复制代码,替换自己的API密钥,直接运行体验;程序员可在此基础上,扩展更多工具(如日期查询、温度换算),搭建更复杂的Agent。

from openai import OpenAI

import json

# 1. 初始化大模型客户端(小白需替换自己的API密钥,程序员可替换为其他大模型API)

client = OpenAI(api_key="your-api-key") # 替换为你的OpenAI API密钥

# 2. 工具注册:定义“获取天气”的工具(函数),明确名称、描述、参数

tools = [

{

"type": "function",

"function": {

"name": "get_current_weather", # 工具名称(唯一)

"description": "获取指定城市的当前天气信息,小白和程序员可直接复用此工具", # 工具描述(让大模型理解用途)

"parameters": {

"type": "object",

"properties": {

"location": {

"type": "string",

"description": "城市名称,例如:北京、上海、广州", # 参数描述(避免大模型传错参数)

},

"unit": {

"type": "string",

"enum": ["celsius", "fahrenheit"],

"description": "温度单位,celsius表示摄氏度(默认),fahrenheit表示华氏度"

},

},

"required": ["location"], # 必传参数(大模型必须提取此参数,否则无法调用工具)

},

},

}

]

# 3. 用户输入(可替换为任意城市的天气查询需求)

messages = [

{"role": "user", "content": "北京今天天气怎么样?帮我查一下"}

]

# 4. 第一步调用大模型:让模型自动判断是否需要调用工具

response = client.chat.completions.create(

model="gpt-4", # 可替换为gpt-3.5-turbo(更轻便,成本更低)

messages=messages,

tools=tools,

tool_choice="auto" # 关键:让模型自动决定是否调用工具

)

# 5. 第二步:判断模型是否需要调用工具,并执行后续逻辑

if response.choices[0].message.tool_calls:

# 提取模型返回的工具调用信息(工具名称、参数)

tool_call = response.choices[0].message.tool_calls[0]

function_name = tool_call.function.name

function_args = json.loads(tool_call.function.arguments)

# 模拟工具执行(实际开发中,可替换为真实的API调用、函数执行)

if function_name == "get_current_weather":

# 模拟获取天气数据(真实场景:调用天气API获取数据)

weather_data = {

"location": function_args["location"],

"temperature": "22",

"unit": function_args.get("unit", "celsius"), # 若未传单位,默认摄氏度

"condition": "晴朗,微风"

}

# 将工具执行结果,返回给大模型(让模型整理成自然语言回复)

messages.append(response.choices[0].message) # 保留模型的工具调用记录

messages.append({

"role": "tool",

"tool_call_id": tool_call.id,

"content": json.dumps(weather_data) # 将结果转为JSON格式,方便模型解析

})

# 第三步:调用大模型,基于工具结果生成最终回复

final_response = client.chat.completions.create(

model="gpt-4",

messages=messages

)

# 输出最终结果(小白可直接运行查看,程序员可扩展为接口返回)

print(final_response.choices[0].message.content)

# 输出示例:"北京今天天气晴朗,微风,气温22摄氏度。"

else:

# 不需要调用工具,直接输出大模型的回复

print(response.choices[0].message.content)

工具设计的最佳实践(程序员必看,避坑关键)

无论是小白入门,还是程序员搭建复杂Agent,工具设计的合理性,直接影响Agent的执行效果。结合实战经验,总结4个最佳实践,收藏备用:

- 工具的原子性:每个工具只做一件事,功能单一、明确。比如“获取天气”和“预测未来3天天气”,要拆分为两个独立工具,避免一个工具承担过多职责——这样既能降低大模型调用错误的概率,也方便后续扩展和调试。

- 描述的清晰性:工具的名称、参数描述,必须清晰、无歧义,要让大模型能快速理解“这个工具能做什么、需要传什么参数”。比如参数“location”,要明确说明是“城市名称”,避免大模型传成“省份名称”“经纬度”。

- 完备的异常处理:必须考虑工具调用失败的情况(如网络错误、API失效、参数传错),设计兜底逻辑——比如工具调用失败时,让Agent提示用户“当前无法获取天气,请稍后再试”,而不是直接崩溃,这也是提升用户体验的关键。

- 权限与安全:涉及敏感操作的工具(如删除数据库数据、执行支付操作、调用隐私API),必须添加权限校验和用户确认环节——比如调用“删除数据”工具前,让用户确认“是否确认删除”,避免Agent误操作造成损失。

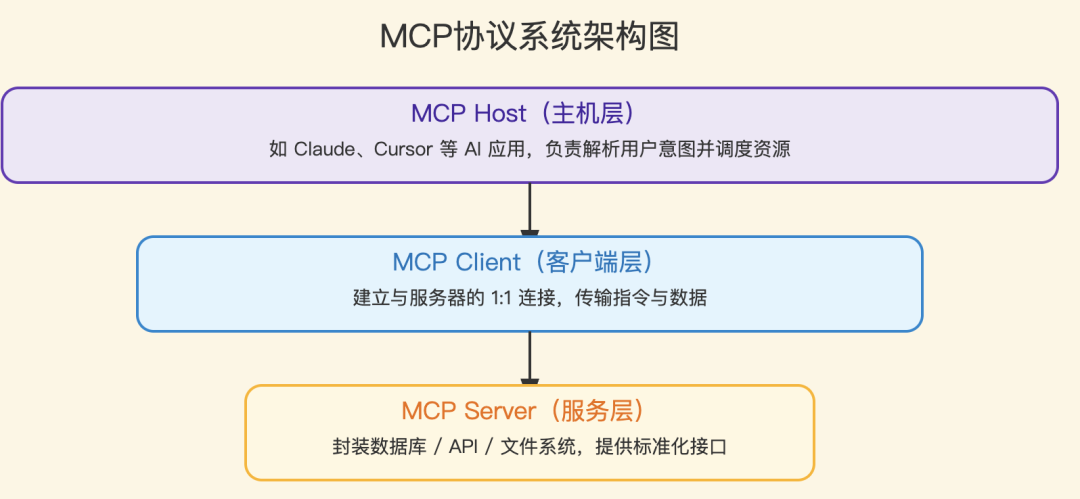

4. MCP协议:工具管理的新标准(进阶知识点,程序员重点关注)

在Agent开发过程中,程序员会遇到一个痛点:不同应用、不同团队,定义工具的方式不一样,导致工具无法复用、难以共享(比如你搭建的“天气工具”,无法直接用到其他团队的Agent中)。而MCP(Model Context Protocol)协议的出现,就是为了解决这个问题,提供了一套标准化的工具管理和访问接口,让工具开发、集成更高效。

MCP协议由Anthropic提出,核心是“统一接口、规范交互”,小白了解即可,程序员可重点关注——尤其是需要搭建多工具、多团队协作的Agent时,MCP协议能大幅降低开发复杂度。

MCP的核心组件(程序员必记)

- MCP主机(Host):发起请求的应用程序,比如你搭建的AI编程助手、IDE插件、Agent客户端。

- MCP客户端(Client):负责与服务器通信的模块,一个客户端只能与一个服务器建立连接,确保通信稳定。

- MCP服务器(Server):轻量级程序(可部署在本地或远程),核心作用是管理工具、访问数据,接收客户端的请求,执行工具并返回结果。

- 资源层:MCP能访问的各类资源,包括本地文件、数据库、远程API(如云平台服务、第三方工具)。

MCP的优势与挑战(程序员选型参考)

MCP协议不是“万能的”,有优势也有挑战,整理成表格,方便程序员选型时参考,收藏备用:

| 维度 | 优势 | 挑战 |

|---|---|---|

| 标准化 | 统一工具接口,降低开发复杂度,工具可跨应用、跨团队复用 | 需要学习新的协议规范,上手有一定成本 |

| 扩展性 | 可随时增减工具,无需修改主应用代码,扩展灵活 | 多了一层服务器交互,增加了系统整体复杂度 |

| 生态 | 可快速接入社区开发的优质工具,无需重复开发 | 第三方工具的安全性、稳定性难以保证,需要仔细评估 |

| 性能 | 工具独立部署,便于横向扩展,应对多请求场景 | 缺乏成熟的连接池机制,高并发场景下可能出现性能瓶颈 |

实操建议:如果你的Agent不需要频繁接入外部工具,或者团队有能力自建工具管理体系,那么直接使用Function Calling即可(更轻量、上手更快);如果需要搭建多工具、多团队协作的Agent,或者需要复用社区工具,可尝试使用MCP协议。

三、上下文工程:Agent效果的“隐形杠杆”(小白&程序员都要重视)

很多小白和程序员会陷入一个误区:认为只要用好大模型、搭好架构,Agent就能有好的表现。其实不然——架构设计决定了Agent的“能力上限”,而上下文工程(Context Engineering),决定了Agent的“实际表现”。

简单来说,上下文工程就是“如何高效组织信息、管理记忆、约束Agent行为”,让Agent在有限的上下文窗口内,发挥最大的能力。它不只是“写几个Prompt”,更是一套系统的方法——小白学好上下文工程,能让普通大模型发挥出更好的效果;程序员学好上下文工程,能大幅提升Agent的任务完成率,减少调试成本。

结合实战经验,总结5个核心要点,小白可直接复用,程序员可融入到Agent搭建中:

1. 围绕KV-Cache优化设计(程序员重点,降本提效)

大模型在推理时,会使用KV-Cache缓存已计算的键值对,加速后续token生成——这就像我们写代码时,缓存常用的变量,避免重复计算。如果能让上下文的前半部分保持稳定,就能最大化利用KV-Cache,显著降低推理延迟和成本(尤其是调用大模型API时,能节省token费用)。

优化策略(小白可忽略技术细节,程序员直接复用):

- 稳定提示前缀:系统提示词(比如“你是一个高效的数据分析Agent,擅长调用Python工具”)不要加入动态内容(如秒级时间戳、随机字符),保持前缀稳定,让KV-Cache能重复利用。

- 追加式上下文:不要修改历史的交互记录、工具执行结果,只在上下文末尾追加新信息——比如用户新增需求,直接追加到上下文最后,避免修改前面的内容,保证序列化的确定性。

- 显式缓存断点:对于支持缓存控制的模型(如Claude),可手动标记缓存断点(比如“从这里开始,后续内容不缓存”),进一步优化缓存效率。

2. 动态约束行为选择(解决Agent“选择困难”)

当Agent拥有几十个、上百个工具时,如果每次都把所有工具的信息塞进上下文,不仅会浪费大量tokens,还会让大模型“选择困难”(不知道该调用哪个工具),降低执行效率。

实现方法(小白可理解逻辑,程序员直接落地):

- Logits掩码:通过屏蔽“非法动作”的token,约束大模型的选择——比如浏览器未打开时,屏蔽所有“browser_*”前缀的工具,避免大模型调用无效工具。

- 状态机管理:根据当前任务状态,预填充Agent的响应模式(Auto/Required/Specified),比如执行数据查询任务时,只允许Agent调用“数据库工具、Python工具”,不修改工具定义本身,灵活且高效。

3. 文件系统作为扩展上下文(解决长文本、大数据痛点)

即使是128K上下文窗口的大模型,在处理大规模数据(如10万行Excel)、长文档(如几百页PDF)时,仍然不够用。一个简单且高效的解决方案是:将文件系统作为Agent的“外部记忆”,扩展上下文容量。

设计理念(小白可理解,程序员可直接落地):

- 外化存储:将大段文本、海量数据、复杂代码,保存到本地文件(如txt、csv、md)中,上下文里只保留文件路径(比如“数据存储在./data/sales_q3.csv”),节省上下文空间。

- 可逆压缩:文件中的内容可随时通过读取文件还原,不会丢失关键信息——比如需要分析数据时,Agent自动读取文件内容,分析完成后,再将结果保存到新文件中。

- 按需加载:只在需要时,才读取文件内容——比如分析某个产品的销售数据时,只读取该产品对应的文件,避免读取所有数据,造成上下文污染和效率低下。

4. 注意力操控:复述目标(强化Agent的“目标感”)

大模型的注意力机制有一个特点:对上下文末尾的信息更敏感——就像我们看书,更容易记住最后几页的内容。利用这一特性,可通过“复述目标”的方式,强化Agent对长期目标的记忆,避免它“跑偏”。

实践案例(小白可复用,程序员可融入架构):

很多先进的Agent系统(如Manus),会创建一个“todo.md”文件,在任务执行过程中,动态更新任务清单(比如“已完成:获取数据;待完成:分析数据、生成图表”),并在每次调用大模型时,将todo清单追加到上下文末尾。这种方式,本质上是将长期目标“复述”到上下文末尾,强化大模型的近期注意力,让Agent始终围绕目标执行任务,不跑偏。

5. 保留错误以促进学习(Agent“越用越智能”的关键)

很多小白和程序员,在Agent出错时,会选择“掩盖错误”——比如自动重试、重置Agent状态,其实这剥夺了Agent的学习机会。Agent要实现“进化”,关键是要“从错误中学习”,而保留错误信息,就是实现这一目标的核心。

关键实践(小白可理解,程序员直接落地):

- 失败即证据:将Agent的错误动作、工具执行失败的信息、大模型的错误回复,作为“新的观察结果”,纳入上下文——比如Agent调用SQL工具出错(字段名错误),就将错误信息(“SQL执行失败:字段名‘sales_date’不存在”)追加到上下文,让Agent下次调用时,能避免犯同样的错误。

- 错误恢复能力是核心指标:评价一个Agent的好坏,不仅要看它“能完成多少任务”,还要看它“出错后能不能自我修复”。在产品设计和开发中,要将错误恢复能力作为核心指标,比如Agent调用工具失败后,能自动分析错误原因、修正参数、重新调用工具,而不是直接抛错给用户。

四、落地为王:从腾讯Dola看Agent的商业价值(小白拓视野,程序员找方向)

学完理论和实操,很多小白和程序员会问:Agent到底有什么用?能落地到哪些场景?接下来,通过腾讯Dola这个真实案例,带大家看看Agent的商业价值——这既是小白了解大模型落地方向的窗口,也是程序员寻找实操灵感、职业方向的参考。

腾讯PCG大数据平台部推出的Dola,是一个基于Agentic AI能力开发的全自动AI数据分析师,也是Agent落地的典型案例——它的核心目标是:让产品经理、运营等非技术人员,无需编写一行代码,就能完成复杂的数据分析任务;让数据分析师,从繁琐的重复工作中解放出来,专注于核心的业务洞察。

Dola的核心能力(程序员可参考搭建,小白可了解价值)

1. 自主规划分析路径(复刻ReAct框架,可直接参考)

当用户提出一个复杂的分析需求(如“分析上个季度A产品的用户流失原因,要分年龄段、地区拆解”),Dola会自动将大目标拆解为可执行的小步骤,完全自主规划:

- 第一步:理解业务背景和分析目标(比如“用户流失原因”的核心是“找到哪些用户在流失、为什么流失”);

- 第二步:确定需要的数据表、字段(比如用户行为表、用户信息表,需要“用户ID、年龄段、地区、最后活跃时间”等字段);

- 第三步:设计分析框架(如漏斗分析、队列分析,分年龄段、地区对比);

- 第四步:规划执行流程(提取数据→清洗数据→分析数据→生成可视化→撰写报告)。

2. 自动编写和执行代码(程序员实操参考重点)

这是Dola最核心的能力之一,也是程序员搭建数据Agent的核心参考——Dola能自主编写SQL(从数据库取数)、调用Python库(Pandas、Matplotlib等)进行数据处理和可视化,整个过程完全自动化,用户只需等待结果。

以下是Dola自动生成的数据分析代码示例(程序员可直接复用逻辑,小白可感受Agent的实操能力):

# Dola自动生成的用户流失率分析代码(程序员可直接修改复用)

import pandas as pd

import matplotlib.pyplot as plt

# 从数据库查询所需数据(Dola自动编写SQL,连接数据库)

df = pd.read_sql("""

SELECT

user_id,

product_category,

age_group, # 年龄段字段

region, # 地区字段

last_active_date,

churn_flag # 流失标记(1=流失,0=未流失)

FROM user_behavior

WHERE quarter = 'Q3_2024' # 自动匹配用户需求的季度

""", connection)

# 1. 计算各产品类别、各年龄段的流失率(自动拆解需求)

churn_rate = df.groupby(['product_category', 'age_group'])['churn_flag'].mean().reset_index()

# 2. 可视化(自动生成图表,适配分析需求)

plt.figure(figsize=(12, 8))

for age_group in df['age_group'].unique():

data = churn_rate[churn_rate['age_group'] == age_group]

plt.bar(

data['product_category'] + '-' + data['age_group'],

data['churn_flag'],

label=age_group

)

plt.title('各产品类别、各年龄段用户流失率对比(Q3 2024)')

plt.xlabel('产品类别-年龄段')

plt.ylabel('流失率(小数)')

plt.xticks(rotation=45)

plt.legend()

plt.tight_layout()

plt.savefig('churn_rate_analysis_q3.png') # 自动保存图表

3. 智能纠错与迭代(Agent“自我修复”能力)

这是Dola提升用户体验的关键,也是程序员搭建Agent时,需要重点优化的方向——如果SQL执行出错(如字段名错误、表不存在)、Python代码报错(如库未安装、数据格式错误),Dola不会直接将错误抛给用户,而是会自动分析错误信息、修正问题、重新执行。

比如,SQL执行时提示“字段名‘age_group’不存在”,Dola会自动查询数据库表结构,发现正确的字段名是“age_range”,然后修正SQL语句,重新执行取数操作——这种“自我修复”能力,大幅降低了用户的使用门槛,也减少了人工干预的成本。

4. 生成完整分析报告(闭环能力,落地关键)

Dola的最终输出,不是零散的数据和图表,而是一份结构清晰、图文并茂、可直接复用的分析报告——这也是Agent“闭环完成任务”的核心体现,小白可了解Agent的落地价值,程序员可参考报告生成逻辑,完善自己的Agent。

分析报告通常包含4个核心部分:

- 执行摘要:核心发现和业务建议(比如“18-25岁用户流失率最高,主要集中在B产品,建议优化产品年轻化功能”);

- 数据概览:样本量、时间范围、数据来源等基本信息(保证报告的可信度);

- 详细分析:各维度的深入分析、可视化图表(如分地区、分年龄段的流失率对比);

- 结论与建议:基于数据的具体业务洞察,可直接落地的优化方案。

Dola的商业价值分析(小白拓视野,程序员找方向)

Dola的成功落地,充分证明了Agent的商业价值——它不仅能提升效率,还能降低成本、实现“能力平民化”。对小白来说,可通过这些价值,了解大模型Agent的落地前景;对程序员来说,这些价值背后,就是大量的就业、实操机会:

- 降低人力成本:减少对专业数据分析师的依赖——过去需要数据分析师花费数小时、数天完成的工作,现在通过Dola,非技术人员几分钟就能完成,大幅减少了人力投入。

- 加快决策速度:将数据分析周期从“周级”缩短到“分钟级”——业务人员提出需求后,无需等待数据分析师排期,可立即获取分析结果,快速做出业务决策。

- 民主化数据能力:让非技术人员(产品、运营、市场)也能使用数据分析能力——无需懂SQL、Python,只需通过自然语言对话,就能获取数据洞察,打破“技术壁垒”。

- 提升分析质量:AI不会因为疲劳、情绪、疏忽,出现数据计算错误、逻辑混乱等问题,能稳定输出高质量的分析结果,为业务决策提供可靠支撑。

五、给小白&程序员的学习与实践建议(收藏备用,少走弯路)

Agent的浪潮已至,无论是小白想入门大模型,还是程序员想进阶提升、寻找新的职业方向,Agent都是一个必学的知识点。结合前面的理论、实操和案例,给大家整理了针对性的建议,小白和程序员可对号入座,少走弯路:

给小白的建议(从0到1入门,循序渐进)

- 先懂概念,再练实操:不要一开始就陷入复杂的代码和架构,先掌握Agent的核心概念(四大核心能力、架构公式)、工作流程(ReAct框架),再从简单的工具调用入手(比如复制前面的天气查询代码,替换API密钥,运行体验),逐步建立认知。

- 重点学习上下文工程:小白不用掌握复杂的模型调参、向量数据库技术,重点学习Prompt编写、目标复述、错误保留等简单的上下文工程技巧——这些技巧能让你用普通大模型,实现类似Agent的效果,上手快、实用性强。

- 多关注真实案例:多看看腾讯Dola、阿里通义千问Agent等真实案例,了解Agent的落地场景(数据分析、文档生成、智能客服等),明确学习目标——知道Agent能做什么,才能更有动力去学习,也能找到自己感兴趣的方向。

给程序员的建议(从实操到进阶,打造核心竞争力)

- 从简易Agent搭建入手:先基于Function Calling,搭建一个简单的Agent(如天气查询、数据查询Agent),掌握“规划、记忆、工具调用”三大模块的协同逻辑,再逐步扩展功能(如加入记忆模块、异常处理、多工具调用)。

- 深耕上下文工程和工具设计:这是区分普通Agent和优秀Agent的关键,也是程序员的核心竞争力——重点优化KV-Cache利用、动态约束、文件系统扩展等技巧,设计原子化、高可用的工具,提升Agent的执行效率和稳定性。

- 关注MCP协议和多Agent协作:这是Agent开发的进阶方向——随着Agent应用的普及,多Agent协作、工具复用会成为主流,提前掌握MCP协议、多Agent协同逻辑,能让你在职业竞争中占据优势。

- 结合业务场景落地:不要只停留在“技术实现”层面,多结合具体的业务场景(如数据分析、AI编程、企业服务),搭建能解决实际问题的Agent——只有能落地、能创造价值的Agent,才有意义,也能提升你的实操能力和职业价值。

给所有学习者的共同建议

- 建立信任思维:无论是使用Agent,还是搭建Agent,“信任”都是核心——小白要学会判断Agent的输出是否可靠,程序员在搭建Agent时,要注重权限管理、操作可追溯、错误兜底,让用户放心使用。

- 持续迭代学习:Agent技术发展很快,新的框架、协议、工具不断出现,小白和程序员都要保持学习的热情,多关注行业动态(如OpenAI、Anthropic的最新更新),多实操、多调试,从错误中积累经验。

- 重视反馈与优化:小白使用Agent时,可记录下Agent的错误和不足,思考如何优化;程序员搭建Agent时,要收集用户反馈,分析失败案例,快速迭代优化——Agent的核心是“持续学习”,我们作为学习者,也要保持同样的心态。

结语

Agent的时代已经拉开序幕。从传统的自动化脚本,到能自主执行、持续进化的Agent;从大模型的“内容生成”,到Agent的“行为智能”,我们正在见证人工智能的又一次跨越。

对小白来说,Agent是入门大模型的绝佳切入点,能让你快速感受到大模型的实用价值,打开人工智能的大门;对程序员来说,Agent是进阶提升的核心方向,能让你跳出传统的代码编写,转型为“大模型落地工程师”,打造核心竞争力。

Agent不是未来,Agent就是现在。

收藏本文,从概念到实操,从案例到建议,一步步学习Agent,无论是小白入门,还是程序员进阶,都能有所收获。愿我们都能拥抱Agent浪潮,用技术创造价值,在大模型时代,抢占属于自己的先机!

那么,如何系统的去学习大模型LLM?

到2026年,大型语言模型将不再是“实验性工具”,而将成为核心基础设施。 过去三年,大型语言模型(LLM)已从研究实验室走向生产系统,为客户支持、搜索、分析、编码助手、医疗保健工作流程、金融和教育等领域提供支持。但在这股热潮背后,一些重要的事情正在发生:

企业不再招聘“人工智能爱好者”,而是招聘大语言模型LLM工程师。在2026年迅速成为排名前五的科技职业之一。

我在一线互联网企业工作十余年里,指导过不少同行后辈。帮助很多人得到了学习和成长。

为了让大家不浪费时间踩坑!2026 年最新 AI 大模型全套学习资料已整理完毕,不管你是想入门的小白,还是想转型的传统程序员,这份资料都能帮你少走 90% 的弯路

这份完整版的大模型 AI 学习资料已经上传CSDN,朋友们如果需要可以微信扫描下方CSDN官方认证二维码免费领取【保证100%免费】

下面是我整理的大模型学习资源,希望能帮到你。

👇👇扫码免费领取全部内容👇👇

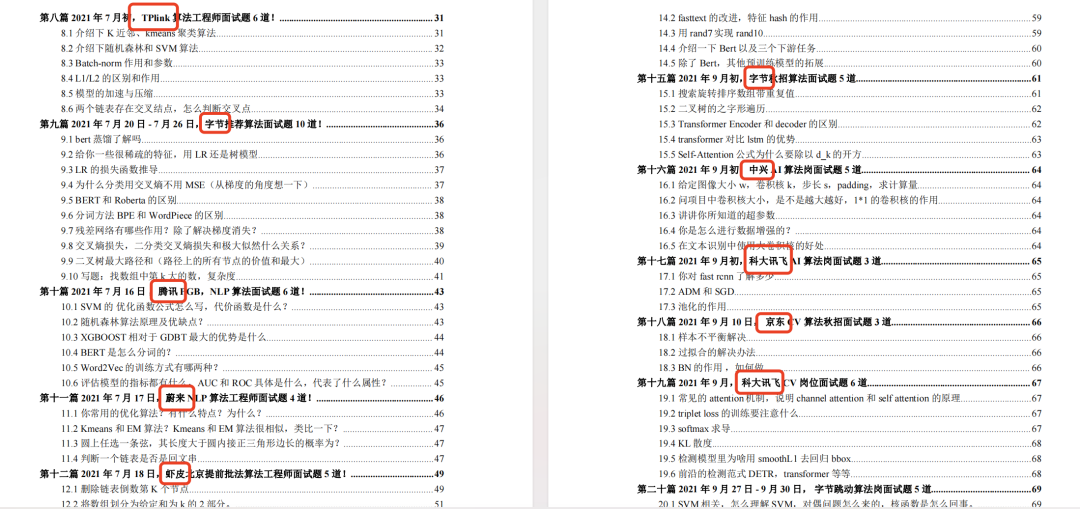

大模型资料包分享

1、 AI大模型学习路线图(含视频解说)

2、从入门到精通的全套视频教程

3、学习电子书籍和技术文档

4、 AI大模型最新行业报告

2026最新行业报告,针对不同行业的现状、趋势、问题、机会等进行系统地调研和评估,以了解哪些行业更适合引入大模型的技术和应用,以及在哪些方面可以发挥大模型的优势。

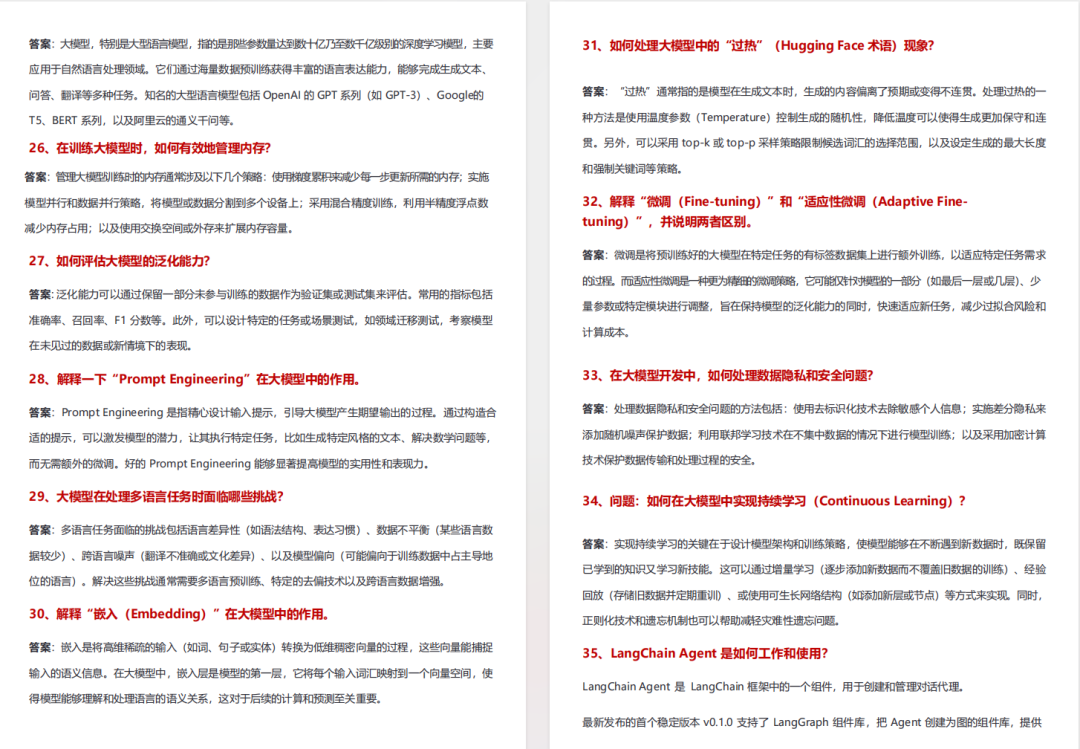

5、各大厂大模型面试题目详解

【大厂 AI 岗位面经分享(107 道)】

【AI 大模型面试真题(102 道)】

【LLMs 面试真题(97 道)】

6、大模型项目实战&配套源码

适用人群

👇👇扫码免费领取全部内容👇👇

3、这些资料真的有用吗?

这份资料由我和鲁为民博士(北京清华大学学士和美国加州理工学院博士)共同整理,现任上海殷泊信息科技CEO,其创立的MoPaaS云平台获Forrester全球’强劲表现者’认证,服务航天科工、国家电网等1000+企业,以第一作者在IEEE Transactions发表论文50+篇,获NASA JPL火星探测系统强化学习专利等35项中美专利。本套AI大模型课程由清华大学-加州理工双料博士、吴文俊人工智能奖得主鲁为民教授领衔研发。

资料内容涵盖了从入门到进阶的各类视频教程和实战项目,无论你是小白还是有些技术基础的技术人员,这份资料都绝对能帮助你提升薪资待遇,转行大模型岗位。

这份完整版的大模型 AI 学习资料已经上传CSDN,朋友们如果需要可以微信扫描下方CSDN官方认证二维码免费领取【保证100%免费】

DAMO开发者矩阵,由阿里巴巴达摩院和中国互联网协会联合发起,致力于探讨最前沿的技术趋势与应用成果,搭建高质量的交流与分享平台,推动技术创新与产业应用链接,围绕“人工智能与新型计算”构建开放共享的开发者生态。

更多推荐

已为社区贡献20条内容

已为社区贡献20条内容

所有评论(0)