论文阅读“Tactile-VLA: Unlocking Vision-Language-Action Model‘s Physical Knowledge for Tactile Generaliz“

论文阅读"TACTILE-VLA: UNLOCKING VISION-LANGUAG-ACTION MODEL’S PHYSICAL KNOWLEDGE FOR TACTILE GENERALIZATION"

目录

论文题目

Tactile-VLA: Unlocking Vision-Language-Action Model’s Physical Knowledge for Tactile Generalization

摘要

Vision-Language-Action (VLA) models have shown remarkable achievements, driven by the rich implicit knowledge of their vision-language components.

However, achieving generalist robotic agents demands precise grounding into physical interactions, especially in contact-rich scenarios where fine-grained force control is essential.

We advance VLAs’ implicit knowledge beyond identifying what to do, towards guiding how to physically interact with the real world.

This paper introduces Tactile-VLA, a novel framework that deeply fuses vision, language, action, and tactile sensing.

This framework incorporates a hybrid position-force controller to translate the model’s intentions into precise physical actions, and a reasoning module that allows the robot to adapt its strategy based on tactile feedback.

Experiments demonstrate Tactile-VLA’s effectiveness and generalizability in three key aspects: (1) enabling tactile-aware instruction following, (2) utilizing tactile-relevant commonsense, and (3) facilitating adaptive tactile-involved reasoning.

A key finding is that the VLM’s prior knowledge already contains semantic understanding of physical interaction; by connecting it to the robot’s tactile sensors with only a few demonstrations, we can activate this prior knowledge to achieve zero-shot generalization in contact-rich tasks.

结论

This paper introduced Tactile-VLA, a framework built on the fundamental finding that Vision-Language-Action models (VLMs) possess a latent, semantic understanding of physical interaction that can be unlocked for complex, contact-rich tasks.

Our core contribution is an architecture that deeply fuses tactile sensing as a native modality, creating the essential bridge between the VLM’s abstract knowledge and the dynamics of physical force.

By connecting the VLM to tactile sensors with only a few demonstrations, we have shown it is possible to unlock this powerful prior knowledge to achieve zero-shot generalization in tasks requiring nuanced physical interaction.

这是一篇提交给 ICLR 2026 的会议论文,提出了一种融合视觉、语言、动作和触觉感知的机器人学习框架。

一、核心问题与动机

1.1 现有VLA模型的局限

当前Vision-Language-Action (VLA)模型(如RT-1, RT-2, π0)在高层推理和规划方面表现出色,但在接触丰富的物理交互场景中存在明显不足:

- 缺乏精确的力控制能力

- 无法将抽象的语言指令(如"轻轻地"、“用力地”)转化为具体的物理力输出

- 视觉在接触过程中常被遮挡,导致感知不准确

1.2 核心洞察

论文的关键发现是:预训练的VLM已经包含了关于物理交互的隐式语义知识,只是缺乏与真实触觉传感器的连接来激活这些知识。

二、方法架构

2.1 整体架构(图2)

Tactile-VLA采用多模态token级融合架构:

输入模态 → 编码器 → Token序列 → Gemma-2.6B (VLM主干) → 触觉感知动作专家(300M) → 输出

| 模态 | 编码器 | 处理方式 |

|---|---|---|

| 视觉 | ViT | 编码最近H帧图像为token集合 |

| 语言 | Tokenizer | 标准文本token化 |

| 触觉 | MLP编码器 | 将H帧触觉测量拼接为融合token |

| 本体感知 | MLP编码器 | 编码机器人状态 |

2.2 关键创新点

(1) 动作空间扩展:力-位混合输出

不同于传统VLA只输出位置,Tactile-VLA的动作专家输出增强动作向量:

a t = [ P t a r g e t , F t a r g e t ] \mathbf{a}_t = [P_{target}, F_{target}] at=[Ptarget,Ftarget]

- P t a r g e t P_{target} Ptarget: 目标位置

- F t a r g e t F_{target} Ftarget: 目标接触力

这使得模型能学习"轻轻地插入USB"(低力)vs"用力地插入USB"(高力)的区别。

(2) 混合位置-力控制器(2.2节)

采用位置主导的间接力控制策略:

P h y b r i d = P t a r g e t + { K ⋅ Δ F if ∥ Δ F ∥ > τ 0 otherwise P_{hybrid} = P_{target} + \begin{cases} K \cdot \Delta F & \text{if } \|\Delta F\| > \tau \\ \mathbf{0} & \text{otherwise} \end{cases} Phybrid=Ptarget+{K⋅ΔF0if ∥ΔF∥>τotherwise

- 当力误差超过阈值 τ \tau τ时,通过增益矩阵 K K K将力误差转换为位置修正

- 使用PID控制器跟踪动态更新的 P h y b r i d P_{hybrid} Phybrid

- 关键设计:解耦外力控制(夹爪笛卡尔位置)和内部抓握力控制(夹爪宽度)

(3) Tactile-VLA-CoT:推理增强变体(2.3节)

通过**链式思维(Chain-of-Thought)**机制实现自适应推理:

触发条件:固定间隔检查任务状态

↓

判断:任务是否成功完成?

↓

若失败 → 分析触觉反馈(如"剪切力应更大,法向力已足够")

↓

生成纠正指令(如"再次擦拭,但施加更大向下力")

↓

执行新策略

训练时使用包含失败案例和纠正推理标注的小规模数据集进行微调。

三、实验验证

3.1 三个核心研究问题

| RQ | 问题 | 对应实验 |

|---|---|---|

| RQ1 | 能否解释和泛化抽象的力相关语言指令? | 充电器/USB插拔任务(3.2节) |

| RQ2 | 能否利用VLM常识推断合适的交互力? | 桌面抓取任务(3.3节) |

| RQ3 | 触觉反馈能否支持物理失败推理和自适应调整? | 擦黑板任务(3.4节) |

3.2 实验结果分析

实验1:触觉感知指令遵循(表1、表2)

任务设计:

- Task A (USB插拔):训练时包含"softly"/"hard"等力相关语言指令

- Task B (充电器插拔):仅学习运动,无力相关语言指令

关键结果:

- 成功率:Tactile-VLA在USB任务达35%,充电器任务达90%,远超π0-base (5%/40%) 和 π0-fast (0%/25%)

- 力的泛化(表2):

| 指令 | 训练任务(USB) | 零样本任务(Charger) |

|---|---|---|

| softly | 0.51N | 4.68N |

| hard | 2.57N | 9.13N |

| gently (未见) | 0.75N ✓ | - |

| firmly (未见) | 1.98N ✓ | - |

| harder (未见,超出训练范围) | 2.94N > 2.57N ✓ | - |

核心发现:模型不仅记住了训练映射,还能插值(gently介于softly-hard之间)和外推(harder > hard),并将这种理解迁移到零样本任务。

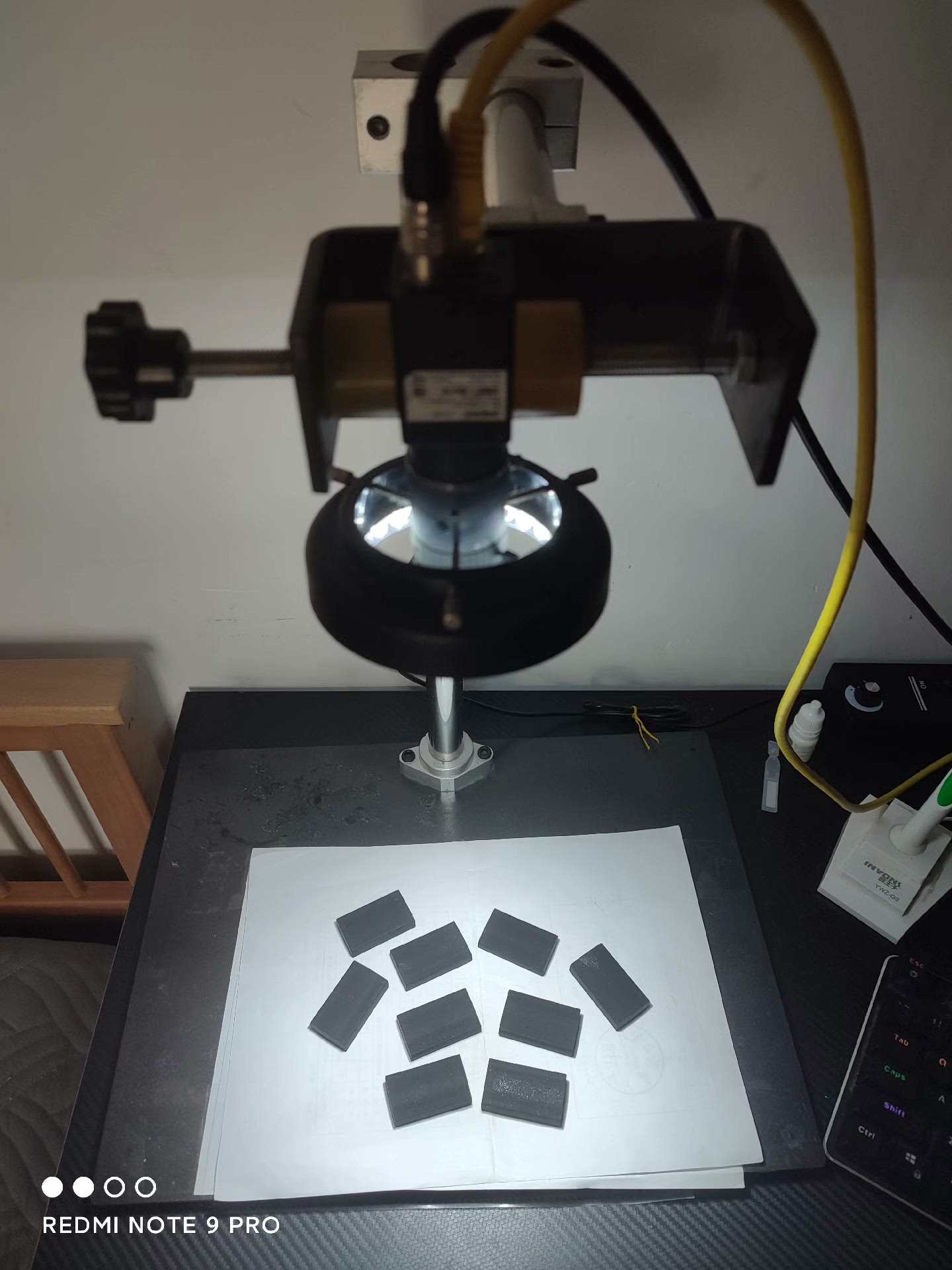

实验2:触觉相关常识(表3、图6)

设置:训练6个域内物体,测试6个域外物体,分为三类:

- Solid & Heavy(铁块、电池)→ 期望大力

- Solid & Light(木头、充电器)→ 期望中力

- Fragile & Light(火龙果、甜瓜)→ 期望小力

结果:

- Tactile-VLA在域外物体上保持90%+成功率,而基线在易碎物体上几乎全失败(0-10%)

- 力的分布(图6):模型自动为重型物体施加大力(6N),轻型中等(2N),易碎轻柔(~0.8N),且域内外分布一致

证明:模型确实激活了VLM中关于物体物理属性的常识知识。

实验3:触觉参与推理(表4、图7)

设置:

- 训练:在白板上擦除记号笔(包含成功/失败案例及纠正推理标注)

- 零样本测试:在黑板上擦除粉笔(需要更大力)

结果:

- Tactile-VLA-CoT在白板成功率80%,黑板通过推理自适应达到75%

- 基线π0在黑板任务上完全失败(0%)

- 推理过程:初始尝试3.5N失败 → 分析"法向力太低" → 自主增至6.7N(比训练数据中的5N还高34%)→ 成功

四、核心贡献总结

-

架构贡献:首个深度融合触觉感知的VLA框架,通过混合控制器将VLM的隐式物理知识转化为精确的力控制

-

学习范式贡献:证明仅需少量演示即可"解锁"VLM预存在的物理交互知识,实现零样本泛化

-

推理能力贡献:Tactile-VLA-CoT展示了基于触觉反馈的自主故障诊断和策略调整能力

五、局限性与未来方向

当前局限(附录C):

- USB插入成功率仍较低(35%),困难在于空中对准

- 光照条件不利时可能定位失败

潜在改进:

- 更大规模的机器人数据集训练

- 更复杂的推理触发机制(非固定间隔)

- 多手指灵巧手扩展

六、与相关工作的对比

| 工作 | 方法 | 与Tactile-VLA的区别 |

|---|---|---|

| FuSe (Jones et al., 2025) | 使用辅助损失微调 | Tactile-VLA直接连接VLM隐式知识,无需复杂微调 |

| ForceVLA (Yu et al., 2025) | 模态特定路由 | Tactile-VLA采用统一token级融合,支持CoT推理 |

| π0 (Black et al., 2024) | 基础VLA模型 | 无触觉融合,无法区分力相关语言 |

这篇论文的核心价值在于架起了抽象语义知识与具体物理控制之间的桥梁,展示了大规模预训练模型中的隐式知识如何通过适当的感知-动作接口被"激活"用于真实机器人控制。

DAMO开发者矩阵,由阿里巴巴达摩院和中国互联网协会联合发起,致力于探讨最前沿的技术趋势与应用成果,搭建高质量的交流与分享平台,推动技术创新与产业应用链接,围绕“人工智能与新型计算”构建开放共享的开发者生态。

更多推荐

已为社区贡献12条内容

已为社区贡献12条内容

所有评论(0)