机器人操作的可信评估:一种新的基准测试和自动评估方法

26年1月来自北大、腾讯和中科院计算所的论文“Trustworthy Evaluation of Robotic Manipulation: A New Benchmark and AutoEval Methods”。在视觉-动作(VA)和视觉-语言-动作(VLA)模型快速发展的推动下,模仿学习显著提升机器人的操作能力。然而,评估方法却相对滞后,阻碍这些行为可信评估的建立。现有范式主要依赖于二元成

26年1月来自北大、腾讯和中科院计算所的论文“Trustworthy Evaluation of Robotic Manipulation: A New Benchmark and AutoEval Methods”。

在视觉-动作(VA)和视觉-语言-动作(VLA)模型快速发展的推动下,模仿学习显著提升机器人的操作能力。然而,评估方法却相对滞后,阻碍这些行为可信评估的建立。现有范式主要依赖于二元成功率,未能解决信任的关键维度:来源真实性(即区分真实的策略行为和人类远程操作)和执行质量(例如,流畅性和安全性)。为了弥补这些不足,提出一种结合 Eval-Actions 基准测试和 AutoEval 架构的综合解决方案。首先,构建 Eval-Actions 基准测试以支持可信度分析。与仅限于成功人类演示的现有数据集不同,Eval-Actions 创新性地将 VA 和 VLA 策略执行轨迹与人类远程操作数据相结合,并明确包含失败场景。该数据集围绕三个核心监督信号构建:专家评分(EG)、排序引导偏好(RG)和思维链(CoT)。基于此,提出AutoEval架构:AutoEval Small(AutoEval-S)利用时空聚合进行语义评估,并辅以运动学校准信号来提升运动平滑度;AutoEval Plus(AutoEval-P)则融合组相对策略优化(GRPO)范式,以增强逻辑推理能力。AutoEval展现出卓越的评估精度,在EG和RG协议下分别实现0.81和0.84的Spearman等级相关系数(SRCC)。更重要的是,该框架拥有强大的源区分能力,能够以99.6%的准确率区分策略生成的视频和远程操控的视频,从而为可信的机器人评估建立严格的标准。

机器人学习数据集

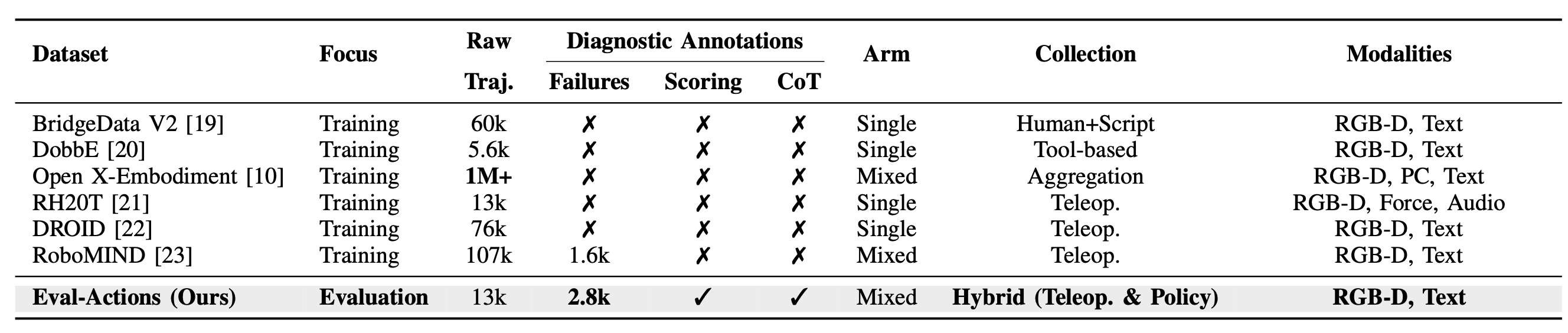

高质量的数据集推动数据驱动型机器人操作领域的最新进展。BridgeData V1 和 V2 [19]、[24] 等开创性项目通过收集大量的单臂远程操作轨迹,确立数据规模对于策略泛化的重要性。遵循这一范式,DobbE [20] 和 DROID [22] 等项目通过分布式采集协议扩展操作数据的多样性。为了应对跨具身泛化的挑战,Open X-Embodiment (OXE) 数据集 [10] 汇集来自全球实验室的超过一百万条轨迹,是迄今为止规模最大的合作项目之一。此外,RH20T [21] 通过整合力信号和音频等多模态信号,丰富这些资源,从而促进灵巧操作任务的实现。

尽管取得了这些成就,但仍存在一个关键差距:现有数据集主要针对模仿学习而构建,几乎完全侧重于成功的专家演示。如表所示,主流基准测试(例如 OXE [10]、DROID [22])大多忽略失败场景,而这些场景对于学习错误恢复和鲁棒的失败检测至关重要。虽然像 RoboMIND [23] 这样的近期研究已经开始引入失败子集,但该领域仍然缺乏诊断策略行为所需的细粒度标注。大多数评估仅依赖于二元的“成功率”,忽略诸如精细动作质量评分和 CoT 推理等密集监督信号。

动作质量评估 (AQA)

动作质量评估 (AQA) 量化动作的执行质量,这与动作识别的分类任务截然不同。该领域在计算机视觉领域得到了广泛的研究,并在竞技体育(例如跳水、体操、篮球)的评分 [33]–[36] 和外科手术技能的评估 [37]、[38] 等方面得到了广泛的应用。

然而,在通用机器人操作领域,AQA 仍处于起步阶段。与人类体育运动中美学表现通常是主要评判标准不同,机器人 AQA 必须优先考虑功能性指标,例如轨迹平滑度、安全裕度和执行效率。目前的机器人评估方法主要局限于二元成功检测,无法捕捉执行过程的精细质量。所提出的 Eval-Actions 基准旨在通过将 AQA 范式正式应用于机器人领域来弥合这一领域差距,从而能够精确量化细粒度动作质量,为可信评估建立严格的标准。

Eval-Actions 基准测试和 AutoEval 架构

为了弥补这一差距,引入 Eval-Actions 基准测试。与以训练为中心的数据集不同,Eval-Actions 专为可信评估而设计。它包含 13000 条轨迹,涵盖单臂和双臂任务,更重要的是,它整合大量的失败数据(2800 条)和来自不同来源的轨迹数据(远程操作和策略),以及动作质量评分和 CoT 标注。这种组合方式使得评估标准从简单的二元成功指标转变为对执行质量和数据来源真实性的诊断性评估。

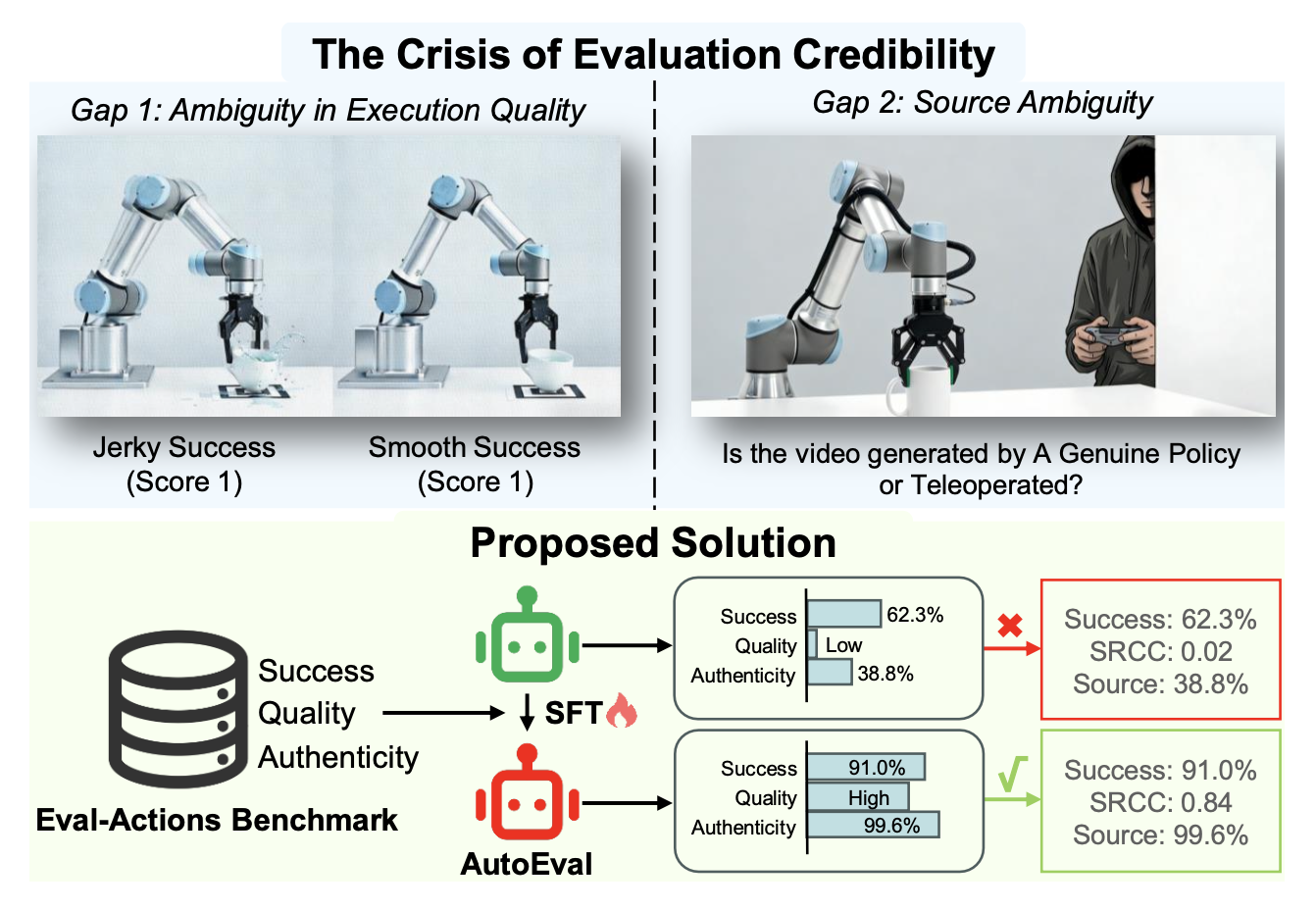

要真正验证机器人实际部署能力,必须回答两个基本问题:“任务执行得如何?”(差距GAP 1:执行质量)以及“执行是否真正自主?”(差距GAP 2:真实性)。目前的框架无法对这两个问题给出明确的答案。如图中的差距GPA 1所示,当前的评估指标主要忽略机器人在执行过程中动作的质量,而侧重于任务的成败二元判断。例如,假设一项任务要求将杯子放置在特定位置。如果模型 A 经过多次试错后完成任务,但动作抖动严重,导致动作僵硬且效率低下;而模型 B 则以流畅、精细且稳定的动作完成同一任务,那么传统的评估指标会不加区分地将两个模型都判定为成功(得分 1)。这种简单的二元方法无法区分模型 B 更高的可靠性,掩盖模型 A 不稳定行为中隐藏的潜在安全风险。

因此,当前的基准测试难以识别出既能成功又能安全可靠地应用于实际场景的策略。为了解决这一局限性,本文引入“细粒度动作质量”作为核心评估标准。与二元指标不同,此指标定义为对执行过程的全面评估,明确量化任务完成情况之外的流畅性、安全性、效率。为了稳健地衡量这一指标,框架整合专家评分(EG)、排序引导偏好(RG)和思维链(CoT)这三种监督信号,从而建立一个整体的真实值,使算法评分与人类对可信行为的标准保持一致。此外,引入 Eval-Actions,这是一个融合这些详细标注的基准测试,为评估策略可靠性提供诊断基础。作为补充,提出 AutoEval,一个统一的框架,旨在通过同时验证任务成功和评估细粒度执行质量来精确评估机器人学习策略。

目标是通过准确评估细粒度动作质量和验证来源真实性,为VLA和VA策略建立一个可信的评估框架。为此,构建Eval-Actions基准测试平台,该平台包含添加细粒度质量标注的人机演示视频。

数据集构建

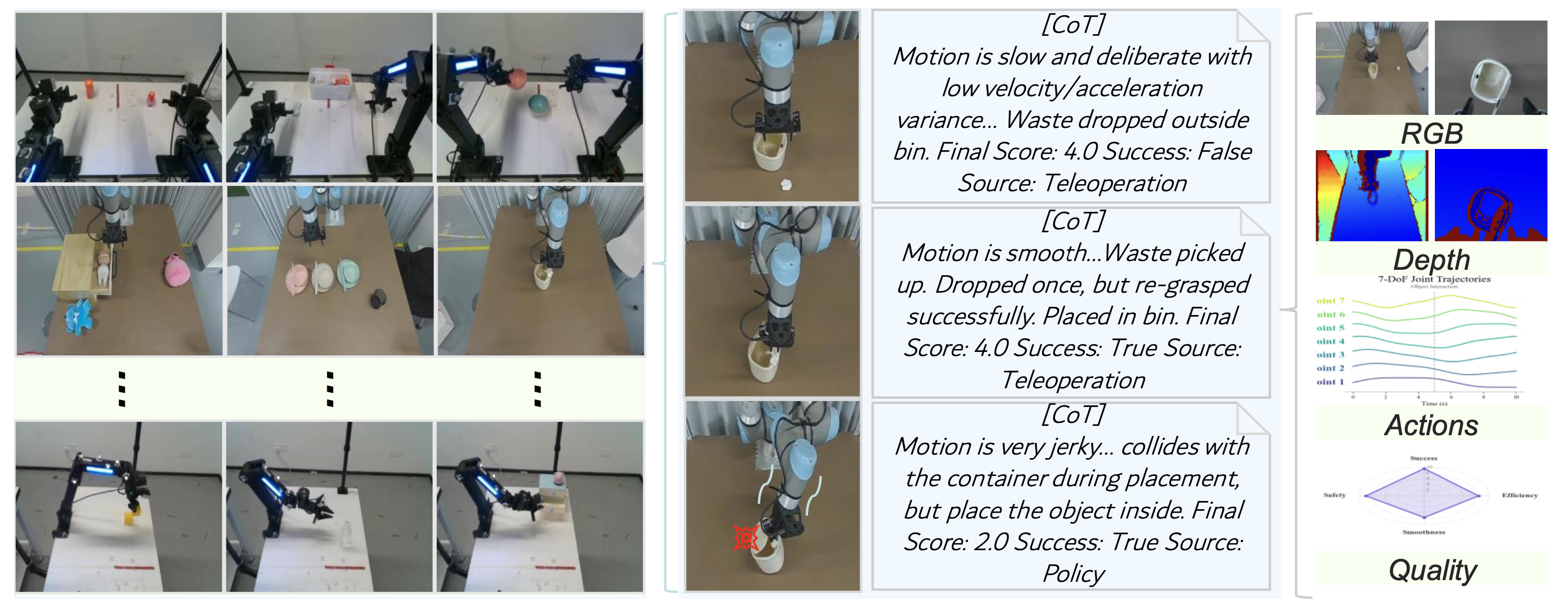

为了克服现有基准数据集在评估维度上的局限性,提出如图所示的 Eval-Actions 数据集。该数据集涵盖单臂和双手协作场景,例如碗堆叠和盘子传递。Eval-Actions 数据集总时长约为 52 小时,包含超过 13,000 个演示片段,涵盖 150 多个不同的任务,并使用多种不同的机械臂配置(例如 ARX R5、UR5)。

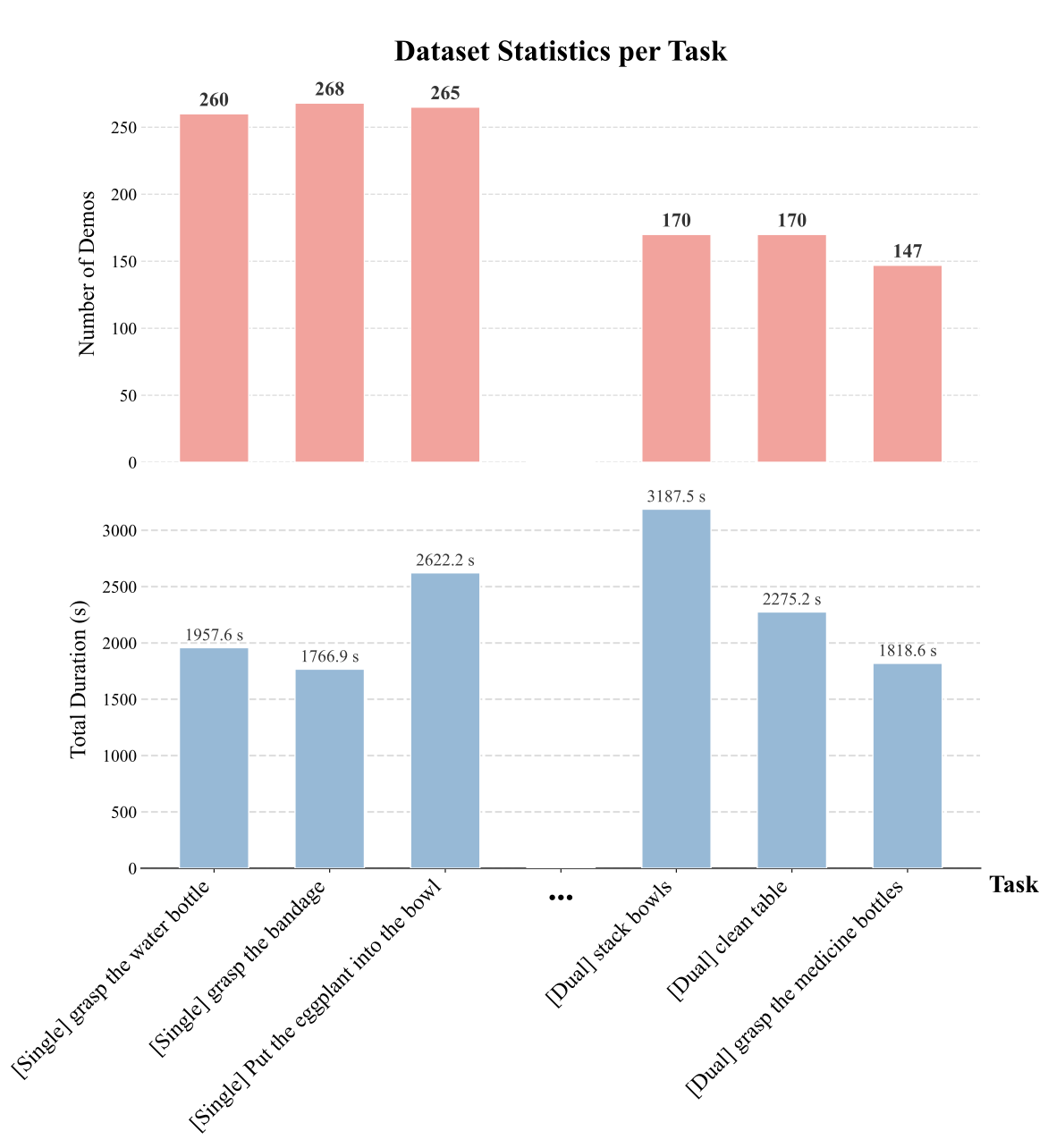

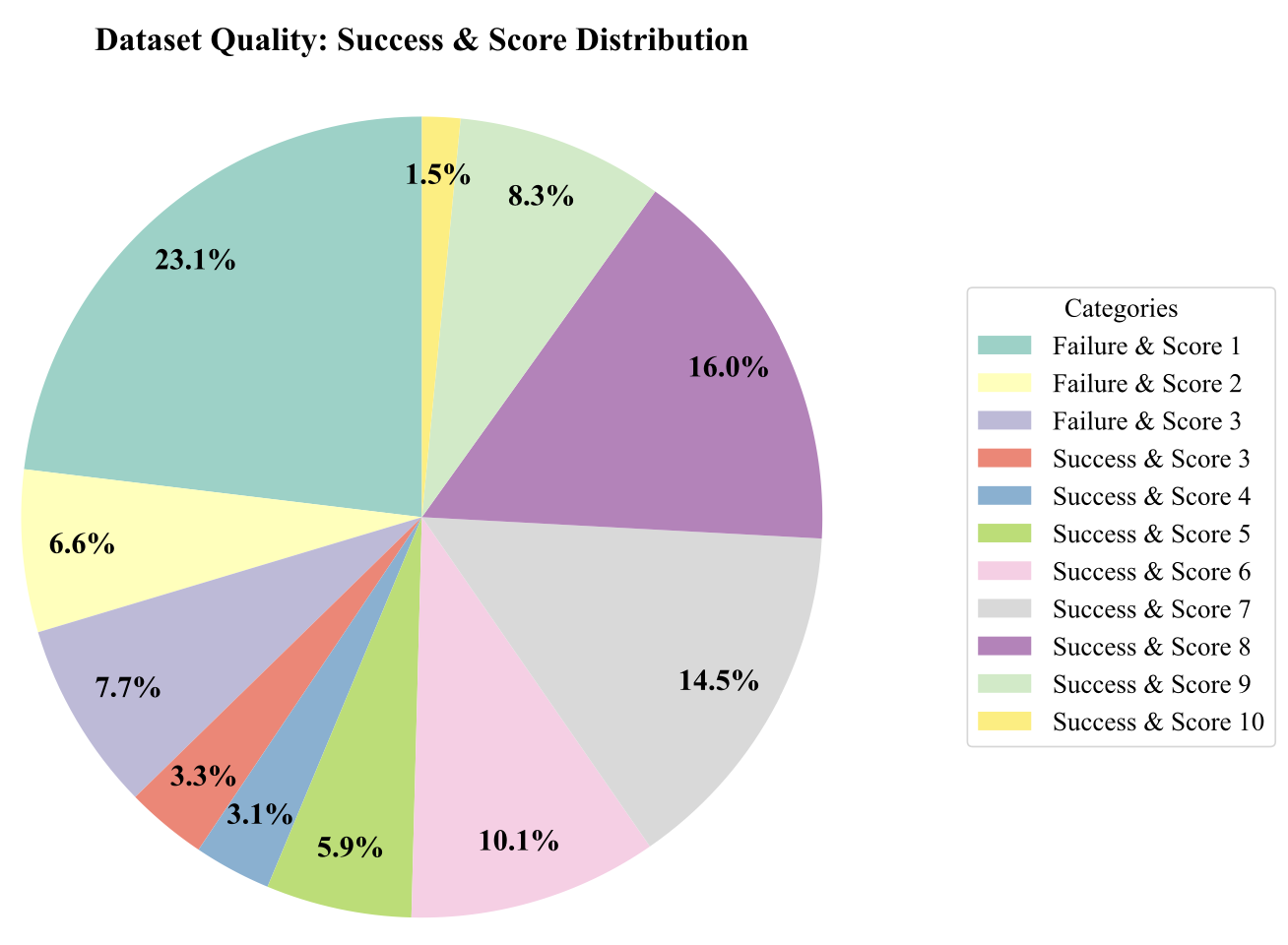

如图所示数据的统计分析:

与主要依赖于成功人类远程操作数据的 RT-1 [15] 或 OXE [10] 等数据集不同,Eval-Actions 引入两个关键特征。首先,该数据集采用混合采集策略,不仅聚合来自20位具有不同专业背景的人类操作员的数据,还聚合不同架构(包括VA和VLA模型)下机器人策略生成的执行轨迹数据,旨在支持数据源真实性验证。其次,该数据集整合失败数据和细粒度质量标注。与仅限于成功演示的标准数据集不同,Eval-Actions数据集明确地包含失败案例以及细粒度的动作质量评分。至关重要的是,该数据集提供这些评分背后的CoT推理过程,为训练透明且可信的评估模型奠定了基础。每个样本都包含丰富的多模态信息,包括RGB-D录像(来自腕戴式和第三人称视角)、文本任务描述、动作轨迹、任务成功指标以及三种类型的诊断标注。此外,为了解决策略生成数据的分布问题,设计一个专门的评估子集(Eval-Actions Small,简称EAS),旨在明确区分遥控操作轨迹和策略生成轨迹,并验证任务执行结果。

数据标注与细粒度动作质量定义

为了减少人工评估的主观性,建立一套标准化的“细粒度动作质量”协议,该协议基于四个核心维度:成功率、平滑度、安全性和效率。具体而言,成功率是一个二元指标,平滑度通过运动学指标量化,包括关节角速度和加速度方差。安全性通过监测物理异常来评估,特别是对意外碰撞或与环境的危险交互进行惩罚。最后,效率由任务完成时间决定;为了确保不同初始距离下的公平性,将这些时间根据划分空间区域内的基线操作员性能进行归一化。基于这些指标,标注框架整合三种互补的方法,以全面量化细粒度动作质量:

专家评分 (EG)。如图所示,邀请 10 位人类专家评估动作质量,根据流畅性、安全性和效率将技能分为三个等级(优秀、良好、差)。最终的真实值取自这些评分的平均值,以最大限度地减少个人偏见。

排序引导的权重优化 (RG)。该方法将计算指标与人类直觉相结合。专家首先对一批又一批的动作视频进行排序。然后,构建一个综合评分——综合考虑流畅性、成功指标、碰撞惩罚和人类评分——并使用遗传算法 (GA) 优化权重,以最大限度地减少评分与专家排序之间的差异。

思维链标注 (CoT)。为了增强可解释性,域专家不仅提供数值质量评分,还提供详细的思路链推理,为每项评估提供明确的依据。

数据集统计信息

Eval-Actions 数据集包含约 52 小时的操作视频,涵盖 150 项不同的机器人任务,包括抓取、放置、推动和其他基本动作。该数据集包含 20 位具有不同专业背景(例如机器人工程师、学生和非专业人士)的人类操作员的演示,以及由多个 VLA 和 VA 策略生成的轨迹。该数据集共包含 13,000 条带标注的动作轨迹,平均每条轨迹持续时间为 14 秒。

在 Eval-Actions 数据集中,相机配置根据不同的机器人形态而变化,涵盖头部、正面和腕部视角等。具体而言,在 Eval-Actions Small (EAS) 数据集中,每个样本都配有同步的多视角录像:(1) 腕部相机视角,(2) 头部相机视角,以及 (3) 静态第三人称视角。此外,每条轨迹都包含完整的7自由度关节角度和末端执行器状态、任务描述、二元成功标志、部署环境(真实世界或仿真)以及由专家评估和客观指标计算得出的综合质量评分。

如上图所示,该数据集在EG上呈现出多样化的评分分布(1-10分)和成功结果。具体而言,37.4%的轨迹为失败,主要集中在最低质量等级(评分1,23.1%)。其余62.6%为成功执行,展现出广泛的质量范围。值得注意的是,高质量的演示也得到充分体现,仅评分8就占16.0%,确保次优示例和高保真示例之间的稳健平衡。

基于排序的权重优化

确定运动学指标和惩罚因子的最佳相对重要性并非易事。为了使自动评估与人类专家的判断保持一致,构建一个超参优化问题。

令 θ = {w_vel, …, w_len, λ_coll, λ_fail} 表示可调参数向量。首先将原始算法得分 S_raw 定义为归一化运动学指标的加权组合。关键在于,如果违反安全或成功约束,则在聚合之前,相应的运动学指标 s_i 会受到除数 λ ∈ θ 的惩罚:S_raw(θ)。

采用遗传算法 (GA) 来搜索最优参数 θ∗,以最小化 S_raw 与真实专家排名 R_human 之间的排名差异。该优化过程使用实值编码和锦标赛选择,损失函数定义为平均绝对排名差:L(θ)。

由于优化目标 L 仅关注相对排序,因此 S_raw(θ∗) 的大小可能与人类评分范围(例如,0-10)不同。为了确保一致性,最终通过 Z 分数归一化进行分布对齐。计算最终校准分数 S_final,其中 μ_raw 和 σ_raw 分别是使用最优权重 θ∗ 计算得到的数据集原始分数统计均值和标准差,而 μ_human 和 σ_human 则是从专家标注中获得的相应统计量。

AutoEval

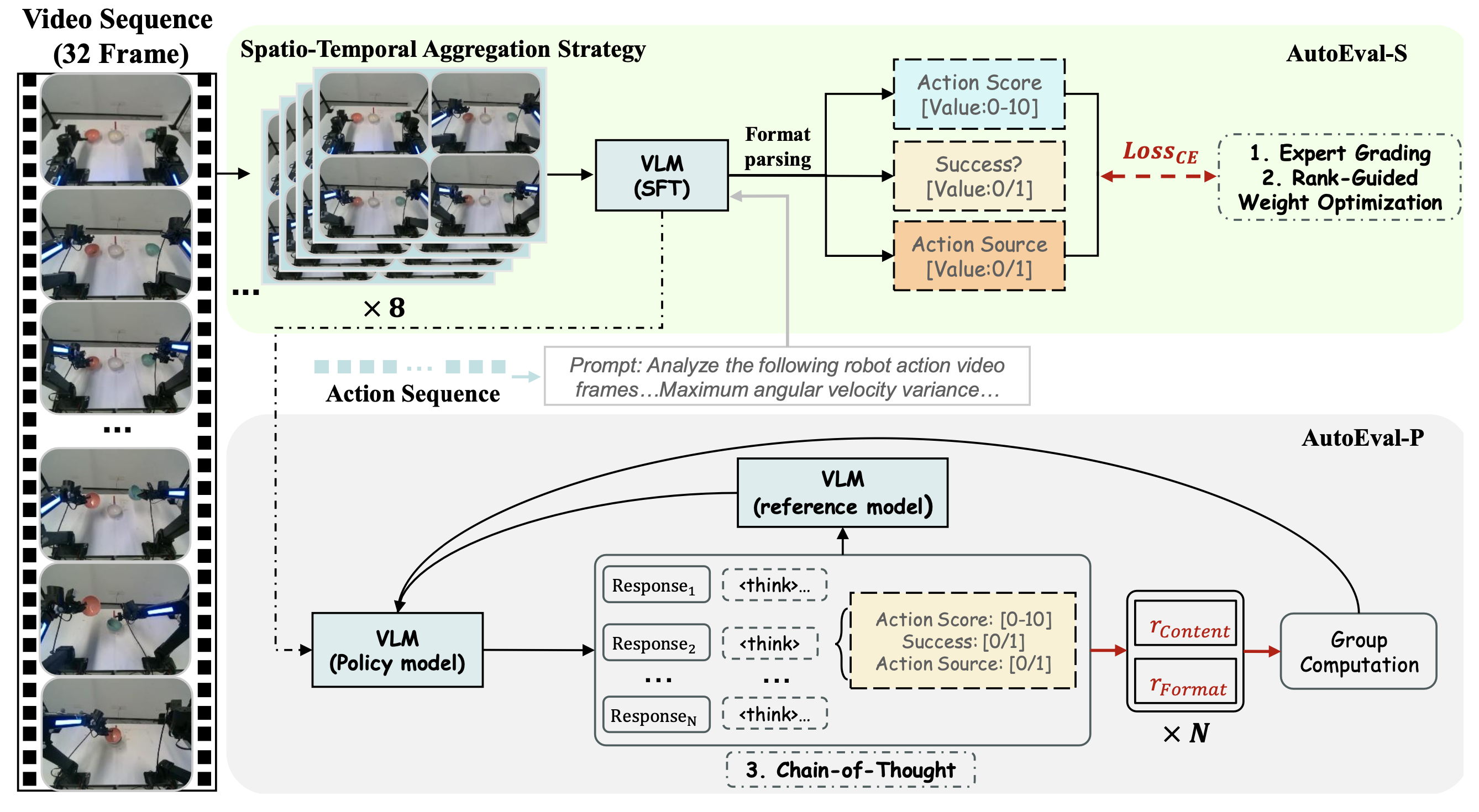

为了应对三种 GT 标签粒度的差异,建立一个统一的评估框架,该框架针对特定的评估目标进行定制。具体而言,对 EG 和 RG 任务采用 AutoEval-S 架构,而将增强型 AutoEval-P 变型用于更复杂的基于 CoT 的动作质量评估。

对于给定的时间长度为 T 的操作片段,视觉输入被离散化为 N 个关键帧的序列 F = {f_i},其中 N ≤ T。为了弥合运动学数据和语义理解之间的差距,将动作轨迹表示为一个联合状态矩阵 Q,其中 J ∈ {7, 14} 表示自由度。通过离散一阶差分运算(假设时间间隔为单位时间)导出瞬时角速度 v_t 和角加速度 α_t:v_t = q_t − q_t−1,α_t = v_t − v_t−1,其中 q_t 表示时间步 t 的关节构型。为了量化运动平滑度并识别潜在的机械抖动,计算速度和加速度的时间方差向量,分别记为 s_v 和 s_α。采用最坏情况公式来捕捉不稳定性,将均匀性指标 (U_v , U_α ) 定义为所有关节的最大方差,并计算平均绝对速度 μ_v 来表示全局运动强度。

这些导出的物理指标被序列化为结构化的文本描述符 I_phys。将 I_phys 作为辅助运动学标定信号。它通过提供明确的运动统计数据来补偿视频压缩伪影,确保精确量化平滑度,同时又不影响语义评估。因此,由 θ 参数化的多模态模型 Φ_θ 同时处理视觉关键帧和物理感知提示,以回归动作质量评分 Sˆ、预测任务成功 Oˆ(成功/失败)以及对轨迹源 Cˆ 进行分类(策略 vs. 远程操作)。

AutoEval-S。在 AutoEval-S 框架中,虽然增加采样帧数 N 可以增强时间推理能力,但也会带来沉重的计算负担,表现为过多的视觉tokens和过高的显存占用。为了缓解时间分辨率和计算效率之间的权衡,提出一种时空聚合策略,如图AutoEval框架的上图所示。该策略并非丢弃两个连续关键帧 f_i 和 f_i+1 之间的密集帧,而是将 k 个中间帧与目标关键帧 f_i+1 进行空间拼接,生成一幅合成图像。然后,将该合成图像调整到标准编码器分辨率,得到一个精细化的序列 F′ = {f_i′}。接下来,利用监督微调 (SFT) 对这些聚合后的输入进行 VLM 优化。该技术将高频运动细节压缩到固定的token预算内,最大化时间信息密度,从而在不增加参数开销的情况下捕捉动态运动模式。

在模型优化方面,将动作质量评估、成功检测和来源分类整合为一个统一的条件文本生成任务。通过将标量质量得分 S、成功标签 O 和源标签 C 序列化为结构化的文本格式,构建真实目标序列 Y。该模型经过训练,能够自回归地生成此序列,最小化给定多模态上下文的真实标记的负对数似然值。其中,L 是目标文本序列的长度,y_t 表示 Y 中的第 t 个token,y_<t 表示前面的上下文token,θ 参数化 VLM (Φ_θ)。这种公式确保模型能够学习以连贯的语言格式将多模态输入显式地映射到精确的定量 (S) 和类别 (O, C) 输出。

AutoEval-P. 针对CoT生成的复杂性,采用组相对策略优化(GRPO)范式[39][40],并结合强化学习(RL)来增强VLM的物理推理能力。将训练问题建模为一个策略优化问题,并采用混合奖励函数R_total来指导训练,该函数旨在鼓励逻辑自洽的推理。

奖励架构首先处理连续动作质量评分。为了缓解回归任务中二元奖励的稀疏性,构建一个基于高斯核的软回归机制。给定预测分数Sˆ(从CoT输出解析而来)和真实值S,评分奖励R_score被定义为平方误差的指数衰减函数,并由灵敏度超参σ进行调节。

对于二元分类任务,将预测的任务成功率 Oˆ 和来源 Cˆ 与其各自的真实值 O 和 C 进行比较。采用指示函数 I(·) 来生成离散奖励 R_succ = I(Oˆ = O) 和 R_src = I(Cˆ = C)。为了平衡每个子任务的贡献,将综合内容准确率奖励 R_acc 表示为加权求和,其中 ω_score、ω_succ 和 ω_src 分别表示任务特定的权重:R_acc = ω_score · R_score + ω_succ · R_succ + ω_src · R_src。

此外,为了防止在探索阶段出现结构退化,引入格式奖励 R_fmt,用于对生成的文本结构施加约束。最终的全局奖励 R_total 计算为内容和格式分量的线性组合,并由平衡因子 γ 控制:R_total = (1−γ)·R_acc +γ ·R_fmt。

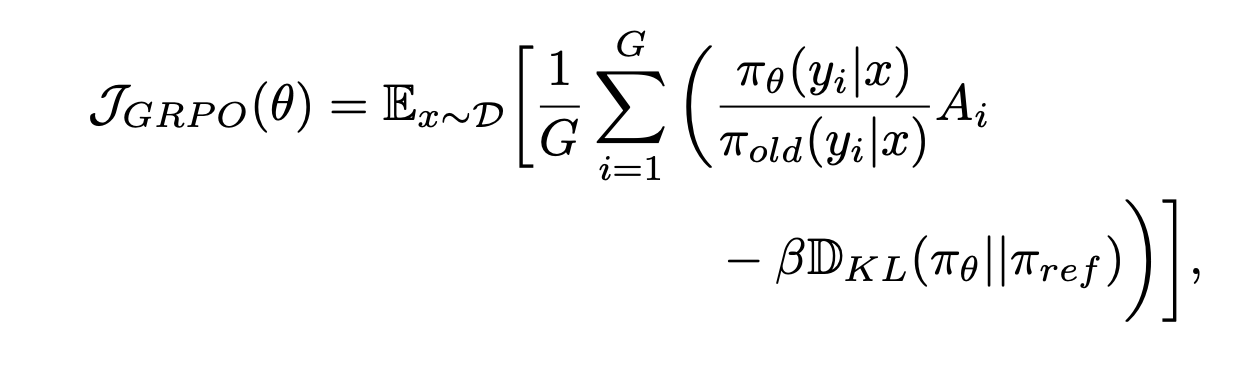

根据全局奖励的定义,采用 GRPO 算法高效地更新模型参数 θ。GRPO 相较于标准 PPO 具有显著优势,因为它无需单独的价值网络,从而降低计算量。具体而言,对于每个输入查询 x = (F, I_phys),将 VLM Φ_θ 视为随机策略 π_θ。从当前策略 π_θ 中采样 G 个不同的 CoT 输出 {y_1, y_2, …, y_G}。

首先,计算每个输出的总奖励,并导出优势值 A_i。为了稳定训练并降低方差,通过分组归一化来构建优势估值,其中 μ_group 和 σ_group 分别表示采样组内奖励的均值和标准差,ε 是一个用于保证数值稳定性的较小常数。最终的优化目标是最大化期望策略梯度。为了防止模型过度偏离其初始语言能力(灾难性遗忘),引入 Kullback-Leibler (KL) 散度惩罚,用于惩罚当前策略 π_θ 和参考策略 π_ref 之间的散度。GRPO 目标函数 J_GRPO 的形式化定义如下:

其中 β 控制 KL 正则化的强度,以确保增强的推理能力不会影响模型的语言流畅性。

DAMO开发者矩阵,由阿里巴巴达摩院和中国互联网协会联合发起,致力于探讨最前沿的技术趋势与应用成果,搭建高质量的交流与分享平台,推动技术创新与产业应用链接,围绕“人工智能与新型计算”构建开放共享的开发者生态。

更多推荐

已为社区贡献155条内容

已为社区贡献155条内容

所有评论(0)