具身智能视觉、触觉、力觉、听觉等信息如何实时对齐与融合?

具身智能视觉、触觉、力觉、听觉等信息如何实时对齐与融合?

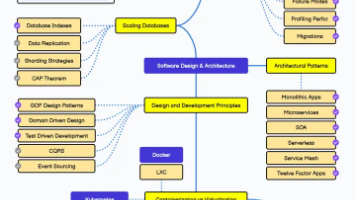

具身智能的核心是让智能体通过与物理世界的持续交互实现目标导向行为,而视觉、触觉、力觉、听觉等多模态信息的实时对齐与融合,是其实现精准感知、高效决策与流畅动作的关键前提——唯有解决不同模态数据的“时空错位”与“语义鸿沟”,才能让智能体真正“看懂、听清、触知、力行”,形成对世界的统一认知并灵活应对动态场景。当前主流技术路径可分为“实时对齐”“特征融合”“工程优化”三大环节,各环节协同联动,兼顾精度、速度与鲁棒性,适配复杂交互场景需求。

一、实时对齐:解决多模态数据的“时空不同步”核心痛点

视觉(摄像头30-60Hz)、触觉/力觉(传感器100-1000Hz)、听觉(麦克风阵列16-48kHz)的采集频率、延迟特性、时间戳精度差异显著,且不同传感器的安装位置(如摄像头在头部、触觉传感器在机械臂末端)会导致空间感知偏差,若直接融合会引入严重误差。实时对齐需从“时间对齐”和“空间对齐”双维度入手,实现数据的同步校准,为后续融合奠定基础。

(一)时间对齐:实现多模态数据的时序同步

时间对齐的核心是将不同模态的数据流映射到统一时间基准,消除采集异步、延迟不一致带来的错位问题,主流方法分为硬件同步与软件补偿两类,实际部署中常组合使用:

- 硬件级同步:通过统一时钟协议或硬件触发机制,强制各传感器同步采集。例如采用PTP(精密时间协议)或NTP协议搭建统一时间基准,实现跨设备时钟同步;对支持硬件触发的传感器(如深度相机Realsense D455),启用内置硬同步模式,让视觉与惯性传感器(IMU)同步采集;对麦克风阵列与力觉传感器,通过GPIO脉冲触发信号,确保数据采集起始时间一致,可将时间对齐误差控制在±5ms以内,满足高实时性需求。

- 软件级补偿:针对不支持硬件同步的异构传感器,通过算法弥补时序错位。常用方法包括时间戳最近邻匹配、线性/样条插值重采样,以及运动模型辅助预测。例如构建“时间对齐缓冲区”,为每种模态维护带时间戳索引的环形队列,当某一模态数据到达时,在预设时间窗口内搜索其他模态的最近数据包,通过插值补充缺失数据;针对动态场景,引入扩展卡尔曼滤波(EKF)对力觉与视觉轨迹进行状态估计与外推,修正异步采集带来的偏差,同时抑制传感器噪声。

(二)空间对齐:实现多模态感知的位置校准

空间对齐的核心是建立不同模态传感器的坐标映射关系,确保视觉“看到”、触觉“摸到”、听觉“听到”的目标对应物理世界的同一位置,主流方法分为坐标标定与语义关联两类:

- 坐标系统一与标定:以智能体自身坐标系(如机器人基坐标系)为基准,通过手眼标定(Eye-in-Hand/Eye-to-Hand)建立视觉传感器与机械臂(触觉/力觉传感器安装于末端)的坐标转换矩阵;通过声呐定位或麦克风阵列标定,将听觉声源位置映射到三维空间坐标系;利用IMU数据辅助姿态校准,补偿智能体运动过程中传感器位置偏移带来的误差,实现“视觉定位-触觉接触-听觉溯源”的空间统一。

- 语义级空间关联:针对复杂场景中传感器遮挡、视角偏差等问题,结合语义信息强化空间对齐。例如通过视觉目标检测提取物体轮廓、位置特征,通过触觉传感器感知物体表面纹理、形状,通过跨模态注意力机制关联二者语义特征,即使视觉视角变化,也能通过触觉特征校准物体空间位置;对于听觉信息,结合视觉唇动分析、环境噪声定位,实现声源位置与视觉目标的精准关联,避免“听声辨位”与“视觉观察”的空间错位。

二、特征融合:打破多模态“语义鸿沟”,形成统一认知表征

实时对齐解决了多模态数据的“时空同步”问题,而特征融合则需打破不同模态的“语义壁垒”——视觉侧重环境与物体的外观、位置信息,触觉侧重物体表面质感、硬度等物理属性,力觉侧重交互过程中的作用力、力矩反馈,听觉侧重语音指令与环境声音线索,通过融合策略将这些异构特征映射到统一语义空间,形成更全面、鲁棒的认知表征,支撑后续决策与动作规划。主流融合策略分为三个层级,可根据场景需求灵活选择或组合使用:

(一)早期融合:原始数据层拼接,适用于强相关模态

早期融合(原始数据层融合)直接对经过预处理(滤波、归一化、同步对齐)的原始传感器数据进行拼接,再输入模型提取特征。例如将视觉图像像素数据与触觉传感器的压力矩阵数据拼接,或将力觉的六维力/力矩数据与听觉的音频波形数据融合,适用于模态间强相关、数据维度相近的场景(如机器人精细抓取中,视觉与触觉的原始数据联动)。

该方法的优势是保留了多模态数据的原始细节,计算开销较低、实时性强;局限性是易受传感器噪声干扰,且要求各模态数据严格同步,不适用于异构性强的模态组合(如视觉图像与听觉音频)。实际部署中,常对原始数据进行预处理(如噪声滤波、数据归一化),降低干扰后再进行融合。

(二)中期融合:特征层动态融合,兼顾精度与灵活性

中期融合(特征层融合)是当前具身智能多模态融合的主流方案,核心是先对各模态数据分别提取特征(如视觉通过CNN提取图像特征、听觉通过RNN提取音频特征、触觉/力觉通过全连接网络提取物理特征),再通过动态融合机制实现特征交互与加权,映射到统一语义空间。该方法既保留了各模态的核心特征,又能通过动态权重适配场景变化,兼顾精度与灵活性。

主流融合机制包括:

- 跨模态注意力机制:通过Query-Key-Value的匹配模式,计算不同模态特征的相关性得分,动态分配权重。例如以视觉特征为Query,触觉、力觉、听觉特征为Key和Value,通过多头跨模态注意力计算各模态的贡献度——抓取柔软物体时,增加触觉(感知柔软度)和力觉(控制作用力)的权重;执行语音指令时,增加听觉(解析指令)和视觉(定位目标)的权重,实现特征的自适应融合。

- 多模态Transformer编码器:构建端到端的融合框架,将各模态特征进行位置编码(增强时序信息)后,输入跨模态注意力层实现语义交互,再通过全局自注意力聚合上下文信息,输出统一的多模态特征表征。例如北京大学MLA模型,采用无编码器的多模态对齐机制,通过空间位置映射与token级对比学习,在大语言模型内部直接对齐视觉、触觉等特征,显著提升复杂操控任务的成功率。

- 图神经网络(GNN)融合:将每种模态视为图节点,利用GNN学习节点间的消息传递函数,建模多模态特征的高阶关联。定义模态节点集合(视觉节点、听觉节点、触觉节点、力觉节点),边权重由注意力得分决定,通过消息更新公式实现各模态特征的动态交互,尤其适用于复杂交互场景中多模态特征的非线性关联建模。

(三)晚期融合:决策层融合,提升鲁棒性与容错性

晚期融合(决策层融合)让各模态独立完成特征提取与决策推理,再通过投票、加权求和等方式整合各模态的决策结果,输出最终结论。例如视觉模态通过目标检测判断物体类别,触觉模态通过纹理识别验证物体属性,力觉模态通过作用力反馈判断抓取稳定性,听觉模态通过语音指令确认任务目标,将四个模态的决策结果进行加权融合,降低单一模态失效带来的风险。

该方法的优势是鲁棒性强、容错性高,某一模态传感器失效(如视觉被遮挡)时,可通过其他模态保障系统正常运行;局限性是忽略了各模态中间特征的语义关联,决策精度略低于中期融合。实际部署中,常与中期融合结合使用,形成“特征层交互+决策层校验”的双重融合机制。

三、工程优化:保障对齐与融合的“实时性”,适配实际部署场景

具身智能多模态对齐与融合需满足“毫秒级响应”(如机器人抓取、人机交互场景),而多模态数据的高维度、高频率会带来较大计算开销,因此需通过工程优化平衡精度与实时性,同时提升系统鲁棒性,适配边缘设备(如Jetson Orin NX)的部署需求。

(一)轻量化模型与计算加速

采用轻量级网络结构降低计算开销,例如用MobileNet、ShuffleNet替代传统CNN提取视觉特征,用力觉/触觉专用轻量化编码器替代全连接网络,用Linformer等注意力变体替代标准多头注意力,在保证特征提取精度的前提下,将计算量降低50%以上;结合硬件加速技术,如利用TensorRT对融合模型进行量化、优化,采用ROS2的rmw_iceoryx中间件实现零拷贝共享内存,减少数据复制开销,将端到端延迟控制在80ms以内,满足实时交互需求。

(二)鲁棒性优化策略

针对复杂环境中的噪声、遮挡、传感器失效等问题,引入鲁棒性增强机制:一是采用模态丢弃训练策略,模拟某一模态失效场景,提升模型对模态缺失的适应能力;二是通过对抗样本训练优化各模态编码器,抵抗视觉噪声、触觉干扰、听觉杂音带来的影响;三是引入世界模型(World Model),构建多模态预测模型,模拟“动作-环境反馈”的关联,提前预判模态数据的变化趋势,补偿传感器延迟或临时失效带来的偏差。

(三)模块化与流式处理架构

基于ROS2的发布-订阅模型构建模块化架构,将各传感器数据采集、时间对齐、特征提取、融合推理拆分为独立节点,每个节点异步运行,通过message_filters库实现近似时间同步,避免单一节点阻塞整个数据流;采用流水线并行与异步处理机制,将耗时操作(如深度学习推理、点云重建)卸载至独立线程或GPU协处理器,确保多模态数据的实时处理与融合,同时提升系统的可扩展性,便于新增传感器模态(如嗅觉、本体感觉)。

四、典型应用场景与落地范式

多模态实时对齐与融合技术已在各类具身智能场景中落地,形成了标准化的技术范式:

- 机器人精细抓取:视觉传感器定位物体位置与轮廓(空间对齐),触觉传感器感知物体表面纹理与硬度,力觉传感器实时反馈抓取作用力,听觉传感器识别环境碰撞声(异常反馈);通过时间戳同步与EKF滤波实现时序对齐,采用跨模态注意力机制融合特征,动态调整抓取力度与轨迹,避免物体滑落或损坏,成功率较单一模态提升30%以上。

- 人机协同交互:听觉传感器解析人类语音指令,视觉传感器捕捉人类手势与面部表情,触觉传感器感知人类接触力度(如协作搬运时的力反馈);通过唇动分析与声源定位实现视听空间对齐,采用中期融合策略关联语音语义与视觉手势特征,让智能体精准理解人类意图,实现自然、流畅的人机协作。

- 复杂环境导航:视觉传感器构建环境语义地图,力觉传感器反馈地面阻力(判断路面状况),听觉传感器识别环境警报声或导航提示音;通过空间坐标标定实现多模态位置对齐,采用晚期融合策略整合各模态决策结果,提升导航的安全性与准确性,即使在视觉遮挡、噪声干扰场景下,也能稳定导航。

五、总结与未来方向

具身智能视觉、触觉、力觉、听觉信息的实时对齐与融合,核心是通过“时空对齐解决同步问题、特征融合打破语义鸿沟、工程优化保障实时鲁棒”,三者协同构建统一的多模态认知体系,是具身智能从“感知”走向“行动”的关键支撑。当前技术已能满足多数场景的实时需求,但在复杂动态环境(如极端噪声、多目标快速交互)、低算力边缘部署、多模态因果推理等方面仍有提升空间。

未来发展方向主要集中在三点:一是探索无监督/自监督跨模态对齐与融合方法,减少对标注数据的依赖;二是结合因果推理与记忆增强网络,提升多模态融合的可解释性与长上下文适应能力;三是推动神经符号系统与多模态融合架构的结合,实现“感知融合-认知决策-动作执行”的闭环进化,让具身智能更灵活、更可靠地适应复杂物理世界。

DAMO开发者矩阵,由阿里巴巴达摩院和中国互联网协会联合发起,致力于探讨最前沿的技术趋势与应用成果,搭建高质量的交流与分享平台,推动技术创新与产业应用链接,围绕“人工智能与新型计算”构建开放共享的开发者生态。

更多推荐

已为社区贡献27条内容

已为社区贡献27条内容

所有评论(0)