【论文自动阅读】技能感知扩散技术实现可泛化的机器人操作

本文提出了一种名为SADiff的技能感知扩散模型,通过显式地引入“技能”级别的信息(如倒水、抓取)来指导机器人生成动作,从而让机器人能举一反三,灵活应对没见过的物体和环境。

快速了解部分

基础信息(英文):

1.题目: Skill-Aware Diffusion for Generalizable Robotic Manipulation

2.时间: 2026.01

3.机构: Shandong University, The University of Manchester

4.3个英文关键词: Robotic manipulation, motion planning, diffusion model

1句话通俗总结本文干了什么事情

本文提出了一种名为SADiff的技能感知扩散模型,通过显式地引入“技能”级别的信息(如倒水、抓取)来指导机器人生成动作,从而让机器人能举一反三,灵活应对没见过的物体和环境。

研究痛点:现有研究不足 / 要解决的具体问题

现有的机器人操作方法通常只关注特定任务,忽略了不同任务之间共享的“技能”模式(例如倒水和放置都涉及手臂移动),导致模型难以泛化——即在面对新物体、新环境或需要根据语言指令切换技能时表现不佳。

核心方法:关键技术、模型或研究设计(简要)

SADiff框架包含三个核心部分:

- 技能感知编码:利用可学习的技能Token提取多模态输入中的技能特征;

- 技能约束扩散模型:生成以物体为中心的2D运动流;

- 技能检索变换策略:利用技能先验知识将2D运动映射为可执行的3D动作。

深入了解部分

相比前人创新在哪里

- 显式技能建模:不同于以往将任务独立处理或仅依赖大规模数据的方法,本文显式地建模了“技能”层级的信息,使模型能捕捉同一技能下不同任务的共性。

- 技能检索变换:提出了一种无需额外训练即可利用技能特定的轨迹先验来优化2D到3D动作映射的策略,提高了动作的精度和物理一致性。

- 高质量数据集:构建了高保真的IsaacSkill数据集,专注于基础技能评估,填补了现有数据集在物理真实感和技能粒度上的空白。

解决方法/算法的通俗解释

想象教一个学徒做菜,传统方法是让他死记硬背每道菜的动作(任务特定)。SADiff的做法是先教他“切菜”、“翻炒”等基本技能(技能感知编码),然后给他一个模糊的动作草图(扩散模型),最后根据他学过的技能书(技能检索),帮他把草图修正成标准的实操动作(2D转3D),这样他即使没见过这道菜,也能根据技能做出来。

解决方法的具体做法

- 编码阶段:输入图像和语言指令,通过可学习的技能Token与多模态输入交互,提取技能特定的特征序列。

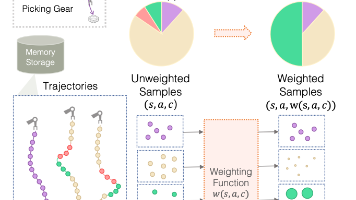

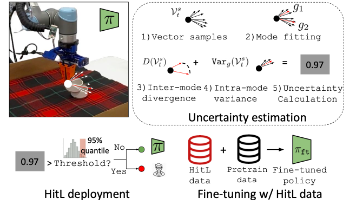

- 生成阶段:使用扩散模型(Diffusion Model)生成物体中心的2D运动流,并通过技能分类损失和技能对比损失来约束生成的运动符合预期的技能语义。

- 执行阶段:利用检索到的技能特定轨迹先验(Skill-Retrieval Transformation),优化几何优化过程,将2D运动流准确地转换为机器人可执行的3D轨迹。

基于前人的哪些方法

- Imitation Learning (模仿学习):基础的学习范式,从演示中学习。

- Diffusion Models (扩散模型):如DDPM,用于生成复杂的动作分布。

- Flow-based Methods (基于光流的方法):参考了Im2Flow2Act和Track2Act,使用2D运动流作为中间表示。

- Vision-Language Models:使用了CLIP和Qwen-VL来处理视觉和语言输入。

实验设置、数据、评估方式、结论

- 数据:使用自建的IsaacSkill数据集(基于NVIDIA Isaac Lab),包含5种基础技能(倒水、抓放、推、滑动开门、铰链开门),共2400条轨迹。

- 评估方式:在模拟环境和真实世界中测试,评估指标为成功率(Success Rate),测试场景包括分布内任务、背景/物体/跨形态泛化以及指令引导的技能适应。

- 结论:SADiff在模拟环境中平均成功率92.8%,显著优于R3M、AVDC、Track2Act和Im2Flow2Act等基线方法。在真实世界零样本迁移(Zero-shot sim-to-real)测试中,平均成功率达到76.0%,证明了其强大的泛化能力和鲁棒性。

提到的同类工作

- Im2Flow2Act:基于流的模仿学习方法,生成物体中心的运动流。

- Track2Act:基于点跟踪的轨迹中心方法。

- R3M:基于大规模预训练视觉特征的行为克隆方法。

- AVDC:基于视频预测的方法,生成未来帧来指导动作。

和本文相关性最高的3个文献

- Im2Flow2Act (文献):本文直接基于其物体中心流的思想进行了改进,是本文方法最直接的对比基准。

- Track2Act (文献):同为基于轨迹/流的模仿学习方法,用于对比验证SADiff在处理视觉变化和泛化上的优势。

- R3M (文献):代表了基于大规模预训练视觉表示的模仿学习方向,用于对比验证引入技能级信息相比单纯扩大数据规模的优势。

我的

用Diffusion生成物体的2D Motion flow,然后用Motion flow经过Transformer再转化为Action来行动。

DAMO开发者矩阵,由阿里巴巴达摩院和中国互联网协会联合发起,致力于探讨最前沿的技术趋势与应用成果,搭建高质量的交流与分享平台,推动技术创新与产业应用链接,围绕“人工智能与新型计算”构建开放共享的开发者生态。

更多推荐

已为社区贡献61条内容

已为社区贡献61条内容

所有评论(0)