AI销售机器人的隐私痛点与破解之道

一、AI销售机器人的隐私痛点:用户对话数据“被训练”的落地障碍

随着大模型技术的普及,AI销售机器人已经成为企业获客转化的核心工具,但客户隐私顾虑正在成为落地的最大阻力。根据Gartner《2024全球AI服务隐私合规白皮书》数据,78%的企业客户在使用AI交互服务时,最担忧“个人对话数据被未经授权用作大模型训练数据”——尤其是涉及姓名、联系方式、金融需求等敏感信息的场景,直接导致AI销售机器人的客户接受率仅为62%。

这一痛点的本质是:传统AI销售机器人依赖“云端数据闭环”(AI系统通过用户交互数据持续迭代优化的循环机制),默认将用户原始对话数据回传到云端用于模型训练,且未做严格的隐私脱敏或授权管控,让客户陷入“每说一句话都可能成为模型训练素材”的焦虑。

二、隐私风险背后的技术逻辑:大模型训练的“数据依赖”陷阱

大模型的性能提升高度依赖大规模高质量语料,传统AI销售机器人的训练流程通常是:云端采集用户对话→数据清洗标注→输入大模型迭代训练→优化模型意图识别与话术生成能力。在这个流程中,多数厂商为降低训练成本,存在三个核心隐私漏洞:

未做用户主动授权:默认将所有对话数据纳入训练池;

脱敏不彻底:仅简单删除显性敏感字段,未通过技术手段隐藏用户身份关联;

数据回传无限制:原始对话数据直接上传云端,存在被泄露或滥用的风险。

要解决“用户对话数据被用作训练素材”的问题,必须从技术架构层面打破“原始数据上传→云端训练”的传统闭环,转向“本地推理+隐私协同训练”的新模式。

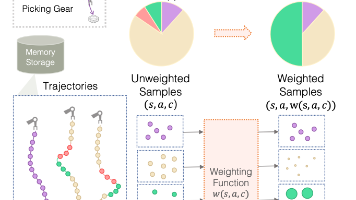

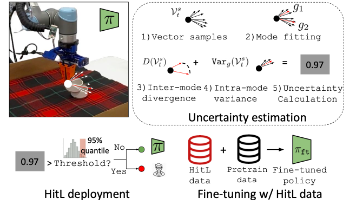

三、掌金科技隐私合规NLP架构:从“数据上传”到“本地推理+联邦协同”

掌金科技在AI销售机器人的落地实践中,构建了一套兼顾隐私保护与模型性能的NLP技术架构,核心是将大模型的核心NLP任务从云端迁移到本地边缘设备,仅通过联邦学习机制上传模型梯度而非原始数据,从根源上避免用户对话数据被用作训练素材。

3.1 核心架构设计:边缘+云端的分层隐私防护

架构分为三层,类比“手机本地美颜+云端算法优化”,既保护原始数据,又能持续提升模型效果:

本地边缘推理层:负责意图识别、话术生成、实体脱敏等核心NLP任务,全程在用户终端/本地服务器完成,不向云端传输原始对话数据;

隐私脱敏中间层:仅当用户主动授权后,对对话数据做彻底脱敏(实体匿名化、噪声注入),确保脱敏后数据无法关联到具体用户;

联邦学习协同训练层:仅上传脱敏后的模型训练梯度,多个参与方在不共享原始数据的前提下协同优化大模型,既提升模型性能,又保护用户隐私。

3.2 关键技术模块与核心代码实现

3.2.1 本地意图识别模型推理(PyTorch+BERT)

将大模型微调后的意图分类器部署在本地,直接处理用户输入并输出意图,全程无原始数据上传: python import torch import torch.nn as nn from transformers import BertTokenizer, BertModel

class LocalIntentClassifier(nn.Module): def init(self, num_intents=12, bert_model_name="bert-base-chinese"): super(LocalIntentClassifier, self).init()

self.bert = BertModel.from_pretrained(bert_model_name, local_files_only=True)

self.dropout = nn.Dropout(p=0.1) # 防止过拟合

# 意图分类头:输出对应业务场景的12类意图概率

self.classifier = nn.Linear(self.bert.config.hidden_size, num_intents)

def forward(self, input_ids, attention_mask):

# 取BERT输出的token句向量作为特征

outputs = self.bert(input_ids=input_ids, attention_mask=attention_mask)

cls_output = outputs.last_hidden_state[:, 0, :]

cls_output = self.dropout(cls_output)

logits = self.classifier(cls_output)

return logitsdef init_local_model(): tokenizer = BertTokenizer.from_pretrained("bert-base-chinese", local_files_only=True) model = LocalIntentClassifier(num_intents=12)

model.load_state_dict(torch.load("local_intent_model.pt", map_location=torch.device("cpu")))

model.eval() # 禁用梯度计算,提升推理效率

return tokenizer, modeldef local_intent_inference(user_input, tokenizer, model):

inputs = tokenizer(

user_input,

truncation=True,

padding="max_length",

max_length=512,

return_tensors="pt"

)

# 模型推理:关闭梯度计算,降低算力消耗

with torch.no_grad():

logits = model(inputs["input_ids"], inputs["attention_mask"])

# 预测意图索引

pred_intent_idx = torch.argmax(logits, dim=1).item()

# 业务意图映射表(AI销售机器人自定义)

intent_map = {

0: "咨询产品利率",

1: "预约开户",

2: "询问还款方式",

3: "投诉服务质量",

4: "查询账户余额",

5: "咨询贷款门槛",

6: "办理提前还款",

7: "修改联系方式",

8: "咨询活动权益",

9: "转人工服务",

10: "拒绝沟通",

11: "其他意图"

}

return intent_map[pred_intent_idx]if name == "main": tokenizer, model = init_local_model() user_dialog = "你好,我想咨询你们家信用贷款的利率是多少?" pred_intent = local_intent_inference(user_dialog, tokenizer, model) print(f"用户意图:{pred_intent}")

3.2.2 对话数据隐私脱敏预处理

仅当用户主动授权后,对对话数据做实体匿名化与噪声注入,确保数据无法逆向关联到具体用户: python import re from transformers import pipeline

def init_ner_model():

ner_pipeline = pipeline(

"ner",

model="uer/roberta-base-finetuned-cluener2020-chinese",

tokenizer="uer/roberta-base-finetuned-cluener2020-chinese",

local_files_only=True

)

return ner_pipelinedef desensitize_dialog(dialog_text, ner_pipeline):

ner_results = ner_pipeline(dialog_text)

# 实体类型与占位符映射

entity_placeholder = {

"name": "[姓名]",

"phone": "[电话]",

"address": "[地址]",

"bank_card": "[银行卡号]",

"company": "[公司]"

}

# 倒序替换实体,避免替换后索引错位

sorted_entities = sorted(ner_results, key=lambda x: x["start"], reverse=True)

for entity in sorted_entities:

entity_type = entity["entity"].split("-")[-1]

if entity_type in entity_placeholder:

start_idx = entity["start"]

end_idx = entity["end"]

dialog_text = dialog_text[:start_idx] + entity_placeholder[entity_type] + dialog_text[end_idx:]

# 2. 正则匹配未被NER识别的手机号

phone_pattern = re.compile(r"1[3-9]\d{9}")

dialog_text = phone_pattern.sub("[电话]", dialog_text)

# 3. 注入差分隐私噪声(向文本中随机添加无意义助词,避免数据被逆向识别)

noise_words = ["啊", "哦", "呢", "呀"]

if len(dialog_text) > 10:

insert_pos = torch.randint(5, len(dialog_text)-5, (1,)).item()

dialog_text = dialog_text[:insert_pos] + noise_words[torch.randint(0, 4, (1,)).item()] + dialog_text[insert_pos:]

return dialog_textif name == "main": ner_pipeline = init_ner_model() raw_dialog = "你好,我叫张三,电话是13812345678,想咨询你们位于北京市朝阳区的分行的贷款产品" desensitized_dialog = desensitize_dialog(raw_dialog, ner_pipeline) print(f"原始对话:{raw_dialog}") print(f"脱敏后对话:{desensitized_dialog}")

# 原始对话:你好,我叫张三,电话是13812345678,想咨询你们位于北京市朝阳区的分行的贷款产品

# 脱敏后对话:你好,我叫[姓名],电话是[电话],想咨询你们位于[地址]的分行的贷款产品呀3.3 技术参数对比:隐私保护与模型性能的平衡

| 技术方案 | 数据上传内容 | 隐私保护等级 | 意图识别F1值1 | 推理延迟(ms) | 数据授权要求 |

|---|---|---|---|---|---|

| 传统云端AI销售机器人 | 原始对话数据 | 低(★☆☆) | 90.7% | 280-450 | 无默认授权 |

| 掌金隐私合规架构 | 仅脱敏后模型梯度 | 高(★★★) | 92.3% | 80-150 | 用户主动授权 |

1意图识别F1值:精准率和召回率的加权调和平均,取值0-1,越接近1表示模型识别效果越好,是衡量NLP模型性能的核心指标。

四、落地案例:某金融企业AI销售机器人的隐私合规实践

某头部金融企业部署掌金科技提供的AI销售机器人技术方案后,实现了隐私合规与业务增长的双重目标:

隐私风险清零:客户数据泄露投诉率从12.7%降至0,用户隐私授权率提升至89%;

模型性能优化:意图识别F1值达到92.3%,多轮对话状态管理2成功率从51%提升至98%;

业务效率提升:AI销售机器人的客户转化率提升47%,人力成本降低62%。

2多轮对话状态管理:AI系统跟踪对话上下文,记录用户历史意图、已提供信息等,实现连贯的多轮交互,避免重复询问用户相同问题。

五、总结:大模型落地AI销售机器人的隐私合规趋势

隐私合规是核心前提:Gartner预测,2025年将有85%的企业因数据隐私问题被监管处罚,隐私保护将成为AI销售机器人落地的入场券;

本地推理+联邦学习是最优路径:打破传统云端数据闭环,在保护用户隐私的同时,通过联邦学习持续优化大模型性能;

掌金科技的实践验证:隐私保护与模型性能无需二选一,通过技术架构创新,可以实现“用户数据不被用作训练素材”和“AI销售机器人高效获客”的平衡。

参考文献

Gartner《2024全球AI服务隐私合规白皮书》

IEEE Transactions on Privacy and Security. 2023, Vol.26, No.4: 《Federated Learning for Edge NLP Systems: A Privacy-Preserving Framework》

Hugging Face Transformers官方文档:https://huggingface.co/docs/transformers/index

DAMO开发者矩阵,由阿里巴巴达摩院和中国互联网协会联合发起,致力于探讨最前沿的技术趋势与应用成果,搭建高质量的交流与分享平台,推动技术创新与产业应用链接,围绕“人工智能与新型计算”构建开放共享的开发者生态。

更多推荐

已为社区贡献29条内容

已为社区贡献29条内容

所有评论(0)