普林斯顿近300篇工作的综述,这一领域是如何为具身提供低成本的训练和测试方案的?

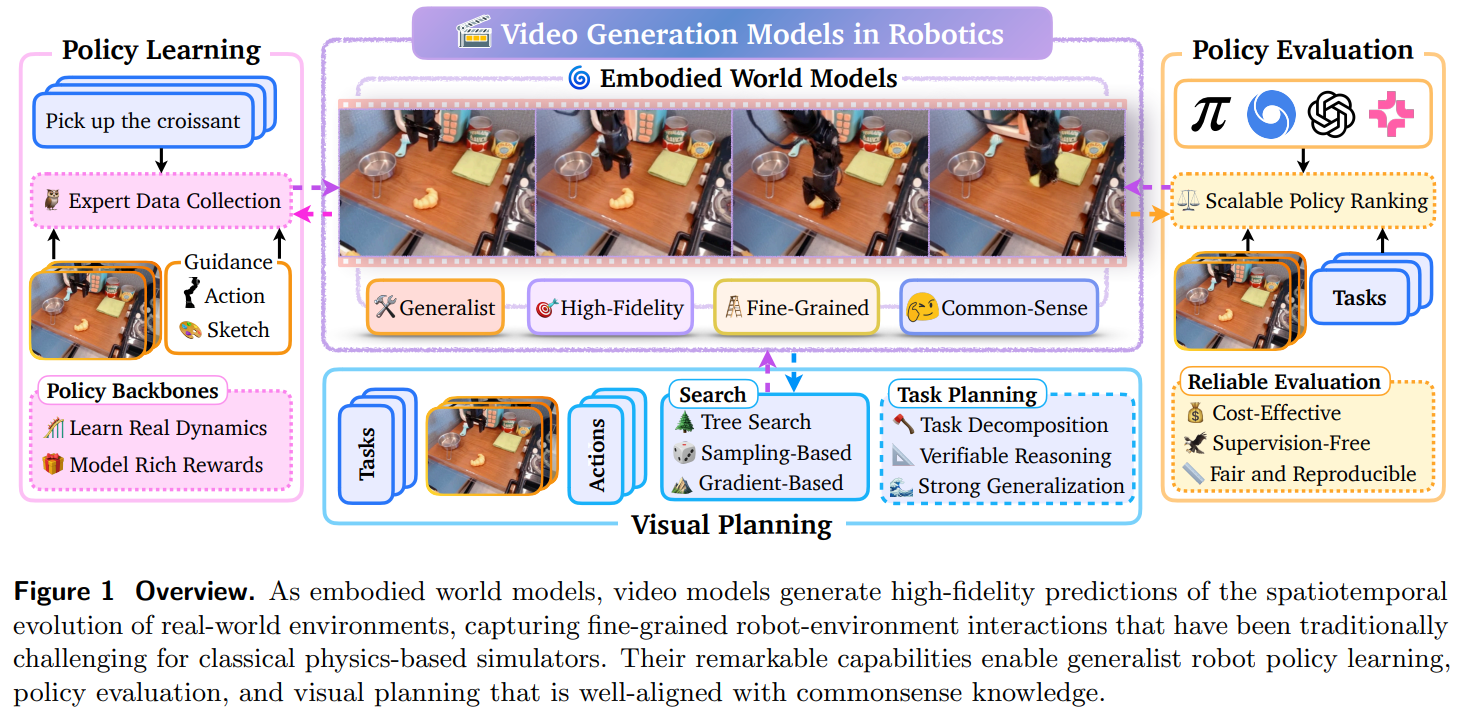

视频生成模型通过高保真时空建模,解决了机器人领域数据稀缺、仿真不准、评估昂贵等核心痛点,其四大应用场景已覆盖政策学习、评估与规划的全流程。未来落地的关键在于:平衡性能与成本,突破长视频生成、物理一致性等技术瓶颈;构建机器人专用的评估体系与安全机制;推动跨平台迁移与实时部署能力提升。该技术的成熟将加速通用自主机器人的发展,尤其在工业操纵、服务机器人等安全关键场景实现规模化应用。

在机器人领域,物理仿真器的保真度局限与语言模型的表达瓶颈长期制约发展,而视频生成模型凭借高保真时空建模能力,成为破解这些难题的核心突破口。普林斯顿大学与天普大学联合发表的综述论文,以 “模型基础 - 核心应用 - 挑战方向” 为逻辑脉络,首次系统梳理了视频生成模型作为嵌入式世界模型在机器人领域的研究现状,构建了完整的技术体系与应用框架,为机器人智能化升级提供了全新范式。

- 论文题目:Video Generation Models in Robotics: Applications, Research Challenges, Future Directions

- 论文链接:https://arxiv.org/abs/2601.07823

核心亮点:首个机器人领域视频生成模型全面综述、四大核心应用场景、十大关键挑战、针对性未来方向

问题根源:传统方法的核心痛点

视频生成模型的崛起,源于对机器人领域现有技术瓶颈的精准破解,三大核心矛盾构成研究起点:

- 语言模型表达局限:纯语言抽象难以捕捉物理世界的精细交互(如机器人抓手与柔性物体的接触过程),且无法准确建模时空依赖关系。

- 物理仿真器保真度不足:传统物理引擎依赖简化假设,难以模拟复杂形态的可变形物体,且存在显著的仿真到现实差距,资产构建成本高昂。

- 数据与评估成本高:机器人政策学习需大量专家演示数据,采集过程耗时耗力;真实世界政策评估需部署物理硬件,硬件与人力成本极高。

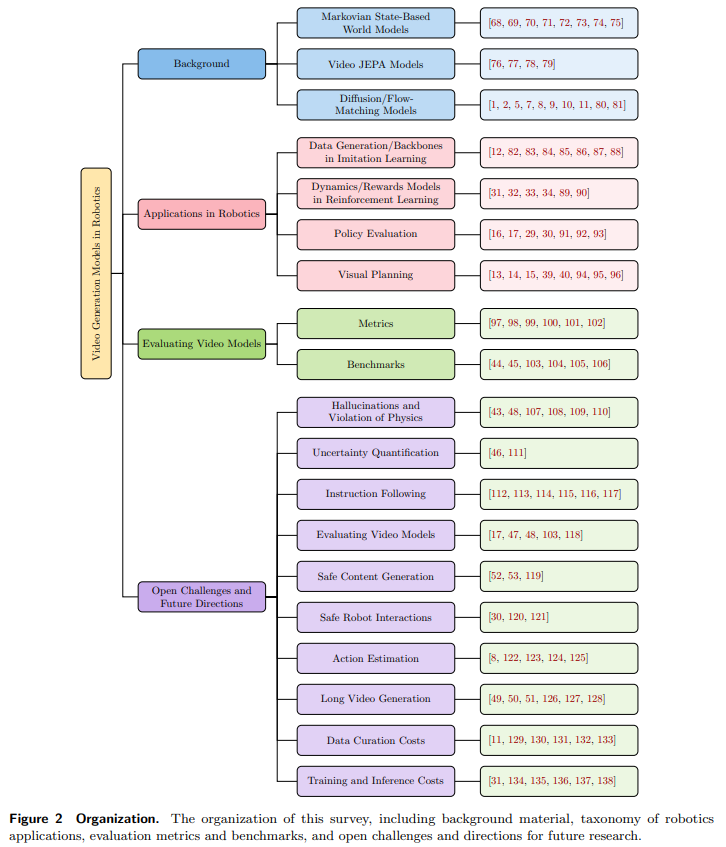

技术基础:视频生成模型的核心架构与分类

视频生成模型通过学习时空映射关系实现物理世界高保真建模,其核心架构可分为三大类,构成技术落地的基础,整体研究框架如图 2 所示:

马尔可夫状态基世界模型

基于当前状态与动作预测未来状态,假设未来演化仅依赖当前时刻信息,通过编码器、动力学预测器与奖励预测器构建模型。传统采用循环神经网络(RNN),近年逐步引入 Transformer 与扩散模型提升动态预测的表达能力,但仍受限于 latent 空间建模的抽象性。

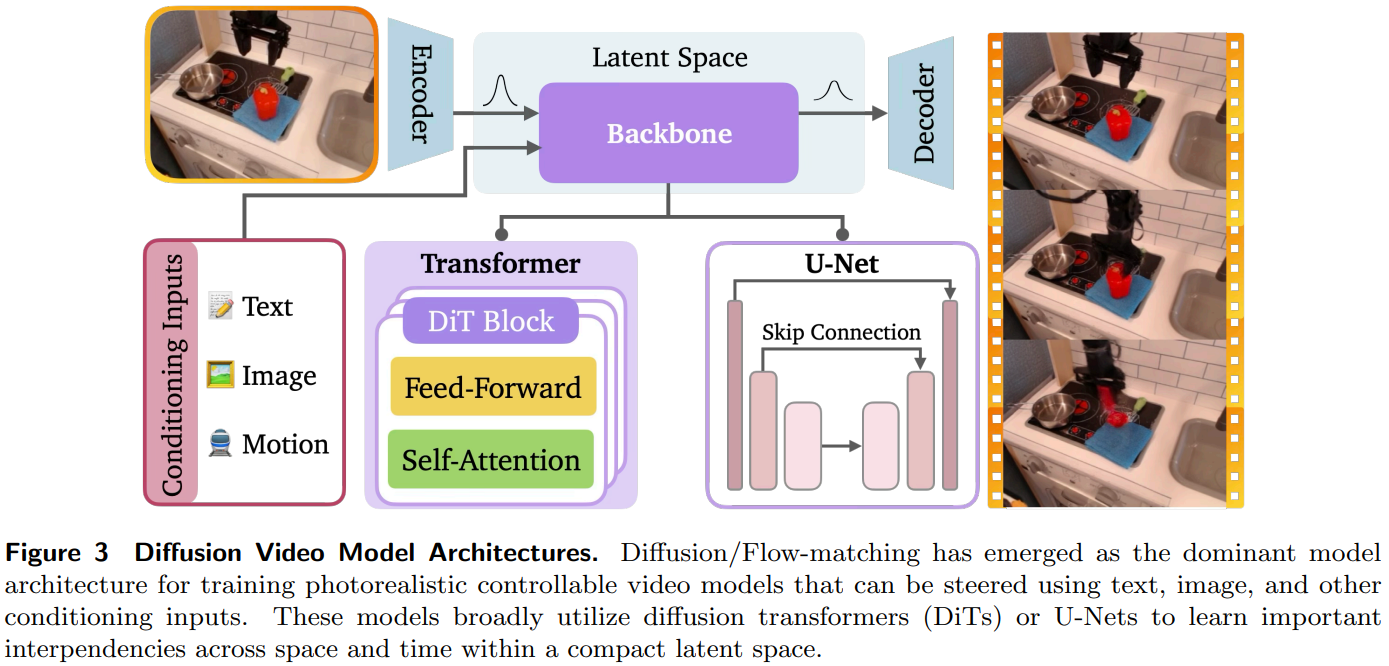

扩散 / 流匹配视频模型

当前主流架构,通过迭代去噪过程生成高保真视频,支持文本、图像、动作等多模态条件输入,核心架构如图 3 所示。其关键技术包括:

- 条件引导机制:通过分类器引导或无分类器引导实现精准调控,后者因简洁性与鲁棒性成为主流。

- 模型骨干网络:U-Net 架构通过 3D 卷积扩展至时空领域,Diffusion Transformer(DiT)利用自注意力机制捕捉长程依赖,适配大规模视频生成。

- 多模态适配:支持文本到视频(T2V)、图像到视频(I2V)、动作轨迹引导等多种生成模式,满足机器人不同场景需求。

视频联合嵌入预测架构(V-JEPA)

通过自监督训练学习 latent 空间表征,不直接预测像素级细节,而是聚焦高层语义与动态规律。核心优势在于无需大量标注数据,可直接用于机器人规划任务,但存在表征坍缩风险,需依赖正则化技术优化。

机器人领域的四大核心应用场景

视频生成模型作为嵌入式世界模型,已在机器人关键环节实现落地,形成四大核心应用方向:

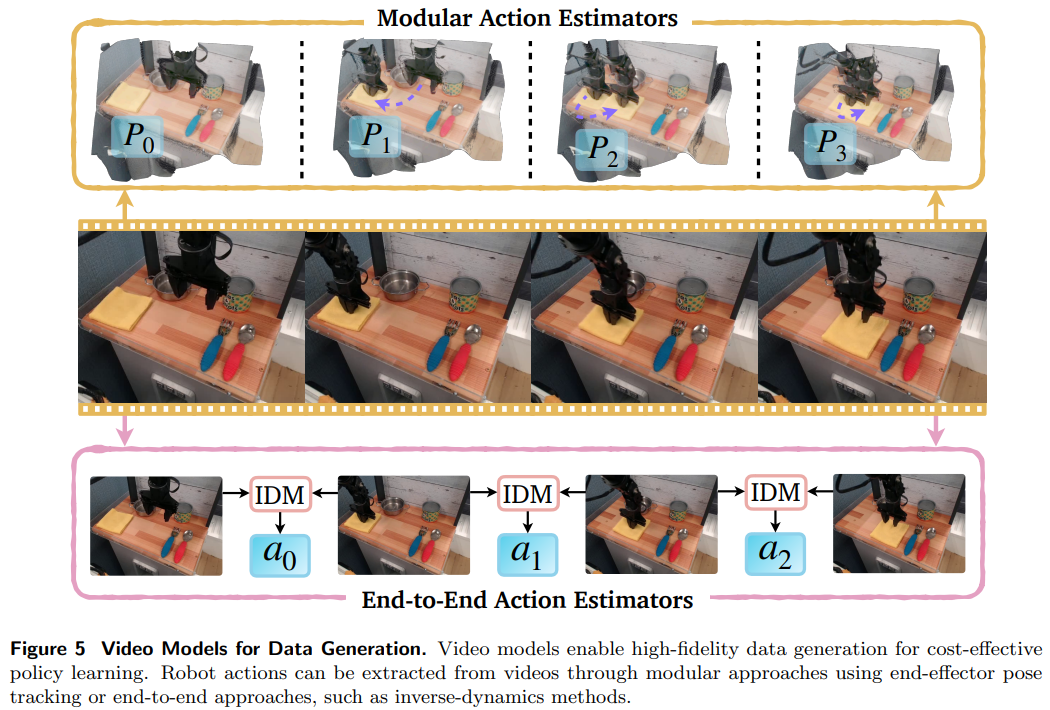

模仿学习中的低成本数据生成与动作预测

解决专家演示数据稀缺问题,通过视频生成模型合成大规模训练数据,支持无监督数据扩展:

-

数据生成:微调预训练模型生成机器人任务演示视频,包括成功案例与失败轨迹,提升政策鲁棒性。

-

动作提取:通过模块化方法(姿态跟踪、光学流分析)或端到端方法(逆动力学模型、latent 动作模型),从生成视频中提取机器人可执行动作,具体流程如图 5 所示。

- 跨形态迁移:实现从人类视频到机器人动作的转化,降低跨机器人平台的适配成本。

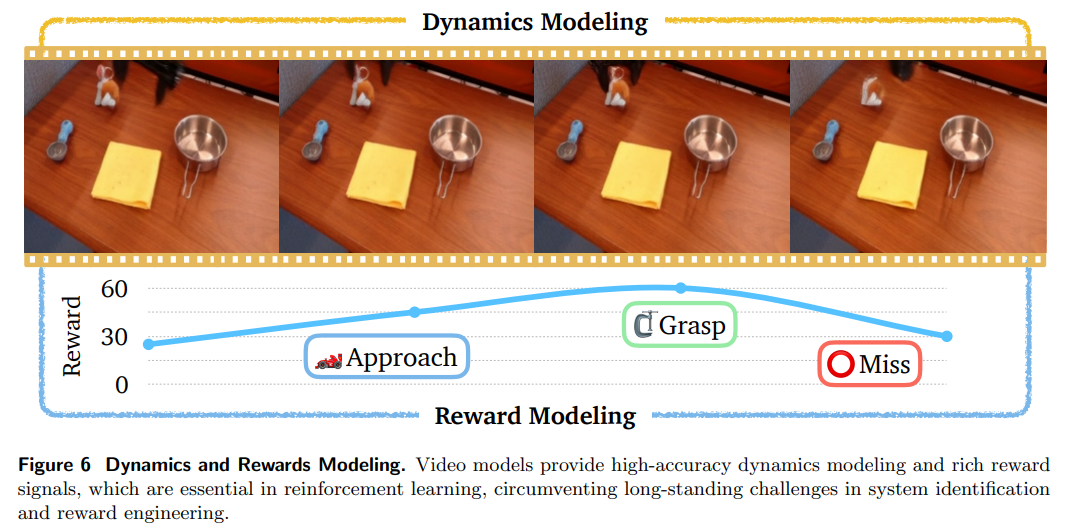

强化学习中的动力学与奖励建模

为强化学习提供高保真环境动态与奖励信号,突破样本效率瓶颈,具体实现如图 6 所示:

- 动力学建模:通过动作条件视频生成,精准预测环境对机器人动作的反馈,替代传统物理仿真器。

- 奖励建模:利用视频生成分布的条件熵或预测似然度,构建丰富的奖励信号,避免手动设计奖励函数的局限性。

- 探索引导:生成多样化视频轨迹,引导机器人探索未见过的场景,提升政策泛化能力。

规模化政策评估

替代真实世界与物理仿真的评估方式,降低评估成本并提升可靠性:

-

闭环评估:将机器人政策与视频模型闭环运行,通过生成视频预测政策执行效果,无需部署物理硬件。

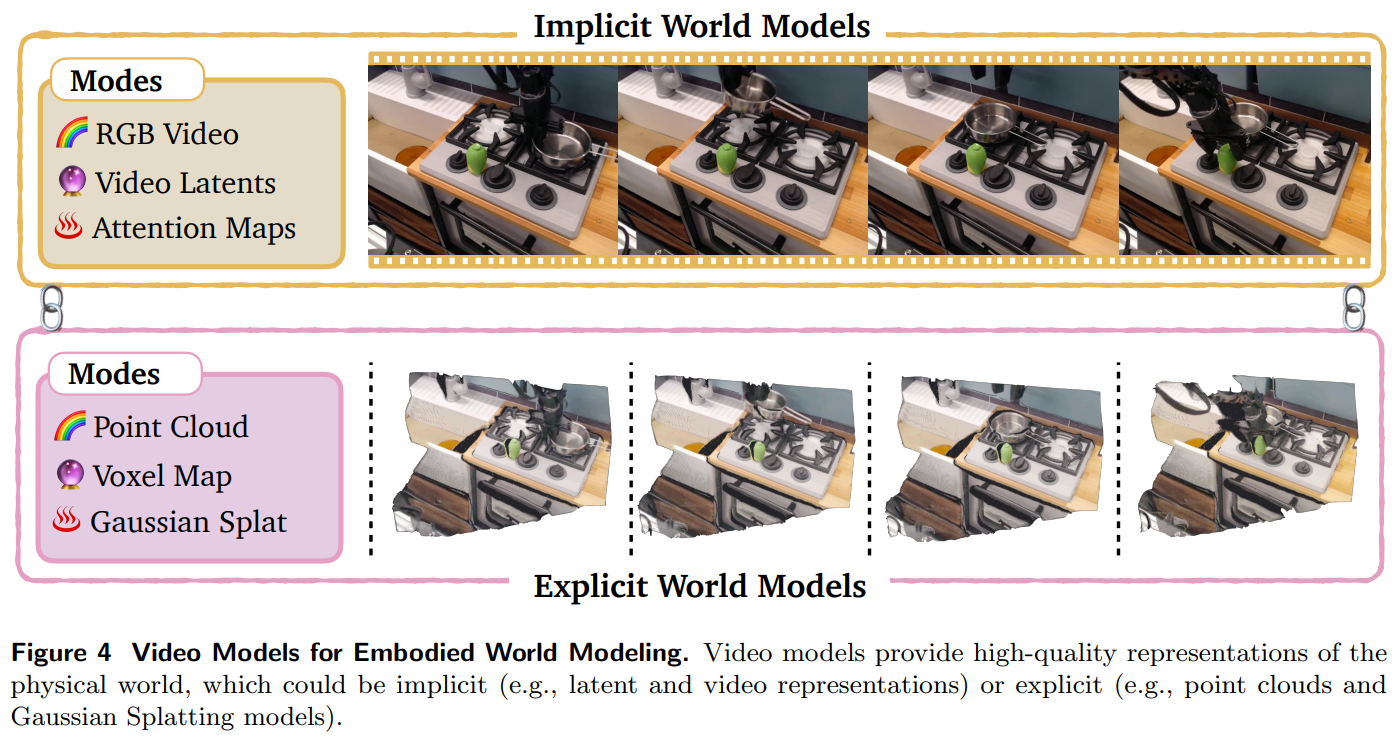

-

多视图增强:结合多相机视角生成(如图 4 中 explicit 世界模型的多视图表征),减少幻觉现象,提升评估准确性。

- 鲁棒性测试:快速构建分布外场景(如添加干扰物、改变环境背景),评估政策在极端情况下的安全性与稳定性。

视觉规划

通过生成任务执行视频,为机器人提供分步行动指南,突破传统规划对精确动力学模型的依赖:

- 动作引导规划:生成动作提案并通过视频模型验证效果,结合优化算法筛选最优轨迹。

- 无动作规划:直接生成目标导向的视频序列,将帧作为图像子目标,通过逆动力学模型映射为机器人动作。

- 任务分解:结合大语言模型(LLM)将复杂任务拆分为子任务,生成分步视频计划,提升长时程任务的规划能力。

视频模型的评估体系:指标与基准

核心评估指标

- 帧级指标:包括峰值信噪比(PSNR)、结构相似性指数(SSIM)、CLIP 相似度、Fréchet Inception 距离(FID)等,用于评估单帧视觉质量与语义一致性。

- 时空指标:包括 Fréchet Video Distance(FVD)、Kernel Video Distance(KVD)、Fréchet Video Motion Distance(FVMD)等,聚焦视频的时间连贯性与运动合理性。

关键基准测试

- 综合基准:WorldModelBench 评估指令跟随与物理一致性,EvalCrafter 涵盖美学、运动质量等多维度,VBench 细分 16 项精细指标。

- 物理常识基准:Physics-IQ 测试物理定律理解,PhyGenBench 覆盖 27 种物理规律,VideoPhy 聚焦物体交互逻辑,为机器人场景的物理一致性评估提供依据。

核心挑战与未来研究方向

尽管应用前景广阔,视频生成模型在机器人领域的规模化落地仍面临十大关键挑战,对应明确的研究方向:

幻觉与物理定律违背

生成视频存在物体消失、形变异常等问题,核心原因是模型缺乏物理常识。未来需融入物理先验(如哈密顿力学)、结合物理仿真器优化生成轨迹,或通过 affordance 映射捕捉物体交互规律。

不确定性量化

模型无法表达预测置信度,限制安全关键场景应用。需开发时空密集型不确定性估计方法,实现对每帧、每个区域的置信度量化,确保评估与规划的可靠性。

指令跟随能力不足

难以精准执行复杂文本指令,尤其在长时视频生成与相机视角控制中表现不佳。需通过多模态条件融合、指令微调等方式提升任务理解能力。

评估体系缺失

缺乏机器人场景专用评估指标,现有方法依赖替代指标或人工判断。需构建 robotics-centric 基准,覆盖物理一致性、预测准确性等核心维度。

安全内容生成

许多视频模型缺乏 adequate 安全护栏,易生成不安全内容。需设计通用安全护栏机制,开发更全面的安全基准,适配机器人敏感应用场景。

安全机器人交互

机器人需兼顾物理安全与语义安全,现有方法多局限于马尔可夫状态基世界模型。需将 latent 空间安全过滤扩展至视频世界模型,提升分布外场景的风险抵御能力。

动作估计精度不足

从生成视频中提取的动作难以满足精细操纵任务需求。需优化 latent 动作模型的可解释性,采用半监督训练提升逆动力学模型的泛化能力。

长视频生成能力有限

现有模型仅能生成数秒视频,无法覆盖分钟级机器人任务。需开发高效记忆机制与分层生成架构,扩展模型上下文窗口,降低长序列生成的计算成本。

数据整理成本高昂

高质量标注数据稀缺,现有数据集存在质量问题。需优化数据筛选与标注流程,利用新视角合成技术降低数据收集成本,同时融入失败数据提升模型鲁棒性。

训练与推理成本高

模型参数规模大,训练与推理耗资源,难以部署于边缘设备。需通过空间时间压缩、模型蒸馏、量化等技术提升效率,适配机器人实时控制需求。

写在最后:从技术突破到规模化落地

视频生成模型通过高保真时空建模,解决了机器人领域数据稀缺、仿真不准、评估昂贵等核心痛点,其四大应用场景已覆盖政策学习、评估与规划的全流程。未来落地的关键在于:平衡性能与成本,突破长视频生成、物理一致性等技术瓶颈;构建机器人专用的评估体系与安全机制;推动跨平台迁移与实时部署能力提升。该技术的成熟将加速通用自主机器人的发展,尤其在工业操纵、服务机器人等安全关键场景实现规模化应用。

具身求职内推来啦

国内最大的具身智能全栈学习社区来啦!

推荐阅读

从零部署π0,π0.5!好用,高性价比!面向具身科研领域打造的轻量级机械臂

工业级真机教程+VLA算法实战(pi0/pi0.5/GR00T/世界模型等)

具身智能算法与落地平台来啦!国内首个面向科研及工业的全栈具身智能机械臂

VLA/VLA+触觉/VLA+RL/具身世界模型等!具身大脑+小脑算法与实战全栈路线来啦~

MuJoCo具身智能实战:从零基础到强化学习与Sim2Real

Diffusion Policy在具身智能领域是怎么应用的?为什么如此重要?

1v1 科研论文辅导来啦!

DAMO开发者矩阵,由阿里巴巴达摩院和中国互联网协会联合发起,致力于探讨最前沿的技术趋势与应用成果,搭建高质量的交流与分享平台,推动技术创新与产业应用链接,围绕“人工智能与新型计算”构建开放共享的开发者生态。

更多推荐

已为社区贡献93条内容

已为社区贡献93条内容

所有评论(0)