自回归离散化预训练下统一的具身 VLM 推理与机器人动作

25年12月来自智元研究、智元机器人公司和上海创新研究院的论文“Unified Embodied VLM Reasoning with Robotic Action via Autoregressive Discretized Pre-training”。在开放世界环境中运行的通用机器人系统必须同时实现广泛的泛化能力和高精度的动作执行,而这对于现有的视觉-语言-动作(VLA)模型而言仍然是一个挑战

25年12月来自智元研究、智元机器人公司和上海创新研究院的论文“Unified Embodied VLM Reasoning with Robotic Action via Autoregressive Discretized Pre-training”。

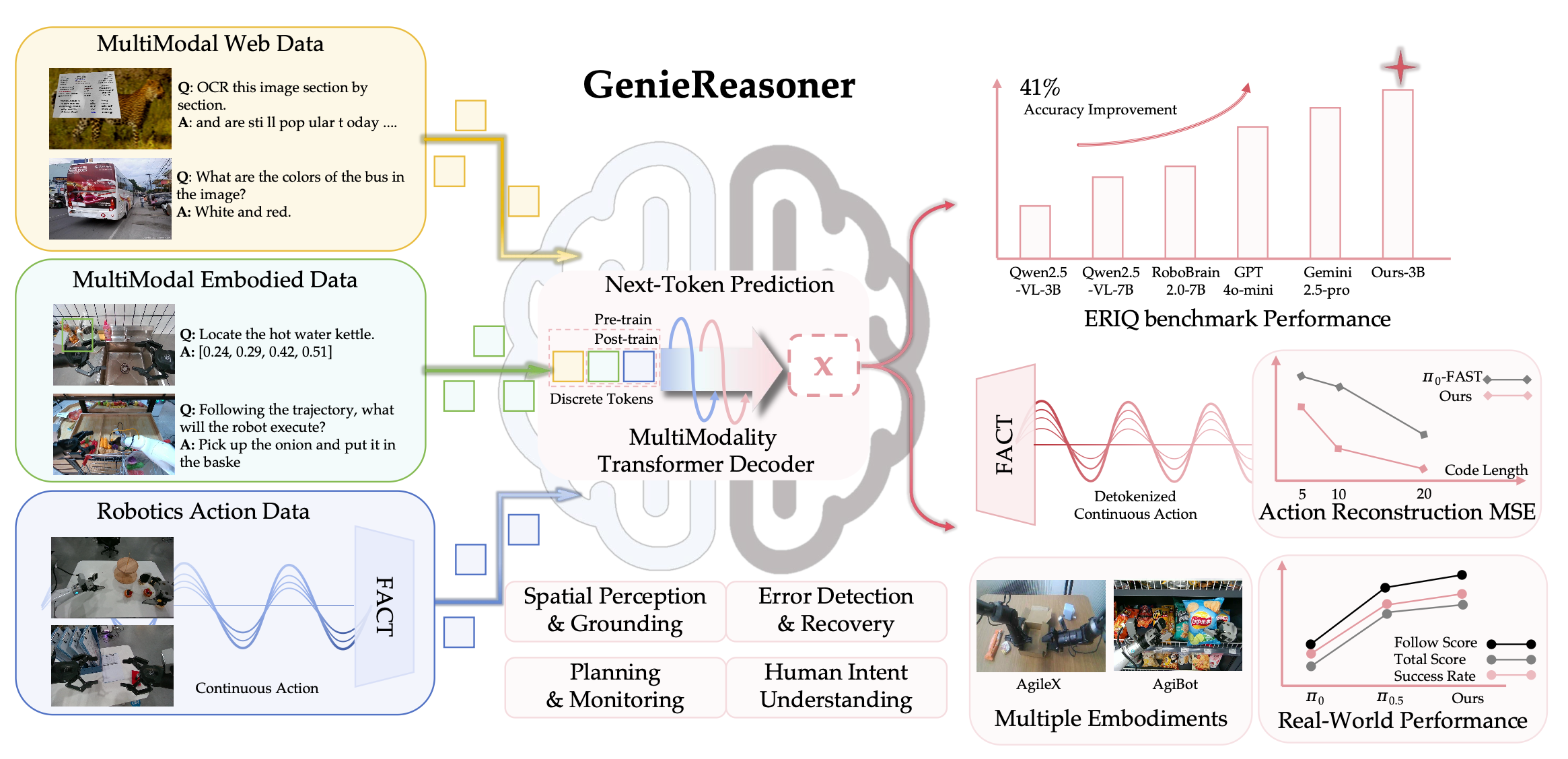

在开放世界环境中运行的通用机器人系统必须同时实现广泛的泛化能力和高精度的动作执行,而这对于现有的视觉-语言-动作(VLA)模型而言仍然是一个挑战。虽然大型视觉-语言模型(VLM)能够提升语义泛化能力,但具身推理能力不足会导致系统行为脆弱;反之,仅靠强大的推理能力,如果没有精确的控制,也是不够的。为了对这一瓶颈进行解耦和定量评估,引入具身推理智能商数(ERIQ),这是一个用于机器人操作的大规模具身推理基准测试,包含四个推理维度上的6000多个问答对。通过将推理与执行解耦,ERIQ能够进行系统性的评估,并揭示具身推理能力与端到端VLA泛化能力之间存在很强的正相关性。为了弥合推理与精确执行之间的鸿沟,提出FACT,一种基于流匹配的动作token化器,它将连续控制转换为离散序列,同时保持高保真轨迹重构。由此产生的GenieReasoner在统一的空间中联合优化推理和动作,在实际任务中优于连续动作基线和先前的离散动作基线。ERIQ和FACT共同提供一个原则性的框架,用于诊断和克服推理与精度之间的权衡,从而推进鲁棒性强、通用的机器人操作。

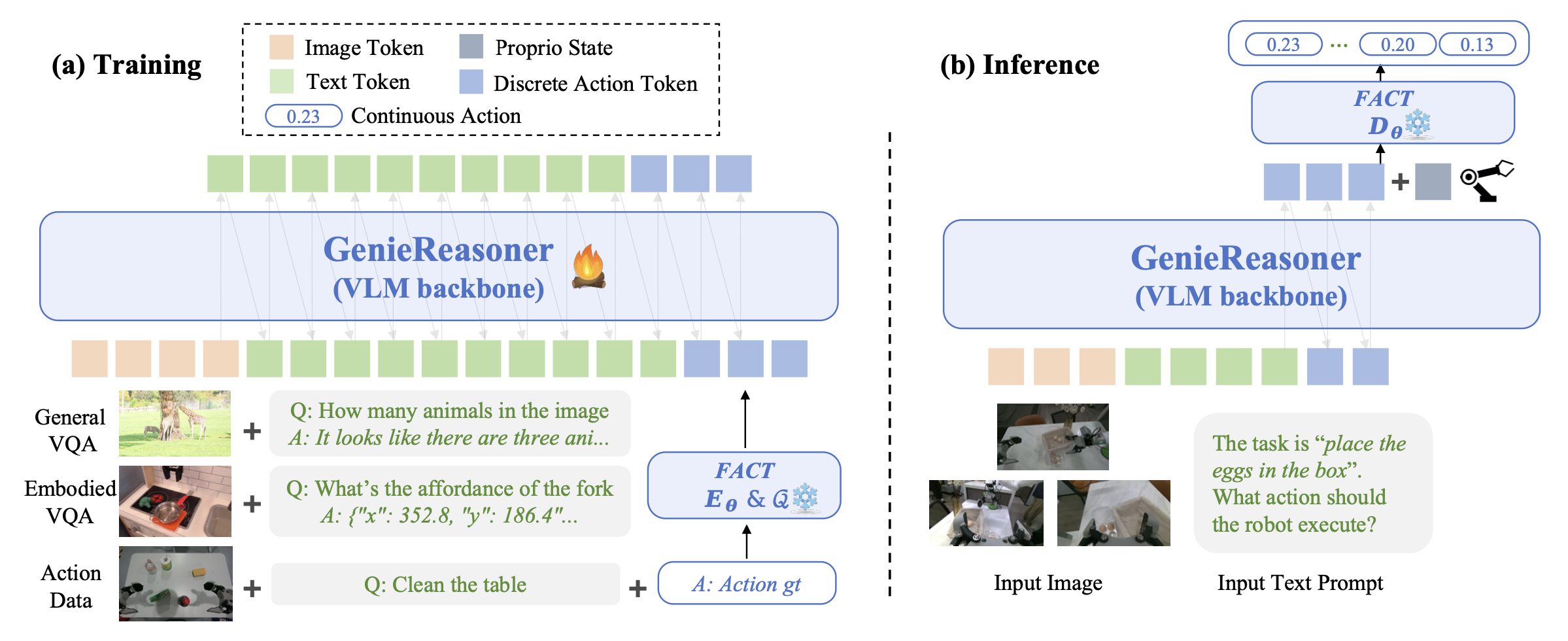

基于流匹配的动作token化器(FACT),将运动控制转换为离散序列,从而在保持连续空间精度的同时实现建模。这使得 GenieReasoner(如图所示)能够在统一的梯度空间内协同优化推理和动作。这种对齐方式直接将 VLM 的推理能力映射到精确的动作,避免连续头带来的泛化损失,同时超越现有离散token化器的保真度限制。实证评估表明,GenieReasoner 的性能优于连续动作基线(例如 π0.5 [6])和离散动作基线(例如 π0-FAST [12]),在各种基准测试和实际机器人部署中有效地平衡具身推理和动作精度。

为了在机器人操作中实现广泛的泛化能力,机器人必须具备强大的“具身推理”能力,即能够综合空间感知、时间动态和因果逻辑来规划和纠正动作。然而,在端到端的VLA模型中评估这种能力极具挑战性;当机器人任务失败时,通常难以确定失败的根源是缺乏高层语义理解还是低层运动执行错误。为了解决这一模糊性,提出将推理能力的评估与物理执行解耦。因此,引入一个基准测试,旨在独立于运动执行来评估VLM的具身推理能力。

具身推理智能商数(ERIQ)基准测试

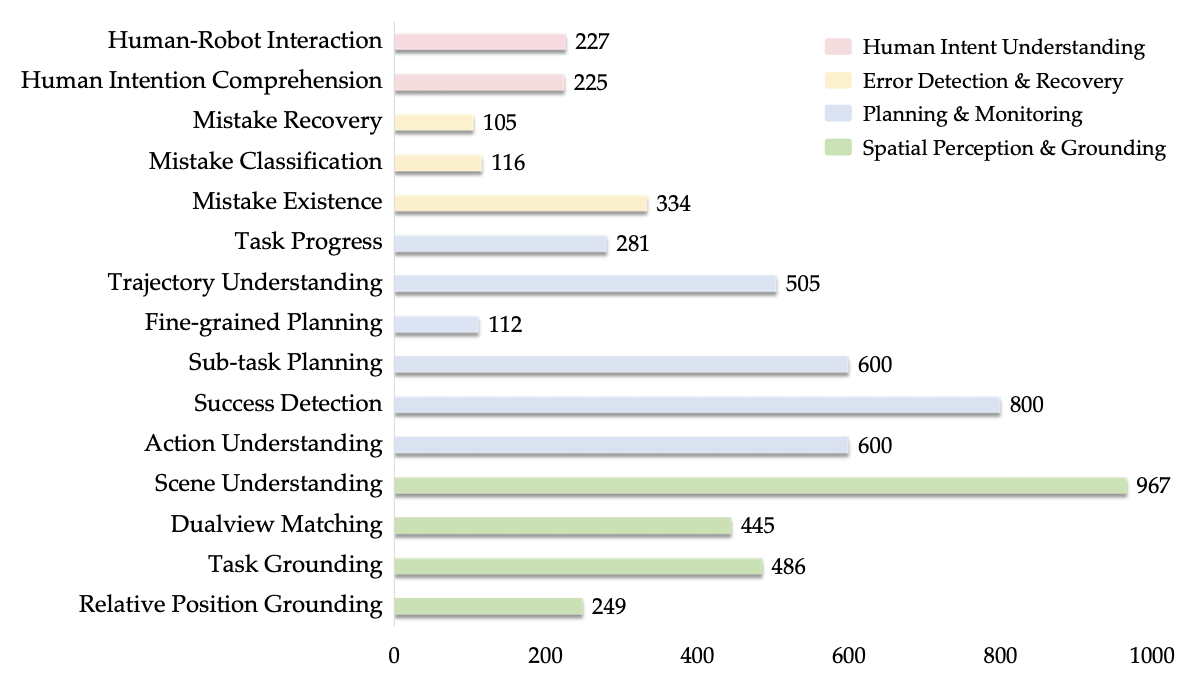

引入ERIQ,这是一个包含6052个具身问答对的大规模基准测试。ERIQ采用标准化的视觉问答(VQA)协议来量化具身理解能力,而无需考虑控制策略。

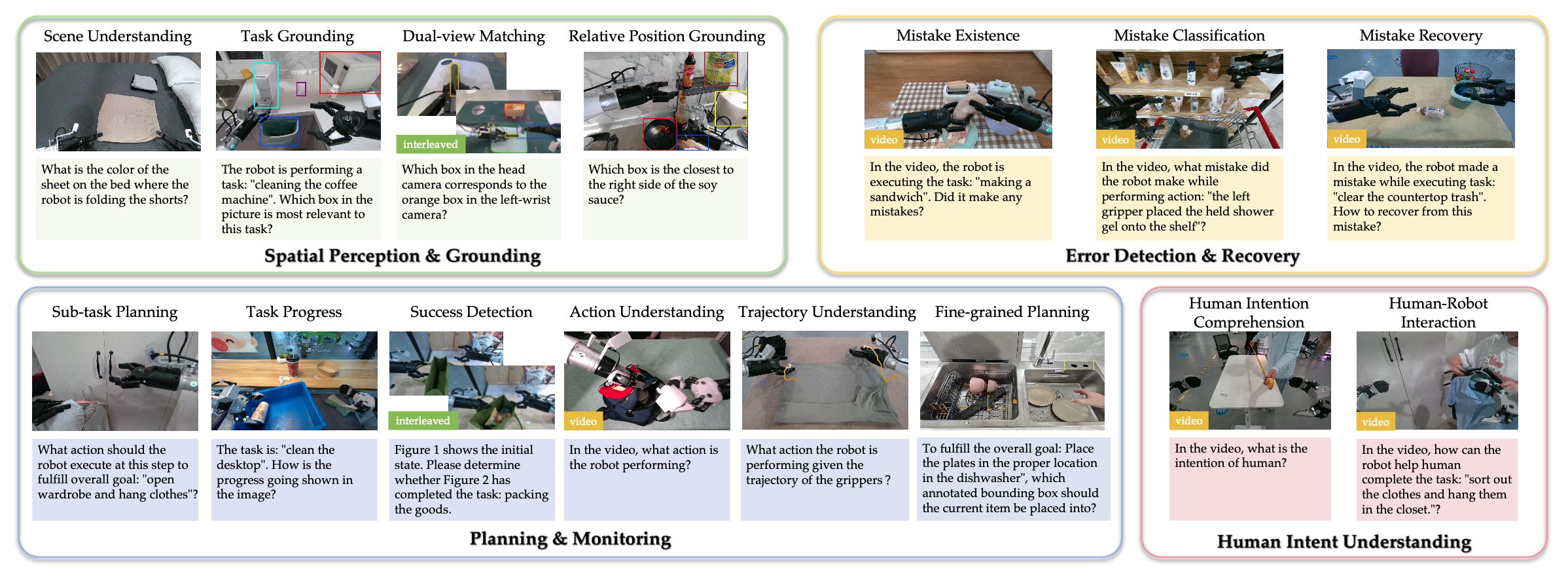

ERIQ 基准测试构建为一个多维框架,评估具身推理的四大支柱:(1) 空间感知与落地,(2) 规划与监控,(3) 错误检测与恢复,以及 (4) 人类意图理解。这些域共同构成 15 个精心设计的子任务,用于在真实物理环境中衡量感知、推理、错误处理和人类意图理解能力。每个子任务均采用标准化的多项选择或二元(是/否)格式,从而实现确定性且直接的评估。这种设计消除开放式生成指标的歧义,确保公平性和可重复性。如图展示 ERIQ 基准测试 QA 样本的概览。

a) 空间感知与落地:机器人执行自主行动的前提是能够感知和解释环境。该领域通过场景理解、任务落地和相对位置落地等任务测试全局和关系理解能力。这些任务评估智体从复杂指令(例如,“砧板左边的碗”)中解析目标参考的能力,以及在杂乱场景中解决符号落地问题的能力。

b) 任务规划和执行监控:智体必须推理因果结构才能实现复杂目标。该领域包括子任务规划和轨迹分析,评估智体是否能够将高级指令分解为连贯的动作序列,并通过视觉状态转换识别任务完成情况。

c) 错误检测和恢复:稳健运行需要诊断故障并从中恢复。建立一个层级结构——错误存在、错误分类和错误恢复——来衡量智体识别错误(例如,机械臂滑脱)、归因错误原因并提出纠正措施的能力,而无需实际执行错误操作。

d) 人类意图理解:有效的协作需要对其他智体的目标进行推理。通过人类意图理解来评估这一点,其中智体必须从视频上下文中推断人类目标以预测合作行为,并将协作视为一种具身推理任务。

如图显示 ERIQ 基准测试在其 15 个细粒度子任务中的分布情况。该数据集由 100 多个不同的任务场景构成,涵盖五个领域:家庭 (35%)、餐厅 (20%)、超市 (20%)、工业 (15%) 和办公室 (10%)。为了全面评估多模态推理能力,该数据集整合三种模态:单幅图像 (53%) 用于基础感知,序列图像 (26%) 用于时间动态,交错图像-文本序列 (21%) 用于上下文丰富的推理。

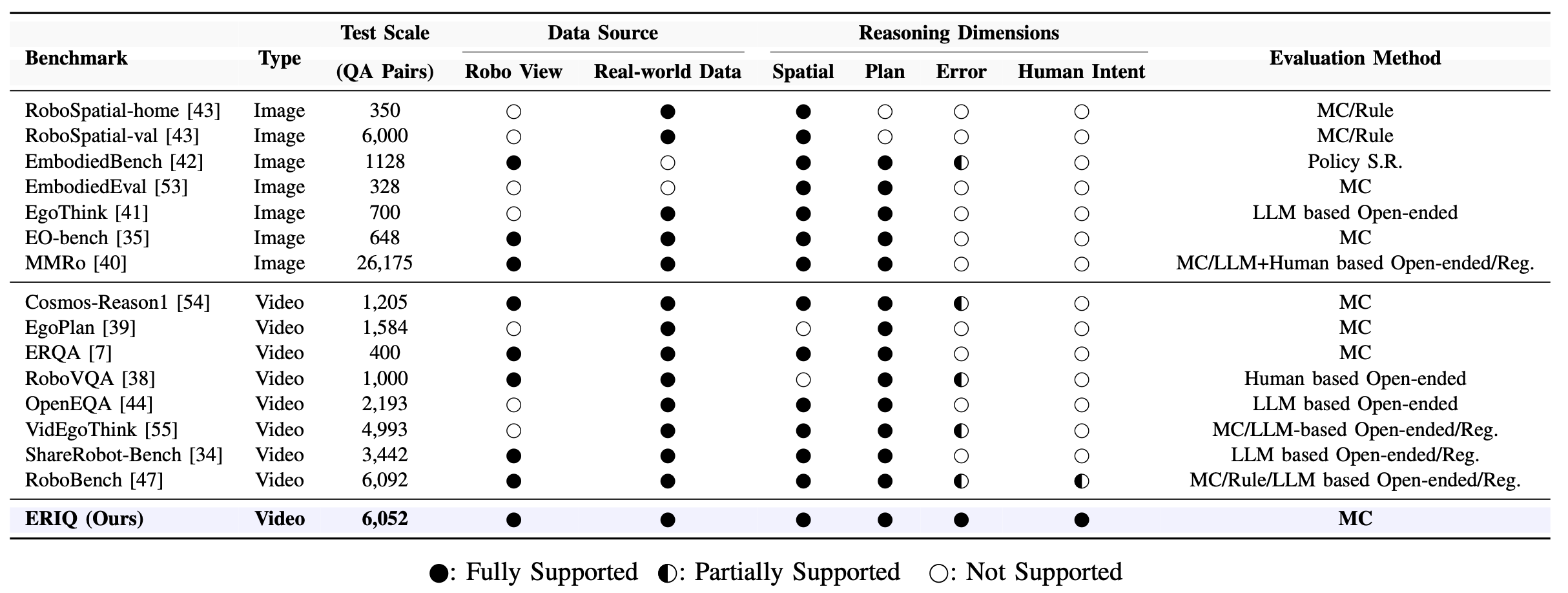

尽管现有的具身推理基准测试范围不断扩大,但它们通常将任务失败视为最终的诊断状态,忽略可操作错误恢复所需的闭环推理。此外,诸如人类意图推断和协作推理等维度在当前的评估中仍然基本缺失。如表所示,ERIQ 通过提供迄今为止更全面的评估套件,在具身推理领域开辟新的前沿。与现有基准测试提供的零散支持不同,ERIQ 是唯一能够全面覆盖所有四个关键推理维度(空间感知、时间规划、错误检测与恢复以及人类意图理解)的框架。与之形成鲜明对比的是,即使是像 MMRo [40] 这样的大规模基准测试,或像 EgoPlan [39] 这样的专业基准测试,也主要关注基本的空间或规划任务,而像错误恢复和人类意图理解这样的高阶认知维度要么完全缺失,要么仅部分涉及。

ERIQ 包含 6,052 个问答对,所有问答对均源自真实的机器人实验,以确保忠实的第一人称机器人视角。通过采用确定性的多项选择 (MC) 评估协议,ERIQ 消除基于 LLM 的评分或人工开放式评估中固有的主观性和噪声,为推进稳健的通用型 VLA 模型提供一个严谨且可复现的诊断工具。

利用 ERIQ 基准测试,后续实验表明,ERIQ 上的高推理得分与端到端操作任务的更高成功率之间存在明显的关联,验证更强大的推理能力是通用机器人控制的基础驱动力。

将通用机器人操作任务建模为一个策略学习问题,该策略由参数 θ 决定。系统接收多模态观测流,并在连续动作空间 A 中运行(例如,末端执行器姿态和夹爪状态)。在每个时间步 τ,观测 o_τ 包含 Tobs 图像 I_τ 和自然语言指令 l。

遵循视觉-语言-动作 (VLA) 路径,将策略学习转化为一个多模态动作生成任务。具体而言,目标是在给定当前观测和指令的条件下,最大化预测未来动作块 a_τ : τ + H 的对数似然,其中 H 表示预测范围。

为了有效地将VLM的语义推理应用于高精度机器人控制,必须调和模型离散自回归骨干网络与运动执行连续性之间的冲突。现有的离散化策略面临着不同的局限性:均匀分箱(binning)需要大量的tokens才能匹配操作所需的精度[3][2];学习的量化(例如,VQ-VAE)虽然实现紧凑性,但缺乏高精度控制[21];基于规则的自适应方法(例如,FAST[12])由于其序列长度的不确定性而引入解码不稳定性[23]。

为了解决这些问题,提出FACT(流匹配动作token化器)。核心思想是将VQ-VAE式的离散化与流匹配解码头相结合[56]。通过将细粒度运动生成的负担从离散潜空间转移到生成解码过程,FACT 使 VLM 能够在紧凑稳定的离散空间中进行规划,同时通过常微分方程积分恢复高保真度的连续轨迹。

基于 FACT,提出 GenieReasoner 系统,如图所示。该系统分两个阶段运行:(1)训练(图 a):采用统一的流水线,联合训练 VLM 的多模态推理和机器人控制能力。通过将连续动作序列token化为离散动作 token序列,VLM 主干网络学习将多模态观测和高级指令映射到紧凑的动作tokens。(2)推理(图 b):在部署过程中,VLM 主干网络生成的离散动作代码通过 FACT 解码器映射回连续控制信号。通过求解概率流常微分方程,解码器确保基于任务指令语义的高精度操作。该集成框架使 GenieReasoner 能够利用 VLM 的推理能力,同时保持复杂机器人任务所需的灵巧性和精确性。

FACT:流匹配动作token化器

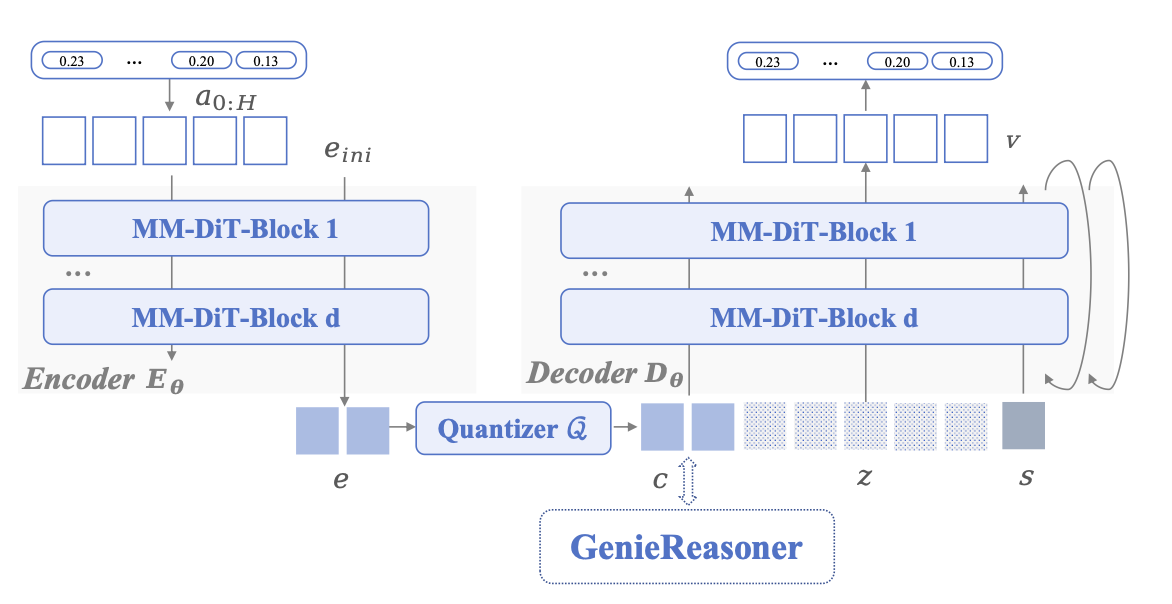

FACT 架构包含一个 VQ 编码器 E_θ 和一个流匹配解码器 D_θ。这两个组件的核心均采用多模态扩散transformer (MM-DiT) 架构 [57],该架构配置为处理块大小为 1 的序列。

a) 编码器和量化:token化过程首先将动作块标准化为 a_0:H。编码器 E_θ 将此输入映射到连续的潜表示 e,同时执行时间 (L ≤ H) 和空间 (D ≤ S) 压缩。如图所示,用零初始化的查询 e_ini 与动作特征进行交互:

为了获得离散表示,采用按照基于无查找表量化方法 [58] 的位级量化器。连续嵌入 e 根据其元素的符号映射到离散码 c ∈ {−1, +1}。

b) 流匹配解码器:用整流目标函数 [56] 训练解码器网络 D_θ。目标是学习沿直线轨迹的速度场,该轨迹将样本从标准高斯分布传输到数据分布。该轨迹由线性插值定义。解码器经过训练,可以根据噪声状态 a(t)、流时间步长 t 和条件 c 预测速度 v(t)。在架构上,t 通过 AdaLN 调制注入到 MM-DiT 模块中,使模型能够根据积分图的多模态观测和高级指令轨迹调整其预测。

c) 训练损失:训练目标函数结合量化正则化和流匹配损失。参照文献[58],对量化过程应用熵损失和承诺损失。而熵损失,最大化码本在批次内码的经验分布上的使用率。承诺损失确保连续嵌入值与其量化值保持接近。解码器网络D_θ的流匹配损失被定义为一个简单的均方误差目标。

d) 推理与积分:在推理阶段,VLA策略π_θ自回归地预测离散动作码序列cˆ。这些码被传递给预训练的解码器D_θ以生成连续动作轨迹。具体来说,求解由学习速度场定义的常微分方程(ODE),并利用流积分时间变量 t ∈[0,1]来区分生成过程和物理动作时间步。具体来说,从 t = 0 时刻的高斯噪声 aˆ(t=0) ∼ N (0, I ) 出发,对解码器预测的速度进行数值积分,其中解码器以当前中间状态 aˆt(而非初始噪声)作为输入。随后,机器人控制器执行重构的动作 aˆ = aˆ(t=1)。该推理过程连接高层推理和底层运动控制:策略生成离散且语义相关的动作tokens,而扩散解码器则确保高保真且物理上可行的运动重构。

实现细节

a) 训练数据:为了在增强具身理解和推理能力的同时保留通用的视觉语言能力,精心构建一个混合源训练数据集,该数据集结合通用多模态数据和具身推理专用数据集。对于通用的VLM训练,用开源的多模态数据集,包括Cambrian-10M [59]、LLaVA-OneVision [60]、Describe Anything [61]、CogVLM-SFT-311K [62]和BLIP3-Grounding-50M [63],涵盖图像、视频、对话式问答和检测模板问答。这些语料库的部分内容经过转换和翻译,以支持双语(中文/英文)训练。为了增强具身理解,进一步整合多个开源的具身智能数据集,例如NVIDIA Cosmos-Reason [54]、ShareRobot [34]、Robo2VLM [64]、EmbSpatial-SFT [65]和ManipulationVQA-60K [64],这些数据集涵盖规划、轨迹推理、空间理解和具身VQA等领域。虽然公开数据集提供广泛的具身知识,但它们通常与实际部署所需的特定自我中心视角存在分布不匹配。为了确保推理与机器人观察空间的同质性对齐,基于 AgiBot World [5] 构建一个具身推理数据集,其中包括:(i) 二维轨迹数据,其中动作序列被投影到三个视角(俯视和双腕)的图像上;(ii) 结合人工标注和自动标注的标注,用于关键对象识别和定位;(iii) 子任务规划数据,这些数据经过完整标注和语言重写,以确保多样性;以及 (iv) 场景理解和其他必要的辅助任务。

对于动作预训练,利用来自 AgiBot World 平台的大规模具身演示、在 ARX 和 AgileX 机器人上收集的多具身数据,以及各种开源操作数据集,从而在具身、场景和执行方式方面提供了丰富的多样性。

b) 训练方案:实施了一种三阶段训练策略,包括两个预训练阶段和一个最终的后训练阶段。在第一阶段,使用定义的损失函数,按照前面提到的方法训练 FACT token化器。在第二阶段,对通用 VQA 数据、具身 VQA 数据和token化后的动作数据进行端到端联合训练。这种联合预训练使模型能够在统一的表征空间内同时获得时空落地和运动控制能力。在第三阶段也是最后一个阶段,进行针对特定任务后训练模式的训练,同时保持共同训练的目标——混合具身 VQA 和动作数据——以稳定一致性并防止推理能力的灾难性遗忘。

DAMO开发者矩阵,由阿里巴巴达摩院和中国互联网协会联合发起,致力于探讨最前沿的技术趋势与应用成果,搭建高质量的交流与分享平台,推动技术创新与产业应用链接,围绕“人工智能与新型计算”构建开放共享的开发者生态。

更多推荐

已为社区贡献99条内容

已为社区贡献99条内容

所有评论(0)