算法调度:场景分析、策略与工程化技术难点——无人机全量感知 vs 机器人定点路由

算法调度的本质是在业务需求与物理约束之间寻找平衡点。无人机调度是在和“物理极限”(显存容量、带宽、算力)做斗争,追求的是高效的吞吐率与实时性;而机器人调度是在和“逻辑复杂度”(依赖管理、状态流转)做斗争,追求的是业务逻辑的准确性、鲁棒性与灵活性。

算法调度:场景分析、策略与工程化技术难点

在边缘计算与嵌入式视觉领域,算法调度不仅仅是简单的“调用模型”,而是业务逻辑与底层硬件资源的博弈。本文将从两个典型的业务场景出发,分析其背后的调度策略,并深入探讨工程化落地中的核心技术难点。

一、场景分析与调度策略

场景一:无人机(全量感知模式)

核心逻辑:全量感知,以高召回率为导向(“宁可错杀一千,不可放过一个”),旨在应对未知威胁。

1. 为什么必须“全量过一遍”?

- 环境未知:无人机飞行场景属于非结构化环境,无固定剧本(可能穿越森林、掠过水面、飞越人群),无法预判下一帧的视觉内容。

- 任务被动:核心任务是“搜寻”未知异常(如入侵的人、车、突发的火、船)。若发生漏检(例如未发现初期火灾),可能引发严重的安全事故。

- 输入定义:以全图为输入,算法模型必须有能力覆盖画面中“所有可能的异常”。

2. 潜在问题与挑战

- 误报率飙升:全图扫描模式会导致大量误检(如地面石头被误判为车辆、红色塑料袋被误判为火焰)。工程上通常需要引入多帧跟踪或多模态数据融合来过滤误报。

- 算力无效消耗:由于缺乏先验知识,90%的画面区域可能并无目标(如大面积天空或空地),但所有算法仍需对全图进行满负荷推理,导致资源利用率低下。

场景二:机器人(定点路由模式)

核心逻辑:定点核查,以高精确率与业务闭环为导向(“在正确位置找特定问题”),聚焦于已知范围。

1. 为什么“依据路由检测”?

- 环境脚本化:巡检路线通常是固定的,检测点位已预设(例如点位 A 对应“变压器”)。

- 任务主动:核心任务是“核查”已知范围(如检查变压器),系统只需运行必要的算法(如漏油检测、表计读数识别),无需关注背景杂波。

- 输入定义:以**感兴趣区域(ROI)**为输入(如直接裁剪出仪表盘区域),而非原始全图。

2. 核心优势

- 强抗干扰性:通过ROI裁剪,天然过滤了环境的不确定性(如背景中经过的猫不会干扰仪表读数的判断)。

- 算力极致应用:仅运行必要的算法,且输入的ROI分辨率远小于全图,能有效降低功耗,延长机器人续航或提升单位时间内的巡检点位数。

两种模式的“检测范围”对比

| 维度 | 场景一:无人机(全量感知) | 场景二:机器人(定点核查) |

|---|---|---|

| 检测目标 | Everything(全量/所有事物) | Specific(特定/特定事物) |

| 环境假设 | Open World(开放世界) | Closed World(封闭世界) |

| 调度逻辑 | 广度优先 | 深度优先 |

| 失败代价 | 漏检代价大(如未及时发现火情) | 误判/错查代价大(如读数错误导致停机) |

| 数据处理 | 全图推理 | ROI聚焦(裁剪+局部推理) |

总结:无人机调度是在应对 “未知的未知”,策略上需全量铺开以覆盖所有可能性;而机器人调度是在应对 “已知的已知”,策略上可精准路由以聚焦特定目标。

在明确了业务逻辑和调度策略后,我们需要拆解这两种模式在工程化落地中各自面临的核心技术挑战。

二、工程化技术难点

场景一:单帧多检测(无人机)

核心技术难点:高并发下的资源争抢与实时性保障

这种模式看似简单(多模型并行跑),但在底层实现上,为了榨干嵌入式硬件(如NVIDIA Jetson)的极限性能,会遇到非常硬核的系统级问题。

1. 显存碎片与 OOM(Out Of Memory)

难点描述:

假设同一帧图像需要并发经过 10 个算法模型。虽然输入图片共享了,但每个模型都有独立的 Workspace(工作空间)和 Output Tensor(输出张量)。

- 容量瓶颈:若模型 A 需 500MB,模型 B 需 300MB……10 个模型累加可能瞬间撑爆嵌入式 GPU 的显存。

- 碎片化危机:并发申请小块内存容易,但申请大块连续内存难。并发释放时,显存空间变得不连续,导致明明总剩余空间足够,却无法分配大块内存,引发 OOM。

工程解法:

- 显存池化:在启动时预分配一大块连续显存,内部自行管理分配与释放,避免频繁调用

cudaMalloc/cudaFree带来的开销和碎片。 - 显存复用:利用推理引擎(如 TensorRT)的 Workspace Reuse 特性,或在时序上错峰计算,让多个模型共享同一块临时显存空间。

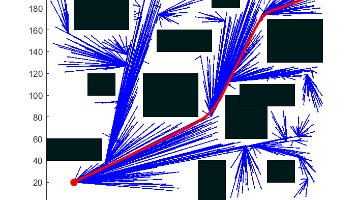

2. CPU/GPU 流水线与背压

难点描述:

无人机数据处理是典型的流式数据。

- 阶段 A(CPU):视频流解码、Resize、归一化。

- 阶段 B(GPU):10 个模型并发推理。

- 问题:如果阶段 B 处理变慢(例如某帧画面复杂,NMS 耗时激增),阶段 A 仍在持续生产数据。这会导致内存队列积压成千上万帧,系统延迟增加甚至崩溃。

工程解法:

- 有限队列 + 丢弃策略:严格限制队列长度(如 5 帧)。当 GPU 忙不过来时,直接丢弃新到来的帧。对于实时巡航场景,处理“最新的一帧”比处理“落后的一秒前的帧”更有意义。

- 异步流水线:利用 CUDA Stream 将 CPU 预处理与 GPU 推理重叠。CPU 在准备第 N+1 帧数据时,GPU 并行处理第 N 帧。

3. 并发推理的线程安全

难点描述:

虽然主流推理引擎(如 TensorRT)的核心 API 是线程安全的,但往往引入的第三方插件或预处理库可能不是。

- 当多个线程同时调用

enqueue()进行推理时,若底层存在全局静态变量或未加锁的资源访问,会引发竞态条件。这种 Bug 表现为随机的程序崩溃或推理结果错乱,极难排查。

工程解法:

- 单例多上下文:模型权重(只读数据)共享,但每个推理线程必须持有自己独立的 Execution Context(执行上下文),隔离运行时状态。

场景二:动态路由(巡检机器人)

核心技术难点:配置依赖管理与上下文传递

这种模式看似灵活,但在处理复杂的“如果-那么”业务逻辑时,代码很容易退化成难以维护的“面条代码”。

1. 动态图构建与内存管理

难点描述:

在运行之前,系统无法确定具体会触发哪条计算链路。

- 链路多样性:链路 1 可能是

分类 -> 检测 -> OCR;链路 2 可能是分类 -> 分割 -> 测量。 - 内存困境:不同链路需要的 Tensor 形状各不相同。若为了兼容所有情况而预先分配最大内存,会造成巨大浪费;若每次都动态申请释放,又会引入严重的性能损耗。

工程解法:

- 按需实例化:只有当路由逻辑确定需要运行 OCR 时,才加载 OCR 引擎并分配相应资源。

- 对象池模式:针对常见的 Tensor 尺寸建立内存池。处理完毕后归还内存,避免频繁的系统级

malloc/free操作。

2. ROI 坐标映射与变换

难点描述:

这是工程中最容易出 Bug 的环节,涉及多次坐标空间的转换。

- 转换链路:原图(4K)-> 缩放到 640x640 进分类器 -> 检测出目标坐标 (100, 100) -> 映射回原图坐标 -> 在原图上 Crop 出 ROI -> 送给下一级算法。

- 常见坑点:如果中间任何一步的 Resize 算法不统一(例如一个用了 LetterBox 填充,一个用了 Stretch 拉伸),或者在坐标转换时遗漏了缩放系数/Padding偏移量,后续所有算法的输入都是错的。

工程解法:

- 维护变换矩阵:每个算法节点不仅输出检测结果,还要输出该结果相对于原图的变换参数(Scale, Offset, Padding)。

- 统一坐标系统:封装统一的

Rect或Region类,重载运算符,自动处理不同分辨率和变换方式下的坐标映射,确保算法逻辑层只关注归一化坐标。

3. 执行编排的开销

难点描述:

巡检机器人虽不要求毫秒级的实时响应,但面对大规模巡检任务,调度器自身的开销不能被忽视。

- 如果调度逻辑用 Python 编写,每帧都涉及查表、反射调用、对象实例化,解释器的额外开销甚至可能超过算法推理本身。

工程解法:

- 将核心调度逻辑迁移至 C++,或使用编译型语言编写业务编排层,减少动态语言带来的性能损耗。

工程化难点对比表

| 维度 | 场景一:单帧多检测(无人机) | 场景二:动态路由(机器人) |

|---|---|---|

| 核心技术挑战 | 资源极限应用:在有限显存/内存下跑最多的算法。 | 复杂逻辑编排:灵活管理算法间的依赖与数据流。 |

| 内存痛点 | 显存碎片化 & OOM:并发导致的资源耗尽。 | 动态内存分配:数据形状不固定导致的分配开销。 |

| 数据痛点 | 背压与丢帧:生产速度 > 消费速度导致的积压。 | 坐标映射(ROI):检测框在不同分辨率下的转换错误。 |

| 代码架构 | 线程池 + 共享指针:强调并发安全和无锁设计。 | 状态机 / 责任链模式:强调流程的可配置性和扩展性。 |

| 调试难度 | 高并发 Bug:难以复现,偶现崩溃或结果抖动。 | 逻辑 Bug:较多,如“分类对了但路由错了”。 |

总结

算法调度的本质是在业务需求与物理约束之间寻找平衡点。无人机调度是在和“物理极限”(显存容量、带宽、算力)做斗争,追求的是高效的吞吐率与实时性;而机器人调度是在和“逻辑复杂度”(依赖管理、状态流转)做斗争,追求的是业务逻辑的准确性、鲁棒性与灵活性。

DAMO开发者矩阵,由阿里巴巴达摩院和中国互联网协会联合发起,致力于探讨最前沿的技术趋势与应用成果,搭建高质量的交流与分享平台,推动技术创新与产业应用链接,围绕“人工智能与新型计算”构建开放共享的开发者生态。

更多推荐

已为社区贡献4条内容

已为社区贡献4条内容

所有评论(0)