元控制在动态环境适应中的应用研究

在当今复杂多变的动态环境中,许多系统需要具备自适应能力以维持高效、稳定的运行。元控制作为一种高级控制策略,为系统在动态环境下的适应提供了新的思路和方法。本文的目的在于全面研究元控制在动态环境适应中的应用,涵盖元控制的基本概念、算法原理、数学模型,通过实际案例展示其应用效果,并分析其未来发展趋势和挑战。范围涉及控制理论、人工智能、机器人技术等多个领域,旨在为相关研究和实践提供有价值的参考。本文将按照

元控制在动态环境适应中的应用研究

关键词:元控制、动态环境适应、智能系统、控制理论、自适应机制

摘要:本文聚焦于元控制在动态环境适应中的应用,深入探讨了元控制的核心概念、算法原理、数学模型等内容。通过详细的Python代码示例和项目实战,展示了元控制在实际场景中的实现和应用。同时,分析了元控制在不同领域的实际应用场景,推荐了相关的学习资源、开发工具和论文著作。最后,对元控制未来的发展趋势和面临的挑战进行了总结,并解答了常见问题。旨在为研究人员和开发者提供全面且深入的关于元控制在动态环境适应方面的知识和实践指导。

1. 背景介绍

1.1 目的和范围

在当今复杂多变的动态环境中,许多系统需要具备自适应能力以维持高效、稳定的运行。元控制作为一种高级控制策略,为系统在动态环境下的适应提供了新的思路和方法。本文的目的在于全面研究元控制在动态环境适应中的应用,涵盖元控制的基本概念、算法原理、数学模型,通过实际案例展示其应用效果,并分析其未来发展趋势和挑战。范围涉及控制理论、人工智能、机器人技术等多个领域,旨在为相关研究和实践提供有价值的参考。

1.2 预期读者

本文预期读者包括控制理论、人工智能、机器人等领域的研究人员、工程师和学生。对于希望了解元控制在动态环境适应中应用的专业人士,以及对相关领域感兴趣的初学者,本文都将提供深入且易懂的内容。

1.3 文档结构概述

本文将按照以下结构展开:首先介绍元控制和动态环境适应的基本概念及相关术语;接着阐述元控制的核心算法原理和具体操作步骤,并给出Python代码示例;然后介绍元控制的数学模型和公式,并通过具体例子进行说明;之后通过项目实战展示元控制在实际中的应用;分析元控制在不同领域的实际应用场景;推荐相关的学习资源、开发工具和论文著作;最后总结元控制的未来发展趋势和挑战,解答常见问题,并提供扩展阅读和参考资料。

1.4 术语表

1.4.1 核心术语定义

- 元控制:元控制是一种高级控制机制,它能够对系统的控制策略进行监控、评估和调整,以适应不同的环境和任务需求。元控制通过对系统的状态和性能进行实时监测,根据预设的目标和规则,动态地改变控制参数或选择不同的控制策略。

- 动态环境:动态环境是指环境的状态和特征随时间不断变化的环境。在动态环境中,系统面临的任务、约束条件和干扰因素等都可能发生变化,要求系统具备自适应能力。

- 自适应机制:自适应机制是指系统能够根据环境的变化自动调整自身的行为和参数,以保持良好的性能和稳定性。自适应机制可以基于反馈控制、学习算法等实现。

1.4.2 相关概念解释

- 控制策略:控制策略是指系统为了实现特定目标而采取的控制方法和规则。常见的控制策略包括PID控制、模糊控制、神经网络控制等。

- 系统状态:系统状态是指描述系统当前状况的一组变量。系统状态可以包括物理量(如温度、压力、速度等)和逻辑量(如开关状态、工作模式等)。

- 性能评估:性能评估是指对系统的性能进行量化和评价的过程。性能评估指标可以包括稳定性、准确性、快速性、鲁棒性等。

1.4.3 缩略词列表

- PID:Proportional - Integral - Derivative,比例 - 积分 - 微分控制

- AI:Artificial Intelligence,人工智能

- ML:Machine Learning,机器学习

2. 核心概念与联系

元控制的基本原理

元控制的核心思想是在传统控制的基础上增加一层更高层次的控制,即元控制层。元控制层负责对底层控制策略进行监控和调整,以适应动态环境的变化。元控制层通过对系统的状态和性能进行实时监测,根据预设的目标和规则,动态地改变控制参数或选择不同的控制策略。

元控制与动态环境适应的联系

在动态环境中,传统的固定控制策略往往难以适应环境的变化,导致系统性能下降甚至失效。元控制通过实时监测环境变化和系统状态,能够及时调整控制策略,使系统在不同的环境条件下都能保持良好的性能。例如,在机器人导航中,元控制可以根据环境的障碍物分布和机器人的位置、速度等信息,动态地调整机器人的运动策略,以避免碰撞并快速到达目标。

元控制架构示意图

该流程图展示了元控制系统的基本架构。动态环境通过传感器被感知,系统状态监测模块获取系统的当前状态。元控制层根据系统状态和性能评估结果,选择和调整合适的控制策略。底层控制器根据元控制层的指令执行控制任务,通过执行器影响系统行为。性能评估模块对系统的性能进行评估,并将结果反馈给元控制层,形成一个闭环控制系统。

3. 核心算法原理 & 具体操作步骤

元控制算法原理

元控制算法的核心是根据系统的状态和性能评估结果,动态地选择和调整控制策略。常见的元控制算法包括基于规则的方法、基于学习的方法和基于优化的方法。

基于规则的元控制算法

基于规则的元控制算法通过预设的规则来决定控制策略的选择和调整。这些规则可以是专家经验、领域知识或实验结果。例如,在一个温度控制系统中,如果温度超过了设定的上限,元控制可以根据规则选择更强的制冷策略;如果温度低于设定的下限,则选择加热策略。

以下是一个简单的基于规则的元控制Python代码示例:

# 定义系统状态和控制策略

system_state = 25 # 假设系统状态为温度

setpoint = 20 # 设定目标温度

control_strategies = {

'heating': lambda: 1,

'cooling': lambda: -1,

'maintain': lambda: 0

}

# 定义规则

def rule_based_meta_control(state, setpoint):

if state > setpoint + 2:

return control_strategies['cooling']()

elif state < setpoint - 2:

return control_strategies['heating']()

else:

return control_strategies['maintain']()

# 执行元控制

control_action = rule_based_meta_control(system_state, setpoint)

print(f"Control action: {control_action}")

在这个示例中,我们定义了系统的当前状态(温度)和目标温度,以及三种控制策略:加热、制冷和维持。通过规则判断系统状态与目标温度的关系,选择合适的控制策略并执行。

基于学习的元控制算法

基于学习的元控制算法通过学习环境和系统的行为模式,自动调整控制策略。常见的学习方法包括强化学习、神经网络学习等。强化学习通过与环境进行交互,根据奖励信号来学习最优的控制策略。

以下是一个简单的基于强化学习的元控制Python代码示例:

import numpy as np

# 定义环境和状态空间

state_space = 5 # 假设状态空间有5个状态

action_space = 3 # 假设动作空间有3个动作

# 初始化Q表

Q = np.zeros((state_space, action_space))

# 定义参数

alpha = 0.1 # 学习率

gamma = 0.9 # 折扣因子

epsilon = 0.1 # 探索率

episodes = 100 # 训练回合数

# 定义环境交互函数

def environment_step(state, action):

# 这里简单模拟环境反馈

next_state = np.random.randint(0, state_space)

reward = np.random.randint(-1, 2)

return next_state, reward

# 强化学习训练

for episode in range(episodes):

state = np.random.randint(0, state_space)

done = False

while not done:

if np.random.uniform(0, 1) < epsilon:

action = np.random.randint(0, action_space)

else:

action = np.argmax(Q[state, :])

next_state, reward = environment_step(state, action)

Q[state, action] = (1 - alpha) * Q[state, action] + alpha * (reward + gamma * np.max(Q[next_state, :]))

state = next_state

if np.random.uniform(0, 1) < 0.1: # 简单模拟结束条件

done = True

# 测试

state = np.random.randint(0, state_space)

action = np.argmax(Q[state, :])

print(f"Best action for state {state}: {action}")

在这个示例中,我们使用强化学习的Q - learning算法来学习最优的控制策略。通过与环境进行交互,不断更新Q表,最终得到在不同状态下的最优动作。

具体操作步骤

- 系统状态监测:通过传感器获取系统的当前状态信息,包括物理量(如温度、压力、速度等)和逻辑量(如开关状态、工作模式等)。

- 性能评估:根据系统的目标和任务要求,对系统的性能进行评估。性能评估指标可以包括稳定性、准确性、快速性、鲁棒性等。

- 控制策略选择与调整:元控制层根据系统状态和性能评估结果,选择合适的控制策略并进行调整。可以使用基于规则的方法、基于学习的方法或基于优化的方法。

- 底层控制执行:底层控制器根据元控制层的指令执行控制任务,通过执行器影响系统行为。

- 反馈与循环:性能评估模块对系统的性能进行实时监测,并将结果反馈给元控制层。元控制层根据反馈信息不断调整控制策略,形成一个闭环控制系统。

4. 数学模型和公式 & 详细讲解 & 举例说明

元控制的数学模型

元控制可以用一个动态系统来描述。假设系统的状态向量为 x ( t ) ∈ R n \mathbf{x}(t) \in \mathbb{R}^n x(t)∈Rn,控制输入向量为 u ( t ) ∈ R m \mathbf{u}(t) \in \mathbb{R}^m u(t)∈Rm,环境干扰向量为 d ( t ) ∈ R p \mathbf{d}(t) \in \mathbb{R}^p d(t)∈Rp,则系统的动态方程可以表示为:

x ˙ ( t ) = f ( x ( t ) , u ( t ) , d ( t ) ) \dot{\mathbf{x}}(t) = f(\mathbf{x}(t), \mathbf{u}(t), \mathbf{d}(t)) x˙(t)=f(x(t),u(t),d(t))

其中, f f f 是一个非线性函数,表示系统的动态特性。

元控制的目标是通过调整控制输入 u ( t ) \mathbf{u}(t) u(t),使系统的状态 x ( t ) \mathbf{x}(t) x(t) 尽可能接近目标状态 x d ( t ) \mathbf{x}_d(t) xd(t)。为了实现这一目标,元控制需要根据系统的状态和性能评估结果,动态地选择和调整控制策略。

性能评估指标

常见的性能评估指标包括误差积分指标和能量消耗指标。

误差积分指标

误差积分指标用于衡量系统的输出与目标输出之间的误差。常见的误差积分指标包括积分绝对误差(IAE)、积分平方误差(ISE)和积分时间绝对误差(ITAE)。

-

积分绝对误差(IAE):

I A E = ∫ 0 T ∣ e ( t ) ∣ d t IAE = \int_{0}^{T} |e(t)| dt IAE=∫0T∣e(t)∣dt

其中, e ( t ) = x d ( t ) − x ( t ) e(t) = \mathbf{x}_d(t) - \mathbf{x}(t) e(t)=xd(t)−x(t) 是系统的误差向量, T T T 是评估时间。 -

积分平方误差(ISE):

I S E = ∫ 0 T e T ( t ) e ( t ) d t ISE = \int_{0}^{T} e^T(t) e(t) dt ISE=∫0TeT(t)e(t)dt -

积分时间绝对误差(ITAE):

I T A E = ∫ 0 T t ∣ e ( t ) ∣ d t ITAE = \int_{0}^{T} t |e(t)| dt ITAE=∫0Tt∣e(t)∣dt

能量消耗指标

能量消耗指标用于衡量系统在运行过程中的能量消耗。假设系统的控制输入 u ( t ) \mathbf{u}(t) u(t) 与能量消耗成正比,则能量消耗指标可以表示为:

E = ∫ 0 T u T ( t ) u ( t ) d t E = \int_{0}^{T} \mathbf{u}^T(t) \mathbf{u}(t) dt E=∫0TuT(t)u(t)dt

举例说明

考虑一个简单的一阶系统:

x ˙ ( t ) = − a x ( t ) + b u ( t ) + d ( t ) \dot{x}(t) = -ax(t) + bu(t) + d(t) x˙(t)=−ax(t)+bu(t)+d(t)

其中, a > 0 a > 0 a>0 是系统的衰减系数, b b b 是控制增益, d ( t ) d(t) d(t) 是环境干扰。

假设目标状态为 x d ( t ) = 1 x_d(t) = 1 xd(t)=1,我们可以使用PID控制器作为底层控制器:

u ( t ) = K p e ( t ) + K i ∫ 0 t e ( τ ) d τ + K d d e ( t ) d t u(t) = K_p e(t) + K_i \int_{0}^{t} e(\tau) d\tau + K_d \frac{de(t)}{dt} u(t)=Kpe(t)+Ki∫0te(τ)dτ+Kddtde(t)

其中, K p K_p Kp、 K i K_i Ki 和 K d K_d Kd 分别是比例、积分和微分增益, e ( t ) = x d ( t ) − x ( t ) e(t) = x_d(t) - x(t) e(t)=xd(t)−x(t) 是误差。

元控制的任务是根据系统的状态和性能评估结果,动态地调整PID控制器的参数 K p K_p Kp、 K i K_i Ki 和 K d K_d Kd。例如,我们可以使用基于规则的方法,根据误差的大小和变化率来调整参数:

- 如果 ∣ e ( t ) ∣ > ϵ 1 |e(t)| > \epsilon_1 ∣e(t)∣>ϵ1 且 d e ( t ) d t > ϵ 2 \frac{de(t)}{dt} > \epsilon_2 dtde(t)>ϵ2,则增加 K p K_p Kp 和 K d K_d Kd;

- 如果 ∣ e ( t ) ∣ < ϵ 3 |e(t)| < \epsilon_3 ∣e(t)∣<ϵ3 且 d e ( t ) d t < ϵ 4 \frac{de(t)}{dt} < \epsilon_4 dtde(t)<ϵ4,则减小 K i K_i Ki。

通过不断调整PID控制器的参数,元控制可以使系统在动态环境中保持良好的性能。

5. 项目实战:代码实际案例和详细解释说明

5.1 开发环境搭建

本项目使用Python作为开发语言,主要使用以下库:

- NumPy:用于数值计算和数组操作。

- Matplotlib:用于数据可视化。

可以使用以下命令安装这些库:

pip install numpy matplotlib

5.2 源代码详细实现和代码解读

项目背景

我们考虑一个简单的温度控制系统,系统的目标是将温度维持在设定值附近。环境温度会随时间变化,模拟动态环境。

代码实现

import numpy as np

import matplotlib.pyplot as plt

# 系统参数

a = 0.1 # 系统衰减系数

b = 0.5 # 控制增益

dt = 0.1 # 时间步长

T = 100 # 总时间

t = np.arange(0, T, dt)

# 设定目标温度

setpoint = 25

# 初始化状态和控制输入

x = np.zeros(len(t))

u = np.zeros(len(t))

# 元控制参数

Kp = 1.0

Ki = 0.1

Kd = 0.01

integral = 0

prev_error = 0

# 模拟环境干扰

d = np.sin(0.1 * t) # 环境温度随时间变化

# 元控制循环

for i in range(1, len(t)):

error = setpoint - x[i - 1]

integral += error * dt

derivative = (error - prev_error) / dt

u[i] = Kp * error + Ki * integral + Kd * derivative

x[i] = x[i - 1] + dt * (-a * x[i - 1] + b * u[i] + d[i - 1])

prev_error = error

# 绘制结果

plt.figure(figsize=(12, 6))

plt.subplot(2, 1, 1)

plt.plot(t, x, label='Temperature')

plt.axhline(y=setpoint, color='r', linestyle='--', label='Setpoint')

plt.xlabel('Time')

plt.ylabel('Temperature')

plt.legend()

plt.subplot(2, 1, 2)

plt.plot(t, u, label='Control Input')

plt.xlabel('Time')

plt.ylabel('Control Input')

plt.legend()

plt.show()

代码解读

- 系统参数定义:定义了系统的衰减系数 a a a、控制增益 b b b、时间步长 d t dt dt 和总时间 T T T。

- 目标温度设定:设定目标温度为25。

- 元控制参数初始化:初始化PID控制器的参数 K p K_p Kp、 K i K_i Ki 和 K d K_d Kd,以及积分项和上一次的误差。

- 环境干扰模拟:使用正弦函数模拟环境温度的变化。

- 元控制循环:在每个时间步,计算误差、积分项和微分项,根据PID控制器的公式计算控制输入 u u u,更新系统状态 x x x。

- 结果绘制:使用Matplotlib库绘制系统的温度变化和控制输入的变化。

5.3 代码解读与分析

通过运行上述代码,我们可以看到系统的温度在元控制的作用下逐渐接近目标温度。当环境温度发生变化时,元控制能够及时调整控制输入,使系统保持稳定。

分析代码中的PID控制器参数 K p K_p Kp、 K i K_i Ki 和 K d K_d Kd 的作用:

- 比例增益 K p K_p Kp:比例增益决定了控制器对误差的响应速度。 K p K_p Kp 越大,控制器对误差的响应越迅速,但可能会导致系统振荡。

- 积分增益 K i K_i Ki:积分增益用于消除系统的稳态误差。 K i K_i Ki 越大,积分作用越强,能够更快地消除稳态误差,但可能会导致系统响应变慢。

- 微分增益 K d K_d Kd:微分增益用于预测误差的变化趋势,抑制系统的振荡。 K d K_d Kd 越大,微分作用越强,能够更好地抑制系统的振荡,但可能会引入噪声。

通过调整这些参数,可以优化系统的性能。

6. 实际应用场景

机器人导航

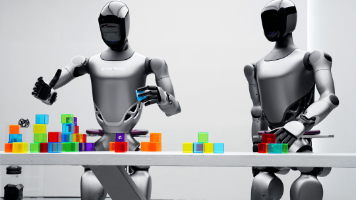

在机器人导航中,环境通常是动态变化的,如障碍物的移动、光照条件的改变等。元控制可以根据机器人的传感器信息,实时监测环境变化和机器人的状态,动态地调整导航策略。例如,当机器人遇到新的障碍物时,元控制可以选择合适的避障策略,如绕行、等待或重新规划路径。

工业生产过程控制

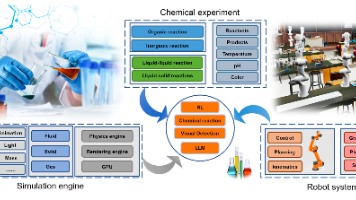

在工业生产过程中,生产环境和生产任务可能会发生变化。元控制可以对生产过程进行实时监测和评估,根据生产需求和环境变化,动态地调整生产参数和控制策略。例如,在化工生产中,元控制可以根据原料质量、反应温度和压力等因素,调整反应物的进料速度和反应时间,以保证产品质量和生产效率。

智能电网管理

智能电网面临着电力需求的波动、新能源发电的间歇性等动态因素。元控制可以对电网的运行状态进行实时监测和分析,根据电力需求和发电情况,动态地调整电网的调度策略。例如,当电力需求增加时,元控制可以协调不同发电设备的输出功率,优化电网的运行效率。

医疗保健系统

在医疗保健系统中,患者的病情和生理状态是动态变化的。元控制可以根据患者的监测数据,实时评估患者的健康状况,动态地调整治疗方案。例如,在重症监护室中,元控制可以根据患者的生命体征(如心率、血压、呼吸等),自动调整药物的剂量和输液速度,提高治疗效果。

7. 工具和资源推荐

7.1 学习资源推荐

7.1.1 书籍推荐

- 《控制理论基础》:本书系统地介绍了控制理论的基本概念、方法和应用,包括经典控制理论和现代控制理论。对于理解元控制的基础理论非常有帮助。

- 《强化学习:原理与Python实现》:强化学习是元控制中常用的学习方法之一。本书详细介绍了强化学习的原理和算法,并通过Python代码示例进行了实现。

- 《人工智能:一种现代的方法》:这本书涵盖了人工智能的各个领域,包括机器学习、控制理论等。对于了解元控制在人工智能领域的应用有很大的帮助。

7.1.2 在线课程

- Coursera上的“Control of Mobile Robots”:该课程介绍了机器人控制的基本原理和方法,包括导航、定位和运动控制等。对于理解元控制在机器人领域的应用有很大的帮助。

- edX上的“Reinforcement Learning”:该课程深入介绍了强化学习的理论和算法,并通过实际案例进行了演示。对于学习基于学习的元控制算法非常有帮助。

7.1.3 技术博客和网站

- IEEE Xplore:IEEE Xplore是电气和电子工程师协会(IEEE)的数字图书馆,提供了大量关于控制理论、人工智能等领域的学术论文和技术报告。

- arXiv:arXiv是一个预印本服务器,提供了最新的学术研究成果。可以在arXiv上搜索关于元控制和动态环境适应的最新研究。

- Towards Data Science:Towards Data Science是一个数据科学和机器学习的技术博客,提供了许多关于控制理论、人工智能等领域的技术文章和教程。

7.2 开发工具框架推荐

7.2.1 IDE和编辑器

- PyCharm:PyCharm是一款专门为Python开发设计的集成开发环境(IDE),提供了丰富的代码编辑、调试和测试功能。

- Jupyter Notebook:Jupyter Notebook是一个交互式的开发环境,适合进行数据分析和实验。可以使用Jupyter Notebook来编写和运行元控制的代码示例。

7.2.2 调试和性能分析工具

- pdb:pdb是Python的标准调试器,可以帮助开发者定位和解决代码中的问题。

- cProfile:cProfile是Python的性能分析工具,可以帮助开发者分析代码的性能瓶颈,优化代码的执行效率。

7.2.3 相关框架和库

- TensorFlow:TensorFlow是一个开源的机器学习框架,提供了丰富的深度学习模型和工具。可以使用TensorFlow来实现基于神经网络的元控制算法。

- OpenAI Gym:OpenAI Gym是一个开源的强化学习环境库,提供了许多不同的环境和任务。可以使用OpenAI Gym来测试和验证基于强化学习的元控制算法。

7.3 相关论文著作推荐

7.3.1 经典论文

- “A Survey of Meta - Control in Intelligent Systems”:该论文对智能系统中的元控制进行了全面的综述,介绍了元控制的基本概念、方法和应用。

- “Reinforcement Learning: An Introduction”:这是强化学习领域的经典著作,详细介绍了强化学习的理论和算法。

7.3.2 最新研究成果

- 可以在IEEE Transactions on Control Systems Technology、Artificial Intelligence等顶级学术期刊上搜索关于元控制和动态环境适应的最新研究成果。

7.3.3 应用案例分析

- 可以在ACM SIGKDD、IEEE International Conference on Robotics and Automation等学术会议上找到关于元控制在不同领域应用的案例分析。

8. 总结:未来发展趋势与挑战

未来发展趋势

- 与人工智能的深度融合:随着人工智能技术的不断发展,元控制将与人工智能的其他领域(如机器学习、深度学习、自然语言处理等)进行更深度的融合。例如,使用深度学习模型来实现更复杂的元控制策略,使用自然语言处理技术来实现人机交互的元控制。

- 多智能体系统中的应用:在多智能体系统中,元控制可以用于协调多个智能体的行为,实现系统的整体优化。例如,在智能交通系统中,元控制可以协调多个车辆的行驶,提高交通效率和安全性。

- 自适应网络控制系统:随着网络技术的发展,越来越多的控制系统采用网络通信。元控制可以用于自适应网络控制系统,解决网络延迟、丢包等问题,提高系统的性能和可靠性。

挑战

- 复杂性管理:元控制涉及到多个层次的控制和决策,系统的复杂性较高。如何有效地管理系统的复杂性,提高系统的可解释性和可维护性,是一个挑战。

- 数据质量和数量:基于学习的元控制算法需要大量的高质量数据来进行训练。如何获取和处理这些数据,保证数据的质量和数量,是一个挑战。

- 实时性要求:在动态环境中,元控制需要实时地对环境变化和系统状态进行响应。如何满足系统的实时性要求,提高系统的响应速度,是一个挑战。

9. 附录:常见问题与解答

问题1:元控制与传统控制有什么区别?

传统控制通常采用固定的控制策略,在设计时假设环境和系统是静态的。而元控制能够实时监测环境变化和系统状态,动态地调整控制策略,以适应不同的环境和任务需求。

问题2:元控制的实现难度大吗?

元控制的实现难度取决于具体的应用场景和所采用的算法。基于规则的元控制相对容易实现,只需要预设一些规则即可。而基于学习的元控制需要掌握机器学习和强化学习等技术,实现难度相对较大。

问题3:元控制在实际应用中需要注意什么?

在实际应用中,需要注意以下几点:

- 系统状态监测的准确性:元控制的决策依赖于系统状态的准确监测,因此需要确保传感器的精度和可靠性。

- 控制策略的选择和调整:需要根据具体的应用场景和任务需求,选择合适的控制策略,并根据系统状态和性能评估结果进行合理的调整。

- 实时性要求:在动态环境中,元控制需要实时地对环境变化和系统状态进行响应,因此需要确保系统的实时性。

10. 扩展阅读 & 参考资料

扩展阅读

- 《智能控制理论与应用》:本书介绍了智能控制的各种理论和方法,包括模糊控制、神经网络控制、遗传算法等,对于深入理解元控制的相关技术有很大的帮助。

- 《机器人学:建模、规划与控制》:这本书涵盖了机器人学的各个方面,包括机器人的运动学、动力学、控制和规划等。对于了解元控制在机器人领域的应用有进一步的拓展作用。

参考资料

- [1] Anderson, B. D. O., & Moore, J. B. (1990). Optimal control: linear quadratic methods. Prentice Hall.

- [2] Sutton, R. S., & Barto, A. G. (2018). Reinforcement learning: An introduction. MIT press.

- [3] Russell, S. J., & Norvig, P. (2010). Artificial intelligence: A modern approach. Pearson Education.

DAMO开发者矩阵,由阿里巴巴达摩院和中国互联网协会联合发起,致力于探讨最前沿的技术趋势与应用成果,搭建高质量的交流与分享平台,推动技术创新与产业应用链接,围绕“人工智能与新型计算”构建开放共享的开发者生态。

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)