从教练到考官,青瞳视觉(CHINGMU)成为中国具身智能进化的关键支撑

宇树科技在G1人形机器人参与CMG世界机器人格斗擂台赛及与UFC精英训练中心的备赛训练中,全面采用了青瞳视觉(CHINGMU)的光学动捕系统,该系统精准捕捉了专业格斗运动员的位姿、速度及关节角度变化等核心运动数据,将人类复杂的拳击、泰拳等动作转化为高精度的训练“蓝本”。行业的脚步从未停歇,青瞳视觉(CHINGMU)的视野已投向更远的未来。通过将操作者(人)的动作数据,甚至精细化到手指的姿态,实时、

当前,全球正掀起一场具身智能的发展浪潮。与在虚拟世界中处理信息的传统AI不同,具身智能强调智能体必须拥有物理实体,通过与真实世界的交互来学习和进化。这一根本性的转变,使得能够适应人类环境与工具的机器人,成为全球科技竞争的前沿焦点。

在这场关乎未来的竞赛中,硬件突破、算法迭代与成本控制固然是显性挑战,但一个更为基础的瓶颈正日益凸显:如何获取驱动机器人在物理世界中生长所必需的、高质量、高精度的“养分”——即真实的运动与交互数据。

上海青瞳视觉科技有限公司(CHINGMU)通过其全栈自研的技术体系,不仅成功打破了国际光学动捕领域的技术垄断,其解决方案更获得了全球具身智能领域的广泛认可和信赖。

核心突破:以亚毫米级光学动捕系统,构建机器人研发的通用数据基座

行业的认可,根植于对机器人研发全流程核心痛点的系统性解决。机器人,作为“三维空间强交互”的复杂系统,其运动控制、算法迭代与性能优化极度依赖高精度、真值级的空间运动数据。青瞳视觉(CHINGMU)的破局之道,在于将其全栈自研的亚毫米级高精度光学动捕系统,深度融入机器人从研发、训练到评测的全生命周期,构建了不可或缺的通用数据基座。

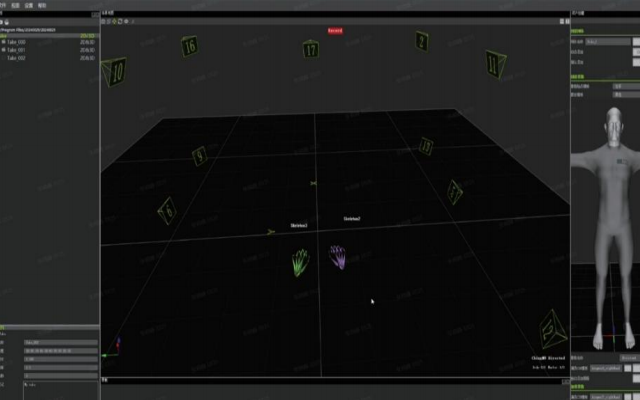

首先,是作为“性能标尺”的精准评测。青瞳视觉(CHINGMU)的光学动捕系统如同为机器人进行“运动体检”,通过实时采集机器人关键部位(关节、末端执行器等)的6DoF运动信息,并生成可视化数据分析报告,满足复杂动作和多机器人协同评测要求。

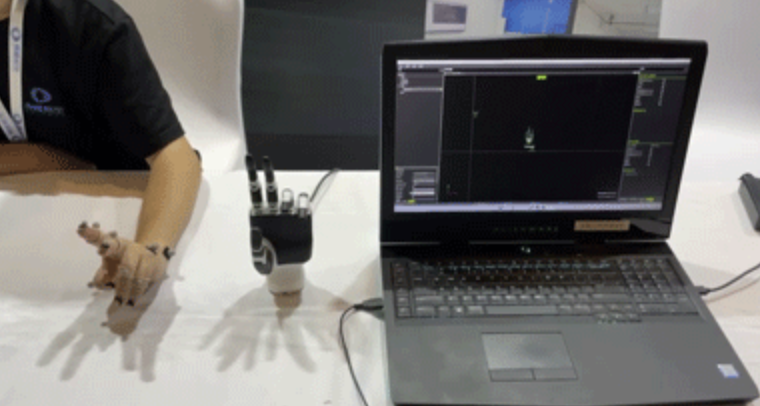

其次,是赋能“灵巧操作”的细微洞察。在灵巧手这一尖端领域,青瞳视觉(CHINGMU)凭借高精度光学手指追踪技术,能够精准捕捉手指的细微动作与关节角度变化,为灵巧手控制研究、算法验证提供真实完整的数据。

进而,是加速“技能学习”的遥操作映射。通过将操作者(人)的动作数据,甚至精细化到手指的姿态,实时、低延迟地映射至机器人端,青瞳视觉(CHINGMU)的遥操作方案极大地缩短了机器人学习复杂动作的研发周期。

然后,是打造“训练数据”的完整工厂。青瞳视觉(CHINGMU)提供的不仅是设备,更是从场地设计、算力中心建设、数据清洗等全流程解决方案。其系统能够精准捕捉机器人在三维空间中的位置、姿态与轨迹,为机器人运动学模型的建立与优化输送高精度的真值训练数据支撑。

成为“标配”方案:深入产学研腹地,从顶尖实验室到领军企业全覆盖

技术价值需要通过广泛的产业应用来印证。青瞳视觉(CHINGMU)的解决方案已成为中国机器人产、学、研链条中备受信赖的基础设施,其合作案例覆盖了从顶尖学术研究到前沿产业化的全链条。

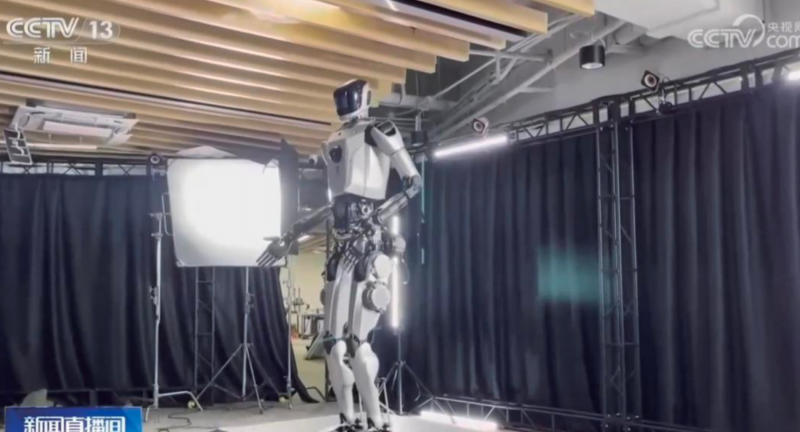

在人形机器人这一领域,青瞳视觉(CHINGMU)是核心的评测与训练伙伴。其为人形机器人(上海)有限公司旗下的国内首款全尺寸通用人形机器人“青龙”提供了全面的性能评测与高精度数据采集服务,为这款标志性产品的运动能力优化提供了依据。不仅如此,青瞳视觉(CHINGMU)还为宇树科技的G1人形机器人提供了关键性的技术支撑。宇树科技在G1人形机器人参与CMG世界机器人格斗擂台赛及与UFC精英训练中心的备赛训练中,全面采用了青瞳视觉(CHINGMU)的光学动捕系统,该系统精准捕捉了专业格斗运动员的位姿、速度及关节角度变化等核心运动数据,将人类复杂的拳击、泰拳等动作转化为高精度的训练“蓝本”。

(人形机器人(上海)有限公司 国内首款全尺寸通用人形机器人训练测试)

(UFC格斗运动员通过青瞳视觉光学动捕系统进行格斗动作数据捕捉)

(宇树科技人形机器人G1与运动员展开格斗互动)

从遥操作的实时数据和反馈来说,行业普遍痛点是数据链路的延迟导致机器人的动作出现明显卡顿、指令响应滞后,使得“人机一体”的协同体验难以实现。而青瞳视觉(CHINGMU)的遥操作解决方案,提供了从人到机器人的高保真动作迁移桥梁。其系统能够将操作者的全身动作,甚至精细到每根手指的姿态,以极低延迟、高保真度的方式实时映射至机器人端。

在灵巧手精细控制方面,手部动作捕捉因其自由度较高、动作细微且存在自遮挡(如手指交叠)等特性,是动捕领域的一大技术难点。青瞳视觉(CHINGMU)的高精度光学手指追踪技术有效克服了遮挡干扰,为灵巧手的仿生设计、控制算法迭代与性能优化构建了可靠的精细化手部动作数据库。清华大学、浙江大学等顶尖学府利用青瞳视觉(CHINGMU)的系统进行灵巧手操作研究,捕捉手指关节的微妙角度变化与运动轨迹,为算法验证提供真实数据。在与灵巧智能的合作中,青瞳视觉(CHINGMU)为其搭建的精细化数据采集体系,直接服务于灵巧手的运动分析与控制逻辑优化,有效加速了其技术从实验室成果向实际应用转化的进程。

(清华大学自动化系灵巧手研究)

(浙江大学控制科学与工程学院灵巧手研究)

(遥操作数据训练研究)

在轮式与移动机器人领域,青瞳视觉(CHINGMU)为自主导航与协同控制研究提供精准的空间定位数据。苏州大学相城机器人与智能装备研究院利用其系统进行扫地机器人的精确测量实验;东南大学自动化学院将其用于多轮式移动机器人编队控制研究;西安交通大学自动化学院则借助该系统开展AGV协同小车的相关研究。

(苏州大学相城机器人与智能装备研究院基于扫地机器人"PoseTrackingSystem"的测量实验)

在仿生与特种机器人方向,青瞳视觉(CHINGMU)的动捕系统展现出强大的环境适应性。温州大学机电工程学院将其用于扑旋翼机器人的精确定位研究;天津大学机械工程学院则将其应用于在对外骨骼机器人仿真控制研究中。在水下的特殊环境中,青瞳视觉(CHINGMU)攻克了水体折射、低光照等特殊环境下的数据采集难题,确立了在水下动捕领域的领先地位。浙江大学海洋学院就采用了青瞳视觉(CHINGMU)水下动捕系统,开展了对软体机器人的水下作业研究。

(温州大学机电工程学院扑旋翼定位)

在高端科研与精密测量层面,青瞳视觉(CHINGMU)的价值同样凸显。浙江海洋大学船舶与海运学院采用了青瞳视觉(CHINGMU)的动捕系统进行船只等比模型测试与数据采集,为真实船舶的性能预测与优化提供可靠的模型数据。

(浙江海洋大学船舶与海运学院船舶等比模型测试与数据采集)

奔向“具身未来”:瞄准下一代交互,定义机器人感知物理世界的新范式

行业的脚步从未停歇,青瞳视觉(CHINGMU)的视野已投向更远的未来。近期,青瞳视觉(CHINGMU)创始人张海威获评“LeadeRobot2025年度中国机器人行业影响力人物”。他在2025年欧洲人形机器人峰会(EHRS)上,系统阐述了其对于具身智能数据未来的思考,并展示了多模态高质量具身智能数据采集系统Project Decode。该系统凭借其创新性与前瞻性,荣膺“LeadeRobot2025年度具身智能数采贡献奖”。

Project Decode致力于在真实场景中同步采集动作、视频、触觉、物体及环境数据,形成高质量、可复用且支持跨平台迁移的数据集,为构建下一代具身大模型奠定基础。

从攻克数据精度瓶颈,到成为产学研标配,青瞳视觉(CHINGMU)的路径清晰而扎实。在机器人学会像人类一样观察、思考并行动的长路上,这些由精准数据构成的“基石”与“通道”,正托起中国具身智能稳健跃迁的未来。

DAMO开发者矩阵,由阿里巴巴达摩院和中国互联网协会联合发起,致力于探讨最前沿的技术趋势与应用成果,搭建高质量的交流与分享平台,推动技术创新与产业应用链接,围绕“人工智能与新型计算”构建开放共享的开发者生态。

更多推荐

已为社区贡献3条内容

已为社区贡献3条内容

所有评论(0)