HEAD——视觉驱动下的自主配送:高层规划器发出手部和眼部的目标位置与朝向指令,低层全身控制策略则执行导航与抓取

斯坦福研究者提出HEAD系统,实现人形机器人自主导航与触达功能。该系统采用模块化设计,高层策略负责视觉导航和手眼协调,低层控制器基于模仿学习实现全身运动控制。创新性地结合大规模人类数据与少量机器人数据训练,通过GAN强化学习方法解决动作模仿挑战,并采用域随机化增强系统鲁棒性。该工作首次实现人形机器人基于自我中心视觉的端到端导航与触达能力,为类人机器人应用提供了新思路。

前言

我在解读CHIP、WholeBodyVLA这两个工作时,这两都提到了本文要解读的HEDA

第一部分

1.1 引言与相关工作

1.1.1 引言

来自斯坦福的研究者提出了一种面向人形机器人的手眼自主递送(hand-eye autonomous delivery,HEAD)系统,旨在充分利用其类人形态结构,以协调的方式同时完成导航、运动和触达任务

- 论文地址为:Hand-Eye Autonomous Delivery: Learning Humanoid Navigation, Locomotion and Reaching

作者包括

Sirui Chen, Yufei Ye, Zi-Ang Cao, Jennifer Lew, Pei Xu, C. Karen Liu - 项目地址为:stanford-tml.github.io/HEAD

GitHub地址为:github.com/Stanford-TML/HEAD_release

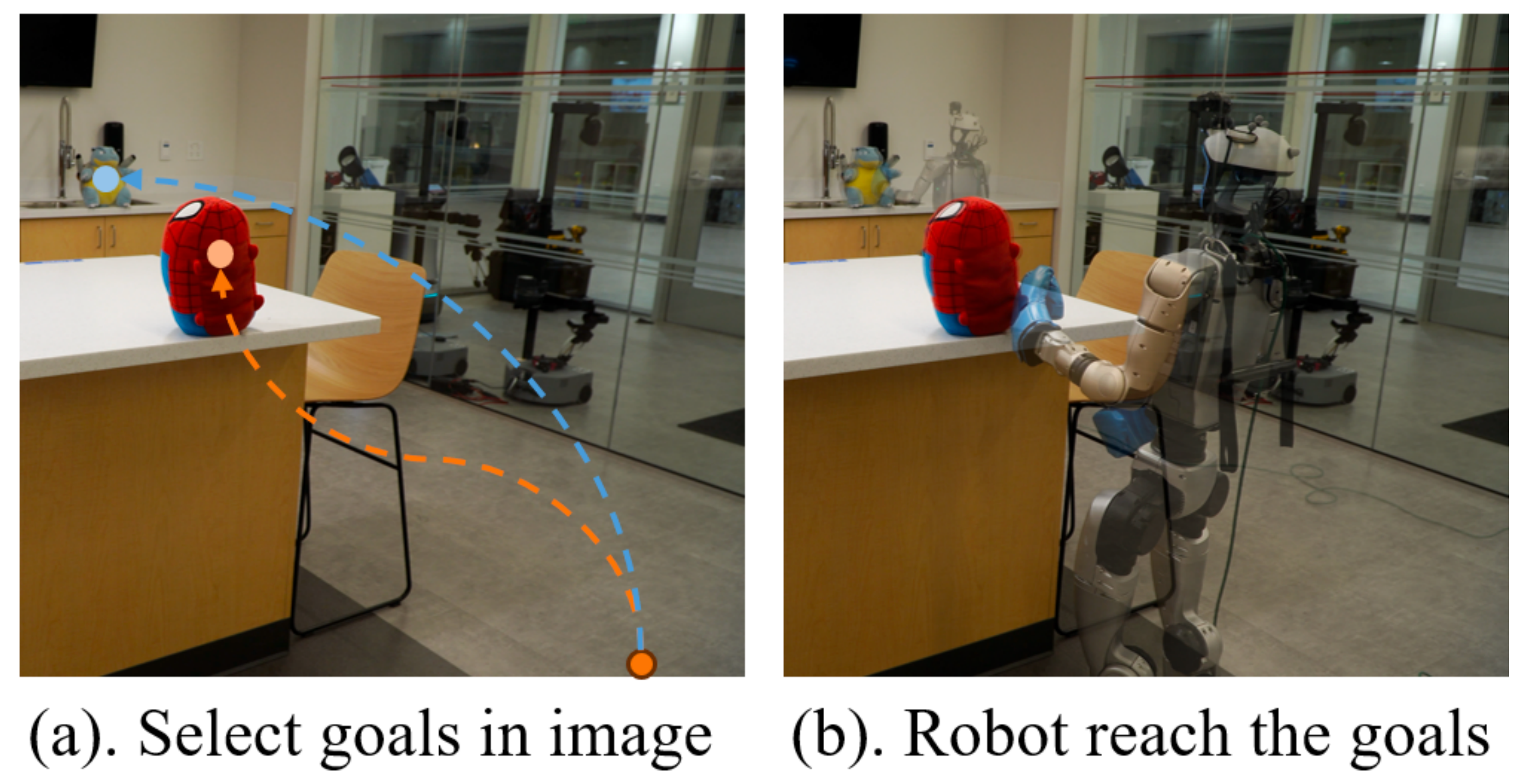

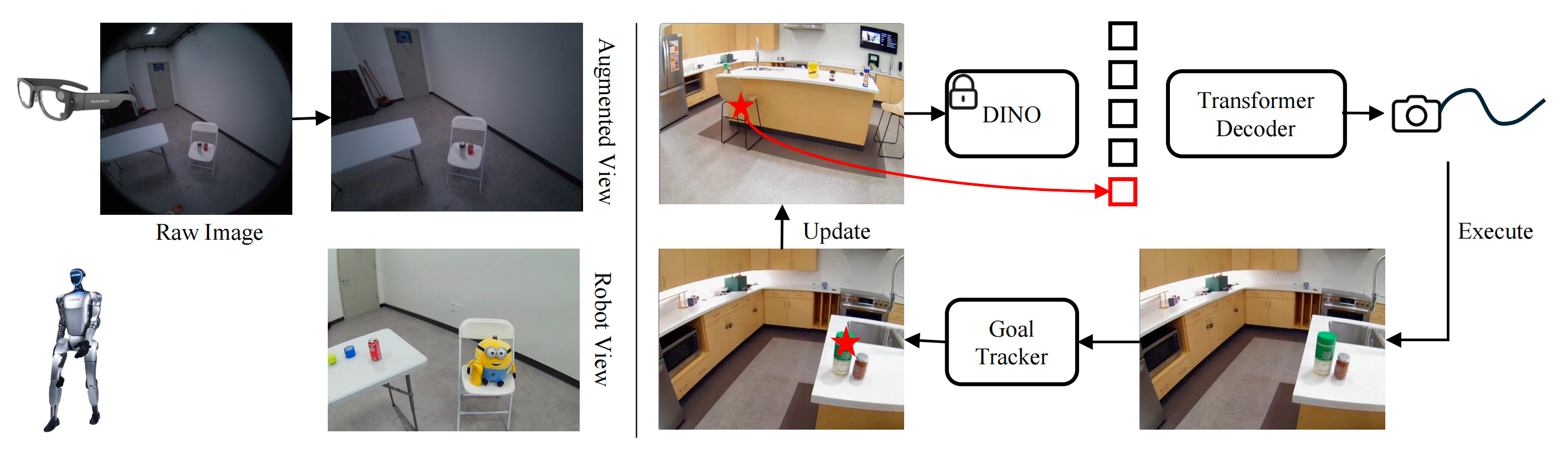

如下图所示,在用户从类人机器人的自我中心视角中选定目标后,人形机器人能够在三维世界中导航并到达该目标

- 尽管从人类示范中学习是一条很有前景的途径,但要端到端训练这三种技能,需要同时包含第一人称视觉和全身动作的异质人类数据

为此,作者采用了一种模块化方法,将自我中心视觉感知与物理动作解耦,从而能够灵活地利用不同来源的人类数据和不同算法来训练全身导航、运动和触达 - 这一设计也缓解了训练统一视觉-运动策略所面临的挑战

HEAD框架由一个高层策略和一个低层控制器构成:高层策略预测仿人机器人眼睛和手部的目标位置与朝向,低层控制器则执行对应的全身运动

在接收到“伸手并触碰某个物体”的指令后,该物体由人形机器人在其感知到的初始RGB 图像中的一个点来指示

- 高层策略预测头部的位置与朝向,从而在保持目标始终处于视野的同时,引导人形机器人朝目标移动并绕开障碍物

当目标进入手臂可及范围后,高层策略还会控制双手与该物体接触

现有的视觉导航方法 [1,2] 通常将机器人抽象为质点,将动作限制为在地面平面上的 2D 移动。此类假设适用于轮式机器人,但对于双足人形机器人却远远不够:双足人形机器人必须协调一具多关节身体,在复杂的3D 空间中导航,同时在不同高度上伸手去够物体并避开障碍物 - 为实现这种 3D 导航能力,作者的方法针对不同目的混合利用多种数据集——使用互联网上的大规模人类探索数据集来提升对新场景的泛化能力

在目标环境中收集中等规模的示教数据以缓解感知带来的领域偏移

并使用少量特定机器人经验来缓解由具身差异引起的领域偏移

低层全身控制器通过大规模人体动作捕捉数据进行训练,以跟踪三个关键点——眼睛(其决定朝向)、左手和右手

作者采用基于模仿的RL进行训练,利用大规模数据集的多样性来处理各种各样的目标配置

使用基于模仿的 RL 训练这样的全身策略面临三个主要挑战

- 首先,与全身跟踪不同,HEAD的目标在空间上是稀疏的,只约束三个点

作者通过构建一个基于 GAN 的强化学习框架来应对第一个挑战,该框架模仿人类示范数据的分布,而不是依赖具体的全身轨迹作为策略输入 - 其次,全身技能要求上半身和下半身能够同时执行不同任务,这需要大量示范样本来覆盖联合动作空间

为解决第二个挑战,作者设计了两个独立的判别器,分别对上半身和下半身给予奖励,从而促进两者之间的可组合性和协调性 - 第三,在真实环境中很难获取精确的根节点位置和速度信息,因此需要一种在没有精确根节点数据情况下依然有效的更鲁棒的策略

为了解决第三个挑战,作者训练的策略不依赖于世界坐标系中的根节点位置或速度;相反,全局信息由导航目标推断,并通过机载摄像头进行估计

1.1.2 相关工作

// 待更

1.2 HEAD的完整方法论

给定机器人在初始 RGB 图像上选定的一个点,HEAD 使得人形机器人能够用手在真实三维物理世界中到达该点

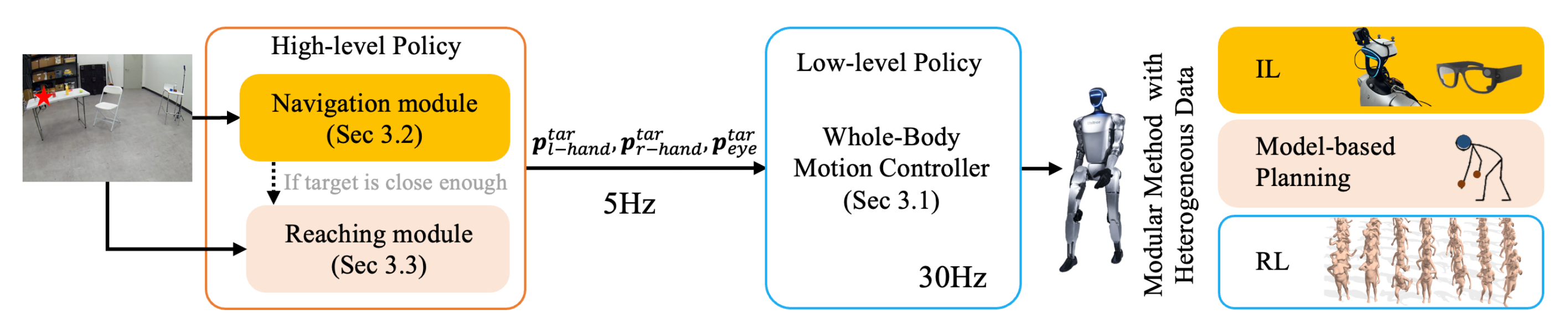

HEAD 是一个模块化系统,由用于导航和触达的高层策略和用于全身控制的低层策略组成(见图2)

HEAD 由一个包含导航和到达两个模块的高层策略,以及一个协调全身运动的低层策略组成

- 高层策略以较低频率提供手眼跟踪目标

基于学习的导航模块从混合训练数据集中学习,将RGB 自我视角感知映射为相机目标轨迹

基于模型的到达模块生成手眼目标位姿- 而全身控制器则以较高频率跟踪这些手眼目标

低层全身控制器使用基于模仿的强化学习,在一组人体动作捕捉数据上进行训练

其核心思想是:导航与触达这两项任务都可以通过对同一个低层全身策略下达指令来完成,该策略负责跟踪头部和双手的 6D 位姿

1.2.1 全身控制器

在高层策略给定目标手-眼位置和姿态的情况下,低层全身控制器通过 PD 伺服器来控制人形机器人

- 为使人形机器人在跟踪任意目标的同时表现得更接近人类,作者在RL框架下,采用类似 GAN 的方法[34-A gan-like approach for physics-based imitation learning and in-teractive character control],从非结构化运动数据中进行动作模仿,并结合面向目标的位置和姿态跟踪控制

模仿人类操作中的手-眼位姿,特别是眼的位姿,这个HEAD是我目前所知的第一个工作了 - 不同于两阶段的蒸馏方法[35-Humanoid policy˜ human policy,19-Omnih2o],HEAD的方法以端到端方式训练低层控制策略,以便部署到真实世界

第一,作者特地整理了人体运动数据集

- 作者发现,动作重定向的质量会显著影响策略性能

故作者通过将来自 AMASS [36] 和 OMOMO [37] 数据集的人体动作捕捉数据重新定向到 G1 机器人,整理了一个 5 小时的数据集 - 该重定向是通过类似于[17-H2O] 的关键点匹配实现的

所收集的运动总体上涵盖了操作与运动两个领域的代表性行为。数据集将在论文被接收后开源

第二,部署的观测空间

为了支持在真实环境中的部署,观测空间必须限制为机器人机载传感器可获取的信息

- 作者的观测向量由机器人局部坐标系中两个连续时间步的机器人连杆位姿

和局部的关节速度

构成

- 它不包含任何未来信息,也不依赖世界坐标系中的任何特权数据,例如根部位置和线速度,这些在仿真之外很难获取

作者发现,去除对特权信息的依赖,其效果优于任何依赖重建或预测替代量的其他方法

第三,运动模仿

作者将全身运动解耦为上半身和下半身两组,并同时使用两个判别器来进行模仿学习

- 通过这种方式,策略可以学习来自上下半身部位姿态的组合,而不再受限于动作数据集中提供的固定全身姿态

- 类 GAN 的强化学习方法使得策略能够从动作数据集中的任意片段进行动作模仿,而无需事先生成或获取完整的模仿轨迹,同时还可以完成跟踪任务

第四,稀疏目标跟踪

- 为了避免在全局空间中引入目标信息,作者通过相对变换来表示跟踪目标,作为策略网络的输入

其中表示相对变换算子,”tar” 表示目标姿态

- 为了执行跟踪

在训练过程中,作者在每个时间步执行动作之后,基于定义以目标为导向的奖励

第五,针对sim2real的考虑

除了目标跟踪的任务奖励之外,作者另外定义了一个正则化项,以辅助实现从仿真到现实的迁移

- 为进一步提升鲁棒性,作者在训练过程中对动力学参数和传感器噪声进行大范围的域随机化

- 且采用文献 [38-Composite motion learning with task control] 中提出的多目标学习框架来进行策略训练,同时利用判别器给出的奖励来优化两个模仿目标,并通过人工定义的奖励函数来优化目标导向的目标函数。实现细节请参见补充材料

1.2.2 导航模块

给定一个能够跟踪三个点的低层次全身控制器,HEAD的导航模块将机器人引导至一个目标,该目标被指定为机器人初始观测到的RGB 图像中的一个2D 点

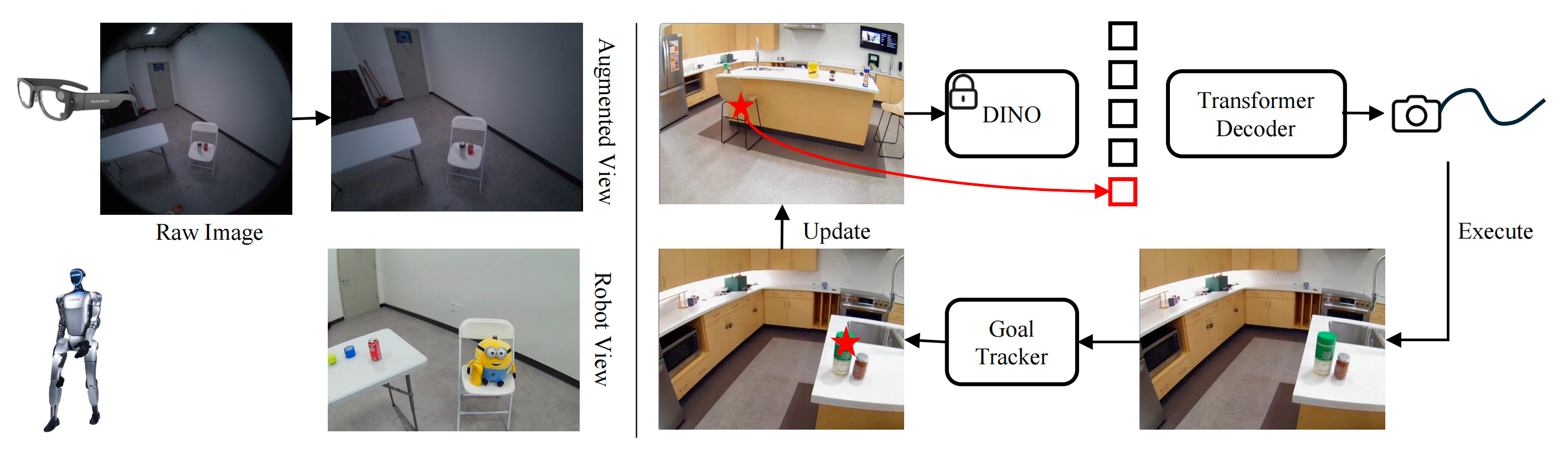

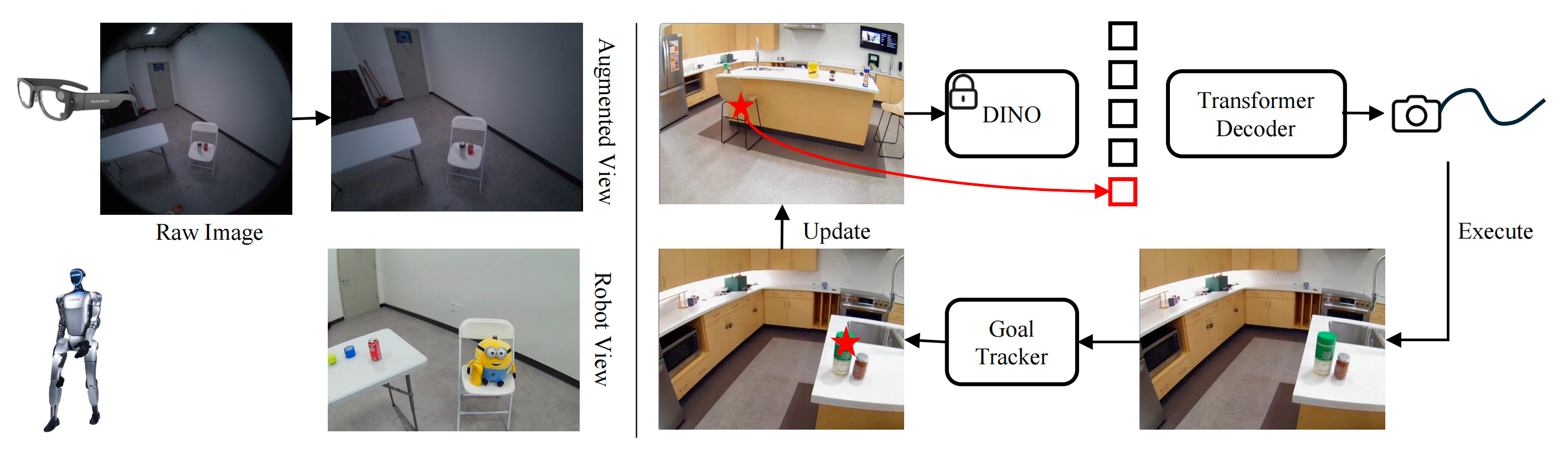

在推理过程中,导航模型从导航相机获取当前RGB 图像以及由点跟踪器[39-Co-tracker3: Simpler and better point tracking by pseudo-labelling real videos] 提供的已跟踪2D 目标,并预测未来眼睛在位置和朝向上的轨迹(见下图图3 右)

- 导航训练数据(左):作者对从 Aria Glasses 采集的图像进行增强(去畸变和单应变换),使其看起来更像机器人的视角

- 导航模块概览(右):在推理过程中,给定一幅图像和一个以二维点形式表示的目标,我们提取 DINO 特征,附加目标坐标,并将它们输入 transformer 解码器,以预测未来的眼睛(摄像头)轨迹

低层全身控制器执行该预测并获得新的观测。随后,利用现成的点跟踪器在新的图像中跟踪该目标

具体来说,作者提取输入图像 的DINO 特征,并向目标

添加位置嵌入。然后将它们输入到一个transformer 解码器中,以输出未来的相机轨迹

,该轨迹相对于前一帧表示为变换

- 收集人类数据

作者提出了一种自动化方法,利用Aria 眼镜来收集以目标为条件的人类训练数据,这些数据以图像、未来相机轨迹和二维目标的元组形式表示

眼镜为所有采集到的数据提供精确的相机位姿、静态点云和视线估计

—————

作者通过在未来视线向量方向上,在静态点云中找到最近的点,并通过当前的相机位姿将其投影到图像平面上,来近似当前目标 - 领域偏移

然而,仅在有限的人类数据上训练得到的导航模型在两个需要解决的潜在领域偏移方面表现不佳首先,为了提升在未见场景中的泛化能力,作者引入大规模第一视角数据集 Aria Digital Twin (ADT) [40],该数据集包含 400 分钟的室内活动,如打扫和烹饪。得益于作者的自动数据筛选管线,可以将任意 AriaGlasses 数据轻松转换为目标条件导航训练数据

其次,由于机器人与普通成年人的具身差异,在视觉感知上存在显著差距。为了将 Aria Glasses 的宽广鱼眼视野与机器人的较窄相机视野对齐,作者对人类数据施加去畸变和单应性变换,以生成从人类数据中得到的机器人的虚拟视角(见下图图3左,细节见附录)

除了视觉差异之外,人和机器人在运动速度上也不同。根据经验,作者发现机器人移动速度大约比人类慢 7 倍,因此在训练过程中我们相应地对机器人视频进行下采样

此外,作者还通过控制机器人执行导航任务,并使用动捕mocap系统记录其头部位姿,从而收集少量机器人数据,并使用人类数据和机器人数据共同训练导航模块

1.2.3 到达模块

当导航模块在房间尺度上驱动机器人朝目标物体前进时,抓取(reaching)模块负责最后的接近以触碰该物体。作者为抓取使用第二个向下朝向的 RGB-D 相机,其视场(FoV)更窄并进行了放大

高层策略在从导航切换到抓取时,低层策略持续运行,以确保平滑过渡

- 首先,对于导航-抓取过渡

当目标物体进入俯视RGB-D 相机的视野并处于可抓取范围内时,导航策略将控制权移交给抓取模块

通过对应关系匹配 [41-Loftr: Detector-free local feature matching with transformers],将目标从原始坐标系转换到 RGB-D 帧中 - 其次,对于到达目标

到达模块将目标近似为一个三维手部位置,并计算目标手部朝向以及头部的6D位姿,以用于低层策略

由于被跟踪的目标只指定了手部位置,作者使用 Mink [42-Mink: Python inverse kinematics based on MuJoC] 求解逆运动学 (IK),以推断缺失的头部姿态和手部朝向

为了保证高层动作之间的平滑过渡并使机器人的姿态看起来自然,作者从当前的机器人状态初始化IK 优化,并添加一个目标项,以鼓励质心位置和骨盆朝向的变化尽可能小

// 待更

DAMO开发者矩阵,由阿里巴巴达摩院和中国互联网协会联合发起,致力于探讨最前沿的技术趋势与应用成果,搭建高质量的交流与分享平台,推动技术创新与产业应用链接,围绕“人工智能与新型计算”构建开放共享的开发者生态。

更多推荐

已为社区贡献57条内容

已为社区贡献57条内容

所有评论(0)