Isaac Lab 全面盘点:具身智能时代的“通用模拟器”究竟长什么样?

相比过去的模拟器只负责“模拟物理”,Isaac Lab 的目标是把机器人学习中的关键环节——动力学、控制器、传感器、场景生成、数据采集、模仿学习工作流、强化学习训练等——全部整合到同一个统一框架下。在白皮书中,Isaac Lab 被描述为一个“GPU 加速、多模态、支持大规模并行的机器人学习框架”,它基于 NVIDIA Omniverse、PhysX、RTX Renderer 与 OpenUSD

目录

02 Isaac Lab的底层构成:从场景到物理,从感知到渲染

OmniPhysics + PhysX:高保真、可扩展的 GPU 动力学引擎

多类型传感器仿真:从 LiDAR 到 Visuo-Tactile

03 为具身智能赋能:Isaac Lab让训练机器人像训练大模型一样系统化

Manipulation 与 Dextero-Manipulation

导读

如果说几年前的机器人学习还是“小作坊时代”,每个实验室都在重复搭建场景、写自己的控制器、调物理参数,那么 2025 年之后的具身智能正在进入真正的“大工业化阶段”。无论你是训练一个会跳跃的四足机器人、一个能执行长时任务的人形机器人,还是在构建一个 Vision-Language-Action 大模型,所有研究路线最终都会回到一个关键的基础设施:模拟器。

而在众多模拟工具中,NVIDIA 发布的 Isaac Lab 是目前唯一专为“大规模多模态机器人学习”而设计的统一平台。从传感器到动力学,从场景建模到模仿学习演示生成,从数据生产到 RL 训练流水线——它不像传统模拟器那样只提供“仿真”,而是提供了一个完整的、可扩展的、高保真的机器人学习体系。

这篇文章基于 NVIDIA 最新白皮书,试图从底层原理、核心能力到典型应用,为你完整盘点 Isaac Lab 的能力版图:它是什么、它解决了什么、它能做什么、为什么所有具身智能方法都离不开它。

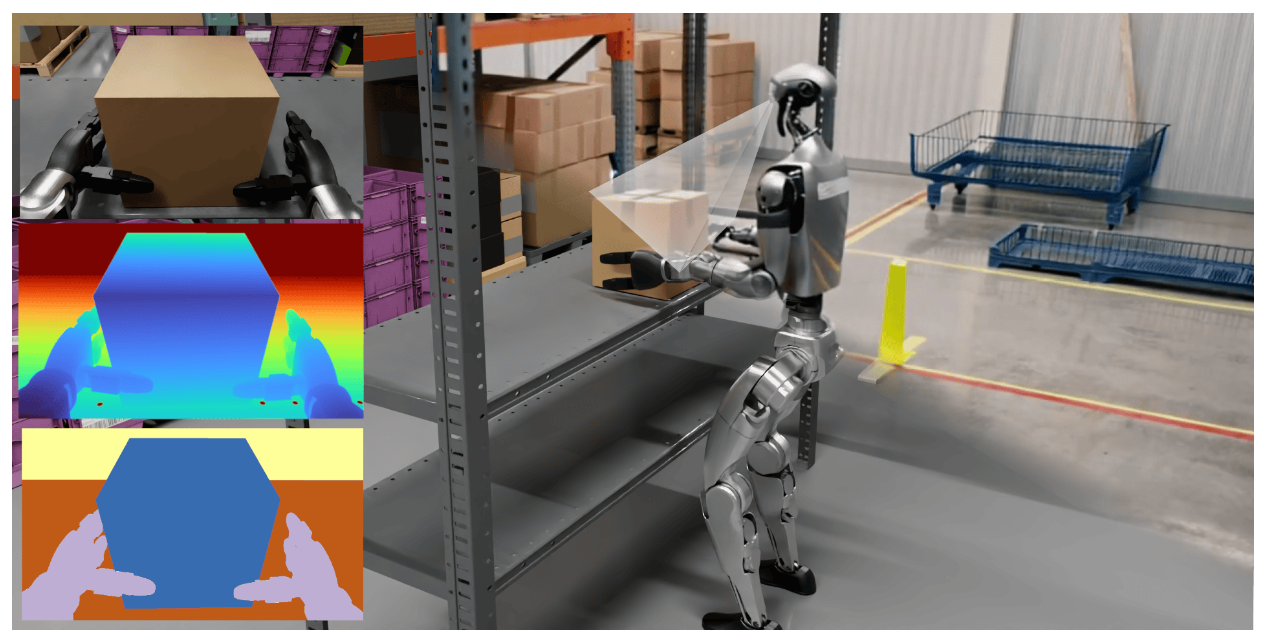

▲图1|Isaac Lab 能同时支撑多类机器人任务,从看得见的 RGB/深度,到看不见的力、触觉与惯性信息,都可以作为模型输入。框架内置直观的 API,方便研究者试验不同控制策略,也为 sim-to-real 提供了必要的接口与工具,是强化学习与模仿学习共同的训练基准

01 Isaac Lab到底是什么?

在白皮书中,Isaac Lab 被描述为一个“GPU 加速、多模态、支持大规模并行的机器人学习框架”,它基于 NVIDIA Omniverse、PhysX、RTX Renderer 与 OpenUSD 构建,是 Isaac Gym 的自然继任者,却不仅是替代,更是一次框架级跃迁。

相比过去的模拟器只负责“模拟物理”,Isaac Lab 的目标是把机器人学习中的关键环节——动力学、控制器、传感器、场景生成、数据采集、模仿学习工作流、强化学习训练等——全部整合到同一个统一框架下。文中强调,过去这些能力由研究人员在不同项目中重复造轮子,导致代码分散、流程不统一,也缺乏可扩展性。Isaac Lab 的使命,就是将这些高度重复的机器人研究流程模块化、标准化,让研究者能真正集中在算法贡献上,而不是在基础设施上耗费大量时间。

正因为由 Omniverse 与 PhysX 提供底层,Isaac Lab 得以把“高保真物理 + 可扩展渲染 + GPU 并行”融入同一个平台,这使得它成为当前研究 humanoid、四足、灵巧手、人机协作、医疗机器人等任务时最完整的模拟工具

02 Isaac Lab的底层构成:从场景到物理,从感知到渲染

Isaac Lab 的核心由四个基础模块组成,它们共同构成了一个真实感强、数据一致性高、具备工业级扩展性的机器人仿真世界。

OpenUSD:统一几何、语义、材质、传感器的世界描述语言

OpenUSD 是 Isaac Lab 的数据骨架。白皮书强调,USD 能够同时描述几何结构、材质属性、语义标签、相机与传感器位置,甚至动力学参数。相比过去机器人使用 URDF/MJCF 这种只包含几何与关节信息的格式,USD 的优势是“跨领域一致性”——同一个场景可以同时服务于渲染、物理模拟、语义分割、相机建模等任务。尤其在需要多模态学习的大模型时代,场景、语义、光照、材质的一致性尤为关键。

在 Isaac Lab 中,所有环境与机器人实体都通过 USD 构建与修改,这让复杂、真实、结构化的场景编辑变得可控而系统化。

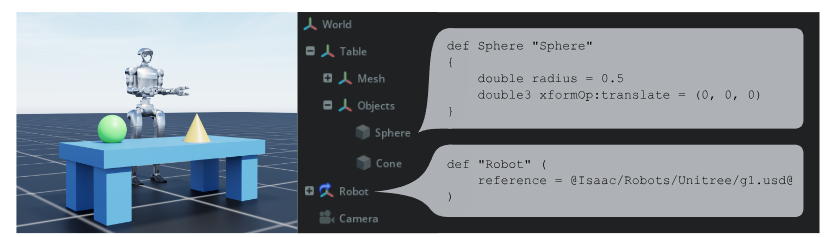

▲图2|Isaac Lab 通过 OpenUSD 构建复杂而真实的模拟世界。机器人、物体与各类传感器都以层级化的 Scene Graph 组织,实现空间关系、坐标系变换、语义标签、几何属性与传感器配置的统一管理。这种统一场景描述是多模态具身智能的核心基础

OmniPhysics + PhysX:高保真、可扩展的 GPU 动力学引擎

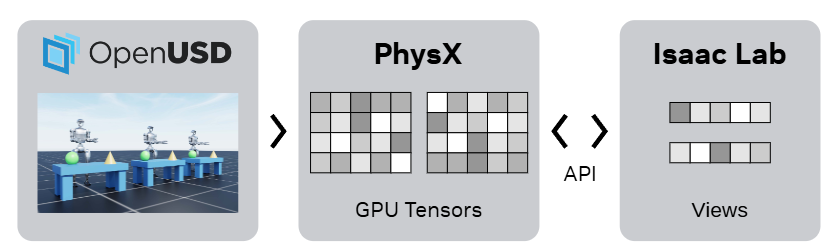

PhysX 是 Isaac Lab 的动力学基础,而 OmniPhysics 则负责将 USD 内容解析到 PhysX,再将仿真状态写回 GPU Tensor,使用户可以用 NumPy、PyTorch 或 NVIDIA Warp 直接访问模拟结果。

白皮书强调,Isaac Lab 的关键创新之一是“完全 GPU 化”——从物理仿真到观察生成,整个过程都可以驻留在显存中,无需频繁的 CPU–GPU 数据交换。这种设计极大提升了 RL 训练速度,尤其是并行上千环境时,在同一块 GPU 上完成一个完整的“观察–决策–控制”循环成为可能。

更重要的是,Isaac Lab 支持刚体、关节系统、软体、布料等不同类型的动力学耦合,还加入了专为机器人应用设计的参数:力矩模型、摩擦模型、关节约束、力-力矩传感器、SDF 碰撞等,使得模拟器能够真实反映机器人硬件特性的变化。

▲图3|OmniPhysics 将 USD 场景无缝映射到 PhysX 引擎中,并在 GPU 上生成可直接访问的 Tensor。研究者不需手动索引对象,只需通过 View API 就能读取或写入任意一组物体的状态。这让大规模并行训练变得更简单、更高效

RTX Rendering:真实视觉输入的生成器

对于多模态机器人学习而言,视觉不是可选项,而是核心输入。因此 Isaac Lab 将 RTX 实时光追渲染整合到模拟循环中,提供:

● 逼真的 RGB 渲染

● 高质量的深度图

● 稠密语义分割

● 结构化的材质与光照

● tiled camera 支持大规模批量渲染

在训练依赖视觉的大模型控制器(如 Diffusion Policy、多模态 VLA、RL agents)时,真实感渲染与可控光照有决定性影响。Isaac Lab 提供的渲染质量与灵活性,已经被用于 locomotion、long-range navigation、dexterous manipulation、loco-manipulation 等任务的 active perception 训练。

▲图4|Isaac Lab 借助 Omniverse RTX 实现高度写实的视觉渲染,支持物理材质、反射、折射等复杂光照效果,生成接近真实相机的视觉输入,为视觉模型与多模态代理提供高质量训练数据

多类型传感器仿真:从 LiDAR 到 Visuo-Tactile

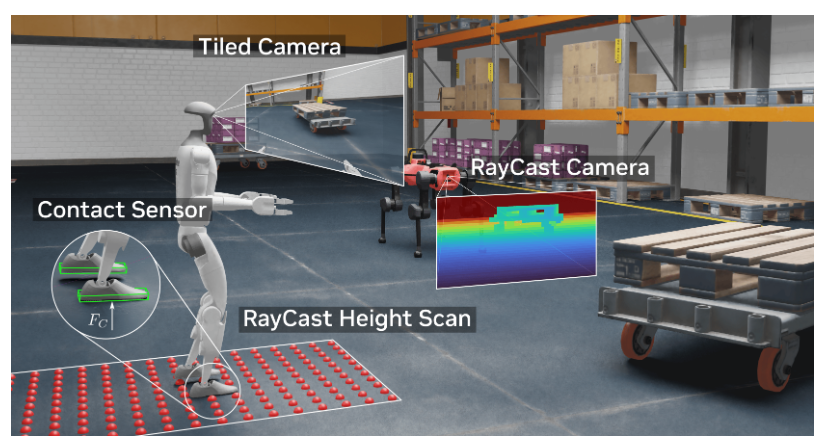

白皮书展示了其完整的传感器套件,包括:

● 基于射线投射的激光雷达

● 全景摄像机

● 多频率深度相机

● 稠密语义相机

● 触觉传感器(visuo-tactile)

其中触觉仿真尤为独特:Isaac Lab 不仅模拟接触力场,还能够生成触觉图像,基于 tiled camera 渲染和 penalty-based 模型构建接触分布,可用于抓取、灵巧操作等高度依赖接触细节的任务。相较于主流模拟器,这是完全不同的能力层级。

▲图5|Isaac Lab 的传感器体系覆盖 IMU、触碰检测、变换器、并行相机与基于 Warp 的 GPU 射线追踪几何感知模块。图中展示了这些传感器在高度真实场景中的示例输出

03 为具身智能赋能:Isaac Lab让训练机器人像训练大模型一样系统化

Isaac Lab 的另一个核心贡献,是将机器人学习的流程抽象为可复用、可扩展的工作流。这些工作流不只是工具,而是帮助研究者在“大规模数据 + 大规模训练”时代建立标准化 pipeline。

GPU 并行强化学习(RL)的天然土壤

白皮书反复强调 Isaac Lab 对 RL 的支持:它能够在一个 GPU 上运行大量并行环境,通过 Tensor API 直接读取状态,使 on-policy RL(如 PPO)可以拥有极高的采样效率。

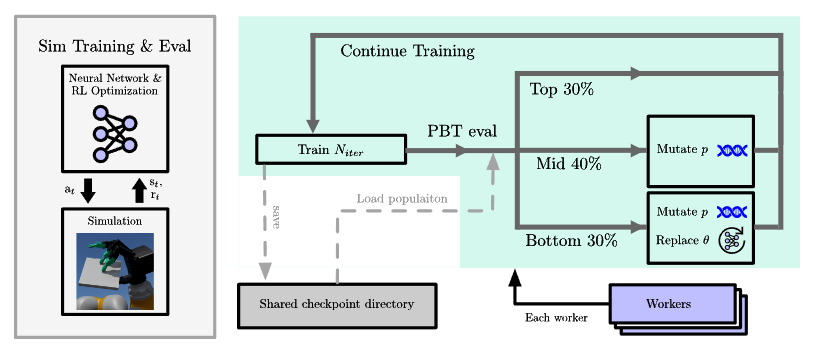

不仅如此,Isaac Lab 集成了 Population-Based Training(PBT),允许每个环境独立训练并周期性交换最佳参数。这种机制被用于 dexterous manipulation、humanoid loco-manipulation 等高维任务,并在多篇论文中验证了效果。

这种“演化式 RL”在高维控制中表现出更高稳定性与探索能力,使得许多过去被认为难以训练的策略如今可以在一天之内收敛。

▲图6|Isaac Lab 内置的 PBT(Population-Based Training)机制能够在多个并行环境中同时运行独立的强化学习进程,每个进程都拥有自己的超参数配置。系统会定期对这些进程进行排名,让表现最好的策略将权重与超参数“传递”给表现较差的策略,同时随机扰动(基因突变)会不断探索新的超参数组合。通过这样循环迭代,RL 的探索能力与训练稳定性都会显著提升

Mimic:把一条示范扩成一整个数据集

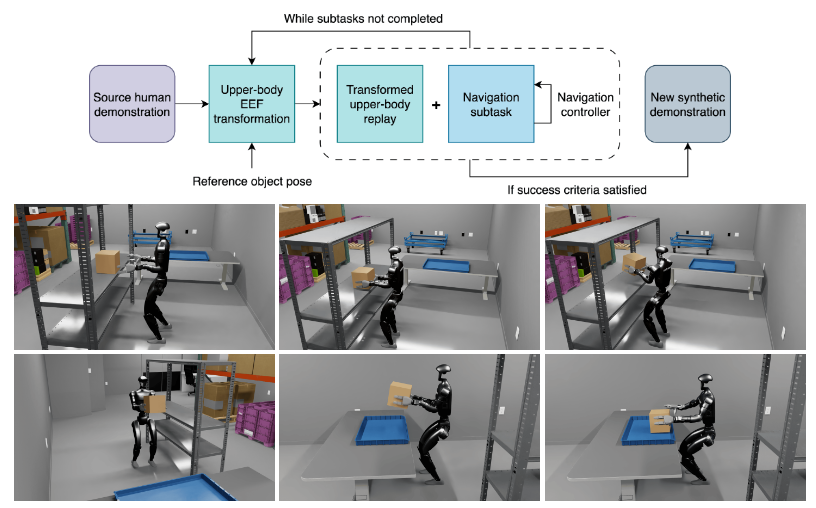

Isaac Lab 的 Mimic 工作流让用户只需提供一次示范,它就能够自动生成无限多的变体示范。这包括位置扰动、环境变化、目标点变化、抓取对象变化等。对于用于训练 Diffusion Policy 或模仿学习模型的数据集,这种“扩增式演示生成器”具有极高价值。

白皮书展示了 humanoid loco-manipulation 的例子:只需单次人类示范,系统就能自动生成带有导航与抓取逻辑的完整、人类风格的示范序列,用于训练会走、会抓、会搬运的人形机器人。

▲图7|上半部分展示 Isaac Lab Mimic 在 loco-manipulation 中的数据生成流程。下半部分给出一个复合任务示例:从走向货架、拾取物体,到转向桌子、行走、下蹲、放置,每一步动作都能被自动化生成并用于训练

SkillGen:自动衔接技能,拼接成高质量示范轨迹

SkillGen 是白皮书中特别提到的另一项增强能力:系统通过 GPU 加速的 motion planning,将人类分段示范连接为完整的任务流程。它能够自动生成不同环境、不同物体布局下的有效轨迹,确保轨迹在碰撞、动力学约束下依然真实可信。

这为高质量模仿学习 dataset 的构建提供了任务级别的自动化能力,使研究者不再需要逐个录制示范。

Domain Randomization 与程序化场景生成

为了实现 sim2real,Isaac Lab 提供了极高自由度的 domain randomization:从材质到光照,从质量到摩擦,从地形到碰撞结构,几乎所有物理与渲染参数都可以随机化。程序化地形生成工具允许研究者批量创建复杂环境,用于测试机器人鲁棒性。

这一能力在 locomotion、navigation、中长期操作任务训练中发挥关键作用。

▲图8|使用 Isaac Lab 训练出强健、敏捷的 locomotion 能力的各类平台示例:包括 Boston Dynamics Spot、磁吸式 Magnecko、轻量级 LEVA、ANYmal 以及 RAI 的水陆移动平台 UMV

04 Isaac Lab 支持的具身智能任务全景图

白皮书用了较大篇幅展示 Isaac Lab 在多个机器人领域的实际应用案例,这些应用构成了它的“真实能力边界”。这些任务覆盖了几乎所有主流的具身智能研究方向。

四足与人形机器人 Locomotion

Locomotion 是 Isaac 系列最经典的应用场景,也是其 GPU 并行能力最早被证明有效的任务。白皮书中提到 RAI 的工作实现了对 Spot 的全流程训练,甚至通过演化策略实现零样本部署,速度提升接近三倍。此外,humanoid loco-manipulation 任务也已经在 Isaac Lab 中完成了从导航到抓取的一体化模拟。

这些案例证明了 Isaac Lab 在处理高维控制、非线性动力学、与接触相关的稳定性问题上具有工业级能力。

▲图9|左图展示 ANYmal 机械臂执行家用场景中的交互任务,如打开洗碗机。右图展示 Boston Dynamics Atlas 通过学习多种人类动作数据,实现丰富的运动能力

Manipulation 与 Dextero-Manipulation

DexPBT、DextrAH 等工作都建立在 Isaac Lab 的 dexterous manipulation 套件上,展示了多指灵巧手在六维重定位、物体再取向等任务上的训练效果。通过 PBT 与 GPU 并行,策略在十几小时内便可收敛并实现可迁移的抓取能力。

白皮书同时强调 Assembly Benchmark(NIST Task Board)的重要性,Isaac Lab 已提供了针对接触密集任务的优化场景,用于评测操控策略。

▲图10|Isaac Lab 中的装配环境与真实装配场景对照。模拟环境具备接触密集、几何精细的特性,用于评测操控策略的可迁移性

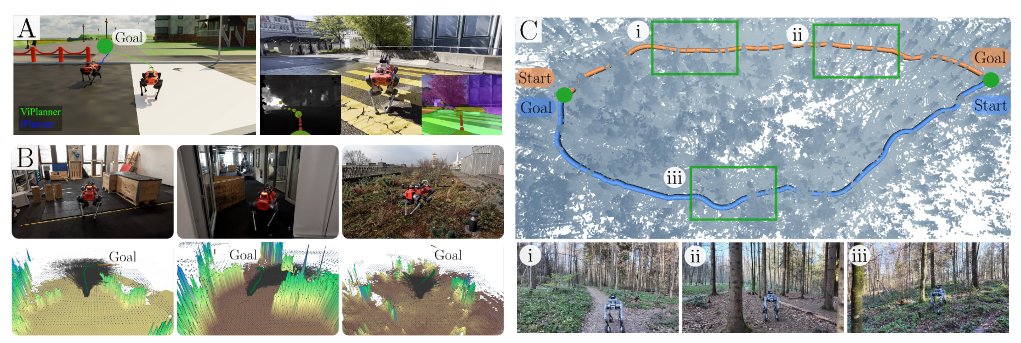

Navigation 与 Long-Horizon Tasks

Isaac Lab 提供可扩展的场景、视觉渲染、深度图与几何信息,使得长距离导航任务能够结合主动感知策略进行训练。文中举例的 attention-based RL policy 显示智能体可以在训练中自发学习“探索—观察—执行”的行为模式。

▲图11|基于 Isaac Lab 的 sim-to-real 导航方法示例:(a)ViPlaner 使用深度与语义图训练端到端策略;(b)Forward Dynamics Model 在模拟中学习,再结合规划器在真实平台部署;(c)一种带时空记忆单元的 RL 策略,用于长时导航任务

Loco-Manipulation:移动与操作的融合

这一方向是当前具身智能的重要趋势。在白皮书展示的 humanoid 任务中,人形机器人可以一边导航、一边同时执行抓取、搬运、放置任务,这种“混合技能”正是未来大模型机器人最需要的能力,Isaac Lab 的 Mimic 与控制器体系为该任务提供了完整的生成与训练 pipeline。

医疗机器人:高精度、高风险场景的数字孪生

白皮书中特别强调 Isaac Lab 在医疗领域的应用,包括:

● CT 解剖模型

● 超声波模拟(GPU 加速声学射线)

● 外科手术器械的高精度碰撞与接触

● 远程手术的 XR teleoperation

在高度依赖精密接触与真实感的场景中,Isaac Lab 的高保真物理与实时渲染能力发挥了核心作用

▲图12|上排示例展示 Isaac for Healthcare 中的超声模拟与人体解剖数字孪生。下排示例展示基于 Isaac Lab 的精细外科操作训练,包括缝合、精密夹取等核心动作,用于提升手术机器人与训练系统的能力

05 总结

如果你把当前所有具身智能方向串起来——humanoid、四足、VLA、Diffusion Policy、RL、大模型控制器、数字孪生、医疗机器人——你会发现它们都需要同一种基础设施:

高保真物理、真实感视觉、可控场景、多模态传感器、大规模并行、标准化工作流、自动化演示生成、稳定训练体系。

过去这些能力是散的;在 Isaac Lab 中,它们第一次被“工程化”和“体系化”,变成一个可复用的统一框架。

这意味着:

● 未来大多数机器人学习研究都会直接跑在 Isaac Lab 上

● 你不再需要自己写力学模型、调材质、搭建场景、录示范样本

● 数据集生成、模仿学习、RL 训练都能在一个统一平台完成

● 新的物理引擎 Newton 即将带来更多真实感与可微能力

● Arena 将推动整个行业的 benchmark 标准化

换句话说,Isaac Lab 不是一个模拟器,而是一条“具身智能进入工业时代”的基础设施。

对于正在做 humanoid、户外导航、dexterous manipulation、医学机器人或 VLA 方向的研究者来说,Isaac Lab 将是你无法绕开的必经之地。

REF:

标题:Isaac Lab: A GPU-Accelerated Simulation Framework for Multi-Modal Robot Learning

DAMO开发者矩阵,由阿里巴巴达摩院和中国互联网协会联合发起,致力于探讨最前沿的技术趋势与应用成果,搭建高质量的交流与分享平台,推动技术创新与产业应用链接,围绕“人工智能与新型计算”构建开放共享的开发者生态。

更多推荐

已为社区贡献47条内容

已为社区贡献47条内容

所有评论(0)