【论文自动阅读】Learning Interactive World Model for Object-Centric Reinforcement Learning

本文提出“因子化交互对象中心世界模型(FIOC-WM)”,通过两级分解(对象级显式交互建模+属性级静动态特征分离)从图像中学习结构化世界模型,并结合分层策略(高层选交互顺序、低层执行动作),提升强化学习在机器人控制等任务中的样本效率和泛化能力。

·

快速了解部分

基础信息(英文):

- 题目:Learning Interactive World Model for Object-Centric Reinforcement Learning

- 时间年月:2025年11月(arXiv:2511.02225v1 [cs.LG] 4 Nov 2025)

- 机构名:University of California San Diego、Mohamed bin Zayed University of Artificial Intelligence、University of Amsterdam

- 3个英文关键词:Object-Centric Reinforcement Learning、World Model、Hierarchical Policy Learning

1句话通俗总结本文干了什么事情

本文提出“因子化交互对象中心世界模型(FIOC-WM)”,通过两级分解(对象级显式交互建模+属性级静动态特征分离)从图像中学习结构化世界模型,并结合分层策略(高层选交互顺序、低层执行动作),提升强化学习在机器人控制等任务中的样本效率和泛化能力。

研究痛点:现有研究不足 / 要解决的具体问题

- 现有对象中心强化学习(RL)方法仅按单个对象分解状态,却将对象间的交互隐含化,无法显式建模动态交互关系,导致策略鲁棒性和迁移性不足;

- 世界模型从高维观测(如像素)提取低维结构化 latent 表示时,不清楚“哪种分解结构(对象级/属性级)”和“分解程度”对下游策略学习最有效;

- 真实场景中视觉外观和动态交互存在强变异性(多对象、多属性),现有模型难以同时捕捉对象独立演化规律和对象间复杂交互,导致长 horizon 任务学习效率低、泛化差。

核心方法:关键技术、模型或研究设计(简要)

FIOC-WM 采用“两阶段框架”:

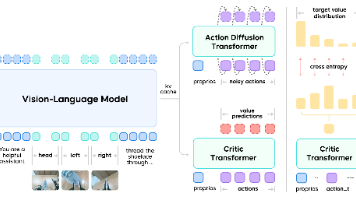

- 离线模型学习:基于预训练视觉编码器(DINO-v2/R3M)和槽注意力(Slot Attention)提取对象中心 latent,将每个对象的状态分解为“静态属性(如颜色、形状)”和“动态变量(如位置、速度)”,同时学习对象间的交互图(用变分掩码或条件独立性测试);

- 在线分层策略学习:高层策略(πh)根据当前状态选择目标交互图序列(子目标),低层策略(πl)基于交互图用MPC/PPO执行动作,实现长任务分解为可组合的交互原语。

深入了解部分

相比前人创新在哪里

- 两级结构化分解:首次在世界模型中联合实现“对象级显式交互建模”和“属性级静动态分离”,既避免交互隐含化,又减少特征冗余(仅动态变量参与交互更新);

- 交互与世界模型协同学习:并非事后从注意力权重等间接推断交互,而是在离线阶段将“观测重建、状态分解、动态预测、交互建模”集成到统一框架,提升交互建模精度;

- 交互中心分层策略:以“对象交互”为子目标(而非传统位置/状态目标),高层策略通过“多样性奖励”控制交互图选择空间(避免指数级增长),低层策略复用离线预训练模型,显著提升长 horizon 任务效率和泛化性。

解决方法/算法的通俗解释,以及具体做法

通俗解释

把环境理解成“多个对象+对象间的互动”:先让模型“看懂”每个对象(比如杯子、桌子),并分清每个对象的“固定属性”(杯子颜色不会变)和“变化属性”(杯子位置会动);再让模型“学会”哪些对象在互动(比如手和杯子在互动,桌子和杯子没互动);最后训练两层策略——“指挥官”(高层)决定先让手和杯子互动、再让杯子和桌子互动,“执行者”(低层)根据指令完成具体动作。

具体做法

-

离线模型学习细节:

- 视觉编码:用冻结的DINO-v2/R3M提取图像特征,再用槽注意力(Slot Attention)聚类为对象级特征(每个槽对应一个对象);

- 状态分解:用VAE将对象特征映射为 latent 状态(sᵢ=(dᵢ,cᵢ)),通过“时间一致性损失(L_static,静态属性跨时间不变)”和“对比损失(L_con,不同对象静态属性区分开)”保证dᵢ(动态)和cᵢ(静态)分离;

- 交互建模:两种方式——①变分掩码(从类别分布/码本采样交互图,用ELBO优化);②条件独立性测试(计算对象间条件互信息,判断是否交互);

- 动态与奖励预测:用GRU建模动态 transition(dₜ₊₁ = 自转移+交互转移),用MLP建模奖励解码器(pᵣ(rₜ|sₜ,aₜ))。

-

在线分层策略细节:

- 低层策略(πl):离线预训练时用MPC/PPO学习“从当前状态+目标交互图到动作”的映射,在线阶段微调;

- 高层策略(πh):用PPO学习“从当前状态到交互图序列”的映射,加入多样性奖励(r_div=1/√已访问交互图数量),限制每次仅关注1-2个对象,减少动作空间。

基于前人的哪些方法

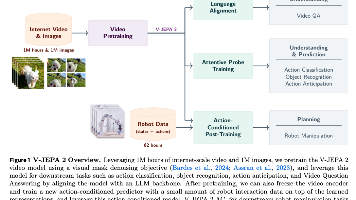

- 对象中心表示学习:槽注意力(Slot Attention,Locatello et al. 2020)、预训练视觉特征(DINO-v2/Oquab et al. 2024、R3M/Nair et al. 2022);

- 世界模型基础:Dreamer系列(Hafner et al. 2020-2023)的 latent 动态建模、VAE变分推断(Kingma et al. 2014);

- 分层RL:子目标分解(Wang et al. 2024/SKILD)、技能发现(Chuck et al. 2023/Granger因果分层);

- 交互/因果建模:变分掩码(Löwe et al. 2022/ amortized因果发现)、条件独立性测试(Wang et al. 2022/因果动态学习)。

实验设置、数据、评估方式

实验环境(数据来源)

覆盖模拟机器人、具身AI等场景:

- SpritesWorld(2D对象交互验证解纠缠);

- OpenAI-Gym Fetch(机械臂推/开关对象);

- Franka Kitchen(7自由度机械臂完成厨房任务:开微波炉、移水壶等);

- i-Gibson(家庭场景Fetch机器人操作桃子:抓取、切割);

- Libero(终身学习基准,桌面/家庭对象搬运)。

基线方法

- 模型无关RL:TD-MPC2(2024)、EIT(2024,对象中心模型无关);

- 世界模型RL:DreamerV3(2023)、DINO-WM(2024,预训练视觉特征世界模型)。

评估方式

- 世界模型能力:

- 观测预测:LPIPS(感知相似度,越低越好);

- 交互建模:nSHD(标准化结构汉明距离,越低越好,衡量交互图与真实的差距);

- 状态分解:线性探测MSE(用线性层预测真实静动态属性,越低越好);

- 策略学习能力:

- 单任务:平均成功率;

- 泛化任务:①属性泛化(零-shot新属性组合);②组合泛化( unseen对象数量/属性组合);③技能泛化( unseen技能组合,如“推+开关”)。

提到的同类工作

- 因子化与对象中心RL:

- Zadaianchuk et al. 2023(对象中心视频特征学习);

- Haramati et al. 2024(EIT,对象中心模型无关RL,建模对象交互);

- Feng et al. 2023(动态属性因子化世界模型,多对象RL);

- 分层RL与技能发现:

- Wang et al. 2024(SKILD,无监督交互技能发现);

- Chuck et al. 2023(Granger因果分层技能);

- Zadaianchuk et al. 2021(对象中心目标条件分层策略);

- 因果/交互建模:

- Löwe et al. 2022( amortized因果发现,变分掩码);

- Wang et al. 2022(因果动态学习,条件独立性测试);

- 预训练视觉特征控制:

- Zhou et al. 2024(DINO-WM,预训练特征世界模型);

- Cui et al. 2024(Dynamo,域内动力学预训练)。

和本文相关性最高的3个文献

- Zizhao Wang et al. 2024. SKILD: Unsupervised Skill Discovery Guided by Factor Interactions(NeurIPS 2024):以“对象交互”为核心技能,提出无监督技能发现框架,与本文“交互中心分层策略”思路高度一致,本文低层策略设计和多样性奖励借鉴其方法;

- Gaoyue Zhou et al. 2024. DINO-WM: World Models on Pre-trained Visual Features Enable Zero-Shot Planning(arXiv 2411.04983):首次将DINO-v2预训练特征用于世界模型,本文视觉编码和离线世界模型训练流程基于此,且将其作为关键基线对比;

- Dan Haramati et al. 2024. Entity-Centric Reinforcement Learning for Object Manipulation from Pixels(ICLR 2024,EIT):提出对象中心模型无关RL,显式建模对象交互,是本文在“对象中心交互”方向的核心基线,本文在世界模型中集成交互建模,弥补其模型无关的样本效率缺陷。

我的

理论性很强,nips2025.

需要详细读理论。

主要来说就是通过人工加了一些先验,然后设计了一个比较复杂的world model。

DAMO开发者矩阵,由阿里巴巴达摩院和中国互联网协会联合发起,致力于探讨最前沿的技术趋势与应用成果,搭建高质量的交流与分享平台,推动技术创新与产业应用链接,围绕“人工智能与新型计算”构建开放共享的开发者生态。

更多推荐

已为社区贡献28条内容

已为社区贡献28条内容

所有评论(0)