机器学习中数学(10)——先验概率,后验概率,似然函数和极大似然估计

前言读论文的时候总是碰到什么先验概率,后验概率,似然,总是搞不懂是什么意思,今天决定集中学习一下,并在此记录。基本概念先了解几个基本的概念:先验概率: 是指根据以往经验和分析得到的概率。后验概率:事情已经发生,要求这件事情发生的原因是由某个因素引起的可能性的大小,即执果求因。基础公式联合概率公式:p(x,y)=p(x|y)p(y)=p(y|x)p(x)p(x,y)=p(...

前言

读论文的时候总是碰到什么先验概率,后验概率,似然,总是搞不懂是什么意思,今天决定集中学习一下,并在此记录。

基本概念

先了解几个基本的概念:

先验概率: 是指根据以往经验和分析得到的概率。

后验概率:事情已经发生,要求这件事情发生的原因是由某个因素引起的可能性的大小,即执果求因。

基础公式

联合概率公式: p(x,y)=p(x|y)p(y)=p(y|x)p(x) p ( x , y ) = p ( x | y ) p ( y ) = p ( y | x ) p ( x ) <script type="math/tex" id="MathJax-Element-27">p(x,y)=p(x|y)p(y)=p(y|x)p(x)</script> 表示x和y同时发生的概率。

条件概率公式: p(x|y)=p(x,y)p(y) p ( x | y ) = p ( x , y ) p ( y ) <script type="math/tex" id="MathJax-Element-28">p(x|y)=\frac{p(x,y)}{p(y)}</script> 表示y发生的条件下x发生的概率。条件概率是由因求果,及y发生了,导致x发生的概率。如一个人抽烟求他得肺癌的概率。

全概率公式: p(x)=∑Mm=1p(x|ym)p(ym) p ( x ) = ∑ m = 1 M p ( x | y m ) p ( y m ) <script type="math/tex" id="MathJax-Element-29">p(x)=\sum_{m=1}^{M}p(x|y_m)p(y_m)</script>, 其中 ∑Mm=1p(ym)=1 ∑ m = 1 M p ( y m ) = 1 <script type="math/tex" id="MathJax-Element-30">\sum_{m=1}^{M}p(y_m) =1</script>

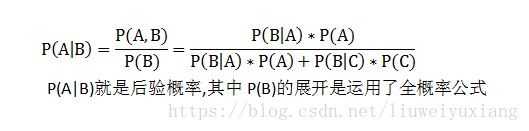

贝叶斯公式: p(ym|x)=p(x,ym)p(x)=p(x|ym)p(ym)p(x)=p(x|ym)p(ym)∑Mm=1p(ym)p(x|ym) p ( y m | x ) = p ( x , y m ) p ( x ) = p ( x | y m ) p ( y m ) p ( x ) = p ( x | y m ) p ( y m ) ∑ m = 1 M p ( y m ) p ( x | y m ) <script type="math/tex" id="MathJax-Element-31">p(y_m|x)=\frac{p(x,y_m)}{p(x)}=\frac{p(x|y_m)p(y_m)}{p(x)}=\frac{p(x|y_m)p(y_m)}{\sum_{m=1}^{M}p(y_m)p(x|y_m)}</script>,贝叶斯公式又称后验概率公式、逆概率公式。贝叶斯公式是执果求因表示已知x发生的条件下求它由y引起的概率。如一个人患了肺癌抽求他抽烟的概率。

一个荔枝

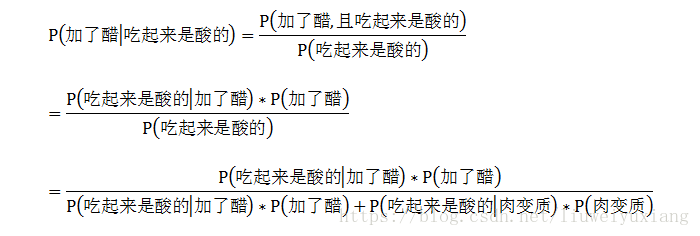

首先我想问一个问题,桌子上如果有一块肉喝一瓶醋,你如果吃了一块肉,然后你觉得是酸的,那你觉得肉里加了醋的概率有多大?你说:80%可能性加了醋.OK,你已经进行了一次后验概率的猜测.没错,就这么简单.

形式化:我们设A为加了醋的概率,B为吃了之后是酸的概率.C为肉变质的概率  ,P(A)是一种先验概率,P(C)也是一种先验概率,P(A,B)是联合概率。

,P(A)是一种先验概率,P(C)也是一种先验概率,P(A,B)是联合概率。

一般而言直接使用概率公式计算后验概率会比较困难,所以一般使用贝叶斯公式,将后验概率转换成含有先验概率和条件概率的形式。

似然函数

贝叶斯公式又名后验概率公式,贝叶斯公式就是在求后验概率。后验概率=似然函数*先验概率 / 证据因子,即 p(ym|x)=p(x|ym)p(ym)p(x) p ( y m | x ) = p ( x | y m ) p ( y m ) p ( x ) <script type="math/tex" id="MathJax-Element-32">p(y_m|x)=\frac{p(x|y_m)p(y_m)}{p(x)}</script>, 证据因子 p(x) p ( x ) <script type="math/tex" id="MathJax-Element-33">p(x)</script>(Evidence,也被称为归一化常数)可仅看成一个权值因子,以保证各类别的后验概率总和为1从而满足概率条件。

那么什么是似然函数呢?

在数理统计学中,似然函数是一种关于统计模型中的参数的函数,表示模型参数中的似然性。

似然函数在统计推断中有重大作用,如在最大似然估计和费雪信息之中的应用等等。“似然性”与“或然性”或“概率”意思相近,都是指某种事件发生的可能性,但是在统计学中,“似然性”和“或然性”或“概率”又有明确的区分。

概率 用于在已知一些参数的情况下,预测接下来的观测所得到的结果,而 似然性 则是用于在已知某些观测所得到的结果时,对有关事物的性质的参数进行估计。在这种意义上,似然函数可以理解为条件概率的逆反。

在已知某个参数B时,事件A会发生的概率写作 P(A∣B) P ( A ∣ B ) <script type="math/tex" id="MathJax-Element-34">\mathbb{P}(A \mid B)</script>, P(A∣B)=P(A,B)P(B) P ( A ∣ B ) = P ( A , B ) P ( B ) <script type="math/tex" id="MathJax-Element-35"> P(A \mid B) = \frac{P(A , B)}{P(B)} \!</script>利用贝叶斯定理, P(B∣A)=P(A∣B)P(B)P(A) P ( B ∣ A ) = P ( A ∣ B ) P ( B ) P ( A ) <script type="math/tex" id="MathJax-Element-36">P(B \mid A) = \frac{P(A \mid B)\;P(B)}{P(A)} \!</script> 因此,我们可以反过来构造表示似然性的方法:已知有事件A发生,运用似然函数 L(B∣A) L ( B ∣ A ) <script type="math/tex" id="MathJax-Element-37">\mathbb{L}(B \mid A)</script>,我们估计参数B的可能性。

形式上,似然函数也是一种条件概率函数,但我们关注的变量改变了: L(B∣A)=b↦P(A∣B=b) L ( B ∣ A ) = b ↦ P ( A ∣ B = b ) <script type="math/tex" id="MathJax-Element-38">\mathbb{L}(B \mid A) = b\mapsto P(A \mid B=b) \!</script>

注意到这里并不要求似然函数满足归一性: ∑b∈BP(A∣B=b)=1 ∑ b ∈ B P ( A ∣ B = b ) = 1 <script type="math/tex" id="MathJax-Element-39">\sum_{b \in \mathcal{B}}P(A \mid B=b) = 1</script>。一个似然函数乘以一个正的常数之后仍然是似然函数。对所有α > 0,都可以有似然函数: L(b∣A)=αP(A∣B=b) L ( b ∣ A ) = α P ( A ∣ B = b ) <script type="math/tex" id="MathJax-Element-40">L(b \mid A) = \alpha \; P(A \mid B=b) \!</script>

极大似然估计

例子:

考虑投掷一枚硬币的实验。通常来说,已知投出的硬币正面朝上和反面朝上的概率各自是pH = 0.5,便可以知道投掷若干次后出现各种结果的可能性。比如说,投两次都是正面朝上的概率是0.25。用条件概率表示,就是:

其中H表示正面朝上。

在统计学中,我们关心的是在已知一系列投掷的结果时,关于硬币投掷时正面朝上的可能性的信息。我们可以建立一个统计模型:假设硬币投出时会有pH 的概率正面朝上,而有1 − pH 的概率反面朝上。这时,条件概率可以改写成似然函数:

也就是说,对于取定的似然函数,在观测到两次投掷都是正面朝上时,pH = 0.5 的似然性是0.25(这并不表示当观测到两次正面朝上时pH = 0.5 的概率是0.25)。

如果考虑pH = 0.6,那么似然函数的值也会改变。

注意到似然函数的值变大了。这说明,如果参数pH 的取值变成0.6的话,结果观测到连续两次正面朝上的概率要比假设pH = 0.5时更大。也就是说,参数pH 取成0.6 要比取成0.5 更有说服力,更为“合理”。总之,似然函数的重要性不是它的具体取值,而是当参数变化时函数到底变小还是变大。对同一个似然函数,如果存在一个参数值,使得它的函数值达到最大的话,那么这个值就是最为“合理”的参数值。

在这个例子中,似然函数实际上等于:

如果取pH = 1,那么似然函数达到最大值1。也就是说,当连续观测到两次正面朝上时,假设硬币投掷时正面朝上的概率为1是最合理的。

类似地,如果观测到的是三次投掷硬币,头两次正面朝上,第三次反面朝上,那么似然函数将会是:

这时候,似然函数的最大值将会在 pH=23 p H = 2 3 <script type="math/tex" id="MathJax-Element-174">p_H = \frac{2}{3}</script>的时候取到。也就是说,当观测到三次投掷中前两次正面朝上而后一次反面朝上时,估计硬币投掷时正面朝上的概率 pH=23 p H = 2 3 <script type="math/tex" id="MathJax-Element-175">p_H = \frac{2}{3}</script>是最合理的。

上面的例子其实就是在做最大似然估计, L(pH=θ∣HHT) L ( p H = θ ∣ HHT ) <script type="math/tex" id="MathJax-Element-176">L(p_H = \theta \mid \mbox{HHT}) </script>越大表示在结果HHT下 pH=θ p H = θ <script type="math/tex" id="MathJax-Element-177">p_H = \theta</script>的可能性越大,当前结果HHT已经发生,在此结果下取 pH=23 p H = 2 3 <script type="math/tex" id="MathJax-Element-178">p_H = \frac{2}{3}</script>, L(pH=θ∣HHT) L ( p H = θ ∣ HHT ) <script type="math/tex" id="MathJax-Element-179">L(p_H = \theta \mid \mbox{HHT}) </script>取得最大值,即表示在此结果 pH=23 p H = 2 3 <script type="math/tex" id="MathJax-Element-180">p_H = \frac{2}{3}</script>的概率最大。

注意: 似然值并不是概率值,但是和概率是正相关的,似然值越大,表示概率值越大。

关于极大似然的生动解释请参看这篇文章: 机器学习中的数学(9)——极大似然估计最通俗的讲解

参考文章

DAMO开发者矩阵,由阿里巴巴达摩院和中国互联网协会联合发起,致力于探讨最前沿的技术趋势与应用成果,搭建高质量的交流与分享平台,推动技术创新与产业应用链接,围绕“人工智能与新型计算”构建开放共享的开发者生态。

更多推荐

已为社区贡献2条内容

已为社区贡献2条内容

所有评论(0)