Python高性能并行计算:多核与GPU加速实战

随着数据规模与计算复杂度激增,单线程Python程序已难以满足性能需求。本文深入探讨多核CPU并行化与GPU加速两大高性能计算方案,结合2025年最新技术生态(如Python 3.13无GIL模式、CUDA 12.4、Dask 2025.7),系统解析其核心原理、工具链实践与行业应用场景。通过对比多进程、多线程、分布式框架及GPU编程的实战优化策略,为开发者提供从理论到落地的全流程

摘要

随着数据规模与计算复杂度激增,单线程Python程序已难以满足性能需求。本文深入探讨多核CPU并行化与GPU加速两大高性能计算方案,结合2025年最新技术生态(如Python 3.13无GIL模式、CUDA 12.4、Dask 2025.7),系统解析其核心原理、工具链实践与行业应用场景。通过对比多进程、多线程、分布式框架及GPU编程的实战优化策略,为开发者提供从理论到落地的全流程指南,助力突破Python性能瓶颈,实现计算效率的指数级提升。

一、并行计算的理论基础与技术挑战

1.1 并行计算的核心范式

- 数据并行:将数据集分割为子集,由多个处理单元同步处理。典型场景包括大规模数组运算(如NumPy矩阵操作)与批处理任务。其优势在于计算负载均衡,适用于SIMD(单指令多数据流)架构。

- 任务并行:将任务拆分为独立子任务并行执行。例如多参数敏感性分析或多模型训练,各子任务无数据依赖关系,可独立调度至不同核心。

- 混合并行:结合数据与任务并行,适用于超大规模计算(如分布式深度学习训练),需协调进程间通信与资源分配。

1.2 Python的并行瓶颈:GIL与内存模型

- 全局解释器锁(GIL):CPython的核心机制限制多线程并发,导致CPU密集型任务无法充分利用多核。2025年Python 3.13的实验性无GIL模式(

--disable-gil)将多线程性能提升40%,但需权衡单线程性能损耗与C扩展兼容性。 - 进程间通信成本:多进程方案(

multiprocessing)通过IPC(管道、共享内存)传递数据,高频率通信易成性能瓶颈。解决方案包括:- 共享内存(

shared_memory)减少拷贝开销 - 零拷贝技术(如Apache Arrow)优化跨进程数据交换。

- 共享内存(

二、多核CPU加速实战方案

2.1 多进程与进程池优化

- 基础方案:

multiprocessing.Process创建独立进程,每个进程独占CPU核心与GIL,适用于计算密集型任务。 - 高级调度:

ProcessPoolExecutor(concurrent.futures)提供异步任务队列,支持动态负载均衡:

关键参数with ProcessPoolExecutor(max_workers=8) as executor: futures = [executor.submit(compute, data_chunk) for data_chunk in dataset] results = [f.result() for f in futures]max_workers需匹配CPU物理核心数(非逻辑线程),避免进程切换开销。

2.2 并行计算框架选型

| 框架 | 适用场景 | 性能优势 | 典型案例 |

|---|---|---|---|

| Joblib | 科学计算流水线 | 自动磁盘缓存 | Scikit-learn交叉验证 |

| Dask | 超大规模数组/DataFrame | 动态任务图调度 | 10TB级气象数据分析 |

| Ray | 分布式Actor模型 | 低延迟任务调度 | 强化学习多Agent训练 |

- Dask实战:将NumPy数组分块(Chunking)并行处理,计算效率提升3–5倍:

通过import dask.array as da data = da.random.random((1e6, 1e6), chunks=(25000, 25000)) # 分块大小25K×25K result = da.sin(data).mean().compute() # 触发并行执行chunks参数平衡任务粒度与通信开销。

2.3 编译优化技术

- Numba JIT加速:将Python函数编译为机器码,支持CPU多线程并行:

from numba import jit, prange @jit(nopython=True, parallel=True) def parallel_sum(arr): total = 0.0 for i in prange(len(arr)): total += arr[i] return totalprange自动启用多线程,数值计算循环速度提升10–50倍。 - Cython静态编译:通过类型声明生成C扩展模块,避免GIL限制,适用于迭代密集型算法。

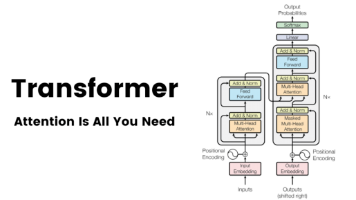

三、GPU加速:从CUDA编程到高阶框架

3.1 GPU架构与编程模型

- 硬件特性:

- 流式多处理器(SM):GPU核心计算单元,含数千个CUDA核心。

- 内存层次:全局内存(高延迟)、共享内存(块内低延迟)、寄存器(线程独享)。

优化关键在于减少全局内存访问,利用共享内存复用数据。

- CUDA逻辑架构:

- 网格(Grid) → 块(Block) → 线程(Thread)

- 线程索引计算:

全局ID = blockIdx.x * blockDim.x + threadIdx.x

3.2 GPU编程实践方案

- Numba+CUDA:免编译实现GPU核函数:

适用于自定义算子开发,需手动管理内存传输。from numba import cuda @cuda.jit def gpu_add(a, b, out): idx = cuda.grid(1) if idx < out.size: out[idx] = a[idx] + b[idx] # 调用配置:32线程/块,总块数=数据量/32 gpu_add[blocks_per_grid, 32](a_d, b_d, out_d) - CuPy:NumPy的GPU替代:

兼容90% NumPy API,迁移成本极低。import cupy as cp a_gpu = cp.random.rand(10000, 10000) b_gpu = cp.random.rand(10000, 10000) c_gpu = cp.dot(a_gpu, b_gpu) # 自动调用CUDA加速

3.3 深度学习框架的GPU优化

- PyTorch/TensorFlow:

- 自动混合精度:

torch.cuda.amp减少显存占用,加速训练40%。 - 多GPU数据并行:

nn.DataParallel或nn.DistributedDataParallel实现零代码修改扩展。

- 自动混合精度:

- 模型部署优化:

- TensorRT编译ONNX模型,推理延迟降低80%。

- Triton推理服务器支持动态批处理与并发调度。

四、应用场景与性能调优指南

4.1 场景驱动的技术选型

| 任务类型 | 推荐方案 | 性能收益 |

|---|---|---|

| 数值模拟/科学计算 | Dask + Numba | 10–100倍(百亿级数据) |

| 深度学习训练 | PyTorch + CUDA | 50倍(对比CPU) |

| 实时流处理 | Ray Actors | 毫秒级响应 |

| 参数扫描优化 | Joblib Parallel | 线性扩展(核数↑=时间↓) |

4.2 性能优化关键策略

- 计算资源绑定:

- CPU:使用

taskset或numactl绑定进程至特定核心,减少缓存失效。 - GPU:

CUDA_VISIBLE_DEVICES隔离设备,避免资源争抢。

- CPU:使用

- 通信压缩:

- 梯度聚合(AllReduce)采用FP16或稀疏通信。

- NCCL后端加速多GPU通信。

- 内存瓶颈突破:

- 分页内存管理:PyTorch的

pin_memory加速CPU→GPU传输。 - 统一虚拟寻址(UVA):CuPy与Numba支持零拷贝访问CPU内存。

- 分页内存管理:PyTorch的

4.3 调试与监控工具

- 性能分析器:

nsys(NVIDIA Nsight Systems)定位GPU内核瓶颈。vTune(Intel)分析CPU缓存命中率与指令级并行。

- 资源监控:

gpustat实时显示GPU利用率与显存占用。dask.dashboard可视化任务调度状态。

结论:构建高效并行计算系统

Python高性能计算需综合多核与GPU能力,形成分层优化体系:

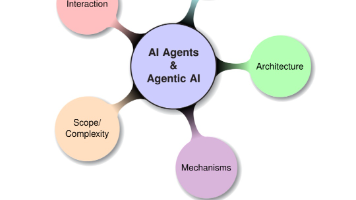

- 架构设计层:

- 依据任务特性选择数据并行(Dask)或任务并行(Ray)。

- 混合精度计算与通信压缩减少I/O瓶颈。

- 工具链层:

- 多核CPU:优先使用

ProcessPoolExecutor与Numba,平衡效率与易用性。 - GPU加速:CuPy快速迁移数值计算,PyTorch生态覆盖深度学习全流程。

- 多核CPU:优先使用

- 部署层:

- 云原生方案:Kubernetes编排Dask/Ray集群,弹性扩展计算节点。

- 边缘计算:TensorRT部署轻量模型,Triton服务器管理推理管线。

未来趋势:随着Python 3.14全面稳定无GIL模式,多线程性能瓶颈将进一步消解;而异构计算架构(CPU+GPU+NPU)的统一编程模型(如oneAPI)将成下一个技术高地。开发者需掌握性能剖析工具链,持续优化计算-通信比,方能在算力革命中保持竞争力。

DAMO开发者矩阵,由阿里巴巴达摩院和中国互联网协会联合发起,致力于探讨最前沿的技术趋势与应用成果,搭建高质量的交流与分享平台,推动技术创新与产业应用链接,围绕“人工智能与新型计算”构建开放共享的开发者生态。

更多推荐

已为社区贡献5条内容

已为社区贡献5条内容

所有评论(0)