深度学习——不同梯度下降法的特点比较

GD、BGD、SGD的比较

·

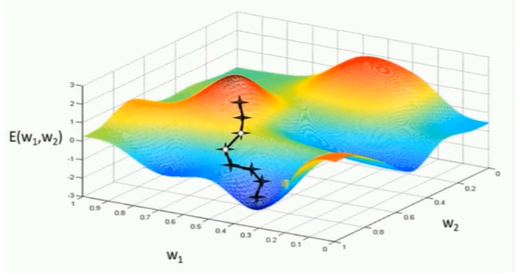

1、标准梯度下降法(GD)

(1)每个样本都计算一次

(2)训练速度慢

(3)容易陷入局部最优解

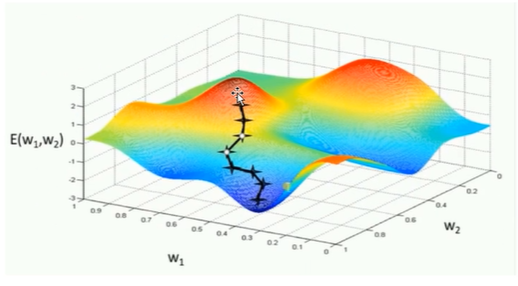

2、批量梯度下降法(BGD]-每批样本计算一次

(1)训练速度较快

(2)选择平均梯度最小的方向

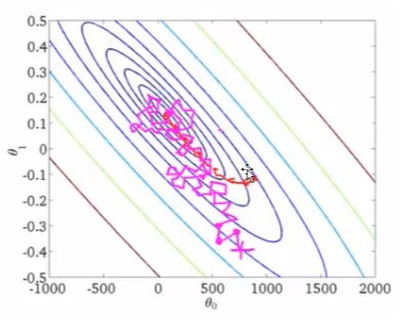

3、随机梯度下降法(SGD)-每批样本计算一次

(1)训练速度快(不需要计算每个样本的梯度或平均梯度)

(2)从批样本随机选择一个方向下降(某次有可能不正确,最终会正确)

(3)注意:

随机下降的跨度给小相当于标准梯度下降

随机的跨度给大相当于批量梯度下降

DAMO开发者矩阵,由阿里巴巴达摩院和中国互联网协会联合发起,致力于探讨最前沿的技术趋势与应用成果,搭建高质量的交流与分享平台,推动技术创新与产业应用链接,围绕“人工智能与新型计算”构建开放共享的开发者生态。

更多推荐

已为社区贡献2条内容

已为社区贡献2条内容

所有评论(0)