【一文到底】深度学习环境配置+ PatchTST复现【Anaconda+PyTorch(GPU版)+CUDA+cuDNN】

【一文到底】深度学习环境配置+ PatchTST复现【Anaconda+PyTorch(GPU版)+CUDA+cuDNN】

【一文到底】深度学习环境配置+ PatchTST复现【Anaconda+PyTorch(GPU版)+CUDA+cuDNN】

深度学习环境配置+PatchTST复现

摘要:

环境配置:Anaconda+PyTorch(GPU版)+CUDA+cuDNN

复现时序模型:PatchTST

Note:如果你想使用 GPU 版的 PyTorch,只需要做到以下几点:

- 电脑必须配有 NVIDIA 独立显卡,并正确安装对应版本的显卡驱动;

- 建议安装 Anaconda 或轻量版的 Miniconda,便于创建隔离的 Python 环境、方便依赖管理;

- 使用

pip或conda安装带有 cuXXX 后缀的 PyTorch 版本(例如cu118表示支持 CUDA 11.8); - 无需手动安装 CUDA Toolkit 或 cuDNN!

总结一句话:

只有开发者才需要手动安装 CUDA Toolkit / cuDNN,尤其是需要开发底层 CUDA 代码、编译框架源码、使用 TensorRT 等的情况。对于普通用户,只要安装好 GPU 版 PyTorch,什么都不用配,就能直接用显卡训练模型。

1.环境配置

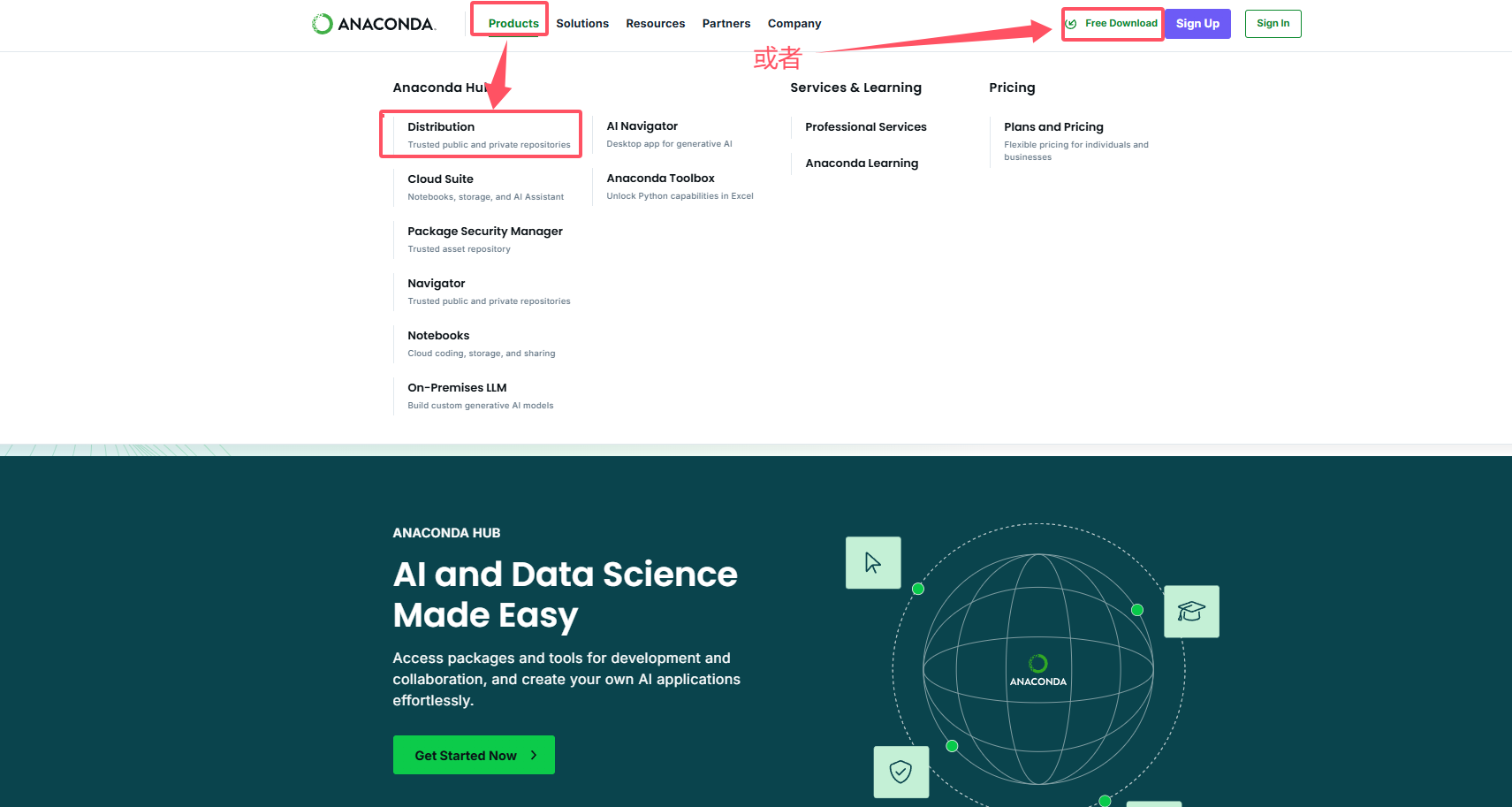

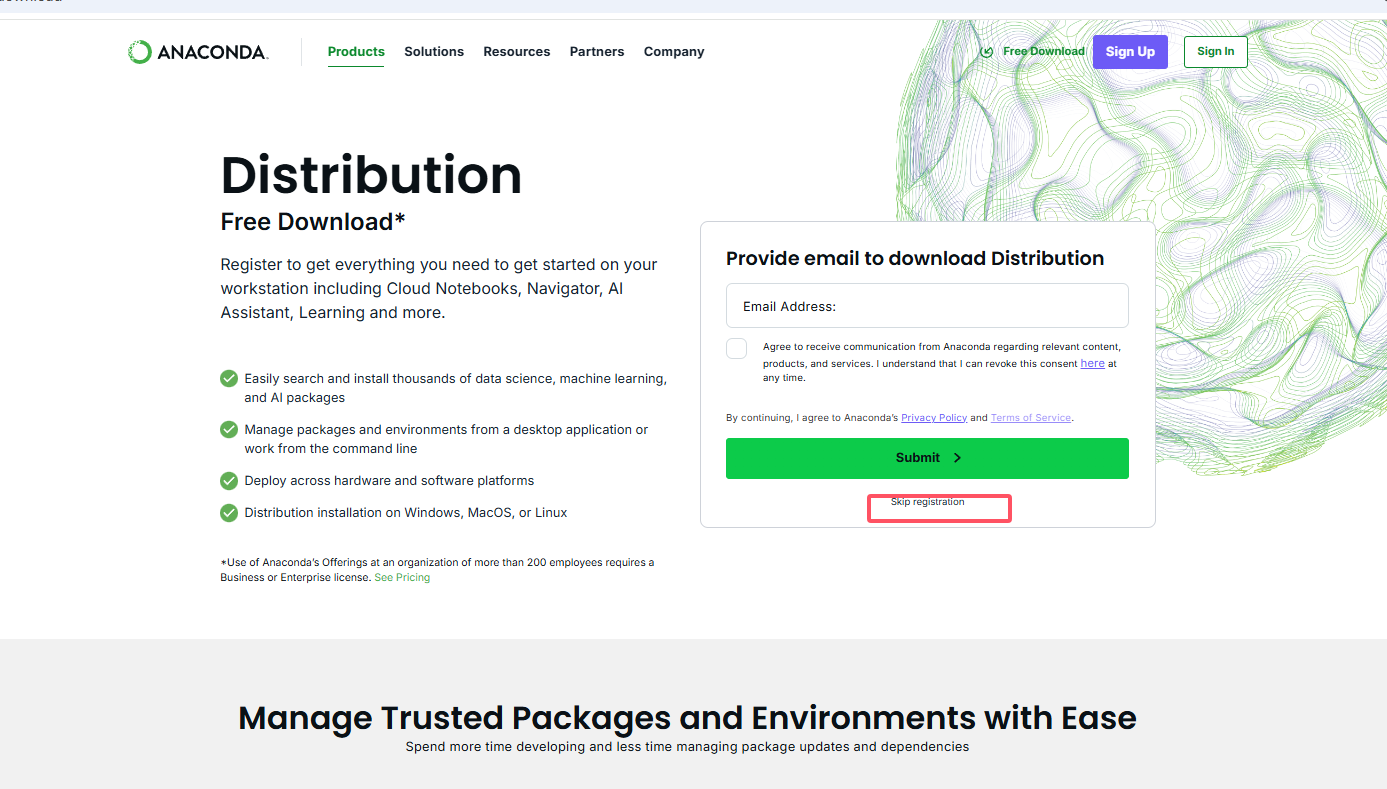

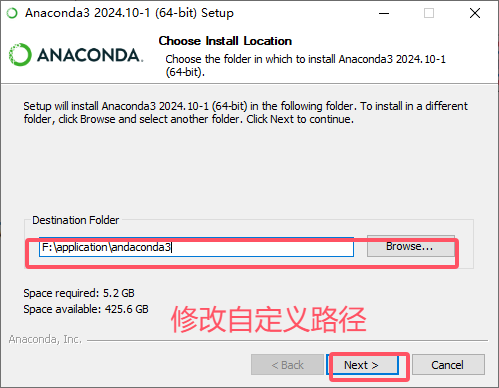

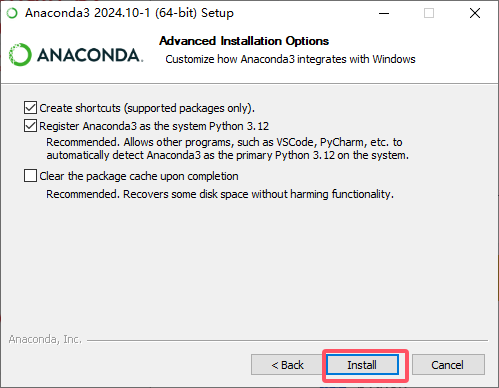

1.1 Anaconda下载及安装

Anaconda官网:https://www.anaconda.com

清华大学开源镜像下载: 清华大学开源镜像

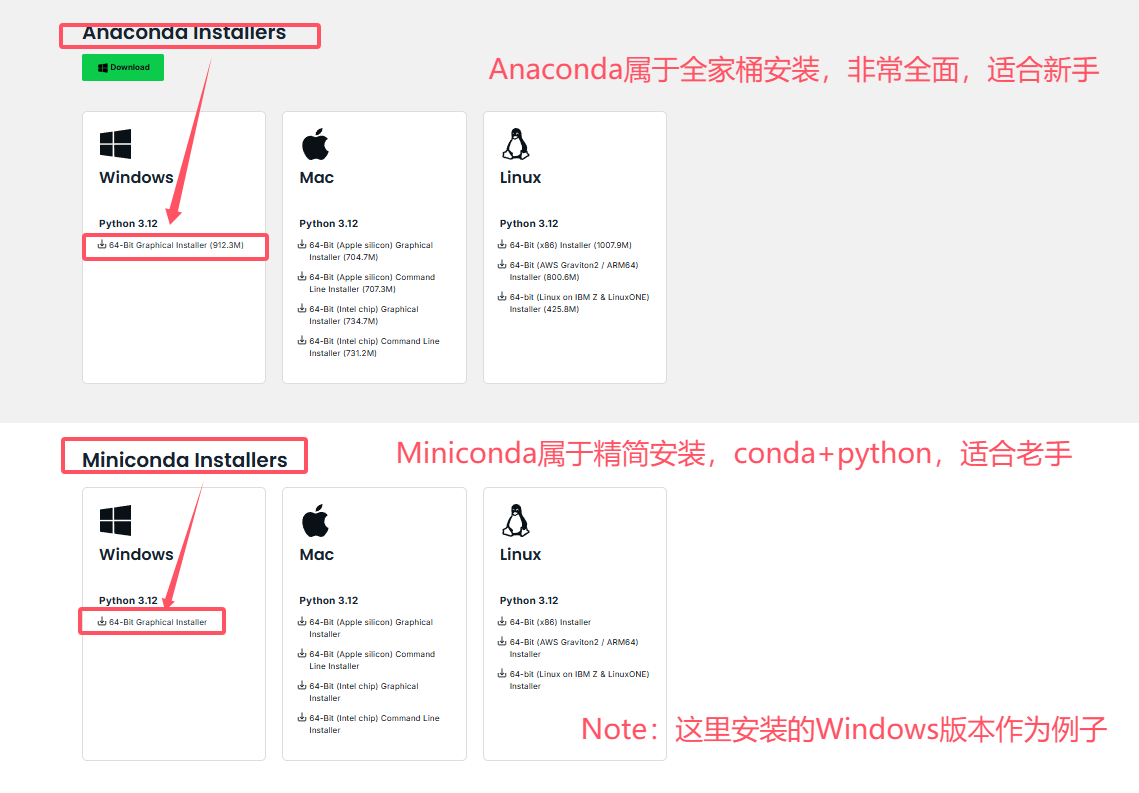

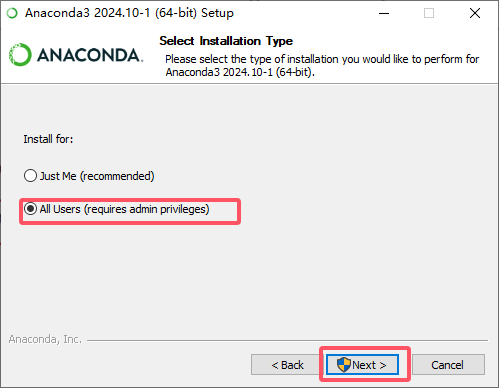

这里下载的Anaconda,下载对应版本后,双击exe文件安装。

Note:没图片的部分,直接点击 Next 继续安装。

接着点击安装即可,安装完成已经默认添加环境变量。

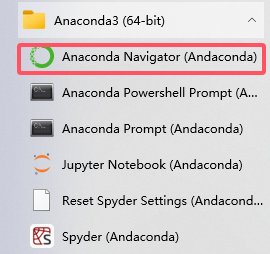

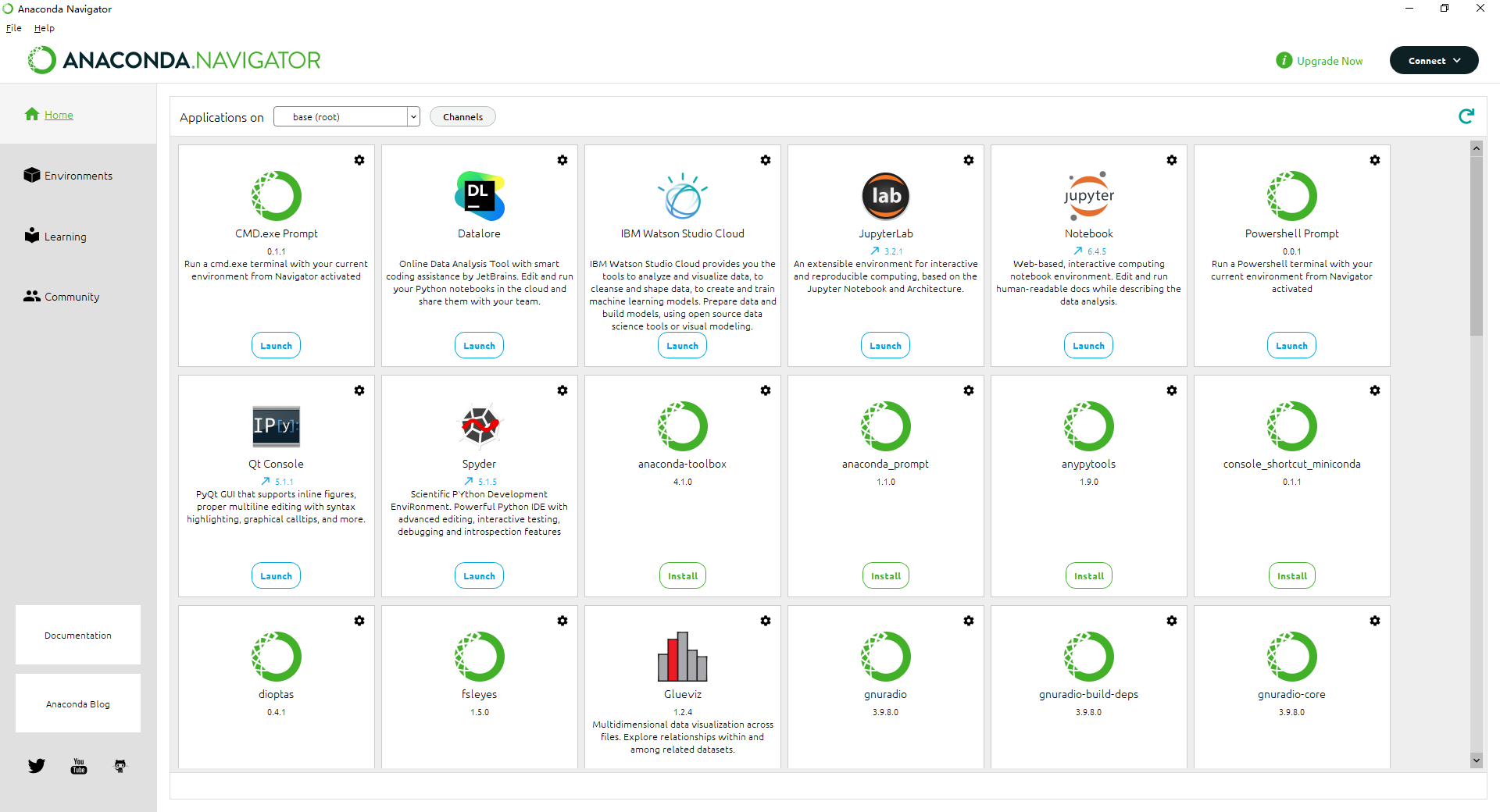

测试是否安装成功

在Anaconda prompt中修改镜像源,切换到国内的源来提高下载速度:

conda config --remove-key channels # 清除已有源(可选)

conda config --add channels https://mirrors.tuna.tsinghua.edu.cn/anaconda/pkgs/main

conda config --add channels https://mirrors.tuna.tsinghua.edu.cn/anaconda/pkgs/free

conda config --add channels https://mirrors.tuna.tsinghua.edu.cn/anaconda/cloud/conda-forge

conda config --add channels https://mirrors.tuna.tsinghua.edu.cn/anaconda/cloud/pytorch

conda config --set show_channel_urls yes

#查看已安装的源

conda config --show channels

此处可能会出现 Anaconda 闪退问题(如未遇到可跳过此节)

解决方法:

(1)使用管理员权限打开Anaconda Prompt

(2)升级navigator,执行conda update anaconda-navigator

(3)重置navigator,执行anaconda-navigator --reset

(4)升级客户端,执行conda update anaconda-client

(5)升级安装依赖包,执行conda update -f anaconda-client

1.2 NVIDIA显卡驱动下载及安装

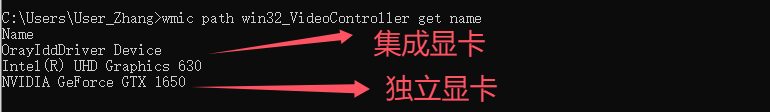

查看自己是否有独立显卡

方法 1:设备管理器查看

- 右键点击开始菜单 → 设备管理器

- 展开「显示适配器」

- 如果你看到两个显卡(例如 “Intel UHD Graphics” 和 “NVIDIA GeForce GTX 1650”) 就说明你有 集显 + 独显

- 如果只看到 Intel 开头的一个,那就是只有集成显卡

方法 2:cmd命令行查看 GPU 列表

wmic path win32_VideoController get name

安装NVIDIA显卡驱动,直接进NVIDIA官网( NVIDIA官网)

点击立即下载,下载的GeForce驱动程序是一个自动识别电脑显卡的NVIDIA驱动,安装好之后注册一个账号并登录,然后在更新显卡驱动,先点驱动程序,然后检查更新,就可以自动更新显卡驱动了。

Note(以下为科普,可以跳过):

| 显卡类型 | 品牌 | 是否支持 CUDA | 是否能装 NVIDIA 驱动 |

|---|---|---|---|

| Intel UHD / Iris | Intel(集成) | 不支持 | 不需要装 NVIDIA 驱动 |

| AMD Radeon | AMD(独立) | 不支持 CUDA | 不能用 NVIDIA 驱动 |

| NVIDIA GTX / RTX 系列 | NVIDIA(独立) | 支持 CUDA | 需要安装 NVIDIA 驱动 |

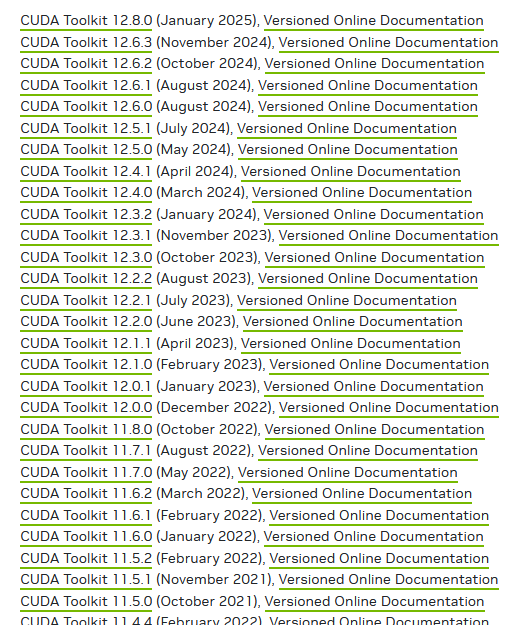

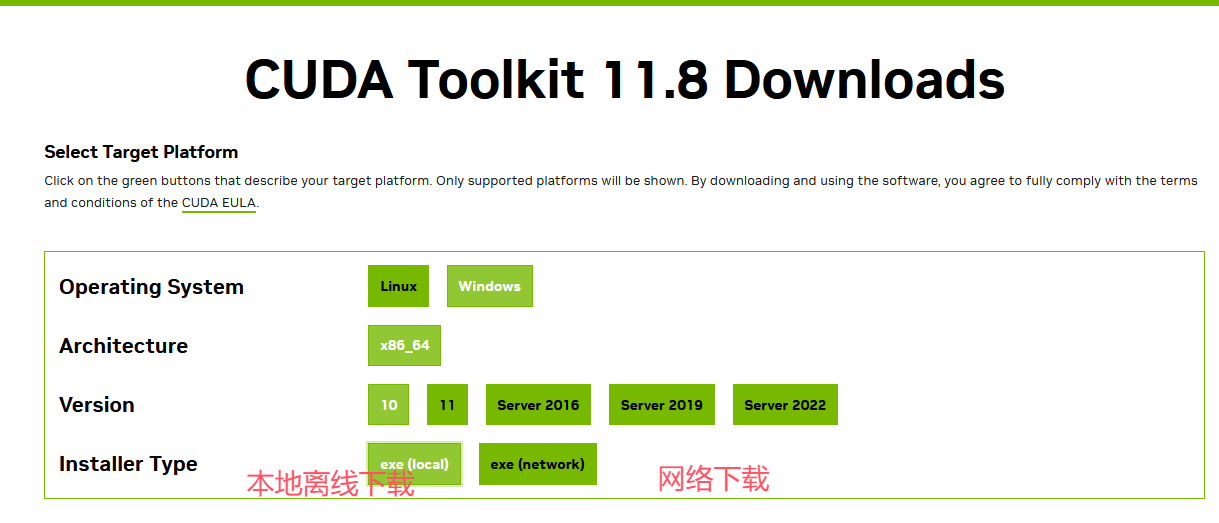

1.3 CUDA下载及安装

Note:以下提供 CUDA 和 cuDNN 的安装流程仅供参考,一般用户可跳过此步骤,直接安装 GPU 版本的 PyTorch 即可完成环境配置。

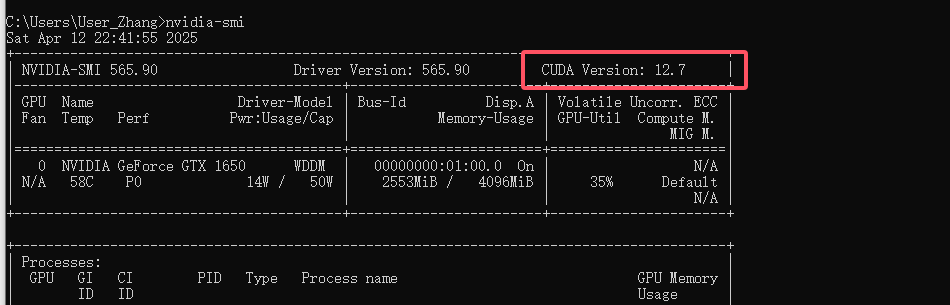

更新完显卡驱动以后进Anaconda prompt的指令界面,输入nvidia-smi,可以看见自己显卡的相关信息

图中看出CUDA版本是12.7及以下版本(此处版本向下兼容,我们显卡及驱动最高支持 CUDA12.7 ,但我们还是采用12.7以下版本,但也别太低)、

**CUDA toolkit Download:**https://developer.nvidia.com/cuda-toolkit-archive

下载好后,双击“exe文件”,选择下载路径(推荐默认路径)

记住安装位置

继续点击下一步安装即可

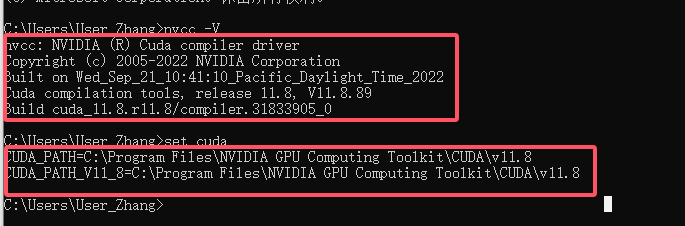

验证是否安装成功

打开cmd,输入:

nvcc --version #查看版本号

set cuda #查看 CUDA 设置的环境变量

如果出现nvcc 不是内部命令,则可能试试没装 Toolkit 或环境变量没配,需要手动添加 CUDA 安装路径到系统 PATH

1.4cuDNN下载及安装

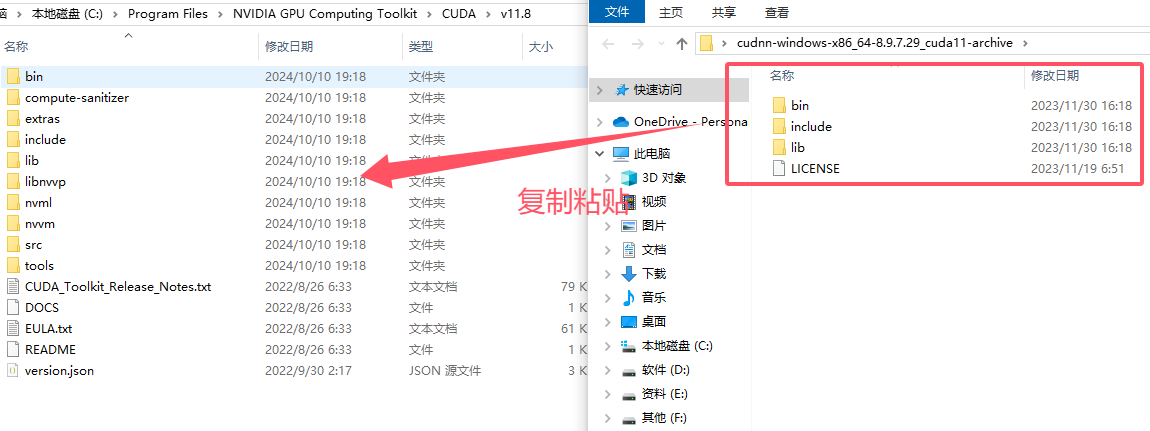

查看适配的 cuDNN:cuDNN Archive | NVIDIA Developer,选择对应的版本下载解压

Note:下载的cudnn要和自己的cuda版本匹配

CUDA 的安装路径在前面截图中有,或者打开电脑的环境变量查看,默认的安装路径如下:

C:\Program Files\NVIDIA GPU Computing Toolkit\CUDA\v11.0

然后复制粘贴

Note:这里直接将cudnn的文件复制到安装cuda中,替换掉原来的文件。cuDNN(CUDA Deep Neural Network library) 是 NVIDIA 提供的一个专门用于 加速深度学习神经网络计算 的 GPU 库。

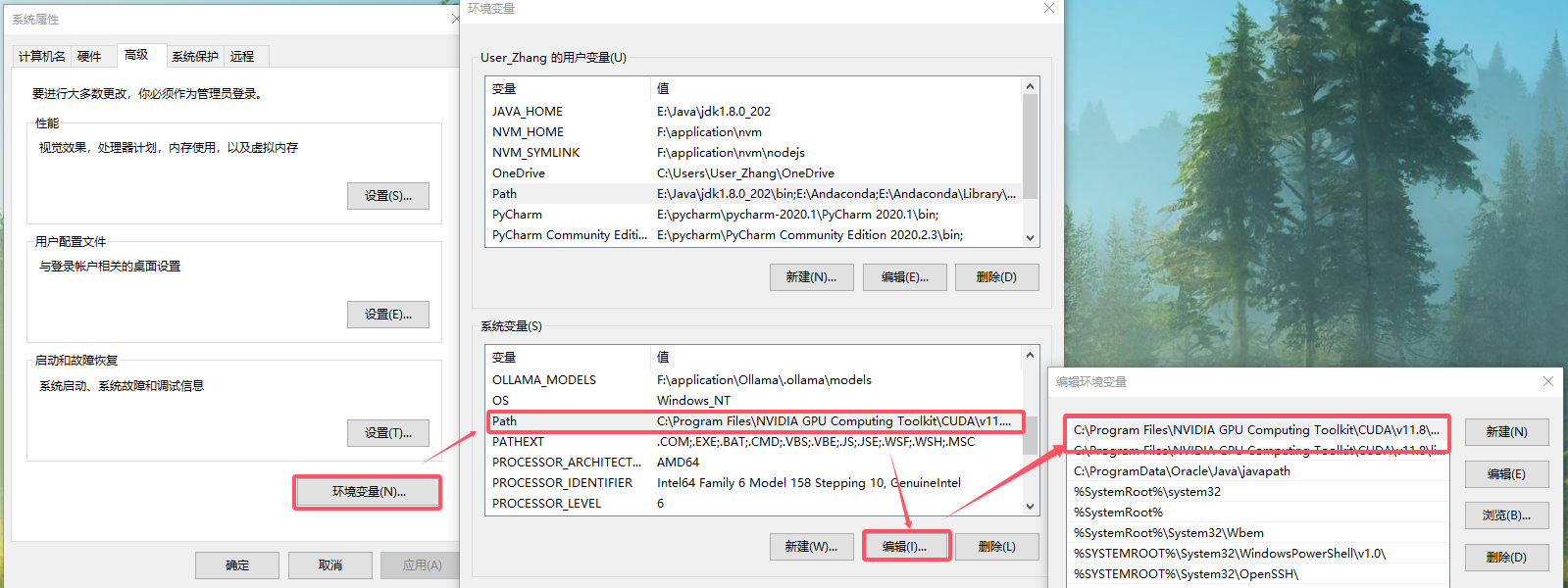

添加环境变量

C:\Program Files\NVIDIA GPU Computing Toolkit\CUDA\v11.2\bin

C:\Program Files\NVIDIA GPU Computing Toolkit\CUDA\v11.2\libnvvp

1.5 PyTorch(GPU版)下载及安装

先在conda中创建虚拟环境

Note:总结一下就是 虚拟环境 = 独立空间 + 独立 Python + 独立依赖,让你不用担心包冲突,轻松完成多个项目,

conda命令集合:conda配置虚拟环境常用命令

# 查看现有环境列表

conda env list

# env_name为虚拟环境名称

conda create --name env_name

#指定python版本(推荐)

conda create --name env_name python=3.9

#激活env_name虚拟环境

conda activate env_name

#查看已经安装的包

conda list

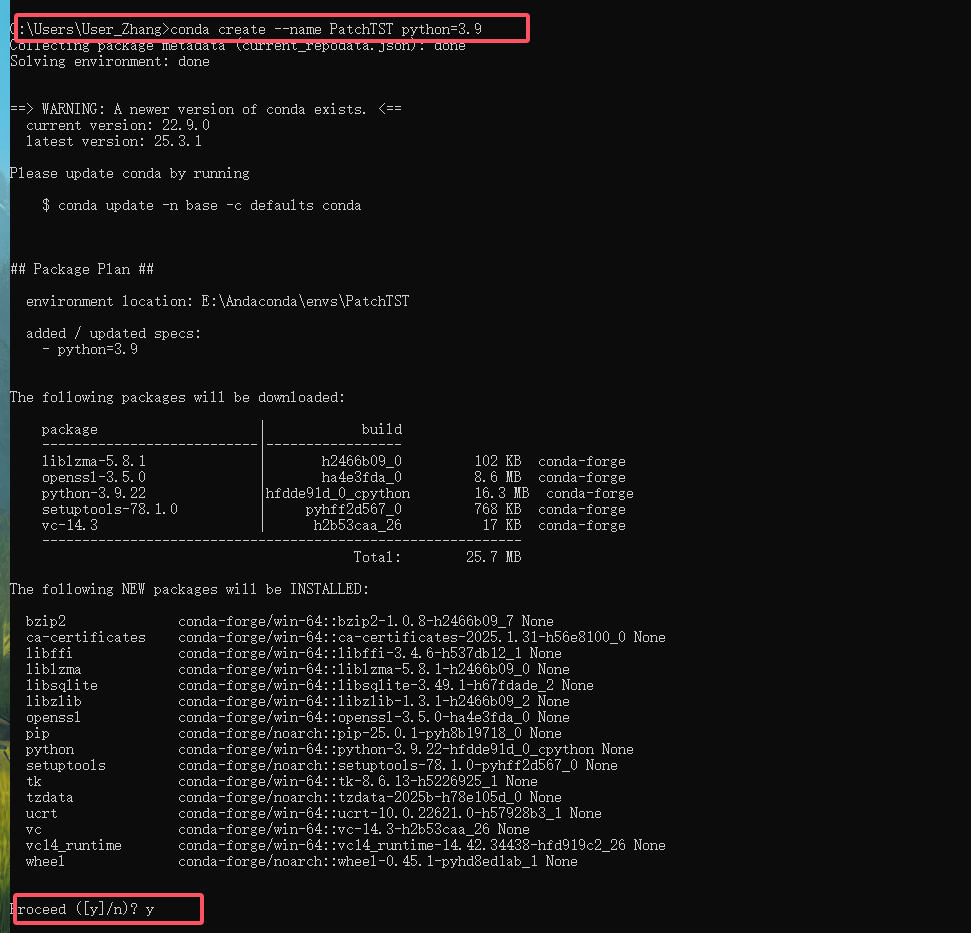

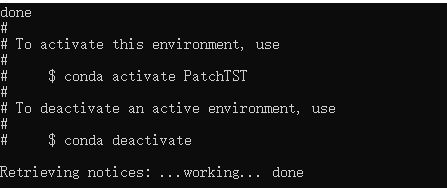

打开cmd,输入conda create --name PatchTST python=3.9 回车后输入y,这里PatchTST是你创建的虚拟环境名称

看到下面内容,说明创建虚拟环境成功

接下来配置pytorch,两种下载方式

第一种pytorch官网下载: https://pytorch.org/

第二种二进制文件下载:https://download.pytorch.org/whl/torch_stable.html

Note:两种方式都可以,第二种是PyTorch 编译好的 二进制文件 (.whl),需要手动挑选,适合离线安装、精细的版本控制,比较推荐;第一种同样是二进制包(实际也是下载 .whl 或 Conda 包),界面友好,简单,如果网速慢,可以使用pip+清华镜像 或 Conda+清华镜像

第一种方式pytorch官网下载

选择自己电脑的对应配置,然后在 Anaconda Prompt中进入配置的虚拟环境,运行 run this Command 即可

# pip安装命令

pip3 install torch torchvision torchaudio --index-url https://download.pytorch.org/whl/cu118

或

#conda安装命令

conda install pytorch torchvision torchaudio cudatoolkit=11.8 -c pytorch

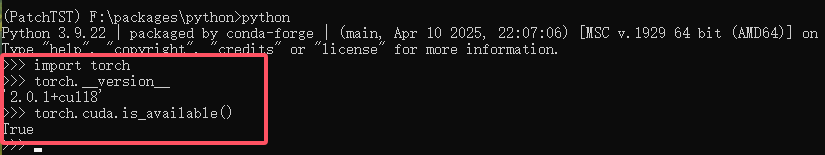

#验证是否安装成功,进入虚拟环境,输入python

import torch

print(torch.__version__) #查看pytorch版本

print(torch.cuda.is_available()) #查看cuda是否可用 输出为True 或者False

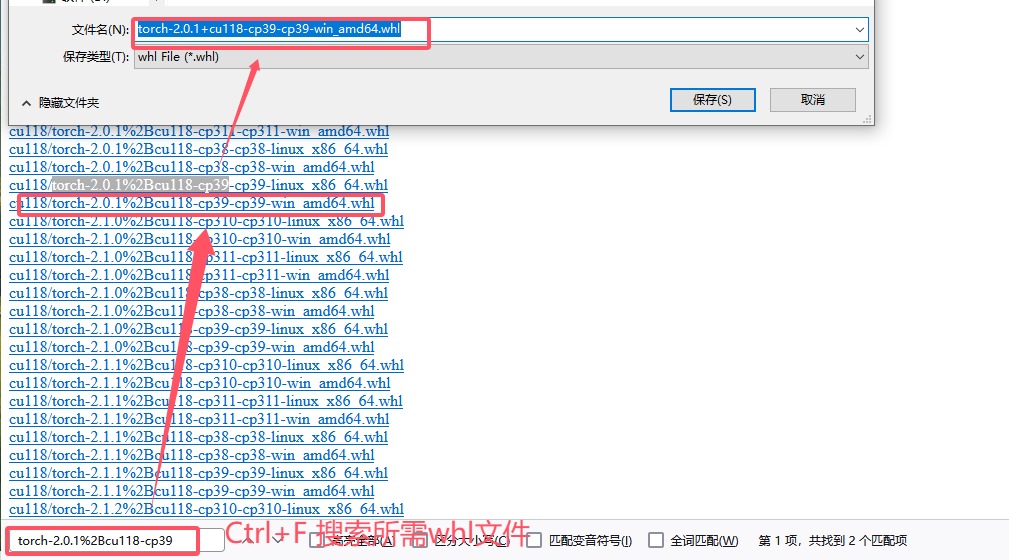

第二种方式二进制文件本地安装

https://download.pytorch.org/whl/torch_stable.html

# 文件

torch-2.0.1+cu118-cp39-cp39-win_amd64.whl

# 文件名解释

torch # PyTorch 库名

2.0.1 # PyTorch 版本号

cu118 # CUDA 11.8(用于 GPU 加速)

cp39-cp39 # 表示这是为 Python 3.9(CPython) 编译的版本

win_amd64 # 平台:Windows 64 位(x86_64 架构)

.whl # wheel 格式:Python 的二进制安装包

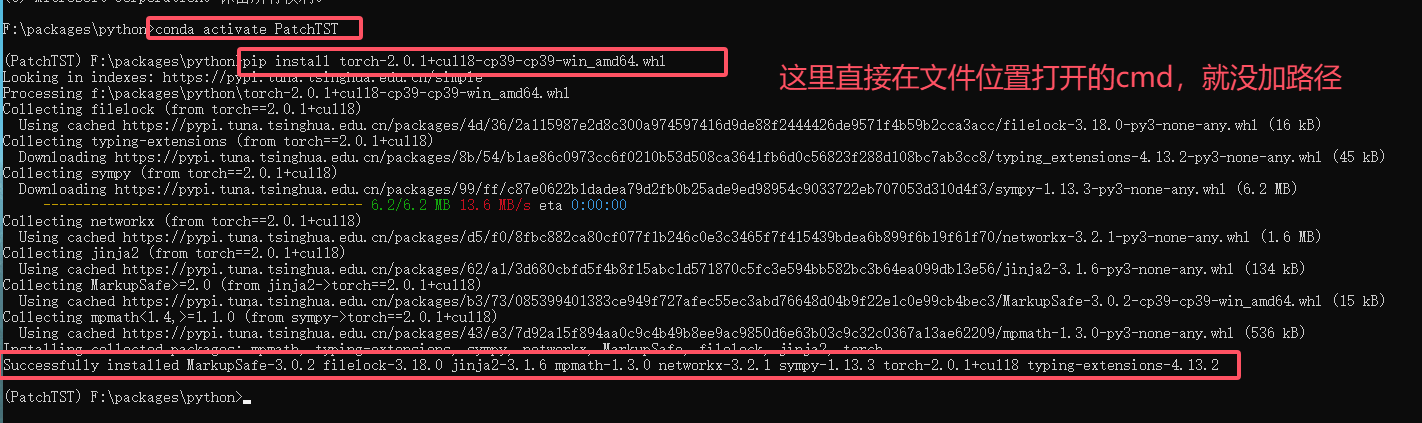

下载好后安装torch

Note:这里按照自己需求下载torchvision 和torchaudio包,下载方式相同

#进入虚拟环境,直接使用pip命令安装

#安装时虚拟环境的python版本要和cp39相同,不然会报错

pip install F:\Downloads\packages\torch-2.0.1+cu118-cp39-cp39-win_amd64.whl

| 包名 | 作用范围 | 常用功能举例 |

|---|---|---|

torch |

核心包 | 提供张量计算、自动求导、模型训练、GPU 支持等 |

torchvision |

图像处理扩展包 | 图像模型(如ResNet)、图像预处理、图像数据集 |

torchaudio |

音频处理扩展包 | 音频读取、特征提取(如梅尔频谱图)、音频模型 |

验证安装是否成功

到这里环境配置就完成了。

2.文献模型复现(PatchTST)

文献标题: A Time Series is Worth 64 Words: Long-term Forecasting with Transformers

会议发表:ICLR 2023(International Conference on Learning Representations)

文献链接: OpenReview 页面

代码实现(GitHub): https://github.com/yuqinie98/PatchTST

Note:PatchTST是NLP/时序方向,本项目基于 PatchTST 官方实现 进行复现,原始版权归作者所有,仅用于学术交流与学习。

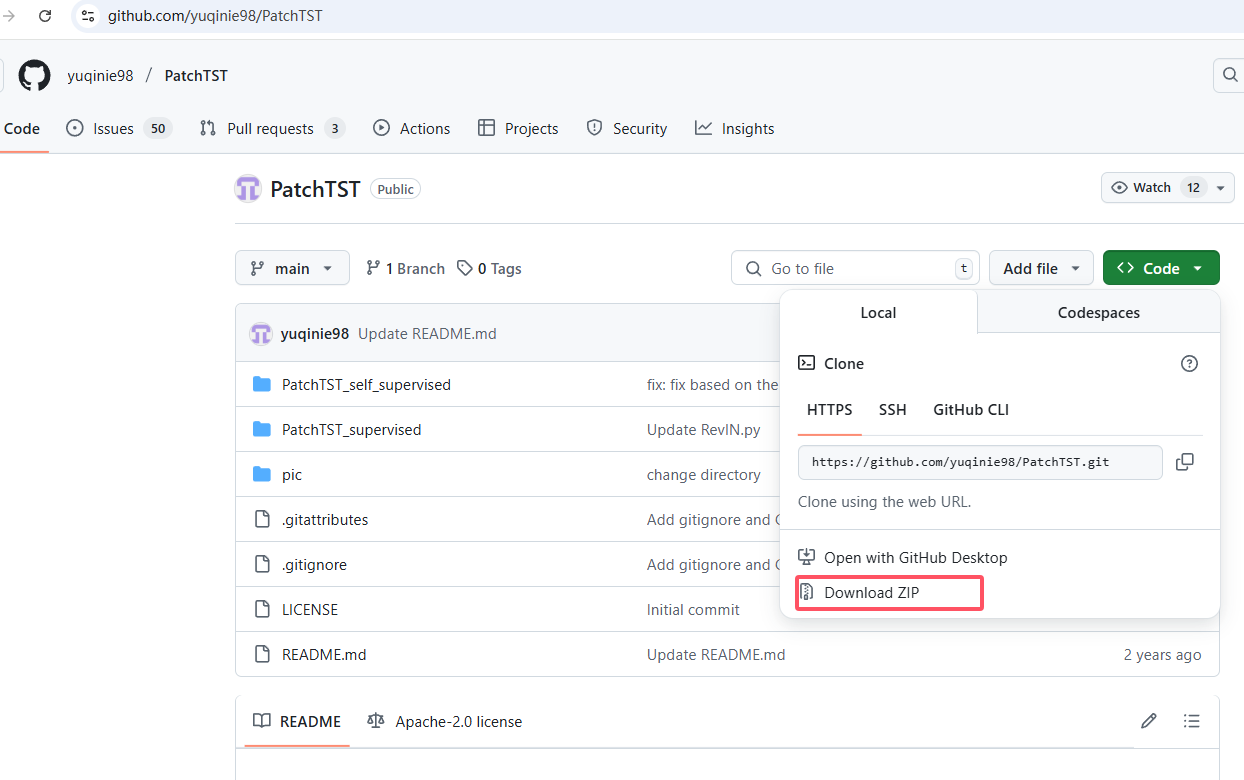

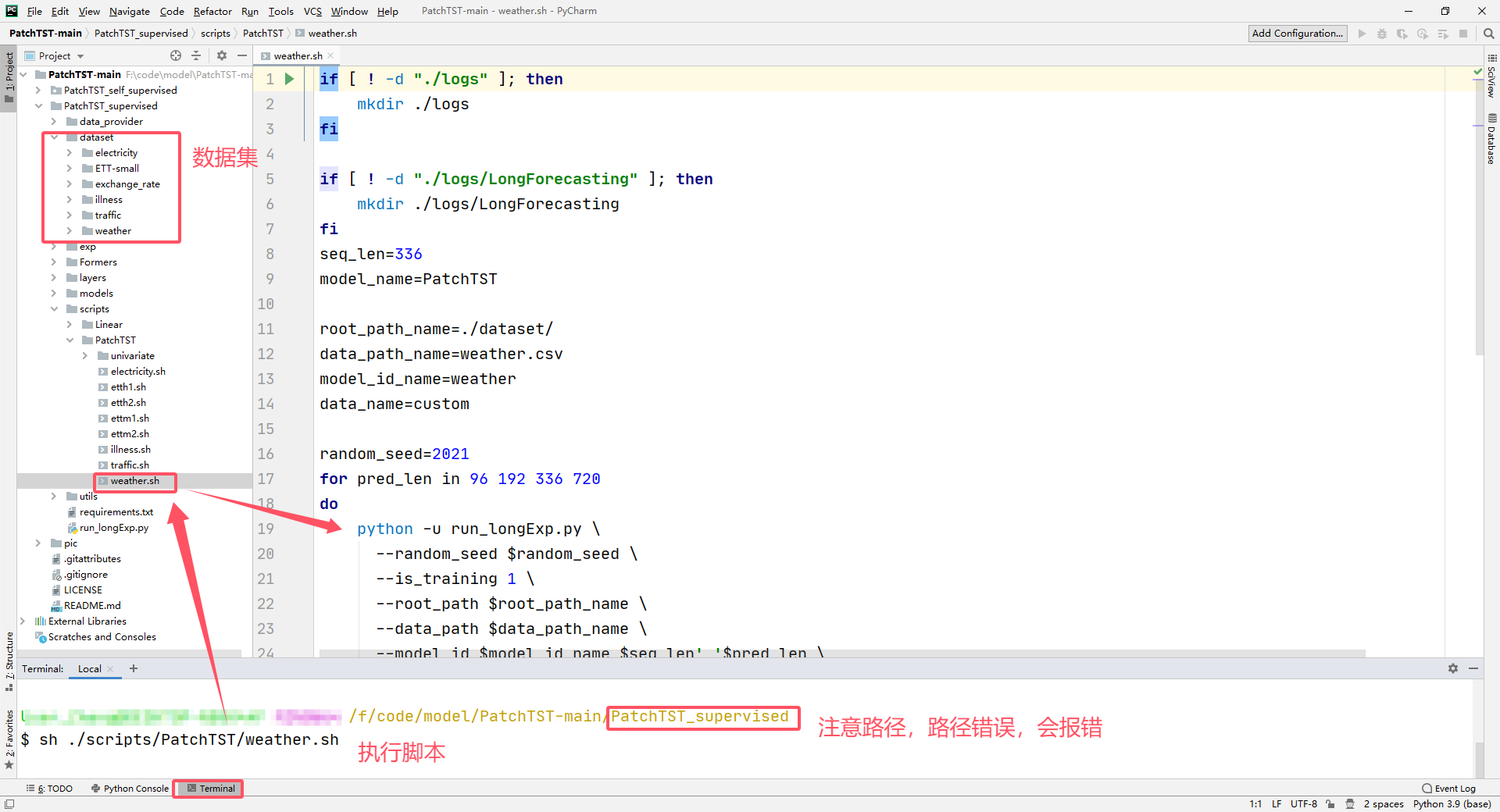

2.1 PatchTST部署

接下来先下载PatchTST代码,如果文献作者公开模型,会在摘要或者结尾部分给出code地址,或者直接在github搜索文献或者简称。

下载好代码解压,然后在pycharm中打开文件夹

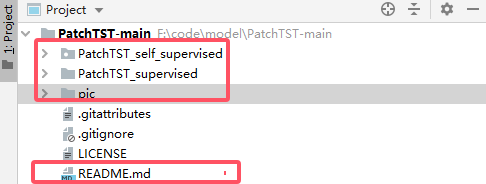

PatchTST_self_supervised和PatchTST_supervised存放的文献中的自监督模型代码和监督模型代码,pic主要是模型图和实验结果数据,README.md是介绍这个模型、取得成就、部署方式、相关信息等等(基本所有公开模型都有这个文件,所以下载代码后可以先看这个文件)。

Note:这里介绍监督学习代码的部署以及讲解,自监督学习留给大家学习。

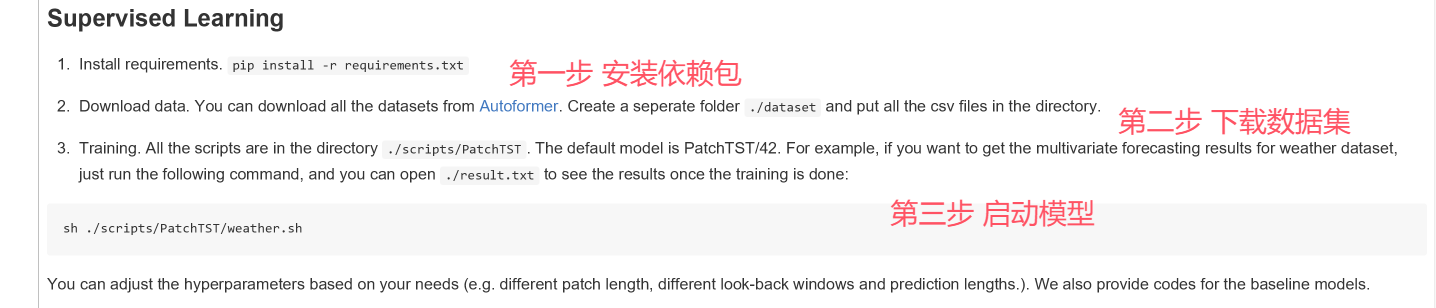

我们看文档中监督学习的启动部分

2.1.1 安装依赖包

文档中给出的安装命令为:

pip install -r requirements.txt

requirements.txt 是项目所需的 Python 包列表,但我们需要根据是否使用 GPU 进行调整:

因为我们已经安装了 GPU 版本的 PyTorch:

-

打开

requirements.txt,删除或注释掉以下这一行:torch==1.11.0删除原因是我们已经安装了 GPU 版本的 torch,如果不删除,执行安装命令时会将原来安装的 torch 降级,并且默认安装的

torch==1.11.0是 CPU 版本,会导致 GPU 加速失效。 -

然后使用以下命令安装其余依赖包:

conda install --yes --file requirements.txtconda 会自动解决包之间的依赖冲突,并不会影响你已有的 GPU 版本 torch。

如果你的电脑显卡是集成显卡或不使用 GPU:

直接运行以下命令安装所有依赖包即可:

pip install -r requirements.txt

此时默认安装的就是 CPU 版本的 torch,适用于 CPU 运行模型。

如果你还没有安装 torch,并且需要使用 GPU,请看上面的PyTorch下载及安装

2.1.2 下载数据集

数据集下载:Autoformer

数据集:

| Dataset | Features | Interval | Samples Numbers | Time |

|---|---|---|---|---|

| ETTh1 and ETTh2 | 7 | 1 h | 17,420 | July 2016 to July 2018 |

| ETTm1 and ETTm2 | 7 | 5 min | 69,680 | July 2016 to July 2018 |

| Electricity | 321 | 1 h | 26,304 | 2012 to 2014 |

| Exchange_rate | 8 | 1 day | 7,588 | January 1990 to October 2010 |

| Traffic | 862 | 1 h | 17,544 | 2015-2016 |

| Illness | 7 | 1 week | 966 | 2002 to 2021 |

2.1.3 启动模型

在 Linux 环境下,用户通常可以直接通过运行如下命令执行 Shell 脚本文件(.sh):

sh ./scripts/PatchTST/weather.sh

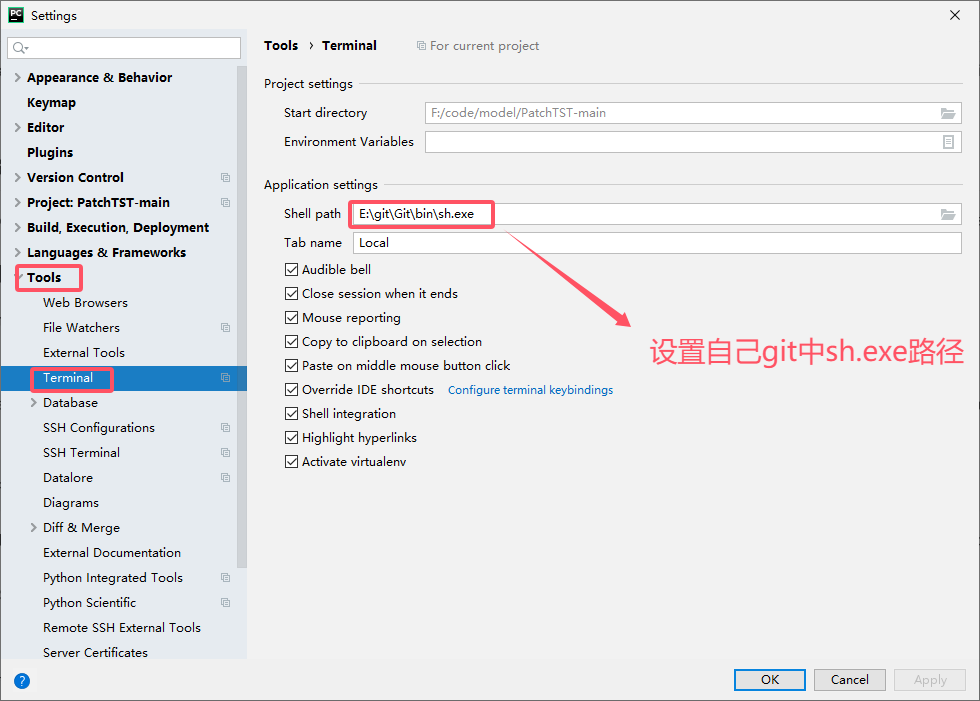

这种 .sh文件是 Linux 系统中常见的 Shell 脚本文件,用于自动化执行一系列命令。然而,在 Windows 系统中是无法直接运行该类脚本的。为了在 Windows 下执行 .sh 文件,我们可以借助 Git for Windows 提供的 Bash 终端来实现。

第一步 安装 Git for Windows

- 访问 Git 官网 https://git-scm.com/,下载安装包并按照默认设置完成安装;

- 安装完成后,系统中会集成 Git Bash,它是一个模拟 Linux Shell 的终端工具,支持运行

.sh脚本; - 安装路径中通常会包含一个可执行文件

sh.exe,后续可在 PyCharm 中配置使用。

第二步 在 PyCharm 中配置 Git Bash 运行 .sh 文件

我们需要在 PyCharm 中运行 .sh脚本,进行如下配置:

- 打开 PyCharm,进入 Settings(设置) > Tools > Terminal;

- 在 Shell path 中将默认的 cmd 替换为 Git Bash 的路径,例如:

E:\git\Git\bin\sh.exe

-

保存设置后,就可以在 PyCharm 的终端中直接运行

sh ./scripts/PatchTST/weather.sh命令,方式与 Linux 下基本一致。

2.2 目录文件说明

| 文件/目录名 | 功能说明 |

|---|---|

checkpoints/ |

用于保存模型训练过程中的权重文件(如 best_model.pth) |

data_provider/ |

包含数据读取、划分、标准化等数据预处理逻辑 |

dataset/ |

存放原始数据或数据格式处理类 |

exp/ |

实验配置类(如参数设定、训练器入口) |

Formers/ |

实现如 PatchTST 模型的核心 Transformer 模块 |

layers/ |

模型的构建模块(如 MLP、LayerNorm、Embedding 等) |

logs/ |

存储训练过程的控制台输出、时间日志等 |

models/ |

包含各种模型结构的定义(例如 PatchTST、Informer、Transformer等) |

results/ |

保存验证集/测试集上的预测输出和评估结果 |

scripts/ |

存储用于批量执行训练或测试的脚本(如 .sh 文件) |

test_results/ |

用于记录模型在测试集上的输出数据(如预测结果、可视化图等) |

utils/ |

工具函数,包括早停机制、学习率调度器、时间处理等 |

requirements.txt |

列出项目依赖的 Python 库(建议使用 pip install -r requirements.txt) |

result.txt |

用于保存每次实验运行后的输出摘要信息 |

run_longExp.py |

运行多个配置实验的入口脚本(命令行参数自动加载配置) |

每天进步一点点,日积月累,终将成就非凡!加油!

Note:求个三连!!!

DAMO开发者矩阵,由阿里巴巴达摩院和中国互联网协会联合发起,致力于探讨最前沿的技术趋势与应用成果,搭建高质量的交流与分享平台,推动技术创新与产业应用链接,围绕“人工智能与新型计算”构建开放共享的开发者生态。

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)