人工智能发展历史摘要-简单易懂版

这篇文章是我在学AI过程中的一些笔记和心得,希望能和同样在学习AI的朋友们分享。由于我的知识有限,文章中可能存在错误或不准确的地方,欢迎大家在评论区提出建议和指正。同时,我也会在文章中注明参考的资料,以示对原作者的尊重。后续会 持续更新相关资源的~--L1正则化(Lasso回归)会让不重要的特征权重变成0,删掉无关的因素,最终使模型更简单、更容易解释。假设你在整理房间,L1正则化就像是“断舍离”,

Foreword写在前面的话:

大家好,我是一名刚开始学习AI以及其算法的新手。这篇文章是我在学AI过程中的一些笔记和心得,希望能和同样在学习AI的朋友们分享。由于我的知识有限,文章中可能存在错误或不准确的地方,欢迎大家在评论区提出建议和指正。我非常期待大家的反馈,以便我能不断学习和进步。同时,我也会在文章中注明参考的资料,以示对原作者的尊重。

PS:本帖以记录学习心得和笔记为主,没有其他大博主那么专业,但是简单易懂^-^

本贴的其他相关学习笔记资料可以通过订阅专栏获取,喜欢的小伙伴可以多多点赞+关注呀!后续会 持续更新相关资源的~

- 人工智能有三个要素:数据、算力及算法

- AI定义:一个经典的AI定义是:“ 智能主体可以理解数据及从中学习,并利用知识实现特定目标和任务的能力。(A system’s ability to correctly interpret external data, to learn from such data, and to use those learnings to achieve specific goals and tasks through flexible adaptation)”

- 人工智能学派:

- 联结主义(也成为仿生学派):基于大数据背景下的机器学习,需要大量数据集来训练算法(连接主义的核心观点是,神经元之间的连接权重可以通过学习和训练进行调整,从而实现对复杂模式的识别和处理。);

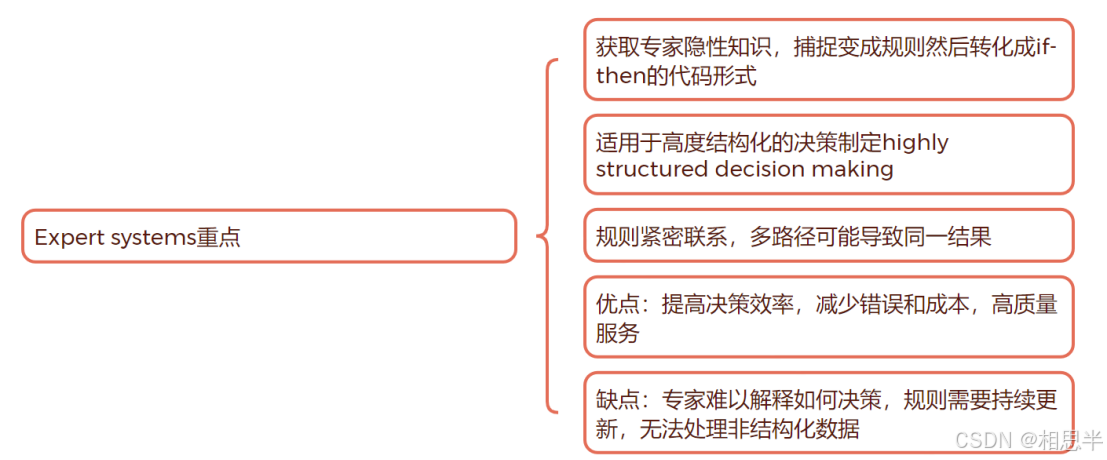

- 符号主义:基于逻辑规则推导答案的人工智能(比如专家系统适用于结构化决策,based on If-then rules,将专家隐性知识引入系统提升决策效率,但是需要持续更新规则以及不适用于半结构化决策)/决策树:处理非线性数据,分类问题;

演化主义:GA算法genetic algorithm, 模仿物种自然选择的过程优化问题解决方案;

贝叶斯主义:偏向于概率统计应用,如logistic回归适用于处理线性大数据集的解释预测;

行为主义:鼓励试错和不断优化策略,类似于监督学习supervised learning 但不完全相同;

连结主义学派-人工神经网络

卷积神经网络(CNN, Convolutional Neural Network)

循环神经网络(RNN, Recurrent Neural Network)

反向传播算法(Backpropagation,简称BP) 是训练人工神经网络(ANN)最重要的优化算法之一。它是一种基于梯度下降法的技术,用于计算神经网络权重的梯度,并通过最小化误差来优化网络性能。 反向传播的引入极大地推动了深度学习的发展,使得复杂的多层神经网络得以高效训练。--可用于金融分析(风险预测、信用评分)

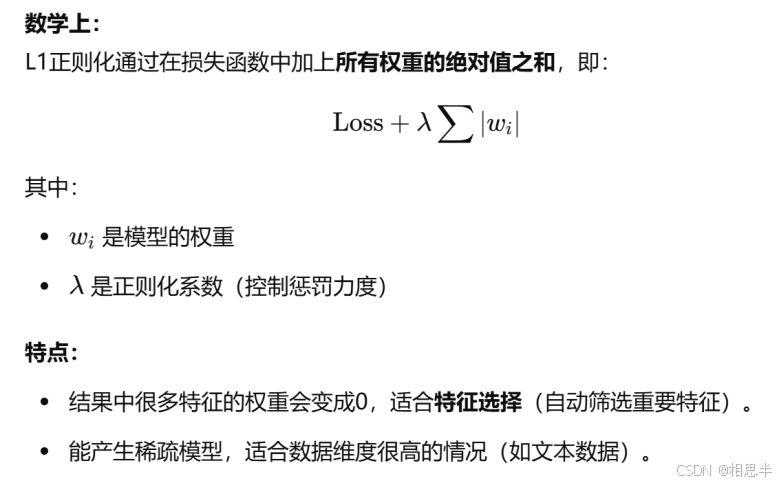

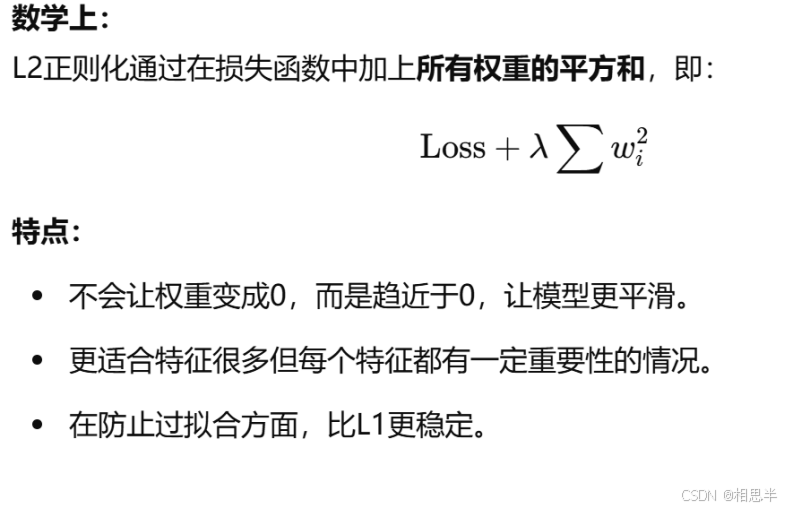

--反向传播算法-目标:最小化损失函数,在网络中不断调整权重(运用梯度下降算法思想gradient descent)最终找到最优解。为了防止过拟合,可以适用L1/L2正则化技术

--L1正则化(Lasso回归)会让不重要的特征权重变成0,删掉无关的因素,最终使模型更简单、更容易解释。--即:把握重要特征

类比:

假设你在整理房间,L1正则化就像是“断舍离”,只保留最重要的东西,扔掉用不到的杂物。

L2正则化(Ridge回归)——让模型“更稳定”--不是直接丢掉某些特征,而是把不重要的特征影响力弱化

脉络:反向传播算法backpropagation--梯度下降算法--L1/L2正则化优化算法权重特征值的处理

人工智能产业未来发展趋势分析:

AI三要素:数据算力算法

Moore's Law 是由英特尔的创始人之一 Gordon Moore 在 1965 年提出的观察法则,内容是集成电路上的晶体管数量每两年会翻一倍-即算力发展速度会 越来越快,从而使得计算能力不断提高,同时成本不断降低。这个规律的背后是半导体技术的进步,尤其是在芯片制造工艺上。

Mass digital storage law 大规模数据存储成本会随时间而降低

量子计算,边缘计算,并行计算

学派融合

最后,感谢每一位阅读这篇文章的朋友,你们的反馈对我来说非常宝贵。如果有任何问题或建议,请随时告诉我。让我们一起学习和进步吧!如果您喜欢我的内容,别忘了点赞和关注哦,我会定期分享更多有价值的信息。

DAMO开发者矩阵,由阿里巴巴达摩院和中国互联网协会联合发起,致力于探讨最前沿的技术趋势与应用成果,搭建高质量的交流与分享平台,推动技术创新与产业应用链接,围绕“人工智能与新型计算”构建开放共享的开发者生态。

更多推荐

已为社区贡献2条内容

已为社区贡献2条内容

所有评论(0)