多传感器数据融合的实现

多传感器输入:从不同类型的传感器(如摄像头、LiDAR、温度传感器等)收集原始数据,确保覆盖多维信息。数据标准化:通过归一化处理消除量纲差异,例如将振动、声学等信号统一到相同尺度。异常值处理:去除噪声或无效数据,例如使用滤波算法或统计方法(如标准差分析)。特征提取:对每个传感器的数据提取关键特征,如信号频域特征(振动传感器)或图像中的边缘特征(摄像头)。时空对齐:通过时间同步和空间注册(如自适应距

多传感器数据融合的实现需要系统化的流程和多种技术策略的结合,具体步骤如下:

1. 数据采集与预处理

多传感器输入:从不同类型的传感器(如摄像头、LiDAR、温度传感器等)收集原始数据,确保覆盖多维信息。

数据标准化:通过归一化处理消除量纲差异,例如将振动、声学等信号统一到相同尺度

。

异常值处理:去除噪声或无效数据,例如使用滤波算法或统计方法(如标准差分析)

。

2. 特征提取与数据对齐

特征提取:对每个传感器的数据提取关键特征,如信号频域特征(振动传感器)或图像中的边缘特征(摄像头)

。

时空对齐:通过时间同步和空间注册(如自适应距离函数ADF)确保不同传感器的数据在同一参考框架下

。

例如,热成像数据需与RGB相机的点云空间配准

。

3. 融合策略选择

数据级融合:直接合并原始数据(早期融合),适用于传感器类型相似的情况。例如,将多个摄像头的图像拼接

。

特征级融合:提取特征后进行整合。

提到各传感器特征分别训练模型,再融合预测分数;

(b)则将所有特征合并后输入单一模型

。

决策级融合:各传感器独立决策后合并结果。例如,

©中每个传感器的决策通过投票或加权整合

。

4. 融合算法实现

加权融合:根据传感器可靠性分配权重。

通过计算标准差动态调整权重,

使用信息池化加权合并

。

模型驱动融合:利用机器学习模型整合数据。例如,

中的神经网络处理融合特征,

结合CNN进行图像与文本数据融合

。

分布式与集中式融合:分布式架构(如

的局部滤波器+融合中心)适合大规模系统;集中式(如

的中央节点)适合实时性要求高的场景

。

5. 结果优化与应用

鲁棒性增强:通过重叠区域融合

或多模态验证(如热成像与激光雷达互补)提高精度

。

可视化与决策支持:生成站点模型或3D点云地图,用于导航、障碍检测等任务

。

例如,

的系统输出障碍物距离和定位信息

。

6. 评估与反馈

性能测试:对比融合结果与地面实况数据,进行定性与定量分析(如

的聚类地图验证)

。

动态调整:根据环境变化(如雨雾条件)更新融合策略,例如

中结合温度阈值调整感知模型

。

典型应用场景

自动驾驶:融合LiDAR、摄像头和GPS数据实现环境感知

。

工业检测:振动与温度传感器融合诊断设备故障

。

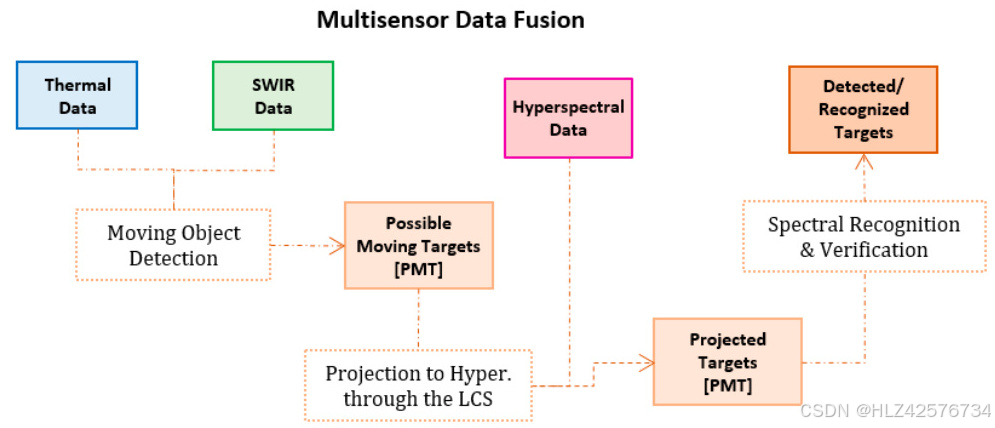

安防监控:热成像与SWIR数据结合检测移动目标

。

综上,多传感器数据融合需综合考虑传感器特性、融合层次(数据/特征/决策)及算法选择,通过标准化、对齐、加权和模型整合提升系统性能,最终服务于高精度感知与智能决策

。

♯ 如何在多传感器数据融合中实现高效的时空对齐?

在多传感器数据融合中实现高效的时空对齐是一个复杂且多方面的任务,涉及时间同步、空间校准以及数据处理等多个环节。以下是基于我搜索到的资料,对如何实现高效时空对齐的详细分析:

1. 时间同步与插值

时间同步是实现时空对齐的基础。例如,在激光雷达与相机的融合中,通过时间戳插值同步IMU(惯性测量单元)和相机的时间戳,可以将激光雷达点云数据帧与相机图像帧对齐。这种方法利用了IMU的时间信息,通过公式计算出相机帧对应的IMU时间戳,从而实现时间上的精确对齐

。此外,对于多光谱相机和光谱仪的融合,可以通过获取毫秒级的时间戳和操作系统提供的实际时间标签来优化时间对齐

。

2. 空间校准与配准

空间校准是确保不同传感器数据在空间上一致的关键步骤。例如,在多光谱相机和光谱仪的融合中,通过图像-光谱仪数据对齐算法,将光谱仪的时间线按比例移动以匹配图像数据的空间位置,从而实现空间上的对齐

。此外,对于多传感器系统,可以通过设计全局和局部传感器级别的内特征对齐方法来减少不同域之间的差异

。

3. 深度学习与模型优化

深度学习技术在时空对齐中发挥了重要作用。例如,一种基于深度学习的多传感器融合系统通过编码器-解码器架构和“FreeAlign”方法实现了高效的时空对齐

。这种方法能够有效消除由于传感器误差或环境变化导致的位置偏差问题,从而提高目标检测和跟踪的准确性。

4. 多传感器数据融合算法

多传感器数据融合算法在时空对齐中也起到了关键作用。例如,一种贝叶斯数据融合方法通过结合不同传感器的时间、分辨率和波段差异,生成高空间和时间分辨率的图像

。此外,多传感器图像融合技术通过结合不同图像的信息,提高了遥感领域的目标识别和分类能力

。

5. 动态环境下的实时对齐

在动态环境中,实时对齐尤为重要。例如,在城市3D建模中,通过多个相机和LiDAR设备在不同时间点收集数据,并将这些数据发送到中央处理器进行融合,可以实现多传感器数据的实时对齐

。这种方法不仅提高了数据的精度和可靠性,还能够在多个时间点上同步收集信息。

6. 序列对齐与时空相关性

对于涉及序列数据的多传感器融合,可以通过最大化两个序列之间的局部时空相关性来实现对齐。例如,一种统一的序列对齐方法能够同时处理不同场景和动作序列,并通过最大化时空强度信息来实现精确对齐

。

7. 误差估计与补偿

在多传感器注册中,误差估计和补偿是提高对齐精度的重要手段。例如,通过估计传感器偏差并进行补偿,可以减少不同传感器之间的误差

。

结论

实现高效的时空对齐需要综合考虑时间同步、空间校准、深度学习优化、多传感器融合算法以及动态环境下的实时处理等多个方面。

♯ 多传感器数据融合中的特征提取技术有哪些最新进展?

多传感器数据融合中的特征提取技术近年来取得了显著进展,主要体现在以下几个方面:

- 特征级融合技术的创新

特征级融合是多传感器数据融合的重要方法之一,其核心在于从不同传感器中提取特征并进行整合。最新的研究主要集中在以下几方面:

特征聚合(Feature Aggregation) :通过将来自所有传感器的特征向量拼接,形成一个统一的特征向量,用于训练单一的分类模型。这种方法可以结合主成分分析(PCA)等降维技术,以减少特征维度并提高计算效率

。

时间融合(Temporal Fusion) :利用卷积神经网络(CNN)和长短时记忆网络(LSTM)从原始数据中自动提取特征,并进行时间上的融合。这种方法特别适用于需要捕捉时间序列信息的场景

。

特征组合技术(Feature Combination, FC) :选择一组特征并组合起来,以实现神经网络的最佳性能。FC方法通过夹紧技术评估特征对网络性能的影响,从而选择最优特征组合

。

2. 深度学习在特征提取中的应用

深度学习技术在多传感器数据融合中的特征提取中发挥了重要作用:

深度神经网络(DNN) :用于从传感器数据中提取复杂特征。例如,在工业制造中,DNN被用于从振动、接近、温度等传感器数据中提取特征,并结合傅里叶变换提取频率特征

。

卷积神经网络(CNN)和长短时记忆网络(LSTM) :这些网络能够从原始数据中自动提取特征,并在时间序列分析中表现出色

。

Transformer模型:近年来,Transformer模型也被引入到多传感器数据融合中,用于处理高维度和非线性特征提取任务。

3. 多模态数据融合与跨域特征提取

多模态数据融合涉及不同类型的传感器数据(如雷达、摄像头、激光雷达等),其目标是通过跨域特征提取提高系统的鲁棒性和准确性:

雷达与摄像头数据融合:通过迭代更新雷达和摄像头信息,以及利用高度扩展和不确定性方法,显著提高了目标检测的准确性

。

雷达通道扩展与双分支CBAM(Convolutional Block Attention Module) :这种技术通过扩展雷达通道并结合注意力机制,进一步提升了雷达数据与图像数据之间的对齐效果

。

4. 特征选择与优化

特征选择是优化多传感器数据融合系统性能的关键步骤:

基于模糊推理系统的特征选择:例如,在涡扇发动机故障检测中,通过模糊推理系统结合特征选择和概率密度函数,实现了对涡扇发动机健康参数的准确预测

。

基于贝叶斯网络的特征选择:这种方法需要精确的概率条件知识,但能够提供更可靠的诊断结果

。

5. 实时性与高效性

为了满足实时应用的需求,多传感器数据融合中的特征提取技术也在不断优化:

快速特征提取算法:例如,在振动监测中,通过统计分析和傅里叶变换快速提取特征,用于故障检测

。

基于自相关系数的权重计算:这种方法通过计算不同传感器信号之间的相关性,为每个传感器分配权重,从而提高系统的实时性和准确性

。

6. 跨领域的应用

多传感器数据融合中的特征提取技术已广泛应用于多个领域:

智能制造:在工业制造中,通过深度学习和特征级融合技术,对振动、温度等传感器数据进行分析,以预测设备故障和评估工作状况

。

医疗诊断:在医学诊断中,通过结合多种传感器数据(如压力、位置等),实现对健康状态的实时监测

。

自动驾驶:在自动驾驶中,通过雷达、摄像头和激光雷达的融合,提高目标检测的准确性和鲁棒性

。

结论

多传感器数据融合中的特征提取技术正朝着深度学习、跨域融合、实时性和高效性方向发展。

♯ 在多传感器数据融合中,哪些加权融合算法表现最佳?

在多传感器数据融合中,表现最佳的加权融合算法主要包括以下几种:

基于偏差估计的多传感器自适应加权数据融合算法

该算法通过引入偏差估计方法,优化了加权因子的选择,避免了因偏差估计不足导致的最优加权因子损失。实验结果表明,该算法在准确性、稳定性和抗噪声能力方面表现优异,尤其是在处理非线性系统时,相比传统算法具有显著优势

。

多传感器自适应加权融合算法(基于三态转换模型)

该算法结合了三态转换模型和误差协方差估计改进公式,能够动态调整加权因子,适应传感器故障或干扰情况。通过积分衰减因子和最小二乘外推,该算法能够有效处理传感器数据的不确定性,并在闭环模式下实现稳定自主跟踪

。

加权平均方法

加权平均方法是一种经典的多传感器数据融合策略,通过计算权重概率的总和做出最终决策。这种方法在多个研究中被广泛应用,尤其是在需要快速响应和实时处理的场景中表现出色

。

基于线性意见池(LOP)的加权融合方法

该方法通过增加权重池中的权重来优先处理高可靠性的数据源,从而简化了参数化过程并提高了融合效率。这种方法特别适用于需要快速处理和规则化操作的场景

。

基于模糊聚类的混合多传感器数据融合方法

该方法通过模糊聚类技术对不同传感器的数据进行分类和加权,解决了传统方法在噪声和密度不同数据上的局限性。这种方法在处理复杂环境下的多传感器数据时表现良好

。

基于改进卡尔曼滤波器的多传感器数据融合方法

该方法结合了自适应模糊卡尔曼滤波器和无迹卡尔曼滤波器,能够有效处理非线性系统的数据融合问题。实验结果表明,该方法在INS/GNSS/CNS集成导航系统中表现优异

。

基于量子遗传算法的多通道数据融合方法

该方法通过量子遗传算法优化加权因子,能够高效处理来自多个传感器的数据,并生成综合结果。这种方法在处理复杂信号时具有较高的精度和效率

。

基于支持向量机和聚类方法的多传感器数据融合

这些方法通过支持向量机和聚类技术对传感器数据进行分类和加权,能够有效处理高分辨率和多模态数据。这些方法在遥感图像处理等领域表现出色

。

表现最佳的加权融合算法主要集中在基于偏差估计、自适应调整、模糊聚类和量子遗传算法等技术的算法上。

♯ 如何评估多传感器数据融合系统的性能和鲁棒性?

评估多传感器数据融合系统的性能和鲁棒性是一个复杂的过程,需要从多个方面进行综合考量。以下是基于我搜索到的资料,对如何评估多传感器数据融合系统性能和鲁棒性的详细分析:

- 性能评估

性能评估主要关注系统在不同任务中的表现,包括精度、速度和效率等指标。

1.1 精度评估

定位与建图(SLAM) :LVI-Fusion系统通过激光雷达、视觉和惯性传感器的融合,实现了高精度的定位与建图。该系统通过时间对齐模块解决异构传感器数据时间不一致的问题,并利用滑动窗口优化模块结合多种约束条件(如激光雷达因子、IMU预积分约束和视觉因子约束),生成误差方程进行处理,从而提高了系统的精度

。

视觉-惯性里程计(VIO) :基于扩展卡尔曼滤波器(EKF)的视觉辅助惯性导航系统能够实现高精度的姿态估计,其计算复杂度线性增长,适用于大规模实时场景。

地面车辆定位:LeGO-LOAM方法通过点云分割、特征提取和Levenberg-Marquardt优化算法,实现了轻量级的实时六自由度姿态估计,并在变地形环境中表现出较好的精度。

1.2 速度与效率

稀疏卷积方法:在处理LiDAR数据时,改进的稀疏卷积方法显著提高了训练和推理速度,同时保持了较高的检测精度。

实时性:LVI-Fusion系统通过滑动窗口优化模块和误差方程处理,实现了高效的实时性能

。

1.3 多传感器融合效果

多传感器融合系统通常通过不同的传感器输入(如激光雷达、摄像头、IMU等)进行数据预处理、特征提取和模型训练。例如,某系统通过特征融合的方式,将不同传感器的数据整合到单一模型中进行训练和预测

。

在能量收集器(EHCs)和参数不确定性的情况下,研究提出了一种鲁棒分布式融合滤波方法,通过引入能量收集机制和考虑参数不确定性,实现了期望的融合估计误差

。

2. 鲁棒性评估

鲁棒性评估主要关注系统在面对噪声、干扰或异常情况时的表现。

2.1 抗干扰能力

抗语义攻击:COMMIT框架通过创建多样化的数据集(包括旋转变位和尺度变换),评估了多传感器融合系统在面对语义攻击时的鲁棒性。实验表明,该框架能够有效检测和抑制攻击

。

NLOS检测与抑制:在UWB(超宽带)信号的处理中,ARIMA-GARCH模型被用于检测和抑制非视距(NLOS)信号,从而提高了系统的鲁棒性

。

2.2 异常值处理

点云数据处理:LeGO-LOAM方法通过点云分割和特征提取,有效过滤噪声并提取关键边缘特征,从而提高了系统的鲁棒性。

视觉-惯性里程计:通过非线性优化方法,结合地标和惯性术语的重投影误差,实现了对异常值的鲁棒处理。

2.3 多传感器协同工作

多传感器融合系统通常需要在不同传感器之间进行数据对齐和误差校正。例如,LVI-Fusion系统通过时间对齐模块解决了异构传感器数据时间不一致的问题

。

在能量收集器和参数不确定性的情况下,提出的鲁棒分布式融合滤波方法通过优化滤波增益矩阵,实现了对异常情况的鲁棒处理

。

3. 综合评估方法

为了全面评估多传感器数据融合系统的性能和鲁棒性,可以采用以下方法:

基准测试:使用标准化的数据集(如COMMIT框架中的数据集)进行基准测试,评估系统在不同任务中的表现

。

多场景测试:在多种环境条件下(如室内、室外、变地形等)进行测试,评估系统的泛化能力和鲁棒性

。

异常情况模拟:通过引入噪声、干扰或异常值,模拟实际应用中的复杂场景,评估系统的抗干扰能力和异常值处理能力

。

理论分析与仿真验证:结合数学模型和数值仿真,验证系统的理论性能和鲁棒性

。

结论

多传感器数据融合系统的性能和鲁棒性评估需要从精度、速度、效率以及抗干扰能力等多个方面进行综合考量。

♯ 多传感器数据融合在自动驾驶领域的应用案例有哪些?

多传感器数据融合在自动驾驶领域的应用案例主要集中在以下几个方面:

感知任务的多模态数据处理

在自动驾驶系统中,多传感器数据融合技术被广泛应用于感知任务。例如,通过结合相机图像和LiDAR点云数据,可以实现对周围环境的全面感知。具体来说,相机图像可以提供丰富的视觉信息,而LiDAR点云则能够提供精确的距离和深度信息。这种融合技术能够生成高精度的2D和3D物体检测结果,并进一步进行实例分割和语义分割,从而帮助自动驾驶系统更好地理解环境并做出安全决策

。

多视角3D目标检测

多视角3D目标检测网络(MV3D)是一种基于多传感器数据融合的框架,它结合了LiDAR点云和RGB图像作为输入,预测3D边界框。该方法通过编码稀疏点云并使用多视角表示,能够高效生成3D候选框,并通过深度融合方案结合区域特征,显著提高了3D定位和检测的准确性

。

近场目标检测

在近场目标检测中,多传感器数据融合技术通过结合摄像头、雷达和激光雷达的数据,提取深度、大小和旋转信息。例如,使用最近邻原则对图像和点云数据进行匹配,并通过动态链接学习机制提高感知系统的性能。这种方法能够显著提升自动驾驶车辆在复杂环境中的感知能力

。

交通监控与车辆检测

多传感器数据融合技术在交通监控和车辆检测中也发挥了重要作用。例如,通过结合雷达、激光雷达和视觉传感器的数据,可以实现对多目标的跟踪和环境重建。此外,基于雷达和视觉传感器的融合技术还能够提高交通标志识别、实时交通灯检测以及行人和车辆检测的准确性

。

自动驾驶场景下的多传感器配置与数据处理

在自动驾驶场景中,车辆通常搭载多种传感器,如摄像头、雷达、激光雷达和IMU等。这些传感器的数据经过融合处理后,可以生成一个综合的三维空间表示,从而帮助自动驾驶系统更好地理解周围环境并做出决策

。

多传感器融合策略的应用

多传感器融合技术在自动驾驶中的应用还包括多目标跟踪、环境重建、障碍物检测等。例如,通过建立运动模型和数据关联,可以实现对多个目标的精确跟踪;通过结合雷达、激光雷达和视觉传感器的数据,可以提高障碍物检测的鲁棒性和准确性。

多模态数据集的开发

为了支持多传感器数据融合技术的发展,一些研究团队开发了包含多种传感器数据的多模态数据集。例如,nuScenes数据集包含了摄像头、雷达和激光雷达的数据,并提供了详细的标注信息,为自动驾驶领域的研究提供了重要的资源

。

多传感器数据融合技术在自动驾驶领域的应用案例涵盖了感知任务、目标检测、交通监控、环境重建等多个方面。

参考文献

- PDFR. Collins, A. Lipton et al. “Algorithms for cooperative multisensor surveillance.” Proc. IEEE(2001)… ROBERT T. COLLINS, ALAN J. LIPTON, HIRONOBU FUJI.

- PDFXiang Cheng, Haotian Zhang et al. “Intelligent Multi-Modal Sensing-Communication Integration: Synesthesia of Machines.” IEEE Communications Surveys & Tutorials(2023)… Xiang Cheng, Haotian Zhang, Jianan Zhang, Shijian Gao, Sijiang Li, Ziwei Huang, Lu Bai, Zonghui Yang, Xinhu Zheng, Liuqing Yang.

- PDFS. Gawde, S. Patil et al. “Multi-Fault Diagnosis Of Industrial Rotating Machines Using Data-Driven Approach: A Review Of Two Decades Of Research.” ArXiv(2022)… Shreyas Gawde, Shruti Patil, Satish Kumar, Pooja Kamat, Ketan Kotecha, Ajith Abraham.

- PDFJ. P. Queralta, Jussi Taipalmaa et al. “Collaborative Multi-Robot Systems for Search and Rescue: Coordination and Perception.” ArXiv(2020)… Jorge Peña Queralta, Jussi Taipalmaa, Bilge Can Pullinen, Victor Kathan Sarker, Tuan Nguyen Gia, Hannu Tenhunen, Moncef Gabbouj, Jenni Raitoharju, Tomi Westerlund.

- PDFPanagiotis Tsinganos, A. Skodras. “On the Comparison of Wearable Sensor Data Fusion to a Single Sensor Machine Learning Technique in Fall Detection.” Sensors (Basel, Switzerland)(2018).

- PDFAlexey Zhukov, Alain Rivero et al. “A Hybrid System for Defect Detection on Rail Lines through the Fusion of Object and Context Information.” Sensors (Basel, Switzerland)(2024).

- PDFG. Psuj. “Utilization of Multisensor Data Fusion for Magnetic Nondestructive Evaluation of Defects in Steel Elements under Various Operation Strategies.” Sensors (Basel, Switzerland)(2018).

- PDFP. Theodorou, K. Tsiligkos et al. “Multi-Sensor Data Fusion Solutions for Blind and Visually Impaired: Research and Commercial Navigation Applications for Indoor and Outdoor Spaces.” Sensors (Basel, Switzerland)(2023).

- PDFJi Ding, Qiang Liu et al. “A Multisensor Data Fusion Method Based on Gaussian Process Model for Precision Measurement of Complex Surfaces.” Sensors (Basel, Switzerland)(2020).

- PDFH. Ignatious, Hesham El-Sayed et al. “Multilevel Data and Decision Fusion Using Heterogeneous Sensory Data for Autonomous Vehicles.” Remote. Sens.(2023).

- PDFJuan Liu, Yang Luo et al. “An Intelligent Online Drunk Driving Detection System Based on Multi-Sensor Fusion Technology.” Sensors (Basel, Switzerland)(2022).

- PDFSabita Panicker, A. Gostar et al. “Recent Advances in Stochastic Sensor Control for Multi-Object Tracking.” Sensors (Basel, Switzerland)(2019)… Sabita Panicke.

- PDFV. Vidal, L. Honório et al. “Sensors Fusion and Multidimensional Point Cloud Analysis for Electrical Power System Inspection.” Sensors (Basel, Switzerland)(2020).

- PDFJ. Núñez, M. Araújo et al. “Real-Time Telemetry System for Monitoring Motion of Ships Based on Inertial Sensors.” Sensors (Basel, Switzerland)(2017).

- PDFKasra Rafiezadeh Shahi, Pedram Ghamisi et al. “Data Fusion Using a Multi-Sensor Sparse-Based Clustering Algorithm.” Remote. Sens.(2020)… Kasra Rafie.

- PDFZ. Kandylakis, Konstantinos Vasili et al. “Fusing Multimodal Video Data for Detecting Moving Objects/Targets in Challenging Indoor and Outdoor Scenes.” Remote. Sens.(2019).

- PDFZhen-tao Hu, Tianxiang Chen et al. “Observable Degree Analysis for Multi-Sensor Fusion System.” Sensors (Basel, Switzerland)(2018)… Zhentao Hu, Tianxiang C.

- PDFIdongesit Ekerete, Matias Garcia-Constantino et al. “Data Mining and Fusion Framework for In-Home Monitoring Applications.” Sensors (Basel, Switzerland)(2023)… Idongesit Ekerete.

- PDFB. Hahn. “Research and Conceptual Design of Sensor Fusion for Object Detection in Dense Smoke Environments.” Applied Sciences(2022).

- PDFDaniel Fernando Quintero Bernal, J. Kern et al. “A Multimodal Fusion System for Object Identification in Point Clouds with Density and Coverage Differences.” Processes(2024).

- PDFZixing Lei, Zhenyang Ni et al. “Robust Collaborative Perception without External Localization and Clock Devices.” ArXiv(2024)… Zixing Lei, Zhenyang Ni, Ruize Han, Shuo Tang, Dingju Wang, Chen Feng, Siheng Chen, Yanfeng Wang.

- PDFWenqiang Pu, Ya-Feng Liu et al. “Optimal Estimation of Sensor Biases for Asynchronous Multi-Sensor Registration.” ArXiv(2017)… Wenqiang Pu, Ya-Feng Liu, Junkun Yan, Hongwei Liu, Zhi-Quan Luo.

- PDFJiang Dong, D. Zhuang et al. “Advances in Multi-Sensor Data Fusion: Algorithms and Applications.” Sensors (Basel, Switzerland)(2009).

- PDFK. Choi, Changjae Kim. “A Framework of Wearable Sensor-System Development for Urban 3D Modeling.” Applied Sciences(2022)… Kanghyeok Choi.

- PDFYaron Ukrainitz, M. Irani. “Aligning Sequences and Actions by Maximizing Space-Time Correlations.” European Conference on Computer Vision(2006)… Yaron Ukrainitz and Michal Iran.

- 王耀南,李树涛.多传感器信息融合及其应用综述[J].控制与决策,2001.

- PDFYucheng Wang, Yuecong Xu et al. “SEnsor Alignment for Multivariate Time-Series Unsupervised Domain Adaptation.” AAAI Conference on Artificial Intelligence(2023)… Yucheng Wang, Yuecong.

- PDFZhenbin Liu, Zengke Li et al. “LVI-Fusion: A Robust Lidar-Visual-Inertial SLAM Scheme.” Remote. Sens.(2024)… Zhenbin Liu, Zengke Li.

- PDFJie Xue, Y. Leung et al. “A Bayesian Data Fusion Approach to Spatio-Temporal Fusion of Remotely Sensed Images.” Remote. Sens.(2017).

- PDFChuiqing Zeng, D. King et al. “Fusion of Multispectral Imagery and Spectrometer Data in UAV Remote Sensing.” Remote. Sens.(2017).

- PDFVolker Fritzsch, Stefan Scherer et al. “An Open Source Process Engine Framework for Realtime Pattern Recognition and Information Fusion Tasks.” International Conference on Language Resources and Evaluation(2010).

- PDFAntonio A. Aguileta, R. Brena et al. “Multi-Sensor Fusion for Activity Recognition—A Survey.” Sensors (Basel, Switzerland)(2019)… Antonio A. Aguileta, Ramon F. Bren.

- PDFA. Tsanousa, Evangelos Bektsis et al. “A Review of Multisensor Data Fusion Solutions in Smart Manufacturing: Systems and Trends.” Sensors (Basel, Switzerland)(2022)… Athi.

- PDFXiyan Sun, Yaoyu Jiang et al. “Camera-Radar Fusion with Radar Channel Extension and Dual-CBAM-FPN for Object Detection.” Sensors (Basel, Switzerland)(2024).

- PDFShahina Begum, Shaibal Barua et al. “Physiological Sensor Signals Classification for Healthcare Using Sensor Data Fusion and Case-Based Reasoning.” Sensors (Basel, Switzerland)(2014)… MDPI.

- PDFV. Zaccaria, Moksadur Rahman et al. “A Review of Information Fusion Methods for Gas Turbine Diagnostics.” Sustainability(2019)… Valentina Zaccaria, Moks.

- PDFErik Molino-Minero-Re, Antonio A. Aguileta et al. “Improved Accuracy in Predicting the Best Sensor Fusion Architecture for Multiple Domains.” Sensors (Basel, Switzerland)(2021)… Eri.

- PDFXin Qian, Shujuan Wang et al. “Multi Channels Data Fusion Algorithm on Quantum Genetic Algorithm for Sealed Relays.” Journal of Physics: Conference Series(2019).

- PDFBingbing Gao, Gaoge Hu et al. “Multi-Sensor Optimal Data Fusion Based on the Adaptive Fading Unscented Kalman Filter.” Sensors (Basel, Switzerland)(2018).

- PDFMingwei Qiu, Bo Liu. “Multi-Sensor Adaptive Weighted Data Fusion Based on Biased Estimation.” Sensors (Basel, Switzerland)(2024)… Mingwei Qiu.

- PDFZhuang Ye, Jianbo Yu. “Feature Extraction of Gearbox Vibration Signals Based on Multi-Channels Weighted Convolutional Neural Network.” Journal of Mechanical Engineering(2021)… 机械工程学报.

- PDFHao Yin, Dongguang Li et al. “Adaptive Data Fusion Method of Multisensors Based on LSTM-GWFA Hybrid Model for Tracking Dynamic Targets.” Sensors (Basel, Switzerland)(2022).

- PDFPei Shi, Guanghui Li et al. “Data Fusion Using Improved Support Degree Function in Aquaculture Wireless Sensor Networks.” Sensors (Basel, Switzerland)(2018).

- PDFYi Mao, Yi Yang et al. “Research into a Multi-Variate Surveillance Data Fusion Processing Algorithm.” Sensors (Basel, Switzerland)(2019)… Yi Mao, Yi Yang.

- PDFShixue Zhang, Houfeng Wang et al. “A Fusion Tracking Algorithm for Electro-Optical Theodolite Based on the Three-State Transition Model.” Sensors (Basel, Switzerland)(2024).

- PDFJ. L. Patino, Michael Hubner et al. “Fusion of Heterogenous Sensor Data in Border Surveillance.” Sensors (Basel, Switzerland)(2022)… Luis Patino, Michael Hubner.

- PDFHuaikun Gao, Xu Li et al. “A Fusion Strategy for Vehicle Positioning at Intersections Utilizing UWB and Onboard Sensors.” Sensors (Basel, Switzerland)(2024).

- PDFC. Qi, W. Liu et al. “Frustum PointNets for 3D Object Detection from RGB-D Data.” 2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition(2017).

- Yan Yan, Yuxing Mao et al. “SECOND: Sparsely Embedded Convolutional Detection.” Sensors (Basel, Switzerland)(2018).

- Stefan Leutenegger, Simon Lynen et al. “Keyframe-based visual–inertial odometry using nonlinear optimization.” The International Journal of Robotics Research(2015).

- Tixiao Shan, Brendan Englot. “LeGO-LOAM: Lightweight and Ground-Optimized Lidar Odometry and Mapping on Variable Terrain.” 2018 IEEE/RSJ International Conference on Intelligent Robots and Systems (IROS)(2018).

- Anastasios I. Mourikis, S. Roumeliotis. “A Multi-State Constraint Kalman Filter for Vision-aided Inertial Navigation.” Proceedings 2007 IEEE International Conference on Robotics and Automation(2007).

- PDFZijian Huang, Wenda Chu et al. “COMMIT: Certifying Robustness of Multi-Sensor Fusion Systems against Semantic Attacks.” ArXiv(2024)… Zijian Huang, Wenda Chu, Linyi Li, Chejian Xu, Bo Li.

- PDFBo Shen, Zidong Wang et al. “Robust fusion filtering over multisensor systems with energy harvesting constraints.” Autom.(2021)… Bo Shen.

- PDFHolger Caesar, Varun Bankiti et al. “nuScenes: A Multimodal Dataset for Autonomous Driving.” 2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR)(2019).

- PDFDongha Chung, Jonghwi Kim et al. “Pohang canal dataset: A multimodal maritime dataset for autonomous navigation in restricted waters.” The International Journal of Robotics Research(2023)… Dongha Chung, Jonghwi Kim, Changyu Lee, and Jinwhan Kim.

- PDFXiaozhi Chen, Huimin Ma et al. “Multi-view 3D Object Detection Network for Autonomous Driving.” 2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR)(2016).

- PDFDe Jong Yeong, G. Velasco-Hernández et al. “Sensor and Sensor Fusion Technology in Autonomous Vehicles: A Review.” Sensors (Basel, Switzerland)(2021).

- PDFYong Wang, Shuqian Du et al. “Autonomous Driving System Driven by Artificial Intelligence Perception Fusion.” Academic Journal of Science and Technology(2024)… Academic Journal of Science and Technology.

- PDFYanqiu Xiao, Shiao Yin et al. “A Near-Field Area Object Detection Method for Intelligent Vehicles Based on Multi-Sensor Information Fusion.” World Electric Vehicle Journal(2022).

- Zhangjing Wang, Yu Wu et al. “Multi-Sensor Fusion in Automated Driving: A Survey.” IEEE Access(2020).

- PDFC.L. Yan. “Analysis of Research Progress of Automatic Driving.” Highlights in Science, Engineering and Technology(2023)… Chuheng Yan, Warwick Business School, University.

- PDFA. Mohammed, A. Amamou et al. “The Perception System of Intelligent Ground Vehicles in All Weather Conditions: A Systematic Literature Review.” Sensors (Basel, Switzerland)(2020).

- PDFMircea Paul Muresan, Ion Giosan et al. “Stabilization and Validation of 3D Object Position Using Multimodal Sensor Fusion and Semantic Segmentation.” Sensors (Basel, Switzerland)(2020).

DAMO开发者矩阵,由阿里巴巴达摩院和中国互联网协会联合发起,致力于探讨最前沿的技术趋势与应用成果,搭建高质量的交流与分享平台,推动技术创新与产业应用链接,围绕“人工智能与新型计算”构建开放共享的开发者生态。

更多推荐

已为社区贡献2条内容

已为社区贡献2条内容

所有评论(0)