人工智能组第一次培训——deepseek本地部署和知识库的建立

本地部署的关键是推理计算,很多人没搞明白,推理计算和训练计算,是两个完全不同的东西,推理不是必须显卡的,推理实际上负荷也不高,只要你的cpu够强,系统内存够大,完全不需要显卡的参与,671b的完整版也可以在无显卡的机器上跑起来。选择Models,里面有很多个模型,主要介绍deepseek-r1和deepseek-v3,v3是更适用于普通的日常对话,r1是更接近于chatgpt的O1它有更长的推理链

deepseek本地部署的用处

-

减少对网络依赖性:

在断网环境下,依然可以使用预先下载的AI模型进行处理,避免因网络不稳定而无法完成任务。 -

提高响应速度:

数据和模型已经在本地设备上准备好,可以直接调用,不需要等待远程服务器的响应,大大提升操作效率。 -

保护用户隐私:

私密数据通过本地处理,减少传输风险,保障数据安全性,特别是在处理敏感信息时非常重要。 -

增强设备灵活性和独立性:

可在不同的设备上运行,无需依赖特定的网络环境或计算架构,提升便利性和适用性。

如何手动本地部署deepseek?

1、打开Ollama官网

https://ollama.com/

2、打开控制台,win+R,cmd,输入ollama,弹出下面如下指令证明安装ollama成功

3、配置环境变量

变量:OLLAMA_HOST

端口值:0.0.0.0:11434

因为后面我们的知识库是运行在一个虚拟机里的,没办法做到访问本机,所以需要我们做一个穿透

变量;OLLAMA_MODELS

值:OLLAMA模型下载的地址

由于默认的OLLAMA模型会下载到C盘,若想放在其他盘,节省C盘空间需要配置该变量

4、下载模型

打开ollama官网:https://ollama.com/

选择Models,里面有很多个模型,主要介绍deepseek-r1和deepseek-v3,v3是更适用于普通的日常对话,r1是更接近于chatgpt的O1它有更长的推理链,但是肯呢个也会有更长的响应时间

deepseel-r1模型大小选择

本地部署的关键是推理计算,很多人没搞明白,推理计算和训练计算,是两个完全不同的东西,推理不是必须显卡的,推理实际上负荷也不高,只要你的cpu够强,系统内存够大,完全不需要显卡的参与,671b的完整版也可以在无显卡的机器上跑起来

模型大小选择好后,点右边的复制

命令行拷贝下载即可

三、下载Chatbox AI软件

官网:https://chatboxai.app/zh

选择chatbox AI后在模型设置中选择Ollama API,保存后就能正常使用

接下来就配置完成了,就可以跟它对话了

构建本地 AI 知识库

DeepSeek 搭建个人知识库的显著优势

集中化管理:把所有资料汇聚一处统一存储,彻底告别资料四处散落、难以找寻的烦恼。

高速检索:运用智能搜索功能,输入关键词,瞬间就能精准定位到你急需的信息。

效率飞升:采用结构化的存储方式,无论是学习新知识,还是处理工作任务,都能让你的效率大幅提升 。

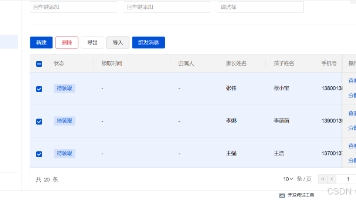

配置工作区

点击聊天设置,LLM提供者选择ollama:

设置模型地址

这里Ollama Base URL配置我们本地部署的模型地址:

DAMO开发者矩阵,由阿里巴巴达摩院和中国互联网协会联合发起,致力于探讨最前沿的技术趋势与应用成果,搭建高质量的交流与分享平台,推动技术创新与产业应用链接,围绕“人工智能与新型计算”构建开放共享的开发者生态。

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)